See discussions, stats, and author profiles for this publication at: https://www.researchgate.net/publication/326829698

Matemáticas Avanzadas: de los espacios lineales al análisis vectorial, con

aplicaciones en MAXIMA

Preprint · August 2018

DOI: 10.13140/RG.2.2.16232.37129

CITATIONS

READS

0

424

2 authors:

Héctor Hernández

Luis Nunez

University of the Andes (Venezuela)

Industrial University of Santander

23 PUBLICATIONS 359 CITATIONS

247 PUBLICATIONS 4,340 CITATIONS

SEE PROFILE

Some of the authors of this publication are also working on these related projects:

Caracterización de SiPMs View project

Water Cherenkov Detector at Universidad Industrial de Santander View project

All content following this page was uploaded by Héctor Hernández on 04 August 2018.

The user has requested enhancement of the downloaded file.

SEE PROFILE

ad

o

rr

Bo

lim

rP

re

ar

in

ar

in

rP

re

lim

Matemáticas Avanzadas:

de los espacios lineales al análisis vectorial,

con aplicaciones en Maxima

H. Hernández

Departamento de Fı́sica, Facultad de Ciencias,

Universidad de Los Andes, Mérida-Venezuela

ad

o

L. A. Núñez

Escuela de Fı́sica, Facultad de Ciencias,

Universidad Industrial de Santander, Bucaramanga-Colombia

Bo

rr

4 de agosto de 2018

ad

o

rr

Bo

lim

rP

re

ar

in

ii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

rP

re

ad

o

rr

Bo

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

in

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

lim

1. Los vectores de siempre

1.1. Vectores geométricos . . . . . . . . . . . . . . . . . . . . . .

1.1.1. Escalares y vectores . . . . . . . . . . . . . . . . . .

1.1.2. Álgebra de vectores . . . . . . . . . . . . . . . . . .

1.1.3. Vectores linealmente independientes . . . . . . . . .

1.1.4. Productos de vectores . . . . . . . . . . . . . . . . .

1.1.5. Producto triple o mixto . . . . . . . . . . . . . . . .

1.1.6. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

1.1.7. Practicando con Maxima . . . . . . . . . . . . . . .

1.1.8. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

1.2. Vectores en componentes . . . . . . . . . . . . . . . . . . . .

1.2.1. Bases y componentes . . . . . . . . . . . . . . . . . .

1.2.2. Cosenos directores . . . . . . . . . . . . . . . . . . .

1.2.3. Una división fallida . . . . . . . . . . . . . . . . . . .

1.2.4. Algebra vectorial en componentes . . . . . . . . . . .

1.2.5. Dependencia e independencia lineal . . . . . . . . . .

1.2.6. Productos de vectores en componentes . . . . . . . .

1.2.7. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

1.2.8. Practicando con Maxima . . . . . . . . . . . . . . .

1.2.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

1.3. Aplicaciones del álgebra vectorial . . . . . . . . . . . . . . .

1.3.1. Rectas y vectores . . . . . . . . . . . . . . . . . . . .

1.3.2. Planos y vectores . . . . . . . . . . . . . . . . . . . .

1.3.3. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

1.3.4. Practicando con Maxima . . . . . . . . . . . . . . .

1.3.5. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

1.4. Álgebra vectorial con ı́ndices . . . . . . . . . . . . . . . . .

1.4.1. Convención de Einstein . . . . . . . . . . . . . . . .

1.4.2. Vectores e ı́ndices . . . . . . . . . . . . . . . . . . . .

1.4.3. Rotación de coordenadas . . . . . . . . . . . . . . .

1.4.4. Escalares, pseudoescalares, vectores y pseudovectores

1.4.5. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

1.4.6. Practicando con Maxima . . . . . . . . . . . . . . .

1.4.7. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

1.5. Un comienzo a la derivación e integración de vectores . . .

1.5.1. Vectores variables . . . . . . . . . . . . . . . . . . .

1.5.2. Derivación . . . . . . . . . . . . . . . . . . . . . . . .

1.5.3. Velocidades y aceleraciones . . . . . . . . . . . . . .

1.5.4. Vectores y funciones . . . . . . . . . . . . . . . . . .

1.5.5. El operador ∇ . . . . . . . . . . . . . . . . . . . . .

1.5.6. Integración . . . . . . . . . . . . . . . . . . . . . . .

1.5.7. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

1.5.8. Practicando con Maxima . . . . . . . . . . . . . . .

1.5.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

1.6. Vectores y números complejos . . . . . . . . . . . . . . . . .

ar

Índice general

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

4

4

6

7

9

9

11

13

14

14

15

16

16

16

17

18

19

21

22

22

23

24

25

26

28

29

30

31

32

34

35

37

37

37

38

39

41

43

44

45

51

58

60

ÍNDICE GENERAL

iv

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2. Espacios vectoriales lineales

2.1. Grupos, campos y espacios vectoriales . . . . . . . . . . . . .

2.1.1. Grupos . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.2. Campo . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.3. Espacios vectoriales lineales . . . . . . . . . . . . . . .

2.1.4. Algunos espacios vectoriales . . . . . . . . . . . . . . .

2.1.5. La importancia de la notación . . . . . . . . . . . . . .

2.1.6. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.7. Practicando con Maxima . . . . . . . . . . . . . . . .

2.1.8. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . .

2.2. Espacios métricos, normados y con producto interno . . . . .

2.2.1. Métricas y espacios métricos . . . . . . . . . . . . . .

2.2.2. Normas y espacios normados . . . . . . . . . . . . . .

2.2.3. Espacios euclidianos . . . . . . . . . . . . . . . . . . .

2.2.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . .

2.2.5. Practicando con Maxima . . . . . . . . . . . . . . . .

2.2.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . .

2.3. Variedades lineales . . . . . . . . . . . . . . . . . . . . . . . .

2.3.1. Dependencia/Independencia lineal . . . . . . . . . . .

2.3.2. Bases de un espacio vectorial . . . . . . . . . . . . . .

2.3.3. El determinante de Gram . . . . . . . . . . . . . . . .

2.3.4. Ortogonalidad y bases ortogonales . . . . . . . . . . .

2.3.5. Ortogonalización . . . . . . . . . . . . . . . . . . . . .

2.3.6. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . .

2.3.7. Practicando con Maxima . . . . . . . . . . . . . . . .

2.3.8. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . .

2.4. Aproximación de funciones . . . . . . . . . . . . . . . . . . .

2.4.1. Complementos ortogonales y descomposición ortogonal

2.4.2. Condiciones para la aproximación de funciones . . . .

2.4.3. El método de mı́nimos cuadrados . . . . . . . . . . . .

2.4.4. Interpolación polinomial de puntos experimentales . .

2.4.5. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . .

2.4.6. Practicando con Maxima . . . . . . . . . . . . . . . .

2.4.7. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

77

77

77

80

80

81

83

83

85

87

89

89

90

91

95

96

99

104

104

104

106

106

109

109

112

115

116

116

117

118

119

119

123

130

3. Vectores duales y tensores

3.1. Funcionales lineales . . . . . . . . . . . . . . . . . . . .

3.1.1. Espacio vectorial dual . . . . . . . . . . . . . .

3.1.2. Espacios duales y bases recı́procas . . . . . . .

3.1.3. Vectores, formas y leyes de transformación . .

3.1.4. Ejemplos . . . . . . . . . . . . . . . . . . . . .

3.1.5. Practicando con Maxima . . . . . . . . . . . .

3.1.6. Ejercicios . . . . . . . . . . . . . . . . . . . . .

3.2. Tensores y producto tensorial . . . . . . . . . . . . . .

3.2.1. Tensores, una definición funcional . . . . . . .

3.2.2. Producto tensorial . . . . . . . . . . . . . . . .

3.2.3. Espacios tensoriales . . . . . . . . . . . . . . .

3.2.4. Bases para un producto tensorial . . . . . . . .

3.2.5. Tensores, sus componentes y sus contracciones

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

135

136

136

137

138

139

141

146

147

147

148

149

150

151

rP

re

ad

o

rr

Bo

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

60

61

63

65

68

70

73

ar

.

.

.

.

.

.

.

in

Los números complejos y su álgebra

Vectores y el plano complejo . . . .

Fórmulas de Euler y De Moivre . . .

Algunas aplicaciones inmediatas . .

Ejemplos . . . . . . . . . . . . . . .

Practicando con Maxima . . . . . .

Ejercicios . . . . . . . . . . . . . . .

lim

1.6.1.

1.6.2.

1.6.3.

1.6.4.

1.6.5.

1.6.6.

1.6.7.

ÍNDICE GENERAL

v

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

154

155

155

156

158

175

178

180

181

182

184

187

188

191

191

192

195

198

200

202

206

4. Matrices, determinantes y autovectores

4.1. Operadores lineales . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.1. Espacio vectorial de operadores lineales . . . . . . . . .

4.1.2. Composición de operadores lineales . . . . . . . . . . . .

4.1.3. Proyectores . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.5. Practicando con Maxima . . . . . . . . . . . . . . . . .

4.1.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2. Tipos de operadores . . . . . . . . . . . . . . . . . . . . . . . .

4.2.1. Espacio nulo e imagen de un operador . . . . . . . . . .

4.2.2. Operadores biyectivos e inversos . . . . . . . . . . . . .

4.2.3. Operadores adjuntos . . . . . . . . . . . . . . . . . . . .

4.2.4. Operadores hermı́ticos . . . . . . . . . . . . . . . . . . .

4.2.5. Operadores unitarios . . . . . . . . . . . . . . . . . . . .

4.2.6. Funciones de operadores . . . . . . . . . . . . . . . . . .

4.2.7. Diferenciación de operadores . . . . . . . . . . . . . . .

4.2.8. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.9. Practicando con Maxima . . . . . . . . . . . . . . . . .

4.2.10. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3. Representación matricial de operadores . . . . . . . . . . . . .

4.3.1. Álgebra elemental de matrices . . . . . . . . . . . . . .

4.3.2. Bases y la representación matricial de operadores . . . .

4.3.3. Representación matricial y transformaciones . . . . . . .

4.3.4. Traza de operadores . . . . . . . . . . . . . . . . . . . .

4.3.5. Un paréntesis determinante . . . . . . . . . . . . . . . .

4.3.6. Diferenciación de operadores y representación matricial

4.3.7. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.8. Practicando con Maxima . . . . . . . . . . . . . . . . .

4.3.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4. Un zoológico de matrices cuadradas . . . . . . . . . . . . . . .

4.4.1. Matriz unidad y la matriz nula . . . . . . . . . . . . . .

4.4.2. Matriz diagonal y diagonal a bloques . . . . . . . . . . .

4.4.3. Matriz transpuesta . . . . . . . . . . . . . . . . . . . . .

4.4.4. Matriz de cofactores . . . . . . . . . . . . . . . . . . . .

4.4.5. Matriz adjunta . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

211

212

214

215

216

216

218

220

221

221

223

224

225

225

225

226

228

229

230

231

232

232

233

233

234

237

238

243

247

249

250

250

250

250

250

rP

re

ad

o

rr

Bo

ar

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

in

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

lim

3.2.6. Tensor métrico, ı́ndices y componentes . . . . . . . .

3.2.7. Métrica, elemento de lı́nea y factores de escala . . .

3.2.8. Teorema del cociente . . . . . . . . . . . . . . . . . .

3.2.9. Vectores, formas, tensores y leyes de transformación

3.2.10. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

3.2.11. Practicando con Maxima . . . . . . . . . . . . . . .

3.2.12. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

3.3. Vectores, tensores y espacios pseudoeuclidianos . . . . . . .

3.3.1. Espacios minkowskianos . . . . . . . . . . . . . . . .

3.3.2. Un toque de Relatividad Especial . . . . . . . . . . .

3.3.3. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

3.3.4. Practicando con Maxima . . . . . . . . . . . . . . .

3.3.5. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

3.4. Espacios de funciones . . . . . . . . . . . . . . . . . . . . .

3.4.1. La función delta de Dirac . . . . . . . . . . . . . . .

3.4.2. Bases continuas . . . . . . . . . . . . . . . . . . . . .

3.4.3. Bases de ondas planas y la transformada de Fourier

3.4.4. Las representaciones |ri y |pi . . . . . . . . . . . . .

3.4.5. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . .

3.4.6. Practicando con Maxima . . . . . . . . . . . . . . .

3.4.7. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . .

ÍNDICE GENERAL

vi

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

251

251

251

251

252

253

255

256

256

257

258

258

259

260

263

265

265

266

267

267

274

277

279

279

281

282

285

292

294

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

299

300

301

302

303

305

306

309

310

317

322

323

325

325

327

327

327

329

330

330

333

336

339

340

342

343

348

ar

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

rP

re

lim

in

4.4.6. Matriz singular . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.7. Matriz inversa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.8. Matriz ortogonal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.9. Matrices complejas . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.10. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.11. Practicando con Maxima . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.12. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5. Sistemas de ecuaciones lineales . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5.1. Eliminación de Gauss-Jordan . . . . . . . . . . . . . . . . . . . . . . .

4.5.2. El método de la matriz inversa . . . . . . . . . . . . . . . . . . . . . .

4.5.3. Factorización LU . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5.4. Método de Cramer . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5.5. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5.6. Practicando con Maxima . . . . . . . . . . . . . . . . . . . . . . . . .

4.5.7. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.6. Autovectores y autovalores . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.6.1. Autovalores, autovectores e independencia lineal . . . . . . . . . . . .

4.6.2. El polinomio caracterı́stico, autovalores y autovectores de un operador

4.6.3. El caso degenerado . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.6.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.6.5. Practicando con Maxima . . . . . . . . . . . . . . . . . . . . . . . . .

4.6.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.7. Autovalores y autovectores de matrices importantes . . . . . . . . . . . . . .

4.7.1. Autovalores y autovectores de matrices hermı́ticas y unitarias . . . . .

4.7.2. Autovalores y autovectores de matrices similares . . . . . . . . . . . .

4.7.3. Conjunto completo de observables que conmutan . . . . . . . . . . . .

4.7.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.7.5. Practicando con Maxima . . . . . . . . . . . . . . . . . . . . . . . . .

4.7.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Bo

rr

ad

o

5. Coordenadas curvilı́neas, campos y operadores diferenciales

5.1. Coordenadas curvilı́neas generalizadas . . . . . . . . . . . . . .

5.1.1. Coordenadas cartesianas . . . . . . . . . . . . . . . . . .

5.1.2. Coordenadas cilı́ndricas . . . . . . . . . . . . . . . . . .

5.1.3. Coordenadas esféricas . . . . . . . . . . . . . . . . . . .

5.1.4. Otros sistemas coordenados . . . . . . . . . . . . . . . .

5.1.5. Curvas y parámetros . . . . . . . . . . . . . . . . . . . .

5.1.6. Covectores, tensores y coordenadas curvilı́neas . . . . .

5.1.7. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . .

5.1.8. Practicando con Maxima . . . . . . . . . . . . . . . . .

5.1.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2. Campos tensoriales . . . . . . . . . . . . . . . . . . . . . . . . .

5.2.1. Campos escalares y superficies . . . . . . . . . . . . . .

5.2.2. Campos vectoriales y curvas integrales . . . . . . . . . .

5.2.3. Flujo de campos vectoriales . . . . . . . . . . . . . . . .

5.2.4. Ejemplos . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2.5. Practicando con Maxima . . . . . . . . . . . . . . . . .

5.2.6. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3. La fauna de los operadores vectoriales . . . . . . . . . . . . . .

5.3.1. Derivada direccional, diferencial total y gradiente . . . .

5.3.2. Divergencia y flujo en campos vectoriales . . . . . . . .

5.3.3. Rotores, lı́neas de torbellino y circulación . . . . . . . .

5.3.4. Formulario del operador nabla, ∇ . . . . . . . . . . . .

5.3.5. Nabla dos veces y el laplaciano . . . . . . . . . . . . . .

5.3.6. Derivadas direccionales de campos vectoriales . . . . . .

5.3.7. La derivada covariante . . . . . . . . . . . . . . . . . . .

5.3.8. Derivadas absolutas y geodésicas . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

ÍNDICE GENERAL

vii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

349

356

359

361

361

363

364

365

367

369

370

370

374

377

382

384

385

386

387

388

388

389

390

394

397

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Bo

rr

ad

o

6. Apéndice

6.1. Introducción a los CAS . . . .

6.2. Maxima: Sintaxis básica . . . .

6.2.1. Cálculos elementales . .

6.2.2. Bibliotecas . . . . . . .

6.2.3. Maxima en modo texto

6.2.4. Invocando la ayuda . . .

6.2.5. Ejercicios . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

401

402

403

406

414

417

418

419

lim

in

ar

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

rP

re

5.3.9. Ejemplos . . . . . . . . . . . . . . . . . . . .

5.3.10. Practicando con Maxima . . . . . . . . . . .

5.3.11. Ejercicios . . . . . . . . . . . . . . . . . . . .

5.4. Integrales y campos vectoriales . . . . . . . . . . . .

5.4.1. Integrales de lı́nea . . . . . . . . . . . . . . .

5.4.2. Integrales de superficie . . . . . . . . . . . . .

5.4.3. Integrales de volumen . . . . . . . . . . . . .

5.4.4. Ejemplos . . . . . . . . . . . . . . . . . . . .

5.4.5. Practicando con Maxima . . . . . . . . . . .

5.4.6. Ejercicios . . . . . . . . . . . . . . . . . . . .

5.5. Campos vectoriales y teoremas integrales . . . . . .

5.5.1. Teorema de Gauss . . . . . . . . . . . . . . .

5.5.2. Teorema de Stokes . . . . . . . . . . . . . . .

5.5.3. Ejemplos . . . . . . . . . . . . . . . . . . . .

5.5.4. Practicando con Maxima . . . . . . . . . . .

5.5.5. Ejercicios . . . . . . . . . . . . . . . . . . . .

5.6. Teorı́a de Potencial . . . . . . . . . . . . . . . . . . .

5.6.1. Potenciales escalares . . . . . . . . . . . . . .

5.6.2. Potenciales vectoriales y calibres . . . . . . .

5.6.3. Teorema de Green y potenciales . . . . . . .

5.6.4. Teorema de Helmholtz . . . . . . . . . . . . .

5.6.5. Teoremas integrales para campos tensoriales .

5.6.6. Ejemplos . . . . . . . . . . . . . . . . . . . .

5.6.7. Practicando con Maxima . . . . . . . . . . .

5.6.8. Ejercicios . . . . . . . . . . . . . . . . . . . .

ÍNDICE GENERAL

Bo

rr

ad

o

rP

re

lim

in

ar

viii

ar

Introducción

Bo

rr

ad

o

rP

re

lim

in

Como toda obra, el contenido de este libro tuvo como motivación inicial la insatisfacción con lo que estaba

disponible y esa necesidad de discutir un conjunto de conceptos con el matiz personal de los autores. A lo largo de

casi 10 años se fue dibujando esa ruta, donde confluyen: una presentación abstracta, una herramienta de cálculo

algebraico y variados ejemplos de aplicación proveniente de la más diversas áreas. Hemos tratado de mostrar que

los conceptos abstractos son útiles porque engloban, bajo un mismo enfoque, una multiplicidad de aplicaciones que

normalmente las percibimos aisladas.

Existe, desde hace mucho tiempo, cierta resistencia en los Departamentos de Fı́sica en incluir en sus programas de

docencia cursos para la enseñanza de herramientas de computación cientı́fica y cálculo numérico, tal vez debido a los

altos costos de la mayorı́a de estos programas, casi todos comerciales. Pensamos que la utilización de herramientas

computacionales enriquece enormemente el aprendizaje de los estudiantes ya que los enseñan a abordar los problemas

desde diferentes puntos de vista, les ayuda a familiarizarse con determinados lenguajes de programación y los

incentiva a desarrollar sus propias técnicas de cálculo.

Hemos decidido utilizar un sistema de computación algebraico de domino público (o software libre) como Maxima porque estos programas tienen la capacidad de ofrecer al estudiante toda una gama de herramientas de cálculo

simbólico, numérico y de visualización de muy alto rendimiento. Maxima es un programa que no requiere conocimientos previos de lenguajes de programación pero permitirá que el estudiante se familiarice con la sintaxis de

programación y la transición a los lenguajes del tipo Fortran, C, o Python será mas sencilla.

Los contenidos que aquı́ presentamos han sido utilizados en cursos de Métodos Matemáticos para estudiantes de

pregrado en Fı́sica de la Universidad de los Andes (Mérida-Venezuela) y más recientemente en los cursos de pregrado

y posgrado para estudiantes en Fı́sica e Ingenierı́as en la Universidad Industrial de Santander (BucaramangaColombia).

1

ad

o

rr

Bo

lim

rP

re

ar

in

2

ÍNDICE GENERAL

ar

Capı́tulo 1

in

Los vectores de siempre

lim

La ruta de este capı́tulo

Vectores geométricos

ad

o

1.1.

rP

re

Suponemos que los estudiantes se acercan a estas notas, no solo conociendo algunos términos sino siendo capaces

de buscar muchos otros en la red. Por lo tanto, concebimos este capı́tulo para que apunte a varios objetivos. Por

un lado, buscamos refrescar un conjunto de conceptos básicos que seguramente son conocidos por el lector. Si no

lo son, aprovechamos la oportunidad para presentarlos –en el marco de R3 , es decir ejemplificando con vectores

tridimensionales– utilizando el lenguaje abstracto al cual haremos referencia en los próximos capı́tulos. Siguiendo

esta lógica presentamos las propiedades de los vectores en la próxima sección 1.1; la independencia lineal, bases,

producto interno (sección 1.1.3) y los sistemas de coordenadas (sección 1.2). Con la excusa del algebra vectorial en

coordenadas, introducimos algunos elementos de álgebra vectorial con ı́ndices, que normalmente no son cubiertos

tan tempranamente (sección 1.4) en cursos de métodos matemáticos. Adicionalmente, esta excusa nos sirve de

puente para presentar nociones operativas de tensores y de análisis de vectorial que formalizaremos más adelante en

los capı́tulos 3 y 5, respectivamente. La representación de los número complejos como vectores, con “componentes”

reales y complejas justifica la incorporación de este repaso en la última sección 1.6. Finalmente, este capı́tulo nos

sirve para iniciar el uso de la herramienta de cálculo algebraico que nos acompañará en el resto del libro y que se

detalla en el apéndice 6.1.

Desde los primeros cursos de Fı́sica en educación media, venimos hablando de vectores como cantidades que

tienen que ser representadas con más de un número. Son varias las razones que obligan a introducir este (y otro)

tipo de cantidades “multidimensionales”. Enumeraremos algunas que, a nuestro criterio personal, son las más

representativas.

rr

1. Necesidad de modelos matemáticos de la naturaleza. Desde los albores del renacimiento, con Galileo

Galilei a la cabeza, nos es imperioso representar cantidades de manera precisa. Las matemáticas nos apoyan

en esta necesidad de precisión y desde ese entonces son el lenguaje de la actividad cientı́fica.

Bo

2. Los modelos tienen que ser contrastados con los experimentos. Las ciencias y sus modelos, en última

instancia, tienen que ver con la realidad, con la naturaleza y por ello debemos medir y contrastar las hipótesis

con esa realidad que modelamos. Necesitamos representar cantidades medibles (observables) y que, por lo

tanto, tienen que ser representadas de la forma más compacta, pero a la vez más precisa posible.

3. Las leyes de los modelos deben ser independiente de los observadores. Cuando menos a una familia

significativa de observadores, el comportamiento de la naturaleza no puede depender de la percepción de un

determinado observador, por lo tanto, los modelos que construimos para describirla tampoco pueden depender

de los observadores.

Es común que tropecemos con: escalares, vectores, tensores y espinores, dependiendo del número de cantidades

que necesitemos para representar determinado objeto matemático. Podremos constatar que las leyes de la Fı́sica

vienen escritas en forma vectorial (o tensorial) y, por lo tanto, será la misma ley para la familia de observadores

equivalentes.

3

CAPÍTULO 1. LOS VECTORES DE SIEMPRE

lim

in

ar

4

1.1.1.

Escalares y vectores

rP

re

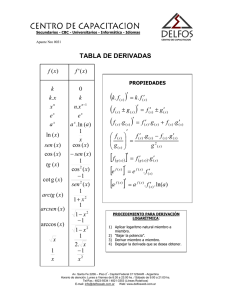

Figura 1.1: Vectores y sus operaciones

Dejaremos para más adelante caracterizar objetos como tensores y espinores, por ahora nos contentaremos con

refrescar nuestros recuerdos con cantidades como:

Escalares: Serán aquellas cantidades las cuales se representan con UN solo número, una magnitud: temperatura, volumen, masa, entre otras. Es costumbre no denotarlas de manera especial, ası́ T = 5◦ C representará

una temperatura de 5 grados centı́grados.

rr

ad

o

Vectores: Serán cantidades las cuales, para ser representadas por un objeto matemáticos, necesitan más de

una cantidad: requieren de UN número, UNA dirección y UN sentido. Entre las cantidades que tı́picamente

reconocemos como vectores están: la velocidad, la aceleración, la fuerza. En términos gráficos podremos decir

que un vector será un segmento orientado, en el cual la dimensión del segmento representará su módulo y

su orientación la dirección y el sentido. Para diferenciarlos de las cantidades escalares hay una variedad de

representaciones, entre ellas: en negrita a; con una flecha arriba de la cantidad ~a; con una tilde arriba o abajo

−−→

ã; o explicitando el origen del segmento orientado OP . El módulo del vector lo representaremos dentro de la

función valor absoluto, o sencillamente sin la flecha arriba a = |a| = |~a|.

Bo

Los vectores son independientes del sistema de coordenadas. Sus caracterı́sticas (módulo, dirección y sentido) se

preservarán en todos los sistemas de coordenadas. Más aún, habrá vectores que podremos desplazar (conservando

su módulo dirección y sentido) paralelos a ellos mismos, y seguirán representando las mismas cantidades. Por ello

encontraremos el término de vectores deslizantes. Un ejemplo son las fuerzas que actúan en un determinado cuerpo,

como se muestra en el cuadrante I en la figura 1.1. También habrá vectores atados a un punto en el espacio, por

cuanto representan una de las propiedades de ese punto: la velocidad del viento, el campo eléctrico, o sus variaciones

son ejemplos de vectores atados (observe la figura 1.2 como ejemplos ilustrativos).

1.1.2.

Álgebra de vectores

Enumeraremos rápidamente el álgebra de vectores sin hacer referencia a un sistema de coordenadas en particular.

Desde los cursos básicos de matemáticas nos enseñaron a representar gráficamente este álgebra, ası́ tenemos que:

Vector nulo. Es aquel que tiene por módulo cero y no se le pude asignar dirección ni sentido. El frecuente

representar al vector nulo por 0.

1.1. VECTORES GEOMÉTRICOS

5

Vector unitario. Es aquel que tiene por módulo la unidad, es muy útil por cuanto, para efectos algebraicos,

“contiene” únicamente dirección y sentido. Lo denotaremos con un acento circunflejo, comúnmente llamado “sombrero” ûa = a/|a|, con lo cual todo vector se podrá expresar por un módulo en la dirección y sentido de un vector

unitario: a = |a| ûa = a ûa .

ar

Comparación de vectores. Al comparar sus módulos diremos que pueden ser mayores, menores o iguales. Por

lo tanto, tal y como mostramos en el cuadrante IIa de la figura 1.1, dos vectores serán iguales, a = b, si tienen la

misma dirección y sentido.

lim

in

Multiplicación por un número. Un vector

multiplicado por un número, α, cambiará su módulo si α > 0 y cambiará su sentido, y eventualmente

su módulo, si α < 0. Tal y como puede apreciarse

en el cuadrante IIa de la figura 1.1. Claramente

dos vectores proporcionales serán colineales. Diremos además, que el inverso del vector a será la

multiplicación de a por (−1). Esto es: (−1) a = −a.