Generación de Variables Aleatorias: Métodos y Ejemplos

Anuncio

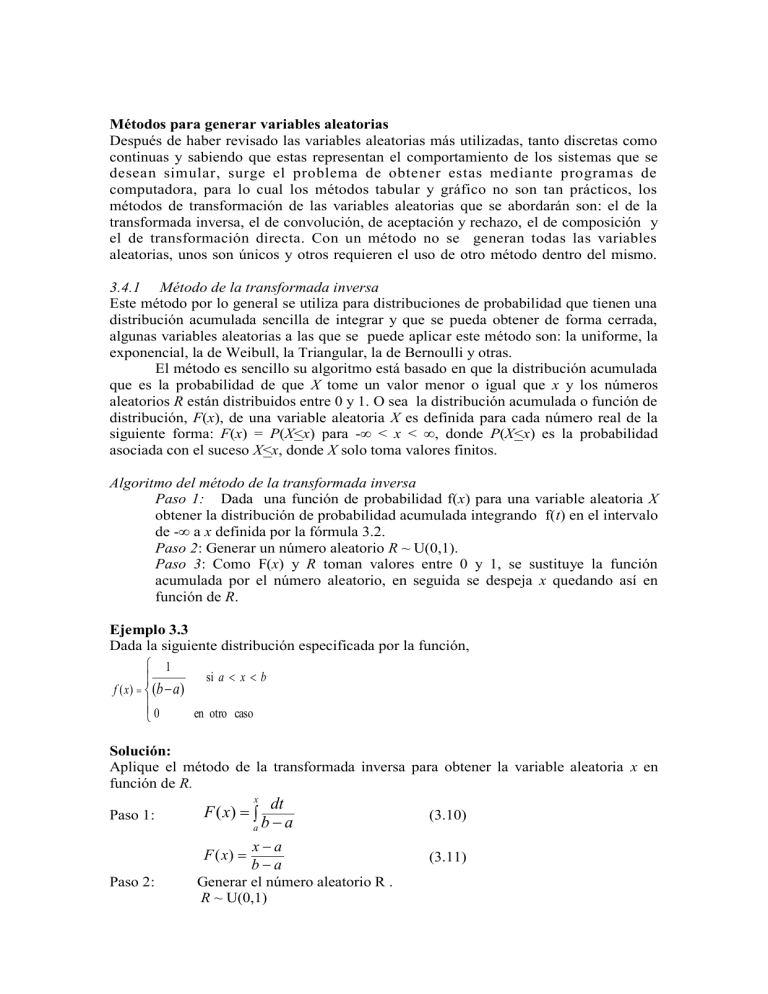

COMPILADO POR GRACIELA MORA OTERO Métodos para generar variables aleatorias Después de haber revisado las variables aleatorias más utilizadas, tanto discretas como continuas y sabiendo que estas representan el comportamiento de los sistemas que se desean simular, surge el problema de obtener estas mediante programas de computadora, para lo cual los métodos tabular y gráfico no son tan prácticos, los métodos de transformación de las variables aleatorias que se abordarán son: el de la transformada inversa, el de convolución, de aceptación y rechazo, el de composición y el de transformación directa. Con un método no se generan todas las variables aleatorias, unos son únicos y otros requieren el uso de otro método dentro del mismo. 3.4.1 Método de la transformada inversa Este método por lo general se utiliza para distribuciones de probabilidad que tienen una distribución acumulada sencilla de integrar y que se pueda obtener de forma cerrada, algunas variables aleatorias a las que se puede aplicar este método son: la uniforme, la exponencial, la de Weibull, la Triangular, la de Bernoulli y otras. El método es sencillo su algoritmo está basado en que la distribución acumulada que es la probabilidad de que X tome un valor menor o igual que x y los números aleatorios R están distribuidos entre 0 y 1. O sea la distribución acumulada o función de distribución, F(x), de una variable aleatoria X es definida para cada número real de la siguiente forma: F(x) = P(X<x) para -∞ < x < ∞, donde P(X<x) es la probabilidad asociada con el suceso X<x, donde X solo toma valores finitos. Algoritmo del método de la transformada inversa Paso 1: Dada una función de probabilidad f(x) para una variable aleatoria X obtener la distribución de probabilidad acumulada integrando f(t) en el intervalo de -∞ a x definida por la fórmula 3.2. Paso 2: Generar un número aleatorio R ~ U(0,1). Paso 3: Como F(x) y R toman valores entre 0 y 1, se sustituye la función acumulada por el número aleatorio, en seguida se despeja x quedando así en función de R. Ejemplo 3.3 Dada la siguiente distribución especificada por la función, 1 si a x b f ( x) (b a) 0 en otro caso Solución: Aplique el método de la transformada inversa para obtener la variable aleatoria x en función de R. x Paso 1: F ( x) Paso 2: dt aba (3.10) xa ba (3.11) F ( x) Generar el número aleatorio R . R ~ U(0,1) Paso 3: R = F(x) (3.12) xa ba (3.13) R Despejando la variable aleatoria x se tiene: x = a + R(b – a) (3.14) Como se observa la distribución a la que se le aplicó el método de la transformada inversa fue a la distribución uniforme U(a,b). Si se desea obtener una variable aleatoria U(3, 6) solo se requiere generar un número aleatorio R uniformemente distribuido entre 0 y 1, y sustituirlo en x = a + R(b – a) y así obtener la variable aleatoria x. De la tabla 2.9 obtenemos R= 0.8594 sustituyendo valores x = 3 + 0.8594(6 – 3) = 5.5782 Ejemplo 3.4 Considere una variable aleatoria x cuya función de densidad está dada por la siguiente distribución empírica: x f ( x) 2 0 si 0 x 2 en otro caso Solución: x Paso 1: t 02 F ( x) dt x t2 F ( x) 2 * 2 0 Paso 2: Paso 3: x2 4 Generar el número aleatorio R. R ~ U(0,1) R = F(x) R = x2 4 Despejando la variable aleatoria x se tiene: x 4R Ejemplo 3.5 Cuando no se conoce el tipo de distribución que tiene una tabla de probabilidades por ejemplo en los datos de servicio que están dados por la tabla 1.2 del ejemplo 1.1, se resuelve: Solución: Aplicando el método de la transformada inversa, el valor que puede tomar la variable aleatoria depende del rango que corresponda al valor del número aleatorio R. x = 1 si R se encuentra en el rango 0.0 - 0.20 x = 2 si R se encuentra en el rango 0.21 - 0.60 x = 3 si R se encuentra en el rango 0.61 - 0.80 x = 4 si R se encuentra en el rango 0.81 – 1.0 3.4.2 Método de convolución Este método, para obtener la variable aleatoria utiliza una suma estadística (convoluciones) de otras variables aleatorias fáciles de obtener. El método de convolución se aplica a varias distribuciones como: m-Erlang, binomial, Poisson, normal y la gamma principalmente, obteniéndose resultados aproximados o exactos al utilizar sumas lineales de otras variables aleatorias por ejemplo la variable aleatoria mErlang se define como la suma estadística de m variables aleatorias exponenciales independientes e idénticamente distribuidas; entonces: X= y1 + y2 + y3 + ……..ym (3.15) donde yi desde i = 1 hasta m son variables aleatorias exponenciales con función de densidad: f(yi) = 1 - x/ , yi > 0, i= 1,2,3….,m e (3.16) Aplicando el método de la transformada inversa a las variables exponenciales se tiene: yi = (-β/m) ln(Ri), i=1,2,3…..m (3.17) Para obtener la variable m-Erlang se tiene: X = (-β/m) [ ln(R1) + ln(R2) + ln(R3) + ….+ ln(Rm)] X = ( -β/m) ln(R1R2R3 ….Rm) X m ln Ri m i 1 (3.18) Ejemplo 3.6 Genere variables aleatorias 3-Erlang(1). Solución: Paso 1: Generar 3 números aleatorios como U(0,1). De la tabla 2.9 se obtienen: R1 =0.7109, R2 = 0.5625, R3 = 0.4141 Paso 2: Obtener la variable aleatoria X m X ln Ri m i 1 X = (-⅓) ln(0.7109*0.5625*0.4141) =(-⅓) ln(0.1656) =(-⅓) (-1.7982) = 0.5994 Ejemplo 3.7 Genere una variable aleatoria binomial (5,0.45). Solución: Para obtener esta variable discreta bin(t,p) se aplica el método de convolución utilizando para obtenerla la Ber (p) de la siguiente forma: X = y1 + y2 + y3 + ……..yt donde yi desde i = 1 hasta t son variables aleatorias Bernoulli con función de densidad: 1 p si x 0 p( x) p si x 1 0 en otro caso Esta distribución da solo 2 valores, cuando: p > R, el valor de X =1, y X=0 en caso contrario Paso 1 Generar 5 números aleatorios. Paso 2 Obtener 5 variables Bernoulli(0.45). Paso 3 Obtener la variable aleatoria bin(5,0.45). Solución: Obteniendo los 5 números aleatorios U(0,1) de la tabla 2.9 se tiene: i R 1 0.2656 2 0.1172 3 0.9688 4 0.8203 5 0.6719 Entonces la variable aleatoria bin(5,0.45) es: yi 1 1 0 0 0 X = y1 + y 2 + y3 + y4 + y5 X=1+1+0+0+0 X=2 3.4.3 Método de aceptación y rechazo Este método es utilizado cuando solo se conoce la función de densidad y no se puede aplicar el método de la transformada inversa a su distribución acumulada. El método consiste en reemplazar la función complicada de densidad de probabilidad, f(x), por una función de densidad representante, g(x), más fácil de manejar. De forma más concreta, se define una función h(x) que domine a f(x) en todo su intervalo, esto es, h(x) > f(x), -∞ < x < ∞, en seguida se define g(x), que es la función de densidad de probabilidad representante de la manera siguiente: h( x ) g ( x) , x (3.19) h( y )dy Ejemplo 3.8 Suponga que se tiene f(x) con rango finito, a < x < b, y moda M, obtenga la variable aleatoria X. Solución: Paso 1: Generar un número aleatorio R1~ U(0,1). Paso 2: Calcular la variable aleatoria Y en función de R1. Y = a + R1 (b-a) Paso 3: Generar un número aleatorio R2~ U(0,1). Paso 4: Si R2 < Y/M, entonces X=Y, esto significa que la variable aleatoria X toma el valor simulado, de lo contrario regresar al paso 1. Ejemplo 3.9 Aplique el método de aceptación y rechazo para generar variables aleatorias N(0,1), aplicando el método polar de aproximación propuesto por Marsaglia y Bray en 1964, este método genera 2 variables aleatorias. Solución: Paso 1 Generar 2 números aleatorios R1 y R2 ~ U(0,1) Paso 2 Obtener Vi = 2*Ri – 1 para i=1,2, y calcular W= V12 + V22 Paso 3 Si W > 1, regresar al paso 1, de lo contrario calcular Y como: Y (2 ln W ) / W Paso 4: Obtener las variables aleatorias N(0,1) X1 = V1*Y y X2 = V2*Y Solución: Algunos autores recomiendan utilizar 2 corridas diferentes de números aleatorios para esta prueba, por lo tanto se tomará un número de la tabla 2.9 y otro del ejemplo 2.14 R1 = 0.523 y R2 = 0.375 V1 = 2*R1– 1 = 2 *0.523 – 1 = 0.046 V2 = 2*R2– 1 = 2 *0.375 – 1 = -0.25 W= V12 + V22 = (0.046)2 + (-0.25)2 = 0.064616 Como W < 1 se calcula Y Y (2 ln W ) / W (2 ln 0.064616) / 0.064616 Y = 9.2406 Obteniendo las variables aleatorias: X1 = V1*Y = 0.046 * 9.2406 = 0.4251 X2 = V2*Y = 0.25 * 9.2406 = -2.3101 3.4.4 Método de Composición En este método la distribución de probabilidad f(x) se expresa mediante una mezcla de varias distribuciones de probabilidad seleccionadas adecuadamente. El proceso para seleccionar las distribuciones adecuadas está en el tiempo de computación requerido. Esto también aplica para la función de distribución acumulada F(x), en cada uno de los casos las funciones serían: n n f ( x ) p f ( x ) Donde pi > 0, y p 1 i i i i 1 i 1 O en función de la distribución acumulada, n F ( x) p F ( x) i i i 1 n pi 1 Donde pi > 0, y i 1 (3.20) Ejemplo 3.10 Aplicar los siguientes pasos a la figura 3.35, para generar variables aleatorias que sigan esta distribución. Solución: Paso 1: Dividir la distribución de probabilidad original en n partes, en este caso 2, recordemos que el área total bajo la curva es 1 igual que la suma de probabilidades, obtener el área de cada una de las fracciones: ba cb A A , 1 ca 2 ca Paso 2: Determinar las funciones de probabilidad para cada área. 2( x a ) 2( x c ) f ( x) f ( x) 1 2 (b a ) 2 (c b) 2 f(x) 1 0.8 2/(c-a) 0.4 0.2 a b c x Figura 3.35 Distribución de probabilidad del ejemplo 3.10 Paso 3: Definir las distribuciones acumuladas de cada fracción, integrando f1(x) y f2(x) F ( x) 1 ( x a) 2 (b a ) 2 F ( x) 1 2 ( x c) 2 (c b) 2 La representación de la distribución acumulada de cada fracción se muestra en la figura 3.36. Paso 4: Obtener la función de probabilidad original como: f ( x) A f ( x) A f ( x) 11 2 2 b a 2( x a ) c b 2( x c) c a (b a ) 2 c a (c b) 2 f ( x) 2( x a ) 2 ( x c ) (b a)( c a) (c a)( c b) f ( x) Paso 5: Generar 2 números aleatorios R1, R2 ~ U(0,1) f(x) 1 (b-a)/(c-a) f1 (x) f2 (x) x Figura 3.36 Distribución acumulada de las áreas. Si R1 < (b-a) / (c-a) entonces x a R (b a ) en caso contrario: 2 x c (c b) R 2 3.5 Algoritmos para generación de variables aleatorias discretas. 3.5.1 Bernoulli- Ber(p) 1. Generar un número aleatorio R ~ U(0,1) 2. Obtener la variable aleatoria de la siguiente forma: Si R< p, X= 1, de lo contrario X = 0. Donde: p es la media de la Bernoulli, R el número aleatorio uniformemente distribuido entre 0 y 1, X es la variable aleatoria. Se determina con el método de la transformada inversa y se usa para generar otras variables aleatorias discretas como la binomial, la geométrica y la binomial negativa. 3.5.2 Uniforme discreta- UD(i,j) 1. Generar un número aleatorio R ~ U(0,1). 2. Obtener la variable aleatoria de la siguiente forma: X i ( j i 1) R Donde i y j son enteros tales que i< j, i es el parámetro de ubicación y j-i el parámetro de forma. 3.5.3 Binomial- bin(t, p) 1. Generar Y1, Y2, Y3,………… Yt como variables Ber(p) independientes e idénticamente distribuidas 2. Obtener la variable aleatoria como: X = Y1+ Y2+ Y3+…………+ Yt En el ejemplo 3.7 se muestra la aplicación del algoritmo. El tiempo de ejecución de este algoritmo depende del valor de t. El algoritmo utiliza el método de convolución. 3.5.4 Geométrica- geom(p) 1. Generar un número aleatorio R ~ U(0,1). 2. Obtener la variable aleatoria de la siguiente forma: X ln R / ln(1 p) Este algoritmo equivale al método de la transformada inversa si se sustituye R por 1-R en el paso 2. 3.5.5 Binomial negativa- negbin(s,p) 1. Generar Y1, Y2, Y3,………… Ys como variables geom(p) independientes e idénticamente distribuidas. 2. Obtener la variable aleatoria como: X = Y1+ Y2+ Y3+…………+ Ys Donde s es un número entero positivo y p ϵ (0,1). Al igual que el algoritmo de la binomial, la variable aleatoria binomial negativa se obtiene mediante el método de convolución. 3.5.6 Poisson- Poisson(ʎ) 1. Inicializar variables: i = 0, t = 0 2. Definir el tiempo T 3. Generar los tiempos entre eventos mediante una distribución exponencial. Generar R ~ U(0,1) Generar la variable exponencial x = -(1/ʎ ) ln(R) Sumar el tiempo simulado t=t+x si t < T se incrementa i i = i +1 ( número de eventos ocurridos en el tiempo T), y se repite el paso 3 hasta que t >T se da por terminada la generación. 4. La variable aleatoria es: X= i Los autores Law y Kelton, presentan el siguiente algoritmo para la variable aleatoria Poisson. 1. Calcular a = e-ʎ, hacer b = 1 e i = 0. 2. Generar Ri+1 ~ U(0,1) y reemplazar b por b* Ri+1, si b < a, entonces X = i En otro caso, ir al paso 3 3. Reemplace i por i +1 y regrese al paso 2 Donde ʎ es la media de la función de Poisson ʎ > 0. El uso de uno u otro depende de cuál sea computacionalmente más rápido y esto queda a elección del programador. 3.6 Algoritmos para la generación de variables aleatorias continuas. 3.6.1 Uniforme- U(a, b) 1. Generar R ~ U(0,1) 2. Obtener la variable aleatoria: X = a + R( b – a ) Donde a y b son números reales y a < b, esta distribución es importante porque es utilizada en la generación de valores aleatorios de todas las distribuciones. Se obtiene mediante el método de la transformada inversa. En la figura 3.38 se presenta un fragmento de código en Java para la obtención de esta variable aleatoria. 3.6.2 Exponencial- expo(β) 1. Generar R ~ U(0,1) 2. Obtener la variable aleatoria X = -β ln R Donde β es la media de la variable aleatoria, β > 0. 3.6.3 m-Erlang- m-Erlang(β) 1. Generar R1, R2, …….. Rm ~ U(0,1) 2. Obtener la variable aleatoria con: m ln Ri m i 1 Donde β/ m es la media de la variable aleatoria, m es un número entero m > 0 y β > 0. En X el ejemplo 3,6 se muestra la generación de esta variable por el método de convolución. Weibull- Weibull(α , β) 1. Generar R ~ U(0,1) 2. Obtener la variable aleatoria con 1/ X (ln R) Donde, α es el parámetro de forma y β el parámetro de escala α, β > 0. Para obtener este algoritmo se utiliza el método de la transformada inversa. En la figura 3.40 se muestra parte del código. 3.6.4 3.6.5 Normal- N(μ, σ2) En el ejemplo 3.9 se obtuvo la variable aleatoria N(0,1), esta variable es muy importante y es conocida como la normal estándar, se utiliza para aceptar o rechazar resultados de experimentos. El algoritmo para generarla ya fue mostrado, a continuación se obtendrán variables aleatorias dada la media y la varianza. 1. Generar Y~ N(0,1) 2. Obtener la variable aleatoria X = μ+ σY 3.6.6 Lognormal- LN(μ, σ) Devore [2005] escribe que una variable aleatoria no negativa X tiene una distribución lognormal si la variable aleatoria Y = ln(X) tiene una distribución normal. Debido a esto la función acumulada de X se puede expresar en términos de la función acumulada de una normal estándar Z, para x > 0. En esta distribución los parámetros μ y σ son la media y desviación estándar de ln(X). 1. Generar Y ~ N(μ, σ2) 2. Obtener la variable aleatoria X = eY 3.6.7 Gamma- gamma(α,1) Si α es entero positivo existe forma cerrada en su distribución acumulada, facilitándose así la transformación de la variable aleatoria. Si n = α: 1. Generar E1, E2,……, En ~ expo(1) 2. Obtener la variable aleatoria como: X = E1+ E2+……+ En 3.6.8 Gamma- gamma(α, β) 1. Generar Y~ gamma(α,1) 2. Obtener la variable aleatoria cuando β>0 X= β Y 3.6.9 Beta- beta(α1, α2) 1. Generar Y1 ~ gamma(α1,1) y Y2 ~ gamma(α2,1) , independiente de Y1 2. Obtener la variable aleatoria X = Y1/ (Y1 + Y2) Donde α1, α2 > 0, y el rango son números reales positivos de cero a α1+ α2 – 1. Esta distribución no tiene forma cerrada, es usada como un modelo forzado, cuando hay ausencia de datos. La distribución U(0,1) y la distribución beta(1,1) son la misma. 3.6.10 Triangular- triang(0, 1, c) 1. Generar R ~ U(0,1) 2. Si R < c entonces la variable aleatoria es: es: X 1 (1 c)(1 R) X cR en otro caso 3.7 Pruebas estadísticas Con el fin de contestar la pregunta ¿los datos observados del sistema se comportan como cierta distribución de probabilidad?. Si la frecuencia de los datos observados se semeja de manera conveniente con la frecuencia teórica o esperada, entonces se puede utilizar la distribución teórica en el modelo para representar la población principal. En el Capítulo 2 se llevaron a cabo pruebas estadísticas para demostrar que los números aleatorios generados por computadora se comportaban como tales. Dentro de esas pruebas están las de bondad de ajuste que son la Chi cuadrada y la de KolmogorovSmirnov, las cuales se revisaron en su teoría y se utilizaron para probar la uniformidad de la distribución de los números pseudoaleatorios, a continuación se utilizarán estas pruebas para determinar si las variables aleatorias generadas corresponden a su distribución teórica. Ejemplo 3.11 Supóngase que se generan 200 variables aleatorias distribuidas binomialmente, con parámetros p=0.5 y t =5 las cuales se muestran en la tabla 3.3, en la tabla 3.4 se observan los resultados teóricos al aplicar los parámetros dados a la distribución de la función binomial, que es: t! t p ( x) ( p) (3.21) x x ! (t x) ! Solución: 1.- Formulación de la H0 H0: Las variables aleatorias generadas se comportan como binomiales con parámetros t = 5 y p = 0.5. Con un nivel de significancia de 0.05. 2.- Obtener las frecuencias observadas de la tabla 3.3. 3.- Obtener las frecuencias esperadas utilizando las probabilidades teóricas obtenidas de la tabla 3.4. 4.- Aplicar la prueba de χ2 a los resultados obtenidos en el paso 2 y 3 5.- Obtener las conclusiones. Tabla 3.3 Variables aleatorias bin(5,0.5) generadas con el algoritmo de la sección 3.5.3 i x i x i x i x i x i x i x 1 1 21 4 41 i x 2 61 i x 3 81 i x 4 101 0 121 2 141 3 161 2 181 2 2 3 22 4 42 3 62 1 82 2 102 4 122 1 142 3 162 1 182 2 3 3 23 5 43 3 63 2 83 3 103 3 123 5 143 2 163 4 183 3 4 4 24 4 44 3 64 3 84 3 104 1 124 1 144 2 164 2 184 2 5 3 25 2 45 2 65 1 85 2 105 1 125 2 145 3 165 1 185 3 6 0 26 4 46 4 66 4 86 2 106 3 126 1 146 3 166 1 186 3 7 2 27 3 47 3 67 1 87 3 107 1 127 2 147 4 167 4 187 3 8 2 28 2 48 2 68 3 88 1 108 1 128 2 148 3 168 2 188 5 9 2 29 4 49 2 69 2 89 2 109 3 129 3 149 4 169 2 189 4 10 1 30 3 50 3 70 5 90 3 110 4 130 4 150 4 170 3 190 2 11 2 31 2 51 5 71 0 91 2 111 2 131 2 151 2 171 3 191 3 12 2 32 2 52 0 72 4 92 4 112 1 132 2 152 1 172 3 192 5 13 4 33 4 53 3 73 2 93 3 113 2 133 2 153 4 173 4 193 4 14 4 34 1 54 3 74 4 94 2 114 2 134 2 154 2 174 1 194 1 15 3 35 0 55 3 75 3 95 3 115 2 135 3 155 3 175 2 195 1 16 0 36 2 56 0 76 4 96 2 116 5 136 1 156 3 176 2 196 5 17 3 37 3 57 2 77 1 97 3 117 1 137 3 157 2 177 4 197 5 18 3 38 2 58 2 78 3 98 2 118 3 138 2 158 2 178 1 198 3 19 1 39 2 59 1 79 4 99 3 119 2 139 4 159 4 179 4 199 4 20 4 40 4 60 2 80 3 100 1 120 2 140 4 160 3 180 3 200 3 Tabla 3.4: Valor teórico de probabilidad de la distribución bin(5,0.5) con la fórmula 3.21 x probabilidad teórica 0 0.03125 1 0.15625 2 0.3125 3 0.3125 4 0.15625 5 0.03125 Tabla 3.5 Aplicación de la prueba χ2 al ejemplo 3.11 (O - E)2 x Frecuencia Frecuencia observada esperada 0 7 6.25 0.09 1 29 31.25 0.162 2 61 62.5 0.036 3 58 62.5 0.324 4 36 31.25 0.722 5 9 6.25 1.21 200 E 200 χ2 = 2.544 El resultado de la χ2 calculada es de 2.544 y el valor teórico correspondiente a χ (γ,α) = χ2(5,0.05) obteniéndose de la tabla A.2, χ2 = 11.07, entonces, como χ2 calculada es menor que la χ 2 teórica, no hay motivo para rechazar la hipótesis nula planteada al inicio de la solución del problema. 2 Conclusión: Las variables aleatorias mostradas en la tabla 3.2 se comportan como variables aleatorias binomiales dado p=0.5 y t =5. 3.9 Ejercicios: 1. ¿Parámetros de una distribución uniforme continua? a) Parámetro de escala λ > 0. b) Límite inferior a, límite superior b. c) Parámetro de escala β > 0, parámetro de forma α > 0. 2. ¿Cuáles son los parámetros de la distribución exponencial? a) Parámetro de escala λ > 0. b) Parámetro de escala β > 0, parámetro de forma α> 0. c) Parámetro de localización µ, parámetro de escala α. 3. ¿Cuáles son los parámetros de la distribución triangular? a) Límite inferior a, límite superior b. b) Parámetro de escala λ > 0. c) Parámetro de localización µ, parámetro de escala α. d) Parámetro de escala β > 0, parámetro de forma α > 0. 4. ¿Cuáles son los parámetros de la distribución Normal? a) Parámetro de escala β > 0, parámetro de forma α > 0. b) Parámetro de localización µ, parámetro de escala α. c) Parámetro de localización µ, parámetro de escala σ. d) Parámetro de escala µ > 0, parámetro de forma σ 5. ¿Para determinar el tipo de una distribución de probabilidad, se cuenta con la herramienta estadística de? a) Prueba F de Fisher. b) Prueba de medias. c) Prueba de bondad de ajuste. 6. Si usted, de una serie de datos ha obtenido un valor de la media de 0.5147 y un valor de la variancia de 0.5995 y ha decidido comparar la serie de datos con una distribución de probabilidad Poisson mediante la utilización de una prueba χ2. ¿Qué valores de parámetros propondría? a) Media igual a 0.5147. b) Media igual a 0.5147 y variancia igual a 0.5995. c) Cualquiera de los dos anteriores. d) Media igual a 0.5571. 7. Generar por el método de la transformada inversa variables aleatorias que siguen la siguiente distribución. ( x 3) 2 f ( x) 18 0 si 0 x 6 si 6 x 0 8. Generar por el método del rechazo la siguiente obtener valores aleatorios. distribución de probabilidad para f(x) ¾ 1 ¼ 1 2 x BIBLIOGRAFÍA 1. Barceló, Jaime: Simulación de sistemas discretos, Isdefe, Madrid, 2006. 2. Coss Bu, Raúl: Simulación: un enfoque práctico, Editorial Limusa, México, 1992. 3. Dagpunar, J.S.: Simulation and Monte Carlo: With applications in finance and MCMC, John Wiley& Sons, Ltd., England,2007 4. Devore, Jay L.; Probabilidad y estadística para ingeniería y ciencias; Ed. Thompson, México; 2005; Sexta Edición; 794 pp; ISBN: 9706864571 5. De la Horra Navarro, J.: Estadística Aplicada; Ediciones Díaz Santos; Madrid 2003, ISBN: 84 7978 554 3 6. Fábregas Ariza, A., Simulación de sistemas productivos con Arena, Universidad del Norte, 2003, ISBN: 9588133246, 206 pp 7. Gordon, Geoffrey, Simulación de sistemas, Editorial Diana, México,1980, Reimp.1989 8. Guasch, A., Piera, M.A. et al: Modelado y simulación Aplicación a procesos logísticos de fabricación y servicios, Ed. Alfaomega, México, 2005. 9. Guisande González, Cástor…et al; Tratamiento de datos; Ed. Díaz de Santos; Madrid; 2006; ISBN 8479787368. 10. Johnson, Robert: Estadística elemental: Lo esencial, Thompson Learning Ibero, 2004, ISBN 9706862870 11. Khoshnevis, B. : Discrete Systems Simulation, McGraw-Hill, 1994. 12. Law, Averill M.,Kelton, W. David: Simulation Modeling &Analysis, Ed. McGraw-Hill, 1991. 13. Mendenhall, W., Beaber, R..J. y Beaber, B.M., Introducción a la probabilidad y estadística, Thompson, 2002, 618 pp, ISBN: 9706861955 14. Myers, R.H., Walpole, R.E.; Probabilidad y estadística para ingenieros; Pearson Educación; 1999; 739 p.p.; ISBN: 9701702646 15. Pierá, M.A. et al; Como mejorar la logística de su empresa mediante la simulación; Ediciones Díaz de Santos; 2007; 103 pp ISBN8479787384 16. Ríos Insua, D.,Ríos Insua S., Martín Jiménez, J.: Simulación: Métodos y aplicaciones, Alfaomega-RA-MA, 2000. 17. Schmidt, J.W, Taylor, R.E.: Análisis y simulación de sistemas industriales, Editorial Trillas, México, 1979, Primera Ed. 18. Taha, Hamdy A.: Investigación de operaciones, Pearson Educación, Séptima Edición, 2004 19. Piera, M. A., Guasch, T. et al: Como mejorar la logística de su empresa mediante la simulación, Ediciones Díaz de Santos S.A., 2006, ISBN 84-7978738-4 20. Wackerly D.D., Mendenhall W. y Scheaffer R.L.; Estadística matemática con aplicaciones; Ed. Thompson; México; 2002; Sexta Edición; 876 pp; ISBN: 9706861947 21. Walpole, R.H., Myers, R.E.: Probabilidad y estadística para ingenieros; Pearson Educación; México; 1999; ISBN 97001702646. 22. Weiers, R.M.; Introducción a la estadística para negocios; Ed. Thompson; México; 2005; 5ª Ed.; ISBN 97068644377. 23. Winston,Wayne L.: Investigación de operaciones, Ed. Thompson, México, 2005,Cuarta Ed. 24. COMPILADO POR GRACIELA MORA OTERO