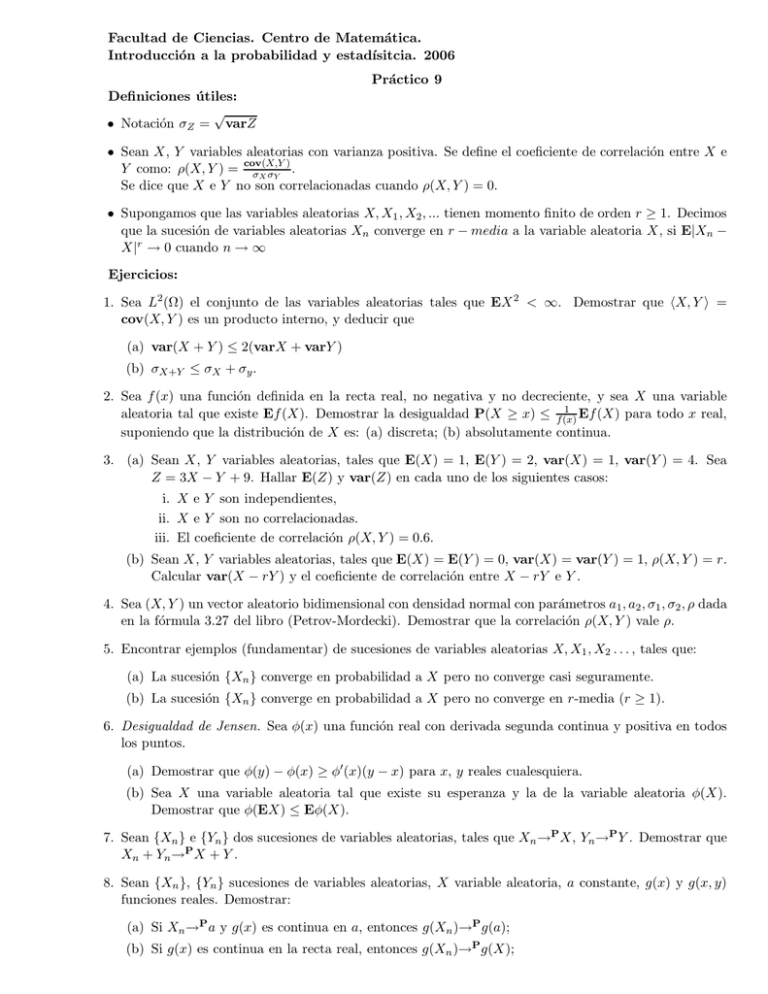

Facultad de Ciencias. Centro de Matemática. Introducción a la

Anuncio

Facultad de Ciencias. Centro de Matemática.

Introducción a la probabilidad y estadı́sitcia. 2006

Práctico 9

Definiciones útiles:

√

• Notación σZ = varZ

• Sean X, Y variables aleatorias con varianza positiva. Se define el coeficiente de correlación entre X e

)

Y como: ρ(X, Y ) = cov(X,Y

σX σY .

Se dice que X e Y no son correlacionadas cuando ρ(X, Y ) = 0.

• Supongamos que las variables aleatorias X, X1 , X2 , ... tienen momento finito de orden r ≥ 1. Decimos

que la sucesión de variables aleatorias Xn converge en r − media a la variable aleatoria X, si E|Xn −

X|r → 0 cuando n → ∞

Ejercicios:

1. Sea L2 (Ω) el conjunto de las variables aleatorias tales que EX 2 < ∞. Demostrar que hX, Y i =

cov(X, Y ) es un producto interno, y deducir que

(a) var(X + Y ) ≤ 2(varX + varY )

(b) σX+Y ≤ σX + σy .

2. Sea f (x) una función definida en la recta real, no negativa y no decreciente, y sea X una variable

1

Ef (X) para todo x real,

aleatoria tal que existe Ef (X). Demostrar la desigualdad P(X ≥ x) ≤ f (x)

suponiendo que la distribución de X es: (a) discreta; (b) absolutamente continua.

3. (a) Sean X, Y variables aleatorias, tales que E(X) = 1, E(Y ) = 2, var(X) = 1, var(Y ) = 4. Sea

Z = 3X − Y + 9. Hallar E(Z) y var(Z) en cada uno de los siguientes casos:

i. X e Y son independientes,

ii. X e Y son no correlacionadas.

iii. El coeficiente de correlación ρ(X, Y ) = 0.6.

(b) Sean X, Y variables aleatorias, tales que E(X) = E(Y ) = 0, var(X) = var(Y ) = 1, ρ(X, Y ) = r.

Calcular var(X − rY ) y el coeficiente de correlación entre X − rY e Y .

4. Sea (X, Y ) un vector aleatorio bidimensional con densidad normal con parámetros a1 , a2 , σ1 , σ2 , ρ dada

en la fórmula 3.27 del libro (Petrov-Mordecki). Demostrar que la correlación ρ(X, Y ) vale ρ.

5. Encontrar ejemplos (fundamentar) de sucesiones de variables aleatorias X, X1 , X2 . . . , tales que:

(a) La sucesión {Xn } converge en probabilidad a X pero no converge casi seguramente.

(b) La sucesión {Xn } converge en probabilidad a X pero no converge en r-media (r ≥ 1).

6. Desigualdad de Jensen. Sea φ(x) una función real con derivada segunda continua y positiva en todos

los puntos.

(a) Demostrar que φ(y) − φ(x) ≥ φ′ (x)(y − x) para x, y reales cualesquiera.

(b) Sea X una variable aleatoria tal que existe su esperanza y la de la variable aleatoria φ(X).

Demostrar que φ(EX) ≤ Eφ(X).

7. Sean {Xn } e {Yn } dos sucesiones de variables aleatorias, tales que Xn →P X, Yn →P Y . Demostrar que

Xn + Yn →P X + Y .

8. Sean {Xn }, {Yn } sucesiones de variables aleatorias, X variable aleatoria, a constante, g(x) y g(x, y)

funciones reales. Demostrar:

(a) Si Xn →P a y g(x) es continua en a, entonces g(Xn )→P g(a);

(b) Si g(x) es continua en la recta real, entonces g(Xn )→P g(X);

(c) Si g(x, y) es continua en R2 , entonces g(Xn , Yn )→P g(X, Y ).

9. Sea {Xn } una sucesión de variables aleatorias independientes con distribución exponencial con parámetro

λ.

(a) Probar que αn = min{X1 , . . . Xn } tiende en probabilidad a cero.

(b) Probar que αn converge casi seguramente a cero.

10. Sea {Xn } una sucesión de variables aleatorias independientes con distribución uniforme en [0, a]. Se

desconoce el valor de a, y se desea “estimar” por medio de una variable aleatoria.

(a) Probar que βn = max{X1 , . . . Xn } tiende en probabilidad a a.

(b) Probar que βn = max{X1 , . . . Xn } tiende casi seguramente a a.

(c) ¿qué se puede decir de la sucesión E(βn )?

11. Método de Monte Carlo. Sea f : [0,RT ] → R una función no negativa, continua, acotada por una

1

constante a. Se desea estimar I = 0 f (x)dx. Consideramos una sucesión de vectores aleatorios

independientes (Xk , Yk ) en R2 , con distribución P

uniforme en [0, T ] × [0, a]. Sea la sucesión Zk =

N

1{Yk ≤f (Xk )} (k = 1, 2, . . . ), y definimos IˆN = aT

k=1 Zk .

N

(a) Probar que IˆN converge casi seguramente a I cuando N → ∞.

(b) Hallar el valor esperado de IN y su varianza.

(c) Se busca acotar el error |IˆN −I|. Dado δ > 0, indicar cómo elegir N para que [var(IˆN −I)]1/2 < δ.

(d) Hallar un estimador para el caso de integrales múltiples. Hallar la varianza, y comparar el orden

de esta con el de la varianza del estimador hallado para el caso de integrales simples.