Capítulo 9: Diagonalización de matrices

Anuncio

Capítulo 9: Diagonalización de matrices

1.

Lección 33. Transformaciones lineales

Del mismo modo que el estudio de las funciones usuales es importante para

analizar las relaciones y la evolución de magnitudes escalares, es conveniente

también estudiar funciones para magnitudes vectoriales; o para magnitudes

cuyos valores son vectores de un espacio de más de 3 dimensiones.

Las funciones más sencillas en que las variables son vectores en lugar de

escalares son las transformaciones lineales.

Una transformación lineal de Rn es una función f : Rn → Rn en que las

variables son vectores, y que está dada por una ecuación matricial lineal

[(y)] = [f (x)] = A · [x]

donde A es una matriz n × n y [x] (respectivamente, [(y)]) es la matriz-columna

del vector x (resp., del vector (y)).

Ejemplo 1. Una transformación lineal de R3 es la

−1

3 1

2 0 ·

[f (x, y, z)] = −1

3 −2 4

dada por la ecuación

x

y

z

La anterior transformación lineal puede darse de forma más desarrollada

como

f (x, y, z) = (−x + 3y + z, −x + 2y, 3x − 2y + 4z)

Por ejemplo, f (0, 1, 2) = (5, 2, 6).

Algunas propiedades de las transformaciones lineales son las siguientes (en

lo que sigue, f es cualquier transformación lineal, u, v vectores cualesquiera, r

cualquier escalar).

1. Conservación de sumas y productos por escalares.

f (u + v) = f (u) + f (v),

f (rv) = rf (v)

2. Conservación de combinaciones lineales.

f (r1 v1 + · · · + rk vk ) = r1 f (v1 ) + · · · + rk f (vk )

1

1.1.

Matriz de una transformación lineal

Si f : Rn → Rn es una transformación lineal dada por la ecuación matricial

[f (x)] = A · [x], entonces decimos que A es la matriz de la transformación, y

escribimos A = M (f ).

Para el comentario siguiente, nos centramos en el caso n = 3, aunque se

pueden hacer consideraciones análogas en cualquier otro caso. Sea f : R3 → R3

una transformación lineal, y sea A = M (f ). Los vectores

→

−

e1 = i = (1, 0, 0),

→

−

e2 = j = (0, 1, 0),

→

−

e3 = k = (0, 0, 1)

forman la base canónica de R3 . Si denotamos los elementos de la matriz A como

los aij , entonces

f (e1 ) = (a11 , a21 , a31 ),

f (e2 ) = (a12 , a22 , a32 ),

f (e3 ) = (a13 , a23 , a33 )

Es decir, la matriz A de la transformación lineal es la matriz de la sucesión

de vectores f (e1 ), f (e2 ), f (e3 ).

Por consiguiente, para conocer la matriz de la transformación f , basta conocer los valores f (ei ) para los vectores ei de la base canónica.

Veamos algunos ejemplos en que podemos escribir la matriz de la transformación a partir de las imágenes de los vectores de la base.

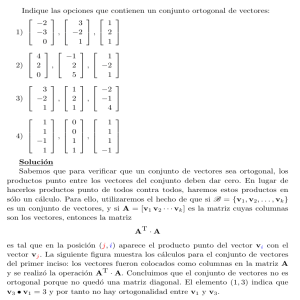

Ejercicio 1. Calcular la matriz de la transformación lineal que lleva cada

vector del plano R2 a su simétrico con respecto al eje horizontal.

La transformación lleva los puntos P, Q, R a P 0 , Q0 , R0 respectivamente.

6

rQ

rR 0

rR

r

P =P 0

r

Q0

De acuerdo con la descripción de la transformación, tendremos que (1, 0) 7→

(1, 0), puesto que los puntos del eje horizontal quedan fijos. Por otra parte, el

punto (0, 1) va a su simétrico, (0, 1) 7→ (0, −1).

La matriz será pues

1

0

0 −1

Naturalmente, conocida lamatriz podemos

calcular

f (v) para

cualquier vec1

0

−2

−2

tor. Por ejemplo, f (−2, 3) =

·

=

.

0 −1

3

−3

Luego f (v) = (−2, −3).

Ejercicio 2. Calcular la matriz de la transformación lineal de R2 que lleva

cada vector a su proyección en el eje vertical.

2

r6

Q=Q0

r

r

-

P0

P

R0

r

rR

Se tiene que (1, 0) 7→ (0, 0) y (0, 1) → (0, 1). Por tanto la matriz será

0 0

0 1

De ese modo, tendremos f (a, b) = (0, b), para cualquier vector (a, b) ∈ R2 .

Ejercicio 3. Calcular la matriz de la transformación gα del plano que consiste en girar cada vector un ángulo α en sentido positivo alrededor del origen.

Q0

r r6

Q

P 0r

r P

Usando la representación geométrica, se puede ver que gα (1, 0) = (cos α, sen α)

y que gα (0, 1) = (−sen α, cos α).

Por tanto, la matriz de la transformación será

cos α −sen α

M (gα ) =

sen α

cos α

De este modo, para cualquier vector (a, b) se tiene

gα (a, b) = (acos α − bsen α, asen α + bcos α)

1.2.

Cambio de base y transformaciones lineales

Supongamos ahora que queremos hallar la matriz de la transformación de

R2 que lleva cada vector a su simétrico respecto de la recta x = 2y.

6rQ

r 0

R=R

P r

r

0

Q

P0 r

v2

6

KAA

v =f (v 1 )

* 1

A

A

AAU f (v )

2

Calcular los vectores f (e1 ) y f (e2 ) no es ahora tan directo como en los ejemplos anteriores. Ocurre, sin embargo, que hay otros vectores v1 , v2 que forman

base y para los cuales es fácil calcular las imágenes.

En efecto, tomando v1 = (2, 1) que está en la recta x = 2y, este vector

queda fijo por la transformación, de modo que f (v1 ) = v1 . También el vector

3

perpendicular a dicha recta v2 = (−1, 2) cumple que f (v2 ) = −v2 , como se ve

en la figura.

Vamos ahora a hacer algunas consideraciones generales sobre estas situaciones, y volveremos al ejemplo más adelante.

Sea f : Rn → Rn una transformación lineal y sea B = {u1 , u2 , . . . , un } una

base de Rn . Para cada vector x, escribimos [x]B para indicar la matriz columna

cuyos elementos son las coordenadas de x con respecto a la base B.

Llamamos matriz de la transformación f respecto de la base B, MB (f ), a la

matriz n × n cuyas columnas son [f (u1 )]B , [f (u2 )]B , . . . , [f (un )]B .

Volviendo al ejemplo del comienzo de este apartado, se tiene que los vectores

v1 , v2 forman una base B, porque la matriz de esa sucesión de vectores es

2 −1

P =

1

2

y su determinante es 6= 0.

Se tiene:

f (v2 ) = −v2

f (v1 ) = v1 ,

y además

[f (v1 )]B =

1

0

,

[f (v2 )]B =

0

−1

Por lo tanto,

MB (f ) =

1

0

0 −1

Sabiendo MB (f ), se puede calcular la matriz M (f ) de la transformación.

Podemos ver en general de qué modo se hace esto.

Sea A = M (f ) y C = MB (f ). Sea P , como antes, la matriz de la sucesión

de vectores que forman la base. Como vimos en el capítulo anterior, se tiene

P · [v]B = [v]

Por la misma razón, se tendrá

P · [f (v)]B = [f (v)]

Por ser A la matriz de la transformación lineal, se tiene

A · [v] = [f (v)]

Esta igualdad vale también cuando tomamos la matriz de la transformación

en otra base:

C · [v]B = [f (v)]B

Por lo tanto, tenemos

P · C · [v]B = P · [f (v)]B = [f (v)] = A · [v] = A · P · [v]B

Del hecho de que esta igualdad se cumple para todo v, se obtiene enseguida

que P · C = A · P .

4

Escribimos esta ecuación a la que hemos llegado en forma más completa:

M (f ) = P · MB (f ) · P −1

P · MB (f ) = M (f ) · P,

Volviendo al ejemplo anterior, hemos visto que

1

0

2 −1

MB (f ) =

, P =

0 −1

1

2

Calculando la inversa, tenemos

P

−1

1

=

5

2

−1

1

2

Luego

1

M (f ) =

5

2 −1

1

2

1

0

2

·

·

0 −1

−1

1

2

=

3/5

4/5

4/5 −3/5

De esta manera se hace el cambio de base de la matriz de una transformación

lineal.

Ejercicio 4.Sabiendo que la matriz de una transformación lineal g es

0 −2 2

−1

0 1 , calcular la matriz de g con respecto a la base B = {(1, 1, 1), (0, 1, 1), (1, 0, 1)}.

−1 −2 3

La matriz de la nueva base será

1

P = 1

1

0

1

1

1

0

1

Si calculamos su inversa por el procedimiento visto en el capítulo anterior,

tendremos

1

1 −1

0

1

P −1 = −1

0 −1

1

Como sabemos que se tiene M (g) = P · MB (g) · P −1 , podemos despejar

MB (g) para obtener

MB (g) = P −1 · M (f ) · P

Como conocemos las tres matrices de

obtenemos

0

MB (g) = 0

0

1.3.

la derecha, hacemos su producto y

0 0

1 0

0 2

Composición de transformaciones

f

g

Dos transformaciones Rn → Rn → Rn se pueden componer; y g ◦ f es

una transformación lineal de Rn si f, g son transformaciones lineales. Se tiene

(g ◦ f )(v) = g(f (v)).

5

Para cualquier vector v ∈ Rn se tiene entonces

[g(f (v))] = M (g) · [f (v)] = M (g) · (M (f ) · [v])

Pero como debe ser

[g(f (v))] = M (g ◦ f )[v]

vemos que, para que esta igualdad se verifique para todo v, debe tenerse

M (g ◦ f ) = M (g) · M (f )

Así, la matriz de una compuesta es igual al producto de las matrices de cada

factor (en el orden indicado).

Vamos a ver algún ejemplo.

Ejercicio 5. Hallar la composición de dos giros en el plano.

Sean gα y gβ los giros (alrededor del origen) de ángulos α, β respectivamente.

Se tiene

cos α −sen α

cos β −sen β

M (gα ) =

, M (gβ ) =

sen α

cos α

sen β

cos β

Su compuesta gβ ◦ gα tendrá la matriz producto

cos βcos α − sen βsen α −cos βsen α − sen βcos α

sen βcos α + cos βsen α −sen βsen α + cos βcos α

Por conocidas relaciones trigonométricas, esta matriz será

cos(α + β) −sen(α + β)

sen(α + β)

cos(α + β)

Pero esta es la matriz del giro de ángulo α + β. Luego la composición será

gβ ◦ gα = gα+β

Ejercicio 6. En R2 , sea g el giro de ángulo

a la recta y = x. Calcular g ◦ h y h ◦ g.

π

2

y sea h la simetría con respecto

Empezaremos por escribir las matrices M (g) y M (h), viendo la acción de

estas transformaciones sobre la base canónica e1 = (1, 0) y e2 = (0, 1).

En primer lugar, el giro g cumplirá g(e1 ) = e2 y g(e2 ) = −e1 . En cuanto a

la simetría h:

=h(ı)

6

ı=h()

cumple que h(e1 ) = e2 y h(e2 ) = e1 .

De esta manera, se tiene

0 −1

M (g) =

,

1

0

6

M (h) =

0

1

1

0

Haciendo los productos, tendremos

1

0

0 −1

−1

0

M (h ◦ g) = M (h) · M (g) =

M (g ◦ h) = M (g) · M (h) =

0

1

Se puede comprobar que M (h ◦ g) coincide con la matriz de la simetría con

respecto al eje horizontal (recta y = 0). De este modo, h ◦ g es la simetría con

respecto al eje horizontal.

Por otro lado, la matriz M (g ◦ h) coincide con la matriz de la simetría con

respecto al eje vertical (recta x = 0). Luego g ◦ h es la simetría con respecto al

eje vertical.

En general, la compuesta en el plano de un giro (alrededor del origen) y una

simetría (respecto de una recta que pasa por el origen) es una simetría. En las

mismas condiciones, la composición de dos simetrías es un giro.

2.

2.1.

Lección 34. Vectores y valores propios

Vectores propios

Consideremos de nuevo una simetría respecto de una recta en el plano. Sea

r la recta de ecuación general mx − y = 0 y sea f la simetría respecto de esa

recta.

Como hemos comentado en la lección anterior, no es totalmente directo calcular las imágenes f (e1 ), f (e2 ) de los vectores de la base canónica. Sin embargo,

si tomamos u1 = (1, m), vemos que ese vector tiene la dirección del eje de

simetría r. Por tanto, f (u1 ) = u1 .

Del mismo modo, la recta x + my = 0 es perpendicular a r. Así, el vector

u2 = (m, −1) tiene dirección perpendicular al eje de simetría. Por tanto, f (u2 ) =

−u2 . Estas propiedades hacen que sea fácil determinar la matriz de f respecto

de la base formada por los vectores u1 , u2 .

De modo más general, las transformaciones lineales pueden tener ciertas

direcciones privilegiadas, de manera que los vectores en esa dirección se transforman en vectores con la misma dirección. Estos vectores, llamados vectores

propios de la transformación, son importantes para describir la transformación;

al mismo tiempo, esos vectores pueden proporcionar bases con respecto a las

cuales la matriz de la transformación tiene una forma sencilla.

Definición 1. Sea f : Rn → Rn una transformación lineal. Un vector v ∈ Rn

se dice que es un vector propio para la transformación f cuando v 6= 0 y existe

un número λ de manera que se tiene

f (v) = λv

En el ejemplo de la simetría anterior, u1 era un vector propio, porque f (u1 ) =

u1 = 1 · u1 . También u2 es vector propio en esa transformación porque f (u2 ) =

−u2 = −1 · u2 .

7

Si v es un vector propio para la transformación f , entonces el escalar λ que

cumple la ecuación f (v) = λv está determinado por v. λ se llama el valor propio

asociado a v.

Una matriz cuadrada A de orden n determina una transformación lineal f

tal que M (f ) = A. La condición de que un vector v 6= 0 sea un vector propio

para f se puede poner en términos de la matriz A. En efecto,

[f (v)] = A · [v],

f (v) = λv ⇔ A · [v] = λ[v] = (λIn ) · [v]

Por tanto, v es vector propio para f si y solo si existe un escalar λ de modo

que se satisface la ecuación matricial A · [v] = (λIn )[v]. Podemos poner esta

ecuación en la forma

(λIn − A)[v] = 0

Sea M (f ) = A. Los vectores propios para f se llaman también vectores

propios de la matriz A. Las consideraciones anteriores muestran que v 6= 0 es

un vector propio de la matriz A si y solo si existe un escalar λ tal que

(λIn − A)[v] = 0

donde 0 es una matriz columna nula.

2.2.

Cálculo de los vectores propios

Cuando conocemos el valor propio λ, es fácil calcular los vectores propios

correspondientes a dicho valor propio, porque se trata de resolver un sistema de

ecuaciones lineales (homogéneas).

Ejercicio 1. Dada la matriz

1

A = −1

−2

2

4

2

2

1

5

hallar los vectores propios correspondientes al valor λ = 3.

Sabemos que los vectores que buscamos son los que verifican la ecuación

matricial (3I3 − A)[v] = 0. Así, debemos escribir la matriz 3I3 − A.

3 0 0

1 2 2

2 −2 −2

3I3 − A = 0 3 0 − −1 4 1 − = 1 −1 −1

0 0 3

−2 2 5

2 −2 −2

La ecuación que da los

2

1

2

vectores propios es

−2 −2

x

0

−1 −1 · y = 0

−2 −2

z

0

Este es un sistema homogéneo que puede resolverse por el método general.

La resolución nos conduce a la ecuación x−y −z = 0 solamente. Para cada valor

de y, z obtenemos una solución, x = y + z. Aparece así un conjunto doblemente

infinito (un plano) de soluciones: es el conjunto de todos los vectores directores

8

del plano x − y − z = 0. Ahora bien: para describir este conjunto basta dar dos

vectores linealmente independientes de ese conjunto: todos los demás son sus

combinaciones lineales.

Por ejemplo, podemos tomar los vectores (1, 1, 0) y (1, 0, 1), que se obtienen

tomando y = 1, z = 0 o y = 0, z = 1, respectivamente. Estos son vectores

propios (con el valor propio λ = 3) y todas sus combinaciones lineales son

vectores propios (excepto el vector 0; pero en adelante se sobreentenderá esta

excepción).

Tenemos, por tanto, esas dos maneras de describir la colección de los vectores

propios (con valor propio λ): (1) son todos los del plano x − y − z = 0; y (2) son

todas las combinaciones lineales de los vectores (1, 1, 0), (1, 0, 1).

2.3.

Cálculo de los valores propios

Cuando se conoce el valor propio λ, es sencillo como hemos visto hallar los

vectores propios correspondientes. Sin embargo, el problema principal cuando

se trata de calcular los vectores propios de una transformación lineal es hallar

cuáles pueden ser los valores propios.

Definición 2. Sea A una matriz cuadrada, de modo que A = M (f ) para

alguna transformación lineal f . Un escalar λ se llama un valor propio para la

matriz A cuando existe algún vector propio de la transformación f con valor

propio λ (por ser vector propio ha de ser 6= 0).

Cualquier escalar λ da lugar a una ecuación matricial (o sistema homogéneo)

(λIn − A)X = 0

donde X es la matriz n × 1 de las incógnitas. Por la definición, λ es un valor

propio si y solo si esa ecuación tiene alguna solución X 6= 0.

El sistema de ecuaciones anterior (λIn − A)X = 0 tiene siempre la solución

X = 0 (y por tanto es un sistema compatible). Esta se llama la solución trivial.

Por tanto, si el sistema es compatible determinado, esa será la única solución y,

en consecuencia, λ no será un valor propio.

Por el contrario, si el sistema es compatible indeterminado, entonces tiene

soluciones distintas de la solución trivial. Esas soluciones darán efectivamente

vectores propios, y λ será un valor propio.

Usamos el teorema de Rouché para dar la conclusión de la discusión anterior.

El sistema homogéneo cuya matriz es λIn − A es determinado si y solo si esa

matriz tiene rango n. Por tanto, λ es un valor propio si y solo si rg(λIn −A) < n.

A su vez, el rango de dicha matriz es n si y solo si la matriz es regular, si y

solo si su determinante es no nulo. En definitiva, tenemos:

Proposición 1. λ es un valor propio de la matriz cuadrada A de orden n si

y solo si

|λIn − A| = 0

Puesto de otro modo: los valores propios de la matriz cuadrada A de orden

n son las soluciones de la ecuación |xIn − A| = 0.

9

Definición 3. Si A es una matriz cuadrada de orden n, el desarrollo del

determinante |xIn − A| es un polinomio, que se llama el polinomio característico

de la matriz A.

Los valores propios de la matriz A son las raíces de su polinomio característico.

Ejercicio 2. Hallar los valores propios de la matriz del ejercicio 1.

La matriz era

1

−1

−2

2

4

2

2

1

5

El polinomio característico es

x − 1

−2

−2 1

x−4

−1 =

2

−2

x − 5

= (x−1)(x−4)(x−5)+4+4−2(x−1)+2(x−5)+4(x−4) = x3 −10x2 +29x−20+8+4x−24

Esto nos dará

pc(A) = x3 − 10x2 + 33x − 36

El problema de hallar las raíces de un polinomio no es, en general, fácil. En

este caso, sin embargo, tenemos éxito buscando raíces enteras, que han de ser

divisores de 36. Probando, podemos ver que 3 es una raíz y en definitiva que

pc(A) = (x − 3)2 (x − 4)

Luego 3, 4 son los valores propios de A.

Ejercicio 3. Calcular todos los vectores propios de la matriz A del ejercicio

anterior.

Hemos calculado ya los valores propios. Son λ = 3 (con multiplicidad 2; es

decir, (x − 3)2 es un factor del polinomio característico) y λ = 4.

Hemos hallado en el ejercicio 1 los vectores propios de valor propio 3: son

todos los vectores que son combinación lineal de (1, 1, 0), (1, 0, 1). Nos falta hallar

los vectores propios para el valor propio 4.

Sabemos que (las coordenadas de) dichos vectores son las soluciones del

sistema de ecuaciones

(4I3 − A)X = 0

es

Es decir, las soluciones del sistema homogéneo cuya matriz de coeficientes

4 0 0

1 2 2

3 −2 −2

0 4 0 − −1 4 1 = 1

0 −1

0 0 4

−2 2 5

2 −2 −1

Haciendo transformaciones elementales de filas (y cambiando el orden de las

indeterminadas y, z), podemos cambiar la matriz

10

1

−3

−2

0 −1

2

2 ,

2

1

1 −1 0

−2

1 2 ,

−3

2 2

1 −1 0

0 −1 2

0 −1 2

Al final, el sistema es equivalente a:

x − z = 0,

−z + 2y = 0

El conjunto de soluciones es simplemente infinito, puesto que podemos darlo

en función de un solo parámetro, la incógnita y, por ejemplo. Dándole el valor

y = 1 a esa incógnita, obtenemos z = 2 = x. Luego el vector (2, 1, 2) es un

vector propio para el valor λ = 4.

Los demás vectores propios para ese valor son combinaciones lineales de

dicho vector, porque solamente hay una incógnita cuyo valor se puede elegir

libremente.

−5 12

Ejercicio 4. Hallar los vectores propios de la matriz A =

−4

9

Hay que calcular primero el polinomio característico.

x + 5 −12 = x2 − 4x − 45 + 48 = x2 − 4x + 3

4

x − 9

Los valores propios son las raíces del polinomio característico. En este caso,

√

4±2

4 ± 16 − 12

=

x=

2

2

lo que da las dos raíces 1, 3.

Ahora, hay que hallar los vectores propios para cada uno de esos dos valores

propios.

(i) Con λ = 1, calculamos la matriz λI2 − A = I2 − A. Será

6 −12

4 −8

Los vectores propios para ese valor son las soluciones del sistema de ecuaciones (I2 − A)X = 0.

El sistema dado es equivalente a la ecuación x − y = 0. Esto da un conjunto simplemente infinito de soluciones, tomando y = t como parámetro. Todas

ellas son combinación lineal de una solución no trivial cualquiera. Por ejemplo,

podemos tomar u1 = (1, 1). Todos los vectores propios para el valor propio 1

son combinaciones de este.

(ii) Ahora tomamos λ = 3. La matriz 3I2 − A será

8 −12

4 −6

El sistema de ecuaciones para calcular los vectores propios será ahora

8 −12

x

0

·

=

4 −6

y

0

11

El sistema resulta equivalente ahora a la ecuación

2x − 3y = 0

El conjunto de soluciones es simplemente infinito y está formado por todos

los vectores que son combinación lineal de (3, 2).

3.

3.1.

Lección 35. Diagonalización de matrices cuadradas

Matrices diagonales

Además del interés que tienen por dar las direcciones invariantes de una

transformación lineal, los vectores propios pueden ayudar a escribir la matriz de

la transformación lineal en una forma especialmente sencilla.

Una matriz cuadrada A = (aij ) se llama diagonal cuando se verifica que

aij = 0 siempre que sea i 6= j.

La condición indica simplemente que los elementos de la matriz que están

fuera de la diagonal principal son todos nulos.

Proposición 1. Si f : Rn → Rn es una transformación lineal y B es una

base de Rn que está formada por vectores propios para f , entonces la matriz de

f con respecto a la base B es una matriz diagonal.

La razón de esta propiedad es que si B = {u1 , . . . , un } y cada vector ui es

propio, entonces existen escalares λ1 , . . . , λn (iguales o distintos) de forma que

f (ui ) = λi ui .

Como la columna j de MB (f ) debe ser [f (uj )]B , tendremos que dicha columna j tendrá el elemento λj en el lugar j-ésimo, y 0 en todos los demás. En efecto,

f (uj ) = λj uj = 0u1 + 0u2 + · · · + λj uj + · · · + 0un

De ese modo, la matriz MB (f ) tiene en cada columna j al elemento λj en

el lugar (j, j) de la diagonal; y ceros en los demás lugares. Luego la matriz es

efectivamente diagonal.

Proposición 2. Sea A una matriz cuadrada de orden n, y sea f la transformación lineal dada por esa matriz, A = M (f ). Supongamos que existe una

base B de Rn formada por vectores propios de la matriz A, y sea P la matriz

de los vectores de esa base. Entonces existe una matriz diagonal D tal que

A = P · D · P −1

Esto se debe a que, en las condiciones de la proposición, MB (f ) es una

matriz diagonal. Si llamamos D = MB (f ), entonces P · D · P −1 = M (f ) = A,

por el resultado visto en la lección 33 sobre la relación entre matrices de una

transformación lineal.

Cuando ocurre la situación de la proposición anterior, hay básicamente una

única matriz diagonal D que cumpla una ecuación de la forma A = Q · D · Q−1 ,

siendo Q una matriz invertible (en realidad, D no es única, pero solamente

porque podemos cambiar el orden en que aparecen los elementos de la diagonal).

12

Esa matriz diagonal D se llama la diagonalización de la matriz A, o la forma

diagonal de A. La matriz Q que cumple la ecuación A = Q·D ·Q−1 es invertible,

y se llama una matriz de paso de la diagonalización. La matriz de paso no está

unívocamente determinada por A.

Una matriz cuadrada puede tener una diagonalización o no. Las matrices

cuadradas que tienen una diagonalización se llaman matrices diagonalizables.

Proposición 3. Una matriz cuadrada A de orden n es diagonalizable si y

solo si existe una base de Rn que está formada por vectores propios para la

matriz A.

La manera de determinar si una matriz es diagonalizable es calcular todos

sus vectores propios y encontrar si se puede construir una base formada por

vectores propios.

La condición necesaria y suficiente para que la matriz A sea diagonalizable

es que el polinomio característico no tenga raíces complejas no reales; y que para

cada valor propio λ cuya multiplicidad como raíz del polinomio característico

sea k ≥ 2, existan k vectores propios linealmente independientes asociados al

valor propio λ.

Encontrar, si existe, la forma diagonal D de una matriz A se llama diagonalizar la matriz A.

El método para intentar diagonalizar una matriz cuadrada A es:

1. Hallar el polinomio característico pc(A).

2. Resolver la ecuación pc(A) = 0 y hallar las raíces. Dichas raíces son los

valores propios de la matriz. Si el polinomio tiene raíces no reales, entonces

la matriz no es diagonalizable.

3. Para cada valor propio λ, hallar los vectores propios asociados, resolviendo el correspondiente sistema de ecuaciones. Las soluciones del sistema

estarán dadas en función de k parámetros t1 , . . . , tk . Por otra parte, la

multiplicidad de la raíz λ en el polinomio característico (esto es, el exponente de (x − λ) en la factorización del polinomio característico) será un

cierto entero m.

Siempre se verifica k ≤ m. Si k < m para alguno de los valores propios λ,

entonces la matriz no es diagonalizable.

4. Si k = m, podemos dar a los parámetros t1 , . . . , tk sucesivamente los valores (1, 0, . . . , 0), (0, 1, 0, . . . , 0), . . . , (0, 0, . . . , 0, 1). Se obtienen así m vectores propios para el valor propio λ que son linealmente independientes. Si

esto ocurre para cada λ, la matriz es diagonalizable, y todos los vectores

propios obtenidos dan una base de vectores propios.

5. Escribimos entonces la matriz de paso P que será la matriz de la base B

formada por vectores propios.

6. La diagonalización de A es la matriz diagonal D en cuya diagonal figuran

los valores propios en el orden correspondiente al orden en que hemos

escrito los vectores de B (es decir, el primer elemento de D es el valor

13

propio del primer vector u1 de la base B; el segundo es el valor propio del

segundo vector u2 de la base, etc).

7. Se puede comprobar la corrección del resultado calculando los productos

A · P y P · D y comprobando que A · P = P · D (esta igualdad equivale a

la igualdad A = P · D · P −1 ).

Ejercicio 1. Diagonalizar la matriz

3

1

1

3

si es posible, y hallar en su

caso la matriz de paso.

Calculamos el polinomio característico:

x − 3

−1 = x2 − 6x + 9 − 1 = x2 − 6x + 8

−1

x − 3

Ahora, hallamos sus raíces que serán los valores propios.

√

6 ± 36 − 32

6±2

x=

=

2

2

De este modo, vemos que los valores propios son 4 y 2.

Ahora debemos calcular los vectores propios para cada uno de los valores

propios.

(i) λ = 2. La ecuación será

−1 −1

x

0

·

=

−1 −1

y

0

Esto da el sistema

x + y = 0,

x = −t,

y=t

El conjunto de soluciones está formado por todos los vectores que son combinación lineal de u1 = (1, −1).

(ii) Buscamos ahora los vectores propios para el valor propio λ = 4. La

ecuación matricial será

1 −1

x

0

·

=

−1

1

y

0

El sistema de ecuaciones es

x − y = 0,

x = t,

y=t

De este modo, los vectores propios correspondientes a λ = 4 son las combinaciones lineales de u2 = (1, 1).

Existe una base de vectores propios que es B = {(1, −1), (1, 1)}.

La matriz de esa base es la matriz de paso

1 1

P =

−1 1

14

En cuanto a la forma diagonal, contiene los valores propios en la diagonal

principal, en el mismo orden que los hemos considerado en la matriz de paso:

2 0

D=

0 4

Finalmente, podemos comprobar la solución viendo que AP = P D.

3 1

1 1

2 4

AP =

·

=

1 3

−1 1

−2 4

1 1

2 0

2 4

PD =

·

=

−1 1

0 4

−2 4

La igualdad se cumple, de forma que la diagonalización es correcta.

Ejercicio 2. Diagonalizar la matriz

8 −2

6

3

1

3

−9

3 −7

El polinomio característico es

x − 8

2

−6 −3

x−1

−3 = (x + 7)(x − 1)(x − 8) − 108 − 9(x − 8)+

9

−3

x + 7

+6(x + 7) + 54(x − 1) = (x3 − 2x2 − 55x + 56) − 162 + 72 + 42 + 51x =

= x3 − 2x2 − 4x + 8 = (x − 2)2 (x + 2)

Vemos de este modo que hay dos valores propios: λ = −2 que es simple, y

λ = 2, que es doble (tiene multiplicidad 2.)

Debemos calcular los vectores propios para cada valor propio. Empezamos

por el valor doble, porque así se decidirá si la matriz es o no diagonalizable.

La ecuación matricial es (para λ = 2)

0

x

−6

2 −6

−3

1 −3 · y = 0

z

0

9 −3

9

Se puede resolver este sistema homogéneo transformando la matriz de los

coeficientes mediante operaciones elementales, como de costumbre:

6 −2 6

3 −1 3

3 −1 3

3 −1 3 , 6 −2 6 , 0

0 0

9 −3 9

9 −3 9

0

0 0

Aunque la matriz no está en forma escalonada simple, podemos resolverlo

ya, porque vemos que equivale a la ecuación

3x − y + 3z = 0

15

que es la ecuación de un plano.

Las incógnitas y, z pueden tomar cualquier valor, de forma que el conjunto

de soluciones puede darse como

x=

u

− v,

3

y = u,

z=v

Así, el conjunto de soluciones está formado por las combinaciones lineales

de los vectores (0, 3, 1), (1, 0, −1). Hemos obtenido esos vectores con los valores

de los parámetros u = 3, v = 1 y u = 0, v = −1, respectivamente.

En definitiva, los vectores propios para el valor propio 2 son las combinaciones lineales de: (0, 3, 1) y (1, 0, −1).

Estudiamos ahora los vectores propios para el valor propio −2.

La ecuación matricial es

−10

2 −6

x

0

−3 −3 −3 · y = 0

9 −3

5

z

0

Hacemos las transformaciones elementales sobre la matriz del sistema

1

1 1

1

1

1

10 −2 6

3

3 3 , 10 −2 6 , 0 −12 −4

9 −3 5

0 −12 −4

9 −3 5

1

0

0

1

12

0

1

4 ,

0

1

0

0

1

3

0

1

1

0

El sistema se puede resolver ya. La incógnita z puede tomar cualquier valor,

y tenemos que el sistema es equivalente a

x + y = −z,

3y = −z

Tomando z = t, obtenemos las soluciones como

z = t,

t

y=− ,

3

x=−

2t

3

Dando un valor no nulo a t, tendremos (por ejemplo, para t = −3), el vector

propio (2, 1, −3).

Hemos obtenido por tanto una base de vectores propios: (2, 1, −3), (0, 3, 1), (1, 0, −1).

El primer vector es el de valor propio −2, los otros tienen valor propio 2.

La matriz de paso es la matriz de los

que acabamos de encontrar.

2

P = 1

−3

16

vectores de la base de vectores propios

0

1

3

0

1 −1

La diagonalización es la matriz

−2

D= 0

0

0

2

0

0

0

2

Comprobamos la igualdad AP = P D.

8 −2

6

2

1

3 · 1

AP = 3

−9

3 −7

−3

2

1

−3

0

1

−2

3

0 · 0

1 −1

0

0

2

0

0

1

−4

3

0 = −2

1 −1

6

0

−4

0 = −2

2

6

0

2

6

0

2 −2

0

2

6

0

2 −2

El resultado es correcto.

Ejercicio 3. Diagonalizar si es posible la matriz siguiente, dando en su caso

la matriz de paso.

1

2 −1

0

1

A= 0

0 −2

3

Hallamos el polinomio característico

x − 1 −2

1 0

x

−1 = (x − 1)(x − 3)x + 2(x − 1) =

0

2 x − 3

(x − 1)(x2 − 3x + 2)

Hay un valor propio λ = 1. Además, están las raíces del factor de segundo

grado:

√

3±1

3± 9−8

=

x=

2

2

En definitiva, el polinomio característico dará

pc(A) = (x − 1)2 (x − 2)

El valor propio λ = 1 tiene multiplicidad 2. Buscamos sus vectores propios.

0 −2

1

x

0

0

1 −1 · y = 0

0

2 −2

z

0

Resolviendo el sistema de ecuaciones (y cambiando el orden de las incógnitas

al orden y, z, x), obtenemos como matriz

1 0 0

1 −1 0

1 −1 0

−2

1 0 , 0 −1 0 , 0 1 0

2 −2 0

0

0 0

0 0 0

17

Tomando x = t, el sistema equivale a

x = t,

z = 0,

y=0

Los vectores propios para λ = 1 son las combinaciones lineales de (1, 0, 0).

Como solamente hay un vector propio linealmente independiente, y la multiplicidad de la raíz es 2, la matriz no es diagonalizable.

4.

Lección 36. Diagonalización ortogonal de matrices simétricas

4.1.

Potencias de matrices

En muchas ocasiones, es conveniente conocer el resultado de aplicar repetidamente una transformación lineal f . Es decir, interesa conocer las transformaciones f ◦ f = f 2 , f ◦ f 2 = f 3 , etc.

Como toda transformación lineal f está descrita por una matriz cuadrada

A = M (f ), el problema es equivalente al de calcular las potencias de una matriz

cuadrada A: A2 , A3 , . . . , An .

El problema, teóricamente fácil, puede ser muy trabajoso en la práctica. Sin

embargo, hay una situación en que el problema es fácilmente manejable: cuando

A es una matriz diagonal.

En efecto: supongamos que D es una matriz diagonal, que escribiremos como

D = diag(d1 , d2 , . . . , dn ), indicando así que d1 , d2 , . . . , dn son los elementos que

aparecen en la diagonal principal de la matriz (el resto de elementos de la matriz

es 0).

Escribiendo las matrices, no es difícil convencerse de que las potencias de

matrices diagonales siguen siendo diagonales. Concretamente,

D2 = diag(d21 , d22 , . . . , d2n ),

Dk = diag(dk1 , dk2 , . . . , dkn )

De este modo, el cálculo de la potencia Dk de una matriz diagonal se reduce

al cálculo de las potencias de los números que son los elementos de la diagonal; un

cálculo mucho más fácil y rápido que el de las potencias de matrices arbitrarias.

Si A es una matriz diagonalizable, también las potencias de A son bastante

fáciles de calcular.

Sea A diagonalizable, con forma diagonal D y matriz de paso P . Sabemos

entonces que

A = P · D · P −1

Se deduce de aquí que

Ak = (P DP −1 )k = (P DP −1 )(P DP −1 ) · · · (P DP −1 ) =

= P D(P −1 P )D(P −1 P )D · · · (P −1 P )DP −1

18

Como cada matriz P −1 P = In , y los productos In · X = X, para cualquier

matriz X, observamos por la ecuación anterior que

Ak = P Dk P −1

y el cálculo de la potencia queda reducido al de la potencia de una matriz

diagonal, más el de la matriz inversa P −1 y los dos productos indicados.

Ejercicio 1. Dada la matriz A siguiente, y los vectores de R2 : u, v, w, se

considera la transformación lineal de R2 definida por A. Si aplicamos esta transformación reiteradamente, comenzando por el vector u, ¿qué vector se obtiene

tras cuatro iteraciones? ¿Se llegará tras algún número de iteraciones a obtener

el vector v? ¿y el vector w?

A=

−1

−3

2

4

,

u = (1, 2),

v = (511, 767),

w = (1023, 1531)

El primer paso debe ser diagonalizar la matriz A, siguiendo el método indicado en la lección anterior. Se obtiene que la forma diagonal D y la matriz de

paso P son:

1 0

1 2

D=

,

P =

0 2

1 3

Debemos hallar también la inversa de P . Se tiene

3 −2

−1

P =

−1

1

De este modo, estamos en condiciones de dar la

expresión general para la

1 0

k

k

matriz A , teniendo en cuenta que D =

:

0 2k

1 0

1 2

3 −2

k

k

−1

A =P ·D ·P =

·

·

=

1 3

−1

1

0 2k

3 − 2k+1 2k+1 − 2

=

3 − 3 · 2k 3 · 2k − 2

Podemos responder ahora a las preguntas planteadas. Es más práctico indicar

primero la expresión general de Ak · [u] = [f k (u)].

3 − 2k+1 2k+1 − 2

1

k

A · [u] =

·

=

2

3 − 3 · 2k 3 · 2k − 2

k+2

k+1

2

−1

2

− 2k+1 − 1

=

=

3 · 2k − 1

3(2k+1 − 2k ) − 1

De este modo, para k = 4, tenemos

f 4 (u) = (31, 47)

En cuanto a las dos últimas preguntas, la condición de que se alcance el

vector v en alguna iteración equivale a saber si existe algún k con la propiedad

Ak · [u] = [v]

19

Es decir:

2k+1 − 1

3 · 2k − 1

=

511

767

Este es un sistema de ecuaciones (no lineales):

2k+1 = 512,

3 · 2k = 768

512

La segunda ecuación es 2k = 768

3 = 256 = 2 . Luego si k cumple la primera

ecuación, cumple la segunda. Será entonces k = log2 256 = log2 28 = 8. Luego

f 8 (u) = v.

Finalmente, la condición para w será

k+1

2

−1

1023

=

1531

3 · 2k − 1

El sistema de ecuaciones es

2k+1 = 1024,

2k =

1532

3

Pero 2 · 1532

3 6= 512. Luego el sistema no es compatible, y w no se alcanza en

ninguna iteración.

4.2.

Bases ortogonales y ortonormales

Una base, formada por los vectores u1 , u2 , . . . , un , de Rn se dice que es

ortogonal cuando se tiene ui ⊥uj para cada par de índices i 6= j.

Sea P la matriz de la sucesión de vectores que forman una base B. Así,

la columna j de P contiene las coordenadas del vector uj . Si consideramos la

matriz traspuesta P t , tendremos que la fila i de P t contiene las coordenadas del

vector ui (ya que es la columna i de P ).

Por esta razón, la condición de que la base B sea ortogonal se puede expresar

en términos de la matriz P de los vectores de dicha base: B es una base ortogonal

si y solo si la matriz producto P t · P es diagonal.

En efecto: el elemento de lugar (i, j) en el producto se obtiene multiplicando

la fila i de P t por la columna j de P ; pero ese elemento no es entonces sino el

producto escalar ui · uj . Luego estos elementos de la matriz P t · P son nulos si

y solo si ui ⊥uj para todo par de vectores distintos de la base B; es decir, si y

solo si la base B es ortogonal.

Una base ortogonal se dice que es ortonormal cuando cada vector ui de dicha

base es unitario (e.d., su módulo es 1).

Si B es una base ortogonal y P es la matriz de los vectores de dicha base,

entonces la condición de que la base sea ortonormal, puesta en términos de esa

matriz, equivale a la de que P t · P = In .

En efecto: la condición de ortonormalidad equivale a la de que los productos

ui · ui den el valor 1; como ese será el elemento que figura en el lugar i-ésimo

de la diagonal de P t · P , y los elementos son nulos fuera de la diagonal, resulta

20

que la base es ortonormal si y solo si la matriz P t P tiene unos en la diagonal

principal; esto es, si y solo si es la matriz identidad.

Con cierta inconsecuencia, las matrices cuadradas P de orden n, que cumplen

que P t · P = In se llaman ortogonales. Por tanto, B es una base ortonormal si

y solo si la matriz de los vectores de B es ortogonal.

4.3.

Matrices simétricas

Recordemos que una matriz cuadrada A se llama simétrica si A = At . Las

matrices simétricas tienen la siguiente propiedad importante.

Teorema. Toda matriz simétrica es diagonalizable. Además, puede elegirse

una matriz de paso que sea ortogonal.

Veremos algunos ejemplos para indicar el método para encontrar la forma

diagonal de una matriz simétrica, y hallar una matriz de paso ortogonal. Este

proceso se llama de diagonalización ortogonal.

Describimos primero el proceso, en lo que tiene de diferente del proceso de

diagonalización ya estudiado. Esta diferencia se halla solamente en la manera

de escoger los vectores propios que forman la base que determina la matriz de

paso.

Lo veremos en dos fases. En primer lugar, veremos cómo escoger una base

formada por vectores ortogonales. Una vez conseguido esto, sustituiremos cada

vector ui de esa base por el correspondiente vector unitario |u1i | ui . De este modo,

la base así formada será una base ortonormal.

La primera fase es la más importante, ya que la segunda consiste en calcular

el vector unitario correspondiente a cada vector de la base.

Respecto a la manera de obtener una base ortogonal, hay que tener en cuenta

que vectores correspondientes a valores propios distintos son ortogonales; de

modo que lo único que hace falta es, para cada valor propio λ, elegir vectores

propios para dicho valor, que sean linealmente independientes y ortogonales

entre sí.

Supongamos que hemos calculado todos los vectores propios para un cierto

valor propio λ. Supongamos que todos esos vectores propios son combinación

lineal de los vectores linealmente independientes u1 , u2 , u3 , por ejemplo.

Entonces, u01 = u1 será el primer vector que escojamos para la nueva base.

Después, buscamos un vector que sea combinación lineal de u1 , u2 , pero que sea

además ortogonal a u1 . Para ello, elegimos u02 por las condiciones

u02 = u2 − xu1 ,

u1 · u02 = 0

Esas condiciones dan una solución única para x; por tanto, determinan el

vector u02 .

Calculados así u01 , u02 , queremos hallar u03 . Como antes, buscamos un vector

que sea combinación lineal de u1 , u2 , u3 y que sea ortogonal a u1 y u2 (esto

implicará que es ortogonal a u01 , u02 ). Para ello, ponemos

u03 = u3 − xu1 − yu2 ,

u1 · u03 = 0,

21

u2 · u03 = 0

De este modo, obtenemos los coeficientes x, y, y el nuevo vector u03 .

Ejercicio 2. Diagonalizar ortogonalmente la matriz simétrica

3 0 −1

0 2

0

−1 0

3

Hacemos el proceso de diagonalización normal hasta encontrar una base de

vectores propios.

El polinomio característico es

x − 3

0

1 0

x−2

0 = (x − 3)2 (x − 2) − (x − 2) = (x − 2)((x − 3)2 − 1)

1

0

x − 3

Un valor propio es x = 2. Los demás son las raíces del polinomio x2 − 6x + 8:

son 2, 4. Así, 2 es un valor propio doble, 4 es simple.

Hallamos los vectores propios para cada valor propio. Para el valor simple

λ = 4, tendremos solamente un vector propio linealmente independiente.

El sistema de ecuaciones obtenido para λ = 4 es

x + z = 0,

2y = 0,

x+z =0

Esto equivale al sistema

x + z = 0,

y=0

z puede tomar cualquier valor, de manera que el conjunto de soluciones es

x = −t,

y = 0,

z=t

Obtenemos así el primer vector de la base de vectores propios: (1, 0, −1).

El otro valor propio es λ = 2. El sistema de ecuaciones es

−x + z = 0,

x−z =0

0 = 0,

El sistema equivale a la única ecuación x − z = 0. Tomamos y, z como

parámetros, y el conjunto de soluciones es

x = v,

y = u,

z=v

Un par de vectores propios linealmente independientes se puede obtener

tomando, por ejemplo, (1, 0, 1) y (0, 1, 0). Estos vectores son ya ortogonales, por

lo que no tenemos necesidad de aplicar el cambio del segundo vector descrito

arriba.

Pero supongamos que hubiésemos elegido los dos vectores como (1, 0, 1) y

(1, 1, 1), que no son ortogonales. Entonces tomamos

u1 = (1, 0, 1)

22

u2 debe verificar las condiciones

u2 = (1, 1, 1) − x(1, 0, 1),

(1, 0, 1) · u2 = 0

Desarrollamos y resolvemos esas ecuaciones:

u2 = (1 − x, 1, 1 − x),

(1, 0, 1) · (1 − x, 1, 1 − x) = (1 − x) + (1 − x) = 2 − 2x = 0

Luego debe ser 2x = 2 y x = 1. Por tanto, u2 = (0, 1, 0).

Tenemos ya, pues, una base ortogonal de vectores propios: (1, 0, −1), (1, 0, 1), (0, 1, 0).

Para obtener una base ortonormal, normalizamos cada uno de estos vectores (es decir, calculamos el vector unitario correspondiente, dividiendo por el

módulo):

√

√

1

2

2

v1 = √ (1, 0, −1) = (

, 0, −

)

2

2

2

√

√

1

2

2

, 0,

), v3 = (0, 1, 0)

v2 = √ (1, 0, 1) = (

2

2

2

Podemos ya escribir la matriz de paso P , que será una matriz ortogonal

√

√

2

2

0

2

2

P = √0 √0 1

2

0

− 22

2

La forma diagonal es la matriz

4

0

0

0

2

0

0

0

2

Ejercicio 3. Diagonalizar ortogonalmente la matriz

3 1 1

M = 1 3 1

1 1 3

Calculamos el polinomio característico

x − 3

−1

−1 −1

x−3

−1 = (x − 3)3 − 2 − 3(x − 3) =

−1

−1

x − 3

= x3 − 9x2 + 27x − 27 + 7 − 3x = x3 − 9x2 + 24x − 20

Se puede observar que el polinomio tiene la raíz x = 2. Dividiendo,

pc(M ) = x3 − 9x2 + 24x − 20 = (x − 2)(x2 − 7x + 10)

Para descomponer el segundo factor, hallamos sus raíces

√

7±3

7 ± 49 − 40

=

x=

2

2

23

Así pues, las raíces son 5, 2, y obtenemos la factorización del polinomio característico

pc(M ) = (x − 2)2 (x − 5)

El valor propio λ = 2 es doble; y el valor propio λ = 5 es simple. Así, el

conjunto de vectores propios para el valor propio 2 se expresará en términos de

dos parámetros; y el de vectores propios para el valor 5 estará dado en términos

de un parámetro.

Pasamos a calcular los vectores propios. Para λ

matricial

1 1 1

x

1 1 1 · y =

1 1 1

z

= 2 obtenemos la ecuación

0

0

0

El sistema equivale a la única ecuación x + y + z = 0. Podemos tomar y, z

como parámetros, y obtenemos las soluciones

x = −u − v,

y = u,

z=v

Dando valores (1, 0) y (0, 1) a los parámetros obtenemos dos vectores propios

linealmente independientes para el valor propio λ = 2:

(−1, 1, 0),

(−1, 0, 1)

Pasamos al valor propio λ = 5 y seguimos el mismo procedimiento.

2 −1 −1

x

0

−1

2 −1 · y = 0

−1 −1

2

z

0

Transformando la matriz del sistema, obtenemos

1

1

1 −2

1

1 −2

1 −2

3 , 0

1 , 0 −3

0 −3

3

0

2 −1 −1

1 −2

1 −1

0

0

y finalmente llegamos a la matriz

1 0 −1

0 1 −1

0 0

0

Tomamos z = t como parámetro, y el sistema nos dará

x = t,

y = t,

z=t

Dando a t el valor t = 1, tenemos el vector propio (1, 1, 1).

La base de vectores propios obtenida es así

(−1, 1, 0), (−1, 0, 1), (1, 1, 1)

Para obtener una base ortogonal, debemos cambiar los vectores correspondientes al valor propio λ = 2, que es doble. Sea

24

u1 = (−1, 1, 0),

u2 = (−1, 0, 1)

Entonces u01 = u1 = (−1, 1, 0). Para el segundo, ponemos

u02 = u2 − xu1 = (−1, 0, 1) − (−x, x, 0) = (x − 1, −x, 1)

Ahora, debemos hallar x para que los vectores u1 , u02 sean ortogonales:

−(x − 1) − x = 0,

1 − 2x = 0,

2x = 1,

x=

1

2

De este modo, obtenemos una base con vectores ortogonales:

(−1, 1, 0),

1 1

(− , − , 1),

2 2

(1, 1, 1)

Finalmente, debemos normalizar los tres vectores, dividiendo por su módulo,

para obtener una base ortonormal.

√

2 1 1

1

1

√ (−1, 1, 0), √ (− , − , 1), √ (1, 1, 1)

2

3 2 2

3

Esto nos da la base ortonormal con vectores propios que se necesita:

√

√ √

√ √ √

√ √

2

2

6

6

6

3

3

3

,

, 0), (−

,−

,

), (

,

,

)

(−

2

2

6

6

3

3

3

3

La matriz de paso ortogonal P y la

√

√

√

− √22 − √66 √33

2

P =

− √66 √33

2

6

3

0

3

3

forma diagonal D son:

2 0 0

, D = 0 2 0

0 0 5

Se puede comprobar para terminar, la ecuación M P = P D, haciendo los

productos de matrices indicados.

5.

Ejercicios

1. Calcular la matriz de la transformación lineal de R2 que lleva cada vector a

su proyección ortogonal sobre la bisectriz del segundo cuadrante x + y = 0

−−→

−−→

(es decir, transforma cada vector v = OX en el vector OY donde Y es

el punto de corte de la recta dada con la perpendicular a dicha recta que

pasa por el punto X; O es el origen de coordenadas)

2. Consideramos los siguientes vectores de R3 :

v1 = (1, −1, 1),

v2 = (2, 0, 1),

v3 = (0, 1, −1),

v = (1, 2, −3)

Probar que los tres primeros vectores forman una base B, y calcular la

matriz de la transformación lineal f que cumple

f (v1 ) = 0,

f (v2 ) = v1 ,

25

f (v3 ) = v

3. Dar las ecuaciones de la simetría de R2 con respecto a la recta de ecuación

ax + by = 0. Obsérvese que pueden elegirse los coeficientes a, b de forma

que a2+ b2 = 1, ydemuéstrese que la matriz de dicha simetría es de la

A

B

forma

, con determinante −1.

B −A

4. Demostrar que si f es una transformación lineal de R2 con una matriz

a b

−b a

y con determinante 1, entonces f es un giro alrededor del origen de coordenadas.

5. Demostrar que la composición de dos simetrías respecto de rectas que

pasan por el origen es igual a un giro alrededor del origen.

6. Probar que si una transformación lineal f : Rn → Rn está dada por la

matriz cuadrada A (esto es, A = M (f )) y A tiene una matriz inversa A−1 ,

entonces la transformación g : Rn → Rn cuya matriz es A−1 es inversa de

f (es decir, g(f (v)) = f (g(v)) = v) para cada vector v ∈ Rn ).

7. Para cada una de las dos transformaciones que siguen, ver si tiene inversa,

y calcular la inversa cuando exista.

(i)

f (x, y, z) = (2x + 4y − 2z, 3x + y + 2z, 2y − x − 3z)

(ii)

g(x, y, z) = (2x + z, x + 2y + z, y − 2x − z)

8. Calcular los valores propios de la matriz

1 −1 1 −1

0

1 0

0

0

0 1

0

1

0 0 −1

9. Hallar todos los vectores propios de la matriz anterior.

10. Calcular todos los vectores propios

−1

6

0

de la matriz

0 2

1 6

0 1

11. Decir cuáles de las siguientes matrices son diagonalizables; y dar su forma

diagonal y la matriz de paso cuando lo sean.

1

0

0

0 −1

1 ,

0

0 −1

26

5 −3 2

6 −4 4

4 −4 5

12. Misma pregunta para las

1

0

0

matrices

4 −4

1

0 ,

4 −3

2

3

2 −1

13. Decir cuáles de las siguientes matrices son diagonalizables; y dar su forma

diagonal y la matriz de paso cuando lo sean.

0 1 0

−9

4

−4 4 0 ,

−25 11

−2 1 2

6 2

14. Dada la matriz A =

, hallar una matriz B tal que B 2 = A.

3 7

15. Diagonalizar la matriz

1 1

1

1

0 1

1 −1

0 0 −1

2

0 0

0

1

16. Calcular las matrices A7 y B 10 , para las matrices siguientes.

A=

−5

−4

12

9

1

B= 0

−1

,

17. Diagonalizar ortogonalmente la matriz simétrica

2 0 −1

0 3

0

−1 0

2

18. Diagonalizar ortogonalmente la matriz

−1 0

0 1

0 1

27

simétrica

0

1

1

0 −1

1

0

0

1

![1 Si v = [ 36 -12 ] , w = [ 9 -3 ] , y S = 1wl. Indique cuáles opciones](http://s2.studylib.es/store/data/004950498_1-7f0b4c506a631255d680bd90dfa0a3e5-300x300.png)