Análisis factorial

Anuncio

Análisis factorial:

una técnica para evaluar

la dimensionalidad de las pruebas

6

Análisis factorial:

una técnica para evaluar

la dimensionalidad de las pruebas

Cuaderno técnico 6

Análisis factorial:

una técnica para evaluar la dimensionalidad de las pruebas

Cuaderno técnico 6

Salvador Zamora Muñoz

Lucía Monroy Cazorla

César Chávez Álvarez

Revisión técnica:

Antonio Saade Hazin

Análisis factorial:

una técnica para evaluar la dimensionalidad de las pruebas

Cuaderno técnico 6

D.R. © 2009, Centro Nacional de Evaluación

para la Educación Superior, A.C. (Ceneval)

Av. Camino al Desierto de los Leones 19,

Col. San Ángel, Deleg. Álvaro Obregón,

C.P. 01000, México, D.F.

www.ceneval.edu.mx

Diseño: Mónica Cortés Genis

Formación: Alvaro Edel Reynoso Castañeda

Primera edición, septiembre de 2010

Impreso en México • Printed in México

Directorio

Dirección General

Rafael Vidal Uribe

Dirección General Adjunta de los EGEL

Jorge Hernández Uralde

Dirección General Adjunta de los EXANI

José O. Medel Bello

Dirección General Adjunta de Programas Especiales

Rocío Llarena de Thierry

Dirección General Adjunta Técnica y de Investigación

Lucía Monroy Cazorla

Dirección General Adjunta de Operación

Francisco Javier Apreza García Méndez

Dirección General Adjunta de Difusión

Javier Díaz de la Serna Braojos

Dirección General Adjunta de Administración

Francisco Javier Anaya Torres

Dirección de Procesos Ópticos y Calificación

María del Socorro Martínez de Luna

Dirección de Tecnologías de la Información

y las Comunicaciones

Francisco Manuel Otero Flores

Índice

Prefacio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

Capítulo I

Antecedentes históricos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

Capítulo II

¿Qué es el análisis factorial? . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

El modelo de factores

17

Supuestos del modelo

18

Métodos de extracción de factores

19

Selección del número de factores que serán extraídos

20

Criterio a priori (tipos de análisis factorial)

20

Criterio de la raíz latente (eigenvalor >1)

21

Criterio del gráfico de codo (contraste de caída)

22

Criterio del porcentaje de varianza explicada

23

Interpretación de la matriz de cargas factoriales

23

Un concepto muy controvertido: rotación de factores

26

Rotaciones ortogonales

26

Rotaciones oblicuas

27

Valoración de las comunalidades

28

Puntajes factoriales

25

Bondad de ajuste del modelo de factores

28

Análisis factorial con variables discretas

29

Capítulo III

Fundamentos técnicos del análisis factorial . . . . . . . . . . . . . . . . . . . 31

Aspectos formales

31

Soluciones múltiples al modelo

34

Número máximo de factores

35

Métodos de estimación

38

Máxima verosimilitud

Mínimos cuadrados

Mínimos cuadrados generalizados

Mínimos cuadrados ponderados

Método de rotación de ejes principales

Prueba sobre el número de factores en el modelo

Puntajes factoriales

Método de Bartlett o de mínimos cuadrados ponderados

Método de Thompson o de regresión

39

40

40

40

41

41

42

42

43

Capítulo IV

Aplicación con variables continuas . . . . . . . . . . . . . . . . . . . . . . . . . 45

Descripción general del EXANI-I

45

Definición del ejemplo

46

Análisis en SPSS

48

Análisis en R

63

Capítulo V

Aplicación con variables discretas . . . . . . . . . . . . . . . . . . . . . . . . . . 69

Objetivo

69

Descripción de las variables

69

Análisis en R

86

Un comentario final

90

Bibliografía . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

Anexo 1

Códigos en R . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93

Índice de tablas

Tabla 1.

Artículos publicados sobre análisis factorial en diferentes

disciplinas, 1904-2004 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

Tabla 2.

Matriz de cargas factoriales para un caso hipotético . . . . . . . . . . . . . . . . 24

Tabla 3.

Directrices para la identificación de cargas factoriales

significativas, basadas en el tamaño de la muestra . . . . . . . . . . . . . . . . . 25

Tabla 4.

Medidas de correlación entre variables . . . . . . . . . . . . . . . . . . . . . . . . . 29

Tabla 5.

Dominios evaluados por el EXANI-I . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

Tabla 6.

Matriz de correlaciones entre las variables que evalúa el EXANI-I . . . . . . . 51

Tabla 7.

Pruebas KMO y de efericidad de Bartlett . . . . . . . . . . . . . . . . . . . . . . . . 53

Tabla 8.

Comunalidades del modelo unifactorial del EXANI-I . . . . . . . . . . . . . . . . 57

Tabla 9.

Total de la varianza explicada por el modelo unifactorial del EXANI-I . . . . 57

Tabla 10.

Cargas factoriales de las variables manifiestas . . . . . . . . . . . . . . . . . . . . 58

Tabla 11.

Matriz de correlaciones reproducidas por el modelo . . . . . . . . . . . . . . . . 60

Tabla 12.

Matriz de correlaciones con niveles de significancia . . . . . . . . . . . . . . . . 62

Índice de figuras

Figura 1.

Crecimiento en las publicaciones sobre análisis factorial . . . . . . . . . . . . . 13

Figura 2.

Representación del modelo unifactorial . . . . . . . . . . . . . . . . . . . . . . . . . 16

Figura 3.

Representación del modelo multifactorial . . . . . . . . . . . . . . . . . . . . . . . . 16

Figura 4.

Explicación de la ecuación del modelo de factores . . . . . . . . . . . . . . . . . 18

Figura 5.

Gráfico de codo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

Figura 6.

Modelo unifactorial del EXANI-I . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

Prefacio

E

l Centro Nacional de Evaluación para la Educación Superior (Ceneval) es

una institución de carácter eminentemente técnico. A lo largo de tres lustros

su actividad esencial ha sido promover la calidad de la educación mediante evaluaciones válidas, confiables y pertinentes de los aprendizajes.

Primordialmente, evalúa los conocimientos y habilidades adquiridos por los

individuos en los procesos de enseñanza-aprendizaje, formales o no formales, de

los sistemas educativos. Así contribuye a la toma de decisiones fundamentadas.

De hecho, con sus servicios de evaluación atiende instituciones de educación

media superior y superior, autoridades educativas, organizaciones profesionales

y otras instancias públicas y privadas y, desde luego, al destinatario final –y el

más importante– de sus pruebas: el propio sustentante.

Con la serie Cuadernos técnicos el Centro promueve también el uso de herramientas de análisis en círculos cada vez más amplios. El propósito de estos

títulos es contribuir a elevar la calidad de la educación mexicana y fomentar una

auténtica cultura de la evaluación.

La inteligencia, el nivel de ansiedad o el grado de satisfacción no pueden

medirse directamente. Los especialistas las denominan variables latentes o

constructos; y para estimarlas lo hacen mediante variables manifiestas, como

podrían ser la respuesta a un reactivo o el número de aciertos en un examen.

La teoría que sustenta el empleo del análisis factorial –tema de estudio del

presente texto– asume que la variable latente es continua: los individuos pueden ordenarse de mayor a menor nivel del atributo bajo estudio. El propósito

es analizar la estructura de correlación entre un grupo de variables medidas, asumiendo que la asociación entre ellas puede ser explicada por una o más variables

latentes, que en el caso del análisis factorial se les reconoce como factores.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

9

Capítulo I

Antecedentes históricos

E

l primer planteamiento del análisis factorial se remonta a principios del siglo

xx, cuando Charles Spearman (1904) hizo un estudio sobre la medición de

la inteligencia. Conjeturó que si dos habilidades están correlacionadas, entonces

cada una está compuesta por dos factores: uno que les es común, responsable de

la correlación, y otro que es específico pues determina la diferencia entre ambas.

En los primeros años de esta herramienta metodológica el enfoque predominante era asumir a priori que en los datos subyacía una estructura unifactorial.

Thurstone (1935) propuso un cambio en la conceptualización del análisis

factorial sugiriendo que los datos analizados podrían explicarse por más de una

variable latente (factor); que lo importante era determinar el número de factores

que podrían ser identificados. El estudio de inteligencia Thurstone (1938)

propuso que la inteligencia puede ser explicada por siete factores.

En 1936 la Sociedad de Psicometría fundó una revista de investigación

especializada: Psychometrika, en cuyas páginas se publicaron entre finales de los

años treinta y principios de los cincuenta numerosos artículos sobre cuestiones

relacionadas con el desarrollo del análisis factorial, tales como la estimación

de las comunalidades, la extracción de factores comunes, la determinación del

número de factores, la rotación de los factores, la estimación de los puntajes

factoriales, los métodos para acelerar la velocidad de los cálculos y la indeterminación de los modelos.

En la actualidad, el uso del análisis factorial como herramienta metodológica

se ha extendido a diversos ámbitos del quehacer científico: la psicología (en

estudios de habilidades, motivación, aprendizaje, etcétera); la pedagogía

(en estudios relacionados con el aprovechamiento escolar, la tipología de profesores, etcétera); la sociología (en dimensiones de grupo, actitudes políticas,

afinidad política, etcétera), y en muchas otras disciplinas (ecología, economía,

medicina, metrología...).

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

11

Como una muestra del uso de esta técnica estadística en los años recientes,

Kaplunovsky (2006) presentó los resultados de una exploración realizada en

internet en mayo de 2004. Detectó 3,460 artículos relacionados con este método

cuantitativo y los clasificó de acuerdo con los campos del conocimiento en que

se habían generado los datos, los cuales se muestran en la tabla 1.

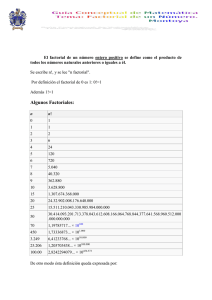

En la figura 1 se muestra el incremento que han tenido, en los últimos 15

años, los estudios que utilizan el análisis factorial en la información.

Tabla 1. Artículos publicados sobre análisis factorial

en diferentes disciplinas, 1904-2004

12

Área

19041980

19811985

19861990

19911995

19952000

20002004

Total

Biología

Química

Cromatografía

Ecología

Economía

Alimentación

Geriatría

Procesamiento de imágenes

Industria

Resonancia magnética

Medicina

Metodología

Investigación de operaciones

Fisiología

Psiquiatría

Psicología

Espectroscopia

18

12

4

2

14

1

8

2

4

1

30

10

1

20

15

93

11

17

14

7

4

12

4

5

7

0

1

32

25

1

26

14

86

27

20

36

16

11

9

5

10

22

2

3

64

31

1

38

39

159

40

23

53

22

15

4

2

9

27

6

6

67

49

9

39

61

219

50

47

88

24

61

20

17

25

38

38

25

109

125

42

51

137

379

108

41

77

15

45

26

21

31

51

28

13

116

151

41

29

99

344

90

166

280

88

138

85

50

88

147

78

49

418

391

95

203

365

1280

326

Cuaderno técnico

6

Figura 1. Crecimiento en las publicaciones sobre análisis factorial

Publicaciones

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

Publicaciones

sin Psychology

13

Capítulo II

¿Qué es el análisis factorial?

E

l análisis factorial es una técnica estadística multivariada que se incorpora a

la metodología cuantitativa que involucra variables latentes.1 Estas variables

no observables, denominadas frecuentemente constructos, son variables que no

pueden medirse de manera directa: se estiman a través de variables manifiestas

(observadas). Ejemplos de variables latentes podrían ser la inteligencia, el nivel

de ansiedad, el nivel socioeconómico, el capital cultural, el grado de satisfacción

con un producto o el nivel de razonamiento verbal. Variables observadas

podrían ser la respuesta a un reactivo de un examen, el número de aciertos en

un examen, la intensidad con que se lanzó una pelota, el número de computadoras

en una vivienda, etcétera.

En el análisis factorial se asume que la variable latente es continua: los individuos pueden ordenarse de mayor a menor nivel del atributo bajo estudio. El

objetivo primordial de esta herramienta es estudiar la estructura de correlación

entre un grupo de variables medidas, asumiendo que la asociación entre las

variables puede ser explicada por una o más variables latentes, que en el caso

del análisis factorial se les reconoce como factores. Dicho de otra manera, la

correlación entre el grupo de variables se explica por la presencia de los factores

subyacentes a ellas.

En el caso de que esta estructura de correlación pueda explicarse a través

de un solo factor, estaremos ante un modelo unifactorial; por el contrario, si

necesitamos más de un factor para explicar estas correlaciones, utilizaremos

un modelo multifactorial. En este último caso, se espera que las variables que

componen cada uno de estos factores estén fuertemente correlacionadas, y con

correlaciones débiles con las variables que componen el resto de los factores.

Cuando se representa gráficamente un modelo latente, como el análisis

factorial, es común representar los factores con un óvalo o círculo, y las variables manifiestas con un cuadrado o rectángulo. Las flechas van del factor a las

1

Véase el Cuaderno técnico sobre análisis de clases latentes para una definición más extensa de

este tipo de variables.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

15

variables, indicando que el factor es una variable explicativa y las variables

manifiestas son variables dependientes. En las figuras 2 y 3 se muestra la representación gráfica de un modelo unifactorial y otro multifactorial, respectivamente.

Figura 2. Representación del modelo unifactorial

V1

V2

V3

V4

Habilidad

matemática

V5

V6

V7

V8

V9

V10

Figura 3. Representación del modelo multifactorial

V1

Resolución

problemas

V2

V3

V4

V5

V6

Series

numéricas

V7

V8

V9

V10

16

Cuaderno técnico

6

El modelo de factores

En este apartado se explicarán los aspectos básicos de la teoría que sustenta el

análisis factorial y se pospone su explicación formal, en términos matemáticos,

hasta el capítulo 3: Fundamentos técnicos del análisis factorial.

Supongamos que tenemos un conjunto de variables observadas X1, X2,...,

Xp y se asume que en este conjunto subyacen k factores (el número de factores

debe ser estrictamente menor al número de variables observadas). De acuerdo

con lo que hemos planteado en secciones anteriores, los factores son variables

latentes que explican la asociación entre las variables manifiestas (en este caso

las X’s); entonces, podemos pensar el modelo de factores de manera similar al

modelo de regresión lineal, en el que se exprese esta relación entre factores y

variables, de la siguiente forma:

Los factores f1, f2,...,fk, juegan el papel de variables explicativas, y cada una de

las X’s el de variables de respuesta; las λ’s son los coeficientes asociados a cada

factor, y reciben el nombre de cargas factoriales; por último, los errores del modelo

son las u’s. En este sentido, el modelo está determinando por las variables y no

por los individuos.

Las cargas factoriales indican la correlación entre cada variable y el factor

correspondiente; así, una variable con mayor carga factorial será más representativa del factor. De este modo, las cargas factoriales sirven para interpretar la

función que cumple cada variable para definir cada uno de los factores. En

la figura 4 se identifican las variables que intervienen en el modelo factorial.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

17

Figura 4. Explicación de la ecuación del modelo de factores

Variable observada

Factores

Cargas factoriales

Error

Supuestos del modelo

En el modelo de factores, a f1, f2,...,fk se les denomina factores comunes y a u1, u2,...,up

factores específicos. Los supuestos básicos sobre los que se construye el modelo

son los siguientes:

1. Los factores comunes fj j=1,2,...,k no están correlacionados y tienen media

cero y varianza uno.

2. Los factores específicos ui no están correlacionados y tienen media cero y

varianza Ψi i=1,2,...,p.

3. Los factores comunes no están correlacionados con los factores específicos.

Bajo estos supuestos es posible descomponer la varianza de cada una de las

variables observables del modelo o variables indicadoras (Xi ), en dos componentes

no correlacionados. Por un lado la varianza común, conocida como la comunalidad

18

Cuaderno técnico

6

de la variable y que representa la varianza de la variable Xi que es explicada por los

factores comunes y, por el otro, la varianza específica conocida como especificidad

y que es la varianza no explicada por estos factores comunes. Los factores

comunes y sus características asociadas (comunalidades, especificidades, número,

etcétera) representan el objeto de interés en el análisis factorial.

Métodos de extracción de factores

Todas las técnicas de estimación del modelo factorial parten del supuesto de

que los factores iniciales que serán extraídos de la matriz de correlaciones de las

variables indicadoras no estarán correlacionados. El objetivo de los métodos de

extracción de factores es minimizar la distancia entre la matriz de correlaciones

observada y la matriz de correlaciones que se desprende del modelo (matriz que

especifica el modelo de factores). La diferencia entre los métodos radica en la

definición de “distancia” que utilizan para llegar a la solución. El método de

mínimos cuadrados, por ejemplo, se ocupa de minimizar la suma de cuadrados

de las diferencias entre estas dos matrices, por lo que los valores de los parámetros

que logren este objetivo serán los estimadores finales.

Uno de los métodos más comunes para la extracción de factores es el conocido

como Factorización de ejes principales (Principal axis factoting). Se trata de un método

iterativo para estimar las comunalidades y subsecuentemente extraer los

factores. Este método es igual al que se usa en la técnica multivariada conocida

como Análisis de componentes principales, salvo que no se realiza sobre la matriz

original de correlación (véanse detalles en el capítulo 3). Los factores se extraen

de manera sucesiva, por lo que la solución final consiste en factores ortogonales.

El primer factor se obtiene de forma que explique la mayor cantidad de la

varianza común; el segundo se extrae de una matriz de correlación residual que

se obtiene una vez que se toma en cuenta la influencia del primer factor. Este

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

19

proceso continúa hasta que se ha extraído un número suficiente de factores. En

el siguiente apartado revisaremos algunos criterios para determinar el número

de factores con que se debería detener este proceso.

Selección del número de factores por ser extraídos

Uno de los objetivos del análisis factorial es la reducción de los datos originales

a un número menor de variables, pero podría ocurrir que –dado un conjunto de

datos– se tengan soluciones muy diferentes, dependiendo del número de factores considerado. Por tal motivo son varios los criterios que pueden servirnos de

guía para determinar cuántos factores extraer.

En el capítulo 3 determinaremos el número máximo de factores que se pueden

extraer, dependiendo del número de variables indicadoras que se incluyan en el

modelo; y a continuación explicaremos la lógica de algunos criterios utilizados

para la selección del número de factores por extraer en el análisis; comenzaremos con los criterios teóricos que definen el análisis factorial confirmatorio y con

algunos criterios estadísticos que nos ayudarán a seleccionar el número exacto

de factores por extraer en el marco del análisis factorial exploratorio.

Criterio a priori (tipos de análisis factorial)

En muchas ocasiones no se tiene certeza sobre el número de factores k que

subyacen en la estructura de datos; por ende, se puede realizar la extracción

de factores de manera secuencial, se inicia con k=1 y se llega hasta un número de

factores que permita lograr un buen ajuste del modelo a los datos. Este procedimiento de incorporar factores hasta lograr un buen ajuste da lugar al llamado

análisis factorial exploratorio, en el que el investigador no conoce de antemano el

número de factores que subyacen en las variables observadas. Una desventaja

de este tipo de análisis: puede ocurrir que los factores encontrados no tengan

20

Cuaderno técnico

6

ninguna interpretación para el investigador. Por el contrario, cuando en una

investigación se determina de forma precisa el número de factores, se está ante

un análisis factorial confirmatorio. La forma usual de proponer este número de factores es en atención a alguna teoría propuesta en el área de aplicación. En este

caso, los objetivos de la investigación se centran en la confirmación del número

de factores y, consecuentemente, en la validación de esta teoría mediante la

evidencia empírica proporcionada por los datos. Si el ajuste estadístico de los

datos al modelo teórico es satisfactorio, se podrá concluir que el modelo es

adecuado. Entonces, cuando el análisis factorial es de tipo exploratorio, se tiene

la necesidad de decidir cuántos factores se deben retener en el análisis. En seguida

se enuncian algunos criterios establecidos para decidir este número.

Criterio de la raíz latente (eigenvalor >1)

La lógica que sigue este criterio se basa en la idea de que cada uno de los factores

extraídos debería justificar, al menos, la varianza de una variable individual (de

lo contrario se incumpliría con el objetivo de reducir la dimensión de los datos

originales).

El análisis factorial –al igual que otras técnicas multivariadas– utiliza eigenvalores (raíces latentes) y sus correspondientes eigenvectores para consolidar

la varianza en una matriz. En el contexto del análisis factorial, los eigenvalores

representan la cantidad de varianza de todas las variables indicadoras que puede

ser explicada por un factor determinado. Cada una de las variables contribuye

con un valor de 1 en el eigenvalor (varianza) total.2 Por lo tanto, de acuerdo con

este criterio, deberían elegirse los factores con eigenvalores mayores a 1 para

garantizar que explican la varianza de al menos una variable.

2

Esto se debe a que el análisis se realiza con variables estandarizadas, por lo que la varianza

de cada una de ellas es igual a uno.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

21

Criterio del gráfico de codo (contraste de caída)

Este criterio consiste en analizar el comportamiento de los eigenvalores

asociados a los factores extraídos, para determinar un punto de corte entre la

pendiente pronunciada de los eigenvalores altos y la pendiente (más bien plana)

de los eigenvalores bajos.

La siguiente figura representa los primeros 11 factores extraídos en el análisis

factorial de un conjunto de reactivos que componen el área de un examen.

Figura 5. Gráfico de codo

Gráfico de codo (scree - plot)

3.5

Eigenvalor

3.0

2.5

2.0

Criterio de contraste de caída

1.5

1.0

0.5

1

2

3

4

5

6

7

8

9

10

11

Del lado izquierdo de la gráfica un punto sobresale de los demás, haciendo que

la pendiente de la línea que une todos los puntos cambie drásticamente en el lugar

correspondiente al segundo factor. En este sitio, todo el conjunto de factores se

22

Cuaderno técnico

6

divide en dos grupos, el primero compuesto solamente por el primer factor,

que explica una cantidad mayor de varianza que cualquiera de los diez factores

restantes pertenecientes al segundo grupo y para los que la cantidad de varianza

explicada parece haberse estabilizado. Por lo tanto, con este criterio deberíamos

incluir sólo el primer factor.

Criterio del porcentaje de varianza explicada

Este criterio consiste en analizar el porcentaje acumulado de la varianza total

extraída. Esto es, se busca asegurar que el número de factores extraídos alcance

a explicar un porcentaje determinado de la varianza total de los datos. Aunque

no se ha determinado un porcentaje preciso de varianza explicada que sirva

como umbral para concluir con la extracción de factores, algunos autores

sugieren que en el caso de aplicaciones concernientes a las Ciencias Naturales

se puede detener el proceso cuando se alcance 95% de la varianza o cuando la

inclusión de un factor adicional contribuya con menos de 5% a la varianza

explicada acumulada. Para el caso de las Ciencias Sociales los criterios propuestos

son más laxos. Se habla de continuar la extracción de factores hasta lograr 60%

de la varianza total (Hair et al., 1998/1999).

Interpretación de la matriz de cargas factoriales

Una vez que se han estimado las cargas factoriales es importante establecer

criterios que permitan interpretar los resultados obtenidos. Esta interpretación

hará posible establecer una conexión entre los resultados vertidos por el análisis

factorial y los constructos teóricos relacionados con los datos. En este sentido,

la extracción de un determinado número de factores por los criterios estadísticos

ya mencionados, carecerá de sentido si no podemos darle un significado lógico

a cada uno de ellos, que además esté justificado teóricamente.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

23

Las cargas factoriales indican la correlación entre cada variable y el factor

correspondiente, de ahí que una variable con mayor carga factorial será más

representativa del factor. Tomando en cuenta esto, un análisis de la matriz de

cargas factoriales puede ayudarnos a identificar cómo se agrupan las variables

manifiestas para conformar cada uno de los factores resultantes del modelo, e

incluso a etiquetarlos. Una vez que sabemos cuáles de las variables manifiestas

“cargan” en el factor 1, por ejemplo, podemos deducir qué tipo de constructo

teórico está representado por dicho factor.

En la siguiente tabla se muestra la matriz de cargas factoriales para un

ejemplo hipotético en el que se realizó un análisis factorial con las respuestas a

10 reactivos de opción múltiple de una prueba. Los primeros 5 (RM1 a RM5)

son reactivos del área de Razonamiento matemático, mientras que los últimos

cinco (RV1 a RV5) corresponden al área de Razonamiento verbal.

Tabla 2. Matriz de cargas factoriales para un caso hipotético

Área

Variable

(Reactivo)

Factor

1

2

Razonamiento verbal

RM1

RM2

RM3

RM4

RM5

0.6

0.5

0.6

0.6

0.5

0.1

0.1

0.2

0.1

0.1

Razonamiento matemático

RV1

RV2

RV3

RV4

RV5

0.1

0.2

0.1

0.2

0.2

0.6

0.6

0.6

0.6

0.7

De acuerdo con estos resultados, podemos identificar al factor 1 con una

influencia común en las primeras cinco variables y al factor 2 con una influencia

común en las últimas cinco. De esta manera podríamos dividir el total de

24

Cuaderno técnico

6

variables (reactivos) en dos grupos, que no se traslapan, y que son indicativos

de dos variables latentes diferentes: Razonamiento matemático (factor 1) y

Razonamiento verbal (factor 2).

¿Cómo podemos determinar si una carga factorial es lo suficientemente

“grande” para concluir que la correlación entre la variable y el factor es significativa? Hair et al. (1998/1999) proponen ciertas directrices para determinar si

una carga factorial es o no significativa, dependiendo del tamaño de la muestra

utilizada para el análisis (esta tabla se basa en estudios de potencia estadística):

Tabla 3. Directrices para la identificación de cargas factoriales

significativas, basadas en el tamaño de la muestra

Carga factorial

Tamaño muestral necesario

para la significancia- (a)

0.30

0.35

0.40

0.45

0.50

0.55

0.60

0.65

0.70

0.75

352

250

200

150

120

100

85

70

60

50

(a) La significancia se basa en un nivel de significación de 0.05, una

potencia de 80% y los errores estándar supuestamente dos veces

mayores que los coeficientes convencionales de correlación

En el ejemplo anterior la interpretación fue muy sencilla, porque cada

variable resultó estadisticamente significativa para un solo factor. Sin embargo,

este no es el caso frecuente. A continuación se describe un procedimiento que

puede ayudar a clarificar la interpretación de los resultados.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

25

Un concepto muy controversial: rotación de factores

Cuando el modelo en cuestión está determinado por un solo factor, su solución

es única; sin embargo, las soluciones de los modelos multifactoriales, no son

siempre únicas, ya que cuando existen dos o más factores significativos, las distintas combinaciones posibles pueden interpretarse de distintas maneras (véanse

“soluciones múltiples al modelo” en el capítulo 3). Este aspecto ha suscitado

críticas sobre el análisis factorial, ya que se piensa que depende de cuestiones

subjetivas, que pudieran encaminar las soluciones a resultados preconcebidos

por el investigador. Estas críticas son erróneas en dos aspectos: primero, el

investigador no obtiene la solución que él desea; segundo, es más adecuado decir

que la misma solución puede expresarse de diferentes maneras; de hecho, varias

características de las soluciones –por ejemplo las comunalidades– permanecen

inalteradas. Rotación –nombre que se le da al proceso de cambiar de una solución

a otra– proviene de la representación geométrica de este procedimiento.

La razón principal para rotar una solución es clarificar la estructura de las

cargas factoriales. Los factores deben tener un significado claro para el investigador, a partir del contexto de aplicación. Si la estructura que muestran las

cargas factoriales de la solución inicial son confusas o difíciles de interpretar,

una rotación puede proporcionar una estructura más fácil de interpretar.

Rotaciones ortogonales

Uno de los patrones de cargas factoriales más usuales y de hecho más deseables

es la llamada estructura simple de cargas factoriales. Se dice que las cargas factoriales

presentan una estructura simple si cada variable tiene una gran carga en un

solo factor, con cargas cercanas a cero en el resto de los factores. Una de las

rotaciones ortogonales (los nuevos ejes después de la rotación siguen siendo

ortogonales) que procura generar una estructura de cargas simple es la rotación

26

Cuaderno técnico

6

varimax, implementada en la mayoría de los paquetes estadísticos. No hay

garantía de que una rotación produzca necesariamente una estructura de cargas

simple, pero, de hacerlo, puede ayudar a una interpretación mucho más fácil de

los factores. Existen otras rotaciones ortogonales (como quartimax y equimax),

pero ninguna tiene la popularidad de varimax.

Rotaciones oblicuas

Contrario a las rotaciones ortogonales, las rotaciones oblicuas permiten relajar la

restricción de ortogonalidad con el fin de ganar simplicidad en la interpretación

de los factores. Con este método los factores resultan correlacionados, aunque

generalmente esta correlación es pequeña. El uso de rotaciones oblicuas se

justifica porque en muchos contextos es lógico suponer que los factores están

correlacionados. Pese a que pueden ser de utilidad en algunas situaciones, estas

rotaciones raramente se usan, a diferencia de las ortogonales. Entre las rotaciones

oblicuas, promax es conceptualmente simple; sin embargo, la más popular es oblimin.

Valoración de las comunalidades

Además del análisis de la matriz de cargas factoriales, es importante verificar si

cada una de las variables incluidas en el análisis son explicadas aceptablemente

por el modelo. Esto puede lograrse analizando la estimación final de las comunalidades. Puesto que la comunalidad representa la proporción de la varianza

de la variable indicadora que es explicada por los factores comunes del modelo,

Hair et al. (1998/1999) proponen que las variables con una comunalidad menor a 0.5

carecen de una explicación suficiente y no deberían ser consideradas en la interpretación

final del análisis.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

27

Puntajes factoriales

Una vez realizado el análisis factorial, quizá con alguna rotación de los factores,

el paso final es asignar los puntajes factoriales (scores) a cada individuo en la

muestra. Esta construcción de puntajes genera una nueva variable por cada

factor en el modelo. Usualmente estas variables derivadas del análisis factorial

pueden utilizarse como insumo para otros procedimientos estadísticos de

interés. Existen dos métodos para construir estos puntajes factoriales, a saber:

el método de Bartlett o de mínimos cuadrados ponderados y el método de

Thompson o de regresión (capítulo 3).

Bondad de ajuste del modelo de factores

Dado que el análisis factorial se realiza a través de un modelo, ¿qué tan bien

ajusta este modelo a nuestros datos? Un primer elemento de juicio lo constituye

la matriz de residuos, definida por:

que es la diferencia entre nuestra matriz observada de correlaciones y la matriz

de correlaciones reproducida por el modelo de factores. Si estas diferencias son

pequeñas, se puede afirmar que el modelo de factores ajusta bien a los datos.

Los valores de estas matrices están acotados entre –1 y 1, de modo que las diferencias deben ser realmente pequeñas. Paquetes estadísticos como spss remarcan

diferencias menores o iguales a 0.05. Obsérvese además que los elementos en la

diagonal de esta matriz de residuos son las especificidades del modelo. Un buen

ajuste significa, en este caso, que el modelo con k factores es adecuado para

nuestra información.

28

Cuaderno técnico

6

Análisis factorial con variables discretas

El análisis factorial estándar se realiza con variables continuas; sin embargo, en

muchas áreas de aplicación lo usual es tener variables medidas en escalas

nominal u ordinal. En estos casos, lo adecuado es realizar el análisis respetando

el orden de medición de las variables involucradas. Dado que el análisis factorial

se basa en el uso de la matriz de correlación, una manera de considerar la escala

de medición de las distintas variables involucradas en el estudio es calcular el

tipo de correlación que corresponda a cada par de variables, de acuerdo con

su escala particular. En este sentido, la tabla siguiente muestra el tipo de

correlación que conviene calcular, de acuerdo con el orden de medición de las

variables involucradas.

Tabla 4. Medidas de correlación entre variables

Escala de medición

Continua

Continua

Pearson

Ordinal

Ordinal

Dicotómica

Poliserial

Punto biserial

Policórica

Policórica

Dicotómica

Tetracórica

El análisis factorial supone la existencia de una variable latente continua con

distribución normal. De esta manera, cuando se utilizan variables discretas

(ordinales y dicotómicas), estás se utilizan como si fueran continuas.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

29

Capítulo III

Fundamentos técnicos del análisis factorial

Aspectos formales

E

n este apartado presentaremos algunos aspectos formales de la teoría que

sustenta este análisis. La presentación se hará de manera general, considerando el modelo multifactorial del que se desprende, como caso particular,

el modelo unifactorial. A lo largo de la exposición se definirán algunos de los

conceptos relacionados con esos modelos.

Supongamos que tenemos un conjunto de variables observadas X1, X2,...,

Xp y se asume que en este conjunto subyacen k factores con k<<p. Sin perder

generalidad, podemos suponer que las variables están centradas sobre sus medias,

i.e.; tienen media cero.

Una manera usual de escribir el modelo factorial es a través de su representación

en forma matricial:

Donde,

Con X, la matriz de datos, Λ la matriz de cargas factoriales, y f y U son los

vectores de variables no observables.

A f1, f2,...,fk se les denomina factores comunes (comunalidad) y a u1, u2,...,up

factores específicos (especificidad).

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

31

Algunos supuestos sobre los que se construye el modelo son:

1. Los factores comunes fj j=1,2,...,k no están correlacionados y tienen media

cero y varianza uno.

2. Los factores específicos ui no están correlacionados y tienen media cero y

varianzaΨi i=1,2,...,p.

3. Los factores comunes no están correlacionados con los factores específicos.

Bajo estos supuestos tenemos que:

con hi2 conocida como la comunalidad de la variable, que es la varianza de la

variable Xi , explicada por los factores comunes, y Ψi conocida como especificidad,

la varianza no explicada por estos factores comunes.

Además, podemos observar que los factores comunes explican las relaciones

entre las variables medidas del estudio, y así se convierten en el objeto de interés de este análisis. Es por lo tanto importante que estén bien determinados y

puedan ser interpretados en el contexto de la aplicación que les dio origen. La

inclusión de los factores específicos en el modelo obedece al hecho de que es

generalmente imposible expresar de manera exacta a nuestras p variables por

medio de un número más reducido k de factores.

32

Cuaderno técnico

6

Es común hacer el análisis factorial con las variables estandarizadas, i.e.,

variables con media cero y varianza uno; entonces lo que tenemos son correlaciones entre las variables, en lugar de covarianzas. Si denotamos como R a la

matriz de correlación de X la matriz de datos estandarizados, la descomposición

anterior se puede escribir, de forma matricial, como

con Ψ una matriz diagonal con elementos , e I la matriz idéntica, que tiene

unos en la diagonal y ceros fuera de ella. De aquí tenemos

para toda i ≠ j además

entonces, el objetivo del análisis factorial es determinar k: número de factores,

^

Λ y Ψ utilizando la matriz de correlación muestral R.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

33

Soluciones múltiples al modelo

Un aspecto muy importante es que la solución del modelo de factores no es

única, en el sentido de que si tenemos una matriz ortogonal M (la condición de

ortogonalidad => MM’=I), podemos escribir:

Entonces, si Λ es una matriz de cargas factoriales, ΛM también lo es, para

toda matriz ortogonal, M. Por lo tanto, la matriz de cargas factoriales no es

única, y esto implica que los factores tampoco son únicos.

Para garantizar una solución única en este modelo debemos anexar alguna

restricción. La forma usual de este tipo de restricciones es alguna de las siguientes:

con Λ y D matrices diagonales.

Obsérvese que el producto de Λ’Λ no genera una matriz diagonal, aunque

las restricciones del modelo exigen que lo sea, es decir que los elementos fuera

de la diagonal de este producto sean cero. Por ello, y ya que fuera de la diagonal

tenemos k(k-1) elementos, entonces es necesario este número de restricciones

para garantizar una solución única del modelo.

34

Cuaderno técnico

6

Número máximo de factores

De acuerdo con la discusión anterior, conviene saber cuál es el máximo número

de factores que podemos extraer de un conjunto de p variables manifiestas.

En este tipo de análisis ¿quién o qué constituye nuestra información? Como la

idea es descomponer la matriz de correlación, entonces los elementos no redundantes de ésta, representan nuestra información. En el caso de que tengamos

p variables indicadoras, el número de elementos no redundantes es p(p+1)/2.

Ahora bien, necesitamos estimar p*k cargas factoriales totales y p especificidades,

entonces necesitamos estimar p(k+1) parámetros de nuestro modelo. Y necesitamos imponer a este número de parámetros por estimar, k(k-1) restricciones

para obtener una solución única. Es lógico suponer que esta diferencia entre

los parámetros por estimar y las restricciones no debe exceder el número de

elementos no redundantes de la matriz de correlación (nuestra información

observada). Entonces, se debe cumplir que:

A partir de esta desigualdad podemos observar que el mínimo de variables

requeridas para extraer un factor es 3 (véase que en este caso se cumple la igualdad).

Con cinco variables manifiestas podemos tener a lo más dos factores; con 20 el

número máximo de factores puede ser hasta de 14; sin embargo, en la práctica

no se busca encontrar este número máximo, sino aquel que nos permita explicar

de la mejor manera posible las correlaciones entre estas variables medidas.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

35

Un ejemplo interesante

Como acotamos en el párrafo anterior, cuando se tienen tres variables manifiestas y un solo factor, se cumple la igualdad en este criterio para el número

máximo de factores. Al respecto, Everitt (2001) proporciona el siguiente ejemplo,

que, además de tratar con detalle esta situación, nos proporcionará una visión

clara de los procesos inmersos en la solución de estos modelos.

Se tienen las calificaciones de exámenes de un grupo de estudiantes, en las asignaturas de X1: Literatura clásica, X2: Francés y X3: Inglés, de las que se obtiene

la siguiente matriz de correlaciones:

X1 X 2 X3

como no puede ser de otra forma, asumimos que un único factor subyace a

este conjunto de variables, que podríamos denominar habilidades lingüísticas,

por ejemplo. Entonces, el proceso para estimar los parámetros es el siguiente:

Escribamos inicialmente el modelo de factores:

como comentamos líneas arriba, el objetivo es encontrar, a partir de la matriz

de correlación R, las matrices Λ̂ y Ψ̂. En este caso tenemos:

36

Cuaderno técnico

6

de este sistema se desprenden las ecuaciones:

λ1λ2=0.83

λ1λ3=0.78

λ2λ3=0.67

de donde concluimos que λ1λ2 λ3 = √ 0.83 * 0.78 * 0.67 = 0.6586 y finalmente

obtenemos que:

De las relaciones

se tiene que

por lo que

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

37

podemos observar que todos los parámetros estimados tienen valores admisibles.

Supongamos ahora que tomamos una nueva muestra sobre estos exámenes,

que arroja la siguiente matriz de correlación:

entonces, realizando el procedimiento anterior llegamos a:

que tiene dos parámetros estimados inadmisibles, var(X1)= Ψ̂1 =-0.44 y λ̂1 =1.2.

Este último debido a que estima la correlación entre X1 y f1, por lo que no puede

ser mayor que uno. El ejemplo muestra que la igualdad en el criterio del número

máximo de factores que se pueden extraer, puede generar resultados inapropiados,

por lo que es preferible considerar la desigualdad estricta. También ilustra

el principio sobre el que se basa el proceso de estimación: igualar la matriz de

correlaciones generada por el modelo, que involucra a los parámetros que

lo componen, con la matriz de correlación estimada con la información.

Métodos de estimación

Si definimos como Σ( −

θ ) a la matriz de correlaciones que se desprende del

modelo, y a S, la respectiva de los datos, entonces el objetivo de los métodos de

38

Cuaderno técnico

6

estimación es minimizar alguna función de distancia entre estas dos matrices, es

decir, la función por minimizar es de la forma:

con G alguna función específica. Los valores en Σ( θ− ) que minimicen esta

función de distancia serán los estimadores de sus parámetros. Tomando en

cuenta que Σ se puede descomponer como:

los procesos que minimizan esta función de distancia entre estas dos matrices

son equivalentes a encontrar los estimadores de Λ y Ψ tales que:

este hecho ya se había evidenciado en el ejemplo mostrado anteriormente.

Máxima verosimilitud

En este caso, la función de distancia se desprende de la verosimilitud del

modelo, y tiene la forma

aunque en este método el objetivo es maximizar la verosimilitud, cabe recordar

que maximizar es equivalente a minimizar el negativo de esta verosimilitud.

Este método de estimación demanda que X tenga una distribución normal

multivariada, hecho que en la práctica es muy difícil que se cumpla. No obstante,

se ha encontrado que el método es robusto ante desviaciones de la normalidad.

Sin embargo, es inadecuado su uso con variables nominales u ordinales.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

39

Mínimos cuadrados

En este caso, la función que se minimiza es:

que también puede considerarse una medida de distancia entre la matriz observada

S y la matriz generada por el modelo Σ. Se minimiza la suma de cuadrados de las

diferencias entre estas dos matrices. Nuevamente, los valores de los parámetros

que minimicen esta función serán los estimadores.

Mínimos cuadrados generalizados

Este método es una generalización del de mínimos cuadrados; la función por

minimizar es:

la intención es minimizar la suma de cuadrados de todos los elementos en este

producto de matrices.

Mínimos cuadrados ponderados

En este método el objetivo es minimizar la diferencia entre la matriz generada

por el modelo y la estimada por nuestros datos, ponderando estas diferencias

por una matriz de pesos. Concretamente, la función que debemos minimizar

tiene la forma:

con Ψ la matriz definida anteriormente.

40

Cuaderno técnico

6

Método de rotación de ejes principales

En este caso se utiliza la llamada matriz reducida S* definida como

por lo que los elementos en la diagonal de S* son las comunalidades estimadas.

Este proceso requiere de una estimación inicial de estas comunalidades. Los

métodos más frecuentes para estas estimaciones iniciales son:

• El coeficiente de correlación múltiple entre cada Xi y el resto de las variables, y

• El mayor coeficiente de correlación, en valor absoluto, entre Xi y cualquiera

de las otras variables, es decir:

a partir de las estimaciones iniciales de las comunalidades se hace un proceso

de componentes principales sobre S* para encontrar las cargas factoriales.

Posteriormente se actualizan los estimadores de las comunalidades. El proceso

continúa de forma iterativa, hasta que el cambio en las estimaciones entre dos

iteraciones consecutivas es prácticamente nulo.

Prueba sobre el número de factores en el modelo

En esta prueba el objetivo es contrastar si el modelo con k factores que hemos

propuesto ajusta bien a los datos. En otras palabras: si k factores son suficientes

para explicar la estructura de correlación subyacente a las variables medidas.

Esta prueba supone que la matriz de datos X tiene una distribución normal

multivariada. Bajo este supuesto tenemos que:

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

41

cuyo estadístico de prueba es:

que se distribuye como una χ2v con v = ½[( p - k)2 - ( p + k)], entonces rechazar

H0 implica que el número de factores elegido no es suficiente para la descripción

adecuada de la estructura de correlación, y hay necesidad de agregar más

factores. Esta prueba se basa en la normalidad multivariada de X, que es difícil

de cumplir, por lo que, en la mayoría de los casos, sólo se podrá usar como una

referencia.

Puntajes factoriales

Método de Bartlett o de mínimos cuadrados ponderados

El desarrollo de este método de construcción de puntajes es como sigue:

Generamos Z: Matriz de datos estandarizados. Entonces, el modelo de factores

se puede expresar en función de Z, como:

Z=Λf+U con U~(0,Ψ) De donde tenemos que:

U’U=(Z-Λf )’(Z-Λf ) (Mínimos cuadrados) o

U’Ψ-1U=(Z-Λf )’ Ψ-1(Z-Λf ) (Mínimos cuadrados ponderados) con Ψ una matriz

de pesos.

42

Cuaderno técnico

6

Bartlett sugiere encontrar f que minimice:

El valor fi que minimiza esta

expresión es:

entonces, se toma a fi como el puntaje factorial del individuo i, i=1,2,...,n.

Método de Thompson o de regresión

Se supone X, f normales. Los puntajes son:

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

43

Capítulo IV

Aplicación con variables continuas

E

n este capítulo ejemplificaremos cómo realizar un análisis factorial con

variables continuas. Los análisis se presentan en dos paquetes: spss que es,

tal vez, uno de los paquetes estadísticos más usados en las ciencias sociales, y R,

que es un paquete gratuito, de gran desarrollo en estos tiempos. En el ejemplo

vamos a trabajar utilizando datos de aplicaciones reales del Examen Nacional

de Ingreso a la Educación Media Superior (exani-i).

Descripción general del EXANI-I

El exani-i es un examen de selección que elabora el Ceneval y que presentan

los estudiantes que terminaron la secundaria y desean continuar sus estudios

de educación media superior. Este examen evalúa sólo los conocimientos y

habilidades que se consideran indispensables para el progreso de los alumnos

en el bachillerato. El examen cuenta con dos secciones:

1. Habilidades intelectuales, que se integra con las subáreas de habilidad de

razonamiento verbal y de habilidad de razonamiento matemático.

2. Conocimientos disciplinarios, que se estructura con ocho subáreas relativas a las

asignaturas del plan de estudios de educación secundaria: español, historia,

geografía, formación cívica y ética, matemáticas, física, química y biología.

El Ceneval otorga a las instituciones educativas una calificación global de

los sustentantes, que es utilizada para seleccionar a los estudiantes que podrán

ingresar a su oferta educativa. Esta calificación global se proporciona en una

escala (índice Ceneval) que va de 700 a 1300 puntos, que es una transformación

lineal del número total de aciertos obtenido por cada sustentante.

Hasta finales de 2008, la calificación global del examen incluía a las 10 áreas

evaluadas. Sin embargo, en 2009, con la intención de responder a las demandas

de los usuarios, el exani-i fue modificado sustancialmente, convirtiéndolo en

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

45

un examen alineado al nuevo currículo de la secundaria, que ofrece una prueba

para selección (examen normativo) y diversas opciones para diagnóstico

(exámenes criteriales). Dado que aún no se cuenta con datos suficientes del

exani-i de nueva generación, el ejemplo que presentamos considera información del 2008, aunque los resultados no se puedan generalizar para la nueva

estructura del examen.

Definición del ejemplo

Objetivo

Comprobar que la variable latente “habilidad académica” es un factor que puede

explicar la asociación de los dominios que se evalúan en el exani-i .

Descripción de las variables

En este primer ejemplo se consideró la información de 1011 sustentantes que

presentaron el exani-i en junio de 2008.

Las variables manifiestas del modelo reportan el número de aciertos que

obtienen los sustentantes del exani-i en cada una de las 10 áreas que se

evalúan en el examen. En la tabla 5 se presentan los dominios que explora el

exani-i , y el número de reactivos con los que se explora esa variable.

46

Cuaderno técnico

6

Tabla 5. Dominios evaluados por el exani-i

Dominio

Núm. de reactivos

1. Habilidad verbal (HV)

2. Español (ESP)

3. Historia (HIS)

4. Geografía (GEO)

5. Educación cívica y ética (FCE)

6. Habilidad matemática (HM)

7. Matemáticas (MAT)

8. Física (FIS)

9. Química (QUI)

10.Biología (BIO)

16

12

12

12

12

16

12

12

12

12

En la figura 6 se muestra gráficamente el modelo factorial que se comprobará

mediante un factorial confirmatorio.

Figura 6. Modelo unifactorial del exani-i

HV

ESP

HIS

GEO

Habilidad

académica

FCE

HM

MAT

FIS

QUIM

BIO

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

47

Análisis en spss

Antes de iniciar el análisis factorial conviene que el investigador analice la

estructura de correlación de las variables bajo estudio y obtenga algunos datos

descriptivos. El paquete SPSS ofrece algunas opciones que permiten explorar

los datos antes de realizar el análisis factorial. En esta sección mostraremos

algunas de estas herramientas y mencionaremos su utilidad.

En el módulo Reducción de Datos (Data Reduction) de spss se encuentra la

opción para realizar el análisis factorial (Factor).

En esta sección el paquete estadístico tiene la posibilidad de efectuar algunos

análisis descriptivos.

48

Cuaderno técnico

6

Si presionamos el botón Descriptivos (Descriptives), aparecerá una ventana para

seleccionar varias estadísticas relacionadas con la matriz de correlación generada

por nuestros datos.

Veamos qué información nos proporcionan algunas de sus opciones (esta

información se desplegará una vez que se activaron las opciones y al momento

de ejecutar el análisis factorial):

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

49

Coeficientes (Coeficients)

Reporta la matriz de correlaciones entre las variables involucradas en nuestro

estudio. Al analizarla podemos ver la magnitud de asociación entre las variables,

identificando las variables que están muy asociadas (correlaciones altas) y las

que no lo están (correlaciones bajas). Determinar si las correlaciones son fuertes

o importantes depende del ámbito de aplicación y del tamaño de la muestra. En la

tabla 6 se muestra la matriz de correlación de las variables de nuestro ejemplo.

La primera tabla (Correlación) muestra las correlaciones entre las variables. El

rango va de 0.558 (correlación entre habilidad matemática (HM) y matemáticas

(MAT)) a 0.360 (correlación entre física (FIS) y educación cívica y ética (FCE)).

En la segunda tabla (Sig. Unilateral) se aprecia que todas estas correlaciones

son estadísticamente significativas (p-value=0). Estas correlaciones pueden

considerarse como importantes en el ámbito de las investigaciones educativas.

50

Cuaderno técnico

6

Tabla 6. Matriz de correlaciones entre las variables que evalúa el exani-i

Determinante de la matriz

Una medida global de la correlación entre todas las variables la proporciona el

Determinante de la matriz. Si este determinante está cercano a cero, será indicativo

de que existe una estructura de correlación importante entre las variables, y el

análisis factorial puede ser pertinente. En este conjunto de datos, el determinante

(en la parte inferior izquierda de la tabla anterior) es: 0.021, que es cercano a cero,

e indica que la estructura de correlación en este conjunto de variables es buena.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

51

kmo,

una prueba de adecuación muestral

La llamada medida de adecuación muestral (Measure of Sampling Adequacy)está

definida por:

Esta prueba es un índice que compara los coeficientes de correlación (r 2ij )

con los coeficientes de correlación parcial (r 2ij·m ). Esta última correlación es la

correlación entre dos variables, eliminando el efecto de las restantes variables

incluidas en el análisis. Entonces, si un par de variables está fuertemente correlacionada con el resto, la correlación parcial debe ser pequeña, ya que implica

que buena parte de la correlación entre estas variables puede ser explicada por

las otras variables en el análisis. Esto significa que está presente una fuerte

estructura de correlación entre ellas y, por lo tanto, tiene sentido realizar el

análisis de factores.

En el ejemplo, el denominador de la expresión anterior será cercano en

magnitud al numerador, puesto que la contribución de las correlaciones parciales

es prácticamente nula, y el índice kmo estará cercano a uno. Por el contrario,

si esta correlación parcial es grande, implica que estas variables tienen poca

correlación con el resto, lo que significa una estructura de correlación débil

entre el conjunto, y pone en tela de duda el análisis factorial. En este escenario,

la contribución de las correlaciones parciales es importante, y el denominador

será mucho mayor que el numerador, con kmo próximo a cero. Como regla

empírica se considera que si kmo<0.6, es inadecuado realizar un análisis

factorial a los datos. En la tabla 7 se muestra que el resultado de esta prueba fue

de 0.94, lo que indica que sí conviene realizar el análisis factorial.

52

Cuaderno técnico

6

La prueba de esfericidad de Bartlett

Si no hubiera estructura de correlación entre las variables involucradas en el

análisis factorial, la matriz de correlación sería la matriz identidad, es decir, tendría

ceros fuera de la diagonal (no habría correlación entre cualesquiera dos variables)

y unos en la diagonal. Entonces, debemos probar –como parte fundamental

para iniciar nuestro análisis factorial– que la matriz de correlaciones de nuestros

datos es distinta de la identidad. A este respecto, la prueba de esfericidad de

Bartlett contrasta la hipótesis nula de que la matriz de correlación es la identidad

contra la hipótesis alternativa de que es distinta de la identidad. Desafortunadamente, esta prueba asume que las variables tienen una distribución normal

multivariada, por lo que en muchas aplicaciones debe usarse únicamente como

una referencia. Los resultados de esta prueba, en nuestro caso, pueden consultarse en la tabla 7.

Tabla 7. Pruebas kmo y de esfericidad de Bartlett

kmo

y pruebas de Bartlett

Medida de adecuación muestral

de Kaiser-Meyer-Olkin

Prueba de esfericidad de Bartlett

0.94

Chi-cuadrado aproximado

gl

Sig.

3872.928

45

.000

Ambas pruebas evidencian que la estructura de correlación entre nuestras

variables es fuerte. Una vez que tenemos una idea de las variables que se

encuentran asociadas y las que no, y que las pruebas kmo y de Bartlett nos

indiquen que en general todas nuestras variables están correlacionadas, iniciaremos el análisis factorial de los datos.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

53

Estimación del modelo factorial

En el módulo de análisis factorial se deberán especificar ciertas condiciones

medulares antes de iniciar el análisis de los datos, tales como el número de

factores y el método de extracción. Estas opciones pueden seleccionarse en la

ventana Extracción (Extraction) que se despliega desde la ventana principal del

Análisis factorial.

Nota: El programa spss tiene seleccionado, por defecto, el método de

extracción de Componentes principales. Sin embargo, este método representa un

análisis conceptualmente diferente al análisis factorial común que se abordó en

este cuaderno. Además, no debe confundirse con el método de Factorización de

ejes principales que es el que utilizaremos en todos los ejemplos.

Número de factores

Existen dos posibilidades de análisis factorial: una es el análisis confirmatorio

(cuando se desea probar una estructura factorial) y la otra es el análisis exploratorio

(cuando se desconoce la estructura de factores).

Cuando se realiza un análisis exploratorio se suele utilizar como criterio inicial

retener en el análisis todos los factores cuyo Eigenvalor (Valor propio) asociado sea

54

Cuaderno técnico

6

mayor que uno. La razón para esta decisión es que, ya que el análisis se realiza

con las variables estandarizadas, entonces cada una de ellas tiene varianza uno,

por lo que se considera que si un factor no explica más varianza que la de una

variable, entonces no tiene sentido considerarlo.

Sin embargo, en el ejemplo que estamos trabajando realizaremos un análisis

confirmatorio, dado que deseamos probar que las variables que se evalúan en el

exani-i pueden ser ajustadas en una estructura unidimensional.

Método de extracción

Aquí decidiremos qué método de estimación debemos utilizar. Se acostumbra

utilizar el de máxima verosimilitud, pero este método es muy demandante de

supuestos que deben cumplir las variables bajo estudio. Un método menos

demandante de supuestos –y por lo tanto más recomendable para las variables que

se incorporarán en el modelo– es el método de Factorización de ejes principales

(Principal axis factoring). Fue escogido para nuestro análisis de los datos.

En la ventana Extracción (Extraction) se presentan opciones para elegir la

matriz por utilizar: de correlación o covarianza. Asimismo, una ventana para

desplegar la solución de los factores sin rotar y, finalmente, en esta parte

del módulo se puede solicitar que en los resultados se incluya una gráfica de

sedimentación (gráfica de codo o scree plot).

Para llevar a cabo el análisis de los datos del ejemplo que estamos trabajando,

elegimos las siguientes opciones:

• Método: Factorización de ejes principales (Principal axis factoring)

• Analizar: Matriz de correlación (correlation matrix)

• Número de factores: 1

Como sólo tendremos un factor, no podremos rotarlo ni observar el gráfico

de codo.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

55

Resultados del análisis

Una vez seleccionadas las opciones para el análisis, debemos elegir las 10

variables que incluiremos y presionar el botón Aceptar en la pantalla principal

de Análisis factorial.

La tabla 8 muestra las comunalidades de las variables involucradas. Podemos

observar que la proporción de varianza de cada variable (Extracción), que explica

este factor, fluctúa entre 35% y 53.1%, lo que implica que una gran parte de estas

varianzas no son explicadas por el factor. En la salida del paquete una columna

denominada Inicial (Initial) corresponde al valor inicial utilizado por el proceso

iterativo.

En la tabla 9 se muestran los Eigenvalores asociados a cada factor, y su

respectivo porcentaje de varianza explicada. Como nosotros sólo seleccionamos

un factor, el porcentaje correspondiente es 44.448%, cercano al 60% recomendado en aplicaciones en Ciencias Sociales.

56

Cuaderno técnico

6

Tabla 8. Comunalidades del modelo

unifactorial del exani-i

Comunalidades

Inicial

Extracción

HV

ESP

HIS

GEO

FCE

HM

MAT

FIS

QUI

BIO

.486

.465

.361

.389

.350

.449

.460

.324

.435

.358

.531

.522

.396

.427

.380

.483

.494

.350

.474

.392

Tabla 9. Total de la varianza explicada por el modelo unifactorial del exani-i

Varianza total explicada

Autovalores iniciales

Factor

Total

% de la

varianza

%

acumulado

1

2

3

4

5

6

7

8

9

10

4.996

.760

.678

.634

.569

.549

.493

.476

.447

.398

49.965

7.603

6.775

6.338

5.692

5.489

4.933

4.756

4.469

3.981

49.965

57.567

64.343

70.680

76.373

81.862

86.794

91.550

96.019

100.000

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

Sumas de las saturaciones

al cuadrado de la extracción

Total

% de la

varianza

4.449

44.448

%

acumulado

44.448

57

Finalmente, la tabla 10 muestra las cargas factoriales de cada una de las variables

observadas con el factor. Estas cargas representan la correlación de la variable con

el factor. En este caso, puede observarse que las cargas van de 0.591 a 0.729. El

juicio sobre qué tan fuertes son estas correlaciones se deja a criterio del área de

aplicación. En investigaciones educativas, estas correlaciones podrían considerarse como buenas, con lo que confirmamos que el exani-i tiene una estructurara

unifactorial subyacente.

Con los resultados del ejemplo podríamos concluir que la variable latente

“habilidad académica” es suficiente para explicar la relación que mantienen las

10 variables manifiestas (dominios), así que brindar una calificación global del

exani-i no resulta inadecuado, ya que todas las variables que se evalúan están

asociadas entre sí.

Tabla 10. Cargas factoriales

de las variables manifiestas

Matriz factoriala

HV

ESP

HIS

GEO

FCE

HM

MAT

FIS

QUI

BIO

Factor

1

.729

.723

.629

.654

.616

.695

.703

.591

.688

.626

Método de extracción: Factorización del eje

principal.

a

1 factores extraídos. Requeridas 4 iteraciones.

58

Cuaderno técnico

6

Es muy importante que el investigador detecte si hay un grupo de variables

con cargas factoriales bajas –un claro indicio de que esas variables no pueden

ser explicadas por el factor. En este caso convendría revisar la teoría o evaluar

otro modelo.

Bondad de ajuste

¿Qué tan bien ajusta a los datos este modelo unifactorial? Para responder esta

pregunta analizaremos la matriz de residuos (para desplegar esta matriz es necesario seleccionar la opción Reproducida (Reproduced) en la ventana Descriptivos

(Descriptives).

En la primera sección de la tabla 11, denominada Correlación reproducida, se

muestra la matriz que reproduce el modelo con nuestro único factor extraído.

La diagonal son las comunalidades (compárese con la tabla correspondiente).

Los valores fuera de la diagonal son las correlaciones entre las variables,

reproducidas por el modelo unifactorial. Para juzgar qué tan bien las reproduce,

observamos la segunda sección de la tabla: Residual. La diagonal, no mostrada

en la salida, debe ser la especificidad de cada variable (1 - comunalidad). Si la

calculamos, confirmaremos que mucha de la varianza de nuestras variables no

es explicada por el modelo. En la tabla 11 se observa que únicamente 8% de

las diferencias entre las correlaciones observadas y calculadas por este modelo

de un factor sobrepasan el corte por defecto de spss (0.05), lo que establece un

buen ajuste sobre las correlaciones entre las variables.

Desafortunadamente, spss no despliega una prueba formal sobre el ajuste

que se logra con este factor, así que no podemos determinar si es suficiente para

lograr un buen ajuste.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

59

Tabla 11. Matriz de correlaciones reproducidas por el modelo

Puntajes factoriales

Finalmente, podemos obtener los puntajes que le corresponden a cada uno

de los individuos en la base, dado el modelo unifactorial. En este paquete se

encuentran en la ventana Puntuaciones (Scores) y contiene tres opciones: Regresión

(Regression), Bartlett y Anderson-Rubin.

Las dos primeras fueron descritas previamente. Estos puntajes podrían ser

de utilidad en algún análisis posterior.

60

Cuaderno técnico

6

Análisis en R

¿Por qué realizar este análisis con este software gratuito? La justificación radica

en el hecho de que, además de ser libre (http://www.gnu.org), en este momento es

uno de los paquetes más utilizados en la investigación estadística.

El programa R es mantenido y actualizado esencialmente por la comunidad

de investigadores en estadística, lo que le sitúa a la vanguardia de los desarrollos

recientes en esta disciplina. Una característica que comparte con s-plus es la

enorme riqueza gráfica que posee.

Intentemos rehacer en este paquete todos los pasos que hicimos en spss.

Importa aclarar que R funciona a base de comandos, así que hay que escribirlos

para ejecutarlos. En seguida se presentan los principales resultados del análisis y

en el anexo 1 se describen las instrucciones para obtenerlos.

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

61

Descriptivos

Tabla 12. Matriz de correlaciones con niveles de significancia

HV

ESP

HIS

GEO

FCE

HM

MAT

FIS

QUI

BIO

HV

1.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

ESP

0.546

1.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

HIS

0.487

0.453

1.000

0.000

0.000

0.000

0.000

0.000

0.000

0.000

GEO

0.516

0.454

0.428

1.000

0.000

0.000

0.000

0.000

0.000

0.000

FCE

0.494

0.453

0.424

0.429

1.000

0.000

0.000

0.000

0.000

0.000

HM

0.511

0.525

0.396

0.457

0.386

1.000

0.000

0.000

0.000

0.000

MAT

0.465

0.510

0.394

0.472

0.392

0.558

1.000

0.000

0.000

0.000

FIS

0.374

0.438

0.367

0.365

0.360

0.422

0.439

1.000

0.000

0.000

QUI

0.476

0.475

0.429

0.408

0.401

0.466

0.513

0.459

1.000

0.000

BIO

0.449

0.433

0.420

0.392

0.385

0.408

0.437

0.361

0.490

1.000

Obsérvese que por arriba de la diagonal están los niveles de significancia y,

por debajo, las correlaciones entre pares de variables.

• Determinante de la matriz de correlaciones

0.0212698

• La prueba kmo arroja el siguiente valor

0.9131283

• Prueba de esfericidad de Bartlett

El estadístico de prueba en este caso es:

62

Cuaderno técnico

6

con n, el número de individuos en el estudio, p el número de variables, y |R|, el

determinante de la matriz de correlación. En nuestro caso tenemos:

n =1011, p=10 y |R|=0.0212698

Tras realizar los cálculos obtenemos:

T = 3872.928, que al comparar contra una χ2(45), nos proporciona un p-value

de cero.

Todos los análisis mostrados indican que es adecuado realizar el análisis

factorial. Implementaremos un análisis confirmatorio con un único factor y

método de extracción: Factorización de ejes principales. Al hacerlo en R, obtenemos

los siguientes resultados:

f.solЅ/values

4.449 0.195 0.118 0.029 0.005 -0.038 -0.049 -0.066 -0.080 -0.114

f.solЅ/rotation

"none"

f.solЅ/n.obs

1011

f.solЅ/communality

HV ESP HIS GEO FCE HM MAT FIS QUI BIO

0.531 0.522 0.396 0.427 0.380 0.483 0.494 0.350 0.474 0.392

f.solЅ/loadings

Análisis factorial: una técnica para evaluar la dimensionalidad de las pruebas

63

Loadings:

PA1

HV

0.729

ESP

0.723

HIS

0.629

GEO

0.654

FCE

0.616

HM

0.695

MAT

0.703

FIS

0.591

QUI

0.688

BIO

0.626

PA1

SS loadings 4.449

Proportion Var 0.445

f.solЅ/residual

64

HV

ESP

HIS

GEO

FCE

HV

0.469

0.019

0.028

0.040

0.045

ESP

0.019

0.478 -0.002 -0.019 0.007

HIS

0.028 -0.002 0.604

0.017

0.036 -0.041 -0.049 -0.005 -0.004 0.026

GEO

0.040 -0.019 0.017

0.573

0.026

FCE

0.045

0.007

0.026

0.620 -0.042 -0.041 -0.005 -0.023 0.000

0.036

HM

MAT

FIS

QUI

BIO

0.005 -0.047 -0.057 -0.025 -0.007

0.022

0.002

0.002

0.011 -0.023 -0.020

0.013 -0.022 -0.042 -0.017

HM

0.005

0.022 -0.041 0.002 -0.042 0.517

0.070

0.011 -0.012 -0.027

MAT

-0.047 0.002 -0.049 0.013 -0.041 0.070

0.506

0.023

0.029 -0.003

FIS

-0.057 0.011 -0.005 -0.022 -0.005 0.011

0.023

0.650

0.052 -0.009

QUI

-0.025 -0.023 -0.004 -0.042 -0.023 -0.012 0.029

0.052

0.526

0.059

BIO

-0.007 -0.020 0.026 -0.017 0.000 -0.027 -0.003 -0.009 0.059

0.608

Cuaderno técnico

6

f.solЅ/fit

0.885

f.solЅ/fit.off

0.995