"LA ENTROPIA: MEDIDA DE LA DESIGUALDAD".

Anuncio

COMUNICACIÓN

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

"LA ENTROPIA: MEDIDA DE LA DESIGUALDAD".

José Luis Cuenca Tadeo

Mª Carmen Reyes Molero

Universidad San Pablo-CEU

1.- Introducción.

La ciencia1, desde sus orígenes, se ha considerado a sí misma como algo separado. La división de la

ciencia no se hubiera podido evitar con su devenir histórico. Hay autores que consideran a Leibnitz como

el último hombre que sabía de todo. La afirmación es exagerada, sin embargo, sustancialmente cierta.

Hasta los últimos años del siglo dieciocho, las mentes más privilegiadas estaban en condiciones de

abarcar toda la ciencia de su tiempo, tener un perfecto conocimiento de varios idiomas, y una vasta

cultura.

La acumulación de saber científico desde el siglo dieciocho, hizo necesario dividir y clasificar de manera

diferente el conocimiento, que desde aquel momento creció exponencialmente . Resultado de esta

división fue, el nacimiento de diferentes disciplinas. Hace poco más de un siglo la ciencia se separó

formalmente de la filosofía, dividiéndose en dos ramas: física y química.

De esa primera división surgieron otras nuevas ramas, tales como la biología, la psicología que derivó de

la biología y la ciencia social de lo hizo de la psicología. Esta proliferación de disciplinas científicas se

produjo a comienzos de este siglo. La división de la ciencia continua y las disciplinas se multiplican.

Pero la naturaleza no está organizada de igual forma como lo está el conocimiento que de ella tenemos.

Los científicos comenzaron a investigar aquellas áreas que menos afectaban las creencias sociales,

culturales, religiosas y morales. Los científicos y los filósofos han querido afrontar la historia de la

ciencia con una lógica mayor que la que la historia proporciona. Han tratado de racionalizar el orden de

desarrollo de las disciplinas atendiéndose al principio de jerarquía de las ciencias.

Por esto la física se ocupa de los objetos, de los fenómenos y de las propiedades en sus expresiones más

simples e irreductibles y son directamente observables. Cada disciplina posterior se ocupa de funciones y

de agregaciones más complejas de estos objetos, fenómenos y propiedades. La conclusión de cualquier

disciplina, se derivaba de aquella de la que procedía. La física se considera básica y fundamental.

Se acepta con generalidad que la ciencia física trata la realidad última y que para hacerlo no necesita

ayudas externas de ninguna otra disciplina. Esta opinión se mantiene a pesar de que no existe ningún

concepto en cualquier disciplina que sea básico y que no pueda ser mejorado por otras disciplinas.

El hombre identifica los hechos, trabajando con diversas metodologías. Así es posible, que un mismo

objeto puede ser estudiado desde la vertiente de ciencias distintas. El crecimiento de aplicación de la

1.ACKOFF, R.L.: " Redisigning the Future" . Jhon Wiley and Sons.

853

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

ciencia hizo conveniente organizar los descubrimientos según su campo de aplicación atendiendo a las

profesiones y disciplinas científicas. Las profesiones que precedieron a la ciencia, cambiaron sus

procedimientos y reglas por la influencia de las científicas, al igual que lo hicieron las nuevas profesiones.

Las clasificaciones del saber científico en disciplinas y profesiones pueden ordenarse mediante una

matriz de doble entrada en la que se reflejen las distintas disciplinas en las filas de dicha matriz y las

profesiones en sus columnas. Esta matriz irá incrementando con nuevas disciplinas (filas) y profesiones

(columnas). Cuando se tratan agregados de problemas, los sistemas - desórdenes- hacen necesario una

organización de la actividad científica y tecnológica diferente.

Entre las dos guerras mundiales aparecieron investigaciones multidisciplinares para dar respuesta a las

nuevas necesidades del desarrollo científico y técnico. Con este tipo de planteamiento , los problemas

complejos se descompone en problemas unidisciplinarios que se suponen resolubles independientemente.

Por este motivo, eran asignados a diferentes disciplinas y profesiones y resueltos separadamente. Las

soluciones, a su vez se agregaban voluntariamente o espontáneamente.

La investigación interdisciplinar de los problemas complejos no descompone las distintas partes sino

que trata el todo por las distintas disciplinas que trabajan conjuntamente. El fruto del movimiento

interdisciplinar fue la aparición de la investigación operativa, las ciencias de dirección, de política, de

planificación, de comunicación y la investigación general de los sistemas.

La complejidad de los problemas, aumenta la necesidad de unificar las disciplinas llegando a lo que se ha

denominado metadisciplina. Lo ocurrido en las últimas décadas puede interpretarse como una evolución

de tránsito hacia la síntesis del saber humano en el ámbito de la ciencia, la tecnología y las humanidades.

El estudio eficaz de los sistemas sociales necesita la síntesis entre la ciencia y los profesionales que las

practican. La investigación operativa, la ciencia de la dirección y las otras disciplinas han obtenido

resultados significativos. Sus logros han sido menos significativos porque el desarrollo ulterior no ha

sido parejo a la creciente complejidad de las situaciones a las que los directivos y administradores se

enfrentan.

Las ciencias de la dirección no son suficientemente amplias como para hacer verdaderamente científica la

dirección de una empresa. Sería importante, conocer el porcentaje de decisiones tomadas por los

directivos basadas en ellas. La investigación operativa no es suficientemente amplia como para estudiar

con éxito las características operativas de nuestro sistema social. Esto quiere decir, que ésta

interdisciplina no es suficiente, como no lo son, las otras comentadas anteriormente fallan por la

aptitud que adoptan quienes necesitan tratar los desórdenes y por los métodos y principios que se aplican.

Esta comunicación que hoy presentamos, se enmarca en un trabajo de mayor embergadura que trata del

desarrollo del concepto de entropia, desde sus orígenes en la termodinámica física hasta su utilización en

las ciencias sociales y dentro de éstas en las ciencias económicas, pasando por la Teoría de la

Comunicación.

2.- Igualdad y desigualdad en economía.

Las medidas de concentración sirven para poner de relieve el mayor o menor grado de igualdad en el

reparto del total de los valores de una variable económica. Por esta razón son indicadores del grado de

equidistribución de la variable. Desde el punto de vista de la equidad otras mediadas de posición o

dispersión no facilitan información relevante respecto al orden o igualdad de la variable que se estudia.

Las medidas de concentración se aplican especialmente a variables económicas tales como los salarios de

una empresa, las rentas que perciben las unidades económicas, la financiación que reciben las distintas

comunidades o estados de un país, la evolución de los ingresos realmente recibidos a lo largo del tiempo,

854

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

la concentración industrial, etc.. Definimos la concentración como la mayor o menor equidad en el

reparto de la suma total de la variable considerada.

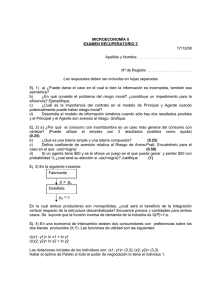

Así, dada una distribución de frecuencias de la variable xi si ordenada resultase que:

x1 ≤ x2 ≤ ........ ≤ xi ≤ .............. ≤ xn

estamos interesados en estudiar hasta que punto

Q

∑ [ ;

L

L está equitativamente distribuida. Además de los estudios tradicionales por medio del indice de

concentración de Gini, Enri Theil2 basándose en el concepto de entropia observó que el grado de

desigualdad podía ser estudiado por medio de dicha función ya que la cuantía de cada variable podía

expresarse como un cociente respecto del total, de manera que cada cociente era siempre mayor que cero

y la suma de los cocientes de todas las variables era igual a la unidad. Permitiendo ello, razonar en

términos de probabilidad, tal y como la teoría de la información, predecesora de ésta aplicación al

campo económico, precisaba.

3.- Entropia en las variables unidimensionales. Concepto y propiedades.

Siendo ξ una variable aleatoria discreta que toma los valores xi, para i = { 1, 2, ..., n}, en los que la

probabilidad de que ocurra cada uno de los sucesos vienen dadas por P ( xi ) que es un valor

comprendido entre 0 y 1, es decir que verifica que:

P ( xi ) ≥ 0, ∀ i

y la suma de la probabilidad de todos los sucesos posibles es igual a 1:

Q

∑3 [ L

L 3 [ 3 [ 3 [ Q Definimos entropia de la variable aleatoria ξ , la denotamos por H a la siguiente expresión sí existe:

Q

+ ξ + > 3 [ 3 [ 3 [ Q @ ∑ 3 [ L log 3 [ L L En la entropia de la información, la base de los logaritmos es la binaria, aunque habitualmente no se

indicará y se deberá sobre entender salvo que se indique otro proceder. No obstante conviene recordar que

entre los logaritmos se verifica la siguiente propiedad:

Install Equation Editor and doubleclick here to view equation.

Expresada como producto la igualdad anterior

log0 loglog0

expresión a la que llegamos operando con potencias. Un número M cualquiera puede ser expresado como

potencias distintas dependiendo de las base y de los exponentes que se consideren. Así tendremos que: M

= 10 z y también M = 2 y, siendo z e y números apropiados que permiten que sea cierta la igualdad. Por

otro lado, es posible expresar el número 2 como una potencia en la que la base sea 10 y el exponente un

número x conveniente para que sea cierta la igualdad, es decir 2 = 10 x. Por tanto:

2.Theil, E. "Economics and information theory". Noth-Holland Publishing Company. Amsterdam Rand McNally & Company. Chicago

855

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

0 ] \WDPELdQ [

siendo x , y, z números reales.

] \ > [ @ \ [\_ ] [ \

para que se verifiquen las igualdades de la izquierda y de la derecha tiene que ocurrir que z = x . y.

De las anteriores igualdades tomando logaritmos se verifica que:

[ log \ log 0 \] log0 por tanto:

log 0 log log 0 \GHVSHMDQGR

log 0 log 0

≈log 0

log En la definición de entropia intervienen los n productos de la probabilidad de que ocurra el suceso P ( xi

) y el - log 2 P ( xi ) . A este último término se le denomina autoinformación. Es tanto mayor cuanto

menor es la probabilidad de que el suceso xi ocurra. El producto de n términos formados por el producto

de P ( xi ) . - log 2 P ( xi ) representan el valor medio de las informaciones que pueden proporcionar los

resultados posibles de las variables aleatorias. La entropia, de la información, representa una medida de la

incertidumbre, esto se justifica por sus propiedades3.

1ª PROPIEDAD: La entropia siempre es mayor o igual que cero. En particular la H es igual a cero

cuando ocurre que un valor i cualquiera, acumula toda la probabilidad de que el suceso ocurra (suceso

cierto) P ( xi ) = 1, y el resto de los j _ i son iguales a cero P ( xj ) = 0 (sucesos imposibles).

Demostración: Vamos a segregar la demostración de la misma en dos partes según que se verifiquen la

desigualdad estricta H > 0, en primer lugar, y en el otro caso cuando H = 0.

a) La probabilidad de que ocurra cualquier suceso P ( xi ) está comprendida entre 0 y 1, es decir 0 < P (

xi ) < 1. Por estar comprendida la probabilidad entre estos valores, se verifica que el logaritmo de la

probabilidad de cualquier suceso log2 P(xi) estará comprendida entre - ∞ y 0, es decir - ∞ < log2 P ( xi )

< 0, o de manera equivalente log2 P ( xi ) ∈ ( - ∞ , 0), por tanto log2 P ( xi ) siempre será negativo. Como:

Q

Q

L L + ∑3 [ L log 3 [ L ∑3 [ L log 3 [ L 3 [ log 3 [ 3 [ log 3 [ 3 [ Q log 3 [ Q @

y dado que todos los logaritmos de la probabilidad de xi son negativos, constituirán un conjunto de

términos positivos y por ello será H > 0.

b) La H = 0, si P ( xi ) = 1 y P ( xj ) = 0, ∀ j _ i. Para demostrarlo partimos de la definición de entropia:

Q

Q

L L + ∑3 [ L log 3 [ L ∑3 [ L log 3 [ L 3 [ log 3 [ 3 [ log 3 [ 3 [ L log 3 [ L 3 [ Q log 3 [ Q @

3.Gil Alvarez, P. :"Teoría Matemática de la información (con aplicaciones a la Estadística)".Ediciones ICE.

856

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

suma compuesta por n términos de la forma 0 . log 2 0 = 0 . ( -- ∞ ) que es un producto indeterminado,

excepto el término i-esimo que es de la forma 1 .log 2 1 = 1. 0 = 0. El valor real de la indeterminación 0 .

( -- ∞ ) = 0 como puede comprobarse a continuación.

lim

3 [ L >3 [ log 3 [ @ lim >

L

→

L

3 [ L →

log 3 [ ∞

@ ∞

3 [ L

L

hemos convertido la indeterminación de producto en indeterminación de cociente, en la que es posible

aplicar la regla de L´Hôpital, tantas veces como sea necesaria hasta que la indeterminación converja a un

valor concreto.

log H

log 3 [ 3 [ lim >

@ lim →

→

3 [ >3 [ @

lim > log H3 [ @ FTG

L

3 [ L L

3 [ L L

3 [ L →

L

L

En consecuencia, por ser la suma de todos los n términos iguales a 0, la entropia H = 0.

2ª PROPIEDAD: Si todos los resultados son equiprobables la entropia coincide con la medida de

Hartley, es decir es igual al log n.

Demostración:

Si todos los sucesos son igualmente probables, entonces se verifica que:

3 [ 3 [ 3 [ L por tanto,

Q

Q

+ ∑3 [ L log 3 [ L ∑ log Q

L Q

L > log log log @

Q

Q Q

Q

Q

Q

Q

log log log Q

Q

Q

Q

3ª PROPIEDAD: Si dos variables aleatorias se diferencian entre sí en un resultado que tiene probabilidad

nula, entonces sus entropias son idénticas.

Demostración: Si la variable aleatoria ξ toma los valores x1, x2, ... xn y otra variable aleatoria _ toma los

valores y1, y2, ..., yn, yn+1 y sin perdida de generalidad se verifica que P ( yn+1 ) = 0, y para el resto de los

sucesos xi = yi entonces se verifica que

H [ P (x1 ), P (x2 ), ... P (xn )] = H´ [ P( y1 ), P (y2 ), ...,P( yn ), P( yn+1 )]

Denotamos por H y H´las entropias respectivas de las variables ξ y _, aplicando la definición de entropia

a ambas variables resulta que:

857

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

Q

+ ∑3 [ L log3 [ L \

L Q

+ ′ ∑3 \ L log3 \ L L admitiendo que las n primeras variables tienen probabilidades iguales, y la variable n+1 tiene una

probabilidad de 0, entonces ambas entropias son iguales.

Q + ′ ∑3 \ L log 3 \ L >+ 3 \ Q log 3 \ Q @ +

L ya que P (yn+1 ) . log 2 P (yn+1 ) = 0 . log 2 0 = 0 como se demostró anteriormente.

4ª PROPIEDAD: Manteniendo la equiprobabilidad de los resultados la entropia aumenta con el número

de datos.

Demostración: Partamos de dos variables ξ y _ que se concretan en los sucesos

( x1, x2, ... xn ) y ( y1, y2, ..., yn, yn+1 ). Denotemos por H y H´sus respectivas entropias, y supongamos que

los sucesos son equiprobables para ambas variables.

Se verifica entonces que:

+>3[

como los sucesos son equiprobables entonces se verifica que P (x1 ) = P (x2 ) = ... P (xn ) = 1/n y P( y1

) = P (y2 ) = ... = P( yn ) = P( yn+1 ) = 1/(n+1). Por tanto las entropias de las variables ξ y _ son

respectivamente:

Q

Q

+ ∑3 [ L log 3 [ L ∑ log log Q

Q

L L Q

Q Q

+ ′ ∑3 \ L log 3 \ L ∑

log log Q Q L L Q como siempre se verifica que log 2 n < log 2 (n+1), H (ξ) < H´ (_) c.q.d.

5ª PROPIEDAD: La entropia de una variable que toma n valores es máxima cuando todos los resultados

son equiprobables.

Demostración: Partimos de dos variables que presentan distinta probabilidad y que denotamos por ξ y _

de forma que la probabilidad de los n sucesos en que se concreta la primera variable xi no son

equiprobables y la probabilidad de los n sucesos en que se concreta la segunda variable yi son

equiprobables. Deberemos demostrar que en esas condiciones se verifica la inecuación siguiente:

H [ P (x1 ), P (x2 ), ... P (xn )] ≤ H´ [1/n, 1/n, ...,1/n]

para demostrarlo aplicaremos el Lema de Gibbs modificado. La suma de las probabilidades de ambas

variables deben ser iguales y en esas circunstancias se verifica que:

Q

Q

∑ [ ∑ \ L

L L Q

L

Q

∑ [ log [ ≤∑ [ log \

L

L L

L

L L

La inecuación, se convierte en igualdad, cuando xi = yi , ∀ i.

858

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

Para cualquier número positivo p, se verifica que log 2 p ≤ p -1. Esta inecuación se convierte en igualdad

para los valores en los que p = { 1 o 2 }, entonces log 1 = 0 siendo x-1 = 0, y log 2 = 1 siendo x-1 = 1.

Suponiendo que xi > 0 efectuando el cambio de variable p = yi / xi se verifica que:

\ \

log L ≤ L [L [L

si multiplicamos ambos miembros por xi el sentido de la desigualdad se mantiene, verificándose que:

\L

\L

[ Llog ≤ [ L > @ \ L [ L

[L

[L

\

SRUWDQWR [ Llog L ≤ \ L [ L BL

[L

sumando cada uno de los i-esimos términos en los dos miembros de la igualdad, se verificará que:

Q

∑ [ > log \ log [ @≤

L

L L

Q

L

Q

∑ [ Llog \ L ∑ [ Llog[ L≤

L L Q

Q

∑ [ log [ ≤∑ [ log \ L

L L

Q

L

L \L

Q

[L

L L

Q

Q

∑ [ log ≤∑ > \ [ @ ∑ \ ∑ [ L

L L

L

L L

L

L desarrollando el producto de xi por el logaritmo del cociente

Efectuando el cambio de variable y de notación adecuadas sustituyendo xi = P(xi ) e yi = P ( yi ), se

verifica que:

Q

Q

L L ∑ 3 [ L log 3 [ L ≤∑ 3 [ L log 3 \ L dado que H (ξ ) = H [ P (x1 ), P (x2 ), ... P (xn )] y H´(_) = H´ [1/n, 1/n, ...,1/n] se verificará que: H (ξ ) ≤

H´(_) c.q.d.

6ª PROPIEDAD: La entropia es una función simétrica de sus n argumentos, es decir:

H [ P(x1 ), ..., P(xi ), ..., P(xj ),....P(xn )] = H´ [ P(x1 ), ..., P(xj ),....P(xi ), ..., P(xn )]

Demostración:Sea H [ P(x1 ), ..., P(xi ), ..., P(xj ),....P(xn )] la entropia de los n términos formados por P(xi

) . log 2 P(xi ) .De igual manera H´ [ P(x1 ), ..., P(xj),....P(xi), ..., P(xn)] es la entropia de los n términos

formados por P(xi ) . log 2 P(xi ) ordenados de diferente manera. Por verificar la suma de números la

propiedad conmutativa ambas entropias serán iguales y por tanto H = H´, siendo independiente del orden

en el que participen los términos y dependiendo de los valores (argumentos) de las P( xi ).

De ésta propiedad se deriva que como la entropia no depende del orden en el que están situados los n

argumentos es posible determinarla sin tener que ordenar las observaciones, en contraposición con los

requerimientos de otros tipos de medida de la concentración en los que se precisa dicha ordenación (

indice de Gini).

859

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

La entropia puede ser expresada en distintos tipos de unidades, dependiendo de la base de logaritmos

elegida. Así la entropia puede expresarse en tres tipos de unidades:

1º BIT ( Binari digit)

2º DIT ( Decimal digit)

3º NAT ( Natural digit)

La entropia viene expresada en BIT cuando la base de logaritmos utilizados sea la binaria. Puede definirse

como la entropia correspondiente a una variable con dos resultados equiprobables. Si los sucesos x1 y x2

tienen probabilidades iguales

Q

+ ∑ 3 [ L log 3 [ L > log log @ log %,7

L log %,7

\DTXH log log P ( x1 ) = P ( x2 ) = 1/2

entonces:

Si los logaritmos considerados son en base 10, la unidad de entropia se expresa en DIT que se puede

definir como la entropia de una variable con diez resultados equiprobables:

∑ log L > log log log @

log log ',7

+

A ésta unidad se le denomina unidad de Hartley. Theil argumento en favor de la entropia como medida

de la desigualdad o de la equidistribución de las magnitudes económicas por dos razones:

1º Porque la H (x) varia en función de las N variables, reflejando la distinta concentración relativa ya que

recoge el efecto que reporta el número de elementos.

2º Porque permite análisis desagregados pudiendo medir la concentración de los grupos que la forman (

concentración intragrupo ) y la concentración interna de un grupo (concentración intergrupos ).

El coeficiente T de Theil es la redundancia, la denotamos por T, es una medida derivada de la entropia, y

la definimos como la diferencia entre la máxima entropia y la entropia de la distribución:

T = log N - H (x)

Como la entropia varia entre 0, valor mínimo y log N, valor máximo, la redundancia se interpreta en

términos opuestos a los de la entropia. No obstante ésta medida no permite el establecimiento de

comparaciones entre distribuciones por lo que se hace preciso definir una variable relativa que permita

dichas comparaciones. Esta variable relativa recibe el nombre de redundancia relativa, la denotamos por

Tr y se define como:

7 U +[

log 1 +[

7

log1

log 1

log1

860

,&RQJUHVRGH&LHQFLD5HJLRQDOGH$QGDOXFtD$QGDOXFtDHQHOXPEUDOGHOVLJOR;;,

COMUNICACIÓN

que es un valor comprendido entre 0 y 1, es decir:

0 ≤ Tr ≤ 1

4.- Conclusiones.

Las características definidas en las líneas anteriores de la función de entropia permiten una aplicación

casi generalizazada a multiplicidad de problemas económicos de carácter general o particular. Allí donde

aparece una magnitud económica es posible, e incluso interesante el estudio de la igualdad o desigualdad

en el reparto de dicha magnitud. Además es posible estudiar la evolución de una o varias magnitudes

económicas a lo largo del tiempo dentro del grupo en el que la variable se desenvuelve, o en relación con

otros grupos semejantes con los que interese establecer comparaciones. También es posible estudiar la

ganancia o perdida de igualdad en el desarrollo de las variables objeto de estudio. Próximos trabajos

empíricos nos permitirán poner de manifiesto dichos aspectos.

5.- Bibliografía.

1.ACKOFF, R.L.: " Redisigning the Future" . Jhon Wiley and Sons.

2.Theil, E. "Economics and information theory". Noth-Holland Publishing Company. Amsterdam Rand

McNally & Company. Chicago

3.Gil Alvarez, P. :"Teoría Matemática de la información (con aplicaciones a la Estadística)".Ediciones

ICE.

861