La más famosa de las campanas,Dame una barra y estandarizaré el

Anuncio

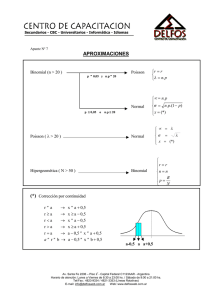

La más famosa de las campanas Dice el diccionario que una campana es un dispositivo simple que emite un sonido. Pero una campana puede ser muchas cosas más. Creo que hay hasta una planta con ese nombre y una flor con su diminutivo. Y no nos olvidemos de las campanas extractoras de las cocinas. Pero, sin duda, la más famosa de todas las campanas es la célebre campana de Gauss, la más querida y venerada por estadísticos y científicos de distinto pelaje. Pero, ¿qué es la campana de Gauss?. Pues no es nada más, ni nada menos, que una función de densidad de probabilidad. Dicho de otra forma, es una distribución continua de probabilidad que tiene forma de campana simétrica, de ahí la primera parte de su nombre. Y digo la primera parte porque la segunda es algo más polémica, ya que no está tan claro que Gauss sea el padre de la criatura. Parece que el primero en utilizar esta función de densidad fue un tal Moivre, que estaba estudiando qué pasaba con una distribución binomial cuando el tamaño de la muestra se iba haciendo grande. Sin embargo, otra de las muchas injusticias de la historia, el nombre de la función se asocia con Gauss, que la utilizó unos 50 años después para registrar los datos de sus estudios astronómicos. Claro que, para defensa de Gauss, hay quien dice que los dos descubrieron la función de densidad de manera independiente. Nosotros, para no polemizar, a partir de ahora vamos a denominarla por su otro nombre, diferente al de campana de Gauss: distribución normal. Y parece que la bautizaron así porque al principio pensaron que la mayor parte de los fenómenos naturales se ajustaban a esta distribución. Más tarde se vio que hay otras distribuciones que son muy frecuentes en biología, como la de Poisson o la binomial. Como ocurre con cualquier función de densidad, la utilidad de la curva normal radica en que representa la distribución de probabilidades de aparición de la variable aleatoria que estemos midiendo. Por ejemplo, si medimos los pesos de una población de individuos y los representamos gráficamente veremos que se distribuyen siguiendo una distribución normal. Así, el área bajo la curva entre dos puntos del eje x representa la probabilidad de aparición de esos valores. El área total bajo la curva es igual a uno, lo que quiere decir que hay un 100% de probabilidades (uno en tantos por uno) de que se encuentre cualquiera de los valores de la distribución. Existen infinitas distribuciones normales, todas ellas perfectamente caracterizadas por su media y su desviación estándar. Así, cualquier punto del eje horizontal puede expresarse como la media más o menos un número de veces la desviación estándar, pudiendo calcularse su probabilidad usando la fórmula de la función de densidad, que no me atrevo a enseñaros aquí. También podemos utilizar un ordenador para calcular la probabilidad de una variable dentro de una distribución normal, pero en la práctica se hace algo más sencillo: estandarizar. Se dice que la distribución normal estándar es aquella que tiene una media igual a cero y una desviación estándar igual a uno. La ventaja de contar con la distribución estándar es doble. Primero, conocemos su distribución de probabilidades para los distintos puntos del eje horizontal. Así, entre la media más menos una desviación se encuentra el 68% de la población, entre la media y más menos dos el 95% y entre más menos tres el 99%, aproximadamente. La segunda ventaja es que cualquier distribución normal puede convertirse en una estándar. Basta con restar la media al valor y dividirlo por la desviación estándar de la distribución. Calculamos así el score z, que es el equivalente del valor de nuestra variable en una distribución normal estándar de media cero y desviación estándar uno. Veis la utilidad del asunto. Ya no necesitamos programas informáticos para calcular la probabilidad. Nos basta con estandarizar y usar una simple tabla, si es que no conocemos el valor de memoria. Pero es que la cosa va incluso más allá. Gracias a la magia del teorema central del límite, otras distribuciones pueden aproximarse a una normal y puede utilizarse la técnica de estandarizar para calcular la distribución de probabilidades de los valores de las variables. Por ejemplo, aunque nuestra variable siga una distribución binomial podremos aproximarla a una normal cuando el tamaño muestral sea grande. En la práctica, cuando np y n(1-p) sean mayores de cinco. Lo mismo ocurre con la distribución de Poisson, que puede aproximarse a una normal cuando la media es mayor de 10. Y la magia es doble, porque además de poder prescindir de herramientas complejas y calcular con más facilidad probabilidades o intervalos de confianza, hay que tener en cuenta que tanto la distribución binomial como la de Poisson son funciones de masa discretas, mientras que la normal es una función de densidad continua. Y este es el final por hoy. Solo deciros que hay otras funciones de densidad continuas distintas a la normal y que también pueden aproximarse a una normal cuando las muestras son grandes. Pero esa es otra historia… Dame una barra y estandarizaré el mundo Pero no me vale una barra cualquiera. Tiene que ser una barra muy especial. O mejor, una serie de barras. Y no estoy pensando en un diagrama de barras, tan conocidos y utilizados que cuando abres el PowerPoint casi te hace uno sin que se lo pidas. No, estos diagramas son muy insulsos, solo representan cuántas veces se repite cada uno de los valores de una variable cualitativa, pero no nos dicen nada más. Yo estoy pensando en un diagrama mucho más profundo. Me refiero al histograma. ¡Vaya!, me diréis, pues no es otro diagrama de barras. Sí, pero de otra clase de barras, mucho más informativas. Para empezar, el histograma se utiliza (o debería) para representar frecuencias de variables cuantitativas continuas. El histograma no es un diagrama de barras, sino una distribución de frecuencias. ¿Y eso qué significa?. Pues que las barras, en el fondo, son algo artificial. Supongamos una variable cuantitativa continua como puede ser el peso. Imaginemos que el rango de nuestra distribución va de 38 a 118 kg de peso. En teoría, podemos tener infinitos valores de peso (como con cualquier variable continua), pero para representar la distribución dividimos el rango en un número de intervalos arbitrario y dibujamos una barra para cada intervalo cuya altura (y, por tanto, superficie) sea proporcional al número de casos del intervalo. Eso es un histograma: la distribución de frecuencias. Ahora supongamos que hacemos los intervalos cada vez más estrechos. El perfil que forman las barras se irá pareciendo cada vez más a una curva según se estrechen los intervalos. Al final, lo que tendremos será una curva que se llama curva de densidad de probabilidad. La probabilidad de un determinado valor será cero (uno pensaría que debería ser la altura de la curva en ese punto, pero resulta que no, que es cero), pero la probabilidad de los valores de un determinado intervalo será igual a la superficie del área bajo la curva en ese intervalo. Y, ¿cuál será el área bajo toda la curva?. Pues fácil: la probabilidad de encontrar cualquier valor, o sea, uno (100% para los amigos del porciento). Veis, pues, que el histograma es mucho más de lo que parece. Nos dice que la probabilidad de encontrar un valor inferior a la media es 0,5, pero no solo eso, sino que podemos calcular la densidad de probabilidad de cualquier valor utilizando una formulita que prefiero no poner porque cerraríais el navegador y dejaríais de leer esta entrada. Además, hay una forma de solucionarlo algo más simple. Con las variables que siguen una distribución normal (la famosa campana) la solución es sencilla. Sabemos que una distribución normal se define perfectamente por su media y su desviación estándar. El problema es que cada distribución tiene las suyas, con lo que la densidad de probabilidad también es específica de cada distribución. ¿Qué hacemos?. Pues nos inventamos una distribución normal estándar de media cero y desviación típica 1 y nos estudiamos su densidad de probabilidad de tal forma que no necesitemos fórmulas ni tablas para conocer la probabilidad de un segmento determinado. Una vez hecho esto, tomamos cualquier valor de nuestra distribución y los transformamos en su alma gemela de la distribución estándar. A este proceso se le denomina estandarización y es tan sencillo como restar al valor la media y dividirlo por la desviación típica. Así obtenemos otro de los estadísticos que los médicos en general, y los pediatras en particular, veneramos más profundamente: el z score. Las probabilidades de la distribución estándar son bien conocidas. Un z de cero está en la media. El intervalo de z = 0 ± 1,64 engloba el 90% de la distribución, el z = 0 ± 1,96 el 95%, y el z = 0 ± 2,58 el 99%. Lo que se hace, en la práctica, es determinar el z deseable para la variable que medimos, una vez estandarizada. Este valor suele ser ±1 ó ± 2, según lo que midamos. Además, podemos comparar cómo se modifica el z en determinaciones sucesivas. El problema surge porque en medicina hay muchas variables cuya distribución se encuentra sesgada y no se ajusta a una distribución normal, como es el caso de la talla, el colesterol sanguíneo y muchas otras. Pero no desesperéis, para eso los matemáticos se han inventado una cosa que llaman el teorema central del límite, que viene a decir que si el tamaño de la muestra es lo suficientemente grande podemos estandarizar cualquier distribución y enlazarla con la distribución normal estándar. Este teorema es una cosa estupenda, ya que permite estandarizar incluso para variables no continuas que siguen otro tipo de distribuciones como la binomial, la de Poisson u otras. Pero la cosa no queda aquí. La estandarización es la base para calcular otras características de la distribución, como su índice de asimetría o su curtosis, y está además en la base de muchas pruebas de contraste de hipótesis que buscan estadísticos de distribución conocida para calcular la significación, pero esa es otra historia…