La más famosa de las campanas,El cocinero y su pastel

Anuncio

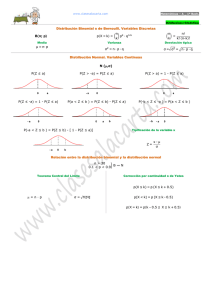

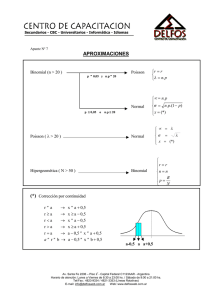

La más famosa de las campanas Dice el diccionario que una campana es un dispositivo simple que emite un sonido. Pero una campana puede ser muchas cosas más. Creo que hay hasta una planta con ese nombre y una flor con su diminutivo. Y no nos olvidemos de las campanas extractoras de las cocinas. Pero, sin duda, la más famosa de todas las campanas es la célebre campana de Gauss, la más querida y venerada por estadísticos y científicos de distinto pelaje. Pero, ¿qué es la campana de Gauss?. Pues no es nada más, ni nada menos, que una función de densidad de probabilidad. Dicho de otra forma, es una distribución continua de probabilidad que tiene forma de campana simétrica, de ahí la primera parte de su nombre. Y digo la primera parte porque la segunda es algo más polémica, ya que no está tan claro que Gauss sea el padre de la criatura. Parece que el primero en utilizar esta función de densidad fue un tal Moivre, que estaba estudiando qué pasaba con una distribución binomial cuando el tamaño de la muestra se iba haciendo grande. Sin embargo, otra de las muchas injusticias de la historia, el nombre de la función se asocia con Gauss, que la utilizó unos 50 años después para registrar los datos de sus estudios astronómicos. Claro que, para defensa de Gauss, hay quien dice que los dos descubrieron la función de densidad de manera independiente. Nosotros, para no polemizar, a partir de ahora vamos a denominarla por su otro nombre, diferente al de campana de Gauss: distribución normal. Y parece que la bautizaron así porque al principio pensaron que la mayor parte de los fenómenos naturales se ajustaban a esta distribución. Más tarde se vio que hay otras distribuciones que son muy frecuentes en biología, como la de Poisson o la binomial. Como ocurre con cualquier función de densidad, la utilidad de la curva normal radica en que representa la distribución de probabilidades de aparición de la variable aleatoria que estemos midiendo. Por ejemplo, si medimos los pesos de una población de individuos y los representamos gráficamente veremos que se distribuyen siguiendo una distribución normal. Así, el área bajo la curva entre dos puntos del eje x representa la probabilidad de aparición de esos valores. El área total bajo la curva es igual a uno, lo que quiere decir que hay un 100% de probabilidades (uno en tantos por uno) de que se encuentre cualquiera de los valores de la distribución. Existen infinitas distribuciones normales, todas ellas perfectamente caracterizadas por su media y su desviación estándar. Así, cualquier punto del eje horizontal puede expresarse como la media más o menos un número de veces la desviación estándar, pudiendo calcularse su probabilidad usando la fórmula de la función de densidad, que no me atrevo a enseñaros aquí. También podemos utilizar un ordenador para calcular la probabilidad de una variable dentro de una distribución normal, pero en la práctica se hace algo más sencillo: estandarizar. Se dice que la distribución normal estándar es aquella que tiene una media igual a cero y una desviación estándar igual a uno. La ventaja de contar con la distribución estándar es doble. Primero, conocemos su distribución de probabilidades para los distintos puntos del eje horizontal. Así, entre la media más menos una desviación se encuentra el 68% de la población, entre la media y más menos dos el 95% y entre más menos tres el 99%, aproximadamente. La segunda ventaja es que cualquier distribución normal puede convertirse en una estándar. Basta con restar la media al valor y dividirlo por la desviación estándar de la distribución. Calculamos así el score z, que es el equivalente del valor de nuestra variable en una distribución normal estándar de media cero y desviación estándar uno. Veis la utilidad del asunto. Ya no necesitamos programas informáticos para calcular la probabilidad. Nos basta con estandarizar y usar una simple tabla, si es que no conocemos el valor de memoria. Pero es que la cosa va incluso más allá. Gracias a la magia del teorema central del límite, otras distribuciones pueden aproximarse a una normal y puede utilizarse la técnica de estandarizar para calcular la distribución de probabilidades de los valores de las variables. Por ejemplo, aunque nuestra variable siga una distribución binomial podremos aproximarla a una normal cuando el tamaño muestral sea grande. En la práctica, cuando np y n(1-p) sean mayores de cinco. Lo mismo ocurre con la distribución de Poisson, que puede aproximarse a una normal cuando la media es mayor de 10. Y la magia es doble, porque además de poder prescindir de herramientas complejas y calcular con más facilidad probabilidades o intervalos de confianza, hay que tener en cuenta que tanto la distribución binomial como la de Poisson son funciones de masa discretas, mientras que la normal es una función de densidad continua. Y este es el final por hoy. Solo deciros que hay otras funciones de densidad continuas distintas a la normal y que también pueden aproximarse a una normal cuando las muestras son grandes. Pero esa es otra historia… El cocinero y su pastel Saber cocinar es una ventaja. ¡Qué bien queda uno cuando tiene invitados y sabe cocinar como es debido!. Te pasas dos o tres horas comprando los ingredientes, te dejas un dineral y te tiras otras dos o tres horas en la cocina… y, al final, resulta que el plato estupendo que estabas preparando te queda hecho una ruina. Y esto le pasa hasta a los mejores cocineros. Nunca podemos estar seguros de que el plato nos vaya a quedar bien, aunque lo hayamos preparado antes muchas veces. Así que entenderéis el problema que tiene mi primo. Resulta que va a dar una fiesta y a él le ha tocado hacer el postre. Sabe hacer un pastel bastante rico, pero solo le sale realmente bueno la mitad de las veces que lo intenta. Así que está muy preocupado por hacer el ridículo en la fiesta, como es bien comprensible. Claro que mi primo es muy listo y ha pensado que si hace más de un pastel, alguno le tiene que quedar bueno. Pero, ¿cuántos tiene que hacer para tener, por lo menos, uno bueno?. El problema de esta pregunta es que no tiene una respuesta exacta. Cuantos más pasteles haga, más probable que alguno salga bueno. Pero claro, puede hacer doscientos y tener la mala suerte de que todos sean malos. Pero no desesperéis: aunque no podemos dar una cifra con seguridad absoluta, si podemos medir la probabilidad de quedar bien con un número determinado de pasteles. Veámoslo. Vamos a imaginar la distribución de probabilidad, que no es más que el conjunto de situaciones que incluyen todas las situaciones que pueden ocurrir. Por ejemplo, si mi primo hace un pastel, éste puede salir bueno (B) o malo (M), ambos con una probabilidad de 0,5. Podéis verlo representado en el gráfico A. Tendrá un 50% de probabilidades de éxito. Si hace dos pasteles puede ocurrir que le salgan bien uno, dos o ninguno. Las combinaciones posibles serán: BB, BM, MB, MM. La probabilidad de tener uno bueno es de 0,5 y la de tener dos 0,25, con lo que la probabilidad de tener al menos uno bueno es de 0,75 o 75% (3/4). Lo representamos en el gráfico B Vemos que las opciones mejoran, pero todavía queda mucho margen para el fracaso. Si hace tres pasteles las opciones son las siguientes: BBB, BBM, BMB, BMM, MBB, MBM, MMB y MMM. Esto mejora, ya tenemos un 87,5% (1/8) de que al menos un pastel salga bien. Lo representamos en el gráfico C. ¿Y si hace cuatro, o cinco, o…?. El asunto se convierte en un auténtico coñazo. Cada vez es más difícil imaginar las combinaciones posibles. ¿Y qué hacemos?. Pues pensar un poco. Si nos fijamos en los gráficos, las barras representan los elementos discretos de probabilidad de cada uno de los eventos posibles. Según aumenta el número de posibilidades y aumenta el número de barras verticales, la distribución de las barras comienza a adoptar una forma acampanada, ajustándose a una distribución de probabilidad conocida, la distribución binomial. Las personas que entienden de estas cosas, llaman experimentos de Bernouilli a aquellos que tienen solo dos soluciones posibles (son dicotómicos), como tirar una moneda (cara o cruz) o nuestro pastel (bueno o malo). Pues bien, la distribución binomial mide el número de éxitos (k) de una serie de experimentos de Bernouilli (n) con una determinada probabilidad de ocurrencia de éxito de cada suceso (p). En nuestro caso la probabilidad es p=0,5 y podemos calcular la probabilidad de tener éxito repitiendo el experimento (cocinando pasteles) según la siguiente fórmula: Si sustituimos p por 0,5 (la probabilidad de que el pastel salga bueno), podemos ir jugando con los valores de n para obtener, al menos, un pastel bueno (k≥1). Si hacemos cuatro pasteles, la probabilidad de tener al menos uno bueno es de 93,75% y si hacemos cinco esta probabilidad sube a 96,87%, un valor de probabilidad razonable para lo que estamos buscando. Yo creo que haciendo cinco pasteles es muy difícil que a mi primo se le arruine su fiesta. También podríamos despejar el valor de la probabilidad y calcularlo al revés: dado un valor de P(k de n) obtener el número de intentos necesarios. Otra cosa que se puede hacer es calcular todas estas cosas sin utilizar la fórmula, sino usar cualquiera de las calculadoras de probabilidad disponibles en Internet. Y aquí se acaba esta entrada tan golosa. Existen, como podéis imaginar, más tipos de distribuciones de probabilidad, tanto discretas como esta distribución binomial como continúas como la distribución normal, la más famosa de todas. Pero esa es otra historia…