5.5 Repaso de estimadores MCO 5.6 Errores estándares robustos

Anuncio

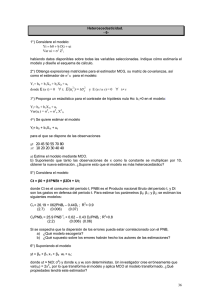

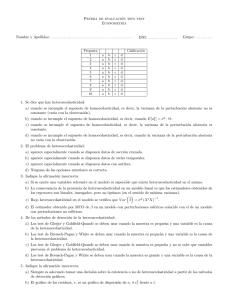

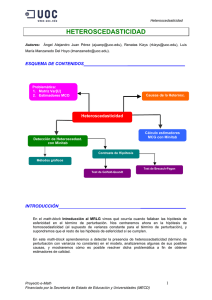

5.5. REPASO DE ESTIMADORES MCO 5.5 105 Repaso de estimadores MCO Tenemos un modelo y = β0 + β1 x1 + . . . + βk xk + ǫ Los cuatro primeros supuestos de Gauss–Markov son: S.1 Linealidad en los parámetros, la variable dependiente es una función lineal de los βj . S.2 Muestreo aleatorio. S.3 E(ǫ|x1 , . . . , xk ) = 0. S.4 Variación muestral de las variables independientes (estas no son constantes). Theorem 5.5.1 Insesgadez de los estimadores MCO Si los supuestos S.1 – S.4 se satisfacen entonces el estimador MCO β̂j de βj es insesgado. El quinto supuesto de Gauss–Markov es la homocedasticidad: S.5 V ar(ǫ|x1 , . . . , xk ) = σ 2 . Theorem 5.5.2 Gauss–Markov Si los supuestos S.1 – S.5 se satisfacen entonces el estimador MCO β̂j es el estimador lineal insesgado óptimo (ELIO) de βj . Pn Las iniciales del acrónimo ELIO: a) Estimador; b) Lineal: β̂ = i=1 wij yi donde wij puede ser una función de los valores muestrales de todas las variables independientes; c) Insesgado: E(β̂j ) = β; d) Óptimo: de varianza mı́nima. El supuesto que presentamos en los primeros dı́as de clase de independencia de los errores es demasiado fuerte y no es necesario para la estimación MCO para datos de corte transversal (no ası́ en el caso de series temporales o datos de panel). 5.6 Errores estándares robustos Como hemos visto en presencia de heteroscedasticidad, los estimadores MCO son consistentes e insesgados. Sin embargo, los estimadores de la varianza y los errores 106CHAPTER 5. PROBLEMAS EN LA ESPECIFICACIÓN DEL MODELO Y LOS DATOS estándar no lo son. Estos errores estándar se pueden ajustar para poder usar los contrastes t, F y LM en presencia de heteroscedasticidad. Consideremos el modelo con una sola variable independiente. yi = β0 + β1 xi + ǫ. Suponemos en todo momento que se cumplen los cuatro primeros supuestos de Gauss–Markov. Si los errores contienen heteroscedasticidad, entonces V ar(ǫi |xi ) = σi2 . Escribamos el estimador MCO como: β̂1 = β1 + Pn i=1 (xi − x̄)ǫi SCTx y sabemos que (5.10) donde SCTx = de V ar(β̂1 )?) V ar(β̂1 ) = Pn 2 i=1 (xi − x̄) Pn − x̄)2 σi2 SCTx2 i=1 (xi (si hay homocedasticidad, ¿cuál es la fórmula habitual Dado que ee(β̂1 ) se basa en la estimación de V ar(β̂1 ), necesitamos estimar (5.10) cuando hay heteroscedasticidad. White mostró como hacerlo usando los residuos porque un estimador válido de V ar(β̂1 ) (para cualquier caso de heteroscedasticidad, incluso para homocedasticidad) es: Pn − x̄)2 ǫ̂2i SCTx2 i=1 (xi que se puede obtener muy fácilmente después de hacer la regresión MCO. En el caso del modelo de regresión múltiple y = β0 + β1 x1 + . . . + βk xk + ǫ, el estimador válido de V ar(β̂j ) bajo los supuestos S.1–S.4 es: V\ ar(β̂j ) = Pn 2 2 i=1 r̂ij ǫ̂i SCTj2 donde r̂ij denota el i-ésimo residuo de regresar xj sobre todas las demás variables independientes. Es decir el residuo de hacer la regression múltiple: xj = δ0 + Pn \ h6=j δh xh + ξ. La raı́z cuadrada de V ar(β̂j ) se llama error estándar robusto a la heteroscedasticidad para β̂j . 5.6. ERRORES ESTÁNDARES ROBUSTOS 107 Una vez obtenidos los errores estándar robustos a la heteroscedasticidad, es simple construir un estadı́stico t robusto a la heteroscedasticidad: t= β̂j − βj ∼ tk−1 . error estándar robusto Para contrastar restricciones de exclusión múltiples de una manera robusta se puede obtener el estadı́stico F robusto a la heteroscedasticidad o estadı́stico de Wald robusto a la heteroscedasticidad. No es parte de este curso. Si recordamos, el estadı́stico LM habitual se hallaba usando los residuos del modelo restringido bajo la hipótesis nula, ǫ̃, que se regresaban sobre el resto de las variables independendientes para hallar el Rǫ̃2 . Ası́ LM = nRǫ̃2 . El estadı́stico LM robusto a la heteroscedasticidad: Pasos 1. Obtener los residuos ǫ̃ del modelo restrigido (bajo la hipótesis nula). 2. Regresar cada una de las variables independientes excluidas bajo la hipótesis nula sobre las variable independiente incluidas, si hay q variable excluidas, esto lleva a q residuos (r̃1 , r̃2 , . . . , r̃q ) 3. Calcular todos los productos cruzados de ǫ̃r̃j , es decir crear las variables z1 = r̃1 ǫ̃, z2 = r̃2 ǫ̃, . . . , zq = r̃1 ǫ̃. 4. Realizar la regresión 1 = δ1 z1 + δ2 z2 + . . . δq zq + error (que pasa por el origen) donde 1 es el vector con todos unos. El estadı́stico LM robusto viene dado por n − SCE1 , donde SCE1 es simplemente la suma de cuadrados de los residuos de esta regresión final. Bajo H0 , LM se distribuye aproximadamente como una χ2q . Practica 5 de clase.