Ampliación de Matemáticas

Grado en Ingeniería Informática

Grado en Estadística.

Doble grado en Informática y Estadística.

Índice

1 Series

1.1 Series de números reales. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.1 Algunas propiedades de las series. . . . . . . . . . . . . . . . . . . . . . . .

1.1.2 Series de términos positivos. . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.3 Series alternadas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.1.4 Convergencia condicional y absoluta. . . . . . . . . . . . . . . . . . . . . .

1.2 Series de potencias. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2.1 Representación de funciones en series de potencias. . . . . . . . . . . . . .

1.3 Series de Fourier . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.3.1 Desarrollos de Fourier con sólo cosenos o sólo senos. . . . . . . . . . . . .

1.3.2 Series de Fourier en un intervalo general [a,b]. . . . . . . . . . . . . . . . .

1

1

3

4

6

7

8

10

14

16

18

2 Interpolación Polinómica

2.1 Polinomio interpolador de Lagrange . . . . . . . . . . . . . . . . . . . . . . . . .

2.2 Forma de Newton del polinomio interpolador de Lagrange. . . . . . . . . . . . . .

2.3 Interpolación de Hermite. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.4 Interpolación polinómica segmentaria. . . . . . . . . . . . . . . . . . . . . . . . .

2.5 Splines. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

19

19

22

24

26

27

3 Producto interior. Ajuste

3.1 Producto interior. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.2 Normas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3 Ángulo y Ortogonalidad. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.4 Proyección y componente ortogonal. . . . . . . . . . . . . . . . . . . . . . . . . .

3.5 Expresión de la proyección en una base arbitraria. . . . . . . . . . . . . . . . . .

3.6 Ecuaciones normales en IRn . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.7 Aplicaciones de la proyección. Ajuste Discreto. . . . . . . . . . . . . . . . . . . .

3.7.1 Recta de ajuste. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.7.2 Caso general discreto. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

29

29

30

31

35

37

39

40

40

41

4 Resolución Numérica de Sistemas

4.1 Errores de redondeo. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.1.1 Situaciones que merecen atención. . . . . . . . . . . . . . . . . . . . . . .

4.2 Aspectos computacionales de la eliminación gaussiana. . . . . . . . . . . . . . . .

4.2.1 Necesidad computacional de pivotaje. . . . . . . . . . . . . . . . . . . . .

4.2.2 Número de operaciones de la eliminación gaussiana. . . . . . . . . . . . .

4.2.3 Implementación práctica. . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Normas matriciales. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

44

44

45

45

46

50

50

i

ii

4.4

4.5

Análisis del problema del acondicionamiento. . . . . . . . . . . . . . . . . . . . .

Métodos iterativos para la resolución de sistemas lineales. . . . . . . . . . . . . .

4.5.1 Métodos de Jacobi y Gauss-Seidel . . . . . . . . . . . . . . . . . . . . . .

52

53

56

5 Cálculo diferencial en varias variables

5.1 Funciones. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.1.1 Representación gráfica. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2 Límites . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3 Continuidad. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.4 Diferenciabilidad. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5 Extremos. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5.1 Formas Cuadráticas. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5.2 Polinomio de Taylor. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5.3 Extremos relativos condicionados. . . . . . . . . . . . . . . . . . . . . . . .

57

57

58

59

64

65

72

74

76

78

6 Programación Lineal

6.1 Un primer ejemplo. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Definiciones y Terminología. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.3 Solución gráfica de problemas en IR2 . . . . . . . . . . . . . . . . . . . . . . . . .

83

83

85

86

Tema 1

Series

1.1

Series de números reales.

Definición 1.1 Llamaremos serie de números reales a una sucesión {sn }∞

n=1 definida a partir

de otra sucesión de números reales, {an }∞

,

de

la

forma

n=1

sn =

n

X

ai = a1 + · · · + an

(1.1)

i=1

Los términos de la sucesión {sn }∞

n=1 de la definición anterior reciben el nombre de sumas parciales

y an recibe el nombre de término general de la serie.

¿Qué utilidad o interés tiene una sucesión como la de la definición anterior? La respuesta

está en el significado de su límite. Puesto que sn es la suma de n números reales (a1 , a2 , . . . , an ),

sn+1 es la suma de los anteriores y an+1 y así sucesivamente, el

s = lim sn

n→∞

(1.2)

en caso de que exista, será la definición matemática de una suma con infinitos sumandos.

Si el límite s en (1.2) existe y es finito diremos que la serie es convergente, si es infinito, divergente y si no existe diremos que la serie es oscilante. A la condición convergente, divergente

u oscilante de una serie se le llama carácter de la misma.

El límite s en (1.2) recibe el nombre de suma de la serie y se denota

∞

X

ai

(1.3)

i=1

Esta notación puede resultar confusa porque

P(1.3) se emplea tanto para denotar la propia serie

como su límite, así, una afirmación del tipo ∞

i=1 ai es convergente, divergente u oscilante lo que

significa es que la sucesión {sn }∞

lo

es.

n=1

Otra manera de representar la idea de sumar infinitas cantidades ai es escribir

a1 + a2 + · · · + an + · · ·

donde los últimos puntos suspensivos son los "más importantes" porque son los que conllevan

precisamente la idea de continuar sumando (hasta infinito). Nótese que a1 + a2 + · · · + an no es

una suma de infinitos términos; es sólo una suma de n términos.

2 Series

Ampliación de Matemáticas.

Ejercicio 1.1 Completa lo que consideres necesario en la tabla siguiente (puede haber resultados

que todavía no sean conocidos):

an

1

1

5

a1 + a2 + · · · + an + · · ·

1 + 1 + ··· + 1 + ···

1

1

1

5 + 5 + ··· + 5 + ···

∞

X

ai

i=1

∞

X

1

5

i=1

−3

n

−3 − 3 − · · · − 3 − · · ·

1 + 2 + ··· + n + ···

sn =

1

i=1

∞

X

∞

X

sn =

sn =

2n

1

n

2 + 2 2 + · · · + 2n + · · ·

sn =

i

1 + 21 + · · · + n1 + · · ·

i=1

i=1

n

X

i=

i=1

2i

i=1

∞

X

i=1

n

X

i=1

i=1

∞

X

ai

s = lim sn

1=n

s = lim n = +∞

n

1

=

5

5

s = lim

n→∞

i=1

n

X

n

X

sn =

(−3) = −3n

−3

i=1

∞

X

n

X

sn =

n

X

i=1

1

i

sn =

(n + 1)n

2

n→∞

n

= +∞

n→∞ 5

s = lim −3n = −∞

n→∞

s = lim

n→∞

n(n + 1)

= +∞

2

2i = 2n+1 − 2 s = lim (2n+1 − 2) = +∞

n→∞

n

X

1

i=1

i

=?

s = lim sn = +∞

n→∞

(−1)n

(−1)n + 1

Ejemplo 1.1 Consideremos la serie

∞

X

q i , llamada serie geométrica. Para estudiar su carác-

i=0

ter debemos hallar el límite de la sucesión {sn }∞

n=1 .

sn =

n−1

X

(

i

q =

i=0

q n −1

q−1

n

si

si

q 6= 1

q=1

(1.4)

(Obsérvese que sn es, para esta serie, la suma de los n primeros términos de una progresión

geométrica de razón q).

qn − 1

lim

=

n→∞ q − 1

(1 − q)−1

∞

si

si

|q| < 1

q>1

(1.5)

El límite anterior no existe si q ≤ −1. Concluimos entonces que este tipo de series son convergentes cuando |q| < 1, divergentes si q ≥ 1 y oscilantes para q ≤ −1.

Ampliación de Matemáticas.

1.1.1

Series 3

Algunas propiedades de las series.

1. El carácter de una serie

∞

X

ai se mantiene si se suprimen o modifican los k primeros

i=1

términos de la sucesión {an }∞

n=1 .

2. Las series

∞

X

ai y

i=1

∞

X

cai , siendo c cualquier número real no nulo, tienen el mismo

i=1

carácter. Si son convergentes se verifica la relación

∞

X

cai = c

i=1

3. Si

∞

X

ai y

i=1

∞

X

∞

X

ai

(1.6)

i=1

bi son convergentes, también lo es

i=1

∞

X

(ai + bi ) y se verifica

i=1

∞

∞

∞

X

X

X

(ai + bi ) =

ai +

bi

i=1

i=1

(1.7)

i=1

Estas tres propiedades pueden demostrarse sin más que tener en cuenta lo que significa el carácter

de una serie y aplicar algunas propiedades de los límites.

Ejercicio 1.2 Extender la tercera de las propiedades anteriores, si es posible, al caso en que

∞

∞

X

X

ai ,

bi o ambas sean divergentes u oscilantes.

i=1

i=1

Si una serie resulta convergente parece razonable que las cantidades que se van añadiendo

(los ai ) tiendan a cero. Así ocurre, en efecto, como puede verse en el siguiente teorema.

Teorema 1.1 Si

∞

X

ai es convergente entonces

i=1

lim an = 0.

n→∞

(1.8)

Demostración. Sea s la suma de la serie. Se verifica entonces

limn→∞ sn = s

así como

limn→∞ sn−1 = s,

por tanto

limn→∞ an = limn→∞ (sn − sn−1 ) = s − s = 0.

La condición dada en el teorema anterior es necesaria pero no suficiente para la convergencia.

Por ejemplo la serie

1 1 1 1 1 1 1 1 1

1 + + + + + + + + + + ···

2 2 3 3 3 4 4 4 4

es divergente con an →P

0.

Para que una serie ∞

i=1 ai sea convergente no basta, según se ha dicho, con que la sucesión

∞

{a

Pn∞}n=1 tienda a cero sino que además habrá de hacerlo "suficientemente rápido".

P∞ La 2serie

(1/n),

denominada

serie

armónica,

es

divergente

mientras

que

la

serie

n=1

n=1 (1/n ) es

convergente. La demostración de su carácter se verá en la siguiente sección. Ambas cumplen

que el límite de la sucesión {an }∞

n=1 es cero.

4 Series

1.1.2

Ampliación de Matemáticas.

Series de términos positivos.

En este apartado veremos algunos resultados útiles para determinar el carácter de series de

términos positivos.

Ejercicio 1.3 ¿Puede una serie de términos positivos ser oscilante?

Teorema 1.2 (Primer criterio de comparación ) Sean

minos positivos tales que ai ≤ bi ∀i ∈ IN. Entonces

P∞

P

1. Si ∞

i=1 ai también lo es.

i=1 bi es convergente,

P

P∞

2. Si ∞

i=1 ai es divergente,

i=1 bi también lo es.

P∞

Teorema 1.3 (Segundo criterio de comparación ) Sean

términos positivos tales que existe

an

lim

n→∞ bn

i=1 ai y

P∞

P∞

y

i=1 ai

i=1 bi dos series de tér-

P∞

i=1 bi

dos series de

(1.9)

Entonces

1. Si el límite es finito y distinto de cero, ambas series tienen el mismo carácter

2. Si el límite es nulo se verifica

P∞

P

(a) Si ∞

i=1 ai también lo es.

i=1 bi es convergente,

P∞

P∞

(b) Si i=1 ai es divergente, i=1 bi también lo es.

3. Si el límite es infinito se verifica

P∞

P

(a) Si ∞

i=1 ai también lo es.

i=1 bi es divergente,

P∞

P∞

(b) Si i=1 ai es convergente, i=1 bi también lo es.

Ejercicio 1.4 Demostrar los dos teoremas anteriores.

En los dos teoremas anteriores el carácter de la serie se obtenía por comparación con el de

otra. En los resultados que siguen el carácter se obtendrá a partir de la serie objeto de estudio

únicamente.

Teorema 1.4 (Criterio del cociente ) Sea

lim

n→∞

P∞

i=1 ai una serie de términos positivos tal que

an+1

=c

an

Entonces

1. Si c < 1 la serie es convergente.

2. Si c > 1 o c = +∞ la serie es divergente.

Si c = 1 no se puede asegurar nada sobre el carácter de la serie.

(1.10)

Ampliación de Matemáticas.

Series 5

Teorema 1.5 (Criterio de la raíz ) Sea

P∞

i=1 ai una serie de términos positivos tal que

√

n

lim

n→∞

an = c.

(1.11)

Entonces

1. Si c < 1 la serie es convergente.

2. Si c > 1 o c = +∞ la serie es divergente.

Si c = 1 no se puede asegurar nada sobre el carácter de la serie.

Teorema 1.6 (Criterio de la Integral ) Sea f : [1, ∞) −→ IR decreciente y positiva. Sea

an = f (n) ∀n ∈ IN. Entonces la serie

∞

X

an

(1.12)

n=1

y la integral

Z ∞

f (t)dt

(1.13)

1

tienen el mismo carácter.

Ejercicio 1.5 Estudiar el carácter de las series de la forma

∞

X

1

n=1

nc

(1.14)

para cualquier c ∈ IR.

La idea del primer criterio de comparación suele ser la simplificación de una serie eliminando

partes poco significativas para de esta manera poder compararla con otra más simple. En el

segundo criterio de comparación, necesitamos "intuir cómo va" el término general de la serie por

lo que tienen mucha importancia los infinitésimos equivalentes estudiados en Fundamentos de

Matemáticas. El criterio del cociente suele ser adecuado con términos generales que se simplifican

mucho al hacer el correspondiente cociente. El criterio de la raíz es adecuado para términos

generales que se simplifican al tomar raíces n-ésimas; este criterio es más fuerte que el criterio

del cociente, pues si el del cociente funciona, también lo hará el de la raíz (en virtud del criterio

de Cauchy para el cálculo de límites de sucesiones).

Los resultados de esta sección son también aprovechables para el estudio del carácter de series

de términos negativos. Basta tener en cuenta que la multiplicación por constantes no altera el

carácter. En particular, una serie y su opuesta tienen el mismo carácter, y si la de partida era

de términos negativos, su opuesta será de términos positivos.

6 Series

Ampliación de Matemáticas.

Ejercicio 1.6 Averigua el carácter de las series siguientes indicando el criterio empleado:

serie

∞

X

n=1

∞

X

2n

criterio

1

√

sen

n=1

carácter (razonado)

n

1

n

∞

X

1

n=1

n!

∞ X

2n + 1 n

n=1

3n + 2

∞

X

1

n=1

1.1.3

n2

Series alternadas.

De no estar ante una serie de términos positivos (o negativos) que es la situación más deseable

en lo que al estudio del carácter se refiere, lo más que se puede pedir es conocer los cambios de

signo de la sucesión {an }∞

n=1 . Esto es lo que sucede con las series alternadas.

Definición 1.2 Llamaremos serie alternada a la de la forma

∞

X

(−1)n an con an ≥ 0

n=1

IN.

Ejercicio 1.7 Razona si las siguientes series son alternadas o no:

serie

∞

X

−1

√

n n

2

n=1

∞

X

(−1)n

n=1

∞

X

n=1

2n

(−1)n

(−2)n

∞

X

(−1)(n+1)

n=1

∞

X

−5n

cos(π n)

2n

n=1

∞

X

sen n

n=1

Alternada (SI/NO/?) (razonado)

∀n ∈

Ampliación de Matemáticas.

Series 7

Por supuesto no todas las series que no son de términos positivos o negativos son alternadas.

Para las series alternadas se dispone del siguiente resultado bastante útil a la hora de estudiar

su carácter.

∞

X

Teorema 1.7 (Criterio de Leibnitz) Sea

(−1)n an una serie alternada tal que

n=1

a1 ≥ a2 ≥ · · · ≥ an ≥ . . .

con

lim an = 0.

n→∞

Entonces la serie es convergente y, si sn es su suma parcial n-ésima y s su suma, se tiene que

|sn − s| ≤ an+1

Ejercicio 1.8 Estudiar el carácter de la serie armónica alternada

∞

X

(−1)n

n=1

1.1.4

1

n

Convergencia condicional y absoluta.

Cuando se quiere estudiar el carácter de una serie cuyos términos cambian de signo una solución

puede ser pasar a considerar la serie de los valores absolutos.

Definición 1.3 Diremos que la serie

∞

X

an es absolutamente convergente si la serie

n=1

es convergente.

∞

X

|an |

n=1

Teorema 1.8 Las series absolutamente convergentes son convergentes.

Ejercicio 1.9 Determinar el carácter de

Serie

∞

X

sen n

2n

n=1

∞

X

(sen n)n

√

n

n

n=1

∞

X (1 − n)n

n=1

Carácter

Explicación

(n2 + 1)n

La convergencia absoluta es una condición suficiente para la convergencia pero no necesaria.

La serie armónica alternada proporciona el contraejemplo puesto que es convergente pero no

absolutamente convergente.

Definición 1.4 Las series convergentes pero no absolutamente convergentes se denominan condicionalmente convergentes.

P∞

Definición

P∞ 1.5 Dada la serie n=1 an llamaremos reordenación suya a cualquier serie de la

forma n=1 aσ(n) donde σ : IN −→ IN es una biyección cualquiera.

8 Series

Ampliación de Matemáticas.

Las series absoluta y condicionalmente convergentes tienen comportamientos muy diferentes

con respecto a la reordenación de sus términos como puede verse en el siguiente teorema.

Teorema 1.9 Si una serie es absolutamente convergente cualquier reordenación suya también

lo es y la suma de cualquier reordenación coincide con la de la serie de partida.

Si una serie es condicionalmente convergente entonces dado un valor real arbitrario, se puede

reordenar la serie de modo que la suma sea ese valor. Es también posible reordenar la serie de

modo que resulte divergente.

El teorema anterior implica que no se tiene la propiedad conmutativa en general a la hora de

sumar infinitos términos.

1.2

Series de potencias.

Así como en una serie numérica sus términos son números reales, se puede encontrar una serie

donde sus términos sean funciones. Cuando todas las funciones dependen de la variable x, se

∞

X

tiene una serie de la forma

fn (x) llamada serie de funciones.

n=0

Las series pueden verse como sumas con infinitos sumandos. En el caso numérico la serie

generaliza las sumas finitas de números, en el de series de funciones, se generalizan las funciones

definidas mediante un número finito de sumas. Entre estas funciones, sin duda, las más conocidas

son los polinomios. Cuando el número de sumandos de un polinomio se aumenta hacia infinito

aparecen las series de potencias.

Definición 1.6 Llamaremos serie de potencias centrada en c a toda serie de funciones de la

forma

∞

X

an (x − c)n

(1.15)

n=0

Cuando en una serie de funciones se toma un valor particular de x, x0 , y las funciones se

evalúan en ese punto, la serie se convierte en una serie numérica. La convergencia de la serie

de funciones estará relacionada con la convergencia de la serie numérica que se obtiene para un

determinado valor. Las series de potencias tienen un comportamiento muy específico en lo que

a convergencia se refiere como puede verse en el siguiente teorema.

P

n

Teorema 1.10 Sea ∞

n=0 an (x − c) una serie de potencias que converge para un cierto x0 6= c.

Sea δ ∈ IR tal que 0 < δ < |x0 − c|. Entonces la serie

∞

X

an (x − c)n

n=0

converge absolutamente en [c − δ, c + δ].

Del resultado anterior se concluye que si una serie de potencias centrada en c converge para

un cierto x0 , también lo hace para los x que estén a menos distancia de c. Al conjunto formado

por los números reales para los cuales una serie de potencias es convergente se le denomina

Ampliación de Matemáticas.

Series 9

campo de convergencia de la serie. Si el conjunto anterior está acotado llamaremos radio de

convergencia R al siguiente número

∞

X

R = sup{ |x − c| /

an (x − c)n

converge }

(1.16)

n=0

Si el campo de convergencia no está acotado, diremos que el radio de convergencia es ∞. Si

la serie sólo converge cuando x = c, diremos que el radio de convergencia es 0.

Obsérvese que si el radio de convergencia es R > 0, el teorema 1.10 nos dice que la serie

de potencias converge en (c − R, c + R) y no converge en (−∞, c − R) y (c + R, ∞). En los

extremos del intervalo x = c − R y x = c + R puede ocurrir cualquier cosa. Es decir, el campo de

convergencia ha de ser necesariamente uno de estos cuatro conjuntos: (c−R, c+R), [c−R, c+R),

(c − R, c + R] o [c − R, c + R].

Para determinar el radio de convergencia resulta útil el siguiente teorema.

Teorema 1.11 Sea

P∞

n=0 an (x − c)

n una serie de potencias tal que

lim

n→∞

p

n

|an | = l

(1.17)

Entonces R = 1/l si l 6= 0. Si el límite es 0, el radio de convergencia es infinito y si el límite es

infinito, R = 0.

El límite que aparece en el teorema anterior se calcula con frecuencia utilizando el criterio de

Cauchy. Veamos algunos ejemplos en los que se determina el radio y campo de convergencia de

una serie de potencias.

∞

X

Ejemplo 1.2 Consideremos la serie

22n xn .

n=0

lim

n→∞

√

p

n

n

|an | = lim 22n = 4

n→∞

(1.18)

Entonces R = 1/4. Veamos qué sucede en c − R y c + R, que en nuestro caso son −1/4 y 1/4.

En x = 1/4 la serie es

n X

∞

∞

X

1

22n

=

1

(1.19)

4

n=0

n=0

y por tanto divergente. En x = −1/4 la serie es

∞

X

n=0

2n

2

−1

4

n

=

∞

X

(−1)n

n=0

de carácter oscilante.

Entonces el campo de convergencia se reduce al intervalo (−1/4, 1/4).

(1.20)

10 Series

Ampliación de Matemáticas.

Ejemplo 1.3 Consideremos la serie

∞

X

xn

n=0

n!

.

p

1

n

|an | = lim √

n→∞

n→∞ n n!

(1.21)

n!

1

= lim

lim √

=0

n

n→∞

(n

+

1)!

n!

(1.22)

lim

Aplicando el criterio de Cauchy

n→∞

Entonces R = ∞ y por tanto el campo de convergencia es IR.

1.2.1

Representación de funciones en series de potencias.

∞

X

Teorema 1.12 Sea s(x) =

an (x − c)n una serie de potencias con radio de convergencia

n=0

R > 0. Entonces, para cada x ∈ (c − R, c + R), existe s0 (x) y se verifica

0

s (x) =

∞

X

n an (x − c)n−1

n=1

Por lo tanto, s0 (x) vuelve a ser una serie de potencias y en (c − R, c + R), la derivada de la

serie (suma infinita) es la suma (infinita) de las derivadas, pues

!

∞

X

n

d

an (x − c)

s0 (x) = dx

n=0

d a + a (x − c) + a (x − c)2 + · · · + a (x − c)n + · · · = dx

0

1

2

n

n−1

= a1 + 2 · a2 · (x − c) + · · · + n · an · (x − c)

+ ···

∞

X

=

n an (x − c)n−1

n=1

Nota: Esta propiedad (la derivada de una suma finita de funciones derivables es la suma de sus

derivadas) no siempre es cierta para una suma infinita. Es otro ejemplo de propiedad (véase

la conmutatividad en series numéricas condicionalmente convergentes) que se pierde cuando se

pasa del caso finito al infinito.

Si volvemos a aplicar el teorema 1.12 a la serie s0 (x) obtenemos

s00 (x) =

∞

X

n(n − 1)an (x − c)n−2

∀x ∈ (c − R, c + R)

(1.23)

n=2

y así sucesivamente. Podemos afirmar entonces que para la función s(x), suma de la serie de

partida, se verifica que es C ∞ (de clase infinito o indefinidamente derivable) y

k)

s (x) =

∞

X

n(n − 1) . . . (n − k + 1)an (x − c)n−k

∀x ∈ (c − R, c + R),

k ∈ IN

(1.24)

n=k

Si evaluamos las series dadas en (1.24) en x = c se obtiene

sk) (c) = k!ak

k = 1, 2, . . .

(1.25)

Ampliación de Matemáticas.

Series 11

y por tanto

s(x) =

∞

X

n

an (x − c) =

n=0

∞ n)

X

s (c)

n=0

n!

(x − c)n

(1.26)

Hemos visto así que las series de potencias son siempre series de Taylor (límites de polinomios

de Taylor) de su función suma.

Cabe ahora preguntarse si, dada una función f indefinidamente derivable y su serie de

Taylor

∞

X

f n) (c)

(x − c)n

(1.27)

n!

n=0

esta serie tiene siempre una función suma que resulte ser la propia f . En contra de lo que podría

esperarse la respuesta es negativa, es decir, es posible que se verifique

f (x) 6=

∞

X

f n) (c)

n=0

n!

(x − c)n

(1.28)

como se ve en el siguiente ejemplo.

1

Ejemplo 1.4 Sea f (x) = e− x2 si x 6= 0 y f (0) = 0. La función anterior cumple que

f n) (0) = 0

∀n ∈ IN

(1.29)

por lo que su serie de McLaurin (es decir, la serie de Taylor centrada en c = 0) resulta idénticamente nula y su suma no coincide con f para ningún x 6= 0.

¿Cómo saber entonces si la serie de Taylor de una función tiene por suma la propia función?

Los siguientes ejemplos muestran algunas formas de conseguir averiguarlo.

P

xn

Ejemplo 1.5 Sea f (x) = ex . Su serie de McLaurin es ∞

n=0 n! . Se vio en el ejemplo 1.3 que

esta serie convergía para todo x real. ¿Es su suma ex ?. Como para series de Taylor la suma

n-ésima sn (x) es el polinomio de Taylor de grado n de la función,

f (x) − sn (x) =

f n+1) (ξx ) n+1

eξx

x

=

xn+1 ,

(n + 1)!

(n + 1)!

Entonces

|f (x) − sn (x)| ≤

ξx ∈ (min(0, x), max(0, x))

max(1, ex )

|x|n+1

(n + 1)!

(1.30)

(1.31)

y

|x|n+1

=0

n→∞ (n + 1)!

por tratarse del término general de una serie convergente.

lim

Ejemplo 1.6 La serie de McLaurin de la función f (x) = (1 + x)−1 es

de una serie geométrica converge para x ∈ (−1, 1) y su suma es

∞

X

(−x)n =

n=0

(1.32)

P∞

1

1 − (−x)

En este caso por tanto la convergencia de la serie hacia f es inmediata.

n

n=0 (−x) . Al tratarse

(1.33)

12 Series

Ampliación de Matemáticas.

Ejemplo 1.7 Como se ha visto en el ejemplo anterior que ∀x ∈ (−1, 1) se tiene que f (x) =

∞

∞

X

X

1

n

0

=

(−x) , aplicando el teorema 1.12 de derivación, obtenemos que f (x) =

(−1) ·

1+x

n=0

n=1

n · (−x)n−1 , es decir,

∞

X

−1

0

=

f

(x)

=

(−1)n · n · xn−1

(1 + x)2

∀x ∈ (−1, 1)

n=1

Y una nueva aplicación de dicho teorema daría

∞

X

2

00

=

f

(x)

=

(−1)n · n · (n − 1) · xn−2

(1 + x)3

∀x ∈ (−1, 1)

n=2

Nota: Estos resultados nos permiten obtener la suma de algunas series numéricas concretas, por

ejemplo:

∞

X

5n

n=0

∞

X

n=1

∞

X

n!

(−1)n

n!

(−1)n

n=2

n(n − 1)

3n−2

= e5

Desarrollo de ex en x = 5

= e−1 − 1

Desarrollo de ex en x = −1

=

27

32

Desarrollo de

2

en x = 1/3

(1 + x)3

Un resultado análogo a la derivación de una serie de potencias se verifica para la integración.

Teorema 1.13 Si el intervalo [a, b] está contenido en el campo de convergencia de la serie de

∞

X

potencias

an (x − c)n , entonces se tiene

n=0

Z b

∞

X

a

n=0

!

an (x − c)

n

Z b

∞ X

n

dx =

an

(x − c) dx

n=0

a

∞

Ejemplo 1.8 Como ∀x ∈ (−1, 1) se tiene que f (x) =

X

1

=

(−x)n , aplicando el teorema

1+x

n=0

anterior para a = c = 0,

Z b

∞ Z b

∞

X

X

1

(−1)n bn+1

n

dx = ln(1 + b) =

(−x) dx =

n+1

0 1+x

0

n=0

n=0

∞

X

(−1)n bn+1

, ∀b ∈ (−1, 1), que llevado a la forma más habitual (x

n+1

n=0

en lugar de b) nos conduce a otra función representada por su serie de Taylor en (−1, 1)

Es decir que ln(1 + b) =

ln(1 + x) =

∞

X

(−1)n xn+1

n=0

n+1

, ∀x ∈ (−1, 1)

Ampliación de Matemáticas.

Series 13

Las funciones representables por su serie de Taylor (también llamadas funciones analíticas)

pueden ser aproximadas (en principio, en cualquier proceso donde intervengan) por polinomios

truncando su serie de Taylor. Esta aproximación será "muyRbuena" si nos quedamos con un

6 2

número suficientemente elevado de términos. Por ejemplo, 0 ex dx no posee una expresión

2

sencilla en términos de funciones elementales pues, es sabido que una primitiva de ex no puede

conseguirse así. Pero como

e

x2

=

∞

X

x2n

n=0

n!

Z 6

⇒

x2

e dx ≈

0

m Z 6

X

x2n

n=0 0

n!

dx

A continuación ponemos una tabla con algunas de estas aproximaciones (nota:

3.644831077 × 1014 )

m

m Z 6

X

x2n

n=0 0

1

5

10

20

40

80

100

n!

R 6 x2

0 e dx ≈

dx

78

3.290229974 × 105

4.088873580 × 108

1.799203394 × 1012

2.997050140 × 1014

3.644831077 × 1014

3.644831077 × 1014

Algunas funciones analíticas (funciones representables por su serie de Taylor) de uso habitual

son:

1)

ex

=

∞

X

xn

n=0

2)

sen x

=

∞

X

(−1)n x2n+1

n=0

3)

cos x

=

(2n + 1)!

∞

X

(−1)n x2n

(2n)!

n=0

4)

1

1−x

=

5) ln(1 + x) =

, ∀ x ∈ IR

n!

∞

X

xn

, ∀ x ∈ IR

, ∀ x ∈ IR

, ∀x ∈ (−1, 1)

n=0

∞

X

(−1)n xn+1

n=0

n+1

, ∀x ∈ (−1, 1)

14 Series

1.3

Ampliación de Matemáticas.

Series de Fourier

En el apartado anterior se ha visto que algunas funciones pueden representarse mediante su

serie de Taylor. Esto significa que pueden ser aproximadas por polinomios, consiguiéndose una

precisión tan alta como se desee. El hecho de que se puedan utilizar polinomios, no significa

que sea la mejor elección posible para el aproximante (la función por aproximar puede tener

propiedades, como son la periodicidad o la acotación, que los polinomios no poseen). En esta

sección se considerarán nuevos aproximantes inicialmente aptos para funciones periódicas. Estos

aproximantes serán combinaciones lineales de las funciones sen(nx) y cos(nx).

Definición 1.7 Llamaremos serie trigonométrica a cualquier serie de funciones de la forma

∞

a0 X

+

(an cos(nx) + bn sen(nx))

2

(1.34)

n=1

Las constantes a0 , an y bn reciben el nombre de coeficientes de la serie trigonométrica.

Definición 1.8 Sea f (x) una función integrable en [−π.π]. Se define la serie de Fourier

de f(x) como la serie trigonométrica (1.34) cuyos coeficientes vienen dados por las siguientes

expresiones:

Z

1 π

f (x)dx

(1.35)

a0 =

π −π

Z

1 π

an =

f (x) cos(nx)dx ∀n ∈ IN

(1.36)

π −π

Z

1 π

f (x) sen(nx)dx ∀n ∈ IN

(1.37)

bn =

π −π

Denotemos s(x) a la suma de la serie de Fouier de una función f (x), es decir

∞

s(x) =

a0 X

+

(an cos(nx) + bn sen(nx))

2

(1.38)

n=1

en los puntos en los que la serie converja. Lo deseable es que s(x) = f (x) pues en este caso las

sumas parciales de la serie serían aproximaciones a f (x) con límite la propia f (x). No es difícil

ver que las sumas parciales de las series trigonométricas son 2π-periódicas, por tanto s(x) será

también una función 2π-periódica. En general f (x) no lo es. Dado que sólo se han utilizado los

valores de f (x) en [−π, π] para determinar los coeficientes de su serie de Fourier, sólo podemos

esperar que f (x) = s(x) en [−π, π]. Fuera de este intervalo la suma de la serie de Fourier

convergerá a una "repetición 2π-periódica" de la función f (x). El siguiente teorema concreta

estas afirmaciones.

Teorema 1.14 Sea f˜ 2π-periódica, monótona a trozos y acotada en (−π, π]. Entonces su serie

de Fourier converge en (−π, π]. En los puntos de continuidad de f˜, la suma es f˜. En los puntos

de discontinuidad, la suma es la media de los límites laterales, es decir, si c es un punto de

discontinuidad de f˜ y s es la función suma

s(c) =

limx→c+ f˜(x) + limx→c− f˜(x)

2

Ampliación de Matemáticas.

Series 15

Ejemplo 1.9 Sea f una función con la siguiente definición en (−π, π].

0 si −π < x ≤ 0

f (x) =

x

si 0 < x ≤ π

Denotemos f˜(x) la prolongación 2π-periódica de f (x) . Las siguientes gráficas corresponden

a estas dos funciones. Nótese que todos los puntos de discontinuidad de f˜(x) tienen imagen π

f (x)

-π

π

π

*

π

f˜(x)

*

o

o

-π

π

*

o

2π

3π

4π

El teorema 1.14 nos permite trazar la gráfica de la suma de la serie de Fourier s(x) sin

conocer explícitamente su expresión. Su gráfica es la siguiente:

o

π

o

s(x)

o

*

*

*

o

o

o

-π

π

2π

3π

4π

Basta observar la gráfica de s(x) para obtener evaluaciones de s(x). Las siguientes líneas

muestran algunas de estas evaluaciones:

• s(−1) = f˜(−1) = f (1) = 0 porque x = −1 es un punto de continuidad de f˜(x), perteneciente

al intervalos (−π, π] donde f y f˜ coinciden.

• s(7) = f˜(7) = f˜(7 − 2π) = f (7 − 2π) = 7 − 2π porque estamos de nuevo en un punto de

continuidad de f˜(x) que es una función 2π-periódica y 7 − 2π ∈ (−π, π] donde f (x) y f˜(x)

coinciden.

limx→π+ f˜(x)+limx→p− f˜(x)

2

0 + f (π)

0+π

=

. Obsérvese

2

2

que en los puntos de discontinuidad de f˜(x) el valor de la suma de la serie de Fourier

es siempre el punto medio del salto. Si prolongamos la definición de f (x) a x = 0 con

(π)

continuidad, podemos expresar el punto medio del salto como f (0)+f

.

2

• s(3π) = s(3π − 2π) = s(π) =

=

Con independencia de todo lo anterior, podemos obtener la expresión explícita de la serie de

Fourier de f (x). Los coeficientes de esta serie son:

Z

1 π

π

a0 =

xdx =

π 0

2

Z

2

1 π

− 2 si n impar

an =

x cos(nx)dx =

πn

π 0

0

si n par

16 Series

Ampliación de Matemáticas.

1

bn =

π

Z π

0

1

n

x sen(nx)dx =

1

−

n

si n impar

si n par

Entonces la serie de Fourier es

∞ π X

s(x) = −

4

n=1

(−1)n

2

cos((2n − 1)x) +

sen(nx)

π(2n − 1)2

n

(1.39)

A continuación se muestra la gráfica de la función f junto con la suma parcial de su serie de

Fourier correspondiente a n = 4:

Nótese que la suma parcial aproxima en realidad a la prolongación de f (x), f˜(x). Obsérvese

tambien que la aproximación se vuelve menos precisa (se aleja más de la gráfica de f˜(x)) a

medida que nos acercamos a los puntos de discontinuidad de f˜(x).

Veamos para finalizar este ejemplo cómo utilizar series de Fourier para conseguir el valor de

la suma de series numéricas.

∞

X

1

(2n − 1)2

n=1

Observemos que las expresiones que queremos sumar aparecen en 1.39, en concreto en los

coeficientes de los cosenos. Si evaluamos 1.39 en x = 0 para que desaparezcan los términos del

seno, tenemos

Supongamos que queremos hallar la suma de la serie

∞

s(0) =

π

2X

1

−

4 π

(2n − 1)2

(1.40)

n=1

Sabemos también que s(0) = f (0) = 0 puesto que x = 0 es un punto de continuidad de f˜(x).

Entonces

∞

0=

π

2X

1

−

4 π

(2n − 1)2

n=1

1.3.1

⇒

∞

X

n=1

1

π2

=

(2n − 1)2

8

Desarrollos de Fourier con sólo cosenos o sólo senos.

Recordemos que se dice que una función g(x) es par si g(x) = g(−x) (simétrica respecto al eje

vertical, por ejemplo x2 + 1, cos x, cos(5x), ...) y que es impar si g(x) = −g(−x) (por ejemplo

x3 − x, sen x, sen(4x), ...). Para estas funciones se tienen las propiedades:

1. El producto de dos funciones pares es una nueva función par.

2. El producto de dos funciones impares es una nueva función par.

Ampliación de Matemáticas.

Series 17

3. El producto de una función par por una función impar es una nueva función impar.

4. Si g es una función impar,

Z a

g(x)dx = 0 ∀a ∈ IR

(1.41)

−a

y si g es una función par,

Z a

Z a

g(x)dx ∀a ∈ IR

g(x)dx = 2

−a

(1.42)

0

Como consecuencia de las propiedades anteriores y de las fórmulas para hallar los coeficientes

de la serie de Fourier de una función f (x) se tiene que los cálculos pueden reducirse a la mitad

en los siguientes casos:

• Si f (x) es par, su serie de Fourier tendrá sólo cosenos.

• Si f (x) es impar, su serie de Fourier tendrá sólo senos.

Si tenemos una función f (x) definida en el intervalo [0, π] podemos prolongarla o extenderla

al intervalo [−π, π] simetrizándola respecto al eje vertical (es decir, llevarla a una función par)

mediante la definición

fp (x) =

f (x)

si 0 ≤ x ≤ π

f (−x) si − π ≤ x ≤ 0

Así, fp (x) es una función par que coincide con f (x) en [0, π], por lo que su serie de Fourier

(que contendrá sólo cosenos) aproxima a los valores de f (x) en [0, π]. Obviamente, algo similar

puede hacerse respecto a prolongaciones impares, definiendo

fi (x) =

f (x)

si 0 ≤ x ≤ π

−f (−x) si − π ≤ x ≤ 0

Así se obtendrían aproximaciones a los valores de f (x) en [0, π] mediante una serie trigonométrica que contendría sólo senos.

18 Series

Ampliación de Matemáticas.

Observación: Ya hemos comentado que la continuidad favorece la bondad de las aproximaciones.

La prolongación par, mantiene la continuidad en x = 0 y x = π; pero la impar no, si f (0) 6= 0 o

bien f (π) 6= 0.

Las prolongaciones pares e impares que acaban de presentarse para el intervalo [0, π] pueden

hacerse de forma absolutamente análoga para cualquier intervalo [0, c].

1.3.2

Series de Fourier en un intervalo general [a,b].

Si f (x) es una función definida en un intervalo [a, b], podemos trasladarla al intervalo [−π, π]

l

b−a

mediante el cambio de variable x = t+c, donde para abreviar la escritura se definen l =

π

2

a+b

y c=

. Así cuando t recorre el intervalo [−π, π], la variable x va recorriendo el intervalo

2

[a, b], pero los valores funcionales (las alturas) son idénticos. Gráficamente:

Si ahora aproximamos la función g(t) = f

l

t + c , t ∈ [−π, π] por su serie de Fourier

π

∞

X

a0

+

(an cos(nt) + bn sen(nt))

g(t) ≈

2

n=1

donde, debido al cambio de variable t = πl (x − c), los coeficientes son

1

an =

π

Z π

1

g(t) cos(nt) dt =

l

−π

Z b

1

π

Z π

Z b

bn =

g(t) sen(nt) dt =

−π

1

l

f (x) cos

a

f (x) sen

a

nπ

l

nπ

l

(x − c) dx , n = 0, 1, 2, . . .

(x − c) dx , n = 1, 2, 3, . . .

se tiene que la aproximación, ya en la variable x tras deshacer el cambio en la fórmula anterior

para aproximar g(t), es

f (x) ≈

∞ nπ

nπ

X

a0

+

an cos

(x − c) + bn sen

(x − c)

, ∀x ∈ [a, b]

2

l

l

n=1

Si f (x) está definida en [a, b] podemos prolongarla a un intervalo de doble longitud de forma

par o de forma impar respecto del centro del intervalo final. Entonces la serie de la fórmula anterior tendría sólo cosenos o sólo senos (respectivamente) como sucedía cuando tratamos funciones

definidas en el intervalo [−π, π].

Tema 2

Interpolación Polinómica

La utilización de un polinomio en sustitución de una función en algún proceso matemático trae

consigo casi siempre una simplificación del problema, y la introducción de un error. En conjunto

la sustitución suele ser ventajosa, sobre todo si se elige adecuadamente el polinomio, y por tanto

muy frecuente.

¿Por qué se eligen los polinomios como sustitutos cuando se quiere simplificar un problema? Se pueden citar como razones su sencillez de evaluación (sólo se necesita un número finito

de sumas y productos), la obtención inmediata de sus primitivas y derivadas o la facilidad para

modificarlos manteniéndonos en la clase de los polinomios (obsérvese que si P (x) es un polinomio

de grado menor o igual que n, P (ax + b) también lo es).

A las razones anteriores hay que añadir que los polinomios son buenos aproximantes para

funciones de una clase tan amplia como la de las funciones continuas, como se deduce del siguiente

teorema debido a Weierstrass.

Teorema 2.1 Sea f : [a, b] −→ IR continua. Entonces dado > 0 existe un polinomio P (x) tal

que

|f (x) − P (x)| < ∀x ∈ [a, b]

(2.1)

2.1

Polinomio interpolador de Lagrange

Consideremos el siguiente problema: de una función f (x) se conoce su valor en n + 1 nodos

distintos x0 , x1 , . . . , xn . ¿Es posible encontrar un polinomio Pn (x) de grado menor o igual que n

que coincida con f en los mencionados nodos? Responderemos a esta pregunta construyendo el

polinomio.

Para cada i = 0, 1, 2, . . . , n, sea Li (x) un polinomio de grado menor o igual que n que se anula

sobre todos los nodos excepto xi y tal que Li (xi ) = 1. Obsérvese que las condiciones impuestas

sobre el grado y las raíces de Li (x) determinan que sea de la forma

Li (x) = ci (x − x0 )(x − x1 ) . . . (x − xi−1 )(x − xi+1 ) . . . (x − xn )

y la condición Li (xi ) = 1 proporciona el valor de ci :

−1

n

Y

ci =

(xi − xj )

j=0

j 6= i

(2.2)

(2.3)

20 Interpolación Polinómica

Ampliación de Matemáticas.

Entonces

Li (x) =

n

Y

j=0

j 6= i

(x − xj )

(xi − xj )

(2.4)

La obtención del polinomio interpolante es inmediata utilizando estos polinomios.

Pn (x) =

n

X

f (xi )Li (x)

(2.5)

i=0

Ejercicio 2.1 Demostrar que el polinomio interpolante que se acaba de obtener es único.

π

,

4

interpolador que se obtiene con los datos anteriores es:

Ejemplo 2.1 Sea f (x) = sen x, x0 = 0,

x1 =

x2 =

3π

y x3 = 2π. El polinomio

4

P3 (x) = f (x0 )L0 (x) + f (x1 )L1 (x) + f (x2 )L2 (x) + f (x3 )L3 (x)

Dado que tanto f (x0 ) como f (x3 ) son nulos, el polinomio se reduce a:

√

√

2 x(x − 3π

2 x(x − π4 )(x − 2π)

4 )(x − 2π)

P3 (x) =

+

π

3π

π 3π

2 π4 ( π4 − 3π

2 3π

4 )( 4 − 2π)

4 ( 4 − 4 )( 4 − 2π)

Su representación gráfica junto con la de f (x) es la siguiente:

P3 (x)

f (x)

Como puede verse en la gráfica anterior, la aproximación que proporciona el polinomio interpolante es mejor en unas "zonas" que en otras. (Obsérvese por ejemplo la diferencia entre f (x)

y P3 (x) en x = π2 y x = 3π

2 )

El siguiente resultado proporciona, bajo ciertas condiciones, una expresión de la diferencia

f (x) − Pn (x) que permitirá en ocasiones acotar el error que se comete al sustituir la función por

el polinomio.

Teorema 2.2 Sea f : [a.b] −→ IR con f ∈ C (n) ([a, b]) y tal que existe la derivada n + 1 en

(a,b). Sean x0 , x1 , . . . , xn ∈ [a, b], n + 1 nodos distintos y Pn (x) el polinomio de grado menor

o igual que n tal que f (xi ) = Pn (xi ) para i = 0, 1, . . . , n. Entonces para cada x ∈ [a, b] existe

ξx ∈ (min(x0 , x1 , . . . , xn , x), max(x0 , x1 , . . . , xn , x)) tal que

f (x) − Pn (x) =

f n+1) (ξx )

(x − x0 )(x − x1 ) . . . (x − xn )

(n + 1)!

(2.6)

Ampliación de Matemáticas.

Interpolación Polinómica 21

Al igual que sucede con la expresión del error en el polinomio de Taylor, su acotación dependerá del conocimiento de una cota de la derivada en un intervalo adecuado.

Ejemplo 2.2 Utilizando la expresión del error que proporciona el teorema 2.2, vamos a acotar

el error que se comete al utilizar el polinomio del ejemplo 2.1 en los siguientes casos:

1. x =

π

,

2

x=

3π

2

y

x=−

π

4

2. x ∈ [0, π]

π π

3. x ∈ [− , ]

2 2

(Obsérvese que la función sen x satisface en los tres casos las hipótesis del teorema)

Según el teorema 2.2 se dispone de la siguiente expresión para el error:

π

3π

f iv) (ξx )

x x−

x−

(x − 2π)

f (x) − P (x) =

4!

4

4

Dado que f iv) (x) = sen x y que ξx ∈ [0,2π] o un intervalo mayor, la única cota disponible

para el módulo de la derivada que aparece en (2.6) es 1:

1

3π

π

|f (x) − P (x)| ≤

x−

(x − 2π)

x x−

4!

4

4

Si llamamos φ(x) al polinomio del segundo miembro y particularizamos la acotación anterior

a los puntos que nos interesan tenemos:

π

π

1

π

|f

−P

| ≤ |φ

| = 0.190252

2

2

4!

2

3π

π

1

3π

|f

−P 3

| ≤ |φ

| = 2.85378

2

2

4!

2

π

−π

1

−π

|f −

−P

| ≤ |φ

| = 1.14151

4

4

4!

4

En la gráfica de la función y el interpolante puede apreciarse lo exagerado de esta acotación

para el segundo de los puntos.

Para los dos casos que quedan el objetivo es encontrar una cota de |f (x) − P (x)| válida en

un intervalo. Puesto que la derivada que aparece en la expresión del error está acotada por uno,

vamos a hallar

maxx∈[0,π] |φ(x)| y maxx∈[− π2 , π2 ] |φ(x)|

Las raíces de φ0 (x) expresadas con seis cifras significativas son:

r1 = 0.342278

r2 = 1.68440

r3 = 5.04189

Como |φ(x)| es una función continua y los intervalos son cerrados, los máximos buscados

se alcanzarán en un punto del intervalo abierto que necesariamente será una raíz de φ0 (x) o un

extremo del intervalo. (Obsérvese que en los puntos en los que |φ(x)| no sea derivable no se

22 Interpolación Polinómica

Ampliación de Matemáticas.

puede alcanzar el máximo buscado porque el módulo de un polinomio sólo puede ser no derivable

en una raíz de éste.) Entonces:

maxx∈[0,π] |φ(x)| = max{|φ(r1 )|, |φ(r2 )|, |φ(0)|, |φ(π)|} = |φ(π)|

π

π

π

maxx∈[− π2 , π2 ] |φ(x)| = max{|φ(r1 )|, |φ(− )|}, |φ( )|} = |φ(− )|

2

2

2

Llegamos así a la siguiente acotación para el error:

maxx∈[0,π] |f (x) − P (x)| ≤

|φ(π)|

= 0.761008

4!

maxx∈[− π2 , π2 ] |f (x) − P (x)| ≤

|φ(− π2 ))|

= 4.75630

4!

Como puede verse la utilización del polinomio en un intervalo exterior al determinado por los

nodos (extrapolación) puede aumentar considerablemente la cota del error. Además, la gráfica

del ejemplo 2.1, induce a pensar que no estamos ante un problema de cota de error exagerada

sino de mala aproximación. Si se desea aproximar en [− π2 , π2 ] sería más conveniente otra elección

de nodos.

Ejercicio 2.2 Sea f (x) = sen x, x0 = − π4 , x1 = 0, y x2 = π4 . Hallar el polinomio interpolador que, para la función sen x, determinan los nodos anteriores. Acotar el error que se

comete al utilizar ese polinomio para aproximar la función sen x en [− π4 , π4 ].

2.2

Forma de Newton del polinomio interpolador de Lagrange.

La expresión del polinomio interpolador obtenida en la sección anterior, conocida con el nombre

de Lagrange, tiene algunas desventajas desde el punto de vista de su utilización práctica:

1. El número de operaciones necesarias para la evaluación de un polinomio interpolador de

grado n escrito en la forma de Lagrange es muy superior al que requeriría la evaluación del

mismo polinomio escrito en potencias de x.

2. Si se desea aumentar el grado del polinomio interpolador añadiendo un nodo más, hay que

volver a construir el polinomio desde el principio.

La forma de Newton del polinomio interpolador consiste en expresar dicho polinomio como

P (x) = f [x0 ] + f [x0 , x1 ](x − x0 ) + · · · + f [x0 , x1 , . . . , xn ](x − x0 )(x − x1 ) . . . (x − xn−1 ) (2.7)

donde f [x0 ], . . . , f [x0 , x1 , ..., xn ] son valores numéricos que llamaremos coeficientes del polinomio

interpolador expresado en forma de Newton. Puede probarse que dichos coeficientes verifican las

siguientes propiedades:

1. f [x0 , x1 , . . . xi ] = f [xσ(0) , xσ(1) , . . . xσ(i) ], para cualquier permutación σ de los índices.

2. f [x0 ] = f (x0 )

Ampliación de Matemáticas.

Interpolación Polinómica 23

3. Se verifica la siguiente relación

f [x0 , x1 , . . . xi ] =

f [x1 , . . . xi ] − f [x0 , . . . xi−1 ]

xi − x0

i = 1, 2, . . . n

(2.8)

Los coeficientes f [x0 , x1 , . . . xi ] serán llamados en adelante diferencias divididas. La última

de las propiedades anteriores justifica el nombre y permite obtener los coeficientes necesarios para

el polinomio interpolador de grado n a partir de una tabla. Para cuatro nodos, por ejemplo, la

tabla sería como sigue:

x0 f [x0 ]

f [x0 , x1 ]

x1 f [x1 ]

f [x0 , x1 , x2 ]

f [x1 , x2 ]

x2 f [x2 ]

f [x0 , x1 , x2 , x3 ]

(2.9)

f [x1 , x2 , x3 ]

f [x2 , x3 ]

x3 f [x3 ]

y el polinomio

P3 (x) = f [x0 ] + f [x0 , x1 ](x − x0 ) + f [x0 , x1 , x2 ](x − x0 )(x − x1 )

+ f [x0 , x1 , x2 , x3 ](x − x0 )(x − x1 )(x − x2 ).

(2.10)

Obsérvese que si se quiere obtener P4 basta añadir un elemento en la parte inferior de cada

columna de la tabla para hallar f [x0 , x1 , x2 , x3 , x4 ].

Ejemplo 2.3 Obtengamos la forma de Newton del polinomio interpolante del ejemplo 2.1:

0

π

4

0

√

√

2 2

π

2

2

√

8 2

− 2

3π

0

3π

4

2π

√

2

2

√

2 2

−

5π

√

8 2

−

35π 2

√

128 2

105π 3

0

√

√ √ 2 2

8 2

π

128 2

π

3π

P3 (x) = 0 +

x−− 2 x x−

+

x x−

x−

π

3π

4

105π 3

4

4

24 Interpolación Polinómica

2.3

Ampliación de Matemáticas.

Interpolación de Hermite.

El polinomio de Taylor de una función se obtuvo imponiendo la coincidencia de las derivadas

en un punto; el polinomio interpolador de Lagrange se consiguió imponiendo la coincidencia

de imágenes en un conjunto de puntos. Plantearemos ahora un problema general del que las

situaciones anteriores son casos particulares.

De una función f (x) se conoce su valor en n + 1 nodos distintos x0 , x1 , . . . , xn . En cada

uno de los nodos anteriores se conocen los valores de derivadas sucesivas de la función hasta un

determinado orden (en general distinto para cada nodo). ¿Es posible encontrar un polinomio que

tenga en común con la función las imágenes y derivadas mencionadas? De existir este polinomio

tendría que verificar:

f 0 (x0 ) = P 0 (x0 ) . . .

f 0 (x1 ) = P 0 (x1 ) . . .

..

.

f m0 ) (x0 ) = P m0 ) (x0 )

f m1 ) (x1 ) = P m1 ) (x1 )

..

.

f (xn ) = P (xn ) f 0 (xn ) = P 0 (xn ) . . .

f mn ) (xn ) = P mn ) (xn )

f (x0 ) = P (x0 )

f (x1 ) = P (x1 )

..

.

(2.11)

Para simplificar la notación, si hacemos N = n+m0 +· · ·+mn , tendremos con las ecuaciones

anteriores N + 1 condiciones o igualdades que cumplir. Así que sería deseable que el polinomio

buscado tuviera grado menor o igual que N , pues entonces el número de sus coeficientes es igual

al de condiciones que tenemos.

Puede probarse que tal polinomio, que denotamos por PN (x), existe y es único. Llamaremos

al polinomio obtenido polinomio de Hermite y a este tipo de interpolación interpolación de

Hermite.

Aunque los coeficientes de PN (x) pueden obtenerse resolviendo un sistema de ecuaciones

lineales al imponer las condiciones dadas en (2.11), es más eficiente construirlo mediante una

tabla similar a la tabla de diferencias divididas empleada para la obtención de la forma de Newton

del polinomio interpolador.

Para ello es necesario ampliar la definición de diferencia dividida en el siguiente sentido: si

x0 , x1 , . . . , xs verifican xi ≤ xi+1 i = 0, 1, . . . s y xi , xi+1 , . . . , xj es un subconjunto suyo con

índices consecutivos se define

f [xi , xi+1 , . . . xj ] =

f [xi+1 , . . . xj ] − f [xi , . . . xj−1 ]

xj − xi

f [xi , xi+1 , . . . xj ] =

f j−i) (xi )

(j − i)!

si xi 6= xj

si xi = xj

(2.12)

(2.13)

Para obtener el polinomio de Hermite del problema (2.11) basta con hacer una tabla de

diferencias divididas de este tipo en la que los nodos estén en orden creciente y cada xi se repita

mi + 1 veces (tantas como datos se conocen de él).

Ampliación de Matemáticas.

Interpolación Polinómica 25

Ejemplo 2.4 Obtengamos el polinomio de Hermite de la función f (x) = ln x que cumple P (1) =

f (1), P 0 (1) = f 0 (1), P 00 (1) = f 00 (1), P (2) = f (2) y P 0 (2) = f 0 (2).

1 0.000000

1.000000

−0.500000

1 0.000000

1.000000

0.193147

−0.306853

1 0.000000

0.693147

−0.079441

0.113706

−0.193147

2 0.693147

0.500000

2 0.693147

El polinomio será pues

P (x) = 0 + 1(x − 1) − 0.5(x − 1)2 + 0.193147(x − 1)3 − 0.079441(x − 1)3 (x − 2)

Podemos ampliar la definición de diferencias divididas de la siguiente manera: si xi , xi+1 , . . . , xj

es un conjunto de nodos (repetidos o no), definimos

f [xi , xi+1 , . . . , xj ] = f [xσ(i) , xσ(i+1) , . . . , xσ(j) ]

(2.14)

con xσ(i) ≤ xσ(i+1) ≤ · · · ≤ xσ(j) .

Utilizando esta definición, el polinomio de Hermite puede obtenerse colocando los nodos en la

tabla en un orden arbitrario aunque, desde un punto de vista práctico, resulta más conveniente

agrupar los nodos repetidos.

Teorema 2.3 Sea f : [a, b] −→ IR con f ∈ C (N ) ([a, b]) y tal que existe la derivada N + 1 en

(a,b). Sean x0 , x1 , . . . , xn ∈ [a, b], n + 1 nodos distintos y PN (x) el polinomio de Hermite que

j)

satisface f j) (xi ) = PN (xi ), j = 0, 1, . . . mi , i = 0, 1, . . . , n con m0 + m1 + · · · + mn + n = N .

Entonces para cada x ∈ [a, b] existe ξx ∈ (min(x0 , x1 , . . . , xn , x), max(x0 , x1 , . . . , xn , x)) tal que

f (x) − PN (x) =

f N +1) (ξx )

(x − x0 )m0 +1 . . . (x − xn )mn +1

(N + 1)!

(2.15)

Obsérvese que cuando m0 = · · · = mn = 0 (no hay derivadas) tenemos la interpolación de

Lagrange y que si n = 0 (sólo un nodo, el x0 ) tenemos el polinomio de Taylor centrado en x0 .

Por otra parte, el polinomio de Hermite obtenido para m0 = m1 = . . . mn = 1 es el más usual

y recibe el nombre de interpolación osculatoria.

26 Interpolación Polinómica

2.4

Ampliación de Matemáticas.

Interpolación polinómica segmentaria.

Utilizando la forma de Newton del polinomio interpolante, es sencillo aumentar el grado del

polinomio. ¿Es ésta una buena medida para mejorar la aproximación? El teorema de Weierstrass

puede inducir a pensar que sí, pero en general no es cierto. Runge demostró que los polinomios

interpolantes de la función

1

f (x) =

(2.16)

1 + x2

en el intervalo [−10, 10], construídos utilizando nodos equidistantes (diremos que los nodos

son equidistantes cuando la diferencia entre dos consecutivos sea una cantidad constante h > 0

que llamaremos tamaño de paso), sólo convergen a f (x) en la parte central del intervalo. Las

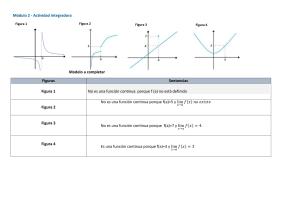

siguientes gráficas muestran la función f (x) junto con sus polinomios

interpolantes de grado 6

(izquierda) y 12 (derecha),

construídos a partir de nodos equidistantes. Obsérvese

cómo las oscilaciones de los

polinomios interpolantes en

las proximidades de los extremos del intervalo aumentan con el grado.

P12 (x)

P6 (x)

Una elección más adecuada de los nodos puede conseguir mejorar la aproximación, pero esta

elección varía con la función, y el grado a que se puede llegar hace que el camino no sea rentable.

Una solución mejor puede ser dividir el intervalo en el que se desea un polinomio interpolador y

considerar en cada subintervalo un polinomio interpolador distinto. A esta forma de interpolación

polinómica se le llama segmentaria o interpolación a trozos. Normalmente los polinomios

utilizados en cada subintervalo son del mismo tipo y el grado suele ser menor o igual que 3. Por

ejemplo, son habituales la interpolación lineal a trozos, con polinomios de grado menor o

igual que 1, o la interpolación cuadrática a trozos, con polinomios de grado menor o igual

que 2.

La interpolación segmentaria tiene el inconveniente de que la función aproximante que se

obtiene, en general no es derivable en los puntos comunes a dos intervalos consecutivos de la

partición considerada.

Una interpolación segmentaria en la que desaparece el problema comentado de la no existencia

de derivada en los nodos comunes es la conocida como interpolación cúbica de Hermite. En

esta interpolación las condiciones que se se imponen para cada nodo de los que determinan los

subintervalos de la partición son dos: coincidencia en imagen y en primera derivada. Así, en cada

trozo [xi−1 , xi ] se tendrá un polinomio de Hermite de grado 3 diferente y el interpolante global

será de clase 1. A este interpolante (que ya no es un polinomio , si no varios trozos "pegados")

se le llama interpolante cúbico de Hermite o trazador cubico de Hermite.

El error en la interpolación segmentaria depende del grado de los polinomios utilizados y de

la proximidad de los nodos. Veamos un ejemplo:

Ampliación de Matemáticas.

Interpolación Polinómica 27

Ejemplo 2.5 En el intervalo [a,b] se utiliza interpolación lineal a trozos con nodos equidistantes.

Sea h la distancia entre dos nodos consecutivos. Cualquier punto de [a, b] se hallará entre dos

nodos consecutivos xi−1 y xi . El error de interpolación para ese x será entonces

f (x) − P1 (x) =

f 00 (ξx )

(x − xi )(x − xi−1 ).

2!

(2.17)

Supongamos que se conoce una cota M del módulo de la derivada segunda de f en [a, b]. Como

el valor máximo de |(x − xi )(x − xi−1 )| en [xi−1 , xi ] es h2 /4 (¿por qué?) tenemos

|f (x) − P1 (x)| ≤

M h2

2! 4

∀x ∈ [a, b]

(2.18)

Obsérvese que en una situación como la descrita la acotación (2.18) asegura que los interpolantes

lineales a trozos convergen a la función cuando h tiende a 0.

2.5

Splines.

La interpolación segmentaria utilizando polinomios de Hermite no es la única forma de utilizar

polinomios diferentes para conseguir aproximantes globales que satisfagan ciertas condiciones

de regularidad. Los splines son otra alternativa. Trataremos únicamente el caso de los splines

cúbicos.

En un intervalo [a, b] se tiene la partición a = x0 < x1 < · · · < xn = b y se desea un

interpolante, en cada subintervalo determinado por la partición, de grado menor o igual que tres

que coincida con la función en los nodos y de forma que el aproximante final sea de clase 2 en

todo el intervalo. Denominaremos a este aproximante spline cúbico.

Analicemos si las condiciones que se le imponen a un spline cúbico son razonables. En cada

subintervalo [xi−1 , xi ] tenemos que determinar un polinomio

Pi (x) = ai (x − xi−1 )3 + bi (x − xi−1 )2 + ci (x − xi−1 ) + di

(2.19)

lo que supone 4n coeficientes para determinar. Estos polinomios han de verificar:

Pi (xi−1 ) = f (xi−1 ) i = 1, 2, . . . n

(2.20)

Pi (xi ) = f (xi ) i = 1, 2, . . . n

(2.21)

0

Pi0 (xi ) = Pi+1

(xi ) i = 1, 2, . . . n − 1

(2.22)

00

Pi00 (xi ) = Pi+1

(xi ) i = 1, 2, . . . n − 1

(2.23)

lo que significa que se tienen 2n + 2n − 2 condiciones, dos menos por tanto que el número

de coeficientes que hay que determinar. La expresión de los polinomios Pi (x) en potencias de

(x − xi−1 ) resulta ventajosa a la hora de buscar relaciones entre los coeficientes de los polinomios,

que faciliten la resolución del sistema. Puede probarse que el sistema planteado tiene solución

que por supuesto no es única. Para igualar el número de condiciones y el de coeficientes se suelen

imponer condiciones suplementarias. Las dos más usuales son: derivada segunda nula en a y b

(spline natural) o fijar los valores de la derivada primera en a y b (spline sujeto).

28 Interpolación Polinómica

Ampliación de Matemáticas.

Una ventaja de la interpolación segmentaria de Hermite frente a los splines cúbicos les que

permite ir logrando aproximaciones en cada subintervalo de manera independiente de los demás.

Así, si deseamos modificar el perfil del trazador en un tramo podemos cambiar allí sus valores

que esto no afectará a los trozos donde los valores se mantengan. En los splines sin embargo, la

modificación de cualquier dato afecta al interpolante obtenido en todos los subintervalos de la

partición.

Ventajas del spline son que el interpolante final es de clase 2 (tiene dos derivadas continuas)

mientras con la cúbica de Hermite a trozos sólo conseguimos primera derivada continua, y que

podemos obtener el aproximante sin necesidad de conocer el valor de la derivada en los nodos.

La elección de una interpolación cúbica de Hermite o de un spline cúbico depende de las

particularidades del problema que se desea resolver.

Tema 3

Producto interior. Ajuste

3.1

Producto interior.

Definición 3.1 Sea V un espacio vectorial. Llamaremos producto interior en V a cualquier

aplicación

< ., . >: V × V −→ IR

( u , v ) −→ < u , v >

que verifique las siguientes propiedades:

1. < u , v >=< v , u >,

∀u, v ∈ V .

2. < u + v, w >=< u, w > + < v, w >,

3. < ku , v >= k < u , v >,

4. < v , v >≥ 0,

∀u, v ∈ V,

∀u, v, w ∈ V .

∀k ∈ IR.

∀v ∈ V y < v , v >= 0 si y sólo si v = 0.

Algunos ejemplos de producto interior son:

1. El producto escalar habitual o euclídeo en IRn : si x = (x1 , x2 , . . . xn )t y y = (y1 , y2 , . . . yn )t

< x, y >=

n

X

xi yi .

(3.1)

i=1

2. En el espacio de matrices M2×2 :

<

a11 a12

a21 a22

b11 b12

,

>= a11 b11 + 2a12 b12 + 3a21 b21 + 4a22 b22 .

b21 b22

Ejercicio 3.1 Utilizando la definición, probar que cualquier producto interior verifica las siguientes propiedades:

1. < u , v + w >=< u , v > + < u , w >,

2. < u , kv >= k < u, v >,

3. < v , 0 >= 0,

∀v ∈ V.

∀u, v ∈ V,

∀u, v, w ∈ V

∀k ∈ IR

30 Producto interior. Ajuste

3.2

Ampliación de Matemáticas.

Normas.

Si consideramos el producto interior definido en IRn en (3.1) para el caso n = 2, 3, no es difícil

ver una relación entre < v, v > y la longitud (módulo) del vector v:

|v| =

√

< v, v >.

El producto interior va a permitir así extender la idea de módulo de un vector de IR2 o IR3

a un vector general como se recoge en la siguiente definición.

Definición 3.2 Sea V un e.v. con producto interior (en adelante p.i.). Denominaremos norma

asociada al producto interior a la siguiente aplicación

k.k : V

v

−→ IR

√

−→ kvk = < v, v >

Definiremos distancia entre dos vectores u y v de V por d(u, v) = ku − vk.

Nota 3.1 Con el producto interior euclídeo definido en (3.1), si V = IR, ||v|| = |v| es el valor

absoluto del número real v y si V = IR2 y V = IR3 , la norma coincide con la "longitud del

vector".

Ejemplo 3.1 En Π2 , espacio

R 1 de los polinomios de grado menor o igual que 2, con el producto

interior < p(x), q(x) >= −1 p(x)q(x)dx se tiene:

< x, x2 >= 0

k1k =

√

2,

kxk =

p

2/3,

d(1, x) =

p

8/3

Las normas asociadas a productos interiores son sólo un caso particular (y especialmente

importante) del concepto general de norma que a continuación definimos:

Definición 3.3 Sea V un e.v. Llamaremos norma a cualquier aplicación

k.k : V

v

−→ IR

−→ kvk

que verifique las siguientes propiedades:

1. kvk ≥ 0, ∀v ∈ V y kvk = 0 ⇐⇒ v = 0.

2. ku + vk ≤ kuk + kvk,

3. kkvk = |k| kvk,

∀u, v ∈ V .

∀v ∈ V, ∀k ∈ IR.

Ya hemos dicho que las normas asociadas al producto escalar en IR2 y IR3 representan la

longitud del vector. Las normas en general pueden entenderse como una forma de medir vectores.

Esta medida puede no ser identificable con una longitud (recuérdese que los vectores pueden ser

cualquier cosa (funciones, matrices,...). Aún cuando nos centremos en IRn , es posible definir

normas que para IR2 y IR3 no sean la longitud del vector. Veamos dos ejemplos.

Norma uno:

∀v = (v1 , v2 , . . . , vn )t ∈ IRn ,

kvk1 =

n

X

i=1

|vi |.

(3.2)

Ampliación de Matemáticas.

Norma infinito:

Producto interior. Ajuste 31

∀v = (v1 , v2 , . . . , vn )t ∈ IRn ,

kvk∞ = max{|vi | : i = 1, 2, . . . , n}.

(3.3)

La norma asociada al producto interior (3.1) (la que da la longitud del vector) se denomina

norma euclídea o norma 2.

No es difícil ver que las normas infinito, uno y dos, en general, no coinciden.

Ejemplo 3.2 Sea v = (1, −2, 3)t . Para este vector

kvk∞ = 3,

kvk1 = 6,

kvk2 =

√

14.

Los siguientes gráficos representan los vectores (x, y) ∈ IR2 unitarios (esto es, cuya norma

es 1) para las tres normas consideradas.

Fig. 3.1. kvk1 = 1

3.3

Fig. 3.2. kvk2 = 1

Fig. 3.3. kvk∞ = 1

Ángulo y Ortogonalidad.

Volvamos a las normas que derivan de productos interiores. Para estas normas es posible extender

los conceptos de ángulo y ortogonolidad conocidos en IR2 y IR3 . Este será nuestro siguiente

objetivo.

Teorema 3.1 (Desigualdad de Cauchy-Schwarz) Sea V un e.v. con p.i., entonces

∀u, v ∈ V se verifica

< u, v >2 ≤ < u, u >< v, v > .

(3.4)

Si u y v son no nulos, la desigualdad (3.4) puede escribirse así:

< u, v >2

≤1

kuk2 kvk2

o en cualquiera de las dos formas equivalentes siguientes:

< u, v >

≤1

kuk kvk

o

< u, v >

≤ 1.

kuk kvk

El cociente anterior puede ser visto como el coseno de un ángulo α ∈ [0, π] y podemos tomar

tal ángulo como el que forman u y v.

−1 ≤

32 Producto interior. Ajuste

Ampliación de Matemáticas.

Definición 3.4 Sea V un e.v. con p.i. y u, v ∈ V ambos no nulos. Llamaremos ángulo entre

los vectores u y v al número α ∈ [0, π] dado por:

< u, v >

.

(3.5)

α = arccos

kuk kvk

Definición 3.5 Sea V un e.v. con p.i. y u, v ∈ V . Diremos que u y v son ortogonales (se

denotará u ⊥ v) si < u, v >= 0.

Nota 3.2 Obsérvese que una consecuencia de las dos definiciones anteriores es que u y v no

nulos son ortogonales cuando el ángulo que forman es π/2.

Teorema 3.2 (Pitágoras generalizado) Sea V e.v. con p.i. y u, v ∈ V . Entonces

u ⊥ v ⇐⇒ ku + vk2 = kuk2 + kvk2 .

Demostración:

ku + vk2 =< u + v , u + v >=< u , u > +2 < u , v > + < v , v >= kuk2 + kvk2

puesto que al ser u y v ortogonales, < u , v >= 0.

Definición 3.6 Sea V e.v. con p.i., v ∈ V y W ⊂ V . Diremos que v es ortogonal a W

(v ⊥ W ) si v es ortogonal a todos los vectores de W .

Ejercicio 3.2 Sea W = lin(S). Demostrar que v ⊥ W ⇐⇒ v ⊥ S.

Definición 3.7 Sea V e.v. con p.i. y S ⊂ V . Se define el ortogonal de S de la siguiente

manera,

S ⊥ = { v ∈ V / v ⊥ S}.

Ejercicio 3.3 Demostrar las siguientes afirmaciones:

1. S ⊥ es un subespacio vectorial.

2. S ⊥ = (lin(S))⊥ .

3. Si A ⊂ B ⊂ V , entonces B ⊥ ⊂ A⊥ .

4. V ⊥ = {0},

{0}⊥ = V .

5. Sea W subespacio de V , entonces W ∩ W ⊥ = {0}.

Definición 3.8 Diremos que un subconjunto U de V es ortogonal si cualquier par de vectores

del conjunto U resulta ortogonal.

Diremos que un subconjunto de V es ortonormal si es ortogonal y todos sus vectores son

unitarios.

Al proceso de multiplicar un vector no nulo por un escalar, de forma que el vector resultante

sea de norma 1, se le llama normalizar el vector. Un conjunto ortogonal se convierte en

ortonormal si normalizamos todos los vectores.

Ampliación de Matemáticas.

Producto interior. Ajuste 33

Ejercicio 3.4 ¿Cuál es el escalar por el que hay que multiplicar un vector para normalizarlo?

Teorema 3.3 Sea V e.v. con p.i. y S = {v 1 , v 2 , . . . , v r } ⊂ V − {0} con S ortogonal. Entonces

S es linealmente independiente

Demostración: Consideremos una combinación lineal de los elementos de S igualada a cero

y veamos que todos los coeficientes deben ser nulos.

r

X

αi v i = 0

=⇒ <

i=1

r

X

αi v i , v j >= 0,

j = 1, 2, . . . , r.

i=1

Aplicando ahora las propiedades de linealidad del producto interior,

<

r

X

αi v i , v j >= 0

=⇒

r

X

< αi v i , v j >= 0

=⇒

i=1

i=1

r

X

αi < v i , v j >= 0.

i=1

y al ser S ortogonal, la expresión anterior se reduce a

αj < v j , v j >= 0.

Como v j es no nulo, necesariamente αj = 0,

j = 1, 2, . . . , r.

La ortogonalidad tiene sus ventajas a la hora de considerar bases y coordenadas como podemos ver en el siguiente resultado.

Teorema 3.4 Sea V e.v. con p.i. y B = {v 1 , v 2 , . . . , v n } una base ortonormal de V . Entonces

∀u, w ∈ V

1. u =

n

X

< u, v i > v i .

i=1

2. < u, w >=

n

X

< u, v i >< w, v i >.

i=1

v

u n

uX

u

3. kuk = t

< u, v i >2 .

i=1

Demostración:

1. Sean (α1 , α2 , . . . , αn ) las coordenadas de u en la base B

u=

n

X

αi v i

=⇒ < u, v j >=

i=1

lo que prueba el apartado.

n

X

i=1

αi < v i , v j >= αj < v j , v j >= αj

34 Producto interior. Ajuste

Ampliación de Matemáticas.

2. Sean (β1 , β2 , . . . , βn ) las coordenadas de w en la base B.

< u, w >=

n

X

αi βi < v i , v i >=

i=1

n

X

αi βi

i=1

y aplicamos el primer apartado.

3. Con la notación introducida,

kuk2 =< u, u >=

n

X

αi2 < v i , v i >=

i=1

n

X

αi2

i=1

y aplicamos el apartado primero.

El primer apartado del teorema anterior dice que las coordenadas de un vector en una base

ortonormal son los productos interiores del vector con los vectores de la base (muy fáciles de

calcular por tanto). El segundo y tercer apartado del teorema permiten ver que si en un espacio

vectorial con p.i. identificamos cada vector con sus coordenadas en una base ortonormal, el p.i.

se reduce al habitual de IRn (segundo apartado del teorema) y lo mismo puede decirse de la

norma asociada al p.i. (tercer apartado).

Una consecuencia inmediata del teorema anterior es el siguiente resultado.

Teorema 3.5 Sea V un e.v. con p.i. Entonces la matriz P de cambio de base entre dos bases

ortonormales de V cumple que P −1 = P t .

Ejercicio 3.5 ¿Por qué el resultado anterior es consecuencia inmediata del teorema (3.4)?

(Recuérdese qué es cada columna de una matriz de cambio de base)

Las matrices cuadradas que cumplen A−1 = At se denominan matrices ortogonales.

Ejemplo 3.3 En IR3 con el producto interior euclídeo B = {u1 , u2 , u3 } con

0

4/5

−3/5

0

u1 = 1 , u2 = 0 , u3 =

0

3/5

4/5

es una base ortonormal.

Si v = (1, 1, 1)t entonces

[v]B = (1, 7/5, 1/5)t

y

kvk =

p

√

12 + (7/5)2 + (1/5)2 = 3

Si u = u1 + 2u2 + 3u3 entonces

kuk =

p

12 + 2 2 + 3 2 .

¿Cual sería la matriz de cambio de la base canónica de IR3 a B?

De lo visto hasta ahora se deduce la ventaja de trabajar con bases ortonormales, pero ¿es

esto siempre posible? Vamos a ver que así es si estamos en un e.v. de dimensión finita, porque

siempre es posible modificar una base cualquiera para convertirla en ortonormal.

Ampliación de Matemáticas.

3.4

Producto interior. Ajuste 35

Proyección y componente ortogonal.

Consideremos el espacio vectorial IR3 con las operaciones y el p.i. habituales y sea W un plano

de IR3 . No es difícil admitir, a nivel intuitivo, la posibilidad de descomponer cualquier vector

v de IR3 en suma de un vector de W (v p ) y otro de W ⊥ (v o ) como se muestra en la figura,

de forma que v = v p + v o . Veamos que esto se puede generalizar a cualquier e.v. con p.i. y

cualquier subespacio W de dimensión finita. Empezaremos por el caso en que se conoce una base

ortonormal de W .