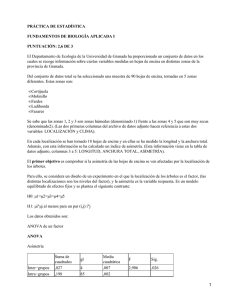

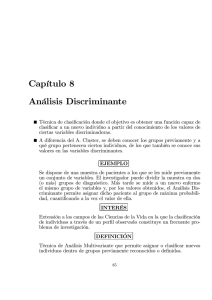

COMPLEMENTOS DE FORMACIÓN EN ANALISIS DE DATOS TEMA 4: ANALISIS DISCRIMINANTE ESCUELA UNIVERSITARIA DE ESTADÍSTICA UNIVERSIDAD COMPLUTENSE DE MADRID INTRODUCCION El análisis discriminante es una Familia de técnicas destinadas a: • Clasificar a individuos en una serie de grupos existentes en base a otro cierto numero de variables numéricas o nominales. • PREDECIR como el ANÁLISIS DE REGRESION (difiere de éste por que la variable dependiente es discreta). • Describir tanto algebraica como gráficamente las diferentes características de las observaciones que provienen de varias poblaciones. Se trata de buscar variables discriminantes (reales o ficticias) cuyos valores propicien la separación de una población en subpoblaciones específicas tanto como sea posible. FORMULACIÓN DEL PROBLEMA El análisis discriminante por tanto se propone • En un primer paso separar lo mejor posible las q clases con la ayuda de p variables . • En un segundo paso resolver los problemas de asignación de individuos nuevos a partir de las p variables conocidas a la clase k que mejor convenga. Siempre tendremos por tanto 2 etapas: • Buscar las funciones lineales discriminantes que mejor separan las q clases utilizando una muestra •Clasificar observaciones. NOTACIÓN Sean i las clases posibles de individuos. Las observaciones se clasificarán en función de p variables explicativas X= X 1 , X 2 ,..., X p Cada subpoblación se describe mediante su función de densidad : fi(x). Buscaremos dividir el espacio muestral correspondiente a las p variables en regiones Ri tal que si una nueva observación cae en Ri se asigna a la población i Pretendiendo que los errores que se cometan en esta asignación sean los menores posibles. Ejemplo Consideremos dos grupos de clientes en una ciudad: 1 compradores de cortacésped y 2 no compradores. Para identificar la mejor propuesta de ventas en una campaña se está interesado en clasificar a los individuos en esas dos clases en función de dos variables x1(ingresos) y x2 (tamaño parcela). Se toman inicialmente dos muestras de 12 observaciones cada una correspondientes y no87 compradores 85.5 64.8 61.5 110 108 82.8 69 93 51 81 Compradores X1 60 a compradores X2 18.4 16.8 21.6 20.8 23.6 19.2 17.6 22.4 20 20.8 X1 75 52.8 64.8 43.2 84 49.2 59.4 66 47.4 33 No R1 17.6 16 18.4 16.4 18.8 Compradores X2 19.6 20.8 17.2 20.4 17.6 R2 22 51 14 20 63 14.8 CRITERIO DE MAXIMIZACIÓN DE LA PROBABILIDAD A POSTERIORI P ocurra 1 y se observe xo P 1 xo P(observar xo ) P(observar xo 1 ) P 1 P(observar x0 1 ) P 1 P(observar x0 2 ) P 2 p1 f1 (xo ) P 1 xo p1 f1 (xo ) p2 f 2 (xo ) p2 f 2 (xo ) P 2 xo p1 f1 (xo ) p2 f 2 (xo ) Clasificamos una observación xo en 1 si P 1 x o P 2 x o f1 (xo ) p2 p1 f1 (xo ) p2 f 2 (xo ) f 2 (xo ) p1 MINIMIZACIÓN DEL COSTE DE LOS ERRORES COMETIDOS El coste que se comete al asignar una observación a la clase k cuando realmente pertenece a la clase k’: c(k/k’) Por lo que si incluimos los costes y tratamos de minimizar el coste esperado nos saldría: f1 (x) c(1 2) p2 relacion relacion de R1 : de costes probabilidades a priori f 2 (x) c(2 1) p1 Clasificamos una observación xo en 1 si P 1 x o P 2 x o REGLA DE DECISIÓN q=2 f1 (x) c(1 2) p2 relacion relacion de R1 : de costes probabilidades a priori f 2 (x) c(2 1) p1 c(2/1) > c(1/2) p1=p2 f1 f2 C(1/2)=c(2/1) p1=p2 R2 R1 MAXIMIZACIÓN SOBRE POBLACIONES NORMALES Si f1(x) y f2(x) siguen leyes de distribución normales multivariantes con vector de medias y matrices de covarianzas: fi (x) 1 (2 ) p / 2 1, . 1 1 exp x μ ' x μ i i 1/ 2 2 Σ 1 1 c(1 2) p 2 1 1 R1 : exp x μ 1 ' x μ 1 x μ 2 ' x μ 2 2 2 c(2 1) p1 1 1 c(1 2) p 2 1 1 R2 : exp x μ 1 ' x μ 1 x μ 2 ' x μ 2 2 2 c(2 1) p1 c(1 2) p2 si denotamos k= c(2 1) p1 MAXIMIZACIÓN SOBRE POBLACIONES NORMALES 1 1 i 1 si: exp x μ1 ' 1 x μ1 x μ 2 ' 1 x μ 2 k 2 2 1 1 -1 -1 - 2 x - μ1 'Σ x - μ1 + 2 x - μ 2 'Σ x - μ 2 ln(k ) 1 1 -1 1 x ' Σ x μ1 ' Σ x μ1 ' Σ-1μ1 2 2 1 1 -1 1 x ' Σ x μ2 ' Σ x μ 2 ' Σ-1μ 2 ln(k ) 2 2 1 μ1 ' Σ x μ 2 ' Σ x μ1 ' Σ -1μ1 μ 2 ' Σ -1μ 2 ln(k ) 2 1 1 1 (μ1 μ 2 ) ' Σ x (μ1 μ 2 ) ' Σ-1 (μ1 μ 2 ) ln( k ) 2 1 MAXIMIZACIÓN SOBRE POBLACIONES NORMALES En la mayoría de las situaciones prácticas se desconocen los parámetros 1, 2 y por lo que se sustituyen por ( x1 , x 2 , S ) ( n1 1)S1 ( n2 1)S 2 S n1 n2 2 Si la matriz de cuasivariaza muestral obtenida de la población i-esima Con lo que la regla de decisión queda: c(1 2) p2 1 1 R1 : x1 x 2 ´S x o x1 x 2 ´S x1 x 2 ln c(2 1) p1 2 1 Ejemplo Los responsables de una empresa, estudian la planificación de la estrategia publicitaria para el año 2014. Se piensa que hay relación entre los resultados de una empresa y su estrategia de comunicación. Se dispone de un estudio en que figura información sobre 35 empresas competidoras, de las que 18 se puede decir que tuvieron resultados malos, mientras que las 17 restantes tuvieron aceptables. Las variables que se tienen en cuenta son: X1 = Duración en días de las actividades publicitarias (Publicidad) X2 = Duración en días de las actividades promocionales (Promoc) X3 = Incremento anual en presupuesto publicitario (inc_publ) X4 = Incremento anual en el presupuesto promocional (inc_prom) X5 = Inversión en patrocinio (Patrocinio). Se estima que la probabilidad a priori de que una empresa tenga resultados aceptables es idéntica a la de que obtenga resultados bajos. Se supone que todos los datos siguen una ley Normal multivariante Ejemplo RESULTAD PROMOCIO PUBLICID INC_PROM INC_PUBL PATROCIN 01 01 01 01 01 01 01 01 01 01 01 01 01 01 01 01 01 01 02 02 02 02 02 02 02 02 02 02 02 02 02 02 02 02 02 156 154 153 155 157 155 158 158 157 158 155 156 160 157 162 155 159 159 159 164 160 161 163 160 165 162 159 159 162 163 163 161 162 162 164 245 240 240 243 238 239 238 240 245 244 240 240 242 245 239 243 242 238 238 248 244 246 246 250 245 243 245 247 252 249 242 245 247 245 248 32 30 32 32 31 33 31 31 32 31 31 32 33 32 30 31 31 32 32 33 31 32 33 32 33 32 32 31 32 33 31 32 32 33 32 19 18 18 19 18 19 19 19 19 19 18 18 19 20 18 19 18 18 18 19 19 19 19 19 20 19 19 18 19 20 18 19 19 19 19 21 20 21 20 20 21 22 22 20 22 21 21 22 21 23 21 21 20 20 21 21 22 22 23 23 21 22 19 22 23 21 21 20 21 21 Ejemplo Los vectores de medias para todas las observaciones y para cada grupo son respectivamente: 159.23 156.89 161.71 243.46 241.17 245.88 X 31.80 X 1 31.50 X 2 32.12 18.77 18.61 18.94 21.20 21.06 21.35 Y las matrices de varianzas covarianzas: 5.16 S1 0.57 0.29 1.12 6.16 0.50 0.95 0.19 0.74 0.21 0.15 0.37 0.08 0.76 0.45 0.20 0.27 4.34 8.31 0.51 0.88 17 S1 16S2 S 0.61 0.23 33 0.34 0.01 3.47 S2 0.94 0.59 0.11 0.26 0.99 1.53 0.72 0.54 10.49 0.51 0.81 0.49 0.26 0.31 0.74 1.42 0.39 0.46 1.24 EJEMPLO 0.29 1 S 0.01 0.16 4.82 4.71 ( X 1 - X 2 ) 0.62 0.63 0.30 0.05 0.01 0.27 0.04 0.47 0.016 2.23 1.75 0.23 6.28 1.18 1.54 318.6 487.05 ( X 1 X 2 ) 63.52 1 ( X X )' S -1.32 1 2 37.55 42.4 0.69 0.81 1 ( X 1 X 2 ) ' S 1 ( X 1 X 2 ) -352.53 2 Regla de clasificacion: Si -1.32 x1 0.69 x2 0.81x3 1.63x4 1.01x5 352.53 x ( x1 ,..., x5 ) R1 1.63 1.01 EJEMPLO Asignar la observación (156 240 19 20 21) Regla de clasificacion: Si -1.32 x1 0.69 x2 0.81x3 1.63x4 1.01x5 352.53 -1.32(156) 0.69(240) 0.81(19) 1.63(20) 1.01(21) 333.1 352.53 por lo que se asigna al grupo de los resultados malos MAXIMIZACIÓN SOBRE POBLACIONES NORMALES caso de dos poblaciones con varianzas distintas c(1 2) p2 f1 ( x ) R1 : ln f2 ( x) c(2 1) p1 1 1 1 exp x μ ' x μ 1 1 1 1/ 2 2 (2 ) p / 2 Σ1 k 1 1 1 exp x μ ' x μ 2 2 2 1/ 2 p/2 2 (2 ) Σ2 1 Σ2 1 1 1 1 1 1 1 1 ln x´ Σ Σ x μ ' Σ μ ' Σ x ' ' 2 1 2 1 1 2 2 1 1 1 2 2 2 ln( k ) 2 Σ1 2 1 x´ Σ11 Σ 21 x μ 1'Σ11 μ 2'Σ 21 x k ' 2 Solución cuadrática MAXIMIZACIÓN SOBRE POBLACIONES NORMALES caso de dos poblaciones con varianzas distintas MEDIDAS INDEPENDIENTES DE LA DISTRIBUCIÓN DE LA POBLACIÓN APER: Se define como el porcentaje de observaciones de la muestra que se encuentran mal clasificadas n1, M n2, M Estim. G1 Estim.g2 ˆ E ( APER ) n1 n2 G1 n1B n1M G2 n2M n2B Problema: sobre estimación de los resultados Soluciones •Partición de la muestra. •Método de Lachenbruch (validación cruzada). BONDAD DE AJUSTE Para justificar el análisis, su método de predicción debe ser mejor que la mera distribución al azar. Es decir esperamos que los errores cometidos tras el análisis discriminante sean menores que los que se cometerían al azar: N E ( APER) N (aciertos al azar) 2 2 18 17 E (aciertos al azar)=N(p12 p22 ) 35 17.51 35 35 EJEMPLO Observación perteneciente al Clasificada como Grupo1 Grupo 2 18 0 2 15 Grupo 1 Grupo 2 02 2 E ( APER) 0.057 17 18 35 2 2 18 17 E (aciertos al azar)=N(p p ) 35 17.51 35 35 2 1 2 2 N E ( APER) N (aciertos al azar) 35 0.057 =1.995 < 35-17.51=17.49 Discriminación cuando q>2 P k | x pk f k (x ) g p i 1 i f i( x ) Asignar x a k si: pkfk (x) pifi(x) para todo ik Todo lo visto para el caso de q=2 se repite para la situación q>2 REGLA DE CLASIFICACIÓN SUPONIENDO NORMALIDAD Si f i (x) 1 (2 ) p / 2 Σ 1/ 2 1 exp x μ i Σ´ 1 x μ i para i=1,2,…,q 2 La regla anterior se convierte (tomando logaritmos): Asignar x a la clase k si: 1 1 p ln pk f k ( x ) ln pk ln( 2 ) ln Σ k x μ k 'Σ k1 x μ k max ln pi f i ( x ) i 2 2 2 p donde la constante 2 ln( 2 ) puede ignorarse al valer lo mismo para todas las clases. Por lo que la función a optimizar será d iQ (x) ln pi 12 ln i 12 x μ i 'Σi1 x μ i REGLA DE CLASIFICACIÓN SUPONIENDO NORMALIDAD d iQ (x) ln pi 12 ln i 12 x μ i 'Σi1 x μ i Simplificación si suponemos que las matrices de covarianzas poblacionales son iguales (i = para todo i). di ( x) ln( pi ) μ'i Σ1x 12 μ'i Σ1μi Donde Σ se estima por S i 1,2,..., q ( n1 1) S1 ( n2 1) S 2 ... ( n g 1) S g n1 n2 ... n g g Ejemplo: Vamos a determinar las reglas discriminantes basadas en unos datos obtenidos para q=3 grupos suponiendo distribución bivariante normal con matriz de covarianzas común. Se obtuvieron las siguientes muestras aleatorias de las poblaciones 1, 2 y 3 2 5 1 1 1 1 : X 1 0 3, por lo que n1 3, x1 , y S1 3 1 4 1 1 0 6 1 1 1 2 : X 2 2 4 , por lo que n 2 3, x 2 , y S 2 4 1 4 1 2 1 2 0 1 1 3 : X 3 0 0 , por lo que n 3 3, x 3 , y S 3 2 1 4 1 4 Se conocen las probabilidades a priori: p1=p2=0.25, p3=0.5 Queremos clasificar en uno de esas 3 clases o grupos a la observación: x’o=(x01,x02)=(-2,-1). 1 1 1 1 1 1 2 2 2 1 4 1 4 1 4 1 ( n 1) S1 ( n2 1) S 2 ( n3 1) S 3 S 1 1 n1 n2 n3 3 3 3 33 3 S 1 1 36 3 35 3 9 13 4 36 3 x1 1 36 1 ˆ d ( x ) ln( 0 . 25 ) 1 , 3 1 , 3 1 35 2 3 9 x 2 3 36 3 x1 1 36 dˆi ( x ) ln( pi ) x i'S 1 x 12 x i'S 1 x i dˆ2 ( x ) ln( 0.25) 1,4 351 2 1,4 3 9 x 2 3 36 3 x1 1 36 1 ˆ d ( x ) ln( 0 . 5 ) 0 , 2 0 , 2 3 35 x 2 3 9 2 3 3 1 9 3 3 1 9 4 3 0 9 2 99 99 27 24 27 24 dˆ1 ( x ) ln( 0.25) dˆ1 ( x0 ) ln( 0.25) 1.943 x1 x2 ( 2) ( 1) 35 35 70 35 35 70 204 204 48 39 48 39 dˆ2 ( x ) ln(0.25) x1 x2 dˆ2 ( x0 ) ln(0.25) ( 2) ( 1) 8.158 70 70 35 35 35 35 36 36 6 18 6 18 dˆ3 ( x ) ln( 0.5) dˆ3 ( x0 ) ln( 0.25) 0.35 x1 x2 ( 2) ( 1) 70 70 35 35 35 35 como dˆ3 ( xo ) es el mayor de los tres, xo queda asignada a la clase 3. Validación de las funciones discriminantes Test estadístico de idoneidad del análisis discriminante: Nº observaciones bien clasificas al azar clase k ˆ ) ek n( p 2 k nk ˆk donde p n ok nkk Z (ok ek ) ek ek 1 nk Observaciones bien clasificadas por la regla discriminante para la clase k Z se distribuye según una Normal(0,1) si no se produce mejora. El test anterior también sirve para la totalidad, donde: o ok k e ek k Z ( o e) e e 1 n Validación de las funciones discriminantes INDICE DE SIGNIFICACIÓN PRÁCTICA o e oe n n ISP e ne 1 n Representa la mejora de la proporción de observaciones acertadas de la clasificación mediante análisis discriminante con respecto al conseguido al azar. ISP<0.25 Desechable el análisis discriminante 0.25<ISP<0.50, Aceptable pero mejorable. 0.50ISP Buena regla discriminante EJEMPLO BONDAD AJUSTE Indice de significación práctica o e oe n n ISP e ne 1 n Utilizando método de resustitución Clasificada como: Grupo Grupo Perteneciente al: 1 2 Grupo 1 Grupo 2 18 2 0 15 Buena regla discriminante 33 17.5 33 17.5 35 35 ISP 0.886 17.5 35 17.5 1 35 EJEMPLO BONDAD AJUSTE Indice de significación práctica Utilizando el método de Validación cruzada, se obtiene el siguiente resultado o e oe n n ISP e ne 1 n Clasificada Grupo 1 como: Grupo 2 Perteneciente al: Grupo 1 Grupo 2 16 3 2 14 Buena regla discriminante 30 17.5 30 17.5 35 35 ISP 0.714 0.5 17.5 35 17.5 1 35 EJEMPLO BONDAD AJUSTE Test de idoneidad: Z Clasificada como: Grupo Grupo Perteneciente al: 1 2 (ok ek ) nk Grupo 1 Grupo 2 ek nk ek emp. res. bajos: (18 35(0.25)) 18 18 18 8.75 emp. res. aceptables total empresas: (33 35(0.5)) 35 33 35 17.5 0 15 9.25 18 3.04, pvalor 0.0012 12.90 (15 35(0.25)) 17 15 17 8.75 18 2 6.25 17 2.32, pvalor 0.0102 11.12 15.5 35 3,81 pvalor 0.00007 24.03 EJEMPLO BONDAD AJUSTE Test de idoneidad: Z (ok ek ) nk ek nk ek o1 =16 Utilizando el método de Validación cruzada, se obtiene el siguiente resultado Clasificada Grupo 1 Grupo como: 2 Perteneciente al: Grupo 1 Grupo 2 o2 =14 o=30 e1=8.75 e2=8.75 16 3 2 14 e=17.5 (16 8.75) 18 7.25 18 emp. res. bajos: pvalor 0.0003 9 8.75 18 8.75 (14 8.75) 17 5.25 17 emp. res. aceptables pvalor 0.0054 8.496 8.75 17 8.5 total empresas: (30 17.5) 35 17.5 35 17.5 12.5 35 pvalor 0.00001 17.5 Si no se conocen las probabilidades a priori de cada grupo, y se ha obtenido la siguiente tabla de resultados tras llevar a cabo la asignación en un conjunto de datos suplementario. Clasificada como Grupo 1 Grupo 2 Grupo 3 Pertenecientes a: 25 10 15 Grupo 1 10 90 0 Grupo 2 5 5 40 Grupo 3 ¿Es aceptable el análisis discriminante realizado? n1 50 p 0.25 1 n 200 n 100 Calculo indices: p2 2 0.5 n 200 n3 50 p 3 n 200 0.25 ISP 155 75 0.64 0.5 200 75 e1 200 p12 200 0.25 12.5 2 e2 200 p22 200 0.50 50 2 e 75 e3 200 p32 200 0.25 12.5 2 25 12.5 0.33 SOLO ACEPTABLE 50 12.5 90 50 ISP2 0.8 MUY VALIDA 100 50 40 12.5 ISP3 0.73 MUY VALIDA 50 12.5 ISP1 CONCLUSIONES A.DISCRIMINANTE PREDICTIVO Regla simple lineal derivada bajo supuestos de normalidad multivariante e igualdad de covarianzas. Previamente deben chequearse las hipótesis. Si alguna o ambas de las suposiciones no se cumple es posible aplicar la reglas si se transforman las variables Regla de clasificación cuadrática, exige normalidad, no igualdad de varianzas para cada clase. Cuidado es sensible a la hipótesis de normalidad. • Tendremos tantas funciones (lineales o cuadráticas) como clases existan. (en el caso de q=2 se nos quedaría reducida a una) Funciones canónicas de Fisher El método de Fisher consiste en crear funciones canónicas discriminantes como combinación lineal de las variables discriminantes: y1 a1,1 x1 a1, 2 x2 ... a1, p x p a1 ' x y 2 a 2,1 x1 a 2, 2 x2 ... a 2, p x p a 2 ' x ym am ,1 x1 am ,2 x2 ... am , p x p am ' x ¿Cómo obtenemos los coeficientes ai,j ?. ¿Cuántas variables canónicas son necesarias? ¿Se pueden interpretar las variables canónicas?. DERIVACION DE LAS FUNCIONES CANÓNICAS El método se caracteriza a partir de los centroides de cada grupo Gi y del centroide general G con la métrica de Mahalanobis. DERIVACION DE LAS FUNCIONES CANÓNICAS Notación: xk ,i , j valor de la variable j para la observacion i-esima del grupo k x k,i x k ,i ,1 , xk ,i ,2, ,..., xk ,i , p vector de datos de la i-esima observ. del grupo k μ vector de medias de toda la poblacion ( μˆ x ) μk vector de medias grupo k μˆ k xk x k,i i 1 nk nk DERIVACION DE LAS FUNCIONES CANÓNICAS Queremos obtener la función discriminante: y1=a1’X que verifica E ( y1,k ) a1' μ k para el grupo k ' V ( y1,k ) a1Σa1 ' E ( y1 ) a1μ para la totalidad V ( y ) a ' Σa 1 1 1 Y que maximice la separación entre grupos DERIVACION DE LAS FUNCIONES CANÓNICAS DERIVACION DE LAS FUNCIONES CANÓNICAS La variabilidad entre los grupos para los valores de la función y1 será función de la suma de cuadrados de la distancia desde la media para cada clase hasta la media total. Es decir: ' ' n a μ a k 1 k 1μ g k 1 2 g a1' nk μ k μ μ k μ ' a1 a1' H μa1 k 1 El cociente entre dicha suma de cuadrados y la varianza de y1 mide la variabilidad entre los grupos relativa a la variabilidad común entre grupos a1' Hμa1 a1' Hμ a1 Max Max ' V ( y1 ) a1 Σa1 DERIVACION DE LAS FUNCIONES CANÓNICAS a1' Hμa1 a1' Hμ a1 Max Max ' V ( y1 ) a1 Σa1 g g Nuestro problema será estimar Σ y H μ nk E nk 1 Sk x k ,i xk x k ,i xk ' k 1 ˆ Σ k 1 i 1 E E n1 n2 ... ng g N g g H nk x k x x k x ' k 1 DERIVACION DE LAS FUNCIONES CANÓNICAS aˆ ' Haˆ aˆ 1' Haˆ 1 1 1 Max ' Max ˆ aˆ 1Σaˆ 1 aˆ 1' E aˆ 1 ng aˆ 1' Haˆ 1 Max ' 1 aˆ 1Eaˆ 1 aˆ 1' Haˆ 1 ' aˆ 1Eaˆ 1 2Haˆ 1 (aˆ 1' Eaˆ 1 ) 2Eaˆ 1 (aˆ 1' Haˆ 1 ) ' ' ˆ ˆ ˆ ˆ ˆ ˆ 0 Ha ( a Ea ) Ea ( a 1 1 1 1 1Ha1 ) 2 ' ' aˆ 1 aˆ 1Eaˆ 1 E1Haˆ 1 aˆ 11 a ˆ 1 autovector de E-1H S-1 Haˆ 1 ˆ1aˆ 1 Haˆ 1 ˆ1 N g aˆ 1 Ng DERIVACION DE LAS FUNCIONES CANÓNICAS Con el resto de autovectores de la matriz E-1H ordenádos de forma decreciente según sus autovalores se forman el resto de variables canónicas Los coeficientes de êi se denominan coeficientes raíces y se pueden utilizar para clasificar los datos. No son interpretables ya que no tiene restricciones sobre el origen ,y los grupos se podrían localizar en cualquier parte del espacio. Por ello los tendremos que normalizar utilizando la métrica generada por la matriz de Varianzas-Covarianzas. A estos nuevos coeficientes se les denomina coeficientes raices ajustados. Aparecen en SAS como raices (raw). EJEMPLO 1 x 1 3 2 5 0 6 1 2 1 X 1 0 3 ; X 2 2 4 ; X 3 0 0 ; por lo tanto : x 2 y 4 1 1 1 2 1 4 0 x 3 2 0 x 5 3 1 1 0 H 3x i x x i x ' 3 1, 43 1, 73 0, 311 7 4 i 1 3 113 3 3 4 / 3 1 7 / 3 0 0 6 3 1 3 4 / 3 16 / 9 7 / 3 49 / 9 0 121 / 9 3 62 1 1 0 E x i,j x i x i,j x i ' ( 1,2) (1,0) (0,2) i 1 j 1 0 2 2 3 ni 1 1 1 0 0 1 ( 1,2) (1,0) (0,2) ( 1,0) (0,2) ( 1,2) 2 0 0 2 2 2 1 2 1 0 0 0 1 0 0 0 1 2 6 2 2 2 4 0 0 0 4 0 0 0 4 2 4 2 24 EJEMPLO 1 E 1 40 24 2 ; E1H 2 6 1 40 24 2 6 3 1 150 196 ; 2 6 3 62 40 30 378 196 1 150 0 Los autovalores de esta matriz salen de resolver: 378 40 30 1 2.8671 2 0.9044 0.615 0.993 eˆ1 , eˆ2 0.789 0.118 c1 eˆ1 ' S 1eˆ1 0.632 Normalizandolo (a’Sa=1) o sea multiplicarlos por c2 eˆ2 ' S 1eˆ2 0.998 aˆ 1 0.386, 0.495 aˆ 2 0.938, 0.112 yˆ1 0.386 x1 0.495 x2 las funciones canónicas yˆ 2 0.938 x1 0.112 x2 INTERPRETACION Si se quiere conocer la importancia relativa de la variable, necesitamos mirar a los coeficientes estandarizados. c , j a , j E j, j Ng Los coeficientes estandarizados sirven para determinar que variables contribuyen más a determinar los valores de la función canónica, examinando la magnitud de los coeficientes estandarizados (ignorando el signo). A mayor magnitud, mayor es la contribución de la variable. En el ejemplo: 6 c11 0.386 0.386 c12 0.495 aˆ 0.386, 0.495 6 1 6 aˆ 2 0.938, 0.112 c21 0.938 0.938 c12 0.112 6 24 0.990 6 24 0.224 6 INTERPRETACION: COEFICIENTES ESTRUCTURALES Para conocer que funciones se relacionan con las variables (explicando la variabilidad dentro de las clases) necesitamos los coeficientes estructurales: p s 'j , j ' 1 E j , j 'c , j ' E j , j E j ', j ' p rj , j 'c , j ' j ' 1 s 'j , coeficiente de estructura para la variable x j , y la función y (dentro de los grupos). ' rj , j ' coeficiente de correlación dentro de los grupos entre variables j ,j'. c coeficiente estandarizado de la función canónica para la variable j. ,j Los coeficientes de estructura son simples correlaciones bivariantes que no se ven afectadas por la relación de las demás variables como ocurre con los coeficientes estandarizados INTERPRETACION: COEFICIENTES ESTRUCTURALES p s ' j , j ' 1 E j , j 'c , j ' E j , j E j ', j ' p s1,1 r1, j 'c1, j ' j ' 1 s2,1 r2, j 'c1, j ' j ' 1 p s1,2 r1, j 'c2, j ' j ' 1 s2,2 r2, j 'c2, j ' j ' 1 rj , j 'c , j ' j ' 1 En el ejemplo que arrastramos, determinamos esos coeficientes 2 (1)0.386 0.990 0.221 6(24) p p p 2 0.386 (1)0.990 0.925 6(24) 2 (1)0.938 ( 0.224) 0.975 6(24) 2 0.938 (1)( 0.224) 0.380 6(24) Numero de funciones discriminantes las funciones discriminantes con mayores autovalores son más poderosas Los autovalores no tienen una interpretación directa aunque cada uno de ellos presenta una relación de magnitud relativa, y pueden compararse Si los autovalores de E-1H son: ˆ1 9.66, ˆ2 1.58 y ˆ3 0.05 la primera función canónica tiene un poder discriminante 180 veces mayor que la 3ª Esta información no es suficiente y deberemos utilizar otras herramientas CORRELACIÓN CANÓNICA r * ˆ ˆ 1 Los coeficientes de correlación canónica se interpretan como: 1) Medidas de asociación entre las variables explicativas (discriminantes) y el conjunto de g variables dicotómicas (1,0) que identifica la pertenencia a un grupo. La 1ª función canónica representaría la combinación de variables originales mas correlacionada con los grupos. 2) (ri*)2 se interpreta como la proporción de variación en la función discriminante explicada por los grupos. Proviene del ANOVA, con los grupos como valores de una variable independiente y la función canónica es la variable respuesta rα* determina la utilidad de la función discriminante yα CORRELACIÓN CANÓNICA r* ˆ ˆ 1 En el ejemplo que venimos desarrollando: 1 2.8671 2 0.9044 2.8671 r 0.7414 3.8671 * 1 0.9044 r 0.4749 1.9044 * 2 r 0.74142 0.5497 *2 1 r 0.47492 0.2255 *2 2 Discriminación residual Es la habilidad de las variables par discriminar entre los grupos más allá de la información que ha sido extraída mediante el computo de las funciones discriminantes. s 1 ˆ ' 1 1 ' s min( g 1, p ) es el número de funciones discriminantes a retener El estadístico que indica la significación de la lamda de wilks es: g p 2 2 N 1 ln se distribuye como ( p )( g 1) 2 SAS utiliza la aproximacion de la lambda a una F: 1- F= k ' DISCRIMINACIÓN RESIDUAL La forma de actuar para determinar el número α de funciones a retener será el siguiente: Calcular 0 ¿es significativo? no Las variables no son discriminantes si Calcular 1 ¿es significativo? no Sólo una función canónica si Calcular 2 Se repite el proceso hasta que para un alfa no sea significativo... NUMERO DE FUNCIONES A RETENER EJEMPLO Calculo de 0 : Consideraremos contraste a nivel 0.05 1 1 1 1 0 0.135786 1 1 1 2 1 2.8671 1 0.9044 pg 2 3 ln( ) 9 1 0 ln(0.135786) 10.98 2 2 PROB( (22 0)(301) 10.98) 0.026 2 N 1 Deducimos que hay significación estadística 1 1 Calculo de 1 : 1 0.91706 1 2 1 0.9044 pg ln( 1 ) 5.5 ln(0.91706) 0.476 2 PROB( (22 1)(311) 0.476) 0.49 2 N 1 Sólo retenemos una función canónica ASIGNACIÓN DE OBSERVACIONES UTILIZANDO LAS FUNCIONES CANÓNICAS Supongamos que se han retenido s funciones que en notación vectorial serán k , y1 a1' μ k y1 ' y k , y2 a 2 μ k 2 con vector de medias k,Y = para la población k Y ' ' y a a μ i i x i 1,..., s y s k , ys s k Una medida apropiada de distancia al cuadrado de Y=y para ikY es: y μ 'y μ y s k ,Y k ,Y j 1 j k , y j 2 La regla consistiría en asignar la observación cuya proyección es y(o) a la población k’ si la distancia al cuadrado desde y(o) a k’,y es la menor de todas las distancias de y(0) a k,y para kk’. EJEMPLO ASIGNACIÓN OBSERVACIONES CON FUNCIONES CANÓNICAS Las funciones discriminantes para un ejemplo anterior eran: yˆ 1 0.386 x1 0.495 x 2 supongamos que queremos clasificar una observación x0=(1,3). yˆ 2 0.938 x1 0.112 x 2 Los pasos a seguir son: a) Determinación de los centroides de cada uno de los grupos en el espacio canónico: 1 ˆ y a ( x x ) 0.386, 0.495 1,1 1 1 3 5 / 3 0.274 1 y aˆ ( x x ) 0.938, 0.112 1 1.087 2 1 3 5 / 3 1,2 1 ˆ y a ' ( x x ) 0.386, 0.495 2,1 1 2 4 5 / 3 1.540 2 y aˆ '( x x ) 0.938, 0.112 1 0.677 2 2 4 5 / 3 2,2 0 ˆ y a ' ( x x ) 0.386, 0.495 3,1 1 3 2 5 / 3 1.815 3 0 y aˆ '( x x ) 0.938, 0.112 2 3 2 5 / 3 0.413 3,2 EJEMPLO ASIGNACIÓN OBSERVACIONES CON FUNCIONES CANÓNICAS Las funciones discriminantes para un ejemplo anterior eran: yˆ 1 0.386 x1 0.495 x 2 supongamos que queremos clasificar una observación x0=(1,3). yˆ 2 0.938 x1 0.112 x 2 Los pasos a seguir son: b) Proyectar la observación en el espacio canónico (determinaryˆ j ( x 0 ) ) para j=1,2. En primer lugar hay que obtener los valores de la observación corregidos por la gran media, es decir: 1 0 1 3 5 / 3 4 / 3 y ahora sustituimos en la función canónica ajustada: yˆ1 ( x0 ) 0.386 x1,0 0.495 x2,0 yˆ1 ( x0 ) 0.386 (1) 0.495 (4 / 3) 1.046 yˆ 2 ( x0 ) 0.938 x1,0 0.112 x2,0 yˆ 2 ( x0 ) 0.938 (1) 0.112 (4 / 3) 0.789 EJEMPLO ASIGNACIÓN OBSERVACIONES CON FUNCIONES CANÓNICAS Las funciones discriminantes para un ejemplo anterior eran: yˆ 1 0.386 x1 0.495 x 2 supongamos que queremos clasificar una observación x0=(1,3). yˆ 2 0.938 x1 0.112 x 2 Los pasos a seguir son: yˆ1 ( x0 ) 1.046 yˆ 2 ( x0 ) 0.789 y1,1 0.274 y1,2 1.087 1 y2,1 1.540 y3,1 1.815 3 y2,2 0.677 y3,2 0.413 2 c) Calculamos la distancia al cuadrado desde el punto proyectado de la observación a clasificar a cada uno de los centroides del espacio canónico. al centroide de 1 : yˆ j ( x0 ) y1, j 1.046 0.274 0.789 1.087 4.115 2 2 2 2 j 1 al centroide de 2 : yˆ j ( x0 ) y2, j 1.046 1.540 0.789 0.677 0.257 2 2 2 2 j 1 al centroide de 3 : yˆ j ( x0 ) y3, j 1.046 1.815 0.789 0.413 8.327 2 2 2 2 j 1 luego la menor distancia se produce con respecto a 2 clase a la cual se asigna la observación. IMPORTANCIA DISCRIMINANTE DE UNA VARIABLE La importancia relativa de cada variable se determina a partir de su Indice de Potencia,: s 0.221 s 0.925 s 0.975 s 0.380 1,1 Pj 1 k s 2 s j , 2,1 1,2 2,2 1 2.8671 2 0.9044 Suponiendo que hubiéramos escogido dos funciones discriminantes: y teniendo en cuenta los valores de los coeficientes estructurales y de los autovalores tendríamos: Px1 1 k 2.8671 0.9044 2 2 (0.221) (0.975) 0.368 s1, 2.8671 0.9044 2.8671 0.9044 Px 2 1 k 2.8671 0.9044 2 2 (0.925) ( 0.3080) 0.673 s2, 2.8671 0.9044 2.8671 0.9044 s s OTROS ESTADISTICOS MULTIVARIANTES UTILIZADOS EN SAS 1 Lambda de Wils = det(E)/det(H+E) = = s i s 11 i la distribución sigue una ley F sobre el estadístico: 1 1 / t rt 2u F pq,rt 2u 1/ t pq Donde q min( g 1, p) r N g ( p q 1) 2 u ( pq 2) / 4 2 2 ( p q 4) 2 2 t si ( p q 5) 0 y 2 2 ( p q 5) t=1 en otro caso OTROS ESTADISTICOS MULTIVARIANTES UTILIZADOS EN SAS 1 Traza de Pillai V= traza(H(H + E) ) = k 1 k -1 2n s 1 V , sigue una ley Fs(2m+s+1),s(2n+s+1) 2m s 1 1 V ( N g p 1) n 2 donde m 0.5(| p g 1 | 1) s min( p, g 1) OTROS ESTADISTICOS MULTIVARIANTES UTILIZADOS EN SAS -1 Traza de Hotelling-Lawley U= traza(E H) = k k 2( sn 1)u sigue una ley Fs(2m+s+1), 2(sn+1) 2 s (2m s 1) -1 Mayor autovalor de Roy (mayor autovalor de E H) 1 OTROS ESTADISTICOS MULTIVARIANTES UTILIZADOS EN SAS R2 parcial. Se calcula como R 2 partial ( j ) 1 ( j) donde ( j) es la lambda de Wilks que resulta al eliminar la variable j-esima. 1 / i N g p(en el mod elo) Fi / i g 1 sirve para contrastar la igualdad de las k-medias para Yi cuando el resto de variables están parcializadas. VARIABLES EXPLICATIVAS Xj CUALITATIVAS Existen varias soluciones: • Creación de variables ficticias binarias (dummy) 0, 1. De cada valor posible de la variable cualitativa se crea una variable que toma el valor 1 si la observación participa de esa característica y 0 si no participa. Si una variable cualitativa posee w categorías serán necesarias w-1 variables. • Obtención de Factores a través de análisis de correspondencias múltiples (sobre la tabla disyuntiva completa) que se tratarán como variables continuas. • Análisis logit. • Arboles de clasificación y regresión (CART y CHAID) • REDES NEURONALES SELECCIÓN DE VARIABLES DISCRIMINANTES Es la elección de un subconjunto de variables que de forma conjunta más discriminen. Eliminación de aquellas que no discriminen Eliminación de las que proporcionen una información redundante. Métodos de selección de variables MÉTODOS DE SELECCIÓN DE VARIABLES Procedimiento Forward Procedimiento Backward Procedimiento Stepwise Se inicia sin ninguna variable en el modelo, y se van incluyendo a través de su significación tras un análisis ANCOVA (salvo en el primer paso que es un ANOVA) Se inicia incluyendo todas las variables. Después se realizan análisis ANCOVA eliminando la variable menos significativa Combinación de ambas soluciones partiendo de 0 variables incluidas en el modelo EJEMPLO: SELECCIÓN DE VARIABLES .Metodo Forwad P-valor máximo para incluir una variable= 0.15 The STEPDISC Procedure Forward Selection: PASO 1 Statistics for Entry, DF = 1, 33 Variable promocion publicidad inc_prom inc_publi patrocinio R-Square F Value Pr > F Tolerance 0.5860 0.4148 0.1413 0.0783 0.0230 46.71 23.39 5.43 2.80 0.78 <.0001 <.0001 0.0260 0.1036 0.3844 1.0000 1.0000 1.0000 1.0000 1.0000 La variable PROMOCION entra en el subconjunto TOLERANCE = 1- Correlación multiple al cuadrado con las variables que ya se encuentran en el modelo. EJEMPLO: SELECCIÓN DE VARIABLES .Metodo Forward Paso 2 Variable publicidad inc_prom inc_publi patrocinio Partial R-Square F Value Pr > F Tolerance 0.1911 0.0277 0.0003 0.0705 7.56 0.91 0.01 2.43 0.0097 0.3471 0.9219 0.1292 0.7195 0.8699 0.8763 0.8381 Entra la variable publicidad R2 parcial. Se calcula como R 2 partial ( j ) 1 ( var inclu+j) ( variab inclui ) 2 R parcial N g p 1 F F-valor, se obtiene como sus grados de libertad son: por tanto: 2 1 R parcial g 1 numerador : g-1 denominador: N-g-p+1 (se pueden considerar g.l.error) EJEMPLO: SELECCIÓN DE VARIABLES .Metodo Forward Paso 3 Statistics for Entry, DF = 1, 31 Variable inc_prom inc_publi patrocinio R-Square 0.0033 0.0583 0.1029 Partial F Value Pr > F 0.10 1.92 3.56 Entra la variable patrocinio 0.7490 0.1757 0.0687 Tolerance 0.6687 0.5560 0.6426 EJEMPLO: SELECCIÓN DE VARIABLES.Metodo Forward Paso 4 Statistics for Entry, DF = 1, 30 Partial Variable R-Square F Value Pr > F inc_prom inc_publi 0.0057 0.0158 0.17 0.48 0.6812 0.4924 Tolerance 0.6246 0.5409 No Entra ninguna variable La solución que nos proporciona este método es elegir las variables: promoción, publicidad y patrocinio EJEMPLO: SELECCIÓN DE VARIABLES.Metodo Forwad Resumen: Average Square Number Step Entered 1 2 3 Partial R-Square promocion publicidad patrocinio 0.586 0.191 0.103 F Value Pr > F 46.71 7.56 3.56 <.0001 0.0097 0.0687 Wilks' Lambda 0.4139 0.3344 0.3004 Pr < Lambda. <.0001 <.0001 <.0001 Canonical Correlation 0.58602 0.66515 0.69962 La solución que nos proporciona este método es elegir las variables: promoción, publicidad y patrocinio EJEMPLO: SELECCIÓN DE VARIABLES. Método backward Paso 1 Backward Elimination: Step 1 Statistics for Removal, DF = 1, 29 Variable promocion publicidad inc_prom inc_publi patrocinio Sale inc_prom R-Square Partial F Value Pr > F 0.4603 0.2197 0.0224 0.0324 0.0513 24.73 8.17 0.66 0.97 1.57 <.0001 0.0078 0.4215 0.3327 0.2206 EJEMPLO: SELECCIÓN DE VARIABLES. Método backward Paso 2 Statistics for Removal, DF = 1, 30 Variable promocion publicidad inc_publi patrocinio R-Square Partial F Value Pr > F 0.4847 0.2173 0.0158 0.0624 28.22 8.33 0.48 2.00 <.0001 0.0072 0.4924 0.1678 Sale inc_publi EJEMPLO: SELECCIÓN DE VARIABLES. Método backward Paso 3 Statistics for Removal, DF = 1, 31 Variable promocion publicidad patrocinio R-Square Partial F Value Pr > F 0.4866 0.2194 0.1029 29.38 8.71 3.56 <.0001 0.0060 0.0687 No sale ninguna. Todas aportan discriminación suficiente ANALISIS MULTIVARIANTE I TEMA 3: ANALISIS DISCRIMINANTE ESCUELA UNIVERSITARIA DE ESTADÍSTICA UNIVERSIDAD COMPLUTENSE DE MADRID