UNIVERSIDAD NACIONAL

AUTÓNOMA DE HONDURAS EN EL

VALLE DE SULA

Carrera de Ingeniería Industrial

Asignatura de Investigación de Operaciones II

Cadena de Markov

Evelyn Yadira Cruz Ramos

Número de Cuenta: 20082000127

Sección: 14:00

SPS, Febrero 3 de 2022

6

Tabla de contenido

Introduccion....................................................................................................................................... 1

Cadena de Markov .........................................................................................................................................2

Conceptos Basicos ......................................................................................................................................2

Concepto Cadena de Markov .....................................................................................................................3

Clasificacion de los estados de Cadena de Markov………………………………………………………………………………..4

Conclusiones……………………………………………………………………………………………………………………………………….5

Bibliografia……………………………………..………………………………………………………………………………………………….6

Anexos………………………………………………………………………………………………………………………………………………..7

Ejemplo………………………………………………………………………………………………………………………………………………9

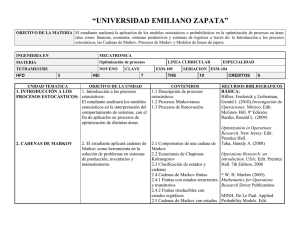

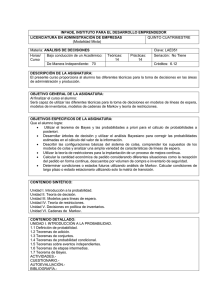

Introducción

A menudo nos encontramos en situaciones de toma de decisiones y con ellas incertidumbres de las

que debemos tener un panorama completo para determinar nuestras acciones. Precisamente para que

estas decisiones sean las más adecuadas nos debemos a ciertas herramientas, una de ellas es sobre

temas de probabilidad como es la Cadena de Markov pero antes de entrar en el tema como tal

conceptualizaremos términos previos para la comprensión y utilización de esta herramienta. El

estudio de este proceso consiste básicamente en conocer cómo cambia una variable de decisión con

respecto al tiempo.

1

Cadena de Makov

Conceptos básicos

Para comenzar esta investigación es importante aclarar algunos conceptos básicos como ser

Procesos Estocásticos el cual se refiere a la representación de valores aleatorios que irán

cambiando según pasa el tiempo o dicho en otras palabras para describir algunas variables que

evolucionan en función de otra variable Ver Figura 1.3. Podemos detallar ejemplo de ello los

siguientes casos:

1. Señales biomédicas como ser electrocardiograma o encefalograma.

2. Señales sísmicas

3. Señales de telecomunicación

Deducimos de los ejemplos anteriores que estos procesos son una serie de observaciones y dichos

valores no los podemos predecir exactamente pero podemos determinar las probabilidades para los

distintos valores posibles en cualquier tiempo.

Como segundo concepto tenemos la Matriz de probabilidad es otro concepto necesario de

explicar, esta es una matriz n x n que según Isaac Mosquera debe cumplir con dos condiciones:

1. Sus entradas son todas positivas

2. La suma de los componentes en cada columna es 1.

De manera que concluimos que dicha matriz solo cuenta con vectores que son positivos y suman 1

en total.

Espacio Muestral los podemos definir como el conjunto de valores resultado de un experimento

previo.

Variable Aleatoria es una función que asigna valores reales a los resultados de un experimento.

Estados: es una variable cuyos valores solo pueden pertenecer al conjunto de estados en el sistema.

El sistema modelizado por la cadena, por lo tanto, es una variable que cambia con el valor del

tiempo, cambio al que llamamos transición

2

Dicho esto podemos conceptualizar una Cadena de Makov como aquellos procesos estocásticos

discretos donde la descripción de las variables aleatorias depende del estado actual y no de los

anteriores es decir del evento inmediatamente anterior Ver Figura 1.2, fue nombrada así en honor

a Andrei A. Markov quien la desarrollo a mediados de 1900.

Esta cadena se puede utilizar para pronosticar el comportamiento de una variable, ejemplo de ellos

podrían ser: los cambios de preferencia que en el mercado tienen diferentes productos, la posible

decisión sobre hacer o no una inversión, es decir, que es aplicable en diferentes áreas desde

meteorológicas hasta economía. En el área operativa nos podría servir para los inventarios,

mantenimiento y flujos de procesos, en la simulación es utilizada para proveer soluciones analíticas

como ser la teoría de colas las cual se puede poner como ejemplo de esta cadena por mencionar

algunas.

Para la aplicación de esta cadena debemos tomar en cuenta que: “Los pasos posibles sean finitos y

que las probabilidades permanezcan constante con el tiempo” todo esto según Taibo, Amaro,

pag.72.

La probabilidad de transición en una etapa se puede se puede representar haciendo uso de un grafo

o como antes lo mencionamos con la matriz de transición de probabilidades. Ver Figura 1.1. Este

diagrama es un grafo dirigido a cuyos nodos son los estados, cuyos arcos se etiquetan con la

probabilidad de transición entre los estados que unen. Si esta probabilidad es nula no se colocaría

un arco.

Tomando el concepto anterior, dados los tiempos cronológicos 𝑡𝑜, 𝑡1 … . 𝑡𝑛 la familia de variables

aleatorias [𝑋𝑡 ₙ … 𝑋1 , 𝑋2 … 𝑋𝑛 ] es un proceso de Markov si:

P {𝑋𝑡 ₙ = 𝑋𝑛 |𝑋𝑡𝑛−1 = 𝑋𝑛−1,…..,𝑋𝑡𝑜 = 𝑋0} = P { 𝑋𝑡 ₙ = 𝑋𝑛 | 𝑋𝑡𝑛−1 (Taha, 2012, pag. 527)

Para mayor comprensión sobre esta herramienta de probabilidad podemos decir que si tuviéramos

un equipo de football que juega en un polideportivo que cuenta con 4 canchas y que las

probabilidades que ellos jueguen en una u otra cancha la podemos representar con la cadena de

Makov. Por lo que diríamos que si la primera semana nos toca jugar en la cancha 1 es posible que

3

la próxima semana toque jugar en la 2, en la 3, en la 4 o inclusive en la misma de esta semana, a

ese cambio de estado le llamaríamos probabilidades de transición la cual la representaríamos por

la matriz de probabilidad donde se representaría cada cambio de estado posible para cada semana

que transcurra a partir de la última cancha utilizada. Siempre con la intención de enriquecer esta

investigación debemos explicar a qué le llamamos una matriz estable esta es cuando la matriz no

genera cambios al realizarse alguna transición. Cualquier matriz superior a la matriz estable

podemos tener la certeza que serán estables.

Que una matriz se encuentre en estado estable nos puede llegar a decir el porcentaje de tiempo que

un elemento permanezca en cada estado, claro que esta interpretación dependerá que estamos

estudiando lo cual nos lleva a clasificar los estados de una cadena de Markov.

Clasificación de estados una cadena de Markov

1. Estado accesible: un lugar que accede a tener nuevos cambios y pasar a otro lugar o estado.

2. Estado recurrente o estable: es el que hace posible llegar desde cualquier estado a los demás

estados. En otras palabras si la probabilidad de ser revisitado desde otros estados es 1.

3. Estado transitorio: se llama así cuando después de haber entrado a este estado el proceso

nunca regresa a él.

4. Estado absorbente: se llama así cuando después de haber entrado ahí el proceso nunca saldrá

de él o de estar seguro que regresara ahí mismo en un movimiento.

Para determinar un estado estable debemos definir dos cosas importantes:

La matriz de transición P. Esta es un matriz cuadrada que tiene tantas posiciones como

estados tenga la cadena de Markov.

La posición o el paso inicial de la cadena. Este está determinado por el vector fila que tiene

tantas posiciones como estados tenga la cadena de Markov.

4

Conclusiones

1. La cadena de Markov nos permite tener un panorama más claro de cómo tomar una decisión

visualizando las probabilidades que un evento suceda independientemente de los eventos

pasados.

2. Los procesos de Markov son procesos estocásticos en los que el desarrollo futuro depende

solamente del estado actual del sistema.

3. La cadena de Markov está basado en probabilidades y puede ser utilizado en una gran

variedad de áreas ya que está orientado a evitar posibles problemas o de mejorar resultados.

5

Bibliografía

Mosquera, I. M. (2020). Obtenido de

http://blog.espol.edu.ec/adguale/files/2022/01/Proyecto_MARKOV_MM.pdf

TAHA, H. A. (2012). Investigacion de Operaciones. MEXICO: PEARSON EDUCACION.

Taibo, A. (2002). Investigacion de Operaciones para los no matematicos. Mexico: Instituto Politecnico

Nacional.

Winston, W. L. (S.F). Investigacion de Operaciones. Mexico: Thompson.

6

Anexos

Figura 1.1.

Grafo de probabilidad

Fuente:View Diagrama De Transicion Pics - Maesta (mapaestadosunidossmall.blogspot.com)

7

Figura 1.2

Ejemplo de una Cadena Markov

Fuente Procesos y Cadenas de Markov (slideshare.net)

Figura 1.3

La figura muestra un proceso estocástico donde X es el número de personas que hay en una cola

en el instante t.

Fuente: GONZÁLEZ VILLEGAS, L. T. Procesos de Markov. Ciencia pag.76. Maracaibo,

Venezuela: Red Universidad del Zulia, 1994

8

9