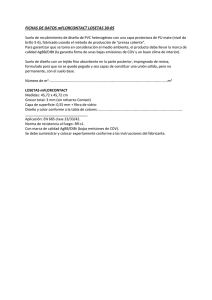

C u ad ro 1: R e su m e n d istrib u c ion e s n om b re p aram etros n

Anuncio

µ 2 R,

✓ > 0,

normal

gamma

>0

X ⇠ gamma(✓, )

)

X ⇠ exp( )

2

X ⇠ unif(a, b)

a, b 2 R, a < b

uniforme

X ⇠ N (µ,

continua

X ⇠ Poisson( )

>0

Poisson

>0

continua

X ⇠ BN(r, p)

r 2 N , p 2 (0, 1)

binomial

negativa

⇤

>0

discreta

X ⇠ geom(p)

p 2 (0, 1)

geométrica

exponencial

discreta

X ⇠ bin(n, p)

n 2 N , p 2 (0, 1)

binomial

⇤

continua

continua

discreta

discreta

discreta

X ⇠ Bernoulli(p)

p 2 (0, 1)

Bernoulli

[0, 1)

R

[0, 1)

[a, b]

{0, 1, 2, . . .}

{r, r + 1, . . .}

{1, 2, 3, . . .}

{0, 1, . . . , n}

{0, 1}

=

pX (1)

1

p

k

r

b

fX (x) =

e

x

x

a

[a,b] (x)

[0,1) (x)

(x µ)2

2 2

1

p

k

k r r

p

[0,1) (x)

1

e

2⇡

1

( x)✓

(✓)

fX (x) = p

fX (x) = e

fX (x) =

k!

1

p)n

p

p)

k

p)k

◆

1

(1

1

pX (k) = e

pX (k) =

✓

pX (k) = (1

✓ ◆

n k

pX (k) =

p (1

k

=

pX (0)

Cuadro 1: Resumen distribuciones

tipo

soporte

distribución

notación

parámetros

nombre

✓

µ

1

a+b

2

r

p

1

1

p

p

p)

p)

(b

2

✓

2

2

1

a)2

12

r(1 p)

p2

p2

np(1

p(1

varianza

np

p

esperanza

✓

✓

1

1

(1

t

t

◆✓

1

◆r

8t <

t

2 2

8t <

eta

a)

(et 1)

etb

t(b

e

pet

(1 p)et

pet

(1 p)et

p + pet )n

p + pet

eµt+ 2

1

f.g.m.

MA3403: Probabilidades y Estadística

Profesor Joaquín Fontbona T.

P. Aux. Luis Fredes

Semestre Otoño, 2015

Universidad de Chile

Facultad de Ciencias Físicas y Matemáticas

Departamento de Ingeniería Matemática

AUXILIAR 7: CAMBIOS DE VARIABLE Y OTROS

Método del Jacobiano: Sea X una variable aleatoria continua con función de densidad fX asumiendo

valores en GX , g una función biyectiva con g : GX ! G con inversa h, donde g y h son diferenciables e

Y = g(X), entonces

fY (y) = |Jh (y)|fX (h(y))

Esperanza.

Sean X v.a, se define

Propiedades.

(1)

(2)

(3)

(4)

8 X

<

x i · pi

E(X) = R i2I

:

x · fX (x)dx

caso discreto

caso continuo

Si

Si

Si

Si

X = ↵, entonces E(X) = ↵

X, Y son variables aleatorias, entonces E(↵X + Y ) = ↵E(X) + E(Y )

X 0, entonces E(X) 0

X v.a. y : R ! R, se tiene entonces

8 X

<

(xi ) · pi

caso discreto

E( (X)) = R i2I

:

(x) · fX (x)dx caso continuo

(5) Si X e Y son variables aleatorias independientes, entonces E(XY ) = E(X) · E(Y ).

Varianza. Si X e Y son variables, se define la varianza de X como:

V ar(X) = E((X

E(X))2 )

Propiedades.

(1) Si X = ↵, entonces V ar(X) = 0.

(2) V ar(↵X + ) = ↵2 V ar(X).

(3) Si X e Y son independientes, V ar(X + Y ) = V ar(X) + V ar(Y ).

Covarianza y Correlación. Sean X e Y dos variables aleatorias, se define covarianza y correlación respectivamente:

Cov(X, Y ) = E (X

⇢(X, Y ) = p

E(X)) · (Y

Cov(X, Y )

E(Y ))

V ar(X) · V ar(Y )

Propiedades.

(1) Cov(X, Y ) = Cov(Y, X).

(2) Cov(X + ↵Y, Z) = Cov(X, Z) + ↵Cov(Y, Z).

(3) Si X e Y son independientes, entonces Cov(X, Y ) = 0.

1

Esperanza Condicional. Sean X e Y dos variables aleatorias, se define la variables aleatoria (función de

Y)

8X

<

xi · P(X = xi |Y = y) caso discreto

E(X|Y = y) = i2I R

:

x · fX|Y (x|y)dx

caso continuo

Propiedad.

E(E(X|Y )) = E(X)

P1. (a) Sean (X1 , X2 ) v.a. conjuntamente continuas con densidad fX1 ,X2 . Calcule en función de f la

densidad del par de v.a. p12 (X1 + X2 , X1 X2 ). ¿Cuál es la interpretación geométrica de estas

nuevas variables? Deduzca que si (X1 , X2 ) son dos v.a. normales centradas reducidas (es decir,

con media 0 y varianza 1) independientes, entonces p12 (X1 + X2 , X1 X2 ) también lo son.

(b) Sean U1 , U2 v.a’s independientes, ambas con ley uniforme [0, 1]. Pruebe que las variables

aleatorias X1 , X2 definidas por

p

X1 :=

2 ln(U1 ) cos(2⇡U2 )

y

p

X2 :=

2 ln(U1 ) sin(2⇡U2 )

Son dos variables aleatorias normales centradas y reducidas independientes.

(c) Sabiendo que con un computador se puede generar v.a. uniformes [0, 1] independientes, deduzca

un método para simular en él v.a. Gaussianas de media µ y varianza cualesquiera.

P2. Sea A ✓ R2 como en la figura, y sea (X, Y ) un vector aleatorio uniformemente distribuido sobre A,

es decir, f(X,Y ) (x, y) = área(A) 1 1A (x, y).

(a) Muestre que fX (x) = 2 3|x| 1[ 1,1] (x). Calcule también la densidad marginal de Y .

(b) Deduzca que E(X) = 0 y muestre que cov(X, Y ) = 0.

(c) Son X e Y v.a independientes? justifique.

P3. Usted posee una barra de largo L, y le hace un corte X de manera uniforme en [0, 1]. Luego usted

hace otro corte pero ahora de manera uniforme en [X, L], como se muestra en la figura. Calcule la

densidad y esperanza de Y .

Indicación: Puede serle útil que, E(Y ) = E(E(Y |X)).

P4. Si la densidad conjunta de X e Y esta dada por

fXY (x, y) = c(x + y + 1 + xy)1[0,1] (x)1[0,1] (y)

. Encuentre c y diga si X e Y son independientes.

2