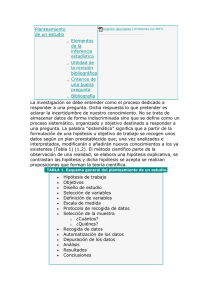

Problema

Anuncio