Teoría de probabilidad

Anuncio

3

3.1

Elementos matemáticos

Estadı́stica

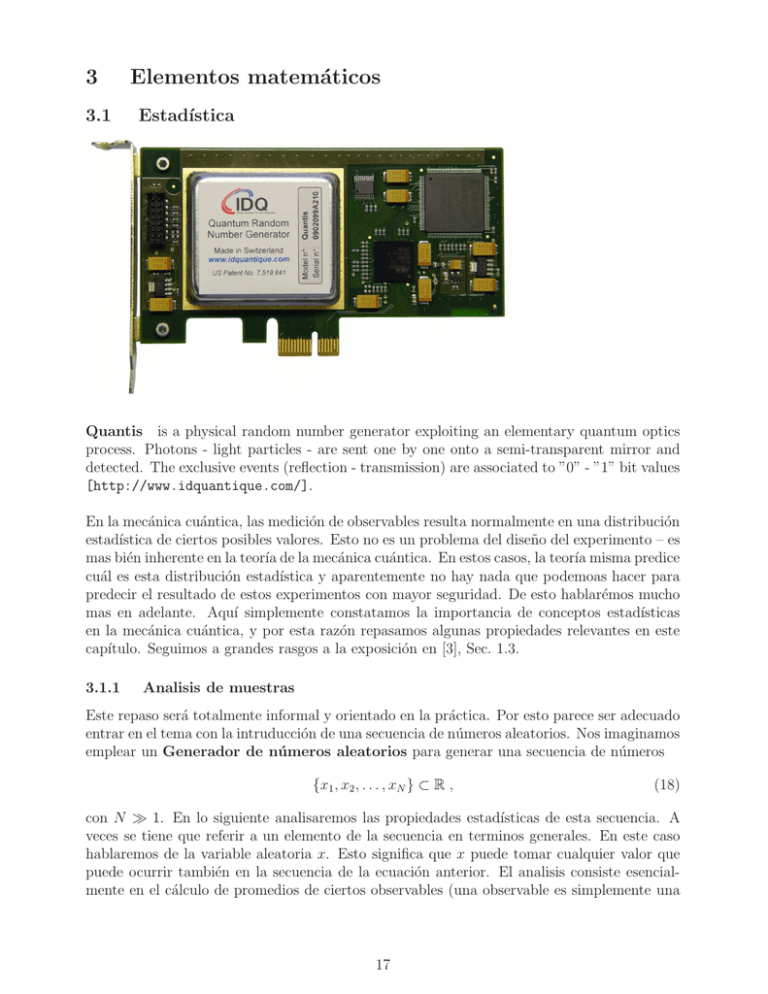

Quantis is a physical random number generator exploiting an elementary quantum optics

process. Photons - light particles - are sent one by one onto a semi-transparent mirror and

detected. The exclusive events (reflection - transmission) are associated to ”0” - ”1” bit values

[http://www.idquantique.com/].

En la mecánica cuántica, las medición de observables resulta normalmente en una distribución

estadı́stica de ciertos posibles valores. Esto no es un problema del diseño del experimento – es

mas bién inherente en la teorı́a de la mecánica cuántica. En estos casos, la teorı́a misma predice

cuál es esta distribución estadı́stica y aparentemente no hay nada que podemoas hacer para

predecir el resultado de estos experimentos con mayor seguridad. De esto hablarémos mucho

mas en adelante. Aquı́ simplemente constatamos la importancia de conceptos estadı́sticas

en la mecánica cuántica, y por esta razón repasamos algunas propiedades relevantes en este

capı́tulo. Seguimos a grandes rasgos a la exposición en [3], Sec. 1.3.

3.1.1

Analisis de muestras

Este repaso será totalmente informal y orientado en la práctica. Por esto parece ser adecuado

entrar en el tema con la intruducción de una secuencia de números aleatorios. Nos imaginamos

emplear un Generador de números aleatorios para generar una secuencia de números

{x1 , x2 , . . . , xN } ⊂ R ,

(18)

con N ≫ 1. En lo siguiente analisaremos las propiedades estadı́sticas de esta secuencia. A

veces se tiene que referir a un elemento de la secuencia en terminos generales. En este caso

hablaremos de la variable aleatoria x. Esto significa que x puede tomar cualquier valor que

puede ocurrir también en la secuencia de la ecuación anterior. El analisis consiste esencialmente en el cálculo de promedios de ciertos observables (una observable es simplemente una

17

función f (x) de la variable aleatoria). Para una secuencia en particular:

N

1 X

f (xj ) .

hf (x)i =

N j=1

(19)

Ahora, el generador puede generar varios secuencias de números aleatorias. Y para cada

secuencia podemos calcular el promedio de la mı́sma observable f (x). El resultado será

siempre el mismo? Claramente no! Dos secuencias tienen normalmente valores totalmente

distintos, y mientras que la secuencias tienen un número finito de elementos, los promedios

tienden a ser cercanos pero distintos.

Por otro lado podemos considerar el limite de secuencias cada vez mas largas. En este

limite, el promedio de una observable es normalmente siempre la misma. En lo que sigue nos

restringimos a esta clase de secuencias – ó a esta clase de generadores de números aleatorias

– ó a esta clase de variables aleatorias:

N

1 X

¯

f = lim

f (xj )

N →∞ N

j=1

(20)

independiente de la secuencia en particular.

Momentos Funciones (Observables) con importancia general son los momentos de la variable aleatoria:

f (x) = xn

(21)

Para n = 1 se obtiene el promedio de la variable misma. Con el primer momento n = 1 y

el segundo n = 2 se puede calcular la varianza y la desviación estandard – lo cúal nos da

información sobre la dispersión de la variable:

N

1 X

hxi =

xj ,

N j=1

σ(x)2 =

N

1 X 2

hx i =

x

N j=1 j

2

N

1 X

(xj − x̄)2 = hx2 i − 2x̄ hxi + x̄2

N j=1

(22)

Nota, que en la definición de la varianza figura x̄ el promedio definitivo de una secuencia

hipotética de longitud infinita. Sin embargo, a veces se ignora la diferencia entre x̄ y hxi y se

escribe para la varianza:

σ(x)2 ≈ hx2 i − hxi2

(23)

Hay que reconocer, que la diferencia entre x̄ y hxi es en muchos casos mı́nima, lo que justifica

esta aproximación.

Histogramas Se puede obtener una mayor imagen de las propiedades de una variable

aleatoria x ∈ R estudiando la probabilidad de que se obtiene un valor cerca de alguno de

ciertos valores de referencia pre-definidos.

Nos imaginamos tener una secuencia de números aleatorios {x1 , . . . , xN } para los cuales

deseamos generar un histograma. Empecamos a definir los valores de Referencia {X1 , . . . Xm }

18

200

’rand-hist.dat’ u 2:3

150

100

50

0

0

0.5

1

1.5

2

Figure 5: Histograma de N = 1000 números aleatorios generados sumando dos variables

aleatorios con densidad constante entre 0 y 1.

– para que sea mas facil – equidistantes con distancia ∆. Cada uno de ellos representa un

cajón, un intervalo (Xi − ∆/2, Xi + ∆/2) , 1 ≤ i ≤ m y se definen los enteros:

∀ 1 ≤ i ≤ m : ni = # xj |Xi − xj | < ∆/2

(24)

En el ejemplo en la figura 5 se muestra un histograma sobre una secuencia de N = 1000

números aleatorios con m = 10 barras. Cada número se obtuvo como suma de dos números

aleatorios con densidad de probabilidad constante entre 0 y 1. La linea azul indica la forma

del histograma en el lı́mite de mas y mas barras cada vez menos anchas. Nota que se necesita

aumentar N si se quiere aumentar el número de barras, para que el número de eventos que

muestra cada barra es suficientemente grande. De otra forma, el histograma es dominado por

fluctuaciones los cuales opacan la verdadera distribución de la variable aleatoria.

Un histograma contiene mucho mas información sobre la variable aleatoria que los promedios de algunos observables. Por qué? Por que se pueden calcular estos promedios a partir

del histograma – pero no se puede calcular el histograma a partir de algunos promedios.

El cálculo del promedio hf (x)i de una observable f (x) funciona de la siguiente forma:

hf (x)i =

N

1 X

f (xj )

N j=1

=

f (x̃1 ) + . . . + f (x̃n1 )

: n1 términos

+ f (x̃n1 +1 ) + . . . + f (x̃n2 ) : n2 términos

..

.

+ f (x̃nm−1 +1 ) + . . . + f (x̃nm ) : nm términos

(25)

donde (x̃1 , x̃2 , . . . , x̃N ) contiene los números de la secuencia anterior ordenados de manera

creciente. En esta fórmula, los términos en la i-ésima linea corresponden a valores xj los cuales

se acumulan en el i-ésimo cajón (la i-ésima barra). Esto permite, de manera aproximada,

sustituir los números aleatorios por los valores de referencia Xi (marcas de clase):

m

1 X

hf (x)i ≈

f (Xi ) ni

N i=1

Esta aproximación se vuelve exacta en el lı́mite barras infinitesimales.

19

(26)

Densidad de probabilidad La densidad de probabilidad de la variable aleatoria x se

obtiene interpretando la suma en la ecuación (26) como una suma de Riemann, la cúal debe

ser convergente en el lı́mite de barras infinitesimales, representando una partición del dominio

de la variable aleatória. Haciendo esto mas explı́cito, escribemos por (26):

hf (x)i ≈

m

X

f (Xi ) p(Xi ) ∆Xi ,

i=1

p(Xi ) =

ni

,

N ∆Xi

(27)

donde ∆Xi es la anchura de la i-ésima barra. De esta manera, p(Xi ) es la probabilidad de

que la variable aleatoria cae en el i-esimo intervalo, por longitud del intervalo. Por lo tanto,

se obtiene como lı́mite de la suma de Riemann:

Z

m

X

hf (x)i = lim

f (Xi ) p(Xi ) ∆Xi = dx p(x) f (x) ,

(28)

m→∞

i=1

donde p(x) dx es la densidad de probabilidad. Mientras que el histograma permite calcular

diferentes promedios de la variable aleatoria de manera aproximada, la densidad de probabilidad permite calcular los promedios de manera exacta. Para un generador de números

aleatorios independientes, la densidad de probabilidad es todo lo que se necesita saber – pero

tambı́en es todo lo que se puede saber – de sus propiedades.

3.1.2

Densidad de probabilidad conjunta

Variables aleatorias no siempre son independientes, ó lo que es casi lo mismo, variables aleatorias pueden ser vectores de dimensión n > 1. Un ejemplo podria ser un generador de números

aleatorios arojando grupos de n variables consecutivos los cuales no son independientes entre

si, mientras que variables de diferentes grupos si lo son. En este case podemos unir los variables de cada grupo en un vector ~x = (x1 , x2 , . . . , xn ) y decir que el generador de números

aleatorios genera vectores aleatorios.

¿Existe entonces algo como la densidad de probabilidad para vectores?

La respuesta es afirmativo. Este tipo de densidad de probabilidad se llama densidad de

probabilidad conjunta; en inglés: Joint probability density (JPD). En esencia, el manejo

de distribuciones de vectores aleatorios no es muy diferente al caso unidimenional.

Sea E la variedad de posibles valores de los vectores aleatorios ~x. En analogı́a al caso

unidimensional, la densidad de probabilidad conjunta p(~x) = p(x1 , x2 , . . . , xn ) es una función

positiva en E, la cuál permite determinar para una región R ⊂ E arbitraria la probabilidad

que un vector obtenido del generador toma un valor en esta región:

Z

P (R) =

dn (~x) p(x1 , x2 , . . . , xn ) .

(29)

R

Igual que en el caso unidimensional, la densidad de probabilidad conjunta representa toda

la información que se puede obtener del generador de vectores aleatorios en cuestión. Por

ejemplo, las observables ahora son funciones en E. Entonces podemos calcular su promedio

usando la formula:

Z

hf (~x)i = dn (~x) f (~x) p(~x) .

(30)

E

Para obtener la densidad de probabilidad conjunta usamos el mismo método del histograma.

Para ello necesitamos una división de la variedad E en pequeños regiones para luego contar

la frecuencia con la cuál los vectores en la secuencia aleatoria arojado por el generado toman

un valor en estos regiones.

20

Separabilidad

forma

Finalmente notamos que si la densidad de probabilidad resulta tener la

p(x1 , x2 , . . . , xn ) = p1 (x1 , x2 , . . . , xp ) p2 (xp+1 , xp+2 , . . . , xn ) ,

(31)

entonces se dice que los variables x1 , x2 , . . . , xp son estadı́sticamente independientes de los

variables xp+1 , xp+2 , . . . , xn y vice versa. Si esto es el caso el promedio de cualquier observable

f1 que solo depende de x1 , x2 , . . . , xp se puede calcular a traves de

Z

hf1 i = dp (x1 , x2 , . . . , xp ) f1 (x1 , x2 , . . . , xp ) p1 (x1 , x2 , . . . , xp ) .

(32)

3.1.3

Transformación de variables

En esta sección entramos a la arena de cálculo con distribuciones (densidades de probabilidad).

El problema que deseamos resolver es el siguiente:

Sean {y1 , y2, . . . , ym } observables estadı́sticas; en otras palabras son variables estadı́sticas

dependientes. En cualquier caso, esto significa que cada uno de las yj ’s se puede expresar

como función de las xi ’s:

y1 = f1 (x1 , x2 , . . . , xn )

y2 = f2 (x1 , x2 , . . . , xn )

..

.

ym = fm (x1 , x2 , . . . , xn )

(33)

Entonces podemos preguntar: ¿Cuál es la distribución de los yj ’s dado la distribución de los

xi ’ ? En otras palabras: ¿Como calcular la JPD de los yj ’s si la JPD de los xi es p(~x)?

El caso unidimensional

Consideramos primeramente el caso m = n = 1. Entonces tendremos una variable aleatoria x

con densidad de probabilidad p(x) y nos interesa la distribución (las propiedades estadı́sticas)

de una nueva variable y la cuál depende de x a través de y = g(x).

En un esfuerzo bruto, podriamos generar una secuencia larga de números aleatorios yj =

g(xj ) y analisar la distribución de los yj utilisando un histograma. Sin embargo, como verémos

en lo que sigue, conociendo la densidad de probabilidad para la variable aleatoria x, podemos

calcular directamente la densidad de probabilidad de la variable y. Para ello usamos la formula

Z

Z

hf (y)i = dx f (g(x)) p(x) = dy f (y) p̃(y) ,

(34)

y cambiamos en la integral a la izquierda la variable x por la variable y = g(x). En el caso

concreto es aconsejable, manejar con cuidado los lı́mites de los integrales. Aquı́, no los especificamos por qué no sabemos nada sobre ellos. Después del cambio de variable, simplemente

hay que identificar en el término que corresponde a p̃(y), comparando el integrando nuevo

con el integrando de la integral a la derecha.

Z

hf (y)i = dy h′ (y) f (y) p h(y)

⇒ p̃(y) = h′ (y) p h(y) ,

donde h(y) es la función inversa de g(x).

21

Ejemplo Sea la distribución original de los x dado por

(

1: 0<x<1

p(x) =

0 : en caso contrario

(35)

y consideramos la transformación:

x

,

1−x

y = g(x) =

(36)

lo cuál significa que y puede tomar valores entre 0 y ∞. Usando el procedimiento propuesto

arriba, hacemos:

Z 1

Z ∞

Z ∞

′

hf (y)i =

dx f (g(x)) =

dy h (y) f (y) =

dy f (y) p̃(y) ,

(37)

0

0

0

donde h(y) se determina por

x = h(y)

:

y(1 − x) = x

⇔

y = x(1 + y)

⇔

x=

y

.

1+y

(38)

Ahora podemos calcular h′ (y) y con esto p̃(y):

p̃(y) = h′ (y) =

y

1

1

−

=

.

2

1 + y (1 + y)

(1 + y)2

(39)

Método de la función de distribución acumulativo La información completa sobre

una variable aleatoria puede representarse en la densidad de probabilidad p(x) como lo hemos

notado anteriormente. Sin embargo existe la alternativa de la función de distribución acumulativa

Z x

P (x) =

dx′ p(x′ )

(40)

−∞

la cuál cuantifica la probabilidad de que el generador de números aleatorios aroja una valor

menor que x. Es muy fácil de ver que la información contenida en P (x) es la misma que en

p(x). Basta comprobar que p(x) se puede calcular a base de P (x) y vice versa.

Entonces, si y = g(x),

Z

P (y) =

dx p(x) ,

(41)

g(x)<y

donde la integral es sobre todas las regiones donde x esta definido y donde g(x) < y. Luego

usamos que con respeto a la densidad de probabilidad de y,

Z y

d

P (y) .

(42)

P (y) =

dy ′ p̃(y) ⇒ p̃(y) =

dy

−∞

El caso m = 1 , n > 1

Esto es el caso donde nos interesa la densidad de probabilidad de una observable y la cuál

depende de las variables aleatorias x1 , x2 , . . . , xn . Podemos abreviar este conjunto de variables

como vector aleatorio ~x = (x1 , x2 , . . . , xn ). Utilizamos el primer método de la observable

22

auxiliar f (~x) = f (y) donde y = g(~x). Entonces, si p(~x) es la densidad de probabilidad

conjunta de ~x, podemos escribir:

Z

Z

n

hf (y)i = d (~x) f (g(~x)) p(~x) = dy f (y) p̃(y) ,

(43)

donde la cantidad que buscamos es p̃(y). Ahora, el siguiente paso consiste en escoger una de las

n coordenadas de ~x (sin restringir la generalidad escogemos xn ) y realisar una transformación

de variable: xn → y = g(~x). Esto convierte la primera integral en

Z

Z

∂h

n−1

f (y) p x1 , . . . , xn−1 , h(x1 , . . . , xn−1 , y) ,

(44)

hf (y)i = d (x1 , . . . , xn−1 ) dy

∂y

donde h(x1 , x2 , . . . , xn−1 , y) = xn es la función que se obtiene despejando xn en la ecuación

y = g(~x). Ahora cambiamos el orden de los integrales, dejando la integral sobre y al último:

Z

Z

∂h

hf (y)i = dy f (y) dn−1 (x1 , . . . , xn−1 )

p x1 , . . . , xn−1 , h(x1 , . . . , xn−1 , y) ,

(45)

∂y

lo cuál demuestra que

Z

∂h

p x1 , . . . , xn−1 , h(x1 , . . . , xn−1 , y) ,

p̃(y) =

dn−1 (x1 , . . . , xn−1 )

∂y

R(y)

(46)

donde es importante manejar con cuidado la región de integración que depende de y.

Ejemplo Sean x1 , x2 dos variables aleatorias independientes y con la misma densidad de

probabilidad p1 (x) = e−x . ¿Cuál es entonces la densidad de probabilidad conjunta del vector

~x = (x1 , x2 )? Deseamos calcular la densidad de probabilidad para la observable y = x21 + x22 .

Entonces podemos escribir para una función arbitraria f (y):

ZZ ∞

hf (y)i =

dx1 dx2 f (x21 + x22 ) e−(x1 +x2 ) .

(47)

0

Realizaremos la transformación de variable de x2 a y, tal que

q

1

∂h

.

= p

x2 = h(x1 , y) = y − x21 ,

∂y

2 y − x21

Por lo tanto:

hf (y)i =

Z

0

∞

dx1

Z

∞

x21

1

dy f (y) p

2 y − x21

q

2

exp −x1 − y − x1 .

(48)

(49)

Ası́ que la region de integración es el conjunto {(x1 , y) | 0 < x1 ∧ x21 < y}. Por lo tanto,

intercambiando el orden de los integrales vemos que

p

2

Z √y

exp −x1 − y − x1

1

p

dx1

p̃(y) =

.

(50)

2 0

y − x21

Posiblemente, esta integral es muy dificil de evaluar y requiere transformaciones de variables

adicionales. Pero en todo caso hemos repadaso todos los pasos cruciales del método y hemos

obtenido una fórmula explı́cita para la densidad de probabilidad que buscabamos.

23