Análisis de performance y optimización en Clusters Beowulf

Anuncio

Universidad de Buenos Aires

Facultad de Ciencias Exactas y Naturales

Departamento de Computación

Análisis de performance y

optimización en Clusters Beowulf

por

Marı́a Carolina León Carri

{[email protected]}

Director: Dr. Ing. Guillermo Marshall

{[email protected]}

Codirector: Dr. Ing. Carlos Garcı́a Garino

{[email protected]}

Tesis para optar al grado de

Licenciada en Ciencias de la Computación

Agosto 2004

Índice general

1. Introducción

8

2. Conceptos Básicos

2.1. Tecnologı́a de redes . . . . . . . . . . . . . . . . . . . . . .

2.1.1. Tecnologı́a Ethernet . . . . . . . . . . . . . . . . .

2.1.2. Protocolo IP, Internet Protocol (MTU) . . . . . . .

2.1.3. Protocolo TCP, Transmission Control Protocol . . .

2.1.4. Ancho de Banda, Latencia y RTT . . . . . . . . . .

2.1.5. Bonding . . . . . . . . . . . . . . . . . . . . . . . .

2.2. Arquitectura del nodo . . . . . . . . . . . . . . . . . . . .

2.3. Implementación de Gigabit Ethernet en clusters de PC . .

2.4. Sistema de archivos . . . . . . . . . . . . . . . . . . . . . .

2.4.1. Sistema de archivo local - ext3 . . . . . . . . . . . .

2.4.2. Network File System - NFS . . . . . . . . . . . . .

2.4.3. Parallel Virtual File System - PVFS . . . . . . . .

2.4.4. Mosix File System con Direct File System Access

MFS con DFSA . . . . . . . . . . . . . . . . . . . .

2.4.5. Global File System - GFS . . . . . . . . . . . . . .

2.5. Administración de Procesos . . . . . . . . . . . . . . . . .

2.5.1. Portable Batch System - PBS . . . . . . . . . . . .

2.5.2. MAUI Scheduler . . . . . . . . . . . . . . . . . . .

2.5.3. Interacción entre PBS y MAUI . . . . . . . . . . .

2.6. Herramientas de programación . . . . . . . . . . . . . . . .

2.6.1. MPICH . . . . . . . . . . . . . . . . . . . . . . . .

2.6.2. ROMIO . . . . . . . . . . . . . . . . . . . . . . . .

3. Experimentos y optimización

3.1. Performance de Red . . . . . . . . . . . . . . . . . .

3.1.1. Mediciones de Throughput de TCP . . . . . .

3.1.2. Mediciones de Throughput de MPICH . . . .

3.1.3. Influencia del tamaño de las ventanas de TCP

3.1.4. Comparación entre diferentes clusters . . . . .

3.2. Performance de Sistemas de Archivos . . . . . . . . .

3.2.1. Benchmark Bonnie . . . . . . . . . . . . . . .

3.2.2. Benchmark Babieca . . . . . . . . . . . . . . .

3.2.3. MPI I/O: perf y coll perf de ROMIO . . . . .

3.3. Throughput de Procesos . . . . . . . . . . . . . . . .

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

10

10

11

11

12

12

13

14

15

16

16

18

.

.

.

.

.

.

.

.

.

22

22

22

23

24

24

25

25

26

.

.

.

.

.

.

.

.

.

.

28

28

28

32

33

33

35

36

38

41

46

4. Conclusiones y lı́neas futuras

49

4.1. Conclusiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

4.2. Lı́neas Futuras . . . . . . . . . . . . . . . . . . . . . . . . . . 51

A. Clusters Utilizados

A.1. Cluster Speedy González

A.1.1. Hardware . . . .

A.1.2. Software . . . . .

A.2. Cluster Meteoro . . . . .

A.2.1. Hardware . . . .

A.2.2. Software . . . . .

A.3. Cluster Mercurio . . . .

A.3.1. Hardware . . . .

A.3.2. Software . . . . .

.

.

.

.

.

.

.

.

.

B. Descripción de Benchmarks

B.1. Red . . . . . . . . . . . .

B.1.1. NetPIPE . . . . . .

B.2. Sistema de archivos . . . .

B.2.1. Babieca . . . . . .

B.2.2. Bonnie . . . . . . .

B.2.3. perf y coll perf . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

52

52

52

52

55

55

56

56

56

56

.

.

.

.

.

.

57

57

57

57

57

58

59

C. Configuración TCP en Linux

60

Bibliografı́a

62

2

Índice de figuras

2.1.

2.2.

2.3.

2.4.

2.5.

2.6.

2.7.

2.8.

2.9.

Envı́o de mensajes [21] . . . . . . . . . . . . . . . . . . . . . .

Recepción de mensajes [21] . . . . . . . . . . . . . . . . . . . .

Estructura de capas de NFS [14] . . . . . . . . . . . . . . . . .

Diagrama del sistema PVFS [17]. . . . . . . . . . . . . . . . .

Flujo de metadata y datos en PVFS [17]. . . . . . . . . . . . .

Flujo de datos a través del kernel [17]. . . . . . . . . . . . . .

Ejemplo de distribución de un archivo en una partición PVFS [16]

Ejemplos de particiones Lógicas PVFS [16] . . . . . . . . . . .

Interacción entre PBS y MAUI . . . . . . . . . . . . . . . . .

13

14

17

19

20

20

21

22

25

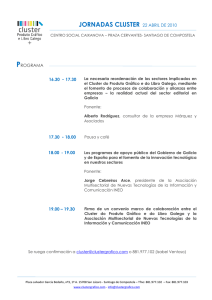

3.1. Throughput de Speedy para tamaño de buffers default de sockets TCP. Referencias: (F)ast, (E)thernet, (B)onding, M(PICH),

(G)igabit. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

3.2. Gráfico de Saturación Ethernet del cluster Speedy. . . . . . . . . 31

3.3. Gráfico de Firma Ethernet del cluster Speedy. . . . . . . . . . . . 31

3.4. Throughput de red para distintos tamaños de ventanas de congestión TCP (A) MTU=1500, (B) MTU=3000 y (C) MTU=9000.

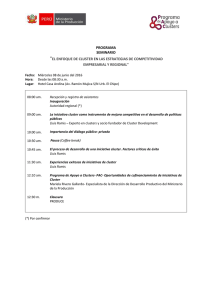

34

3.5. Comparación del throughput entre los clusters Meteoro, Mercurio

y Speedy. Referencias: (F)ast, (E)thernet, (B)onding, M(PICH),

(G)igabit. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.6. Throughput de accesos al sistema de archivos. Benchmark Bonnie. 37

3.7. Cantidad de búsquedas por segundo. Benchmark Bonnie. . . . . . 38

3.8. Performance de sistemas de archivos ext3, NFS, PVFS. Comandos

de lectura Unix. Benchmark Babieca. . . . . . . . . . . . . . . . 39

3.9. Performance de sistemas de archivos ext3, NFS, PVFS. Comandos

de lectura/escritura Unix. Benchmark Babieca. . . . . . . . . . . 40

3.10. Distribución fı́sica del archivo generado por perf para la ejecución

con 4 nodos de tamaño 4 MB por nodo, en la partición PVFS

(base=1, pcount=15 y ssize=64 KB). Programa perf de ROMIO. . 41

3.11. Throughput de escrituras/lecturas. (A) sin la función MPI File sync(),

(B) con dicha función. Programa perf de ROMIO. . . . . . . . . 42

3.12. Throughput de (A) escrituras y (B) lecturas SIN la función MPI File sync().

Programa perf de ROMIO. . . . . . . . . . . . . . . . . . . . . 43

3.13. Throughput de (A) escrituras y (B) lecturas CON la función MPI File sync().

Programa perf de ROMIO. . . . . . . . . . . . . . . . . . . . . 44

3.14. Throughput de Funciones Colectivas de lectura/escritura. Programa coll perf de ROMIO para cubos de 2563 . . . . . . . . . . . . . 45

3.15. Porcentaje de cantidad de trabajos por tiempo de duración. . . . . 46

3.16. Corridas homogéneas vs. heterogéneas. . . . . . . . . . . . . . . . 47

3

A.1. Topologı́a del Cluster Speedy. . . . . . . . . . . . . . . . . . . . 54

4

Índice de cuadros

2.1. Caracterı́sticas del throughput nominal del Bus PCI/PCI-X [41]. . 15

3.1. Throughput de accesos al sistema de archivos. Las búsquedas aleatorias están dadas en cantidad de búsquedas por segundo. Benchmark

Bonnie. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

A.1.

A.2.

A.3.

A.4.

A.5.

Caracterı́sticas

Caracterı́sticas

Caracterı́sticas

Caracterı́sticas

Caracterı́sticas

del hardware de Speedy. . . . .

de los discos de Speedy. . . . .

de las placas de red 3c2000 [43].

del hardware de Meteoro. . . .

del hardware Cluster Mercurio.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

53

53

53

55

56

C.1. Configuración TCP en linux. . . . . . . . . . . . . . . . . . . . 61

5

Resumen

En la última década la computación paralela tuvo un gran resurgimiento

gracias a los sistemas tipo Beowulf, cluster de PCs conectadas entre sı́ para

formar una supercomputadora.

El objetivo de este trabajo es presentar un estudio de la performance y

optimización de clusters Beowulf a través del análisis de la compleja relación

existente entre la tecnologı́a de red, la arquitectura del nodo, los sistemas de

archivos, las herramientas de programación y la administración de procesos.

En relación a la tecnologı́a de red y a la arquitectura del nodo, se muestra

que para obtener la máxima performance de Gigabit Ethernet es fundamental

analizar cuidadosamente los elementos subyacentes. El máximo ’throughput’

alcanzable depende fuertemente del bus PCI (Peripheral Component Interconnect) del nodo, de la velocidad del procesador, sus técnicas de ’caching’,

de las caracterı́sticas de la placa de red (capacidad de realizar ’checksums’

y segmentación de paquetes TCP, disponibilidad de un bus PCI dedicado) y

del ’tuning’ de los parámetros TCP.

En relación al sistema de archivos, se muestra que PVFS (Parallel Virtual

File System) resulta la opción más apropiada para utilizar el espacio en disco

distribuido entre los nodos del cluster y para optimizar el uso del mismo en

programas paralelos.

En relación a las herramientas de programación, se prueba que las funciones de operaciones de entrada/salida, MPI I/O (ROMIO), son las que

acceden en forma más eficiente a las áreas de disco global.

Finalmente, con respecto a la administración de procesos se sugiere, entre otras polı́ticas, la implementación de ’checkpointing’ para aumentar el

’throughput’ total de procesos.

En sı́ntesis, éste trabajo pretende mostrar la importancia que tiene para

el logro de una performance óptima de un cluster Beowulf, la elección de

la tecnologı́a de red, la arquitectura del nodo, el sistema de archivos, el administrador de procesos y las herramientas de programación. Un correcto

balance de estos ingredientes permite obtener una notable mejora en el uso

de los recursos facilitando el objetivo fundamental de la computación paralela

que es permitir resolver problemas más grandes en menor tiempo.

6

Agradecimientos

Quisiera dedicar este trabajo especialmente a mis padres Graciela y Juan,

a mis abuelos La Baby y Marcelo, a mi hermana Marı́a y a Rodo. Ellos fueron

las principales personas que me impulsaron y apoyaron cuando decidı́ seguir

esta carrera y siempre estuvieron presentes durante el transcurso de ella.

En los años de estudiante fueron muchos los que participaron de la ’lucha’

por el tı́tulo. Ellos recordarán bien las horas sin dormir que compartimos en

tiempos de entregas de trabajos prácticos, parciales y finales. Podrı́a nombrarlos a todos aquı́ pero no quisiera arriesgarme a olvidar a uno sólo de

ellos.

Y fuera del ambiente universitario los amigos y compañeros de trabajo

fueron la compañı́a ideal para los tiempos de ocio y lamentos.

Y ahora sı́ voy a nombrar a los responsables más directos sobre la realización de este trabajo. A los que lo leyeron una y otra vez para sacarle el

jugo, a los que me explicaron pequeñas pero muy valiosas dudas que me iban

surgiendo, a los que soportaron la desesperación por terminar... Ellos son

especialmente dos grupos, la gente del laboratorio de Sistemas Complejos:

Silvina, Esteban, Graciela, Pablo(s), Ernesto, Diego, Guillermo y Carlos. Y

los del trabajo: Isa, Diego, Jorge y Luis.

7

Capı́tulo 1

Introducción

Los clusters de computadoras se crearon con el objetivo de resolver problemas complejos en forma más económica que los supercomputadores. Están

compuestos por un conjunto de PCs interconectados por una red local. Poseen

software funcional y hardware que permiten que el cluster sea visto y administrado como un sistema único. Los clusters pueden ser agrupados según su

funcionalidad en tres grupos [12]:

servidor aplicaciones administrador central de recursos dedicados a iniciar tareas

alta disponibilidad conjunto de máquinas que garantizan redundancia y

tolerancia a fallas

alta performance sistemas que trabajan en conjunto para solucionar un

problema

Los clusters Beowulf pertenecen al último grupo. Su denominación surgió en la NASA por el investigador Donald Becker quien buscó desarrollar un

recurso de supercómputo sin tener que utilizar una supercomputadora. Interconectó un conjunto de máquinas mediante un switch y logró su objetivo,

un recurso para implementar la computación paralela de alta performance

(High Performance Computing - HPC). Es importante que las computadoras

paralelas de alta performance cumplan esta caracterı́stica, sin embargo no se

espera de ellas que sean confiables. Esto significa que debe realizar los cálculos en forma eficiente y rápida pero que una falla ocasional se tolera y puede

ser superada con solo reinicializar la corrida del problema. Además deben

cumplir con la relación costo/beneficio, se desea obtener alta performance a

bajo costo.

En este trabajo, se analizarán los puntos a tener en cuenta si se quiere

poner en funcionamiento un cluster de alta performance. Las pruebas se

realizarán en el cluster Beowulf Speedy Gonzalez del Laboratorio de Sistemas

Complejos del Departamento de Computación, UBA. Se utilizará software

libre y gratuito. Los recursos a utilizar son:

sistema operativo Linux, Mandrake 9.2 [19]

benchmark de red NetPIPE descripto en el Apéndice B.1.1 que permite el análisis de la capacidad de la red interna que interconecta las

máquinas del cluster

8

sistema de archivos, organización de los discos distribuidos en todas

las máquinas que componen el cluster, NFS y PVFS descriptos en el

Capı́tulo 2.4

sistema de administración de procesos, PBS y MAUI descriptos en el

Capı́tulo 2.5

monitoreo del sistema (uso de memoria, CPU, discos, etc.)

herramientas de programación paralela basadas en pasaje de mensajes,

MPICH (Message Passing Interface) y ROMIO descriptas en el Capı́tulo 2.6.

Además, se llevaran a cabo pruebas en dos clusters externos al laboratorio

descriptos en el Apéndice A que permitirán comparar a Speedy con tecnologı́as más modernas.

9

Capı́tulo 2

Conceptos Básicos

2.1.

Tecnologı́a de redes

La eficiencia de un cluster de alta performance depende en gran parte

de la tecnologı́a utilizada para interconectar sus nodos. Esto se debe a que

los programas paralelos utilizan intercambio de mensajes entre los nodos

involucrados en la resolución de un problema. En esta sección se describirán

algunos aspectos teóricos necesarios a tener en cuenta durante el desarrollo

del trabajo.

2.1.1.

Tecnologı́a Ethernet

Redes Compartidas En un principio bastó con poder conectar los nodos

del cluster mediante una red compartida. Cada nodo con su placa de

red ethernet de 10 Mbps, se conectaba con los demás mediante un hub

a través de cables de cobre de par trenzado según norma de transmisión

10BaseT (10 Mbps). La tecnologı́a Ethernet es un bus broadcast que

transmite paquetes a 10 Mbps. Es un bus porque todas las máquinas

comparten el mismo canal de comunicación, y es broadcast porque todas

las máquinas reciben todas las transmisiones [14]. El modo de transmisión es half duplex.

El mecanismo de acceso al medio en Ethernet es CSMA/CD (Carrier

Sense Multiple Access/Collision Detection). Consiste en que cada nodo

se fija si el bus está libre, si es ası́ envı́a su paquete. Puede ocurrir que

otro nodo haya visto el bus libre al mismo tiempo y haya enviado un

paquete, esto generará una colisión de paquetes que podrá ser detectada

por el transmisor teniendo que reenviar el mensaje luego de un intervalo

de tiempo.

Esta opción presenta la desventaja de que el medio de transmisión de

mensajes es muy lento y con posibles colisiones. Además a medida que

se agregan nodos al cluster estos problemas se producen con mayor

frecuencia y es posible que la red se sature.

Redes Conmutadas Actualmente las computadoras son más potentes y

necesitan un medio de conexión más veloz para alcanzar los niveles de

alta performance deseados. En las redes conmutadas se reemplazó el

10

hub por el switch. En un principio, los conmutadores tenı́an una velocidad de transferencia de 100 Mbps, actualmente han evolucionado

hasta alcanzar 1000 Mbps y más. Esta opción requiere que cada nodo

posea una placa de red fast ethernet (100 Mbps, norma 100BaseT) o

gigabit ethernet (1000 Mbps), dependiendo de la capacidad del switch,

conectadas por un cable de par trenzado. Dicho cable posee 4 pares

de hilos, en Ethernet y Fast Ethernet sólo se empleaban 2 pares, en el

caso de Gigabit se utilizan los 4 pares. Para Gigabit se necesita como

mı́nimo cables de categorı́a 5e y preferentemente categorı́a 6.

En las redes conmutadas cuando un nodo transmite un mensaje a través

del switch hacia otro nodo, es el switch quien se encarga de enviar el

mensaje a la placa del nodo destino. Utiliza el protocolo Ethernet en

modalidad full duplex, con envı́o y recepción de paquetes en forma

simultánea. La transmisión entre la estación y el switch es punto a

punto, el mecanismo CSMA/CD ya no tiene sentido, se emplea un

par de hilos para transmisión de datos y otro para recepción en forma

simultánea. No requiere estar escuchando permanentemente en el bus

como en el primer caso.

2.1.2.

Protocolo IP, Internet Protocol (MTU)

El protocolo estándar TCP/IP define al datagrama IP como la unidad de

información enviada a través de la red y provee las bases para la distribución

de paquetes. El MTU, Maximum Transfer Unit, es el tamaño de paquete más

grande que puede ser transferido a través de una red fı́sica. En teorı́a, puede

ser de hasta 64 Kbytes, pero en la práctica está determinado por el hardware

de red. Actualmente el estándar de los dispositivos para interconectar redes

(switches, routers, etc.) es de 1500 bytes, pero algunas placas de red gigabit

permiten configurar el MTU de hasta 9000 bytes logrando ası́ incrementar

el throughput. Se debe tener en cuenta que si el MTU es muy pequeño, la

máquina estará respondiendo seguido mientras que si es muy grande puede

haber errores y los paquetes tendrı́an que ser retransmitidos.

2.1.3.

Protocolo TCP, Transmission Control Protocol

TCP es un protocolo confiable pues garantiza que los datos llegarán a

destino y orientado a conexión pues simula un túnel entre el emisor y el

receptor. Básicamente una conexión TCP consta de las siguientes partes:

emisor con un buffer para el envı́o de mensajes cuyo tamaño está dado en

bytes

receptor con un buffer para la recepción de mensajes cuyo tamaño está dado

en bytes y puede ser diferente al anterior

Dichos buffers, también llamados ventana de congestión, cambian de tamaño

dinámicamente en el transcurso de una conexión TCP controlando ası́ el flujo

de datos.

El protocolo TCP provee confiabilidad debido al uso de paquetes de acknowledge (ACK), estos paquetes son enviados por el receptor para confirmar

11

que se ha recibido un paquete determinado. Si el emisor no recibe el ACK

en un determinado transcurso de tiempo, reenvı́a el paquete. Si recibe el

ACK continúa enviando paquetes. El tamaño de la ventana de congestión

del emisor indicará cuantos paquetes puede enviar el mismo mientras que

espera el ACK de cada uno de ellos. El tamaño de la ventana del receptor

estará condicionado por la rapidez que el mismo tenga para enviar el ACK

del paquete recibido y liberar espacio en el buffer.

La performance depende del tamaño de las ventana y de la velocidad en

que la red transmita los paquetes. Incrementando el tamaño de la ventana

es posible reducir por completo los momentos ociosos de la red. Una buena

configuración del tamaño de la ventana deslizante, mantiene a la red completamente saturada de paquetes, obteniendo un mejor throughput. Luego, el

máximo throughput está condicionado por el tamaño de ambos buffers. La

siguiente fórmula permite calcular el máximo ancho de banda dado el tamaño

del buffer emisor y el tiempo de respuesta del enlace:

buffer de envı́o

ancho de banda = tamaño delRTT

El ancho de banda, la latencia y el RTT serán explicados en la próxima

sección. Por la misma fórmula, sabiendo el ancho de banda teórico de la red

y el RTT podemos calcular el tamaño óptimo de la ventana de congestión

para lograr un buen throughput.

2.1.4.

Ancho de Banda, Latencia y RTT

La performance de la red se mide preferentemente en bits por segundo

’bps’. Sus caracterı́sticas están dadas por el ancho de banda y la latencia.

El ancho de banda indica la cantidad de datos que pueden ser transferidos a

través de un enlace por unidad de tiempo. La latencia es el tiempo necesario

para transferir un dato desde un origen al destino, generalmente se refiere a

las demoras debidas al procesamiento del dato de red. El tiempo de ida y

vuelta se denomina Round Trip Time (RTT).

El ancho de banda y la latencia están relacionados. Mientras que el máximo ancho de banda teórico es fijo (dado por el hardware de red utilizado), el

ancho de banda real se ve afectado por la latencia de la red, es decir por el

tiempo mı́nimo necesario para transferir un paquete de dato desde un punto

a otro. Mucha latencia en un corto perı́odo de tiempo puede causar cuellos

de botella que no permiten llenar el enlace, por lo tanto decrece el ancho de

banda. También se ve afectado por el overhead del hardware y del sistema

operativo. El ancho de banda práctico lo llamamos throughput. La percepción

de la velocidad de la red es una sı́ntesis de estas dos unidades de medida.

2.1.5.

Bonding

Linux permite instalar dos o más placas de red por nodo con el fin de

obtener un mayor throughput balanceando la carga entre ellas. Esta configuración se denomina bonding, es totalmente transparente para el usuario y

los procesos. Por ejemplo, si se instalan dos placas de red Fast Ethernet por

nodo y se conectan ambas placas al switch se podrı́a obtener un throughput

12

aproximado del 85 % de la suma de la capacidad de ambas placas. Se debe

tener en cuenta que se requiere un switch con el doble de cantidad de bocas

que el número de máquinas a conectar.

El bonding es un driver que es parte del sistema operativo linux. Permite

definir una polı́tica para el balance de carga entre las dos placas, por ejemplo

Round-Robin (envı́a en forma circular un paquete a cada placa disponible).

Es una buena opción para lograr mayor performance de red a bajo costo.

2.2.

Arquitectura del nodo

A grandes rasgos, el camino seguido en una transferencia de datos a través

de una red implica tres cargas en memoria. Del lado del receptor, el adaptador

de red accede directamente a memoria (DMA, Direct Memory Access) para

cargar los datos en el buffer receptor, el CPU lee los datos de dicho buffer y

los escribe al de la aplicación. En una transmisión se realiza el paso inverso.

Las cargas en memoria dependerán de la aplicación que esté siendo utilizada,

tamaños de buffers y el comportamiento de la cache.

El tráfico total de memoria, lecturas/escrituras, es a través del Front

Side Bus - FSB. La Figura 2.1 muestra el tráfico de memoria durante la

transmisión de un mensaje. La Figura 2.2 muestra el tráfico de memoria

durante la recepción de un mensaje.

Envı́o de mensajes. 1. El CPU lee el buffer de la aplicación

2. El CPU escribe los datos al buffer del socket

3. La placa de red (NIC) accede directamente a memoria y lee el

buffer del socket

Figura 2.1: Envı́o de mensajes [21]

Recepción de mensajes. 1. La placa de red (NIC) accede directamente

a memoria y escribe el buffer del socket

2. El CPU lee el buffer del socket

3. El CPU escribe los datos al buffer de la aplicación

13

Figura 2.2: Recepción de mensajes [21]

2.3.

Implementación de Gigabit Ethernet en

clusters de PC

Dado un cluster de PCs interconectado mediante placas de red y switch

Fast Ethernet que presenta buena performance de comunicación, no es trivial

migrar su medio de conexión a Gigabit Ethernet. No se obtiene con facilidad

un aumento de rendimiento utilizando placas de red y switch Gigabit Ethernet. Esto se debe en gran parte a la arquitectura del bus PCI (Peripheral

Component Interconnect) que poseen los motherboards que en general se encuentran en uso y que poseen placas de red fast ethernet. Otra posible fuente

de dificultad son los potenciales cuellos de botella asociados a la gestión del

FSB [31] como ası́ también la configuración de los parámetros TCP/IP.

El bus PCI es compartido entre varios dispositivos, por su naturaleza paralela. Aquellos dispositivos que se encuentren conectados al bus harán uso

del mismo rotando cı́clicamente. No solo comparten el bus sino que la frecuencia quedará definida en base al dispositivo de menor frecuencia, disminuyendo

ası́ la performance de los dispositivos más rápidos [41]. Por ejemplo, el bus

PCI está compartido por el CPU, la memoria, la placa de video, las placas

de red, etc.

En particular, las placas de red negocian la velocidad con el bus PCI. Para

una placa con un bus PCI 32 bits/33 Mhz, ver Cuadro 2.1, se observa que

nominalmente soporta 1 Gbps, pero no es recomendable. En el caso del cluster

Speedy, éste posee motherboards PC-Chip M810 con PCI 2.2 y placas de red

3Com 3c2000 que negocian a 32-bit/66 MHz, alcanzando un ancho de banda

teórico de 2 Gbps. Existe una arquitectura más moderna para bus PCI [41]

que consiste en no compartir el bus con muchos dispositivos a través de un

bridge PCI, sino que se conectan directamente con el Memory I/O Control,

MIOC alcanzando ası́ mayor throughput para las placas Gigabit. Este es el

caso del Cluster Mercurio, ver Apéndice A.3.

No solo el bus PCI puede ser responsable de los inconvenientes para alcanzar el throughput que ofrece gigabit ethernet, las ineficiencias del sistema

pueden ocurrir en varios niveles entre la capa de aplicación y el hardware.

14

Cuadro 2.1: Caracterı́sticas del throughput nominal del Bus PCI/PCI-X [41].

Se puede perder hasta el 50 % en la capa de pasaje de mensajes. El sistema operativo y los drivers usualmente aumentan la latencia y disminuyen

el ancho de banda debido a que realizan muchas copias de dato memoria a

memoria al empaquetar los datos para su transmisión. Estos movimientos

extras de datos saturan el bus de memoria, tı́picamente antes de saturar el

bus PCI [31]. Por otro lado, también se debe tener en cuenta que los sistemas

operativos actualmente calculan los parámetros TCP/IP suponiendo el uso

de placas fast ethernet. Con lo cual, se deben configurar los parámetros por

defecto de las ventanas TCP/IP como ası́ también los buffers para pasaje de

mensajes de MPICH.

2.4.

Sistema de archivos

Dada la arquitectura, diseño y composición del hardware de Speedy se

tiene la necesidad de utilizar la capacidad de disco de cada uno de los nodos en

forma global. Se quiere aplicar un sistema de archivos que soporte el acceso

a los mismos en forma paralela. Cada sistema de archivos será evaluado

con respecto a su velocidad de acceso de entrada/salida y su escalabilidad.

También se tendrá en cuenta el tipo de aplicaciones que se quiere ejecutar en

el cluster Speedy, aquellas con gran cantidad de operaciones de entrada/salida

y las que tienen poca cantidad de operaciones de entrada/salida

Se evaluarán los siguientes sistemas de archivos:

local (ext3) tipo de fichero utilizado en Linux

NFS - Network File System

PVFS - Parallel Virtual File System

MFS - Mosisx File System

GFS - Global File System

La Figura 2.3 ilustra cómo están embebidos los distintos sistemas de

archivos con el sistema operativo (SO). Cuando se ejecuta una operación

ésta llama al SO para abrir, cargar o tomar los datos de un archivo. El

mecanismo de acceso a un archivo acepta el pedido automáticamente lo pasa

al software de su sistema de archivos local, al cliente NFS, al cliente PVFS

15

o al que corresponda dependiendo si el archivo está en el disco local, en una

máquina remota o en varias.

Cuando recibe un pedido, el software del cliente utiliza el protocolo correspondiente para conectarse al/los servidor/es remotos apropiados y lleva a

cabo la operación requerida. Cuando el servidor remoto contesta, el software

del cliente devuelve los resultados a la aplicación que inicio el pedido.

2.4.1.

Sistema de archivo local - ext3

El tipo de fichero local ext3 [24], utilizado actualmente en Linux, posee la

ventaja de tener journaling (registros de eventos periódicos), esto garantiza

disponibilidad e integridad de los datos y velocidad de acceso.

disponibilidad pues luego de una caı́da del sistema inesperada ext3 no

requiere un chequeo total del sistema de archivos gracias al journal.

integridad garantiza integridad de los datos luego de una caı́da abrupta del

sistema.

velocidad a pesar de escribir los datos mas de una vez, es más rápido que

ext2, su predecesor, pues el journaling optimiza el movimiento de las

cabezas del disco.

Posee distintas opciones de journal : registrar periódicamente todos los

archivos y los metadata, o bien, registrar sólo los metadata. En el último

caso se puede optar por escribir los datos en el sistema de archivos antes que

el metadata lo que garantiza que todos los metadata apunten a datos válidos

o escribir el metadata antes que el dato en este caso el sistema de archivos

será consistente pero luego de una caı́da del sistema podrı́an aparecer datos

viejos. Esto permite al administrador decidir si se quiere mayor rapidez o

mayor consistencia de datos.

2.4.2.

Network File System - NFS

NFS es un protocolo desarrollado por Sun Microsystems, Incorporated.

Permite que un conjunto de máquinas accedan a sistemas de archivos remotos

en forma transparente.

Cuando un cliente monta un sistema de archivos, el servidor de NFS le

devuelve un file handle (FH) que contiene el tipo de archivo, el disco, el

i-nodo e información de seguridad. La implementación de NFS, ver Figura

2.3 [14], independiente del protocolo, consiste en tres capas. La primer capa de

llamadas al SO (OPEN, READ, CLOSE) luego de examinar el pedido invoca

a la segunda capa, el sistema de archivos virtual (VFS). Ésta se encarga de

mantener una tabla con una entrada por archivo abierto llamado v-nodo. Si

el archivo es local, la entrada contendrá un i-nodo y la tercer capa será la que

manipula archivos locales y si el archivo es remoto, la tercer capa estará a

cargo del cliente NFS. Analizaremos las llamadas al sistema: MOUNT, OPEN

y READ.

16

Figura 2.3: Estructura de capas de NFS [14]

MOUNT Para montar un fichero remoto se utiliza el comando mount, se

especifica el directorio remoto y el directorio local donde será montado, entre otra información. El programa mount analiza el nombre del

directorio remoto, descubre la máquina a la cual pertenece, la contacta

y le pide el FH. Si el directorio existe y está disponible para su acceso

remoto, el servidor le da el FH. Finalmente, el programa realiza una llamada al sistema MOUNT y le pasa el FH al kernel. El kernel construye

el v-nodo y le pide al cliente NFS que cree el r-nodo (i-nodo remoto) en

su tabla interna para guardar el FH. Luego el v-nodo apunta al r-nodo.

Cada v-nodo de la capa VFS contendrá un puntero o un r-nodo en el

código del cliente NFS o bien, un puntero a un i-nodo del SO local.

Luego desde la capa VFS se puede saber si el directorio o archivo es

remoto o local y si es remoto, se puede encontrar el FH.

OPEN Durante la examinación del ’path’ del archivo, el kernel descubre

que el directorio en el cual está montado el fichero es remoto. Busca en

la tabla de v-nodos el puntero al r-nodo. Luego pide al cliente NFS que

abra el archivo. El cliente NFS busca el resto del ’path’ en el servidor

remoto asociado con el directorio montado y devuelve el FH. Crea un

r-nodo para el archivo remoto en sus tablas y reporta a la capa VFS,

la cual pone en sus tablas el v-nodo que tendrá un puntero al r-nodo.

Entonces vemos que todo archivo o directorio abierto tiene un v-nodo

que apunta a un r-nodo o i-nodo.

Notemos que el que guarda la información del FH es el cliente, el servidor no guarda ningún tipo de información sobre el archivo. El servidor

provee los FH ante un pedido, pero no lleva ningún registro de los

FH entregados. Cuando un cliente le envı́a un FH para acceder a un

archivo, el servidor verifica que el mismo exista y lo usa.

READ Cuando el FH es utilizado en llamadas posteriores al sistema, por

ejemplo para una lectura, la capa VFS localiza el v-nodo correspondiente y a partir de el determinara si es local o remoto y también que

i-nodo o r-nodo lo describe.

17

Se utilizan distintas técnicas para mejorar la eficiencia del protocolo. Las

transferencias entre el cliente y el servidor se realizan en bloques de 4096

bytes, incluso en el caso en que se pidan menos bytes. Una vez que el cliente

recibe el bloque de 4 KB, pide el siguiente, este procedimiento se llama look

ahead e incrementa la performance de NFS. Para las escrituras se procede

del mismo modo, sólo se envı́a la escritura al servidor cuando el cliente junta

un bloque de 4 KB. Se recomienda elevar el tamaño del bloque a 8192 bytes

para lograr mayor performance.

Otra técnica utilizada para mejorar la performance es el uso de cache, los

servidores guardan datos en cache para evitar accesos al disco. Los clientes,

mantienen dos caches, una para los atributos del archivo (i-nodos) y otra para

los datos. Cuando se necesita un i-nodo o un bloque de archivo, se verifica

primero si está en cache, si es ası́ se evita el tráfico de red.

Mientras que la cache en el cliente ayuda a mejorar la performance, introduce problemas de consistencia. Si dos clientes tienen en cache la misma

porción de un mismo archivo, y uno de ellos la modifica, cuando el otro lea

el bloque leerá información vieja. La cache no es coherente. NFS trata de

evitar este problema del siguiente modo:

asocia a cada bloque en cache un contador de tiempo, cuando el mismo

expira (normalmente 3 segundos para bloques de datos y 30 segundos

para directorios) se descarta la entrada;

cuando se abre un archivo que esta en cache envı́a un mensaje al servidor para averiguar cuándo fue modificado el archivo por última vez, si

la misma ocurrió luego de la copia en cache la misma se descarta y se

trae la nueva información;

cada 30 segundos expiran los datos de la cache y todos los bloques que

han sido modificados se envı́an al servidor.

En resumen, NFS ha sido muy criticado pues mientras que un cliente

escribe un archivo puede o no ser visto por otro que lo está leyendo, dependiendo del tiempo. Cuando se crea un archivo puede no ser visto por el resto

de los clientes hasta pasados 30 segundos. La semántica del acceso a archivos

no está bien definida, si un conjunto de programas cooperativos se ejecutan

varias veces podrı́an dar distintos resultados dependiendo del tiempo.

2.4.3.

Parallel Virtual File System - PVFS

PVFS es un sistema de archivos paralelo cliente/servidor en el cual los

archivos se distribuyen en forma transparente en discos de múltiples servidores. Su caracterı́stica principal es que a través de él las aplicaciones paralelas pueden acceder velozmente a los datos. Provee tres servicios básicos

a los usuarios:

un espacio de nombres consistente entre los nodos del cluster que permite a los programadores acceder a los archivos desde múltiples nodos;

distribución fı́sica de los datos entre los discos de los nodos que permite

evitar cuellos de botella tanto en la interface del disco como ası́ también en la red proveyendo mayor ancho de banda a los recursos de

entrada/salida (E/S);

18

interface de E/S que permite que los usuarios controlen cómo serán

distribuidos los datos y habilitar modos de acceso.

Figura 2.4: Diagrama del sistema PVFS [17].

Como se observa en la Figura 2.4 las máquinas que integran el sistema PVFS

pueden tomar uno o más de los siguientes roles:

Servidor Metadata. Existe un único servidor metadata por sistema de

archivos PVFS en el cual corre el demonio MGR. Contiene información correspondiente a los archivos y directorios que posee como ser

permisos, dueño, ubicación de los datos distribuidos en los servidores

de E/S. Es contactado por los clientes cuando necesitan leer un directorio o bien crear, eliminar, abrir o cerrar un archivo.

Servidor de E/S. Puede haber uno o más. Cada servidor de E/S (IOD)

aporta una porción de su disco local para integrar la partición PVFS.

Lleva a cabo las operaciones de acceso a los archivos sin intervención

del servidor metadata.

Cliente. Puede haber uno o más clientes. En ellos se corren las aplicaciones

que acceden a los archivos y directorios de la partición PVFS. Cuando

una aplicación desea abrir, cerrar, crear o eliminar un archivo se comunica directamente con el MGR a través de la biblioteca libpvfs. Una vez

que el servidor metadata localiza el archivo, le devuelve la ubicación a

la aplicación. Luego ésta puede utilizar la biblioteca para acceder directamente al servidor de E/S correspondiente para leer o escribir sin

necesidad de comunicarse con el MGR (ver Figura 2.5).

PVFS utiliza el protocolo TCP/IP para transmitir los datos. Las particiones PVFS pueden ser directamente accedidas por las aplicaciones a través

de la bibliotecas libpvfs.a, archivos de include y el archivo de configuración

pvfstab que indica cómo acceder a los ficheros PVFS. También se pueden utilizar las funciones ROMIO [36] como interface de E/S de MPICH las cuales

19

Figura 2.5: Flujo de metadata y datos en PVFS [17].

utilizan las bibliotecas mencionadas. Por otro lado, se puede acceder indirectamente a través del kernel, ver Figura 2.6. En este caso los clientes deben

utilizar:

el demonio pvfsd que se encarga de las transferencias a través de la red,

comunicación entre clientes;

el módulo del kernel pvfs.o registra en el kernel este tipo de fichero

PVFS permitiendo que los archivos PVFS sean accedidos a través de

las clásicas llamadas al SO. Este módulo es el que permite que los

programas comunes accedan a particiones PVFS que estén previamente

montadas;

el dispositivo /dev/pvfsd es utilizado como punto de comunicación entre

el módulo pvfs.o y el demonio pvfsd;

el ejecutable mount.pvfs es utilizado por el comando mount para llevar

a cabo el proceso especı́fico de montar un fichero PVFS.

Figura 2.6: Flujo de datos a través del kernel [17].

Los clientes hacen uso transparente de la partición PVFS a cambio de

pérdida de performance debido al movimiento de datos entre el kernel y el

demonio pvfsd. Por eso existe la opción de utilizar directamente las bibliotecas PVFS, o a través de las funciones ROMIO, para que el programador

pueda especificar la distribución fı́sica del archivo y configurar particiones

20

lógicas, logrando ası́ mayor performance sobre todo en aplicaciones paralelas

que posean operaciones colectivas.

Los programas que estén desarrollados para utilizar funciones de entrada

y salida propias de UNIX (read, write), correrán también sobre una partición

PVFS sin necesidad de hacerles ningún cambio. Si se crea un archivo de este

modo será distribuido entre todos los servidores de E/S con las variables

default, porciones de 64 KB. Notar que en este caso, cada escritura o lectura

que se quiera realizar sobre dicho archivo involucrará a todos los servidores de

E/S. Con muchos accesos a pequeñas porciones no dará un buen resultado.

Por eso es conveniente utilizar las funciones de la biblioteca estándar (fread,

fwrite) que permiten definir el tamaño del buffer a utilizar. Generalmente el

PVFS tendrá mayor performance con tamaños de buffers grandes.

En la Figura 2.7 se presenta un ejemplo de cómo se distribuye un archivo

en una partición PVFS. Se puede definir en qué nodo se comienza a guardar el

archivo (base=1), cuántos servidores de E/S utilizará (pcount=4) y cuantos

chunks (grupos de igual cantidad de bytes) habrá contiguos en cada servidor

de E/S, strip size (ssize).

Figura 2.7: Ejemplo de distribución de un archivo en una partición PVFS [16]

Si el programador define particiones lógicas en un archivo, los accesos

subsiguientes a dichas regiones se harán en forma más eficiente. Dichas particiones, son útiles para programación paralela pues simplifican el acceso a

datos compartidos por un conjunto de tareas de una aplicación. Cada proceso

puede definir su propia partición lógica y una vez definida todas las operaciones de E/S verán únicamente los datos correspondientes a dicha tarea. Las

particiones se definen con tres parámetros: offset, distancia en bytes desde

el inicio del archivo hasta el primer byte de la partición; group size (gsize)

número de bytes continuos de una partición y stride distancia desde el inicio

de un grupo de bytes al siguiente. En la Figura 2.8 se muestran dos ejemplos

de particiones lógicas, en el caso (A) se desea que 4 procesos paralelos procesen un archivo de 40.000.000 registros de 1.000 bytes cada uno, entonces

cada proceso (0..3) configurará su offset de modo tal de particionar al archivo

en regiones disjuntas, 10.000.000 registros para cada uno, (B) otra opción de

particionamiento del archivo es repartir en forma cı́clica los registros (roundrobin), en este caso el group size será 1.000 bytes y la cantidad de registros

a saltear hasta el próximo perteneciente a la misma tareas es de 4.000 bytes

(stride size). También se pueden definir particiones lógicas para acceder a un

21

archivo en forma matricial.

Figura 2.8: Ejemplos de particiones Lógicas PVFS [16]

2.4.4.

Mosix File System con Direct File System Access - MFS con DFSA

MFS es un sistema de archivos para clusters que optimiza el uso de la

red migrando los procesos hacia el lugar donde se encuentran los datos en

vez de buscar los datos y traerlos hacia el proceso. Esto permite mejorar la

performance de entrada/salida y reduce la congestión de la red evitando el

uso de protocolos como ser NFS y PVFS entre otros. DFSA permite operaciones paralelas consistentes en diferentes sistemas de archivos. Este tipo de

sistema de archivos no se probará en este trabajo, solo se menciona a modo

informativo.

2.4.5.

Global File System - GFS

GFS [23] es un sistema de archivos compartido apropiado para clusters

con share storage (almacenamiento compartido de datos) que permite a los

clientes acceder a los mismos mientras que mantiene la consistencia de los

datos. Los nodos comparten espacio de almacenamiento, cache de datos y

control. El problema de este tipo de sistema de archivo es el alto costo del

hardware por lo tanto en este trabajo tampoco será probado. Su escalabilidad

aún no se conoce.

2.5.

Administración de Procesos

El cluster es utilizado por un grupo de usuarios heterogéneo, alumnos y

profesores de diversas áreas. Esto implica que el tipo de problemas que se

ejecutan en el cluster es variado y por lo tanto se necesita un método que

permita balancear la carga de procesos que se genera a partir de un conjunto

de usuarios con distintos requerimientos:

mucha memoria

22

poca memoria

mucho uso de CPU

poco uso de CPU

muchas horas de procesamiento

pocas horas de procesamiento

gran cantidad de pasaje de mensajes

poca cantidad de pasaje de mensajes

Es necesario aplicar polı́ticas de administración de procesos para optimizar el ’throughput’ de procesos y ası́ utilizar el cluster en forma óptima aumentando la disponibilidad de una máquina de alta performance para

un mayor número de investigadores. Para esto se utilizaron las aplicaciones

’Portable Batch System’ (PBS) como administrador de procesos y ’MAUI

Scheduler’ que permite definir polı́ticas para decidir qué proceso de la cola

se ejecutará y en qué momento.

2.5.1.

Portable Batch System - PBS

PBS [10] es un sistema de control de ejecución de procesos y de asignación

de recursos a los mismos (cpu, memoria, cantidad de procesadores, tiempo

de ejecución de CPU, tiempo total de ejecución de un proceso ’walltime’).

Como tal, aceptará procesos ’batch’, un script escrito en shell, atributos de

control y se encargará de preservar y proteger el proceso hasta que el mismo

comience su ejecución, se ejecute y devuelva la salida a quien le solicitó la

ejecución del proceso. PBS consiste básicamente en cuatro componentes:

1. Comandos de:

usuario permiten enviar a ejecutar procesos, monitorearlos, modificarlos y borrarlos (qsub, qstat, qalter y qdel)

operador este tipo de usuario tiene más privilegios que los usuarios

comunes, puede encender y apagar colas, bajar y levantar el servidor, modificar o borrar procesos de usuarios (qdisable, qenable,

qrun, qstart, qstop, qterm, pbs_mom, pbs_server y pbsnodes)

administrador posee el máximo nivel de privilegios, puede realizar

todas las operaciones anteriores y además puede modificar la configuración de las colas y del servidor (qmgr, qenable, qrun)

2. ’Job Server’ (demonio pbs server) corre en el nodo ’master’, su función

principal es proveer los servicios básicos como ser recibir/crear un proceso ’batch’, modificarlo, protegerlo de ’system crashes’ y ejecutar el

proceso.

3. ’Job Executor’ (demonio pbs mom) este demonio es quien realmente se

encarga de poner el proceso en ejecución cuando recibe una copia del

mismo enviada por el pbs server. También tiene la responsabilidad de

devolver la salida del proceso al usuario cuando el servidor se lo indica.

23

4. ’Job Scheduler’ (MAUI scheduler) Es quien controla, según las polı́ticas

definidas, qué proceso corre, cuándo y dónde. PBS tiene tres posibles ’schedulers’ para habilitar pero son básicos y no permiten definir

polı́ticas precisas como el MAUI.

2.5.2.

MAUI Scheduler

El encolador MAUI [11] es un sistema avanzado de encolamiento de procesos por lotes, adecuado para la computación cientı́fica en gran escala o,

en su versión actual, computación de alta performance (High Performance

Computing - HPC). Fue diseñado para correr sobre plataformas Alpha e Intel, con sistemas operativos IBM SP y Unix/Linux y puede utilizar distintos

administradores de recursos entre ellos PBS (Portable Batch System).

’MAUI Scheduler’ provee un mecanismo para enviar a ejecutar procesos,

ejecutarlos y hacer un seguimiento del estado del mismo en un sistema con

recursos compartidos. Esta tarea es muy importante en un ’batch system’

que provee acceso centralizado a recursos distribuidos. Además de proveer

una visión global de los recursos del cluster, MAUI puede administrar dichos

recursos de manera justa y efectiva. Permite definir polı́ticas de asignación

de los recursos, qué proceso corre, dónde y cuándo maximizando el ’throughput’ del sistema. MAUI soporta un sistema de reserva de recursos avanzada,

niveles de calidad de servicio (QOS), métodos para optimizar la distribución

de procesos en la arquitectura del sistema (’backfill’) y administración de

asignación de los recursos en general (’allocation management’). Su esquema

de ’scheduling’ está basado en un concepto avanzado de reserva de tiempo

(’walltime’) combinada con ’backfill’. La principal diferencia con respecto a

otros encoladores (e.g. NQS, DQS) es que MAUI permite que algunos procesos de menor prioridad se ejecuten antes que otros de mayor prioridad si y

solo si no se produce un retraso la ejecución de mayor prioridad.

Los comandos disponibles para todos los usuarios son:

showq muestra información sobre procesos: en ejecución, ociosos, no encolados (son aquellos enviados al sistema pero que están considerados no

elegibles, no pueden ganar prioridad)

showbf muestra los recursos disponibles

showstart jobid muestra el tiempo aproximado de iniciación del proceso

checkjob jobid muestra detalles sobre los procesos encolados. Los usuarios

pueden ver solamente el estado de sus propios procesos.

2.5.3.

Interacción entre PBS y MAUI

MAUI Scheduler es un conjunto de funciones que permiten un ’schedule’

racional y capacidades de ’backfill’ utilizando un administrador de recursos

del sistema, PBS. PBS es un sistema de administración de procesos que

provee información de los recursos de la máquina al MAUI y se encarga de

ejecutar los procesos según las indicaciones del mismo. La Figura 2.9 muestra

un esquema que explica en forma sintética la interacción entre PBS y MAUI.

24

Figura 2.9: Interacción entre PBS y MAUI

En sı́ntesis:

el usuario envı́a a encolar un proceso con el comando qsub al PBS server

MAUI consulta al PBS server en forma periódica acerca de los procesos

encolados

MAUI consulta a los PBS moms para saber el estado de los recursos

del sistema

MAUI en base a los requerimientos de los usuarios y a sus reglas predefinidas, asigna prioridades y ordena la ejecución de los procesos.

2.6.

Herramientas de programación

2.6.1.

MPICH

El paradigma de pasaje de mensajes Message Passing Interface - MPI [26],

es utilizado usualmente en distintas clases de computadoras paralelas, especialmente en aquellas que poseen memoria distribuida. Es un estándar de

funciones para llevar a cabo el pasaje de mensajes en la programación paralela. Puede invocarse desde C y Fortran. Una función de pasaje de mensajes

se encarga simplemente de transmitir datos de un proceso a otro a través de

la red. MPICH [26] es una de las tantas implementaciones de MPI que actualmente se encuentran disponibles y la que está instalada en el cluster Speedy.

Provee los siguientes tipos de operaciones descriptas en detalle en [25]:

Combinación de contexto y grupos de mensajes a través de un comunicador

Comunicación punto a punto

• estructuras de buffers y tipos de datos

• modos de comunicación: normal (bloqueante y no bloqueante),

sincrónica, buffered

25

Comunicación Colectiva

• gran variedad de rutinas para pasar datos entre procesos

• definición de grupos

Control de errores

En los sistemas UNIX, MPICH utiliza la biblioteca llamada p4 [27, 28]

como interface sobre la capa TCP. Las transferencias de datos sólo se llevan a cabo durante las llamadas a las funciones de la biblioteca MPICH.

Se puede optimizar el uso de la biblioteca p4 mediante la configuración

de diversas variables en el entorno del usuario. Por ejemplo, la variable

P4 SOCKBUFSIZE se utiliza para definir el tamaño del buffer para el socket,

se define en bytes. Se recomienda actualizar el valor por defecto que tiene la

variable P4 SOCKBUFSIZE de 32 KB por 128 KB, esto permite aumentar

el throughput de MPI [30].

Por otro lado, se puede optimizar el uso del protocolo TCP utilizando

la opción -p4sctrl al ejecutar un trabajo por lı́nea de comandos. Dicha opción permite definir distintas caracterı́sticas del socket TCP, pero sólo se

recomienda modificar el bufsize, en este caso se define en KB [30, 31]. Por

ejemplo, si se quiere definir el buffer del socket en 64 KB (por defecto es de

16 KB), se debe ejecutar:

# mpirun -np 2 mpptest -p4sctrl bufsize=64

Es importante mencionar que la biblioteca p4 utiliza tres protocolos de

pasaje de mensaje dependiendo del tamaño del paquete a transmitir [29].

Ellos son: Short los datos son enviados junto con la información de control

(menor o igual a 16 KB), Eager los datos son enviados sin esperar que el

receptor los pida (entre 16 y 128 KB) y Rendezvous los datos no serán

enviados hasta que el receptor los pida (mayor a 128 KB). Esta estrategia en

el tratamiento de los paquetes se realiza con el fin de optimizar la latencia en

el envı́o de mensajes cortos y alcanzar mayor ancho de banda para los largos.

2.6.2.

ROMIO

ROMIO [36] es una implementación de funciones para manejo de E/S de

alta performance portable a MPI-IO. Estas funciones pueden ser utilizadas

sobre distintos tipos de sistemas de archivos (NFS, PVFS, ufs - Unix file

system, linux ext3, etc.) Se caracteriza por la utilización de dos técnicas

novedosas para el manejo de datos:

data sieving Técnica para acceder eficientemente a bloques de datos no

contiguos cuando las funciones primitivas del fichero utilizado no pueden

hacerlo. Consiste en acceder a las regiones de datos no contiguas leyendo

un bloque de datos que contiene todas las regiones deseadas incluyendo

los datos que están superfluos y que no se necesitan. Las regiones de

interés serán extraı́das en el cliente. Esta técnica tiene la ventaja de

realizar una única transferencia de datos pero lee más datos de disco

que los requeridos y transfiere más datos por la red.

two phase I/O También llamada collective buffering, es una optimización

para operaciones colectivas de E/S. El conjunto de E/S independientes

26

que componen la operación colectiva, es analizado para determinar

que regiones deben ser transferidas (leı́das o escritas). Dichas regiones

serán distribuidas entre los procesos que finalmente interactuarán con

el fichero. Por ejemplo, en el caso de una lectura, los procesos encargados de recolectar los datos leerán sus regiones de disco y redistribuirán

los datos a sus ubicaciones finales. Mientras que en el caso de una escritura, los datos son recolectados primero por el proceso que pide la

escritura y luego son tomados por los procesos encargados de realizar

efectivamente la escritura a disco.

27

Capı́tulo 3

Experimentos y optimización

3.1.

Performance de Red

El diseño, construcción y utilización de un sistema de alta performance

requiere de la medición y optimización de la configuración de la red. En esta

sección se evaluará y optimizará la performance de red de Speedy mediante

la ejecución del benchmark de red NetPIPE descripto en el Apéndice B.1.

Además se compararán algunos de los resultados obtenidos en Speedy con los

clusters externos Meteoro y Mercurio descriptos en el Apéndice A.2 y A.3

respectivamente.

En el punto 3.1.1 se discute el throughput de TCP y en el 3.1.2 se plantea

el mismo análisis para el caso de MPICH. La influencia del tamaño de las

ventanas de congestión de TCP y el rendimiento de Speedy se analizan en el

punto 3.1.3. Finalmente, en el apartado 3.1.4 se compara la performance de

los diferentes clusters utilizados en este trabajo.

Para llevar a cabo estos experimentos se realizaron las pruebas con las

siguientes configuraciones:

una placa de 100 Mbps Fast Ethernet por nodo conectadas mediante

un switch Fast Ethernet

dos placas de 100 Mbps Fast Ethernet por nodo configuradas en bonding

interconectadas mediante un switch Fast Ethernet

una placa de 1000 Mbps Gigabit Ethernet por nodo conectadas con un

switch Gigabit Ethernet

una placa de 1000 Mbps Gigabit Ethernet por nodo conectados espalda

contra espalda.

Para materializar los cuatro escenarios en el cluster Speedy cuyo hardware

es heterogéneo, se tomaron los nodos 12 y 13 de iguales caracterı́sticas, ver

Apéndice A.1, Cuadro A.1. En los clusters externos Meteoro y Mercurio sólo

se probó Bonding y Gigabit respectivamente y se tomaron un par de nodos

al azar debido a que son clusters homogéneos a nivel de hardware.

3.1.1.

Mediciones de Throughput de TCP

Se desea evaluar el throughput de la red del cluster Speedy a nivel de

protocolo TCP. Para esto se utilizó el módulo tcp del benchmark NetPIPE.

28

Con los resultados obtenidos se realizaron los gráficos de throughput según

el tamaño de bloque transferido, de saturación de la red y de firma ethernet

(definidos más adelante). Éstos últimos permiten analizar el máximo tamaño

de paquete para el cual se logra un incremento en el throughput y la latencia

de la red respectivamente.

Se tomó la siguiente configuración para las ventanas de congestión de

TCP:

Fast Ethernet (FE) y Bonding (FEB) buffer de envı́o 16 KB,

Gigabit Ethernet (GE) buffer de envı́o 64 KB,

en ambos casos el buffer de recepción es de 85 KB. El buffer de envı́o para GE

se configuró modificando las variables de configuración del socket TCP del

sistema operativo Linux, descriptas en el Apéndice C, según el Cuadro C.1.

Por otro lado, en el caso en que se conectan las máquinas espalda contra

espalda, se realizaron mediciones para MTU de 3000 y 9000 bytes. Esto

pudo llevarse a cabo pues las placas de red permitı́an el uso de jumbo frames,

tamaño de datagramas mayores a 1500 bytes. Se tomó un cable cruzado y

se conectaron las dos máquinas espalda contra espalda. Con el comando de

linux ifconfig se configuraron los distintos tamaños de MTU, por ejemplo

para 3000 bytes se ejecutó:

# ifconfig eth0 mtu 3000

La Figura 3.1 muestra el throughput en función del tamaño de

bloque transferido. A simple vista, se pueden observar las mejoras resultantes al incrementar la capacidad del medio de comunicación entre los

nodos. Sin embargo, pese a utilizar placas y switch GE el mejor resultado no

alcanza los 350 Mbps.

Con respecto a GE y a la variación en el tamaño del MTU, si se aumenta a 3000 bytes se logra una mejora pareja de 20 Mbps comparada con

1500 bytes. También se logra una mejora similar con 9000 bytes, pero su

comportamiento es un poco inestable y por debajo del caso de 3000 bytes.

Es posible que el procesador no sea lo suficientemente rápido para realizar

los cálculos que requiere TCP/IP para poder utilizar la capacidad de ancho

de banda que provee GE. Al utilizar jumbo frames, se realiza menor cantidad

de cálculo TCP/IP para enviar o recibir la misma cantidad de datos. Esto

permite que el procesador pueda enviar más datos con la misma cantidad de

cálculo obteniendo un throughput mayor al utilizar jumbo frames. Por otro

lado, también se probó el MTU por defecto, 1500 bytes, con las máquinas

conectadas espalda contra espalda obteniendo el mismo resultado que cuando

se utiliza el switch Gigabit Ethernet. De aquı́ se concluye que la limitación

en el throughput no depende de él.

Todos los casos están prácticamente superpuestos para paquetes de tamaño

menor o igual a 8 bytes, esto se debe a que para paquetes tan pequeños el

benchmark envı́a un sólo paquete TCP muchas veces y devuelve el promedio

de la latencia obtenida. Estos casos no son útiles para analizar el throughput. También se observa que para cada caso la función crece abruptamente

en cierto intervalo de tiempo, es allı́ donde se obtiene un throughput sustancialmente mayor al incrementar el tamaño del bloque. Luego de dichos

29

intervalos, no se logra mayor beneficio al incrementar el tamaño del paquete.

Esta última observación se puede ver gráficamente realizando un gráfico de

saturación de la red.

El gráfico de saturación de la red [32], Figura 3.2, se obtiene de graficar

el tamaño de bloque versus el tiempo ambos en escala logarı́tmica. Se define

como punto de saturación aquel a partir del cual al incrementar el tamaño del

bloque el tiempo crece linealmente. El punto de saturación para FEB y GE,

en todos los tamaños de MTU presentados, es cuando el paquete es de 4 KB

mientras que para FE es de 2 KB. El intervalo de tiempo luego del punto de

saturación se determina intervalo de saturación. En este intervalo el gráfico

crece a velocidad constante, por lo tanto a partir de allı́, el throughput de la

red no puede mejorarse incrementando el tamaño del bloque.

Finalmente, se observa la latencia de la red mediante el gráfico de

firma ethernet [32], Figura 3.3. Se grafica el throughput versus el tiempo de

transferencia en escala logarı́tmica obteniendo ası́ un gráfico de aceleración

de la red. La latencia de la red coincide con el primer punto de tiempo. Se

observa mayor latencia para el caso de FE y FEB con 47 µs, luego sigue el

caso de GE con MTU igual a 1500 bytes con 30 µs siendo el mejor caso para

GE con MTU de 3000 y 9000 bytes con 26 µs cada uno.

Figura 3.1: Throughput de Speedy para tamaño de buffers default de sockets

TCP. Referencias: (F)ast, (E)thernet, (B)onding, M(PICH), (G)igabit.

30

Figura 3.2: Gráfico de Saturación Ethernet del cluster Speedy.

Figura 3.3: Gráfico de Firma Ethernet del cluster Speedy.

31

3.1.2.

Mediciones de Throughput de MPICH

En esta sección se desea evaluar el throughput de red de las funciones de

envı́o y recepción de mensajes de MPICH en el cluster Speedy. Para esto se

utilizó el módulo mpi del benchmark NetPIPE. Los resultados obtenidos se

analizan a partir de los gráficos de throughput según el tamaño de bloque

transferido, de saturación de la red y de firma ethernet presentados en la

sección anterior.

La Figura 3.1 muestra el throughput versus el tamaño de bloque

transferido. Se graficaron los resultados para MPICH en Fast Ethernet

(FE), Bonding (FEB) y Gigabit (GE) con MTU=1500 bytes. En el último

caso, se modificó la variable P4 SOCKBUFSIZE, explicada en el Capı́tulo 2.6.1 y se ejecutó el benchmark para buffers de 32 KB y 128 KB. Para las

pruebas de las funciones de MPICH a primera vista se observa que la performance se degrada en comparación con los resultados obtenidos para TCP.

Esto se debe al overhead que se agrega sobre el protocolo TCP al implementar

funciones de pasajes de mensajes más simples para uso del programador.

En las pruebas de MPICH con su configuración de buffers de envı́o y

recepción de mensajes por defecto (32 KB), el throughput disminuye en

promedio: 18 % para GE, 13 % para FEB y 11 % para FE. Para GE también se evaluó la performance de MPICH incrementando el buffer mediante

la variable P4 SOCKBUFSIZE a 128 KB. Se logró en promedio una mejora

del 10 % sobre el caso por defecto para paquetes mayores o iguales a 16 KB.

Notar que el pico más alto se alcanza para paquetes mayores o iguales a

128 KB. Esto se debe al protocolo que utiliza la interface P4 para envı́o de

mensajes descripto en el Capı́tulo 2.6.1. Es en ese punto donde comienza a

utilizar el protocolo Rendezvous. A pesar que el que envı́a el paquete tiene que

esperar a que el receptor los pida, se logra un incremento en el throughput

gracias al gran tamaño de los mensajes transmitidos. Para paquetes menores

a 16 KB utiliza el protocolo Short, entre 16 y 128 KB el Eager. Finalmente,

se decide dejar configurada la variable P4 SOCKBUFSIZE en 128 KB para

todos los usuarios del sistema.

En el gráfico de saturación de la red [32], Figura 3.2, se observa que los

puntos de saturación de MPICH coinciden con los de TCP. Siendo de 4 KB

para FEB y GE, mientras que para FE es de 2 KB. Aquı́ nuevamente en el

intervalo de saturación el gráfico crece a velocidad constante, por lo tanto

a partir de allı́, el throughput de MPICH no puede mejorarse considerablemente incrementando el tamaño del bloque.

Finalmente, se observa la latencia de MPICH mediante el gráfico de

firma ethernet [32], Figura 3.3. Se observa mayor latencia para el caso de FE

y FEB con 70 µs, luego sigue el caso de GE con MTU igual a 1500 bytes con

47 µs. Notar que la latencia de un mensaje de MPICH en GE es tan grande

como la latencia TCP en FE y FEB y la latencia para FE y FEB de MPICH

siguen siendo iguales entre si.

32

3.1.3.

Influencia del tamaño de las ventanas de TCP

Se realizaron mediciones variando el tamaño de las ventanas TCP. No

se obtuvieron grandes diferencias para FE y FEB pero sı́ para GE. En la

Figura 3.4 se muestran los datos obtenidos para GE para cada uno de los

tamaños de MTU evaluados (1500, 3000 y 9000 bytes). La configuración por

defecto corresponde a tamaños de 16 KB y 85 Kb para los buffers de envı́o

y recepción respectivamente y def2 cambia el tamaño del buffer de envı́o por

64KB, el resto tienen el mismo tamaño para ambos buffers. El throughput

de MPICH se muestra para buffers de 32 KB y se evaluaron las operaciones

de envı́o y recepción de mensajes sincrónicas. En los tres gráficos podemos

agrupar las pruebas en casos según su comportamiento:

1. buffers de 256, 512 y 1024 KB

2. buffers default y 128 KB

3. buffers de 64 KB

4. buffers def2

5. MPICH

Si se compara el gráfico de MTU igual a 1500 bytes con el de 3000, se

observa que cada uno de los casos se comportan proporcionalmente igual,

ganando entre 20 y 25 Mbps para MTU de 3000 bytes. Sin embargo para

MTU igual a 9000, MPICH se comporta muy irregular y los casos 2, 3 y 4

se unen sin alcanzar la performance del caso def2 de la Figura 3.4 (b). Sólo

para el caso 1, MTU igual a 9000 muestra mayor performance para tamaños

de paquetes mayores a 128 KB pero a pesar de ello, en el recorrido hasta

allı́ presenta escalones irregulares.

Del análisis de estos tres gráficos surge que la configuración con MTU=3000

bytes es óptima y estable, sin embargo no es posible llevarla a la práctica debido a que la norma IEEE 802.3 impone una MTU máxima de 1500 bytes

de carga útil que respetan los switches comerciales. Solo unos muy pocos

equipos permiten el empleo de MTU mayores. Una última observación respecto a esta figura es que al ampliar la ventana de escritura por defecto de

16 KB a 64 KB, según las recomendaciones del documento [35], se obtuvo

una mejora de un 5 % para paquetes mayores a 128 KB. El cluster Speedy

quedó con esta última configuración.

3.1.4.

Comparación entre diferentes clusters

Por último, se comparan los resultados obtenidos en el cluster Speedy con

los extraı́dos de los clusters Meteoro y Mercurio de tecnologı́as más modernas, ver Apéndice A. El cluster Meteoro, está configurado en bonding y no

presentó diferencias para TCP, sin embargo mostró mejor performance que

Speedy en MPICH. Esto puede ocurrir debido a que el sistema necesita mayor

poder de procesamiento y memoria para manejar el bonding y ejecutar un

programa paralelo, caracterı́sticas que posee el cluster Meteoro. El cluster

Mercurio posee una red gigabit ethernet y máquinas aún más potentes que

los dos clusters anteriores, procesador de 2.8 GHz, memoria cache de nivel

33

Figura 3.4: Throughput de red para distintos tamaños de ventanas de congestión

TCP (A) MTU=1500, (B) MTU=3000 y (C) MTU=9000.

34

3 de 2 MB, FSB de 800 MHz, 4 GB de RAM y un bus PCI (sin bridge

PCI) de 64 bits/100 MHz, la placa de red negocia a 66 MHz. Se observa una

performance de un 64 % superior al cluster Speedy. Puede observarse que el

throughput alcanzado en el cluster Mercurio es del orden de 900 Mbps. Según

el bus PCI que posee, resulta en un máximo ancho de banda teórico de:

PCIb = 64 bits × 66 MHz = 4224 Mbps

En este caso, la placa de red sólo utiliza el 21 % del ancho de banda

disponible. En el caso de Speedy, se utiliza un 16 % del mismo. Comparando

el máximo throughput del cluster Speedy con Mercurio, este último es 2,5

veces mayor, se debe tener en cuenta que no solo el bus PCI tiene el doble de

capacidad sino también posee un FSB 3 veces mayor, tres niveles de cache

en vez de dos y 8 veces el tamaño de la cache.

Figura 3.5: Comparación del throughput entre los clusters Meteoro, Mercurio y

Speedy. Referencias: (F)ast, (E)thernet, (B)onding, M(PICH), (G)igabit.

3.2.

Performance de Sistemas de Archivos

Se quiere probar la performance de los distintos tipos de sistemas de

archivos configurados en el cluster Speedy Gonzalez. El análisis de los mismos servirá para que los usuarios puedan mejorar la performance de sus

procesos utilizando eficientemente las funciones de E/S disponibles. Se utilizarán los benchmarks: Bonnie [39], Babieca [40], perf y coll perf [36] para

evaluar distintos aspectos, ver Apéndice B.2.

En las pruebas básicamente se compara la velocidad de acceso (MBps)

a los distintos sistemas de archivos local de Unix ext3, NFS (versión 3) y

PVFS (versión 1.6.2). Los sistemas Mosix y GFS no se implementaron en

35

el cluster Speedy González, el primero debido a que para implementarlo se

debe recompilar el kernel para que éste aplique balance de carga en forma

automática y transparente para el usuario y ese no era el objetivo de nuestro

trabajo, el segundo por ser un tipo de sistema de archivo implementado en

mainframes.

Para poder utilizar ROMIO sobre NFS, la función fcntl debe funcionar

correctamente sobre NFS. En algunas instalaciones, dicha función no funciona. Para asegurase que no exista este problema, se debe utilizar la versión

3 de NFS y montar el sistema de archivos con la opción noac (no attribute

caching). La misma quita la opción de ’caching’ del NFS lo cual puede reducir la performance, pero es necesario para un comportamiento adecuado

[37]. Todas las pruebas de acceso a archivos se realizaron con el switch de

gigabit ethernet y con la configuración TCP actualizada según el Cuadro C.1.

3.2.1.

Benchmark Bonnie

El benchmark Bonnie, descripto en el Apéndice B.2.2, se utiliza para

medir la performance de operaciones de acceso a los sistema de archivos Unix.

Fue diseñado para hallar cuellos de botella en los servidores de aplicaciones.

Aquı́ se ejecutó en todas las máquinas del cluster, para cada tipo de fichero

disponible y con distintos tamaños de archivo en MB: 32, 64, 128, 256, 512

y 1024. Sin embargo, de todos los resultados obtenidos, se seleccionó como

tamaño de archivo 1 GB para el mejor caso correspondiente a speedy12,

Athlon 1200 MHz con 512 MB de RAM. El resto de las máquinas en los

distintos tamaños de archivo se comportaba igual que ésta para cada tipo

de fichero, pero su performance se mantenı́a o disminuı́a en proporción a los

Hzs del CPU.

Cuadro 3.1: Throughput de accesos al sistema de archivos. Las búsquedas aleatorias están dadas en cantidad de búsquedas por segundo. Benchmark Bonnie.

En la Figura 3.6 se pueden observar los resultados obtenidos en un gráfico

de barras. En todos los casos, la mejora alcanzada por PVFS se debe a la

metodologı́a que utiliza para realizar el acceso a los datos explicada en la

Figura 2.5. El archivo será distribuido en la partición PVFS como se muestra

en la Figura 2.7 con base aleatoria entre 1 y 15, pcount=15 y ssize=64 KB.

Las escrituras y lecturas a caracter realizadas en el fichero NFS con

bloques de 4 KB son 1,9 % y 3,3 % respectivamente más veloces que las

realizadas con bloques de 8 KB. Sin embargo, para la re-escritura, escritura

y lectura por bloques, esta relación se invierte. En el caso de la escritura

a caracter, Bonnie escribe el archivo invocando 1024 millones de veces a

36

la macro putc(). En NFS con bloques de 4 KB alcanza una velocidad de

5799 KBps, con lo cual, se escribirá el primer bloque NFS aproximadamente a

los 0,71 segundos después de realizada la primer llamada a la macro. Además,

mientras se realiza la escritura a través de NFS, paralelamente el benchmark

sigue escribiendo caracteres en cache. En cambio, cuando el bloque NFS

está configurado en 8 KB, la función putc() se invoca a una velocidad menor

de 5686 KBps realizando la primer escritura del primer bloque 1,44 segundos

después de realizada la primer llamada a la macro. Esta diferencia de tiempos

sumado al paralelismo entre operaciones NFS y el loop del benchmark Bonnie

para realizar las escrituras en cache, es la que hace la diferencia final. En el

caso de PVFS, por cada loop en cache se escribirá un bloque de 64 KB

en el nodo de E/S que corresponda siguiendo la estructura definida. Al ser

distintos nodos los que se encargan de la escritura se logra una mejora del

35 % sobre NFS. Se debe resaltar que las operaciones por caracter consumen