SUMA DE VARIABLES ALEATORIAS

Anuncio

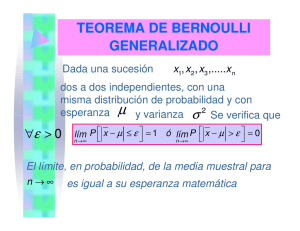

Desigualdad de Tchebyshev Si la Esperanza y la varianza de la variable X son finitas, para cualquier número positivo k, la probabilidad de que la variable aleatoria X esté en el intervalo k ; k es mayor o igual que 1- 1 es decir 2 k La probabilidad 1 de que X P x k ; k 1ó 2 asuma un k valor que 1 está dentro P x k 1- 2 de las k k dispersiones de su 1 esperanza, 1 1 k 0 la P x k 2 k2 es por lo k menos O también por ser sucesos contrarios Consideraciones 1)Si k 1 1 1 1 0 y 1 2 2 k k Entonces la desigualdad de Tchebyshev es trivial para valores de k < 1, ya que 0< p < 1 2) El significado de esta desigualdad reside en su completa universalidad, ya que puede ser aplicada a cualquier variable aleatoria 3) Si conocemos la distribución de probabilidades de una variable aleatoria discreta o continua, podemos calcular, si existen, E(x) y V(x). La recíproca no es cierta, es decir, conociendo E(x) y V(x), no podemos reconstruir la distribución de probabilidades, por lo que no podemos calcular la probabilidad de la desigualdad, pero si podemos dar una cota superior o inferior de dicha probabilidad Ejemplo ¿Cuál es la probabilidad que se asocia con valores de x alrededor de su media hasta 2σ? P x 2 ? x 0 1 2 3 4 P(x) 0,05 0,2 0,4 0,25 0,1 P x 2 P x 2,15 2.1,0136 P x 2,15 2,0272 P 0,1228 x 4,1772 P( x 1) P( x 2) P( x 3) P( x 4) Supongamos no conocer la distribución de X, pero si su esperanza y varianza. Podemos aplicar Tchebysheff 0,2 + 0,4 + 0,25 + 0,1 = 0,95 P x 2 1 P x 2,15 2.1,0136 1 1 k2 1 3 0,75 22 4 Ley de los grandes números Teorema de Bernoulli Cuando el número de repeticiones de un experimento aleatorio aumenta, la frecuencia relativa del suceso A converge en sentido probabilístico a la probabilidad teórica P(A) fA P( A) para n La probabilidad de que la frecuencia relativa del éxito en n pruebas, difiera de la probabilidad p en una cantidad menor que , tiende a uno cuando la cantidad de pruebas tiende a infinito. • En una sucesión de pruebas de Bernoulli • Dado un número positivo arbitrario, lim P fA p 1 0 n lím P fA p 0 0 n En toda sucesión de pruebas de Bernoulli, la frecuencia relativa converge en sentido probabilístico a la probabilidad Demostración Dado un experimento y un suceso A asociado a dicho experimento, consideramos n repeticiones independientes del experimento, x es el número de veces que ocurre A en las n repeticiones, además P(A) = P en cada repetición. x fA n Es una variable aleatoria binomial E x np y V x np 1 p 1 x 1 E fA E E x n.p p n n n p 1 p 1 x 1 V fA V 2 V x 2 n.p 1 p n n n n Aplicando la desigualdad de Tchebyshev a la variable aleatoria fA p 1 p 1 P fA p k 1 2 n k 1 P fA p k 1 2 k Como 0 consideramos p 1 p k n 2 k2 1 P fA p 1 n 2 p 1 p límP f n A p p 1 p n n 2 k2 p 1 p P fA p 1 p 1 p lím 1 1 2 n n límP f n p 1 p n 2 A p 1 Población y Muestra Una variable aleatoria X con E(x) = µ y V(x) =σ2 puede pensarse como cualquier característica medible de los individuos de una población. El conjunto de todas las mediciones de dicha variable es la Población o Universo. x1, x2 , x3 ,.....xN Muestra es un subconjunto de la población al que tenemos acceso y sobre el que realmente hacemos las mediciones x1, x2 , x3 ,.....xn Cada una de estas mediciones son valores que toman las variables aleatorias X1, X 2 , X3 ,..... X n Estas variables forman una muestra aleatoria de tamaño n si: •Las Xi son variables aleatorias independientes. •Cada variable Xi tiene la misma distribución de probabilidad que la distribución de la población con su misma esperanza µ y varianza σ2., es decir E(xi) = µ y V(xi) = σ2 TEOREMA DE BERNOULLI GENERALIZADO Dada una muestra aleatoria, es decir: una sucesión de v.a. x1, x2, x3, x4,…..xn dos a dos independientes, con una misma distribución de probabilidad y con esperanza μ y varianza σ2, entonces 0 lím P x 1 ó lím P x 0 n n El límite, en probabilidad, de la media muestral para n es igual a la media de la población de la que se extrajo la muestra Demostración x1, x2 , x3 ,.....xn Son variables aleatorias independientes con esperanza y varianza de la población de donde fueron extraídas x n i 1 xi n E ( xi ) y V ( x i ) 2 Es una función de x1, x2 , x3 ,.....xn Por lo tanto es otra variable aleatoria. 1 n xi 1 n E x E E xi .n. n i 1 n n i 1 1 xi 1 2 V x V 2 V xi 2 .n. n n i 1 n n i 1 n n 2 Aplicando la desigualdad de Tchebyshev Consideramos k. n 1 P x k. 1- k 2 n 2 P x k. 1- n 2 n k 2 n 2 2 1 P x k. 1- n 2 n 2 ó P x < 2 n 2 Aplicando Límite para n tendiendo a infinito 2 lím P x lím 1 2 n n n lím P x 1 n ó 0 lím P x 0 n El teorema se puede generalizar a variables aleatorias con distintas esperanzas y varianzas. SUMA DE VARIABLES ALEATORIAS Teorema del límite central El teorema afirma que, con ciertas restricciones leves, la distribución de la suma de un gran número de variables aleatorias, tiene aproximadamente una distribución normal. El valor de este teorema es que no requiere condiciones para las distribuciones de las variables aleatorias individuales que se suman. Enunciado del TLC Si S es la suma de un gran número de variables aleatorias independientes x1, x2 , x3 ,.....xn entonces, bajo ciertas condiciones, la función de densidad de probabilidad de la variable aleatoria S se distribuye normalmente, para n tendiendo a infinito. n Es S i i 1 n z ~ N 0,1 decir, n entonces S xi i2 i 1 i 1 n donde E (s ) i i 1 (S ) n 2 i i 1 Esta generalización es válida cuando las variables aleatorias individuales sólo hacen una contribución relativamente pequeña a la suma total En particular, si las xi están idénticamente distribuidas E xi n n E (S ) E xi E xi n. i 1 i 1 V xi 2 n n V (S ) V xi V xi n. 2 i 1 i 1 Por ser las xi independientes. Entonces el teorema afirma que la fdp de la variable S se distribuye normalmente S n Luego z n . ~ N 0,1 Ejemplo 1 Supóngase que un proceso de fabricación produce lavadoras de las cuales, alrededor del 5% son defectuosas. Si se inspeccionan 100 lavadoras ¿Cuál es la probabilidad de que haya entre 2 y 6 lavadoras defectuosas? P 2 x 6 P x 3 P( x 4) P( x 5) 100 100 100 3 97 4 96 5 95 0,05 .0,95 0,05 .0,95 0,05 .0,95 0,4977 3 4 5 Comparemos el resultado del cálculo directo con el cálculo aproximado, es decir, aplicando el TCL: Aplicamos el TCL Calculamos E(x)=np=100.0,05=5 V(x)= np(1-p)=100.0,05.0,95= 4,75 65 25 P 2 x 6 0,46 1,38 4,75 4,75 0,6772 0,0838 0,5934 Comparamos con el resultado exacto 0,4977. No es una buena aproximación. Por ser x una variable discreta, calculemos 55 35 P (3 x 5) 4,75 4,75 0 0,92 0,5 0,1788 0,3212 Tampoco es buena aproximación Corrección por continuidad Para variables discretas, consiste en ampliar el intervalo en una unidad, es decir: 1 1 Si a x b a x b 2 2 5,5 5 2,5 5 P 2,5 x 5,5 4,75 4,75 0,4659 0,23 1,15 0,591 0,1251 Es una buena aproximación La distribución Binomial converge a la normal cuando n tiende a (teorema de de Moivre, caso particular del teorema central del límite) 1 1 Si a x b a x b 2 2 p(x) a -0.5 a b b + 0.5 Calculamos las probabilidades pedidas 14,5 15 a) P C 14,5 2,15 0,0158 0,23238 15,3 15 b) P C 15,3 1 1 1,29 0,23238 1 0,9015 0,0985 Consideraciones finales • El n que se requiere para aplicar el teorema central del límite en gran parte depende de la forma de la distribución de las variables aleatorias individuales que se suman •Si los sumandos están normalmente distribuidos , al aplicar el teorema central del límite, las probabilidades obtenidas son exactas. No importa n. •Si no se conoce la distribución de los sumandos, para n mayor o igual que 25, se obtienen buenas aproximaciones. •Si las variables aleatorias se distribuyen binomialmente, n >10 si p 0,5 tambien si p 0 ó 1 , n debe ser bastante mayor. Ejemplo 2 Una fábrica de productos alimenticios produce carne enlatada, con un peso medio de 250 grs y una varianza de 900 grs cuadrados por lata. Si los pesos de las latas son estadísticamente independientes. Las cajas contienen 60 latas. Se elige una al azar, hallar la probabilidad de que: a) El peso de la caja sea a lo sumo 14,5 kg. b) El peso de la caja sea al menos 15,3 kg. x i : es el peso de cada lata C: es el peso de la caja E( xi ) 250grs. V ( xi ) 302 grs 60 60 C xi E C E xi E ( xi ) 60.250 15.000grs 15kg. i 1 i 1 i 1 60 60 60 V C V xi V ( xi ) 60.900 54.000grs 2 i 1 i 1 (C ) 60.900 60.30 232,38grs 0,23238kg