2. MODELOS PROBABILISTICOS

2.1

2.1.1

Funciones de Probabilidad

Variable Discreta

Un modelo probabilístico de un experimento requiere asociar un valor de

probabilidad a cada punto del espacio muestral. En el caso de las variables aleatorias

discretas, la función que asocia una probabilidad a la variable se denomina función de

probabilidad de masa (fpm), y se designa por px(x0) . Esta función representa la

probabilidad que la variable aleatoria X tome el valor x0 en la realización del experimento.

Usualmente, la función de probabilidad de masa se representa por un gráfico de barras para

cada valor de la variable aleatoria.

Cualquier función matemática es una posible función probabilidad de masa siempre

que cumpla las siguientes dos propiedades que se derivan directamente de los axiomas de

probabilidad. En primer lugar, su valor debe estar comprendida entre 0 y 1 ya que

representa una probabilidad, y en segundo término la sumatoria para todos los posibles

valores de x debe ser unitaria, ya que representa la probabilidad del evento universal.

El concepto de función probabilidad de masa puede extenderse al caso de varias

variables. En especial, para dos variables, se define la función de probabilidad de masa

compuesta, como la probabilidad que los valores experimentales de la variable aleatoria X

e Y, al realizar un experimento sean iguales a x0 e y0 respectivamente y se designa por

pXY (x0, y0).

Análogamente al caso anterior, esta función tiene las siguientes propiedades :

∑∑ p

∀x ∀y

∑p

∀x

XY

XY

( x 0 , y0 ) = 1

( x0 , y0 ) = pY ( y0 )

∑p

∀y

XY

( x0 , y0 ) = p X ( x0 )

Las funciones pX(x0) y pY(y0) se denominan funciones de probabilidad de masa

marginales.

Dos conceptos adicionales de gran utilidad son la función de probabilidad

acumulada o función distribución acumulada (FDA) y la noción del valor esperado. Se

define función distribución acumulada (FDA) a la función que establece la probabilidad

que la variable aleatoria X tome valores menores o iguales a un valor dado en la

realización del experimento.

Prob( X ≤ x0 ) = PX ( x0 ) = ∑ p X ( x0 )

∀x

Esta función es siempre positiva, está comprendida entre 0 y 1 y es creciente,

debido a los axiomas de probabilidad y a las propiedades de la función probabilidad de

masa.

El valor esperado de una función bi-unívoca de una variable aleatoria X es la

sumatoria para todos los posibles valores de X del producto de la función por la fpm

evaluada en el mismo punto que la función.

E {g( x )} = ∑ g( x0 ) ⋅ p X ( x0 )

∀x

En particular, son importantes algunos casos especiales de la función g(x) como ser

el valor esperado de potencias enteras de x, los cuales se denominan momentos de x. Se

puede definir también, la potencia centrada con respecto al valor esperado o momento

central n-ésimo de x. El primer momento de x se conoce también como valor esperado o

promedio de x (E(x)) y el segundo momento central se conoce como varianza de x (sx2) :

E ( x n ) = ∑ x n ⋅ p X ( x0 )

∀x

E ( x ) = ∑ x0 ⋅ p X ( x0 )

∀x

sx2 = {E ( x − E ( x )) 2 } = ∑ ( x0 − E ( x)) 2 ⋅ p X ( x0 )

∀x

2.1.2

Variable Continua

La probabilidad asociada a una variable continua, está representada por la función

densidad de probabilidades (fdp). Si X es una variable aleatoria continua en el rango -∞ a

+ ∞ se define :

b

Prob(a ≤ x ≤ b) =

∫f

a

X

( x )dx

Siendo fX(x) = la función densidad de probabilidades.

La integral representa el área marcada (Figura 2.1), la cual es igual a la

probabilidad que el valor de la variable aleatoria x esté comprendido en el intervalo a, b.

Esta función tiene la propiedad de ser positiva y de encerrar un área unitaria bajo ella al

ser integrada para todo el rango de la variable aleatoria. Es decir, se cumple que :

+∞

0 < fX(x) < + ∞

∫

y

f X (x) dx = 1

−∞

f x (x)

x

a

b

Ilustración 2.1.2.1: Área que representa la Prob (a ≤ x ≤ b).

Es importante recalcar que en este caso la probabilidad de un evento, está asociada

al área bajo la curva de la función densidad de probabilidades y no al valor de la función,

lo cual implica que siendo X una variable continua, la probabilidad asociada a un valor

específico es nula y sólo se puede hablar de probabilidad asociada a un intervalo de la

variable.

Se define función de distribución acumulada (FDA) de la variable X a la

probabilidad de que la variable aleatoria sea menor o igual a un valor dado:

xo

Prob(x < x0) = FX (x0) =

∫

−∞

f x (x) dx

La función distribución acumulada mide la probabilidad que en una realización

cualquiera de un experimento el valor de la variable sea menor o igual al valor x0 y tiene

las siguientes propiedades:

Fx (+∞) = 1

Fx (-∞) = 0

Prob(a < x < b) = Fx (b) - Fx (a)

Fx (b) > Fx (a) para b > a

dFX ( x )

= f X ( x)

dx

Si un experimento queda definido por varias variables aleatorias, entonces las

probabilidades se determinan mediante una función densidad de probabilidades

compuesta.

Los valores esperados y los momentos se calculan mediante la integración del

producto de la función densidad de probabilidades por la función para todo el rango de la

variable aleatoria.

+∞

E(g(x)) =

∫

-∞

g(x) fX(x) dx

o bien en el caso de dos variables :

E(g (x,y)) =

+∞

+∞

-∞

-∞

∫ ∫

g (x, y) f(x,y) dx dy

En la Tabla 2.1 se resumen las expresiones para las funciones densidad de

probabilidades y funciones de distribución acumulada para los modelos de uso habitual en

los estudios hidrológicos.

Tabla 2.1.2.1: Funciones densidad y probabilidad acumulada

Función densidad de

probabilidades f (x )

o Función distribución acumulada

F (x)

Distribución

− xα− β

F (x ) = exp− e

Valores extremos

tipo I

(Gumbel o EV1)

Valores extremos

generalizados

(GEV)

1

x − u

F (x ) = exp− 1 − k

α

Rangos de variable

aleatoria y parámetros

−∞ ≤ x ≤ ∞

α >0

k

α >0

α

u + ≤ x ≤ ∞ Si k < 0

k

α

−∞ < x ≤u+

Si k >0

k

β −1

x −γ

a

x −γ

f (x ) =

exp−

a Γ(β )

a

Pcarson Tipo III

Si α > 0

x≤γ

Si α < 0

β −1

(

x / a)

x

f (x ) =

exp −

α Γ(β )

a

Gama:

Pearson Tipo III

con γ = 0

Exponencial:

Pearson Tipo III

con β = 1

Lognormal-2

(LN2)

x≥γ

f (x ) =

f (x ) =

1

x −γ

exp −

a

a

1 log x − α 2

1

exp−

β

2πβx

2

γ ≤x

0< x

Función densidad de

probabilidades f (x )

o Función distribución acumulada

F (x)

Distribución

Lognormal-3

(LN3)

Valores extremos

de dos

componentes

(TCEV)

Wakeby (WAK)

2.2

f (x ) =

Rangos de variable

aleatoria y parámetros

1 log(x − γ ) − α

1

exp−

β

2πβ .(x − γ )

2

γ <x

(

F (x ) = exp A1e − x / θ 1 − A2 e − x / θ 2

[

] [

x>0

θ1 > 0

)

θ2 > 0

x = m + a 1 − (1 − F (x )) − c 1 − (1 − F (x ))

b

−d

]

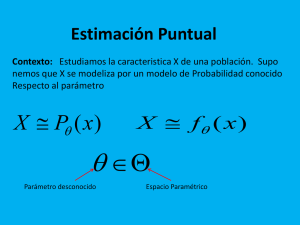

Estimación de Parámetros

Los modelos probabilísticos constituyen herramientas matemáticas para manejar

variables aleatorias y para asociar probabilidades a los distintos valores de ellas. El hidrólogo

al trabajar con registros observados requiere elegir el modelo más adecuado para representar

la muestra y además estimar los parámetros del modelo seleccionado. Una vez elegido el tipo

de modelo a emplear, se debe estimar, utilizando los registros observados, los parámetros del

modelo, para lo cual existen diversos procedimientos. Las metodologías usuales para ello son

el método de máxima verosimilitud, el método de los momentos, y el método de momentos

ponderados por probabilidad

2.2.1

Método de máxima verosimilitud

Se define como función de verosimilitud de n variables aleatorias x1, x2, x3,.........xn a

la función densidad de probabilidad conjunta de las n variables, g(x1, x2, x3,........xn, Q). En

particular, si x1, x2,......., xn es una muestra aleatoria de la función densidad f(x,Q) entonces,

la función verosimilitud es:

L(Q) = g(x1, x2,..., xn, Q) = f(x1,Q) f(x2, Q) ...... f(xn,Q)

La función de verosimilitud da entonces la probabilidad que las variables aleatorias

tomen valores particulares x1, x2,....... xn.

Si Θ es el valor de Q que maximiza L(Q) entonces, se dice que Θ es el estimador de

máxima verosimilitud de Q.

El estimador de máxima verosimilitud es la solución de la ecuación que anula la

primera derivada de la función de verosimilitud con respecto al parámetro. Para facilitar la

búsqueda del parámetro, se aprovecha la condición que las funciones L(Q) y su logaritmo

tienen sus máximos para el mismo valor de Q, ya que en algunos casos es más simple

encontrar el máximo del logaritmo de la función. El procedimiento de máxima verosimilitud

tiene ventajas teóricas para la estimación de los parámetros de un modelo, cuando las

muestras son de tamaño grande, pues entrega estimadores no sesgados, lineales y de mínima

varianza.

El cálculo de los parámetros de los distintos modelos por este procedimiento es más

complejo que por otros métodos, pues generalmente se debe resolver la ecuación resultante

por métodos iterativos, para encontrar el valor de los parámetros que maximizan la función

logarítmica presentada. Este cálculo requiere resolver el sistema de ecuaciones que se

forma al igualar a cero la primera derivada de la función de verosimilitud o del logaritmo

de dicha función, con respecto a cada uno de los parámetros. En la Tabla 2.2 siguiente se

muestran las expresiones para el logaritmo de la función de verosimilitud de varios

modelos probabilísticos.

Tabla 2.2.1.1:Logaritmo de las funciones de verosimilituD

Modelo

Logaritmo natural de la función

1 n ln xi − α

− n ln 2π − n ln β − ∑ ln xi − ∑

2 i =1

β

i =1

Log-normal-3

1 ln (xi − γ ) − α

− n ln 2π − n ln β − ∑ ln(xi − γ ) − ∑

2

β

n

Valores Extremos I

Valores Extremos

Generalizada

k (xi − u )

n ln α − ∑ exp ln1 −

α

i =1

1/ k

k (xi − u )

− (1 − k )∑ exp − ln1 −

α

i =1

n

Gama-2

1/ k

n

n

i =1

i =1

− n ln Γ(α ) − nα ln β + (α − 1)∑ ln xi − ∑

n

Pearson Tipo III

2

n

(x − β )

1 n xi − β

−∑

− ∑e − i

α i =1 α

α

i =1

n ln

n

xi

β

− n ln Γ(α ) − nα ln β + (α − 1)∑ ln (xi − γ ) − ∑

i =1

2.2.2

2

Log-normal-2

xi − γ

β

Método de los momentos

Este método se apoya en un teorema fundamental de la teoría de muestreo que

expresa que los momentos de la muestra son buenos estimadores de los momentos de la

población o universo. En consecuencia, este método establece que dado un conjunto de

observaciones x1, x2, .... xn de la variable aleatoria x, un buen estimador del promedio del

universo es el promedio de la muestra:

xbar =

1 n

∑x

n i =1 i

mientras que el estimador de la varianza σ2 es la varianza de la muestra S2.

S2 =

1 n

∑ ( x − xbar ) 2

n i =1 i

o bien, un estimador no sesgado es :

1 n

S =

( xi − xbar ) 2

∑

n − 1 i =1

2

Se pueden encontrar ecuaciones similares para los momentos de orden superior,

siendo los dos primeros momentos suficientes para las distribuciones de dos parámetros. No

siempre los parámetros de una distribución son exactamente iguales a los dos primeros

momentos. Sin embargo, los parámetros son funciones de los momentos y puede resolverse

el sistema de ecuaciones resultante para encontrar los parámetros.

En general la estimación de los parámetros de una muestra utilizando el

procedimiento de los momentos es el más sencillo, pues requiere obtener de la muestra los

estimadores de tantos momentos como parámetros tenga el modelo de distribución. En

seguida se forma un sistema de ecuaciones igualando los estimadores calculados de la

muestra con los correspondientes momentos del universo o población. Así se forma un

sistema de tantas ecuaciones como parámetros hay que estimar. En la Tabla 2.3 se

muestran las expresiones para calcular los parámetros de varios modelos probabilísticos

usando el método de los momentos. Las expresiones están en función del promedio de la

muestra (xbar) , la desviación estándar (S), el coeficiente de variación (Cv) y el coeficiente

de asimetría (g1).

El promedio y la varianza de la muestra son a su vez, variables aleatorias, y como tal,

puede estudiarse su valor medio, su varianza y su distribución. En especial, es importante la

relación entre ellos y el valor esperado de la variable x. Se puede demostrar, utilizando el

teorema del Límite Central, que el valor esperado del promedio de la muestra es igual al

promedio de la variable aleatoria x y que la varianza del promedio o error medio cuadrático

es σ2/n. Una estimación puntual de un parámetro es a veces poco conveniente, ya que rara

vez coincide con el parámetro. Por esta razón, se prefiere a veces, realizar una estimación

mediante un intervalo (I, S) en el cual I es el límite inferior y S es el límite superior del

intervalo. Este intervalo se denomina intervalo de confianza o de significación del

estimador.

Tabla 2.2.2.1:Parametros de los modelos de distribucion

Modelos

Parámetro α

Parámetro β

xbar

S

Normal

Log-normal-2

σ 1

ln − ln 1 + C v2

z 2

(

)

Parámetro γ

ln(1 + C v2 )

xbar (1 − C v / z )

Lognor

mal-3

Valores

Extremos I

Gama-2

Pearson III

2.2.3

σ

ln

z

(

1

2

− ln 1 + C v

2

)

ln(1 + C v2 )

1,2825 / σ

xbar − 0,45005σ

xbar S 2

S 2 xbar

S

(2 g1 )2

β

2

1

z = 1 − w 3 / w 3

w = 1 * − g + g2 + 4

2

(

)

xbar − S β

Método de Momentos Ponderados por Probabilidad

Greenwood y otros autores (1979) recomendaron estimar los parámetros de diversas

distribuciones mediante el método de momentos ponderados por probabilidad (MPP), ya que

este procedimiento tiene características preferibles al de máxima verosimilitud o de

momentos convencionales, cuando el tamaño de la muestra es limitado. Los momentos

ponderados por probabilidad se definen como el valor esperado del producto de tres

términos: la variable aleatoria (x), la función de distribución acumulada (F(x)) y el

complemento de esta función. De esta forma el MPP de orden l, j, k se calcula mediante la

siguiente expresión:

l

M i , j ,k = E ( x i F j (1 − F ) k ) = ∫ x i F j (1 − F ) k dF

0

Los momentos convencionales son un caso especial de los MPP, ya que en ellos el

exponente i es unitario y los otros dos exponentes son nulos.

Para facilitar el cálculo de los MPP se usan valores particulares para los exponentes.

Por ejemplo, para la distribución Wakeby se recomienda usar un valor unitario para el

exponente i y nulo para el exponente j. En este caso se denomina M1.0.k al MPP de orden k, y

se designa simplemente por Mk (Greenwood et al., 1979). Para las distribuciones de valores

extremos generalizados y tipo I se recomienda un exponente unitario para i y nulo para k,

obteniéndose los momentos Mj.

Landwehr y otros autores (1979a) recomiendan calcular estimadores de los MPP a

partir de la muestra, utilizando la siguiente expresión, que entrega MPP sesgados para k

positivo, en función del tamaño de la muestra (n), de los valores de caudales ordenados en

forma creciente (xi) y del número de orden (i) de cada valor en la lista:

Mk =

1 n

∑ x ((n − i + 0,35) / n) k

n i =1 i

Los autores nombrados también exploraron el empleo de estimadores sin sesgo para

los MPP, pero reportan que los estimadores moderadamente sesgados proporcionan mejores

resultados, particularmente al estimar los valores de los cuantiles superiores, lo cual es

especialmente relevante en el contexto del análisis de frecuencia de crecidas.

Para encontrar estimadores con este método, se debe establecer una igualdad entre

los momentos ponderados del modelo y los correspondientes de la muestra, formándose un

sistema de ecuaciones con tantas ecuaciones como parámetros hay que estimar.

Los momentos de la muestra se calculan ponderando cada valor por la probabilidad

Fi :

Fi =

i − 0,35

N

El índice i representa el número de orden de cada valor de la muestra ordenada en

valores crecientes, es decir, i vale uno para el valor más pequeño. Los momentos se

estiman por las expresiones siguientes (Hosking et al., 1985) :

1

M$ j =

N

N

∑F

i =1

i

j

xi

o bien

1 N

$

M K = ∑ (1 − Fi ) k xi

N i =1

Los momentos ponderados del universo o población dependen del modelo

probabilístico que se emplee. A continuación se incluyen las expresiones para diferentes

modelos.

Tabla 2.2.3.1 :Momentos ponderados por probabilidad

Distribución

EV1

Distribución inversa y fórmula de MPP

x = β + α (− In − InF ),

M1 j0 =

GEV

Wakeby

{

}

(

[

[

] )

] [

x = m + a 1 − (1 − F ) − c 1 − (1 − F )

M 10 k =

2.3

β

α {1n(1 + j ) + 0,57721}

+

1+ j

1+ j

α

k

1 − (− ln F )

k

1

−k

=

u + α 1 − ( j + 1) Γ(1 + k ) / k

1+ j

x=u+

M 1 jo

F=Prob ( X ≤ x )

b

−d

],

m

a−c

a

c

+

−

+

1+ k 1+ k 1+ k + b 1+ k − d

Selección de Modelos

El único procedimiento para verificar el comportamiento de un modelo matemático,

ya sea probabilístico o determinístico, es comparar las predicciones efectuadas por el modelo

con observaciones de la realidad. Si el modelo es determinístico, y no existe error

experimental, entonces la comparación con los valores observados es simple y concluyente.

Sin embargo, en el caso de modelos probabilísticos, debido a la naturaleza misma del

modelo, las observaciones son sólo una muestra de la realidad, y en consecuencia una

repetición del ensayo puede dar un resultado diferente. Resulta, pues, poco probable

encontrar una correspondencia exacta entre modelo y realidad, aún cuando las hipótesis sean

válidas. Por ello, es necesario definir la magnitud de la discrepancia que puede obtenerse sin

que sea necesario desechar la hipótesis estudiada. Al ser la variable observada una variable

aleatoria, pueden producirse grandes diferencias, aun cuando ello sea poco probable. Por

otro lado, una correspondencia entre la predicción y la observación tampoco es suficiente

para garantizar que la hipótesis sea cierta.

En la elección de un modelo probabilístico, es conveniente considerar todo el

conocimiento que se tenga sobre la variable. Por ejemplo, puede haber ciertas limitantes

físicas que hagan imposible la existencia de valores negativos, valores límites, etc. Si el

modelo no concuerda con estas limitantes, cabe entonces, preguntarse si esas discrepancias

son o no importantes, al adoptar un determinado modelo. Otra medida cualitativa sobre la

bondad del modelo, es su facilidad de tratamiento matemático u operativo, la cual también

conviene considerar.

Fuera de estas nociones cualitativas deben considerarse ciertos aspectos cuantitativos.

A saber, pueden calcularse los momentos de orden superior de la distribución y compararlos

con los valores calculados a partir de la muestra. Sin embargo, es preciso tener presente que

el error medio cuadrático cometido en la estimación de dichos momentos, aumenta al

incrementar el orden de momento y por ello disminuye la precisión en los estimadores.

También se recomienda comparar las probabilidades observadas con las calculadas con el

modelo, lo cual puede realizarse gráficamente o analíticamente.

2.3.1

Métodos gráficos

Para verificar el modelo propuesto, se recurre usualmente a comparaciones gráficas

entre el modelo y los datos, ya sea utilizando la función densidad de probabilidad, o bien, la

distribución acumulada. En ambos casos, la comparación gráfica permite una visualización

rápida del ajuste del modelo e indica las zonas en las cuales el ajuste es deficiente. Ello

permite decidir sobre la bondad del ajuste, estimar los distintos percentiles de la distribución

y los parámetros del modelo.

Una etapa útil en el análisis es dibujar los datos en forma de un gráfico de barras. Al

graficar las frecuencias observadas para cada intervalo del variable se obtiene un histograma,

en el cual la altura de cada barra es proporcional al número de observaciones en ese

intervalo. Este gráfico entrega al ingeniero un cuadro inmediato de las frecuencias

observadas en cada intervalo y su comparación con el modelo propuesto.

Para estudiar el ajuste de los datos al modelo, se procede a graficar la curva de

distribución acumulada. Para facilitar la decisión se acostumbra a usar un papel especial de

modo que el modelo probabilístico se representa en él por una recta. Para ello, se deforma la

escala de las abscisas de modo de estirar los extremos de la distribución.

Para preparar un gráfico de probabilidades para un conjunto de valores se sigue el

siguiente procedimiento :

i) Se obtiene un papel especial, llamado papel de probabilidades, diseñado para el

modelo en estudio. Existen papeles para la distribución normal, log-normal y valores

extremos tipo I.

ii) Se ordenan las observaciones en orden creciente en magnitud.

iii) Se grafican las observaciones en el papel de probabilidades, asignándoles a cada

una, una probabilidad o posición de ploteo. Existen varias posiciones de ploteo y en la

actualidad una de las preferidas es la propuesta por Weibull, que entrega un estimador no

sesgado de probabilidad. En este caso la probabilidad se calcula con la siguiente expresión:

Prob( x ≤ X ) =

m

n +1

siendo

m = número de orden

n = número de datos.

Se utiliza también el concepto de período de retorno que se define como el tiempo

para el cual en promedio se produce un evento igual o superior al considerado.

Es decir,

Tr =

1

1 − Prob( x ≤ X )

o bien,

Tr =

iv)

n +1

n−m

Si los puntos graficados se ajustan a una recta, entonces el modelo elegido

representa un buen ajuste y se traza la recta en forma visual. Si los puntos no

representan una tendencia lineal, entonces el modelo elegido no es adecuado.

2.3.2

Métodos cuantitativos

Los métodos anteriores permiten juzgar en forma gráfica la bondad del ajuste de los

datos a un determinado modelo probabilístico. Sin embargo, en ciertas ocasiones es

preferible contar con procedimientos cuantitativos, que permitan una decisión objetiva sobre

el ajuste. A continuación se describen dos procedimientos cuantitativos: el test chi-cuadrado

y el test Kolmogosov-Smirnov.

Los tests de hipótesis sobre modelos de distribución cuentan con las siguientes etapas

generales: Primero, se calcula un estadígrafo a partir de los datos observados. Luego, se

calcula la probabilidad de obtener el estadígrafo calculado, en el supuesto que el modelo sea

correcto. Esto se realiza refiriéndose a una tabla probabilística que entregue los percentiles

del modelo de distribución del estadígrafo. Finalmente, si la probabilidad de obtener el valor

del estadígrafo calculado es baja, se concluye que el modelo supuesto no provee una

adecuada representación de la muestra. Debe hacerse notar que este procedimiento permite

rechazar un modelo por no ser adecuado, pero no permite probar que el modelo

probabilístico elegido sea el correcto.

(a) Test Chi-Cuadrado

Es el test más usado para medir la bondad de ajuste de un modelo y es aplicable

estrictamente a cualquier tipo de distribución siempre que los parámetros de ella, hayan sido

estimados mediante el método de máxima verosimilitud. El test consiste en comparar, en

intervalos previamente definidos de la variable aleatoria, el número de casos observados en

ese intervalo con el teórico, el cual es función del modelo probabilístico en estudio.

Si O1, O2,.........Ok son las frecuencias absolutas observadas y E1, E2,...... Ek son las

frecuencias teóricas, en cada una de las clases, se define un estadígrafo.

(Oi − Ei ) 2

Χ =∑

Ei

i =1

k

2

La variable X2 tiende a tener una distribución chi-cuadrado con K-S-1 grados de

libertad, siendo K el número de clases o intervalos definidos y S el número de parámetros

estimados en el modelo.

Para que el ajuste de la distribución a la muestra sea aceptable, se requiere que el

valor chi-cuadrado sea menor o a lo sumo, igual al valor teórico que toma la distribución chicuadrado para un cierto nivel de significación (normalmente 5%). Las tablas de la

distribución chi-cuadrado permiten conocer el valor teórico de chi en función de los grados

de libertad y del nivel de probabilidad deseado.

Se recomienda elegir un número reducido de clases de modo que el valor teórico de

casos observados en cada clase sea por lo menos igual a 5 y usar clases equiprobables.

(b) Test de Kolmogorov-Smirnov

El test se basa en calcular el estadígrafo D definido como el valor máximo de la

diferencia absoluta entre la función distribución acumulada empírica (Gn(a)) y la función

distribución del modelo calculada para cada punto de la muestra (Fn(a)). En general, el

estadígrafo se calcula usando las distribuciones empíricas de las muestras, de la siguiente

manera :

D = max {Fn (a) − Gn (a) }

−∞ < a < ∞

La dócima es rechazar la hipótesis nula si D es mayor o igual que un valor crítico

que depende del tamaño de la muestra y del nivel de significancia. La Tabla 2.5 presenta

los valores límites para esta dócima en función del tamaño de la muestra y del nivel de

significancia..

Tabla 2.3.2.1: Valores críticos para el test de kolmogorov-smirnov

Tamaño

muestra

n

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

25

30

35

40

45

50

n>50

2.3.3

Nivel de significancia

0,20

0,90

0,68

0,57

0,49

0,45

0,41

0,38

0,36

0,34

0,32

0,31

0,30

0,28

0,27

0,27

0,26

0,25

0,24

0,24

0,23

0,21

0,19

0,18

0,17

0,16

0,15

1,07/√n

0,15

0,93

0,73

0,60

0,53

0,47

0,44

0,41

0,38

0,36

0,34

0,33

0,31

0,30

0,29

0,28

0,27

0,27

0,26

0,25

0,25

0,22

0,20

0,19

0,18

0,17

0,16

1,14/√n

0,10

0,95

0,78

0,64

0,56

0,51

0,47

0,44

0,41

0,39

0,37

0,35

0,34

0,33

0,31

0,30

0,30

0,29

0,28

0,27

0,26

0,24

0,22

0,21

0,19

0,18

0,17

1,22/√n

0,05

0,98

0,84

0,71

0,62

0,56

0,52

0,49

0,46

0,43

0,41

0,39

0,38

0,36

0,35

0,34

0,33

0,32

0,31

0,30

0,29

0,26

0,24

0,23

0,21

0,20

0,19

1,36/√n

0,01

0,99

0,93

0,83

0,73

0,67

0,62

0,58

0,54

0,51

0,49

0,47

0,45

0,43

0,42

0,40

0,39

0,38

0,37

0,36

0,35

0,32

0,29

0,27

0,25

0,24

0,23

1,63/√n

Consideraciones adicionales

No existe ninguna justificación teórica absoluta que apoye la elección de un

determinado modelo probabilístico o de un determinado método de estimación de

parámetros. El hidrólogo deberá en cada caso seleccionar la mejor alternativa apoyado en

argumentos de diversa índole. En relación con la estimación de parámetros de los modelos,

el método de máxima verosimilitud, tiene ventajas teóricas que se alcanzan en forma

asintótica al aumentar el tamaño de la muestra. Sin embargo, se ha demostrado en

experimentos de simulación con muestras pequeñas que otros procedimientos tienen

mejores propiedades en estos casos.

No obstante lo anterior, existen algunos elementos que ayudan a seleccionar los

modelos más adecuados en un caso particular. Los argumentos se basan en la naturaleza de

los datos, en los resultados de tests estadísticos, en representaciones gráficas de la

distribución de frecuencia acumulada y en la comparación de los histogramas.

Adicionalmente en ciertos casos existen situaciones especiales que hacen que

determinados modelos no sean aplicables, por producirse contradicciones entre la muestra

y los algoritmos de cálculo o la esencia del modelo de distribución. Algunos de estos casos

son, por ejemplo, no usar transformaciones o modelos de tipo logarítmico cuando la

muestra tiene valores nulos. En consecuencia, en estos casos se desaconseja el uso de los

modelos log-normal, gama, gumbel, valores extremos generalizados y log-Pearson tipo III.

Si el estimador del coeficiente de asimetría es superior a 2 en valor absoluto, no se pueden

calcular los parámetros de la distribución log-normal-3 y Pearson tipo III por el método de

máxima verosimilitud.

Por otra parte, se aconseja usar:

•

•

•

•

la distribución normal cuando las razones entre el coeficiente de asimetría y su error

estándar, y cuando la razón entre el coeficiente de kurtosis menos tres y su error

estándar son inferiores a 2 en valor absoluto, ya que en el 98% de los casos se debe

cumplir esta condición si las variables son normales. Sin embargo, esta situación puede

no ser muy decisiva si las muestras son pequeñas

los modelos log-normal, de dos y tres parámetros cuando se cumple la condición

anterior aplicada a los logaritmos de los valores.

distribuciones de valores extremos tipo I y/o valores extremos generalizados, cuando

se estudian valores máximos anuales o valores superiores a un umbral o un cierto

números de máximos en cada año, siempre que se trate de muestras con coeficiente de

asimetría positivo.

distribución gama o Pearson tipo III cuando el coeficiente de asimetría es positivo.

Anuncio

Documentos relacionados

Descargar

Anuncio

Añadir este documento a la recogida (s)

Puede agregar este documento a su colección de estudio (s)

Iniciar sesión Disponible sólo para usuarios autorizadosAñadir a este documento guardado

Puede agregar este documento a su lista guardada

Iniciar sesión Disponible sólo para usuarios autorizados