Análisis estadístico de datos simulados Estimadores

Anuncio

Análisis estadístico de datos simulados

Estimadores puntuales

Georgina Flesia

FaMAF

2 de mayo, 2013

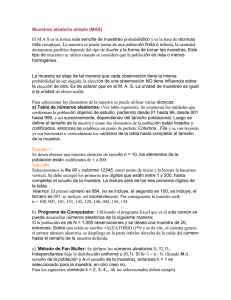

Análisis estadístico

Modelización estadística:

I

Elegir una distribución en base a los datos observados.

I

Estimar los parámetros de la distribución (EMV).

I

Pruebas de bondad de ajuste.

Estimación de parámetros

I

Estimador puntual.

I

Varianza del estimador. Var(θ̂).

I

Error cuadrático medio del estimador. E[(θ̂ − θ)2 ].

I

Estimadores por intervalo e intervalos de confianza.

Estimación de parámetros

Dada una muestra de n datos observados, se llama estimador θ̂ del

parámetro θ a cualquier función de los datos observados.

Propiedades de un buen estimador puntual

I

Insesgabilidad: se dice que el estimador es insesgado si

E[θ̂] = θ.

I

Consistencia: si al aumentar la muestra, el estimador se

aproxima al parámetro.

I

Eficiencia: se calcula comparando su varianza con la de otro

estimador.

I

Suficiencia: utiliza toda la información obtenida de la muestra.

Media muestral

Dadas n observaciones: X1 , X2 , . . . , Xn , con una misma distribución,

la media muestral se define por

X (n) =

X1 + X2 + · · · + Xn

.

n

La media muestral se utiliza como un estimador de la media θ, es

decir, de θ = E[Xi ], si la media es finita.

Estimador insesgado.

"

E[X (n)]

=

E

n

X

Xi

i=1

n

#

=

n

X

E[Xi ]

i=1

n

=

nθ

= θ.

n

Media muestral

Dadas n observaciones: X1 , X2 , . . . , Xn , con una misma distribución

con media finita θ,

X (n) =

X1 + X2 + · · · + Xn

.

n

Estimador consistente.

lim [X (n)]

n→∞

por la ley de los grandes números.

=

θ.

Media muestral

Dadas n observaciones: X1 , X2 , . . . , Xn , con una misma distribución

con media finita y varianza finita

X1 + X2 + · · · + Xn

.

n

√

Z = n(X (n) − θ)/σ.

X (n) =

Estimador asintóticamente normal.

lim [FZ (n)(x)]

n→∞

por el teorema central del límite.

=

Φ(x).

Métodos de estimación mas comunes

I

Estimador de máxima verosimilitud

I

Estimador de momentos

Estimador de máxima verosimilitud

Si la distribución supuesta es discreta para los datos observados, y

se desconoce un parámetro θ.

Sea pθ (x) la probabilidad de masa para dicha distribución.

Dado que se han observado datos X1 , X2 , . . . , Xn , se define la función

de máxima verosimilitud L(θ) como sigue:

L(θ) = pθ (X1 ) · pθ (X2 ) · · · pθ (Xn ).

El estimador de máxima verosimilitud es el valor θ̂ que maximiza L(θ):

L(θ̂) ≥ L(θ),

θ valor posible.

Estimador de máxima verosimilitud

Si la distribución supuesta es continua, y fθ (x) es la densidad para

dicha distribución.

Dado que se han observado datos X1 , X2 , . . . , Xn , se define la función

de máxima verosimilitud L(θ) como sigue:

L(θ) = fθ (X1 ) · fθ (X2 ) · · · fθ (Xn ).

El estimador de máxima verosimilitud es el valor θ̂ que maximiza L(θ):

L(θ̂) ≥ L(θ),

θ valor posible.

Estimador de máxima verosimilitud

El estimador de máxima verosimilitud tiene, en general, las

siguientes propiedades:

1. Es único: L(θ̂) > L(θ) para cualquier otro valor de θ.

2. La distribución asintótica de θ̂ tiene media θ.

3. Es invariante: φ = h(θ), entonces φ̂ = h(θ̂).

4. La distribución asintótica es la normal.

5. Es fuertemente consistente: limn→∞ θ̂ = θ.

Distribución exponencial

Ejemplo

Para la distribución exponencial, θ = 1/λ (λ > 0) y fλ (x) = λe−xλ

para x ≥ 0.

L(λ)

=

=

λe−X1 λ

λe−X2 λ · · · λe−Xn λ

!

n

X

n

λ exp −λ

Xi

i=1

Distribución exponencial

ln(L(λ))

= ln(λn exp −λ

n

X

!

Xi )

i=1

= n ln(λ) − λ

n

X

Xi

i=1

d

ln(L(λ))

dλ

n

=

n X

−

Xi

λ

i=1

= 0

λ̂ =

θ̂ =

1

n

1

λ̂

1

Pn

i=1

Xi

n

=

=

1

1

=

Media muestral.

X (n)

1X

Xi = X (n) = Media muestral.

n

i=1

Distribución geométrica

Ejemplo

Para la distribución geométrica, θ = p y pp (x) = p(1 − p)x−1 para

x = 1, 2, . . . .

L(p)

=

p(1 − p)X1 −1 . . . p(1 − p)Xn −1

=

pn (1 − p)

=

=

Pn

i=1 (Xi −1)

Pn

pn (1 − p) i=1 Xi (1 − p)−n

n

Pn

p

(1 − p) i=1 Xi

1−p

n

ln(L(p))

= n ln(

X

p

) + ln(1 − p)

Xi

1−p

i=1

= n ln(p) − n ln(1 − p) + ln(1 − p)

n

X

i=1

Xi

Distribución geométrica

d

ln(L(p))

dp

=

n

X

d

[n ln(p) + ln(1 − p)[

Xi − n]]

dp

i=1

=

n

1

−

p 1−p

n

X

(

Xi − n) = 0

i=1

n

n

p

=

1−p

=

1

=

p̂ =

1 X

(

Xi ) − n

1−p

i=1

1X

Xi − 1)

p(

n

1X

p + p(

Xi ) − p

n

X −1

1

Xi

n

Estimadores de máxima verosimilitud:

Distribuciones continuas:

I

Uniforme: â = min{Xi }, b̂ = max{Xi }.

I

Exponencial: θ̂ = X (n).

I

Gamma, Weibull: α̂ y β̂ se resuelven numéricamente.

I

Normal:

µ̂ = X (n),

I

"

n−1 2

σ̂ =

S (n)

n

1/2

log(Xi )

,

n

Pn

n

1X

=

(Xi − X )2

n

#1/2

.

i=1

Lognormal:

Pn

µ̂ =

i=1

σ̂ =

i=1 (log(Xi )

n

− µ̂)2

1/2

.

Estimadores de máxima verosimilitud

Distribuciones discretas:

I

Binomial (t, p): si t es conocido, p̂ = X (n)/t.

I

Bernoulli: Caso binomial con t = 1 e igual p.

I

Geométrica: p̂ =

I

Binomial negativa (s, p): número de ensayos hasta el s-ésimo

s

éxito. Si s es conocido: p̂ = X (n)

.

I

Poisson: λ̂ = X (n).

1

.

X (n)

Error cuadrático medio

I

θ̂: estimador del parámetro θ de una distribución F

I

Se define el error cuadrático medio (ECM) de θ̂ con respecto al

parámetro θ como

ECM(θ̂, θ) = E[(θ̂ − θ)2 ].

E[(θ̂ − θ)2 ]

= E[(θ̂ − E[θ̂] + E[θ̂] − θ)2 ]

= E[(θ̂ − E[θ̂])2 ] + (E[θ̂] − θ)2

=

Var(θ̂) + (E(θ̂) − θ)2

I

El error cuadrático medio de un estimador es igual a su varianza

más el sesgo al cuadrado.

I

Si el estimador es insesgado, su ECM es igual a la varianza.

ECM de la media muestral respecto de la media

Muestra de X : X1 , X2 , . . . , Xn ,

ECM(X (n), θ)

E[Xi ] = θ

= E[(X (n) − θ)2 ]

= Var(X (n)) =

n

1 X

σ2

Var(X

)

=

i

n2

n

i=1

√

La media muestral es un buen estimador de E[X ] si σ/ n es

pequeño.

I

El ECM depende de la distribución de Xi y del tamaño de la

muestra.

I

Teorema central del límite. Si Z ∼ N(0, 1) y n es grande:

!

|X (n) − θ|

√

P

> c ≈ P{|Z | > c}.

σ/ n

Varianza muestral

σ2

como estimación del error en la media muestral, tiene

El indicador

n

el inconveniente que σ es en general desconocida.

Para estimar la varianza se utiliza el estimador

Pn

(Xi − X (n))2

2

S (n) = i=1

.

n−1

I

Estimador insesgado de la varianza

I

Fórmula a utilizar:

E S 2 (n) = Var(X )

n

n

X

X

2

(Xi − X (n))2 =

Xi2 − nX (n)

i=1

i=1

Varianza muestral

E[Xi2 ]

2

E[X (n)]

(n − 1)E[S 2 (n)]

= Var(Xi ) + (E[Xi ])2 = σ 2 + θ2 .

=

σ2

+ θ2 .

n

2

= nE[X12 ] − nE[X (n)] = n(σ 2 + θ2 ) − n(

σ2

+ θ2 )

n

E[S 2 (n)]

= σ2

p

Utilizaremos S(n) = S 2 (n) como estimador de la desviación

estándar.

I

Error del estimador X (n): σ 2 /n.

I

Simulación de datos: Si el objetivo es estimar la media, para

disminuir el error deben generarse muestras de tamaño n, n

grande.

Media muestral

I

I

I

Elegir un valor aceptable d para la desviación estándar del

estimador.

√

√

Generar (n) datos hasta que σ/ n < d. (S/ n < d)

Conviene generar al menos 100 datos para:

I

I

asegurar normalidad de la distribución de X (n).

para disminuir la varianza de S.

I

La estimación de θ estará dada por el último valor de X (n).

I

El algoritmo implica calcular en cada paso X (n) y S(n).

I

Es posible calcularlo recursivamente.

Media muestral

Cálculo recursivo de X (n) y S 2 (n)

I

X (1) = X1 ,

I

S 2 (1) = 0.

X (j + 1)

S 2 (j + 1)

Xj+1 − X (j)

= X (j) +

j +1

1

=

1−

S 2 (j) + (j + 1)(X (j + 1) − X (j))2

j

Estimación de una proporción

El estimador X (n) puede utilizarse también para estimar la

proporción de casos en una población.

(

1 probabilidad p

Xi =

0 probabilidad 1 − p.

I

I

I

X (n) es un estimador insesgado de p.

p(1 − p)

E[(X (n) − p)2 ] = Var(X (n)) =

n

En este caso, se estima la varianza del estimador X (n) por:

X (n)(1 − X (n))

.

n

Algoritmo: Cálculo de E[X ]

Algorithm 1: Estimación de la media M de X con error d

Generar X , M ← X

M = X (1) = X1 ;

S 2 = S 2 (1) = 0;

S2 ← 0

for 1 < j ≤ 100 do

Generar X ; A ← M;

M ← M + (X − M)/j;

S 2 ← (1 − 1/(j − 1))S 2 + j(M − A)2

end

j ← 100;

p

while S 2 /j > d do

j ← j + 1;

Generar X ;

A ← M;

M ← M + (X − M)/j;

S 2 ← (1 − 1/(j − 1))S 2 + j(M − A)2

end

return M

Algoritmo: Cálculo de una probabilidad

Algorithm 2: Estimación de la probabilidad p de X con error d

Generar X

p ← X;

for 1 < j ≤ 100 do

Generar X ;

p ← p + (X − p)/j

end

j ← 100;

p

while p(1 − p)/j > d do

j ← j + 1;

Generar X ;

p ← p + (X − p)/j;

end

return p

X es 0 o 1;

![( ) ( )2 ( )[ ] ( )ξ ( ) PQ](http://s2.studylib.es/store/data/006099496_1-61f82d8b006ba0985f60bbb263d08047-300x300.png)