Cátedra I Estadística II Autor I Nidia Blanch 151

Anuncio

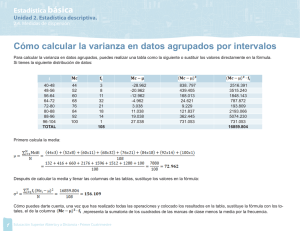

Cátedra I Estadística II Autor I Nidia Blanch 8.1. Introducción Hasta aquí hemos aprendido a efectuar inferencias respecto a las medias y varianzas de una o dos poblaciones. Deseamos saber ahora si existe una metodología mediante la cual se puedan comparar en una sola prueba los parámetros de tres o más poblaciones, simultáneamente. Como es obvio, este procedimiento resultará de suma importancia en el análisis estadístico, pues a menudo surgen situaciones en las que el investigador puede estar interesado en efectuar un experimento cuyo objetivo es estudiar el efecto de diferentes sustancias químicas en la reacción de una pasta, distintas técnicas de manipulación de archivos de datos, la efectividad de varios procedimientos para la reducción de accidentes, la calidad de los productos de varios proveedores, el estudio de diferentes procedimientos para el control de errores administrativos, etc. El investigador podría decidir la comparación de estas muestras mediante alguno de los procedimientos vistos anteriormente, tomando las medias de a pares. Pero este procedimiento es ineficiente y antieconómico. Se necesita, una metodología que investigue simultáneamente las diferencias existentes entre medias de varias poblaciones y esa metodología se denomina Análisis de la Varianza (ANAVA). El nombre de Análisis de la Varianza deriva del hecho de que el análisis se basa en la comparación de las varianzas estimadas a partir de diversas fuentes. Una forma sencilla de entender el ANAVA es considerarlo como un procedimiento para comprobar si dos o más medias muestrales pueden haberse obtenido de poblaciones con la misma media paramétrica, respecto a una variable dada, o lo que es lo mismo, si el tratamiento aplicado a las unidades experimentales ha modificado a la población de la cual se extrajo la muestra, de tal manera que ahora, ya no se tiene una sino varias poblaciones. Abordaremos entonces el estudio del Análisis de la Varianza y sus aplicaciones como el procedimiento correcto para resolver esta situación, mediante el desarrollo del caso más simple: el Análisis de la Varianza de un solo factor. 8.2. Análisis de la varianza de un factor A menudo resulta de interés comparar diferencias en los resultados de varios grupos. Muchas situaciones prácticas implican experimentos en los que se toman en cuenta solamente los grupos o niveles pertenecientes a un factor de interés, como la temperatura de horneado de un producto o el nivel de ocupación. Un factor como la temperatura de horneado puede tener varios niveles numéricos (por ejemplo, 300º, 350º, 400º, 450º) o un factor como el nivel de ocupación con varios niveles categóricos (operario, administrativo, gerente). Tales experimentos, en los cuales los sujetos o unidades experimentales son asignados aleatoriamente a grupos o niveles de un solo factor, se conocen como; modelos completamente aleatorizados de un solo factor. Se tratará de clarificar este concepto mediante la consideración del siguiente problema: Supongamos que una empresa manufacturera debe comprar una nueva máquina. Existen en el mercado tres marcas diferentes y el gerente de compras debe decidir cual le conviene comprar. Supongamos que el costo de las tres es similar y que la decisión se tomará eligiendo aquella que sea más rápida para la produc- 151 Cátedra I Estadística II Autor I Hebe Goldenhersch ción del bien que realiza la empresa. El gerente de compras observa los volúmenes de producción de cinco horas de trabajo seleccionadas en forma aleatoria para cada una de las máquinas. Los resultados obtenidos se informan en la siguiente tabla: Volumen de producción horario de tres máquinas para cinco horas Muestra 1 2 3 4 5 Total Media Varianza Rango C.V. % Máquina I 25 30 36 38 31 160 32 26.5 13.0 16.1 II 31 39 38 42 35 185 37 17.5 11.0 11.3 III 24 30 28 25 28 135 27 6.0 6.0 9.1 En este ejemplo la variable principal de interés es el factor máquinas, los niveles del factor son las tres máquinas (I, II y III) y la variable de respuesta elegida para medir su efecto es el volumen de producción (en unidades producidas). Cuando el investigador analiza un solo factor a distintos niveles y diseña su experiencia de la manera explicada, se dice que está diseñando un experimento completamente aleatorizado. El siguiente gráfico muestra la dispersión del volumen de producción de las tres máquinas. Cada punto representa el volumen de producción observado para cada máquina y la línea central indica el promedio general de las 15 producciones. Producción Dispersión del volumen de producción de las tres máquinas 50 40 x 30 20 10 I II III Máquina A partir de este gráfico de dispersión (scatter-plot) se puede observar que los volúmenes de producción medios son diferentes, que la tercera máquina es más homogénea, que con la segunda máquina hay un volumen de producción superior al resto y que la primera máquina tiene volúmenes de producción más variables que las otras dos. 152 Cátedra I Estadística II Autor I Nidia Blanch La pregunta que nos hacemos a esta altura es: ¿cuál de las tres máquinas debe comprar el gerente de producción? Para contestar a esta pregunta comenzaremos a desarrollar el procedimiento de análisis de la varianza. En primer lugar, se definen las hipótesis de interés. El supuesto que se realiza es que los c niveles del factor o c grupos que se desean estudiar (máquinas, en este caso) corresponden a poblaciones normales, con iguales varianzas. Además se supone que las mediciones fueron obtenidas de manera aleatoria e independiente. En esta situación, la hipótesis nula establece que no existen diferencias entre los promedios poblacionales. Esto es: H0 : µ1 = µ 2 = ... = µc contra la alternativa de que no todos los promedios poblacionales son iguales. Esto es: H1 : No todas las µ j son iguales (j = 1, 2, ..., c) Volviendo al ejemplo planteado, la hipótesis nula establece que no hay diferencia en el volumen de producción promedio de las tres máquinas, es decir: H0 : µI = µII = µIII La hipótesis alternativa establece que existe un efecto de tratamiento o efecto de máquina que hace que los volúmenes de producción medios de las tres máquinas no sean iguales. H1 : No todos los promedios son iguales 9.1. Variación entre y dentro de grupos Para llevar a cabo una prueba ANAVA de igualdad de medias poblacionales, se subdivide a la variación total de las mediciones obtenidas en el experimento en dos partes, una correspondiente a la variación entre grupos (entre máquinas) y la otra correspondiente a la variación dentro de grupos (variación de las mediciones de cada máquina). Justamente, la denominación análisis de la varianza proviene de descomponer la variabilidad total de los datos en sus partes componentes. Veremos esta descomposición en fórmulas: Variación total18/ = c nj 2 ∑ ∑ ( xij − x ) j =1 i =1 18/ Para entender el doble sumatorio observe la tabla que se presenta en la página siguiente, el primer sumatorio indica la variación en las columnas y el segundo, en las filas. En este caso, se mantiene fijo el subíndice del sumatorio exterior y se hace variar el interior (j = 1, i = 1 a nj); una vez agotado n1 seguimos con j = 2 y nuevamente i = 1 a n2 y así sucesivamente. 153 Cátedra I Estadística II Autor I Hebe Goldenhersch Donde c representa el número de grupos o niveles del factor en el experimento, n j la cantidad de observaciones por grupo o tamaño de la muestra en cada grupo, x ij indica la i-ésima medición obtenida en el grupo j y x el promedio general. Esta expresión corresponde al numerador de la varianza de todos los datos del experimento y luego recibe el nombre de Suma de cuadrados total (SCT). Variación entre grupos19/ = c ∑ n j (x j − x ) 2 j =1 La variación entre grupos se conoce como Suma de cuadrados entre grupos (SCE) y mide la suma de las diferencias al cuadrado entre la media de cada grupo y la media general, ponderadas por el tamaño de cada grupo. c nj Variación dentro de grupo = 2 ∑ ∑ ( xij − x j ) j =1 i =1 La variación dentro del grupo, conocida como suma de cuadrados dentro de los grupos (SCD) mide la diferencia entre cada observación y la media de su propio grupo elevada al cuadrado y sumada sobre todos los grupos. Obtendremos ahora estas tres sumas de cuadrados con los datos del ejemplo. Emplearemos las fórmulas de cálculo simplificadas, tomando la información de la siguiente tabla de cálculos auxiliares. Cálculos auxiliares Cálculos auxiliares Muestra 1 2 3 4 5 Total c nj Siendo: ∑ ∑ xij 2 xi1 xi21 xi2 xi22 x i3 x i23 25 30 36 38 31 625 900 1296 1444 961 31 39 38 42 35 961 1521 1444 1764 1225 24 30 28 25 28 576 900 784 625 784 160 5226 185 6915 135 3669 = 5226 + 6915 + 3669 = 15810 j =1 i =1 2 y 19/ c nj 2 2 ∑ xij = (160 + 185 + 135) = 480 = 230400 ∑ = = j 1 i 1 En este caso, los términos de la suma no están afectados por el subíndice i, por lo que el segundo sumatorio se convierte en nj veces cada diferencia. 154 Cátedra I Estadística II Autor I Nidia Blanch Luego: Suma de cuadrados total = = c nj ∑ xij ∑ c nj j =1 i =1 2 ∑ ∑ xij − j =1 i =1 cn 2 ( 480 ) 2 = 15810 – 15360 = 450 15 15810 − c (Siendo cn el total de datos = ∑ nj ) j =1 nj ∑ ∑ xij j =1 i =1 nj c Suma de cuadrados entre grupos = = 2 c nj ∑ xij ∑ j =1 i =1 − cn 2 (160 ) 2 (185 ) 2 (135 ) 2 (480) 2 + + − 5 5 5 15 = 15610 – 15360 = 250 nj ∑ ∑ xij c nj j =1 i =1 2 ∑ ∑ xij − j =1 i =1 nj c Suma de cuadrados dentro de grupos = 2 = 15810 - 15610 = 200 Podremos verificar una importante propiedad de las sumas de cuadrados que dice que a pesar de que estas sumas se obtienen independientemente una de otra, la suma de las mismas reproduce la suma de cuadrados total. Es decir, las sumas de cuadrados son aditivas. Luego: SCT = SCE + SCD Con los resultados del ejemplo: 450 = 250 + 200 De esta manera hemos verificado la aditividad de las sumas de cuadrados. Resulta sencillo demostrar cómo esta propiedad aditiva se cumple para todos los casos, si tenemos en cuenta que: c nj SCT= 2 ∑ ∑ ( xij − x ) Sumando y restando la media de cada grupo, se puede escribir: j =1 i =1 c nj c nj j =1 i =1 j =1 i =1 2 2 ∑ ∑ ( xij −x ) = ∑ ∑ (( xij − x j )+ ( x j − x )) 155 Cátedra I Estadística II Autor I Hebe Goldenhersch Desarrollando el cuadrado del Segundo miembro e introduciendo los sumatorios20/: c nj c nj c c nj j =1 i =1 j =1 i =1 j =1 j =1 i =1 2 2 2 ∑ ∑ ( xij −x ) = ∑ ∑ ( xij −x j ) + ∑ n j ( x j − x ) +2 ∑ ∑ ( xij −x j )( x j − x ) En el ultimo término, se trata de sumas de productos de desvíos con respecto a la media; al introducir los sumatorios, ambos factores se anula. Por lo tanto este término es nulo y resulta: c nj ∑ ∑ ( xij −x ) j =1 i =1 2 c nj =∑ ∑ ( xij −x j ) 2 j =1 i =1 c +∑ j =1 n j ( x j − x )2 Con lo cual hemos demostrado la aditividad de las sumas de cuadrados, tal como lo hemos verificado en el ejemplo numérico. Como existen c niveles del factor siendo comparados, existen c–1 grados de libertad asociados con la suma de cuadrados entre grupos. Además, como cada uno de los c niveles contribuye con n j −1 grados de libertad y; c ∑ (n j − 1) =n–c j =1 existen (n – c) grados de libertad asociados con la suma de cuadrados dentro de grupos. Por otro lado, existen (n – 1) grados de libertad asociados con la suma de cuadrados total, porque cada observación x ij se compara con la media general basándose en el total de observaciones; c ∑ nj = n j =1 Es posible observar que los grados de libertad asociados a las sumas de cuadrados también son aditivos. n - 1 = (c - 1) + (n - c) Por otro lado, si cada suma de cuadrados se divide por sus respectivos grados de libertad asociados, se obtienen tres varianzas o términos cuadráticos medios. Es decir: Cuadrado medio total (CMT) = SCT = n −1 1 c nj 2 ∑ ∑ ( xij −x ) n − 1 j =1 i =1 Cuadrado medio entre grupos (CME) = SCE = c −1 1 c 2 ∑ nj (xj − x ) c − 1 j =1 Cuadrado medio dentro de grupo (CMD) = SCD = n−c 1 c nj 2 ∑ ∑ ( xij −x j ) n − c j =1 i =1 Los cuadrados medios no son aditivos. 20/ Al introducir los sumatorios, se producen algunos cambios según cómo los términos contienen o no los subíndices i y j. El segundo término no contiene a i, por lo tanto en lugar del sumatorio con respecto a i se debe colocar nj. 156 Cátedra I Estadística II Autor I Nidia Blanch Calculemos ahora los cuadrados medios con los datos del ejemplo. CME = 250 / 2 = 125 CMD = 200 / 12 = 16,67 Ahora bien, el cuadrado medio entre grupos y el cuadrado medio dentro de grupos representan dos estimaciones independientes de la varianza poblacional, por lo tanto nos interesa saber si ambas estiman al mismo parámetro. Esto ocurre cuando las medias de todos los grupos son iguales (H0 verdadera), si esto no ocurre se concluye que la H0 es falsa. Para probar esta hipótesis se necesita una prueba estadística que evalúe la probabilidad de que dos varianzas muestrales estimen la misma varianza poblacional. Esta prueba es la prueba F que ya hemos visto. El estadístico de prueba es el cociente de las varianzas calculadas con los datos muestrales, es decir; F0 = 125,00 = 7,50 16,67 La varianza del numerador tiene c - 1 = 2 grados de libertad y la del denominador n - c = 12 grados de libertad. Luego, la estadística F0 sigue una distribución F con 2 y 12 grados de libertad. Si fijamos un nivel de significación α = 0,05, el valor crítico será: F0,95, 2, 12 = 3,89 Y la regla de decisión consistirá en rechazar H0 si F0 > 3,89. En nuestro ejemplo, 7,50 > 3,89 por lo cual se toma la decisión de rechazar H0 . El resultado obtenido parece indicar que la variabilidad entre los grupos no es igual a la variabilidad intrínseca del material experimental, y por lo tanto, la conclusión es que las dos varianzas muestrales no estiman a la misma varianza poblacional, o sea que debe ser rechazada la igualdad de medias. 9.2. Tabla de ANAVA Los resultados del análisis de la varianza se presentan generalmente en una tabla resumen llamada tabla ANAVA cuyo formato se presenta en la tabla siguiente. En la primera columna se informan las fuentes de variación (entre grupos, dentro de grupos y total) seguida por las respectivas sumas de cuadrados, grados de libertad, cuadrados medios y valor de la estadística F calculada. En la última columna se informa la significación de la prueba (conocida como valor de p) que indica la probabilidad de obtener una estadística F mayor o igual a la alcanzada, cuando la hipótesis nula es verdadera. Esto nos permite llegar directamente a una conclusión respecto a la hipótesis nula o problema planteado sin tener que referirnos a una tabla de la distribución F. De esta manera, cuando el valor de p es menor que el nivel de significación α elegido, la hipótesis nula es rechazada. 157 Cátedra I Estadística II Autor I Hebe Goldenhersch Tabla resumen del análisis de la varianza (ANAVA) Origen de las variaciones Sumas de cuadrados c Entre grupos ∑ n j (x j − x ) Dentro de grupos ∑ ∑ ( xij −x j ) Total 2 ∑ ∑ ( xij −x ) 2 j =1 c nj 2 j =1 i =1 Grados de libertad Cuadrados medios c-1 CME = SCE c −1 n-c CMD = SCD n−c valor de p F0 F= CME CMD p c nj j =1 i =1 n-1 A continuación se muestra la tabla de ANAVA correspondiente al procesamiento de los datos del ejemplo. ANAVA para volumen de producción de tres máquinas Fuente de variación Máquina Suma de cuadrados 250,00 Grados de libertad 2 Cuadrado medio 125,00 Error 200,00 12 16,67 Total 450,00 14 F Valor p 7,50 0,0077 Es posible observar que los resultados coinciden con los obtenidos en forma manual. La única diferencia se encuentra en la última columna que contiene el valor p exacto para el valor calculado de la estadística F0 (p = 0,0077). Este valor de p indica la probabilidad de obtener una estadística F0 de 7,50 o mayor cuando la hipótesis nula es verdadera. Puesto que p = 0,0077 es menor al valor especificado de α ( α = 0,05) la hipótesis nula es rechazada. De acuerdo con estos resultados, el gerente de producción encuentra evidencia suficiente para llegar a la conclusión de que existe un efecto significativo en los niveles del factor de interés, es decir, las tres máquinas. Se concluye, por lo tanto, que existe una diferencia significativa en el volumen promedio de produc- ción de las tres máquinas. Aclaración: Si quisiéramos realizar este análisis con el programa Excel, los datos deberían acomodarse de la siguiente manera: Maquina I 25 30 36 38 31 Máquina II 31 39 38 42 35 Máquina III 24 30 28 25 28 Posteriormente empleando el procesamiento Análisis de datos -Análisis de varianza de un factor, datos en columnas- se obtiene la siguiente salida: 158 Cátedra I Estadística II Autor I Nidia Blanch Análisis de varianza de un factor RESUMEN Grupos Cuenta 5 5 5 Máquina I Máquina II Máquina III ANÁLISIS DE VARIANZA Origen de las variaciones Dentro de los grupos SC 250,0 0 200,0 0 Total 450,0 0 Entre grupos Suma 160 185 135 Promedi o 32 37 27 Varianza 26,5 17,5 6 g.l. CM F Valor p F crítica 2 125,00 7,50 0,0077 3,89 12 16,67 14 9.3. Modelo estadístico y supuestos del ANAVA En el ANAVA, como en cualquier otra metodología de análisis de datos, es importante conocer el procedimiento que sigue el método para llegar a un resultado, pero no es menos importante conocer la fundamentación teórica subyacente. Se hace imprescindible, en el momento de elegir entre varias alternativas de procesamiento de datos, conocer cuáles son las características teóricas que hacen que un modelo de análisis sea mejor que otro. Por este motivo pasaremos ahora a desarrollar las características teóricas del modelo de ANAVA con un criterio de clasificación y efectos fijos. Modelo de ANAVA Podemos preguntarnos: ¿qué representa cada medición efectuada sobre una unidad experimental? Consideremos una observación cualquiera, x ij , por ejemplo (i-ésima observación correspondiente al j-ésimo grupo). Partiendo de la identidad: x ij = x ij es posible reconstruir sus componentes más importantes. En efecto, sumando y restando convenientemente, tenemos: x ij = x ij + (µ − µ) + (µ j − µ j ) = µ + (µ j − µ) + (x ij − µ j ) x ij = µ + t j + e ij (i =1, 2, ..., n j y j = 1, 2, .., c) Luego, podemos decir que en el ANAVA a un criterio de clasificación, cualquier observación puede descomponerse en estas tres componentes, donde: µ es la media poblacional de todas las observaciones. (µ j − µ) = t j es el efecto del j-ésimo tratamiento sobre la media µ . (x ij − µ j ) = eij es una componente aleatoria que refleja aquellos errores que no son atribuibles al tratamiento (o a sus diferentes niveles), sino a la fuente de error que 159 Cátedra I Estadística II Autor I Hebe Goldenhersch llamamos error experimental o error residual. Esto es así, por cuanto tales diferencias se calculan dentro de cada nivel de tratamiento. El término µ es constante para todas las mediciones en todos los tratamientos. El efecto t j es constante para todas las mediciones dentro de la población j. El error experimental eij es único para cada una de las observaciones en el experimento. Además, se supone que el efecto t j es independiente de eij . Dado que µ y t j son constantes para todas las mediciones dentro de la población j, la única fuente de variación para estas mediciones es la debida al error experimental. Ahora bien, si las unidades experimentales (productos producidos, individuos, etc.) son asignadas aleatoriamente a cada nivel del tratamiento, tendremos cierta seguridad de que el error experimental será independiente del efecto del tratamiento. De aquí surge la importancia de la aleatorización en el diseño de la investigación. El error experimental mide todos los efectos no controlados que no están relacionados con el tratamiento en sí mismo. Por lo tanto el error experimental es un efecto combinado de varias variables aleatorias que son independientes del efecto del tratamiento. En estas condiciones, es razonable suponer que la distribución de los errores dentro de la población j será aproximadamente normal con media 0 y varianza σ 2j . Si las fuentes del error experimental son comparables en cada uno de los tratamientos, es posible establecer que: σ12 = σ 22 = ... = σ c2 = σ 2 9.4. Supuestos del modelo De acuerdo con lo ya establecido, los supuestos subyacentes al modelo de análisis de la varianza a un criterio de clasificación, implican errores normalmente distribuidos e independientes y con varianzas homogéneas para todas las observaciones. La pregunta es ahora: ¿cómo podemos verificar el cumplimiento de estos supuestos? Dado que la única componente aleatoria del modelo es el error experimental, el análisis de los supuestos está referido al estudio de la distribución de estos errores. En la práctica dicho estudio se conoce como análisis de los residuales, dado que al error experimental también se lo denomina error residual. El análisis de la distribución de los residuales eij es de suma importancia, por cuanto a través de este estudio se pueden descubrir tanto una inadecuada formulación del modelo como violaciones a los supuestos del modelo establecido. El análisis de los residuales debe convertirse en una tarea rutinaria antes de aplicar cualquier procedimiento de análisis de los datos utilizando la metodología del análisis de la varianza. Veremos ahora como podemos verificar los supuestos de normalidad, independencia y varianza constante a partir del análisis de los residuales, eij . El cálculo de los residuales es muy sencillo de realizar. En un modelo de ANAVA de un solo factor, los residuales se obtienen restando a cada observación el valor predicho por el modelo que coincide con la media de su grupo. 160 Cátedra I Estadística II Autor I Nidia Blanch eij = x ij − x j 9.4.1. Supuesto de normalidad de errores La comprobación del supuesto que establece que los residuales deben estar normalmente distribuidos con media 0, puede efectuarse construyendo un histograma de frecuencias para los eij . Algunas veces, cuando la muestra es chica, se presenta el problema de la verificación de este supuesto. En estos casos, suele ocurrir que se producen alejamientos de la simetría por contar con muy pocos datos más que por un real alejamiento de la normalidad. En general, desviaciones moderadas de la normalidad no afectan al análisis de la varianza. Por ello se dice que el análisis de la varianza es un procedimiento robusto o consistente ante el supuesto de normalidad, debido a que la prueba F se ve muy poco afectada en este caso. También se puede probar este supuesto mediante el gráfico Q-Q (plot-normal). En el caso en que aparezca un residuo mayor que otros, esto puede distorsionar seriamente al análisis de los datos. Frecuentemente la causa de un residuo distanciado es un error de cálculo o de carga de datos. Si esta no es la causa, se debe investigar cuidadosamente las circunstancias experimentales con respecto a esta medición. Si la respuesta distanciada es un valor particular observado de la variable (alta resistencia, bajo costo, etc.) este residuo distanciado puede proporcionar más información que el resto de los datos. Hay que ser muy cuidadoso para no descartar o rechazar una observación distanciada, a menos que exista una base no estadística razonable para hacerlo. En el peor de los casos se pueden hacer dos análisis, uno con la observación atípica y otro sin ella. Un procedimiento para detectar residuos atípicos o inusitados es tomando los residuales estandarizados. rij = eij CMD Entonces, si los errores eij se distribuyen de manera normal, los residuos estandarizados deben ser aproximadamente normales con media cero y varianza uno. Luego, aproximadamente el 68% de los residuos estandarizados debe encontrarse entre los límites de ± 1, aproximadamente el 95% entre ± 2 y prácticamente todos deben estar entre ± 3. Sin embargo, la forma más apropiada de probar el supuesto de normalidad de los errores es mediante una prueba de hipótesis. La estadística de la prueba difiere de un programa de estadística a otro, pero en general las más empleadas son las de Kolmogorov-Smirnov (esta prueba se estudiará en el Capítulo VI) y de Shapiro-Wilks (ver Anexo al final del presente Capítulo). En esta oportunidad nos detendremos sólo en su interpretación). Veremos ahora el cumplimiento de este supuesto para el ejemplo considerado. En primer lugar, se presenta la tabla con los valores observados, el cálculo de los valores predichos (promedios de cada máquina), residuales (diferencia entre observado y predicho) y residuales estandarizados (cociente entre residual y desviación estándar del modelo). 161 Cátedra I Estadística II Autor I Hebe Goldenhersch Valores observados, predichos y residuales para las tres máquinas Máquina Valor observado Valor predicho 1 1 1 1 1 2 2 2 2 2 3 3 3 3 3 25 30 36 38 31 31 39 38 42 35 24 30 28 25 28 32 32 32 32 32 37 37 37 37 37 27 27 27 27 27 Residual - 7,0 - 2,0 4,0 6,0 - 1,0 - 6,0 2,0 1,0 5,0 - 2,0 - 3,0 3,0 1,0 - 2,0 1,0 Residual estandarizado - 1,71 - 0,49 0,98 1,47 - 0,24 - 1,47 0,49 0,24 1,22 - 0,49 - 0,73 0,73 0,24 - 0,49 0,24 Para verificar la normalidad de los residuales, construimos un histograma de frecuencias. Aunque el número de observaciones es reducido, es posible observar que no se encuentran alejamientos “sospechosos” de la normalidad. Frecuencia absoluta Histograma de residuales 7 6 5 4 3 2 Std. Dev = ,93 1 Mean = 0,00 N = 15,00 0 -2,50 -1,50 -,50 ,50 1,50 2,50 Residuales El reducido número de intervalos se debe a que se cuenta con pocos datos. Sin embargo, la distribución de los residuos es bastante simétrica. 162 Cátedra I Estadística II Autor I Nidia Blanch Valor normal esperado Gráfico Q-Q o normal-plot 2,0 1,5 1,0 ,5 0,0 -,5 -1,0 -1,5 -2,0 -2,0 -1,5 -1,0 -,5 0,0 ,5 1,0 1,5 2,0 Residual De acuerdo con este gráfico podemos decir que para nuestro ejemplo, los residuales se distribuyen de manera normal puesto que todos los puntos se ubican próximos a la línea imaginaria de 45o. No se observan valores atípicos. Para complementar los análisis gráficos, se pueden efectuar algunas pruebas de hipótesis (donde H0 representa la normalidad de los residuales). Este recurso no siempre está disponible en todos los programas y sólo suele ser de utilidad cuando se sospechan alejamientos importantes de la normalidad. Prueba de normalidad Variable dependiente RESIDUAL MAQUINA I II III Kolmogorov-Smirnov Estadística g.l. Sig. (p) ,181 5 ,200* ,194 5 ,200* ,258 5 ,200* Shapiro-Wilk Estadística g.l. Sig. (p) ,934 5 ,556 ,969 5 ,820 ,894 5 ,392 *. Límite inferior de significatividad Ambas pruebas de normalidad indican que los residuos para cada máquina se comportan de manera aproximadamente normal puesto que no se rechaza la hipótesis de normalidad en ningún caso a pesar del reducido tamaño de las muestras. Las consecuencias de la no-normalidad de los residuos no son demasiado graves. Únicamente una distribución muy asimétrica tendría un efecto marcado sobre el nivel de significación del test F o sobre la eficiencia del diseño. Cuando el supuesto de normalidad no puede ser mantenido, es posible recurrir a algún procedimiento no paramétrico o realizar una transformación adecuada a los datos para que se distribuyan normalmente. 9.4.2. Supuesto de independencia de errores La violación del supuesto de independencia de errores provoca un cambio en la varianza de error a través del tiempo en que dura la experiencia. Cuando la varianza no es constante produce un serio problema indicando que han variado las condiciones experimentales. 163 Cátedra I Estadística II Autor I Hebe Goldenhersch Ya hemos dicho que la aleatorización generalmente protege ante la correlación de errores. Sin embargo, si quedan dudas acerca del cumplimiento de este supuesto, puede efectuarse un gráfico en cuya abcisa se ubica el orden o momento en que se tomaron las observaciones y en la ordenada los respectivos residuales De esta forma, si se ordenan los datos dentro de cualquier grupo en un orden lógico independiente de su magnitud (ese orden puede ser, por ejemplo, en el que se obtuvieron los datos) esperaríamos que los eij se sucedan uno a otro en una secuencia aleatoria. Residual Observaciones ordenadas vs. Residuales 2 1 0 -1 -2 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 Orden de medición En él gráfico se presenta la distribución aleatoria de los residuales considerando el orden de las observaciones. Esto se visualiza por cuanto los residuales correspondientes a cada valor de la variable se ubican en el gráfico por encima y por debajo del valor 0, en una forma aleatoria. Si por el contrario en el gráfico se observara una sucesión de valores por debajo del 0 seguida por otra sucesión por encima del 0, en una forma no aleatoria, ello indicaría la presencia de errores sistemáticos. 9.4.3. Independencia entre residuos y variable de respuesta Otro supuesto importante de independencia es el referido a la independencia entre los residuos y la variable de respuesta. Si el modelo es correcto y las suposiciones se satisfacen, los residuos no deben tener ningún patrón ni deben estar relacionados con otra variable. La única manera de probar que esto realmente es así, es mediante el estudio de la independencia entre errores y la variable de respuesta. Este supuesto puede ser verificado por medio de un gráfico adecuado. En la abcisa se ubican los valores estimados de las observaciones y en la ordenada los residuales correspondientes. Residuales vs. valores predichos 164 Residuales Cátedra I Estadística II Autor I Nidia Blanch 2,0 1,5 1,0 ,5 0,0 -,5 MAQUINA -1,0 III -1,5 II -2,0 I 26 28 30 32 34 36 38 Valores predichos Como muestra la figura anterior, los valores estimados (predichos) corresponden a las medias de grupos. Lo que interesa observar es luego, que los residuales se ubiquen en forma aleatoria por encima y por debajo del valor 0 (promedio de residuales). 9.4.4. Supuesto de varianza constante para todos los grupos La figura de Residuos vs. Valores predichos, también nos permite verificar el supuesto de varianza constante. Si el gráfico presenta un dibujo semejante a un embudo (en forma de V corta), esto indicará que a medida que aumentan los valores de la variable, aumenta la varianza. Esto sucede cuando el error es proporcional a la magnitud de las observaciones (comúnmente esto sucede con muchos instrumentos de medición, el error es proporcional a la escala de lectura). La varianza variable también ocurre cuando los datos no tienen distribución normal, porque en las distribuciones asimétricas la varianza tiende a ser función de la media. La igualdad de varianzas en un grupo de muestras es una importante precondición para muchas pruebas estadísticas. Sinónimos de esta condición son homogeneidad de varianzas u homoscedasticidad. La condición inversa, desigualdad de varianzas entre muestras, se denomina heteroscedasticidad. Aunque dijimos que el supuesto de igualdad de varianzas puede ser visualizado por medio de un gráfico, también existen diferentes pruebas estadísticas que verifican la hipótesis de homoscedasticidad. Una de las más empleadas es la prueba de Hartley. La prueba de Hartley es el procedimiento más simple para probar la hipótesis de igualdad de varianzas poblacionales, pero requiere del supuesto de normalidad de los datos. La estadística de prueba es: Fmáx = 2 s máx 2 smín que tiene distribución Fmax de Hartley con c y ( n − 1 ) grados de libertad. Donde: 2 smáx = mayor varianza muestral 165 Cátedra I Estadística II Autor I Hebe Goldenhersch 2 smín = menor varianza muestral c n= ∑ nj j =1 c = n c (sólo se utiliza la porción entera de este valor) Las hipótesis que se someten a prueba son: H0 : σ12 = σ 22 = ... = σ c2 H1 : no todas las varianzas son iguales. Con los datos de nuestro ejemplo tenemos: s12 = 26.5 Fmáx = s 22 = 17.5 2 s máx 2 smín = s 32 = 6.0 26.5 = 4.42 6.0 Si se selecciona un nivel de significación de 0,05, la regla de decisión será rechazar H0 si Fmáx > Fmáx[3,4] = 15,5 (ver tablas de Hartley en las tablas en estadísticas). Por lo tanto, en nuestro caso no se rechaza la hipótesis nula y se concluye que no existe evidencia de una diferencia en la varianza de las tres máquinas. Cuáles pueden ser las razones de esta heterogeneidad? En un ANAVA que represente los resultados de una experiencia, puede ocurrir que una muestra se haya obtenido en condiciones menos normalizadas que otras y, por lo tanto, tengan una varianza mayor. Existen también muchos casos en que la heterogeneidad de varianzas es consecuencia de haber elegido mal la escala de medición. Estas desviaciones de la hipótesis de igualdad de varianzas pueden, a menudo, corregirse empleando una adecuada transformación de los datos. 9.5. Comparaciones múltiples Cuando el cociente calculado para F en la tabla ANAVA es mayor que el correspondiente valor crítico de tabla, la hipótesis nula: H0 : µ1 = µ 2 = ... = µ c se rechaza, aceptándose en consecuencia la H1 de que no todas las medias son iguales, es decir que una o tal vez todas son diferentes. De esta manera la prueba F nos revela la existencia de diferencias entre las medias, pero no nos dice nada acerca de la localización de tales diferencias. Existen diferentes procedimientos o pruebas para la comparación de medias de grupos que reciben el nombre de comparaciones múltiples. Entre ellas las más conocidas son: la prueba de mínima diferencia significativa o prueba LSD (least significant defference), la prueba de Tukey, Scheffé, Duncan, Dunett, Student-Newman-Keuls, etc. 166 Cátedra I Estadística II Autor I Nidia Blanch Presentamos aquí una prueba para la comparación entre las medias de grupos, la prueba de Tukey-Kramer, comentando sus ventajas y desventajas. Tukey y Kramer desarrollaron un procedimiento de comparaciones múltiples basado en el recorrido o rango studentizado que tiene un error de tipo I ( α ), constante para todas las comparaciones de medias de a pares. Este procedimiento requiere el uso de un valor QU = qα (c, g.l. error) para determinar el valor crítico de todas las comparaciones independientemente de cuantas medias tenga el experimento. Es decir, la prueba de Tukey–Kramer determina que dos medias son significativamente diferentes si el valor absoluto de sus diferencias muestrales excede a: CMD 1 1 + 2 n j n j' Tα = q α (c, g.l. error) siendo q una variable aleatoria que corresponde al rango studentizado. Los parámetros de esta variable q son; c = cantidad de grupos o niveles del tratamiento y g.l. error = grados de libertad del error. Los valores de q se encuentran tabulados en una tabla de rangos studentizados (ver bibliografía de referencia). Luego se compara este valor crítico con el de las diferencias entre las medias de grupos. En general, la prueba de Tukey–Kramer es más exigente o “más difícil” para establecer que dos medias son significativamente diferentes respecto a otras pruebas de comparaciones múltiples. Sin embargo, esta prueba suele ser empleada cuando se necesita tener una gran certeza de que, si se verifica una diferencia entre medias de dos grupos, esta diferencia realmente exista. Para emplear el procedimiento de Tukey-Kramer, simplemente se comparan las diferencias observadas entre cada par de promedios con el valor correspondiente de la estadística Tα . Si x j − x j' > Tα se concluye que las medias poblacionales µ j y µ j' son diferentes. Para ilustrar este procedimiento emplearemos los datos de nuestro ejemplo. Supongamos un error de tipo I del 0,05, luego: T0,05 = q 0,05 (3, 12) 16.67 2 1 1 5 + 5 = 3,77 x 1,826 = 6,88 Entonces, un par de medias difiere significativamente si el valor absoluto de su diferencia es mayor a 6,88. En nuestro ejemplo los promedios de volumen de producción de las tres máquinas son los siguientes: x1 = 32 x 2 = 37 167 y x 3 = 27 Cátedra I Estadística II Autor I Hebe Goldenhersch y las diferencias de promedios son: x1 − x 2 = 32 − 37 = 5 < 6,88 no significativa x1 − x 3 = 32 − 27 = 5 < 6,88 no significativa x 2 − x 3 = 37 − 27 = 10 * > 6,88 significativa Luego, es posible observar que los volúmenes de producción de las tres máquinas no son todos iguales. En particular, la máquina III tiene el menor volumen de producción horario, seguida por la máquina I y luego por la máquina II. La máquina II tiene un volumen de producción horaria significativamente superior al de la máquina III. Finalmente es posible concluir que el gerente de producción debería comprar la máquina II. Sin embargo si sus costos no fueran iguales, debería decidir sabiendo que entre las máquinas I y II no hay diferencias como tampoco entre la máquina I y la III. Actividad 28: Se ha realizado un experimento para determinar si cuatro temperaturas específicas de horneado afectan la densidad de un cierto tipo de producto. El experimento se realizó considerando 4 temperaturas diferentes. Los resultados obtenidos se muestran a continuación: Temperatura Densidad 100 21.8 21.9 21.7 21.6 125 21.7 21.4 21.5 21.4 150 21.9 21.8 21.8 21.6 175 21.9 21.7 21.8 21.4 a) ¿Afecta la temperatura de horneado a la densidad del producto? b) Realice un gráfico de promedios para temperaturas. c) Obtenga todas las conclusiones posibles. Actividad 29: El gerente de compras de una empresa que fabrica videocasetes tiene la opción de comprar componentes de cinco proveedores. Para determinar cual es el mejor proveedor, le compra a cada uno ocho lotes con la misma cantidad de productos y cuenta el número de componentes defectuosos por lote. Para tomar su decisión, utilizó un ANAVA obteniendo los siguientes resultados: Fuente de variación Proveedor Error Suma de cuadrados 496.54 Grados de libertad Cuadrado medio F Sig. 333.20 Total a) b) c) d) e) Determine las hipótesis nula y alternativa. Complete la tabla de ANAVA. Determine las reglas de decisión para un nivel de significación del 0,01. ¿Cuál será la conclusión del gerente de compras? ¿Puede determinar el gerente cuál es el mejor proveedor con los resultados del ANAVA? f) ¿Cómo debería hacer para saberlo? Actividad 30: Un economista agrario debe efectuar un estudio económico relacionado con los 168 Cátedra I Estadística II Autor I Nidia Blanch rendimientos de diferentes cultivares de maíz. Para ello, realiza un experimento empleando un diseño completamente aleatorizado con 10 repeticiones o parcelas por cultivo. La variable que estudia o variable de respuesta es el rendimiento en Kgs/Ha. Los resultados obtenidos fueron los siguientes: a) b) c) d) e) f) Cultivar 1 Cultivar 2 Cultivar 3 Cultivar 4 115.77 106.78 112.24 77.13 90.16 115.19 147.12 126.61 110.01 68.00 60.47 76.93 66.40 81.59 73.51 76.01 62.93 77.32 97.14 94.49 137.95 111.32 147.07 91.44 159.20 166.68 90.52 119.41 85.51 91.47 104.88 164.70 73.54 102.49 114.99 110.91 90.64 127.51 78.56 86.14 Determinar las hipótesis nula y alternativa. Calcular los residuales y residuales estandarizados para cada observación. Verificar los supuestos de normalidad, aleatoriedad y varianzas iguales. Construir la tabla de ANAVA. Trabajar con α = 0,10. ¿Son los cuatro cultivares igualmente rendidores? Obtener todas las conclusiones posibles. Actividad 31: En la cátedra de Estadística se asignaron en forma aleatoria 26 alumnos a tres modalidades de examen final: oral, escrito con desarrollos y escrito con alternativas. El objetivo es definir la mejor forma de evaluación, en función de la nota final obtenida por los alumnos, a fin de implementarla en los años siguientes. Las notas obtenidas por este grupo de alumnos fueron: Oral 8 6 7 7 10 4 4 5 6 4 Escrito (con desarrollos) 7 7 3 6 5 2 7 Escrito (con alternativas) 3 2 7 2 7 6 5 4 6 A partir de estos datos, ¿se puede recomendar, con un riesgo del 5%, alguna técnica de examen en particular? ¿Qué supuestos debería corroborar para que su conclusión sea válida, y cómo lo haría? Actividad 32: La siguiente tabla muestra información sobre el tiempo (en min.) requerido por una línea de transporte para realizar su trayecto, teniendo en cuenta cuatro recorridos distintos. Dicho trayecto fue efectuado en 7 oportunidades utilizando los distintos recorridos, y una vez procesada la información se obtuvieron los resultados que muestra la salida siguiente. ¿Es el “recorrido” un factor que influya en el tiempo que se tarda para realizar el trayecto? En caso afirmativo, ¿qué trayecto recomendaría a la empresa de transporte teniendo en cuenta que los pasajeros valoran mucho la rapidez de un 169 Cátedra I Estadística II Autor I Hebe Goldenhersch sistema de transporte? ¿Se cumplen los supuestos que requiere la aplicación del test F? Recorrido 1 65 87 73 79 81 69 76 Recorrido 2 59 78 67 62 83 76 71 Recorrido 3 94 89 80 88 83 80 86 Recorrido 4 75 69 83 81 72 79 90 Análisis de la varianza Variable tiempo N 28 R² 0,39 R²Aj 0,32 CV 9,30 Cuadro de Análisis de la Varianza F.V. Modelo Recorrido Error Total SC 808,68 808,68 1253,43 2062,11 gl 3 3 24 27 CM 269,56 269,56 52,23 F 5,16 5,16 Valor p 0,0068 0,0068 Test: Tukey Alfa: 0,05 DMS: 10,65543 Error: 52,2262 gl: 24 recorrido Medias n 2 70,86 7 A 1 75,71 7 A 4 78,43 7 A 3 85,71 7 B B B Q-Q plot 13,71 Diagrama de dispersión n= 28 r= 0,991 13,34 6,85 6,74 RDUO_tiempo Cuantiles observados(RDUO_tiempo) Letras distintas indican diferencias significativas(p<=0,05) 0,00 -6,85 -13,71 -13,71 -6,85 0,00 6,85 0,14 -6,46 13,71 Cuantiles de una Normal(-2,0321E-16,46,423) -13,06 70,11 74,20 RDUO_tiempo Shapiro-Wilks (modificado) Variable n 78,29 82,37 PRED_tiempo Media D.E. 170 W* p (una cola) 86,46 Cátedra I Estadística II Autor I Nidia Blanch RDUO_tiempo 28 0,00 6,81 0,94 0,3233 Actividad 33: En base a los datos de la EPH de Córdoba correspondiente a Octubre 2001 se ha procesado la siguiente información. Indique claramente cuál ha sido la hipótesis de trabajo, qué refleja cada tabla y cuál será la conclusión final a partir del análisis de las mismas. Descriptives Ingreso de la ocupación ppal. asalariado otros cuentapropista patrón Total N 610 10 240 27 887 Mean 467,06 437,00 387,52 932,59 459,37 Std. Deviation 360,60 198,83 365,12 511,47 376,42 95% Confidence Interval for Mean Lower Upper Bound Bound 438,39 495,73 294,76 579,24 341,09 433,95 730,26 1134,92 434,56 484,18 Std. Error 14,60 62,88 23,57 98,43 12,64 Min. 20 200 15 300 15 Max. 3500 800 2500 3000 3500 Test of Homogeneity of Variances Ingreso de la ocupación ppal. Levene Statistic ,790 df1 df2 3 Sig. ,500 883 ANOVA Ingreso de la ocupación ppal. Between Groups Within Groups Total Sum of Squares 7326390 1,18E+08 1,26E+08 df 3 883 886 Mean Square 2442130,140 133873,364 F 18,242 Sig. ,000 Ingreso de la ocupación ppal. Tukey HSD a,b Categoría ocupacional cuentapropista otros asalariado patrón Sig. N 240 10 610 27 Means for groups in homogeneous subsets are displayed. a. Uses Harmonic Mean Sample Size = 28,003. b. The group sizes are unequal. The harmonic mean of the group sizes is used. Type I error levels are not guaranteed. 171 Subset for alpha = .05 1 2 387,52 437,00 467,06 932,59 ,848 1,000 Cátedra I Estadística II Autor I Hebe Goldenhersch Multiple Comparisons Dependent Variable: Ingreso de la ocupación ppal. Tukey HSD (I) Categoría ocupacional asalariado otros cuentapropista patrón (J) Categoría ocupacional otros cuentapropista patrón asalariado cuentapropista patrón asalariado otros patrón asalariado otros cuentapropista Mean Difference (I-J) 30,06 79,54* -465,53* -30,06 49,48 -495,59* -79,54* -49,48 -545,07* 465,53* 495,59* 545,07* Std. Error 116,65 27,88 71,96 116,65 118,09 135,45 27,88 118,09 74,27 71,96 135,45 74,27 Sig. ,994 ,022 ,000 ,994 ,975 ,001 ,022 ,975 ,000 ,000 ,001 ,000 95% Confidence Interval Lower Upper Bound Bound -269,61 329,73 7,91 151,16 -650,39 -280,67 -329,73 269,61 -253,90 352,86 -843,56 -147,63 -151,16 -7,91 -352,86 253,90 -735,87 -354,27 280,67 650,39 147,63 843,56 354,27 735,87 *. The mean difference is significant at the .05 level. Actividad 34: Los siguientes datos corresponden a las ventas (en miles de $) computadas durante 7 meses, según la localización de una determinada marca de aceite a lo largo de un pasillo, en un hipermercado local. Las localizaciones estudiadas fueron: al comienzo, a la mitad y al final del pasillo. Comienzo Mitad Final 31 29 30 36 35 34 37 41 38 42 35 36 35 39 35 34 36 39 40 38 39 n1 = 7 n2 = 7 n3 = 7 x1 = 33 x2 = 38 x3 = 37 s = 20 s = 18 s32 = 13 2 1 2 2 Plantee las hipótesis que correspondan a fin de determinar si la localización del producto influye en el monto de ventas mensuales. Utilice un nivel de significación de 0,10. Completamos aquí el Capítulo III. En el próximo encararemos uno de los temas más interesantes y que genera gran cantidad de aplicaciones en diversas áreas. Hasta aquí hemos trabajado con una variable en una, dos o más poblaciones. Comenzaremos a estudiar “Relaciones entre variables”; en primer lugar lo haremos con el Análisis de Regresión y Correlación. 172 Cátedra I Estadística II Autor I Nidia Blanch Anexo Uno de los supuestos que se establecen al realizar una prueba de hipótesis es que la variable se distribuye normalmente. Cuando se realizan pruebas con respecto al parámetro media poblacional, el teorema central del límite apoya la distribución normal de la variable media muestral, pero no ocurre lo mismo cuando se realizan pruebas con respecto al parámetro varianza poblacional. Por ello, una práctica común consiste en realizar una prueba de hipótesis de la normalidad de la variable en estudio. Existen varias pruebas para decidir si se cumple la siguiente hipótesis nula: H0) La distribución poblacional de la variable es normal Contra la alternativa: H1) La distribución poblacional de la variable no es normal Estas pruebas pertenecen a la categoría c), que dimos oportunamente. Estudian la forma de la distribución de una variable y entran en la categoría de pruebas no paramétricas; las cuales se estudiarán en el Capítulo VI. No obstante, dado que en este Capítulo se han realizado algunas pruebas de normalidad, incluimos en este anexo, la prueba de Shapiro-Wilks21/. Veamos un ejemplo de aplicación del test. Este ejemplo pertenece al libro de Daniel Peña: “Fundamentos de Estadística”. H0) la distribución de la variable en la población es normal H1) la distribución de la variable en la población no es normal Supongamos que se tiene una muestra de tamaño 7: x1 = 20 x2 = 22 x3 = 24 x4 = 30 x5 = 31 x6 = 32 x7 = 38 Con estos datos calculamos la media y la desviación estándar: x = 28.14 s = 6.39 La prueba de Shapiro-Wilks considera el ajuste a una recta de la muestra representada en papel probabilístico normal. Se rechaza la normalidad cuando este ajuste es malo, que se dá cuando se obtienen valores pequeños del estadístico. El estadístico es el siguiente: w= donde 1 ns 2 2 A2 h a ( x − x = ∑ j =1 j.n ( n − j +1) ( j ) ns 2 ns 2 = ∑( xi − x ) 2 , h = n/2 si n es par e igual a (n-1)/2 si n es impar. Los coeficientes aj.n están tabulados en una tabla especial y x(j) es el valor ordenado de la muestra que ocupa el lugar j. La distribución de w también esta tabulada y se rechaza la normalidad cuando el valor calculado es menor que el valor crítico proporcionado por dicha tabla. La razón de esto es que w mide el ajuste a la recta y no la discrepancia con la hipótesis nula planteada. Esta breve explicación de la prueba de normalidad de Shapiro-Wilks es únicamente para que se interprete la salida de un programa estadístico y no para que se calcule el estadístico w. 21/ En el Capitulo IV se presentan otras pruebas de bondad de ajuste para la normal, entre ellas la de Kolmogorov-Smirnov. 173 Cátedra I Estadística II Autor I Hebe Goldenhersch 174