Comparación de variables “continuas” Familias

Anuncio

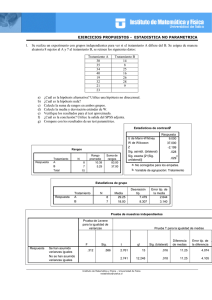

Métodos Paramétricos vs No Paramétricos Introducción Familias param. y no-param. • Familias paramétricas: Funciones de distribución caracterizadas por pocos parámetros • Familias no paramétricas: Funciones de distribución que no se pueden caracterizar con pocos parámetros Comparación de variables “continuas” • Métodos paramétricos: Métodos estadísticos válidos para la familia de las distribuciones normales • Métodos no paramétricos: Métodos estadísticos válidos para una familia de distribuciones no paramétricas. También se les llama métodos estadísticos de distribución libre puesto que sus propiedades estadísticas no dependen de la distribución de la población que se estudia 2 Métodos Paramétricos vs No Paramétricos Introducción Métodos Paramétricos vs No Paramétricos Introducción Métodos No Paramétricos Ventajas • Requieren pocas asunciones (normalidad) • El cálculo manual es más rápido en muestras pequeñas Ventajas • Son a menudo más fáciles de entender • Son relativamente insensibles a valores extremos Desventajas 3 Métodos Paramétricos vs No Paramétricos Introducción 4 Métodos Paramétricos vs No Paramétricos Introducción Ventajas Desventajas • Son aplicables en muchas situaciones donde los métodos paramétricos no lo son. Muchos métodos no paramétricos precisan sólo los rangos de las observaciones, en vez de la magnitud. • Los métodos jacknife y boostrap permiten una aproximación en situaciones muy complicadas. • El desarrollo de programas informáticos ha facilitado un rápido cálculo del p-valor en los métodos no paramétricos condicionados. Por eso, en principio, siempre es posible el cálculo exacto del p-valor. 5 • Cuando las variables son normales (en cuyo caso ambos métodos son válidos) son menos eficientes (potentes). – En este caso el p-valor excede al obtenido por métodos paramétricos. Así es más difícil encontrar un resultado significativo con una prueba no paramétrica. Aunque la diferencia no es muy grande • El cálculo manual con muestras grandes es tedioso y largo • Permiten menos refinamientos en el análisis posterior, más detallado, de los datos. 6 Métodos Paramétricos vs No Paramétricos Introducción Métodos Paramétricos vs No Paramétricos Introducción Tamaño de la muestra Rangos Puntuaciones • Un factor que limita la aplicabilidad de los métodos paramétricos es el tamaño de la muestra disponible para el análisis. • Las pruebas no paramétricas usan el orden de los datos para su análisis • Podemos asumir que la distribución de la muestra es normal aunque no estemos seguros si la variable en la población es normal, siempre que nuestra muestra sea suficientemente grande (p.e. 30 o 100 observaciones o más). • Rango: El orden de cada uno de los datos • Puntuación (“score”): Se transforma el rango en una puntuación para realizar la prueba estadística • Si nuestra muestra es pequeña, entonces estos métodos pueden ser usados solamente si estamos seguros de que la variable se distribuye normalmente y no hay manera de comprobar esta asunción si la muestra es pequeña. • Los empates pueden tratarse de diferente manera 7 8 Métodos Paramétricos vs No Paramétricos Introducción Métodos Paramétricos vs No Paramétricos Introducción Rangos Puntuaciones Comprobación Normalidad • Ejemplo Datos Wilcoxon Median VW Savage 1 1 2 3 2 0 -0,90846 -0,78889 3,5 0 -0,47667 -0,59246 3 3,5 0 -0,47667 -0,59246 4 5 5 0 -0,11419 -0,35437 6,5 1 5 6 6,5 7 8 0 -1,33518 -0,90000 Siegel-Tukey Ansari-Bradley Klotz Mood 1 1,78271 20,25 4 2 0,82530 12,25 6,5 3,5 0,22721 6,5 3,5 0,22721 4 10 5 0,01304 0,25 0,23147 -0,02937 8,5 4,5 0,05358 1 1 0,23147 -0,02937 8,5 4,5 0,05358 1 8 1 0,60459 0,42897 5 3 0,36553 6,25 9 1 0,90846 0,92897 3 2 0,82530 12,25 10 1 1,33518 2 1 1,78271 20,25 1,92897 1 4 • Prueba de Kolmogorov-Smirnov – SAS también realiza los estadísticos de Anderson-Darling y Cramer-von Mises – Se basan en las diferencias entre la distribución observada y la esperada • Estadístico de Shapiro-Wilks – El SPSS versión 8 lo calcula para muestras 50 observaciones – El SAS lo calcula para muestras 2000 observaciones 9 Métodos Paramétricos vs No Paramétricos Introducción 10 Métodos Paramétricos vs No Paramétricos Introducción Comprobación Normalidad Preguntas comunes • Hay que tener en cuenta que la capacidad de una prueba de rechazar la hipótesis nula (potencia) aumenta con el tamaño de la muestra • Si las pruebas no paramétricas con válidas para los datos con o sin distribución normal, ¿porqué no usarlos siempre? – Con tamaños de muestra grandes se pueden detectar desviaciones pequeñas de la normalidad – Puesto que pequeñas desviaciones no afectan gravemente a la validez de las pruebas estadísticas es importante examinar otras pruebas y los gráficos 11 12 Métodos Paramétricos vs No Paramétricos Introducción Métodos Paramétricos vs No Paramétricos Introducción Preguntas comunes Preguntas comunes – Se prefieren las pruebas paramétricas porque: • Raramente estamos interesados sólo en la significación estadística; muchas veces queremos conocer aspectos de la población original, y esto se consigue con estimadores e intervalos de confianza • ¿Las pruebas no paramétricas comparan medianas? • Es difícil hacer un modelo flexible con las pruebas no paramétricas, por ejemplo para factores de confusión en regresión múltiple 13 14 Métodos Paramétricos vs No Paramétricos Introducción Métodos Paramétricos vs No Paramétricos Introducción Preguntas comunes Elección de la prueba Datos independientes – Es una creencia común que la prueba de MannWhitney es, de hecho, una prueba para diferencias entre medianas. • Sin embargo, dos grupos podrían tener la misma mediana y tener una prueba significativa. • Considerar los siguientes datos de dos grupos con 100 observaciones. – Grupo 1: 98 (0), 1, 2. – Grupo 2: 51 (0), 1, 48 (2). – La mediana en ambos casos es 0. – Prueba de Mann-Whitney: p<0.0001 Nominal Variable Inicial 2 Nominal o Fisher Categórica (>2 categorías) 2 Variable Resultado Ordinal Cuantitativa Discreta 2 -tendencia Manno Mann-W. Whitney KruskalKruskalWallis Wallis Spearman Spearman Cuantitativa No-Normal Mann-Whitney o log-rank (1) Kruskal-Wallis 2 2 (2) Cuantitativa Discreta Cuantitativa No-Normal 2 -tendencia o Mann-Whitney Regresión Logística Regresión Logística (2) (2) Spearman Spearman (2) (2) (2) Gráfico datos y Pearson o Spearman Cuantitativa Normal Regresión Logística (2) (2) (2) Regresión lineal Categórica (>2 cat.) Ordinal Spearman Análisis de la varianza Spearman o regresión lineal Spearman o regresión lineal Gráfico datos y Pearson o Spearman y regresión lineal Pearson y regresión lineal P.e. ensayo clínico: Var.de entrada=Tipo de tratamiento (nominal). Var.resultado=Colesterol (cuant.normal). t-Student P.e. Var.de entrada=Puntuación clínica (cuantitativa). Var.resultado=Curación (nominal). Regresión logística (1) (2) 15 Si los datos son censurados Hay muchas técnicas avanzadas. Sin embargo, requieren ciertas asunciones y a menudo es más fácil dicotomizar la variable resultado o tratarla como continua 16 Métodos Paramétricos vs No Paramétricos Introducción Elección de la prueba Datos apareados Variable Nom inal O rdinal (Categorías ordenadas) Cuantitativa (Discreta o No-Normal) Cuantitativa (Norm al) Cuantitativa Normal t-Student Prueba M cNemar W ilcoxon W ilcoxon t-test para datos apareados 17 Estimación y análisis Supón que todos los datos numéricos de tu muestra son cuantitativos y procede en consecuencia. Puede que el ordenador te calcule la media de la situación civil RESULTADOS Situación civil 3,4 Sexo 2,3 Conduce 1,3 No compruebes si tus datos siguen una ley normal. Las pruebas no paramétricas no son tan divertidas. 19 20 K-S de 1 muestra / Normal H0: NORMALIDAD H1: NO NORMALIDAD Prueba de Kolmogorov-Smirnov para una muestra SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 a. La distribución de contraste es la Normal. b. Se han calculado a partir de los datos. 21 K-S de 1 muestra / Normal H0: NORMALIDAD p 0.05 22 K-S de 1 muestra / Normal H1: NO NORMALIDAD H0: NORMALIDAD p 0.05 p < 0.05 Prueba de Kolmogorov-Smirnov para una muestra SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) p < 0.05 Prueba de Kolmogorov-Smirnov para una muestra PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) a. La distribución de contraste es la Normal. b. Se han calculado a partir de los datos. H1: NO NORMALIDAD PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 a. La distribución de contraste es la Normal. 23 b. Se han calculado a partir de los datos. 24 Pueden haber muchas formas... ...y NO hay normalidad • Transformar la variable (A) (B) 0 50 100 150 x 0 1 2 3 4 5 x^0,25 80 x (C) 60 (D) 0 20 40 ¿Raíz cuarta de ‘algo’? 0.2 0.4 0.6 0.8 1.0 1.2 1.4 1.6 x^0.25 25 26 No pasa nada, hay otras técnicas • Técnicas basadas en –Rangos –Puntuaciones –Signos ¿Son independientes las variables? 27 Métodos 28 Ejemplo de los gemelos Clark y cols. realizaron diferentes pruebas psicológicas en gemelos bicigóticos (p.e. no idénticos) para comprobar si había relación entre entre ellas. • Métodos paramétricos – Coef. de correlación de Pearson • Métodos no paramétricos – Coef. de correlación de Spearman – Kendall tau 29 Pareja Gemelo 1 Gemelo 2 1 277 256 2 169 118 3 157 137 4 139 144 5 108 146 6 213 221 7 232 184 8 229 188 9 114 97 10 232 231 11 161 114 12 149 187 13 128 230 30 Si lo graficamos... 300 250 200 150 100 50 50 100 150 200 250 300 31 32 Coef. de correlación de Pearson Correlations GEMELO1 GEMELO2 Pearson Correlation Sig. (2-tailed) N Pearson Correlation Sig. (2-tailed) N GEMELO1 GEMELO2 1,000 ,649* , ,016 13 13 ,649* 1,000 ,016 , 13 13 *. Correlation is significant at the 0.05 level (2-tailed). Se interpreta en términos de variabilidad explicada 33 34 Kendall tau GEMELO1 GEMELO2 Coef. de correlación de Spearman GEMELO1 Correlation Coefficient Sig. (2-tailed) GEMELO1 GEMELO2 GEMELO1 Correlation Coefficient Sig. (2-tailed) N GEMELO2 Correlation Coefficient Sig. (2-tailed) N 1.000 0.514 , 0.072 13 13 0.514 1.000 0.072 , 13 13 N GEMELO2 Correlation Coefficient Sig. (2-tailed) N 1,000 0,348 , 0,099 13 13 0,348 1,000 0,099 , 13 13 Es similar a Spearman en términos. Sin embargo son muy diferentes en cuanto a la magnitud puesto que los cálculos son muy diferentes (Spearman: rangos; Kendall: signos). Al igual que el coef. de correlación de Pearson se interpreta en términos de variabilidad explicada. La diferencia es que el coef. de Spearman se calcula con rangos. Se interpreta como la diferencia entre la probabilidad que en los datos observados las dos variables estén en el mismo orden versus la probabilidad que las dos variables estén en diferente orden. 35 36 Métodos • U de Mann Whitney - Independencia observaciones - Distribución de Probabilidad contínua Este test fue desarrollado en 1945 por Wilcoxon y después ampliado por Mann y Whitney en 1947. De ahí que en algunos libros se denomine test de Wilcoxon y en otros la prueba U de MannWhitney. INDEPENDIENTES 38 Que en términos de eficiencia... Características El test U de Mann-Whitney, también denominado test de Wilconxon-Mann-Whitney, o test de la suma de rangos de Wilcoxon, evalúa los rangos de las puntuaciones combinadas de dos grupos independientes. En Es el test no paramétrico con más potencia estadística. N Paramétrico N No _ Paramétrico Siendo n el tamaño muestral necesario para conseguir Una determinada potencia del test. Para el caso de la U de Mann-Whitney E=95, es decir, si para el test paramétrico se necesita n=100, para el homólogo no paramétrico es suficiente con 95 39 40 ¿Pero qué supone el Test? ¿Cómo trabaja? • • Supone que la forma de las muestras a comparar son la misma, sin tener en cuenta dicha forma Este test examina la siguiente hipótesis nula: - “La probabilidad de que una observación obtenida al azar de la primera población supere una observación aleatoria de la segunda población es igual a 1/2”. • El test es sensible a diferencias de medianas • Poco sensible a diferencias de asimetría • Insensible a diferencias de varianzas • Resistente a los “outliers” 41 42 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) Ejemplo V. CUANTITATIVA NORMALEN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Grupos apareados Estadística / Comparar medias / Prueba T para muestras relacionadas V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? 43 Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal 44 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Grupos apareados Estadística / Comparar medias / Prueba T para muestras relacionadas V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal 45 46 47 48 K-S de 1 muestra / Normal K-S de 1 muestra / Normal H0: NORMALIDAD H0: NORMALIDAD H1: NO NORMALIDAD p 0.05 Prueba de Kolmogorov-Smirnov para una muestra SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) p < 0.05 Prueba de Kolmogorov-Smirnov para una muestra PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 Media Desviación típica Absoluta Positiva Negativa H1: NO NORMALIDAD SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) a. La distribución de contraste es la Normal. b. Se han calculado a partir de los datos. PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 a. La distribución de contraste es la Normal. 49 b. Se han calculado a partir de los datos. 50 K-S de 1 muestra / Normal H0: NORMALIDAD H1: NO NORMALIDAD p 0.05 p < 0.05 Prueba de Kolmogorov-Smirnov para una muestra SEXO hombre N Parámetros normales a,b Diferencias más extremas mujer Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) N Parámetros normales a,b Diferencias más extremas Media Desviación típica Absoluta Positiva Negativa Media Desviación típica Absoluta Positiva Negativa Z de Kolmogorov-Smirnov Sig. asintót. (bilateral) PESO INICIAL (kg) 23 89.57 3.47 .115 .075 -.115 .552 .921 27 80.22 5.37 .179 .179 -.105 .931 .352 a. La distribución de contraste es la Normal. b. Se han calculado a partir de los datos. 51 52 53 54 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Grupos apareados Estadística / Comparar medias / Prueba T para muestras relacionadas V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal Prueba T para muestras independientes H0: H1: 55 Prueba T para muestras independientes H0: 56 Prueba T para muestras independientes H1: H0: Estadísticos del grupo PESO INICIAL (kg) SEXO hombre mujer N 23 27 Media 89.57 80.22 H1: Estadísticos del grupo Error típ. de la media .72 1.03 Desviación típ. 3.47 5.37 PESO INICIAL (kg) SEXO hombre mujer N Media 89.57 80.22 23 27 Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas F PESO INICIAL (kg) Se han asumido varianzas iguales No se han asumido varianzas iguales 3.896 Sig. .054 Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas Prueba T para la igualdad de medias t Sig. (bilateral) gl Error típ. de la media .72 1.03 Desviación típ. 3.47 5.37 Diferencia de medias Error típ de la diferencia Intervalo de confianza para la diferencia Inferior Superior 7.163 48 .000 9.34 1.30 6.72 11.97 7.406 45.009 .000 9.34 1.26 6.80 11.88 F PESO INICIAL (kg) Se han asumido varianzas iguales No se han asumido varianzas iguales 3.896 Sig. .054 Prueba T para la igualdad de medias Intervalo de confianza para la diferencia Inferior Superior Diferencia de medias Error típ de la diferencia 7.163 48 .000 9.34 1.30 6.72 11.97 7.406 45.009 .000 9.34 1.26 6.80 11.88 t Sig. (bilateral) gl H0: p 0.05 p < 0.05 57 Prueba T para muestras independientes H0: 58 Prueba T para muestras independientes H1: H0: H1: p 0.05 Estadísticos del grupo PESO INICIAL (kg) SEXO hombre mujer N 23 27 Media 89.57 80.22 p < 0.05 Estadísticos del grupo Error típ. de la media .72 1.03 Desviación típ. 3.47 5.37 PESO INICIAL (kg) SEXO hombre mujer N 23 27 Media 89.57 80.22 Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas F PESO INICIAL (kg) Se han asumido varianzas iguales No se han asumido varianzas iguales 3.896 Sig. .054 Prueba de muestras independientes Prueba de Levene para la igualdad de varianzas Prueba T para la igualdad de medias t Sig. (bilateral) gl Error típ. de la media .72 1.03 Desviación típ. 3.47 5.37 Diferencia de medias Error típ de la diferencia Intervalo de confianza para la diferencia Inferior Superior 7.163 48 .000 9.34 1.30 6.72 11.97 7.406 45.009 .000 9.34 1.26 6.80 11.88 F PESO INICIAL (kg) Se han asumido varianzas iguales No se han asumido varianzas iguales H0: 3.896 Sig. .054 Prueba T para la igualdad de medias Intervalo de confianza para la diferencia Inferior Superior Diferencia de medias Error típ de la diferencia 7.163 48 .000 9.34 1.30 6.72 11.97 7.406 45.009 .000 9.34 1.26 6.80 11.88 t Sig. (bilateral) gl H0: 59 60 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Estadística / Comparar medias / Prueba T para muestras independientes Grupos independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Estadística / Comparar medias / Prueba T para muestras relacionadas Grupos apareados V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal NORMALIDAD? 61 62 Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney H1: U H0: U= N1*N2 N1*N2 63 Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney 23*27 H0: U= N1*N2 = = 310.5 2 H1: U 64 Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney 23*27 H0: U= N1*N2 = = 310.5 2 N1*N2 310.5 2 H1: U p 0.05 N1*N2 310.5 2 p < 0.05 Rangos SEXO PESO INICIAL (kg) hombre mujer Total N 23 27 50 Rango promedio 36.65 16.00 Rangos Suma de rangos 843.00 432.00 SEXO PESO INICIAL (kg) hombre mujer Total N 23 27 50 Rango promedio 36.65 16.00 Suma de rangos 843.00 432.00 Estadísticos de contrastea U de Mann-Whitney W de Wilcoxon Z Sig. asintót. (bilateral) Estadísticos de contrastea PESO INICIAL (kg) 54.000 432.000 -5.003 .000 U de Mann-Whitney W de Wilcoxon Z Sig. asintót. (bilateral) a. Variable de agrupación: SEXO 65 PESO INICIAL (kg) 54.000 432.000 -5.003 .000 a. Variable de agrupación: SEXO 66 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Estadística / Comparar medias / Prueba T para muestras relacionadas Grupos apareados V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal 67 68 69 70 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Grupos apareados Estadística / Comparar medias / Prueba T para muestras relacionadas V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal Prueba T para muestras relacionadas H0:d 71 H1:d 72 Prueba T para muestras relacionadas H0:d Prueba T para muestras relacionadas H0:d H1:d PESO INICIAL (kg) PESO FINAL (kg) Media 84.52 79.68 N 50 50 Desviación típ. 6.54 7.38 Error típ. de la media .93 1.04 Par 1 Correlaciones de muestras relacionadas N Par 1 PESO INICIAL (kg) y PESO FINAL (kg) PESO INICIAL (kg) PESO FINAL (kg) Media 84.52 79.68 N 50 50 Sig. .571 N Par 1 .000 PESO INICIAL (kg) y PESO FINAL (kg) Media 4.84 Desviación típ. Error típ. de la media 6.49 .92 Sig. .571 .000 Prueba de muestras relacionadas Diferencias relacionadas PESO INICIAL (kg) PESO FINAL (kg) Error típ. de la media .93 1.04 Correlación 50 Prueba de muestras relacionadas Par 1 Desviación típ. 6.54 7.38 Correlaciones de muestras relacionadas Correlación 50 p < 0.05 Estadísticos de muestras relacionadas Estadísticos de muestras relacionadas Par 1 H1:d p 0.05 Diferencias relacionadas Intervalo de confianza para la diferencia Inferior Superior 3.00 6.68 t 5.272 Sig. (bilateral) gl 49 Media Par 1 .000 PESO INICIAL (kg) PESO FINAL (kg) 4.84 Desviación típ. Error típ. de la media 6.49 Intervalo de confianza para la diferencia Inferior Superior .92 3.00 6.68 t 5.272 Sig. (bilateral) gl 49 .000 73 74 75 76 V. CUANTITATIVA .vs. V. CUALITATIVA (2 grupos) V. CUANTITATIVA NORMAL EN AMBOS GRUPOS Grupos independientes Estadística / Comparar medias / Prueba T para muestras independientes V. CUANTITATIVA NO NORMAL EN ALGUN GRUPO Estadística / Pruebas no paramétricas / 2 muestras independientes / U de Mann-Whitney COMPARACIÓN DE MEDIAS V. DIFERENCIA NORMAL Grupos apareados Estadística / Comparar medias / Prueba T para muestras relacionadas V. DIFERENCIA NO NORMAL Estadística / Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon NORMALIDAD? Estadísticos / Pruebas no paramétricas / K-S de 1 muestra / Normal Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon H0: T= n (n+1) 77 H1: T n (n+1) 78 Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon H1: T H0: T= n (n+1) = 49*50 = 612.5 4 Pruebas no paramétricas / 2 muestras relacionadas / Wilcoxon n (n+1) 612.5 H0: T= n (n+1) = 49*50 = 612.5 4 Rangos negativos Rangos positivos Empates Total 38a 11b 1c 50 Rango promedio 27.68 15.73 Suma de rangos 1052.00 173.00 N PESO FINAL (kg) - PESO INICIAL (kg) Rangos negativos Rangos positivos Empates Total a. PESO FINAL (kg) < PESO INICIAL (kg) a. PESO FINAL (kg) < PESO INICIAL (kg) b. PESO FINAL (kg) > PESO INICIAL (kg) b. PESO FINAL (kg) > PESO INICIAL (kg) c. PESO INICIAL (kg) = PESO FINAL (kg) c. PESO INICIAL (kg) = PESO FINAL (kg) contrasteb Z Sig. asintót. (bilateral) p < 0.05 Rangos N Estadísticos de n (n+1) 612.5 p 0.05 Rangos PESO FINAL (kg) - PESO INICIAL (kg) H1: T 38a 11b 1c 50 Rango promedio 27.68 15.73 Suma de rangos 1052.00 173.00 Estadísticos de contrasteb PESO FINAL (kg) - PESO INICIAL (kg) -4.379a .000 Z Sig. asintót. (bilateral) a. Basado en los rangos positivos. PESO FINAL (kg) - PESO INICIAL (kg) -4.379a .000 a. Basado en los rangos positivos. b. Prueba de los rangos con signo de Wilcoxon b. Prueba de los rangos con signo de Wilcoxon 79 Comparación de dos medianas 80 Trabajo previo Determinar la mediana combinada de las observaciones de las Muestras n1 + n2 • Sirve para comprobar si dos muestras aleatorias independientes y cuyos datos se miden por lo menos en una escala ordinal proceden de poblaciones con la misma mediana. Contar cuántas observaciones en cada grupo caen por encima y por debajo de la mediana combinada (Tabla de contingencia 2 x 2) • Es una forma alternativa de testar la hipótesis nula 1=2 Realizar un contraste de hipótesis tipo Ji al cuadrado o prueba Exacta de Fisher (según frecuencia esperada) • Si ambas muestras proceden de poblaciones con la misma mediana, cabe esperar bajo H0 que la mitad de valores de una muestra y la mitad de la otra han de ser superiores a la mediana de la población. • ATENCIÓN: sólo un 64% de eficiencia respecto a una T de Student. 81 La tabla en cuestión... Muestra 1 Muestra 2 Total Valores superiores a la mediana A B A+B Valores inferiores a la mediana C D C+D A+C B+D N1+N2 82 ...y las consideraciones del tamaño • Si n1+n2 > 40 2 con corrección de Yates • Si 20 < n1+n2 >40 2 con Yates, si no hay freq. Esperadas <5, en tal caso Fisher • Si n1+n2 < 20 83 • Prueba exacta de Fisher 84 Un ejemplo Trat Control 80 96 77 79 76 74 82 82 83 69 84 72 75 94 69 77 97 77 71 97 85 75 74 69 98 95 88 78 96 73 72 83 75 70 94 . Los cálculos Trat Mediana Tratamiento Mediana Control 81 77 Mediana combinada 78 <Me >Me Total Obtenidas Control 8 10 18 Trat <Me >Me Total Total 10 7 17 Esperadas Control 9.257 8.743 18 Estadístico 2= 0.7237 18 17 35 Total 8.743 8.257 17 18 17 35 Valor de p= 0.3949 85 86 Independientes 87 Test H de Kruskal-Wallis Aplicación El punto de partida del test H de Kruskal Wallis es el mismo que para la U Se ordenan las n observaciones de las k muestras en una única serie creciente y se les asigna números de rango (desde 1 hasta n) Sea Ri la suma de rangos de la muestra i-ésima Si se cumple la hipótesis nula, y para valores de n suficientemente grandes (en la práctica ni 5 y k 4), el estadístico Que sigue una distribución 2 con k-1 grados de libertad 89 90 Interpretación de los primeros resultados Solución elegante • Queda claro que las muestras son diferentes pero cuáles son distintas entre sí. • Realización de un ANOVA con rangos – El SAS lo hace previo cambio de los datos a rangos (Proc Rank) – Permite la interpretación de los resultados vía la típica tabla de Análisis de la Varianza •Se ordenan las sumas de rangos de las k muestras •de mayor a menor como en las comparaciones paramétricas de Tukey) •Se empieza comparando la suma de rangos mayor con la menor •Se divide la diferencia de rangos por el error estándar apropiado par obtener un estadístico de distribución conocida. En esta caso Q. 91 92 Comparación de más de 2 muestras relacionadas. Test de Friedman Ejemplo: • Comparación de la eficacia de k=4 muestras de penicilina por el método de la difusión en placas. • La experiencia se realiza con n=3 placas de agar de 9 cm de diámetro cada una en las que se cultiva B. Subtilis (bacilo de heno). • En cada una de las placas se deposita una cantidad fija de penicilina y se extiene provocando la inhibición de crecimiento de la B.subtilis. El diámetro de la zona de inhibición es proporcional a la concentración de penicilina. Se pregunta si los diámetros de las zonas de inhibición presentan alguna diferencia. Dependientes 94 Comparación de más de 2 muestras relacionadas. Test de Friedman Comparación de más de 2 muestras relacionadas. Test de Friedman • H0: el diámetro de las zonas de inhibición son las mismas en todas las disoluciones de penicilina • Análisis de la variancia de un diseño experimental de bloques con una observación por celda. Placa nº 1 2 3 Placa nº 1 2 3 Suma de rangos 1 27 27 25 Disoluciones de penicilina 2 3 23 26 23 25 21 26 4 21 21 20 1 4 4 3 Disoluciones de penicilina 2 3 2 3 2 3 2 4 4 1 1 1 11 6 10 b= nº de bloques a=nº de tratamientos 3 95 96 Comparación de más de 2 muestras relacionadas. Test de Friedman Resultados iniciales con SPSS Estadísticos descriptivos • El test de Friedman se puede considerar que se aproxima a una distribución ji cuadrado con a-1 grados de libertas N Disolució Disolució Disolució Disolució 3 3 3 3 Media 6.3333 2.3333 5.6667 0.6667 Percentiles Desviación típica MínimoMáximo 25 0 (Mediana 75 1.1547 25.00 27.00 5.0000 27.0000 7.0000 1.1547 21.00 23.00 1.0000 23.0000 3.0000 .5774 25.00 26.00 5.0000 26.0000 6.0000 .5774 20.00 21.00 0.0000 21.0000 1.0000 Rangos Disolución 1 Disolución 2 Disolución 3 Disolución 4 • Se rechaza la hipótesis nula de igualdad de las cuatro soluciones 97 Muestras relacionadas:COCHRAN Prueba 1 0 1 1 1 1 1 1 1 Prueba 2 1 0 0 0 0 1 0 0 Prueba 3 0 1 1 0 0 1 0 0 Prueba 4 0 0 0 0 0 0 0 0 Frecuencias Valor 0 P1 P2 P3 P4 1 1 6 5 8 7 2 3 0 Estadísticos de contraste Variables binarias N Q de Cochran gl Sig. asintót. Sig. exacta Probabilidad en el punto 8 12.000a 3 .007 .006 .004 a. 0 se trata como un éxito. 99 Rango promedio 3.67 2.00 3.33 1.00 Estadísticos de contrastea N Chi-cuadrado gl Sig. asintót. Sig. exacta Probabilidad en el punto a. Prueba de Friedman 3 8.200 3 .042 .017 .016 98