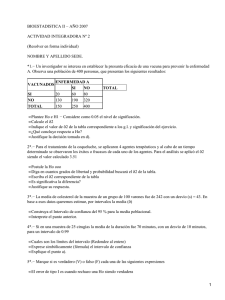

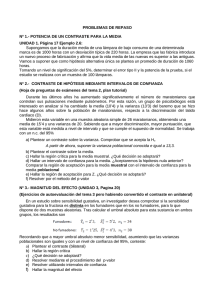

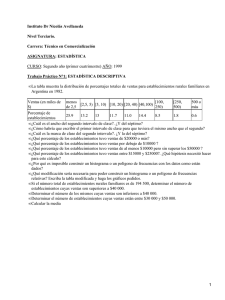

todos juntos - bioestadistica

Anuncio