Clase 5 - Universidad del CEMA

Anuncio

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

V - ESTIMACION PUNTUAL E INTERVALOS DE CONFIANZA

5.1 Introducción

En este capítulo nos ocuparemos de la estimación de caracteristicas de la población a partir

de datos. Las caracteristicas poblacionales buscadas son cuantitativas, parámetros

poblacionales.

Dado un conjunto relevante de datos (una muestra) de una población, el problema es

trabajar los mismos para arribar a un valor que, en algun sentido, se acerque los mas posible

al valor poblacional desconocido que desamos estimar. El estadístico que calculamos es

entonces llamado ESTIMADOR PUNTUAL.

En realidad no esperamos, cuando utilizamos datos sujetos a aleatoriedad, encontrar un

estimador puntual exactamente igual al parámetro poblacional, pero esperaríamos que este

lo razonablemente cerca de forma tal que nuestro error de estimación, la diferencia entre el

estimador y el valor del parámetros, sea pequeña.

Empezaremos por definir que queremos decir por “cerca del parámetro” y a partir de alli

establecer criterios bien definidos para la selección de estimadores puntuales.

Este capítulo es acerca de la selección de estimadores puntuales en tanto que el capitulo

siguiente concierne con la aplicación y evaluación de los mismos a partir de muestra – el

objeto de los intervalos de confianza.

1

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

Estimaciones simples de parámetros poblacionales serán:

Si la media poblacional es desconocida, utilizaremos la media muestral como estimador

puntual.

Si la proporcion poblacional es desconocida, entonces utilizaremos las proporciones

muestrales como estimadores puntuales.

5.2

Criterio de Estimacion

Error al Cuadrado

La medida básica que se utiliza para evaluar el desempeño de un estimado es la FUNCION

DE PERDIDA, con un formato generalmente aceptado llamado PERDIDA DE LOS

ERRORES AL CUADRADO. Este es un concepto muy simple y opera de la siguiente

manera; si estamos interesados en un parámetro desconocido θ, y utilizamos un estimado t

para estimarlo, entonces la diferencia de aproximación estara dada por (t - θ) e incurriremos

en una penalidad de (t - θ)2 como resultado de esta estimación. Si t es exactamente igual a

θ no hay pérdida y es claramente lo mejor que podemos obtener; pero si t es diferente,

incurrimos en una perdida que crece aceleradamente a medida que al diferencia se agranda.

El objetivo obvio es acercarse lo mas posible a θ de manera tal de minimizar la pérdida.

Este es un buen punto de partida para establecer criterios de estimación, pero como

veremos, existen muchas dificultades asociadas al mismo. Para apreciar esto consideremos

el problema de elegir entre dos estimadores t1 y t2 de θ. Los dos estimadores son funciones

de los datos de la muestra y daran generalmente distintos valores no obstante estar basados

en el mismo set de datos. Pero cual de los dos estara mas cerca de θ? Aplicando el concepto

de perdida por errores al cuadrado, diremos que preferimos t1 si

2

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

(t1 - θ)2 < (t2 - θ)2

pero ninguna de estas funciones son cantidades que son susceptibles de ser comparadas;

son funciones del parámetro poblacional desconocido. Una visión simple de nuestro

objetivo es que necesitamos asociar, de alguna manera, un número con cada ti de manera tal

que uno seria considerado un mejor estimado que el otros si el número asociado fuese

menor.

Podemos avanzar un paso mas a los efectos de obtener un criterio manejable, haciendo uso

de nuestro conocimiento de la distribución muestral de los datos. A traves de promediar la

pérdida de los errores al cuadrado (calculando su valor esperado) sobre esta distribución

muestral arribamos a un criterio mas manejable de comparación de estimadores,

denominado el CRITERIO DE ERRORES AL CUADRADO, definido por:

Error medio al cuadrado (MSE) de t = E{( t - θ)2}

Ahora, preferiremos t1 a t2 si

E{( t1 - θ)2} < E{( t2 - θ)2}, o equivalentemente

MSE (t1) < MSE (t2)

El Error medio al cuadrado es simplemente el promedio de pérdida; en un contexto mas

general es conocida como la Función de riesgo.

No estamos fuera del lio todavia! El MSE es todavia una funcion del parámetro θ, y no

provee de una solución final para nuestro problema de estimación. Si por ejemplo, en el

3

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

contexto de la distribución binomial, utilizamos la proporcion muestral para calcular la

proporcion poblaciónal p, entonces MSE es npq; no obstante n es conocido, el MSE no es

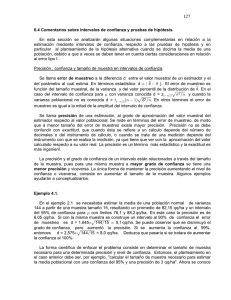

un número sino una funcion del parámetro desconocido p. El siguiente gráfico muestra el

problema de utilizar MSE como criterio de estimacion. Es una gráfica de t1 y t2 como

funciones de θ.

MSE

t1

t2

θ

Si el verdadero valor θ es bajo, claramente preferiremos t1, mientras que si es alto, nos

inclinaremos por t2, el punto es que no conocemos θ. No obstante podemos tener una vaga

idea de su ubicación, no es un método cuantitativo formal de determinación. Llegamos a un

punto en el que no obstante MSE es un método claro y aceptado, no nos proporciona la

solucion completa a nuestro problema.

Por otro camino, podemos descomponer MSE en dos partes de la siguiente manera: esto

surge de notar que el valor esperado del cuadrado de una variable aleatoria es igual a la

suma de su varianza mas el cuadrado de su valor esperado. La variable aleatoria en este

caso es (t- θ).

4

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

MSE = Var (t) + {E(t- θ )}2

O equivalentemente, MSE = Varianza + (Sesgo)2

El sesgo de un estimador es la diferencia entre la media (valor esperado) de la distribución

muestral y el parámetro que se está estimando. Claramente, será provechoso tener un sesgo

igual a 0.

5.3

Criterio de selección Estimadores insesgados

Si t es un estimador de θ tal que E(t) = θ, entonces t es un ESTIMADOR INSESGADO

de θ.

Un enfoque generalmente aceptado al problema de estimación es el de restringir la atención

a estimadores insesgados, y sujeto a esta propiedad, tratar de encontrar los estimadores con

la menor varianza. Un estimador de estas características es considerado insesgado, y

eficiente si su varianza es pequeña, por tener mayores probabilidades de encontrarse cerca

del parámetro poblacional.

No es difícil encontrar estimadores que satisfagan estos criterios, y en muchas

circunstancias podemos construir y usar estimadores insesgados de mínima varianza.

Ejemplo de estimadores insesgados son

m para µ

para datos de N {µ, σ2}

5

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

R/n para p

en pruebas de Bernoulli con parámetro de éxito p

s2 para σ2

para datos de N {µ, σ2}

Para el calculo de s2 se divide por (n-1) y no n, de manera tal que el estimador sea

insesgado.

Se debe mencionar que el hecho de obtener un estimador insesgado no implica que una

transformación del mismo también lo será. Si t es insesgado para θ, t2 lo sera para θ2, esto

puede ser apreciado inmediatamente en:

E(t2) = Var (t) + θ 2 > θ 2

Estimadores insesgado para funciones paramétricas pueden ser obtenidos a través de ajustes

a un estimador obvio.

Ejemplo :

Supongamos que tenemos una muestra aleatoria de n elementos de una población con

media µ y desviación estandar σ, y queremos encontrar un estimador insesgado para µ2.

Entonces intentaremos m2, y veremos que

E(m2) = µ 2 + σ2/n,

6

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

Pero sabemos que E(s2) = σ2, de manera tal que combinando estas dos formulas podemos

obtener

m2 – s2/n como estimador insesgado de µ2

Esto muestra un método rápido pero efectivo de obtener estimadores insesgados al elegir un

estimador, calcular su sesgo y luego ajustar el estimador original de manera tal de remover

el sesgo.

La propiedad de ser insesgado es muy deseable en estimadores utilizados en encuestas, en

donde la transparencia que implica el ser insesgado es considerada de extrema importancia.

5.4 Eficiencia

Supongamos que tenemos dos estimadores insesgados del parámetro θ, t1 y t2, de forma tal

que

E(t1) = E(t2) = θ,

entonces preferiremos 1 a 2 si

Var (t1) < Var(t2)

Cuando esto es así, decimos que t1 es mas eficiente que t2, y la eficiencia relativa de t2 a t1

es:

100 * Var(t1) / Var(t2) %

7

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

claramente, el mas eficiente es el mejor.

5.5 Consistencia

Esta es una propiedad simple que básicamente nos dice que a medida que la muestra se

agranda, el estimador converge al verdadero valor del parámetro desconocido. Definiciones

mas formales y rigurosas pueden ser encontradas en libros de estadistica, pero puede ser

mostrado que un estimador es consistente si las siguientes dos condiciones se cumplen:

(i)

El sesgo (si existe) tiende a cero a medida que la muestra se agranda.

(ii)

La varianza (y error estándar) tiende a cero a medida que la muestra se agranda.

La mayoria de los estimadores comunes son consistentes, no obstante en tópicos como

series de tiempo algunos estimadores no lo son.

5.6 Minimos Cuadrados y el teorema de Gauss Markov

El método de minimos cuadrados es ampliamente utilizado para construir buenos

estimadores en diversas disciplinas .

Supongamos que tenemos un set de datos x1, x2, ..... xn de una población con media µ.

8

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

entonces si x1, x2, ..... xn son datos observados,

∑ {( x

i

− µ)2}

es una funcion solamente de µ.

Supongamos que ahora elegimos como estimador de µ el valor que hace mínima esa

función, se puede ver en forma clara que se obtiene la media muestral como estimador. Este

es un ejemplo simple del método cuantitativo de mínimos cuadrados.

Puede ser mostrado que este método siempre proporciona los estimadores insesgados mas

eficientes, conociéndose este resultado como el teorema de Gauss Markov.

•

INTERVALOS DE CONFIANZA

5.7 Introducción

Es usualmente fácil producir un estimador puntual del parámetro de una distribución

poblaciónal. Por ejemplo, la media muestral es claramente un razonable estimador de la

media poblacional, la varianza muestral estima la varianza poblacional, y así

sucesivamente.

Sin embargo estos valores citados “fríamente” no proporcionan una idea clara de la

exactitud del valor citado. Una media muestral basada en 100 observaciones será

9

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

claramente mas confiable que una media muestral basada en solo 5. Hasta cierto punto

podemos otorgar una idea de exactitud a nuestro estimador al citar el error estándar de

manera que un error alto proporciona idea de mayor volatilidad; un mejor método de

obtener un grado de exactitud es el método de los intervalos de confianza – ie un intervalo

en el cual uno espera se encuentre el verdadero valor del parámetro. Este método de

expresar grado de exactitud es fácilmente entendible y no requiere de sofisticaciones

estadísticas en su uso. Por ejemplo, supongamos que estimamos un parámetro a través del

estimador puntual 3.7, y damos un intervalo de confianza de {3.5, 3.9}. Entonces estamos

diciendo que, con evidencia en los datos, nuestra mejor elección del valor del parámetro es

3.7 , y no obstante esperamos que se encuentra cercano al verdadero valor del parámetro,

nos sorprendería si fuese igual. Pero si tenemos confianza que, cualquiera sea el valor del

parámetro objetivo, tendra grandes probabilidades de estar en ese intervalo.

Claramente un amplio intervalo de confianza muestra que nuestro estimado no es muy

exacto debido a que no podemos estar muy seguros que se encuentre cerca del valor del

parámetro; por otros lado, un intervalo de confianza estrecho nos dirá que nuestro

estimador es bueno. El grado de confianza que tenemos en nuestro intervalo puede ser

expresado numéricamente; la situación ideal es un intervalo corto con alto grado de

confianza. Con estos puntos en mente, estos intervalos pueden ser computados a partir de

los datos en el contexto de algunas situaciones básicas. El tópico de intervalos de confianza

esta muy asociado a Tests de Significancia, materia del próximo capítulo.

5.8 Una formula general para estadísticos distribuidos normalmente

Caso 1

Se conoce el Error estándar (Varianza)

10

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

Consideremos una situación en la que tenemos un estimador insesgado u para θ y

supongamos que u sigue una distribución

u ~ N (θ, SE2)

donde SE (el error estandar de u es conocido).

Entonces estaremos mirando por una vía de cálculo de un par de valores de manera tal que

exista una alta chance que θ esté entre los mismos.

Ahora, sabemos que Z = (u - θ)/SE se distribuye normal estándar, entonces se sigue de las

tablas estadisticas que,

P { - 1.96 < (u - θ)/SE < + 1.96} = .95

Redistribuyendo terminos en la igualdad:

P { u - 1.96 *SE< θ < u + 1.96*SE} = .95

entonces un intervalo de confianza del 95% para θ esta dado por

u ± 1.96*SE

[1]

Este es un resultado muy simple pero a la vez muy importante; como veremos puede ser

aplicado para obtener intervalos de confianza en diversas situaciones como la estimacion de

la media, proporcion, diferencias de medias, coeficientes de regresion, coeficientes de

series de tiempo, etc.

11

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

Lo hemos utilizado para derivar un intervalo de confianza de 95% debido a que es un

intervalo generalmente aceptado. Puede ser facilmente visto, de la derivacion realizada,

como otros coeficientes pueden ser utilizados; solamente requiere de escoger el valor

adecuado de la tabla estadistica de la distribución normal estandar. Por ejemplo:

Para una confianza de 95% utilizamos 1.96,

para 90%, 1.645,

y 99%, 2.58.

Esta limitado, a pesar de todo, por el hecho que conocemos la varianza poblacional; en la

mayoría de los casos prácticos será necesario estimar el error estandar desde los propios

datos, y ello motivará una pequeña modificación en la fórmula.

Si el tamaño de la muestra es grande entonces la anterior formula puede ser utilizada con

SE reemplazada por un estimador apropiado; esto es debido al hecho que podemos ignorar

la variabilidad del estimador cuando el tamaño de la muestra es grande.

Caso 2

Error Estandar desconocido

Consideremos casos en los que el error estandar es estimado usando cálculos basados en la

suma corregida de cuadrados. Sea ESE el estimador del error estándar, en donde ESE esta

basado en ν grados de libertad. En lugar de considerar el hecho que (u - θ)/SE es normal

estándar, estamos forzados a reemplazar el parámetro desconocido SE por su estimador

ESE, y en consecuencia analizamos la distribución de (u - θ)/ESE.

Desafortunadamente, este estadístico no sigue una distribución normal estándar debido a la

variabilidad muestral de ESE, y esta volatilidad extra causará que (u - θ)/ESE tenga una

distribución mas dispersa. Esta distribución ha sido derivada, tabulada y es conocida como

la distribución t de Student; posee una función de densidad mas bien complicada (en la que

no profundizaremos) y tiene, como la distribución normal, una forma simétrica,

12

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

acampanada y con centro en cero; pero posee una forma funcional diferente de la

disrtibución normal estandar, y es mas dispersa. Converge a la distribución normal a

medida que los grados de libertad se incrementan (la muestra incrementa su tamaño)

Distribución t de Student

Esta distribución se obtiene de la estandarizacion de una variable normalmente distribuida

utilizando un estimador independiente de su desviación estándar. Cuando la distribución

subyacente es aproximadamente normal, puede ser demostrado que el criterio de

independencia se obtiene para los estimadores m y s.

La distribución t se modifica de acuerdo a los grados de libertad (ν) considerados. Siendo

que cada valor de ν da lugar a una nueva distribución t, las tablas estadísticas tienen

tabuladas no más que los porcentajes de ciertos valores clave.

Entonces, en tablas estaditicas o softwares especializados, podemos encontrar valores de tν

de manera que:

P { -tν < (u - θ)/ESE < + tν } = .95,

O reacomodando las variables dentro de las llaves,

P { u -tν *ESE < θ < u + tν * ESE} = .95,

Entonces un intervalo de confianza del 95% para θ esta dado por:

u ± tν * ESE

[2]

13

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

pudiendo utilizarse este resultado general en muchas situacion de calculo de intervalo de

confianza. Procedemos ahora a demostrar estas técnicas para situaciones básicas e

importantes.

5.9 Intervalo de Confianza para la media (varianza conocida)

Dado un set de datos independientes x1, x2, ..... xn, estimamos la media poblaciónal µ a

través de la media muestral m, siendo la desviación estandar de m igual a σ/√n.

De aquí que sustituyendo en [1], un intervalo de confianza de 95% para µ puede ser

computado como

m ± 1.96*σ

σ/√

√ n.

Es inusual conocer σ, pero si n es grande, entonces esta fórmula puede ser utilizada con σ

reemplazada por s, la desviación estándar muestral; esto es asi porque s es un muy buen

estimador de σ debido al gran tamaño de la muestra y no existe necesidad de preocuparse

por su volatilidad. Generalmente, la version “a ojo”

m ± 1.96*σ/√n

es utilizada.

14

Universidad del CEMA

Métodos Cuantitativos

5.10

Prof. José P Dapena

Intervalo de Confianza para la media (varianza desconocida)

En este caso aplicamos la formual general [2], con las sustituciones:

m por u, s/√n por ESE,

un intervalo de confianza para µ sera

m – tn-1*s/√

√ n < µ < m + tn-1*s/√

√n

donde el valor t es aquel que corta, digamos 2.5%, de la cola de la distribución t (para una

confianza de 95%).

5.11

Intervalos de Confianza para las Proporciones

Sabemos que la varianza de la proporción muestral es igual a npq, donde p es la proporción,

n el tamaño de la muestra y q = 1 – p. Cuando construímos un intervalo de confianza para

la proporción, no sabemos a priori la proporción poblacional, de manera tal que la varianza

debe ser estimada; naturalmente reemplazamos p en esta varianza por la proporción

muestral de manera de obtener nuestro desviación estándar estimada,

SE = √ { (r/n) * (1- r/n)/n}

y el intervalo de confianza para p es ahora

r/n ± 1.96*SE

15

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

NOTA: no utilizamos la distribución t por dos razones, el error estandar no ha sido

estimado en base a la suma corregida de cuadrados, y ademas el tamaño muestral debe ser

grande para que la aproximación a la distribución normal sea válida.

5.12

Escogiendo el tamaño muestral

La pregunta “que tan grande debe ser la muestra?” es común al muestrear datos. La

respuesta yace en la calidad de “inferencia” que el encuestador u observador requiere de los

datos. En el contexto de estimación esto puede ser considerado como el grado de precisión

de la estimación.

Si el observador requiere que debe haber una chance de 95% que el error de estimación no

exceda d unidades, es equivalente a tener un intervalo de confianza de largo 2d.

El intervalo de confianza de 95% esta basado en que el error de estimacion no exceda 2 (o

mas exactamente 1.96) errores estándar.

De alli tenemos 2*SE = d, y resolviendo esta simple ecuación nos proporciona el tamaño

muestral buscado. Por ejemplo, para la estimación de la media poblaciónal el error estandar

es σ/√n. Entonces tenemos

d = 2 * σ/√

√ n, o n = 4 * σ2/d2,

donde d es la tolerancia requerida y, si σ es desconocida, debe ser estimada en funcion a

una muestra piloto.

16

Universidad del CEMA

Métodos Cuantitativos

5.13

Prof. José P Dapena

La comparación de Proporciones

El enfoque correcto para la comparación de proporciones de dos poblaciones es,

naturalmente, a través de la comparación de la diferencia en sus proporciones muestrales.

Para muestra grandes, este estadístico d = (r1/n1 – r2/n2) tiene la siguiente distribución

normal:

d ~ N (p1 – p2, p1q1/n1 + p2q2/n2) ,

de donde el error estandar será igual a √ (p1q1/n1 + p2q2/n2)

Esta distribución muestral es la base del siguiente intervalo de confianza y test;

Intervalo de Confianza para la diferencia de proporciones

Estimamos p1 por r1/n1, etc., de manera tal que un intervalo de confianza de 95% puede ser

computado de la siguiente formula:

u1 –u2 ± 1.96 * √ {u1(1 - u1)/n1 + u2(1 – u2)/n2},

donde

u1 = r1/n1 y u2 = r2/n2

17

Universidad del CEMA

Métodos Cuantitativos

5.14

Prof. José P Dapena

Comparacion de dos medias poblacionales

En esta sección estamos interesados principalmente en la diferencia entre dos medias

poblacionales. Existen tres casos a ser analizados dependiendo en los tamaños de las

muestras y en que medida los datos se matchean entre si o no.

Caso 1

Datos no matcheados, - muestras grandes o varianzas conocidas

Supongamos que tenemos muestras aleatorias de dos poblaciones con medias desconocidas

y varianza conocidas.

Para la población 1

media= µ1

Tamaño muestral = n1

Para la población 2

media= µ2

Tamaño muestral = n2

SD= σ1

media muestral= m1

SD= σ2

media muestral= m2

y deseamos estimar µ1 - µ2

Estimamos esto a través de un estimador insesgado que surge naturalmente

m1 - m2

entonces

18

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

m1 - m2 ~ N (µ

µ 1 - µ 2, σ12/n1+ σ22/n2)

y el error estándar del estimador puntual es

SE = √ (σ

σ12/n1+ σ22/n2)

Entonces m1 - m2 ± 1.96 * SE provee de un intervalo de confianza del 95%.

Caso 2

Datos no matcheados – tamaños muestrales pequeños

Este es un caso difícil que debe ser analizado con cuidado. El rpblema es similar al visto en

el caso 1 de manera tal que tenemos la siguiente distribución muestral

m1 - m2 ~ N (µ

µ 1 - µ 2, σ12/n1+ σ22/n2)

como antes. Sin embargo, si procedemos a reemplazar las varianzas poblacionales por su

correspondiente estimador muestral, entonces encontraremos dificultades porque el

estadístico standarizado que obtenemos no sigue una distribución t y en consecuencia la

teoria de intervalo de confianza no es de aplicación. Este dificil problema es conocido

como el problema de “Fisher – Behrens”, del que no nos ocuparemos aquí.

En su lugar, si estamos en condiciones de hacer el supuesto que las poblaciones poseen la

misma variabilidad, entonces es materia simple el computar el intervalo de confianza.

Suponiendo σ1 = σ2 = σ, entonces el error estándar se transforma en σ√(1/n1 + 1/n2),

19

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

que procedemos a estimar por s√(1/n1 + 1/n2) en n1 + n2 - 2 grados de libertad., donde s2 es

computada a través de hacer un pool entre la suma corregida de cuadrados de ambas

muestras, así

s2 = (SCC1 + SCC1) / (n1 + n2 - 2),

o equivalentemente

s2 = {(n1 – 1)s12 + (n2 – 1)s22}/ (n1 + n2 - 2) con n1 + n2 - 2 grados de

libertad.

Esta última formula muestra que s2 es una función ponderada de las varianzas muestrales –

ponderada por los grado de libertad-.

Caso 3

Datos matcheados – muestras pequeñas

Este es el caso mas fácil de analizar, debido a que se reduce únicamente al análisis de

diferencias. Si, en cada par de datos, tomamos la diferencia de los mismos, tendremos

d1 = x1 – y1, d2 = x2 – y2, ........dn = xn – yn,

entonces md = mx – my, entonces utilizamos los d’s para computar un intervalo de

confianza para µd obteniendo el requerido intervalo de confianza para µx - µy. La técnica

utilizada es la misma que la de las secciones 7.3 y 7.4.

20

Universidad del CEMA

Métodos Cuantitativos

5.15

Prof. José P Dapena

Intervalos de confianza para las varianzas

En esta sección describimos técnicas para determinar intervalo de confianza para varianzas

en lugar de medias; en este caso estamos interesados en evaluar la variabilidad de nuestra

población y en comparar la variabilidad de dos poblaciones mas que la media de dos

poblaciones. No obstante los estadísticos y las distribuciónes muestrales son diferentes, los

conceptos esenciales subyacentes en los que estos métodos se basan son exactamente

iguales. Una diferencia básica entre inferencias de varianza e inferencias de medias surge

en las distribuciónes muestrales. Para las medias, estan son simétricas (normal, o t),

mientras que para las varianzas las distribuciones (chi – cuadrada, o F) no lo son.

Varianzas muestrales son estimadores bastante menos confiables que medias muestrales, de

manera que buenos estimadores son posibles únicamente si el tamaño muestral es

razonablemente grande o los datos no poseen mucha volatilidad. También, se parte del

supuesto que los datos se obtienen de una distribución normal y, a diferencia de la media

muestral, la distribución de la varianza muestral no es robusta a desviaciones de este

supuesto. Se debe tener cuidado en asegurarse que los datos se distribuyen

aproximadamente en forma normal.

Finalmente, debe ser notado que, no obstante la discusión de este capítulo apunta a varianza

poblacionales, su aplicación se extiende a desviaciones estandar poblacionales, con la obvia

precaución de tomar la raiz cuadrada positiva.

Un intervalo de confianza para una varianza

Tests e intervalos de confianza para varianzas poblaciónales estan basados en la

distribución muestral de la varianza muestral. Esando esta distribución muestral estamos en

condiciones de hacer una aformacion como:-

21

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

P(L < (n – 1) s2 / σ2 < U) = .95,

donde L corta a nivel inferior la distribución chi –cuadrada (χ2) a .025 (2.5%), y U corta a

nivel superior la distribución chi –cuadrada a .025 (2.5%).

Algunas manipulaciones algebraicas de esta relación proporcionan la formula estandar para

el intervalo de confianza de la varianza:

Esta es

(n- 1)s2/ U a (n- 1) s2/ L

Comparación de varianza

El enfoque correcto para al comparación de volatilidades de dos poblaciones normales es a

traves del ratio de sus varianzas poblacionales. Este tipo de procedimiento de inferencia es

particularmente importante, como procedimiento de test, en el contexto de regresion y

analisis de varianza (ANOVA). El ratio de varianzas muestrales es el estadístico natural a

considerar en este caso, y puede ser demostrado que la distribución muestral basica en las

que se respaldan estas inferencias se encuentra bien tabulada y es conocida como la

distribución F. En términos generales, posee la misma forma que la distribución χ2 y es, de

hecho, la distribución muestral de la función:

F = { s12 / s22 } / {σ

σ 12 / σ 22}

[3]

Esta basada en dos tipos de grados de libertad, los grados de libertda del numerador y del

denominador. Los superiores estan asociados con s1, mientras que los inferiores estan

asociados a s2. Tanto las tablas como funciones especiales de softwares proporcionan

probabilidades a partir de los parámetros de consideración.

22

Universidad del CEMA

Métodos Cuantitativos

Prof. José P Dapena

Intervalo de Confianza para el ratio de varianzas.

Sea L el valor que corta a nivel inferior la distribución F con una probabilidad de 2.5%, y

sea U el valor que corta a nivel superior la distribución F con una probabilidad de 2.5%.

Entonces p(L < F < U) = .95 y sustituyendo en la formual [3] y después de un pequeño

manipuleo de la desigualdad, arribamos a la fórmula para un intervalo de confianza del

95% para el ratio de varianzas, σ12 / σ22 como

{ s12 / s22 } /U a {s12 / s22 } /L

23

![( ) ( )2 ( )[ ] ( )ξ ( ) PQ](http://s2.studylib.es/store/data/006099496_1-61f82d8b006ba0985f60bbb263d08047-300x300.png)