Tema 2 Introducción a las técnicas de estimación robusta

Anuncio

Tema 2

Introducción a las técnicas de

estimación robusta

2.1-CONCEPTOS BÁSICOS

- A menudo, en los procesos de ajuste, se usan distribuciones de probabilidad

sencillas para los errores, como puede ser la distribución normal. Los estadísticos

clásicos se obtienen bajo la suposición de que estos modelos son estrictamente

verdaderos. Sin embargo, estos modelos no lo son casi nunca.

-Las

desviaciones de estos modelos pueden ser debidas a la existencia de

equivocaciones en el proceso de observación. La existencia de estos errores y su

desviación de la distribución clásica, hace que los procedimientos clásicos de ajuste,

como el de los mínimos cuadrados, sean poco eficientes en determinados casos.

-El

dogma de que los errores de medida deberían distribuirse según una distribución

normal lleva a ciertas contradicciones pues el método de los mínimos cuadrados

presenta algunos problemas dado que casi todas las variaciones estadísticas son

debidas a los errores de medida.

2.2. -ELIMINACIÓN DE LOS ERRORES DE TIPO I

-Una forma de abordar los errores graves es rechazar todos los errores que no se

ajusten a la suposición de normalidad. Pero este asunto es complicado por el

hecho de que sólo conocemos estimaciones de los errores después del ajuste por

mínimos cuadrados, en el cual los errores son enmascarados y distribuidos por

todas las observaciones, y por tanto, difíciles de reconocer. También, los residuos de

mayor tamaño no indican necesariamente la correcta posición del error.

Para localizar un error de este tipo, la magnitud estimada, êi, de cada error ei, puede

ser testada para comprobar si se desvía de forma significante de cero. El test

estadístico más utilizado es el residuo normalizado:

t=

σ

el cual se distribuye según una distribución t de Student con un grado de libertad.

El denominador representa la desviación estándar correspondiente a la estimación del

error y puede ser calculada en el proceso del ajuste. Sólo los errores más

significantes se rechazan como posibles errores graves, y este proceso(el ajuste y el

test) se repiten hasta que ya no se localicen.

-El

denominador representa la desviación estándar correspondiente a la estimación

del error y puede ser calculada en el proceso del ajuste. Sólo los errores más

significantes se rechazan como posibles errores graves, y este proceso(el ajuste y el

test) se repiten hasta que ya no se localicen.

Veamos un ejemplo sencillo para ilustrar el método:

Consideremos el valor medio a estimar de la muestra

Z= (10,11,11,12,100) con desviación estándar 1.

Una vez calculados los residuos y los residuos normalizados resulta para la primera

iteración:

media=29 ;

t5% ,1= 6. 7

max(

σ

) > t α=5%,1

y para la segunda iteración(ya sin el valor 100):

media=11 ; t 5% ,1 = 6. 7

max(

σ

) < t α=5%,1

indica error ,

-Este ejemplo muestra la importancia de rechazar sólo el residuo más

significante, pues todos los residuos son de forma significante mayores

que el valor rechazado en la primera iteración.

Posibles problemas que plantea el método son:

-El test es uniparamétrico, es decir, sólo detecta un error por cada

iteración, y por tanto las conclusiones equivocadas sobre la exclusión de

observaciones incrementa en probabilidad con el número de errores en los

datos.

-Pueden quedar errores no detectados con una cierta probabilidad(alta).

-No se conocen expresiones para la precisión del valor estimado

resultante.

2. 3. - ESTIMACIÓN ROBUSTA ( RECHAZANDO LA NORMALIDAD)

-El objetivo sería, por tanto, según lo expuesto, disponer de métodos de

estimación,

que

siempre

proporcionaran

los

valores

óptimos,

independientemente de la distribución de los errores. En particular, los

estimadores no deberían ser influidos por los errores de gran tamaño y deberían

ser construidos como valores centrales del conjunto total de los datos.

-Aspectos generales de la teoría en la que se basa la estimación robusta:

La característica común de todos estos métodos es que no se minimiza el

sumatorio de los cuadrados de los residuos, sino otra función elegida de forma

adecuada:

Σ φ(v) --> mínima

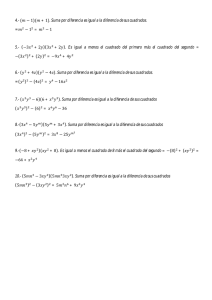

-Un ejemplo sencillo puede ser la función valor absoluto

φ(v)= abs(v), llamado método de la suma mínima, que estima la

media por medio de la mediana.

La solución numérica de estos principios de ajuste se puede hacer

de forma iterativa, por sucesiva aplicación del método de los mínimos

cuadrados ponderados.

-La iteración comienza con unos valores dados a priori para los pesos de las

observaciones y un ajuste convencional por mínimos cuadrados(se supone por

el momento que todas las observaciones tienen el mismo peso).

-En la siguiente iteración, se calculan nuevos pesos para cada observación

individual a partir de sus residuos obtenidos en el ajuste anterior, y se repite el

ajuste mínimo cuadrático con estos nuevos pesos. Los pesos p de cada

observación individual se obtienen de la siguiente forma:

En primer lugar reescribimos las equivalentes “Ecuaciones Normales”:

Σ

∂φ

∂

= 0 ; donde x son las incógnitas;

que lleva a una expresión para los pesos :

∂φ

p(e) = ∂

/v

-Para el método de la Minima Suma:

p(v) =

+ε

con ε una constante pequeña

-Para el denominado Método de Huber:

p(e) =

σ

σ≤

σ>

con a = 1. 5

siendo σ la desviación estándar a priori o estimada de las observaciones.

- Aplicando el método de la suma mínima al ejemplo anterior, el valor de la

estimación de la media es 11.01 después de 20 iteraciones, tomando como

constante 0.01 . Veamos los resultados de las 6 primeras iteraciones en forma

de tabla:

iteración

1

2

3

4

5

6

pesos

1 2 3

1 1

1

0.05 0.06 0.06

0.16 0.19 0.19

0.4 0.7 0.7

0.6 1.4 1.4

0. 6 1. 7 1. 7

media

4 5

1 1

0.05 0.01

0.23 0.01

2.2 0.01

3.5 0.01

2. 4 0. 01

28. 8

16. 2

12. 4

11. 7

11. 5

11. 4

1

residuos

2

3

4

5

19

6. 2

2. 4

1. 7

1. 5

1. 4

18

5. 2

1. 4

0. 7

0. 5

0. 4

71

83. 8

87. 6

88. 3

88. 5

88. 6

18

5. 2

1. 4

0. 7

0. 5

0. 4

17

4. 2

0. 4

0. 3

0. 5

0. 6

-Otro método de interés es el M. Danés (Krarup 1967, Kubik, 1982). Puede

ser considerado como un método de estimación robusta con pesos dados por:

p(v) =

< σ

σ

> σ

Si aplicamos el Método Danés al ejemplo anterior obtenemos:

Iteración

1

2

3

1

1

2

1

pesos

3

4

1

1

5

1

1.7 10-77 1.6 10-69 1.6 10-69 5.1 10-62 0

1

1

1

1

0

media

28.

residuos

1

2

3 4 5

19 18 18 17 71

12

11

2

1

1

0

1

0

0 88

1 89

-Este método tiene unas propiedades favorables comparado con otros métodos

robustos, en la detección de observaciones erróneas y en la velocidad de

cálculo (convergencia rápida del proceso)

-Habiendo analizado los diversos aspectos de los errores groseros, se puede

concluir que estos errores no existen como entidades independientes. Están

totalmente conectados con el dogma de la distribución normal y el método de

los mínimos cuadrados. En este sentido hay dos posibles caminos a seguir:

aceptar el método de los mínimos cuadrados y por tanto también la existencia

de estos errores, o elegir nuevos métodos de ajuste, en cuyo caso tanto el

concepto de mínimos cuadrados como el de error grosero desaparecen.

2. 4. - APLICACIÓN DEL MÉTODO DE LA MÍNIMA SUMA

-Vamos a describir de forma genérica el método de la mínima suma para

resolver un conjunto de ecuaciones lineales:

Ax=b+v

donde A es la matriz (n,m) de las ecuaciones de observación, n>m, x es el

vector de parámetros incógnita (m,1), b, es el vector de observaciones (n,1) y v

es el vector de residuos.

El método de la mínima suma, como ya hemos comentado , está basado en el

criterio de minimizar la suma de los valores absolutos de los residuos:

min v = min Ax -b

En este capítulo se mostrará como se puede obtener la solución por medio de

algoritmo equivalente este principio, y también se comparará con el algoritmo

clásico de los mínimos cuadrados.

-Sin embargo, los datos de observación rara vez contienen errores que sean

puramente aleatorios y sigan la distribución normal. De hecho, en la mayoría de

los casos, estos datos contienen algunos puntos “espúreos” (observaciones

fuera de rango), que es imposible o impracticable aislar del resto de los datos.

-Por ejemplo, en la mayoría de las redes geodésicas nacionales, las series de

observaciones que son necesarias para ajustar están formadas usualmente por

datos heterogéneos que han sido recogidos en diferentes momentos y con

diferente instrumentación, técnicas de observación y observadores de distinta

experiencia.

- Tratando con este tipo de redes, el problema no es tanto la identificación y

rechazo de las observaciones fuera de rango, sino conseguir la mejor solución

para la red tal y como está diseñada. Es decir, elegir un método de ajuste

adecuado para definir las mejores estimaciones de los parámetros de dicha red.

-En tales casos, algunos métodos rigurosos de ajuste distintos a los mínimos

cuadrados, pueden proporcionar un mejor ajuste. Uno de estos métodos es el

de la mínima suma o ajuste L1 como a veces se le denomina.

Consideremos el conjunto de ecuaciones de observación:

donde :

Ax=b+v

A: matriz de las ecuaciones de observación

x: vector de parámetros incógnita

b: vector de observaciones

v: vector de residuos

Por ejemplo, en el contexto del ajuste de una red de nivelación, x representaría

el vector de correcciones a las alturas aproximadas de los puntos.

Este método está basado en el criterio de minimizar la suma de los valores

absolutos de los residuos:

min Σ Ax-b

Este criterio se atribuye a Laplace(1799), sin embargo el primer método

sistemático para encontrar la solución fue desarrollado por Edgeworth(1888).

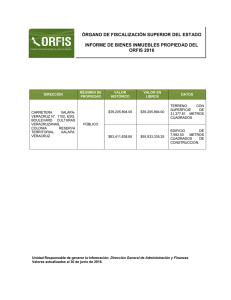

APLICACIÓN EN EL AJUSTE DE UNA RED DE NIVELACIÓN :

- Como aplicación de dicho método, y teniendo en cuenta su tamaño y

naturaleza, se eligió la red de nivelación geodésica de Nigeria, formada por 250

líneas de nivelación.

-El programa de nivelación para esta red comenzó en 1955 y aunque el plan

estaba totalmente definido desde el principio, la ejecución por el contrario fue un

proceso de muchas fases. Las observaciones se realizaron desde 1955 hasta

1977, con el consiguiente cambio en la instrumentación a lo largo de este

tiempo.

-Por estos cambios instrumentales y las variaciones en las condiciones

atmosféricas a lo largo de todo el territorio, estas observaciones no se podían

considerar homogéneas. De hecho, muchas líneas no se incluyeron en el ajuste

por la conocida heterogeneidad de los datos.

-La red ajustada estaba formada por 68 puntos y 40 circuitos con perímetros

entre 267 y 1299 Km, siendo 12656 Km la longitud total de las líneas.

APLICACIÓN EN EL AJUSTE DE UNA RED DE NIVELACIÓN :

-El método de la suma mínima se aplicó de la siguiente forma: a cada desnivel

se le asignó un peso de 1/L donde L era la longitud correspondiente.

-El ajuste final se realizó utilizando un algoritmo que se debe a Barrodale y

Young(1966), formulando un ajuste generalizado libre en el que no se consideró

fija ninguna estación.

-Después del ajuste, más de la mitad de los residuos resultaron cero. Se

observó que los desniveles con residuos distintos de cero grandes eran también

los únicos con discrepancias relativamente grandes en los dos sentidos de cada

tramo de la línea de nivelación. Esto indica que la magnitud del residuo en

cualquier desnivel depende de la calidad de la observación en dicho desnivel;

los desniveles con observaciones de peor calidad tenían posteriormente los

residuos o correcciones mayores.

-Para poder realizar una comparación se realizó un ajuste de la misma red

usando el método de los mínimos cuadrados. Se compararon los valores de las

estimaciones de la precisión de la red calculadas por los dos métodos y el valor

calculado con los errores de cierre del circuito, resultando mucho más realista el

valor obtenido por la suma mínima.

APLICACIÓN EN EL AJUSTE DE UNA RED DE NIVELACIÓN :

-Por otro lado, el estudio de la distribución de los errores de cierre dentro de

cada circuito, muestra que, mientras que el método de la suma mínima coloca

los mayores residuos en las diferencias de altura más flojas en precisión, el

método de los mínimos cuadrados los distribuye o reparte entre todos.

-Se podría resumir como conclusión que en un ajuste mínimo cuadrático, no es

posible detectar errores sistemáticos o groseros mediante un mero examen de

la variabilidad interna de los propios residuos.

-Esto ocurre porque en este ajuste, la observación peor no recibe

necesariamente la corrección mayor. La detección de este tipo de errores se

realiza indirectamente a través de test estadísticos sobre los residuos(Baarda)

y a través del análisis de la matriz covarianza

-En cambio, en el ajuste aquí estudiado, las partes más débiles de la red se

localizan directamente observando el tamaño de los residuos.

2. 5. PROBLEMAS PLANTEADOS POR EL MÉTODO CLÁSICO

-Sabemos que el método de los mínimos cuadrados minimiza el sumatorio de

los cuadrados de las correcciones v de las observaciones.

Σ v2 MÍNIMO

-A partir de los resultados del ajuste y los residuos puede ser muy complicado

detectar y localizar los errores graves . De hecho, el método es “muy

eficiente” en ocultar los errores mayores y distribuir sus efectos sobre todas las

observaciones, haciéndolos , por tanto, irreconocibles.

-Las observaciones erróneas no son necesariamente aquéllas con los mayores

residuos después del ajuste, como se mostrará en determinados ejemplos que

se desarrollarán en capítulos posteriores.

-Para afrontar estos problemas, Baarda desarrolló una amplia teoría basada

en tests estadísticos (Data Snooping) . Este método es, sin embargo, muy

elaborado, requiriendo tanto la inversión de la matriz de ecuaciones normales o

ajustes sucesivos excluyendo de forma individual todas las observaciones

Veamos algunos ejemplos de Estimadores Robustos:

MÉTODO DE LA SUMA MÍNIMA

Como una alternativa al método de los mínimos cuadrados, fue propuesto este

método en 1887. En este caso, se hace mínima la suma de los valores

absolutos de las correcciones:

Σ v MÍNIMO

Este método resulta atractivo de forma intuitiva, pues los residuos más grandes

son tolerados, facilitando la detección y localización de las observaciones

erróneas a partir de los resultados.

Estudios posteriores demuestran que este método proporciona mejores

resultados en la presencia de este tipo de errores que el método clásico.

En la mayoría de los casos, los residuos individualmente indican claramente

que medidas son erróneas.

(Sólo en la presencia de muchos y desfavorablemente localizados errores el

método puede llegar a conclusiones equivocadas )

MÉTODO DE HUBER:

Consiste en minimizar una función de los residuos φ(v), siendo para Huber

φ(v) = {

si v≤ 2σ

v2

2σ (2v-2σ)

si v> 2σ

siendo σ la desviación estándar de las observaciones

MÉTODO DE HAMPEL:

v2

φ(v) =

0 ≤| v |< a

a ≤| v |< b

a

v2

(cv − ) b ≤| v |< c

c -b

2

2

a c

| v |≥ c

c -b 2

av

Donde a , b y c son constantes

Otros principios de Estimación Robusta vienen dados por :

Σ |v| p ----> mínimo

con

1≤p<2

donde el rango de valores más favorable para la constante p está entre 1. 2 y

1. 5.

MÉTODO DANÉS :

-Este método fue desarrollado a partir de las ideas de Krarup(1967) y estaba

diseñado especialmente para eliminar errores groseros.

-El punto de partida de este método es un ajuste convencional por mínimos

cuadrados.

-A partir de los residuos del primer ajuste, se calculan nuevos pesos para cada

medida de forma individual, basados en la siguiente función de pesos

p(v) =

1

ke

- cv 2

| v |≤ 2σ

| v |> 2σ

-Con estos nuevos pesos, se realiza un nuevo ajuste por mínimos

cuadrados, y este proceso de reponderación y ajuste se repite hasta que se

logre la convergencia.

-Finalmente las observaciones afectadas de este tipo de errores tienen peso

cero y sus residuos son una medida de la magnitud del error correspondiente.

Una posible selección de pesos, que usualmente proporciona buenos

resultados dentro del campo de la fotogrametría sería la siguiente:

1ªiteración:

p=1

2ªy 3ªiteración: p=(exp[-(v/σ)4.4])0. 05

siguientes iteraciones: : p=(exp[-(v/σ)3])0. 05

2. 6. -BASES MATEMÁTICAS DE LA TEORÍA DE LA ESTIMACIÓN

ROBUSTA

Métodos de Estimación Robusta ( basada en estimadores

robustos)

Punto de partida:

• Φ (v) mínima ≠ vt P v

Planteamiento Matemático General:

f(x) distribución asociada al conjunto de observaciones

Parámetro a estimar : θ

Valor Estimado :

θ

Distribución del Estimador : ϕ (

θ

,f)

- f(x) no se conoce exactamente

- g(x)

-

θ

Representa el Modelo matemático

para f(x)

será ROBUSTO si

d(f,g) < η

d [ϕ ( θ ,f), ϕ ( θ ,g) ] < ε

∀ η , ε positivos

d : se denomina distancia de Prokhorov

Planteamiento Matemático : Aplicación

Modelo de Distribución de las

Observaciones:

g(x) ≈ N ( µ, σ2)

Distribución Real : Normal Contaminada

f(x) = (1-) N(µ,σ2) + η(a ,σ2)

con η pequeño

y (a - µ)2 > n σ2

PASOS DEL PROCESO

Elección del Punto de Análisis

Construcción

Influencia

de

la

Función

de

Método de Jacknife

Clasificación General

Condiciones que debe cumplir un estimador de tipo M

-Veamos primero cual sería el algoritmo de aplicación para los

estimadores de tipo M:

Como ya se ha señalado con anterioridad, una de las técnicas robustas

más utilizadas son los llamados estimadores de tipo M.Sea vi el residuo

correspondiente al dato iésimo, la diferencia entre la observación y el

valor ajustado. El método estándar de los mínimos cuadrados trata de

minimizar el sumatorio

, el cual es inestable si existen datos aislados

dentro de las observaciones.

Estos datos producen un efecto tal en el proceso de minimización, que los

parámetros estimados quedan distorsionados. Los estimadores de tipo M,

como ya se ha señalado, intentan reducir el efecto de estas

observaciones reemplazando los residuos al cuadrado por otra función de

dichos residuos, es decir

ρ

-donde ρ es una función simétrica, definida positiva con un único mínimo en cero, y

se elige de tal forma que sea menos creciente que el cuadrado.

-En lugar de resolver directamente el problema, tal y como se hizo en el método

clásico de los mínimos cuadrados, se puede implementar un algoritmo que sería

unos mínimos cuadrados reponderados.Veamos como se construye el algoritmo:

!

%"

'

&' ( ρ

"+

Ψ

"

∂

∂

=,

&' (

Ψ

"

&' (

ρ

&'

#

" "

)' "

,

#$ "

" ' (

" " *'

"

./

&

" ' &' (

" "

Ψ

"

' (

)'

∂

∂

$"

" *'

"

%

"

=-

,

#

,

""

0

" '

'

" )' "

"

%

" "

"'

"

−

"'

)' "

0

'

1

" '4"

2

( #$

(

'

"

" *'

13

#

&' (

"

#5

&'

,

"

&'

0

" '

'

"

!

ρ

&' (

&'

"

Ψ

"

"'

' !

' )'

"* &

&'

'

#7'

' "

%"

(

#8 9

"

(

&

3 %'"

" %'" " '

" "'&

" )' % '

#

"' ' "

#

'

"

"

6

"

)'

'

&

'

' "

' &' (

&'

" *'

"

'

)'

)'

2 #$"

)' &' ( %,

"

* ' 2

0

#

&' ( ρ "

% #$"

"

"( )'

&' ( ρ

* ' 2

"'&

#

(

" )'

∂ ρ #

"

∂

&

*

#

(

0

&'

"

+

#

"

"

"

!

)'

"

0

)'

)'

"

)'

Resumen del Algoritmo General de aplicación de

los estimadores de tipo M:

Elección de la Función Objetivo :

• ρ(v) mínima

Construcción de la Función de Influencia:

• Ψ(x) = d ρ(x)/ dx

Construcción de la Función de Pesos:

• p(x)= Ψ(x)/ x

Algoritmo General de aplicación de los

estimadores de tipo M:

Proceso Iterativo :

1−

• k: nº de iteración

• i : nº de residuo

Otros estimadores(tipo M):

ρ

Ψ

ρ

Ψ

"*

3

ρ

+

−

Ψ

+

+

Otros estimadores(tipo M):

ν

ρ

Ψ

ν

ν3

"*

ν3

:; <

ρ

3

8'%

ρ(

−

*

"

"

Ψ

=

=

=

≤ 1

≥ 1

Ψ

1 "*

1

Otros estimadores(tipo M):

7 ' /9+

ρ(

>

ρ(

Ψ

* +

3

+

7' +

Ψ

+

+

+

+

? " /+

ρ(

−

'1 9+

ρ(

B

−

B

]

−

−

−

Ψ

−

≤

"

@

]A

Ψ

−

-

]

−

-

]

Veamos ahora una serie de características de de estas funciones:

0

&'

D

" "

"'&' (

"

'

" +" " "

#

"

"

%'" " ' "

&' (

%" ' + " " "

"

"

" % " ' " &' (

" "

#C / /

" *'

"!

9 '

"' ' " ' (

%" '

*'

A

" '

"!

"

"

&'

"

&'

'

' '

3

"

"

"*

&'

"

"

#

9

"

#

, "

"9

"

"

"

"

#

E

&' (

0

"#$"

ν

&'

"

ν

.

"

% "

"

&

#

"

)' ν

#5

ν

9 "

'

"

"

(

%"

'

%'" #

" *

(

#

!

"'

""

'

' %'

% * "

'

ν "!

'

" #

&' ( ;

"

"(

" %

"

B

&'

*

4"

"

" 9

"

#AGGH#

'"

' 2

(

"

' (

ν#F

(#

"

'"

"

&

"

" ' (#

!'

" '"

'

'

'

&

"

9

I

&' (

8'%

" '

'

" %' ( " !

$" "

"" '

"

"

"

"K

"

% *

'

"

% "

&' ( ρ

"' "

ρ

"

)'

"&

"/

!%

@1#

%

"

0"

9

" (

GEJ

"

1 #ADE#

&

)' "

"'

"

&

" /

&

" %

' " *'

*'

'

=

"

≤1

- "

≥1

'

&'

*

" )'

+

&

H

&' (

7 ' /9

%4

*

' 2

" ' ( #7 '

&' (

'

)'

' "

%"

#

#AHDG#

&' ( #

*' "

"

"

"

9

"

#

-I#

&' (

" '

&

"

9 "

( "

" *'

/

'

'

G " &'

7 ' /9#7

"

"*

" "

" '

" "(

"

%"

"

&' (

%

&'

"'

" &'

" >

3 7' 9 ? " /

&'

" 9

&' ( %

'1 9

"#$" 2

" *'

&

9

? " /

#GHDB#

5

*

' " '

" "

*

%

,

( "

"

%'" "#

)'

)'

#5

"

%

"

"

"' (

&' (

&'

6#

'

'" "'

D#BHE 9

%4 " "

"

"

&' (

ρ

'"

( 9 * "(

3 %'" K"

'" 3

" *'

, &' ( " ;

' '

'*

*

&

"

#$

'

%4 '

8'%

"' " (

*

&

#

" " " &'

&'

"

"*

"#

'" "

"

" )'

&' (

Elección de los Estimadores Robustos:

Mínima Suma :

ρ(x) = |x|

ψ (x) = sgn(x)

p(x) = 1 / |x|

Método de Huber :

≤1

ρ(x) =

1

3

1

p(x) = 1

>1

≤1

>1

ψ (x) =

≤1

1 "*

k cte.

>1

Elección de los Estimadores Robustos:

Método Danés :

≤ σ

ψ (x) =

3

p(x) =

> σ

c,σ ctes.

≤ σ

3

> σ

Elección de los Estimadores Robustos:

Estimador de Geman & McClure:

ρ(x) =

ψ (x) =

+

p(x) =

+

+

2. 7. –ALGUNOS EJEMPLOS SENCILLOS DE APLICACIÓN DE ESTIMADORES

EJEMPLO DEL ESTIMADOR DE HUBER

Este estimador fue desarrollado por PETER J. HUBER en el año 1964 y en

su trabajo “Robust Estimation ” del año 1968 presenta en detalles la teoría de

la estimación robusta de un parámetro de tendencia central o posición central

o puntual de una distribución normal “contaminada” y presenta los tres

métodos para construir estimadores que robustos.

El Estimador HUBER se desarrolló en base a las funciones :

( Vi )² = mínima

K

(2 V

si se cumple

- K ) = mínima

|V|

K

si cumple con | V |

K

generalmente K adopta valores de 2 ó 3. Muchos recomiendan usar el valor 3,

pués K representa la tolerancia de la medición y representa la exactitud

de la observación o medición obtenida. Es un proceso iterativo.

El Estimador de HUBER usa como función de Peso P lo siguiente :

P= 1

si

| V|

K

K

P = ---------------

si

|V|

K

| V|

Veamos en la pizarra un ejemplo numérico de aplicación muy

sencillo:

EJEMPLO DEL MÉTODO DANÉS

-Este método fue propuesto por TORBEN KRARUP en 1967 y desde entonces

ha sido usado como un método standard de computación en el Instituto Danés de

Geodesia para sus cálculos Geodésicos. Durante los últimos años ha sido usado

para otras tareas en la Universidad de Aalborg.

- El método Danés puede ser interpretado también como un método iterativo, como

lo es el estimador de HUBER, para resolver un problema de programación lineal,

particularmente si los Pesos para las mediciones con errores groseros ( los

denominados “outliers”) son reducidos a cero.

-La convergencia del método depende de las condiciones del problema y del

porcentaje de errores groseros.

La estimación de acuerdo con el Método Danés tiene el siguiente algoritmo

iterativo :

CASO DE MEDICIONES DE IGUAL EXACTITUD :

(1) Si los residuos l V l

K les corresponde un peso P = 1

(2) Si los residuos l V l

K les corresponde un peso dado

por la expresión siguiente :

p(v ) = e

Siendo :

v2

−

( kσ )2

e = 2.718282 . . . ( base de los logaritmos Neperianos )

K = constante que adopta el valor de 2 ó 3

= precisión adoptada para el grupo de mediciones.

Hay que señalar que existen diferentes variantes del Método Danés

dependiendo del problema a resolver.

Veamos también ahora un ejemplo numérico como aplicación de este

Método:

EJEMPLO COMPARATIVO

Consideremos el caso de dos estudiantes A y B que cursaron las mismas

asignaturas y cuyas calificaciones son las siguientes :

ASIGNATURAS

Matemáticas

Física

Química

Biología

Historia

CALIFICACIONES

A

B

10

20

10

20

10

20

10

20

20

10

¿ Cual es la calificación que representaría al Estudiante A y B ?

Si aplicamos las estimadores paramétricos de la media aritmética, la mediana y la

media de los extremos, por ejemplo, se obtiene :

ESTIMADOR

Media Aritmética

Mediana

Media de los Extremos

ESTUDIANTE

A

B

12

10

15

18

20

15

De estos resultados observamos que la media aritmética parece que no

representa mejor las calificaciones, mientras que la mediana ofrece una mejor

representación; mientras que la media de los extremos califica de igual tanto al

buen estudiante como al mal estudiante ( ¿ qué tal ? ). Obsérvese que no hay

consistencia entre las tres estimaciones realizadas.

Obsérvese que la muestra es pequeña y no podemos eliminar la calificación

que se sale de la mayoría; tampoco podemos asumir alegremente que es una

distribución normal o una distribución rectangular.

Aplicando los ESTIMADORES ROBUSTOS se obtienen los valores siguientes :

ESTIMADOR

APLICADO

Estimador de HUBER ( * )

Método Danés ( * )

( * ) Se utilizó

= 1 y valor de K = 2

ESTUDIANTE

A

10.498

10

B

19.501

20