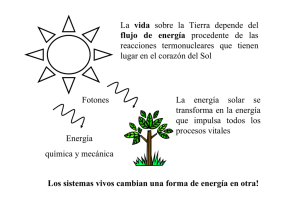

La selección natural y la termodinámica

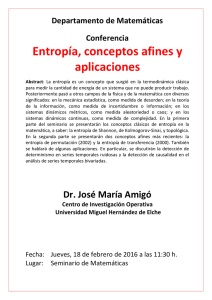

Anuncio