∫Ξ ∑

Anuncio

Métodos de Muestreo (Monte Carlo)

Los métodos de muestreo son una alternativa para la

evaluación de la función de recurso (integral multidim.).

Mediante estimaciones estadísticas se pueden obtener

intervalos de confianza sobre los resultados.

Mediante análisis estadístico se pueden derivar propiedades

asintóticas de las soluciones de un programa estocástico

formado por un conjunto de observaciones.

Derivaciones del método L:

- Estableciendo cortes mediante muchas muestras por corte.

- Adicionando muchos cortes con pocas muestras en cada

iteración (método de descomposición estocástica).

1

Muestreo de Problemas

Para un integrando general g(x, ξ), el objetivo es resolver

min x∈ X

∫

Ξ

g ( x, ξ ) P (dξ )

donde ξestá definida sobre un espacio de prob. con medida P.

Se supone que tiene solución óptima x* con valor óptimo z*.

Alternativamente, se puede considerar el problema aproximado

formado por muestras de ξ. Se considera una muestra de

observaciones independientes de ξ, {ξi}, i=1,...,v, entonces el

problema aproximado es

1 v

g ( x, ξ i );

∑

v i =1

se supone que tiene solución óptima xv con valor óptimo zv.

min x∈ X

2

1

Teorema Central del Límite (TCL)

Si las variables aleatorias X1, ..., Xn son independientes y

tienen la misma distribución (iid) con esperanza µ finita y

varianza σ2 finita no nula, entonces la variable aleatoria

Zn =

X 1 + K + X n − nµ

σ n

es asintóticamente normal, es decir su función de distribución

Fn(z) cumple, para todo z

X + K + X n − nµ

lim n → ∞ Fn ( z ) = lim n → ∞ P 1

≤ z = Ν (0,1).

σ n

3

Teorema Central del Límite: Derivado

Definiendo

Xn =

1

n

∑

n

i =1

Xi

se tienen las formas equivalentes

X − µ

n n

a Ν (0,1)

σ

n ( X n − µ ) a Ν (0, σ 2 ).

4

2

Propiedades sobre la

solución óptima aproximada

Para inferir propiedades estadísticas sobre intervalos de

confianza en x* a partir de la observación xv, se busca encontrar

una distribución u tal que

ν (xν − x* ) a u.

Bajo ciertas hipótesis de diferenciabilidad de segundo orden de

g(.), medida del gradiente y condiciones del hessiano de g(.), se

puede obtener u como la solución a un problema cuadrático que,

entre otros, involucra el gradiente y la esperanza del hessiano de

g(.).

5

Propiedades sobre el

valor óptimo aproximado

Sea zv el valor óptimo aleatorio aproximado de z*

Suponiendo que g(x, ξi) es una observación iid de g(x, ξ), y que

g(x, ξ) tiene varianza finita

2

Var g ( x ) = ∫ | g ( x,ξ ) |2 P(dξ ) − [ Eξ ( g ( x,ξ ))]

Ξ

entonces se puede aplicar el TCL, estableciendo

v

v 1v ∑ g ( x,ξ i ) − ∫ g ( x, ξ ) P(dξ ) a N (0, Var g ( x)).

Ξ

i =1

Bajo ciertas condiciones de g(.) y la existencia de un mínimo x0

se cumple

v

*

0

(

v z −z

)a

N (0, Var g ( x )).

6

3

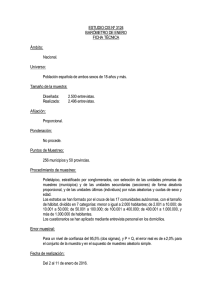

Muestreo en el Método L

Los métodos discretos pueden aplicarse al problema aproximado.

Es ineficiente resolver el problema aproximado completamente

para aproximaciones no cercanas dado que se desperdician

recursos de optimización.

En cambio, es deseable que se use muestreo sin optimización

completa; i.e., que ambos procesos se realicen simultáneamente.

Particularmente, se incluye muestreo dentro del método L:

- utilizando muestreo por importancia para reducir la varianza en

deducir cada corte (muestras grandes), y

- usando una muestra para crear muchos cortes que se actualizan

a medida que evoluciona el proceso (método de descomposición

estocástica).

7

Descomposición Estocástica

Genera muchos cortes con un número pequeño de muestras

adicionales en cada corte y actualiza cortes a medida que el

algoritmo evoluciona.

Se asume recurso completo, una cota cota inferior de Q(x,ξ),

conjunto de soluciones duales es acotado, y que K1 y Ξ son

compactos.

8

4

Método de Descomposición Estocástica

Paso 1.

Establecer v = 0, ξ0 = E(ξ) y sea x1 la solución de

min x∈ X {cT x + Q( x,ξ 0 )}

Paso 2.

Sean v = v + 1 y ξv una muestra generada de ξ.

Calcular Q v ( x v ) = 1 ∑v Q( x v ,ξ s ) = 1 ∑v (π sv )T (ξ s − Tx v )

v

v

s =1

s =1

Establecer v 1 v

v

1

v

v T

v T s

E =

v

∑

s =1

(π s ) T

e =

v

∑

s =1

(π s ) ξ

Paso 3.

Actualizar los cortes Es := ((v-1)/v)Es, es := ((v-1)/v)es, para

s=1,...,v-1.

Paso 4.

Resolver el problema maestro obteniendo x v+1. Ir al Paso 2.

9

5