Teorema de cambio de variable

Anuncio

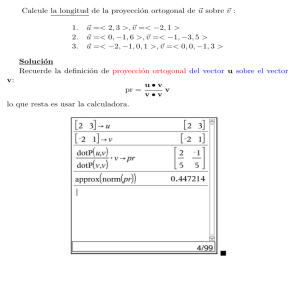

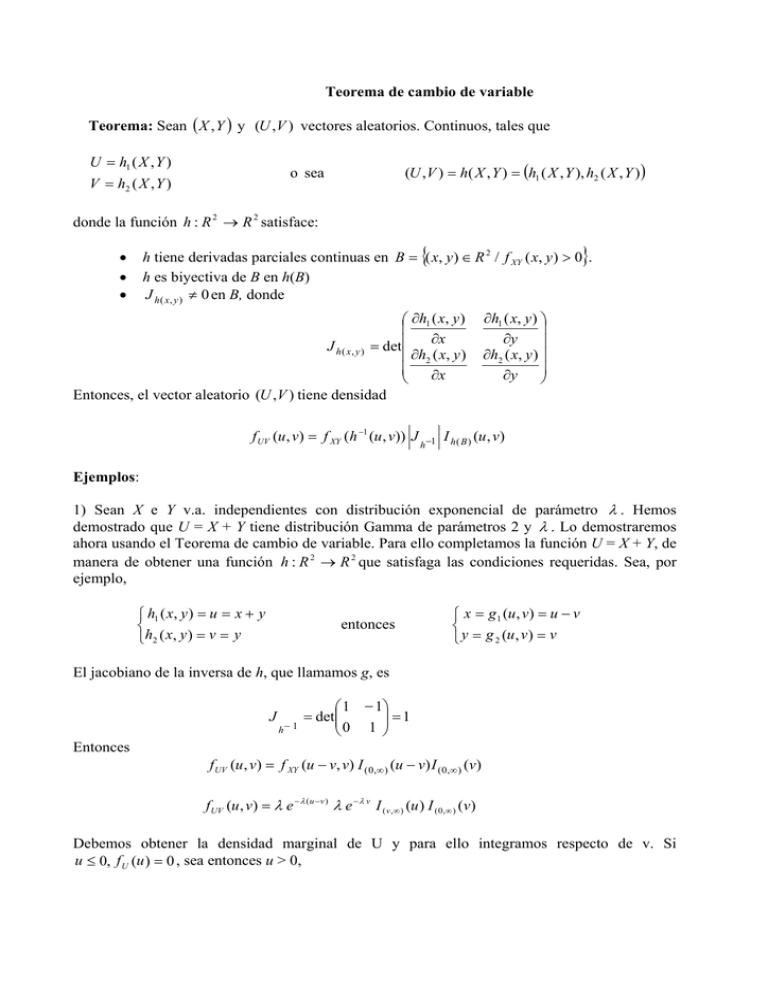

Teorema de cambio de variable

Teorema: Sean ( X , Y ) y (U , V ) vectores aleatorios. Continuos, tales que

U = h1 ( X , Y )

V = h2 ( X , Y )

(U , V ) = h( X , Y ) = (h1 ( X , Y ), h2 ( X , Y ) )

o sea

donde la función h : R 2 → R 2 satisface:

{

•

•

•

}

h tiene derivadas parciales continuas en B = ( x, y ) ∈ R 2 / f XY ( x, y ) > 0 .

h es biyectiva de B en h(B)

J h ( x, y ) ≠ 0 en B, donde

⎛ ∂h1 ( x, y )

⎜

∂x

J h ( x , y ) = det⎜

⎜ ∂h2 ( x, y )

⎜ ∂x

⎝

Entonces, el vector aleatorio (U ,V ) tiene densidad

f UV (u, v) = f XY (h −1 (u , v)) J

h −1

∂h1 ( x, y ) ⎞

⎟

∂y

⎟

∂h2 ( x, y ) ⎟

⎟

∂y

⎠

I h ( B ) (u , v)

Ejemplos:

1) Sean X e Y v.a. independientes con distribución exponencial de parámetro λ . Hemos

demostrado que U = X + Y tiene distribución Gamma de parámetros 2 y λ . Lo demostraremos

ahora usando el Teorema de cambio de variable. Para ello completamos la función U = X + Y, de

manera de obtener una función h : R 2 → R 2 que satisfaga las condiciones requeridas. Sea, por

ejemplo,

⎧ h1 ( x, y ) = u = x + y

⎨

⎩ h2 ( x , y ) = v = y

entonces

⎧ x = g1 (u , v) = u − v

⎨

⎩ y = g 2 (u , v) = v

El jacobiano de la inversa de h, que llamamos g, es

J

h− 1

⎛ 1 − 1⎞

⎟⎟ = 1

= det⎜⎜

⎝0 1 ⎠

Entonces

f UV (u , v) = f XY (u − v, v) I ( 0,∞ ) (u − v) I ( 0,∞ ) (v)

f UV (u , v) = λ e − λ ( u −v ) λ e − λ v I ( v ,∞ ) (u ) I ( 0,∞ ) (v)

Debemos obtener la densidad marginal de U y para ello integramos respecto de v. Si

u ≤ 0, f U (u ) = 0 , sea entonces u > 0,

u

f U (u ) = ∫ λ e

−λ (u −v )

λe

−λ v

dv = λ e

2

-λu

0

u

∫ dv = λ

2

e -λu u

0

Luego, f U (u ) = λ 2 e -λ u u I ( 0,∞ ) (u ) y queda demostrado que X+Y ~ G(2, λ ).

2) Sean X e Y v.a. independientes con distribución Normal standard y sean U = X+Y y V = X-Y.

Hallemos la densidad conjunta del v.a. (U,V).

u+v

⎧

⎪x= 2

⎨

u-v

⎪ y=

2

⎩

⎧u = x + y

⎨

⎩v = x − y

Entonces

J

f UV ( u , v ) =

h− 1

⎛1 / 2 1 / 2 ⎞

⎟⎟ = −1 / 2 .

= det⎜⎜

⎝1 / 2 − 1 / 2 ⎠

f UV (u, v) = f XY (h −1 (u , v)) J

h −1

2

2

1

2π

e

1 ⎛ u +v ⎞

− ⎜

⎟

2⎝ 2 ⎠

1

2π

f UV ( u , v ) =

e

1 ⎛ u −v ⎞

− ⎜

⎟

2⎝ 2 ⎠

1

2π 2

e

⎛u +v⎞ ⎛u −v⎞1

I h ( B ) (u, v) = f X ⎜

⎟ fY ⎜

⎟

⎝ 2 ⎠ ⎝ 2 ⎠2

1 1

=

e

2 4π

1⎛ u ⎞

⎟

− ⎜⎜

2 ⎝ 2 ⎟⎠

1 ⎛ u 2 + 2uv + v 2 + u 2 − 2uv + v 2

− ⎜

2⎜

4

⎝

2

1

2π 2

e

1⎛ v ⎞

⎟

− ⎜⎜

2 ⎝ 2 ⎟⎠

⎞

⎟

⎟

⎠

1

=

e

4π

1 ⎛ u 2 +v2

− ⎜

2⎜ 2

⎝

⎞

⎟

⎟

⎠

2

Por lo tanto U y V son v.a. independientes con distribución N(0,2).

3) (Extensión a dimensión mayor que 2). Sean X1, X2 y X3 v.a. independientes con distribución

N(0,1), hallar la distribución conjunta de (U,V,W) siendo

⎧U = X 1 + X 2 + X 3

⎪

⎨V = X 1 − X 2

⎪W = X − X

1

3

⎩

Observar que

⎧u = x1 + x 2 + x3

⎪

⎨ v = x1 − x 2

⎪w = x − x

1

3

⎩

u+v+w

⎧

⎪ x1 =

3

⎪⎪

u − 2v + w

⎨ x2 =

3

⎪

u

v

+

− 2w

⎪x =

3

⎪⎩

3

y, entonces

J h −1

1/ 3 ⎞

⎛1 / 3 1 / 3

⎟ 1

⎜

= det⎜1 / 3 − 2 / 3 1 / 3 ⎟ = .

⎜1 / 3 1 / 3 − 2 / 3 ⎟ 3

⎠

⎝

⎛ u + v + w u − 2v + w u + v − 2 w ⎞ 1

f UVW (u , v, w) = f X1 X 2 X 3 ⎜

,

,

⎟

3

3

3

⎝

⎠3

1 ⎛ u +v+ w ⎞2

⎜

⎟

2⎝ 3 ⎠

1 1 −

f UVW ( u , v , w ) =

e

3 2π

1

2π

e

−

1 ⎛ u − 2v + w ⎞

⎜

⎟⎟

2 ⎜⎝

3

⎠

2

1

2π

e

−

1 ⎛ u +v−2 w ⎞

⎜

⎟⎟

2 ⎜⎝

3

⎠

2

Desarrollando se obtiene:

f UVW ( u , v , w ) =

1

2π 3

e

1 ⎛ u ⎞⎟

− ⎜⎜

2 ⎝ 3 ⎟⎠

2

1 1

e

2π 3

1 ⎛ 2 v 2 + 2 w 2 − 2 vw ⎞⎟

− ⎜

⎟

2⎜

3

⎝

⎠

.

Se observa, en particular, que U = X1+X2+X3 ~ N(0,3).

Algunos resultados importantes:

1) Si X 1 ~ N ( μ1 ,σ 12 ) y X 2 ~ N ( μ 2 ,σ 22 ) son v.a. independientes, entonces

aX 1 + bX 2 ~ N ( aμ1 + bμ 2 , a 2σ 12 + b 2σ 22 )

2) Si X 1 ,..., X n son v.a. independientes e idénticamente distribuidas, X i ~ N ( 0,1 ) y a ∈ R n es

un vector tal que a = 1 , entonces

n

∑a X

i =1

i

i

~ N ( 0,1 )

Dem: Sea B una matriz ortogonal de dimensión n × n, cuya primer columna es el vector a y sea

X = (X 1 , X 2 ,..., X n )' . Definiendo

Y = B' X

(1)

n

su primera componente es Y1 = ∑ a i X i .

i =1

El jacobiano de la transformación (1) J = det( B ) =1 pues la matriz B es ortogonal. Entonces:

fY ( y ) = f X ( By) =

(

1

2π

)

n

e

−

2

1

By

2

=

(

1

2π

)

n

e

−

2

1

y

2

y por lo tanto las componentes del vector Y son v.a. independientes con distribución N(0,1).

Hemos demostrado entonces que Y1, que es la primera componente, tiene distribución Normal

standard.

3) Teorema: Sean X 1 ,..., X n v.a. independientes e idénticamente distribuidas, X i ~ N ( μ ,σ 2 ) ,

entonces

i) X =

ii)

⎛ σ2

1 n

X

~

N

∑ i ⎜⎜ μ , n

n i =1

⎝

( n − 1 )s 2

σ2

~ χ n2−1

⎞

⎟⎟ ⇒

⎠

siendo s 2 =

n( X − μ )

σ

~ N ( 0 ,1 )

1 n

(X i − X )2

∑

n − 1 i =1

iii) X y s 2 son v.a. independientes

iv)

n( X − μ )

~ t n −1

s

Dem: No la haremos pero también se basa en hallar una transformación ortogonal adecuada. Este

Teorema lo verán nuevamente en Estadística Teórica.