Fiabilidad 2

Anuncio

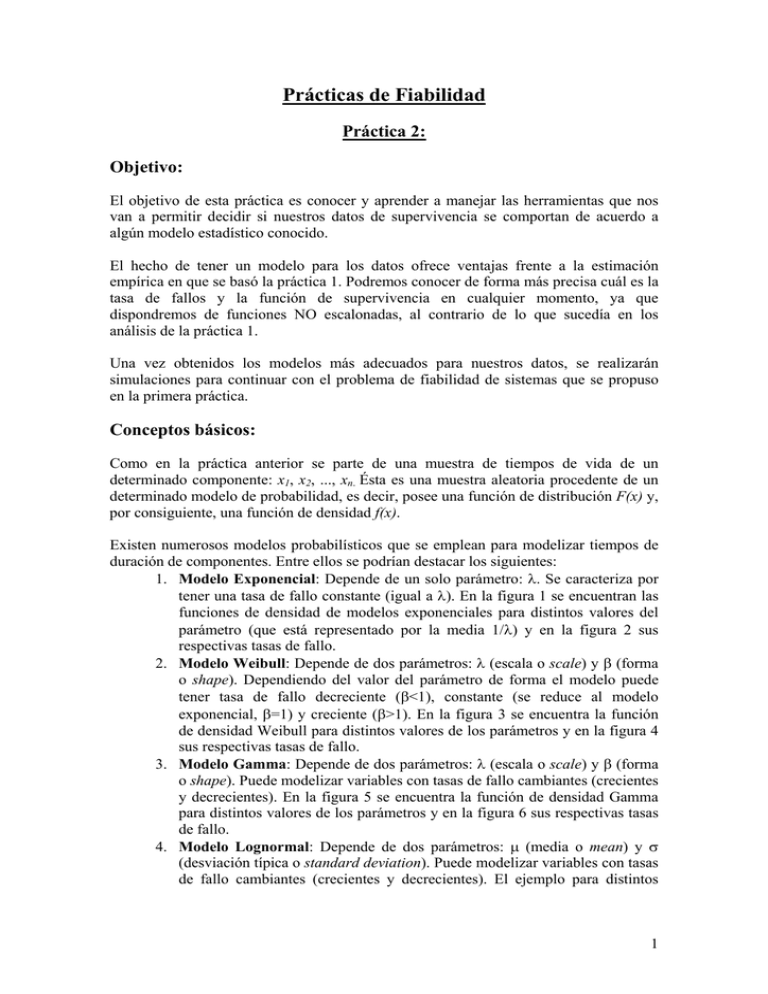

Prácticas de Fiabilidad Práctica 2: Objetivo: El objetivo de esta práctica es conocer y aprender a manejar las herramientas que nos van a permitir decidir si nuestros datos de supervivencia se comportan de acuerdo a algún modelo estadístico conocido. El hecho de tener un modelo para los datos ofrece ventajas frente a la estimación empírica en que se basó la práctica 1. Podremos conocer de forma más precisa cuál es la tasa de fallos y la función de supervivencia en cualquier momento, ya que dispondremos de funciones NO escalonadas, al contrario de lo que sucedía en los análisis de la práctica 1. Una vez obtenidos los modelos más adecuados para nuestros datos, se realizarán simulaciones para continuar con el problema de fiabilidad de sistemas que se propuso en la primera práctica. Conceptos básicos: Como en la práctica anterior se parte de una muestra de tiempos de vida de un determinado componente: x1, x2, ..., xn. Ésta es una muestra aleatoria procedente de un determinado modelo de probabilidad, es decir, posee una función de distribución F(x) y, por consiguiente, una función de densidad f(x). Existen numerosos modelos probabilísticos que se emplean para modelizar tiempos de duración de componentes. Entre ellos se podrían destacar los siguientes: 1. Modelo Exponencial: Depende de un solo parámetro: λ. Se caracteriza por tener una tasa de fallo constante (igual a λ). En la figura 1 se encuentran las funciones de densidad de modelos exponenciales para distintos valores del parámetro (que está representado por la media 1/λ) y en la figura 2 sus respectivas tasas de fallo. 2. Modelo Weibull: Depende de dos parámetros: λ (escala o scale) y β (forma o shape). Dependiendo del valor del parámetro de forma el modelo puede tener tasa de fallo decreciente (β<1), constante (se reduce al modelo exponencial, β=1) y creciente (β>1). En la figura 3 se encuentra la función de densidad Weibull para distintos valores de los parámetros y en la figura 4 sus respectivas tasas de fallo. 3. Modelo Gamma: Depende de dos parámetros: λ (escala o scale) y β (forma o shape). Puede modelizar variables con tasas de fallo cambiantes (crecientes y decrecientes). En la figura 5 se encuentra la función de densidad Gamma para distintos valores de los parámetros y en la figura 6 sus respectivas tasas de fallo. 4. Modelo Lognormal: Depende de dos parámetros: μ (media o mean) y σ (desviación típica o standard deviation). Puede modelizar variables con tasas de fallo cambiantes (crecientes y decrecientes). El ejemplo para distintos 1 valores de los parámetros aparece en la figura 7 y en la figura 8 sus respectivas tasas de fallo. Exponential Distribution Mean 10 15 20 25 0,1 density 0,08 0,06 0,04 0,02 0 0 30 60 90 120 150 x Figura 1. Función de densidad exponencial. Exponential Distribution 0,12 Mean 10 15 20 25 hazard 0,1 0,08 0,06 0,04 0,02 0 0 30 60 90 120 150 x Figura 2. Tasa de fallos de la función de densidad exponencial. Weibull Distribution Shape,Scale 1,1 0,8,2 2,1 5,3 1 density 0,8 0,6 0,4 0,2 0 0 3 6 9 12 15 18 x Figura 3. Función de densidad Weibull. 2 Weibull Distribution Shape,Scale 1,1 0,8,2 2,1 5,3 hazard 15 10 5 0 0 1 2 3 4 5 x Figura 4. Tasa de fallos de la función de densidad Weibull. Gamma Distribution Shape,Scale 1,1 2,1 0,5,1 4,0,5 1,5 density 1,2 0,9 0,6 0,3 0 0 5 10 15 20 25 30 x Figura 5. Función de densidad Gamma. Gamma Distribution Shape,Scale 1,1 2,1 0,5,1 4,0,5 2,4 hazard 2 1,6 1,2 0,8 0,4 0 0 5 10 15 20 25 30 x Figura 6. Tasa de fallos de la función de densidad Gamma. 3 Lognormal Distribution Mean,Std. dev 1,1 2,2 5,1 10,2 1 density 0,8 0,6 0,4 0,2 0 0 4 8 12 16 20 x Figura 7. Función de densidad Lognormal. Lognormal Distribution Mean,Std. dev 1,1 2,2 5,1 10,2 2 hazard 1,6 1,2 0,8 0,4 0 0 4 8 12 16 20 x Figura 8. Tasa de fallos de la función de densidad Lognormal. Estos son sólo algunos ejemplos de funciones de densidad conocidas. Pero, ¿qué herramientas estadísticas hay para saber qué modelos pueden ser adecuados para mi variable? ¿Qué herramientas estadísticas ayudan a decidir si un modelo es o no adecuado? Para hacer un primer análisis de la variable se debe hacer uso de técnicas descriptivas, es decir, se emplea el histograma para ver cómo se distribuye la muestra por intervalos y se realizan estimaciones de la función de densidad para obtener algo semejante al histograma pero de forma suave y continua (no por intervalos). En cuanto a las herramientas para determinar si un modelo es adecuado a una muestra se pueden clasificar en procedimientos gráficos y numéricos. Gráficamente se puede comprobar si la función de densidad del modelo propuesto es aproximadamente igual que el histograma de los datos. Aunque es mucho más fiable el gráfico cuantil-cuantil o quantil-quantil plot (QQ-plot) que consiste en hacer un gráfico de dispersión entre los valores de la muestra ordenados y los cuantiles del modelo propuesto. El modelo podrá ser adecuado si los puntos del gráfico están alineados. 4 NOTA: Se dice que X p es el cuantil de probabilidad p si F ( X p ) = p . Ejemplo: Supongamos que tenemos la siguiente muestra de tiempos: 6.2, 1.5, 2.1, 3.5 y 0.7. Que tenemos un modelo representado por la función de distribución F(x) y cuya inversa es F-1(p), con p entre cero y uno. Lo que hace el QQ-plot es hacer el diagrama de dispersión de las columnas 2 y 3 de la siguiente tabla. La primera columna representa la función de distribución empírica de la muestra. La segunda los datos de la muestra ordenada y la tercera la inversa de la función de distribución del modelo evaluada en los puntos de la columna 1. En la tabla se disponen los datos de forma ordenada. Fn (xi) 1/5 2/5 3/5 4/5 1 xi 0.7 1.5 2.1 3.5 6.2 F-1(Fn (xi)) F-1(1/5) F-1(2/5) F-1(3/5) F-1(4/5) F-1(1) Así pues, si los datos se distribuyen según F(x) se tiene que F-1(1/5) será próximo a 0.7, F-1(2/5) será próximo a 1.5 y así sucesivamente, es decir, en el gráfico los puntos aparecen alineados según la recta y=x. Los procedimientos numéricos consisten en realizar contrastes de hipótesis sobre los datos. Por tanto atenderemos al p-valor de los mismos para determinar si existe la posibilidad de que la muestra se comporte según un determinado modelo o no. Las hipótesis de este tipo de contrastes son: ⎧ H 0 : f ( x ) puede ser la densidad de x1 , x2 ,..., xn ⎨ ⎩ H 1 : f ( x ) no es la densidad de x1 , x2 ,..., xn Como en todo contraste de hipótesis si se obtienen p-valores bajos existe evidencia en los datos a favor de la hipótesis alternativa (en este en particular, evidencias que indican que los datos no tienen esa función de densidad). Dos ejemplos clásicos de contrastes que trabajan estas hipótesis son el de Chi-cuadrado (Chi-square) y KolmogorovSmirnof. NOTA MUY IMPORTANTE: Si se rechaza la hipótesis nula (los datos ofrecen evidencia a favor de la alternativa) significa que se tiene una confianza importante en que los datos no siguen el modelo propuesto. Pero si no se rechaza la hipótesis nula, no quiere decir que el modelo propuesto sea el que siguen los datos. Es decir, si no se rechaza la nula quiere decir que el modelo propuesto resulta compatible con los datos, pero no se puede afirmar con rotundidad que sea ése. En STATGRAPHICS, el resultado del test Chi-cuadrado puede ser diferente según la versión instalada del programa. Por tanto, utilizaremos el test de Kolmogorov para realizar estos contrastes. Datos: Los datos que se van a analizar se encuentran en el fichero practica 1 fiabilidad.sf. 5 Nota: Recordar que las cuatro primeras columnas del fichero recogen la duración de los cuatro componentes para los que se estudió varios sistemas. Qué hay que hacer: No se va a realizar ningún análisis descriptivo previo ya que con el análisis de ajuste de distribución (distribution fitting) de Statgraphics se obtiene directamente el histograma y existe la posibilidad de obtener la estimación de la densidad. Nota: Antes de realizar el análisis de ajuste de distribución conviene mencionar que por defecto el programa Statgraphics compara con la distribución normal, para la que estima los parámetros correspondientes. • • Se abre el fichero practica 1 fiabilidad.sf. Se va a: DESCRIBE Distributions Distribution Fitting (Uncensored data) (Ajuste de distribución, datos sin censura) • • • En Data ponemos el nombre de la variable que queremos analizar. En la práctica se empezará con V1 y se continuará hasta V4 (el resto se dejan como tarea para la práctica del alumno). Por defecto, el programa proporciona un resumen numérico (Analysis Summary) y el gráfico de la estimación de la función de densidad (Density Trace). Se va a obtener también el resto de herramientas comentadas anteriormente. Para obtener los tests o contrastes de bondad de ajuste, se presiona el botón de opciones y se selecciona la opción de test de bondad de ajuste de tabla (tabular options) (Goodness-of-fit tests). También se van a obtener dos gráficos más. Se presiona el botón de opciones gráficas (graphical options) y se seleccionan el histograma y el QQ-plot. A continuación se estudian todos los análisis para determinar el (los) modelo(s) más adecuados para esta variable. La figura 9 recoge el resumen del análisis (Analysis Summary). Éste nos indica que la variable V1 es una muestra de 100 observaciones, con un mínimo de 3.68535 y un máximo de 3215.24. Nos informa que se le ha ajustado una distribución normal y que los valores estimados de los parámetros son de 801.838 para la media y de 742.109 para la desviación típica. 6 Analysis Summary Data variable: V1 100 values ranging from 3,68535 to 3215,24 Fitted normal distribution: mean = 801,838 standard deviation = 742,109 Figura 9. Resumen del análisis. El histograma de los datos se encuentra en la figura 10. Se observa una curva superpuesta a éste. Esa curva es la función de densidad correspondiente a una distribución normal con los parámetros que aparecen en la figura 9. Histogram for V1 frequency 40 30 20 10 0 -200 800 1800 2800 3800 V1 Figura 10. Histograma de V1 con densidad normal. También se puede observar una incongruencia con la naturaleza de los datos. ¡¡El límite inferior del primer intervalo es –200!! Dado que se dispone de datos de tiempos de vida, hay que corregir esto en el gráfico, hay que cambiar el límite inferior del gráfico. Esto se hace con el cursor sobre el gráfico, presionando el botón derecho y seleccionando opciones de panel (pane options). Aparece la ventana de la figura 11. La primera casilla nos muestra el número de clases o intervalos del histograma (debe variarse su valor para ver cómo va cambiando el histograma). La segunda y tercera casilla nos indica el límite inferior y superior del gráfico. En el límite inferior ponemos un cero, para conseguir un gráfico más consistente con los datos. Figura 11. Opciones de panel del histograma. 7 El nuevo gráfico es el correspondiente a la figura 12. Se observa claramente que la función de densidad normal no es adecuada para estos datos que, aparentemente, poseen una distribución exponencial. Histogram for V1 50 frequency 40 30 20 10 0 0 1 2 3 V1 4 (X 1000) Figura 12. Histograma de V1 corregido. La figura 13 contiene el gráfico de la función de densidad estimada (density trace). Este gráfico se interpreta como un histograma pero tiene la ventaja de tener un comportamiento suave y continuo. Density Trace for V1 (X 0,0001) 6 density 5 4 3 2 1 0 0 1 2 V1 3 4 (X 1000) Figura 13. Función de densidad estimada de V1 La curva obtenida sale por defecto muy suavizada. Para que se vea mejor la distribución de los datos hay que cambiar el parámetro Interval width (por defecto del 60%) que se encuentra en Pane options. Si modificamos este valor a 10% obtenemos la densidad de la figura 14. Ambas densidades nos muestran de nuevo la falta de ajuste de V1 con la distribución normal ya que los datos presentan una clara asimetría (hacia la derecha ó positiva) y la distribución normal es simétrica. 8 Density Trace for V1 (X 0,0001) 10 density 8 6 4 2 0 0 1 2 3 V1 4 (X 1000) Figura 14. Función de densidad estimada de V2 con ancho de banda del 10%. Por último el gráfico QQ-plot (figura 15) muestra una vez más que la distribución normal no es adecuada. Los puntos no están alineados sobre la recta y=x, por lo tanto debemos cambiar a otra distribución. Quantile-Quantile Plot (X 1000) 4 V1 3 2 1 0 0 1 2 3 Normal distribution 4 (X 1000) Figura 15. QQ-plot de V1 frente a distribución normal. Por último debemos confirmar mediante los contrastes de hipótesis lo que se ha venido concluyendo con los análisis gráficos: que la normal no es un buen modelo para estos datos. Antes de pasar a analizar la tabla de dichos contrastes hay que mencionar que cuando el número de observaciones es pequeño (menos de 30 datos) no es conveniente hacer uso de los contrastes. Los contrastes son útiles para conjuntos de datos de tamaño mayor que 30. En caso contrario la decisión de si nuestros datos pueden seguir un modelo determinado hay que tomarla de forma gráfica empleando en mayor medida el último gráfico mencionado, el QQ-plot. La siguiente figura (figura 16) muestra la tabla correspondiente al apartado Goodnessof-fit tests o tests de bondad de ajuste. Como se dijo en la parte de conceptos básicos hay que analizar los p-valores de los contrastes (valores sombreados en la figura 16). 9 Para el test de Chi-cuadrado se tiene un valor de 9.84e-10 a , para Kolmogorov 0.0149 y para los otros dos contrastes p-valores menores que 0.01. Por lo tanto, dados estos valores existen evidencias suficientes para decir con una elevada confianza que la variable V1 no sigue una distribución normal. Goodness-of-Fit Tests for V1 Chi-Square Test ---------------------------------------------------------------------------Lower Upper Observed Expected Limit Limit Frequency Frequency Chi-Square ---------------------------------------------------------------------------at or below -256,468 0 7,69 7,69 -256,468 44,829 5 7,69 0,94 44,829 255,41 19 7,69 16,62 255,41 429,0 16 7,69 8,97 429,0 584,116 11 7,69 1,42 584,116 730,18 9 7,69 0,22 730,18 873,496 6 7,69 0,37 873,496 1019,56 8 7,69 0,01 1019,56 1174,68 2 7,69 4,21 1174,68 1348,27 3 7,69 2,86 1348,27 1558,85 4 7,69 1,77 1558,85 1860,14 6 7,69 0,37 above 1860,14 11 7,69 1,42 ---------------------------------------------------------------------------Chi-Square = 46,9006 with 10 d.f. P-Value = 9,84404E-7 Estimated Kolmogorov statistic DPLUS = 0,156492 Estimated Kolmogorov statistic DMINUS = 0,14107 Estimated overall statistic DN = 0,156492 Approximate P-Value = 0,0149233 EDF Statistic Value Modified Form P-Value --------------------------------------------------------------------Kolmogorov-Smirnov D 0,156492 1,57666 <0.01* Anderson-Darling A^2 4,80867 4,84582 0,0000* --------------------------------------------------------------------*Indicates that the P-Value has been compared to tables of critical values specially constructed for fitting the currently selected distribution. Other P-values are based on general tables and may be very conservative. Figura 16. Tests de bondad de ajuste de V1 suponiendo distribución normal. Debemos probar con otras variables hasta encontrar modelos que puedan describir la variable V1. Para conseguirlo se presiona el botón derecho y se seleccionan las opciones de análisis (Analysis Options). Aparece la ventana de la figura 17. En ella aparecen numerosos modelos. Entre ellos cabe destacar dos grupos. Distribuciones de variables discretas y distribuciones de variables continuas (el caso de tiempos de vida). De entre las continuas, las más usadas en estudios de fiabilidad son: Exponencial, Gamma, Weibull, Lognormal y Erlang. En la práctica anterior se determinó que la tasa de fallos de V1 era constante, por lo tanto la posibilidad de que la exponencial sea un modelo adecuado es alta. Y, por lo comentado anteriormente, también la Weibull y la Gamma son buenas opciones (recordar que la exponencial es caso particular de ambas). Así pues se va a analizar el a Recordar que el resultado de este test puede ser diferente según la versión instalada de STATGRAPHICS 10 QQ-plot para V1 y estas tres distribuciones (exponencial: figura 18, Weibull: figura 19 y Gamma: figura 20) así como el p-valor para el contraste de Kolmogorov (tabla de la figura 21). Figura 17. Posibles modelos para ajustar. Quantile-Quantile Plot Quantile-Quantile Plot 3 3 V1 (X 1000) 4 V1 (X 1000) 4 2 2 1 1 0 0 0 1 2 3 0 4 (X 1000) exponential distribution 1 2 3 Weibull distribution Figura 18. Exponencial-V1. 4 (X 1000) Figura 19. Weibull-V1. Quantile-Quantile Plot (X 1000) 4 V1 3 2 1 0 0 1 2 3 gamma distribution 4 (X 1000) Figura 21. Gamma-V1. Distribución Exponencial Weibull Gamma Parámetros Estimados p-valor Kolmogorov Mean: 801.838 Shape: 1.045 Scale: 815.878 Shape: 1.058 Scale: 0.0013 0.91884 0.98327 0.98560 Figura 22. Tabla con los parámetros y p-valores de los tests para V1. Gráficamente se observan pocas diferencias entre los tres gráficos. A pesar de eso si se observa un mejor comportamiento en el correspondiente a la distribución exponencial, 11 ya que en los otros dos el punto de más valor está sensiblemente más alejado que en éste. El comportamiento para el resto de puntos es prácticamente igual. En cuanto a la tabla que contiene las estimaciones de los parámetros y los p-valores se observa que los tres modelos se ajustan muy bien. Para la variable V2 tenemos los siguientes resultados para el ajuste a las densidades exponencial, Weibull, Gamma y lognormal (figuras 23 a 26 respectivamente). Quantile-Quantile Plot Quantile-Quantile Plot 10 10 8 8 V2 (X 1000) 12 V2 (X 1000) 12 6 6 4 4 2 2 0 0 0 2 4 6 8 10 exponential distribution 12 (X 1000) 0 2 Figura 23. Exponencial-V2. 6 8 10 12 (X 1000) Figura 24. Weibull-V2. Quantile-Quantile Plot Quantile-Quantile Plot (X 1000) 12 10 10 8 8 V2 (X 1000) 12 V2 4 Weibull distribution 6 6 4 4 2 2 0 0 0 2 4 6 8 10 gamma distribution 12 (X 1000) Figura 25. Gamma-V2. Distribución Exponencial Weibull Gamma Lognormal 0 2 4 6 8 10 lognormal distribution 12 (X 1000) Figura 26. Lognormal-V2. Parámetros Estimados p-valor Kolmogorov Mean: 1315.63 Shape: 0.6669 Scale: 997.268 Shape: 0.542 Scale: 0.0004 Mean: 3157.64 Std. Dev.: 23882.6 0.00544 0.4486 0.1234 0.1446 Figura 27. Tabla con los parámetros y p-valores de los tests para V2. Gráficamente se tienen dos opciones por encima del resto, que son el modelo Weibull y el modelo Gamma. De entre los dos el mejor es el del modelo Weibull, ya que en el modelo Gamma el punto de mayor valor está más alejado y el comportamiento del resto de los puntos es prácticamente idéntico. En cuanto a los p-valores recogidos en la figura 27 el modelo que ofrece mayor p-valor es el Weibull, por lo tanto si debemos decir qué modelo es más parecido a estos datos elegiríamos sin duda a éste. 12 Para la variable V3 se tienen dos posibles modelos de nuevo: el Weibull y el Gamma. Las figuras 28 y 29 respectivamente contienen sus QQ-plot. Y la tabla de la figura 30 contiene los p-valores y los parámetros estimados para estos modelos. Quantile-Quantile Plot Quantile-Quantile Plot 4 4 3 3 V3 (X 10000) 5 V3 (X 10000) 5 2 1 2 1 0 0 0 1 2 3 4 5 (X 10000) Weibull distribution 0 1 Figura 28. Weibull-V3. Distribución Weibull 2 3 4 gamma distribution 5 (X 10000) Figura 29. Gamma-V3. Parámetros Estimados p-valor Kolmogorov Shape: 0.62 Scale: 1756.52 Shape: 0.49 Scale: 0.00019 Gamma 0.95 0.83 Figura 30. Tabla con los parámetros y p-valores de los tests para V3. Para V4 se tienen esencialmente dos posibilidades: Erlang y Weibull. A continuación se muestran los gráficos y la tabla que confirman dicha posibilidad. Quantile-Quantile Plot Quantile-Quantile Plot 1500 1500 1200 1200 V4 1800 V4 1800 900 900 600 600 300 300 0 0 0 300 600 900 1200 1500 1800 0 300 Weibull distribution Figura 31. Weibull-V4. Distribución Weibull Erlang 600 900 1200 1500 1800 Erlang distribution Figura 32. Erlang-V4. Parámetros Estimados p-valor Kolmogorov Shape: 1.5546 Scale: 707.938 Shape: 2 Scale: 0.0031 0.94 0.86 Figura 32. Tabla con los parámetros y p-valores de los tests para V4. Supongamos el modelo exponencial para la variable V1: DESCRIBE Distributions Distribution Fitting (Uncensored data) (En data poner V1) 13 Presionar el botón derecho y seleccionar Analysis Options. Elegir la distribución exponencial. ¿Cómo se puede saber cual es la supervivencia según este modelo estimado para la variable V1? ¿Cómo se puede obtener un valor crítico? (La definición de valor crítico es la misma que la de cuantil). Para obtener estos valores hay que presionar el botón de opciones de tabla seleccionar las opciones tail areas y critical values (figura 33). y Figura 33. Opciones de tabla. La opción de tail areas da como resultado el valor de la función de distribución en un determinado punto. Así pues si se desea conocer la supervivencia de la variable V1 según un modelo exponencial (ajustado a esos datos) para el instante 100, es decir, S(100), debemos obtener la función de distribución en dicho valor, ya que S(100)=1F(100). Para hacer esto hay que situar el cursor encima del panel de tail areas, presionar el boton derecho y elegir la opción pane options. Aparecerá una ventana con cinco casillas. En cada casilla se puede introducir un tiempo de interés. En este caso se pondrá 100 en una de ellas (figura 34) y se presionará el boton OK. Figura 34. Pane options de tail areas. El programa proporciona: “area below 100.0 =0.11725”, es decir, probabilidad de que el tiempo de vida del componente V1 sea menor que 100 (esto es P(T<t)=1-S(t)). Por lo tanto la supervivencia en este instante será: S(100)=1-0.11725=0.88275 (frente al 0.9 que se obtuvo en la práctica 1). ¿Cuál será la supervivencia en 101 según el modelo exponencial ajustado a V1? S(100)=1-0.11835=0.88165 (frente al 0.9 de la práctica 1). Una primera consecuencia de estimar un modelo si éste es adecuado, es que se dispone de tasa de fallos acumulada y función de supervivencia NO escalonada. Con los valores 14 obtenidos por medio de tail areas se pueden rehacer los cálculos de fiabilidad de los sistemas de la práctica 1. En cuanto a los valores críticos, la forma de obtenerlos es análoga. ¿Cuál es el valor de la variable para el que la supervivencia vale 0.45? Se pide el tiempo de fallo para el que S(x)=0.45, es decir, para que 1-F(x)=0.45, o lo que es lo mismo, para que F(x)=0.55. Para el panel de critical values se obtienen sus pane options y se introduce 0.55 en una de las casillas (figura 35). Obteniéndose que F-1(0.55)=640.274. Figura 35. Pane options de critical values. Simulación de variables aleatorias: En esta sección se va a aprender a simular muestras de variables aleatorias con el objetivo de realizar simulaciones de sistemas de componentes. Supongamos que se tienen cuatro componentes cuyas duraciones se distribuyen de la siguiente manera: • • • • C1: Weibull(2,750) C2: Weibull(0.7, 1500) C3: Exponencial(1000) C4: Exponencial(1300) Se van a generar para cada componente una muestra de 5000 observaciones que será empleada para simular los tiempos de fallo del primer sistema de la práctica anterior (figura 36). Figura 36. Sistema descompuesto en subsistemas. Se comenzará generando las muestras de los componentes C1 y C2: 15 DESCRIBE Distributions Probability Distributions Aparece una ventana de selección de modelo (figura 37). En ésta seleccionamos la opción Weibull. Figura 37. Selección de distribución. Por defecto el análisis muestra información para una Weibull(1,1). Así pues, lo primero que se debe hacer es poner los parámetros de las distribuciones de los componentes C1 y C2. Lo hacemos presionando el botón derecho y seleccionando las opciones de análisis (Analysis Options). Se pueden introducir hasta cinco pares de parámetros distintos. Se rellena la tabla como muestra la figura 38. Figura 38. Parámetros componentes C1 y C2. En el gráfico de la función de densidad aparecen ahora dos curvas, una para cada componente. En este análisis podemos obtener la tasa de fallos, la función de supervivencia y la de distribución (en la parte gráfica). Si se hace ha de obtenerse una curva creciente para la tasa de fallos del componente C1 y otra decreciente para el componente C2 (ver los valores del parámetro de forma). 16 Para generar números aleatorios se trabaja con las opciones numéricas, , seleccionando random numbers o números aleatorios. Las otras opciones son tail areas y critical values para esta distribución con estos parámetros (figura 39). Figura 39. Opciones de tabla de probability distributions. En el nuevo panel del análisis se informa que se han generado 100 números aleatorios de las distribuciones que se están analizando. Pero hay que cambiar el tamaño de la muestra. Eso se hace en pane options (botón derecho). Se introduce 5000 en la nueva ventana (figura 40). Figura 40. Tamaño muestral números aleatorios. Tan sólo falta guardar estas muestras en nuevas variables, cuyos nombres serán C1 y C2. Esto se hace presionando el botón en la figura 41. . Se rellena la nueva ventana como se indica Figura 41. Guardar aleatorios con nombre. El proceso se repite para los componentes C3 y C4. Los aleatorios los guardamos con esos mismos nombres. NOTA IMPORTANTE: Se están generando números aleatorios. Cada vez que se repita el proceso los números cambian y, por lo tanto, los cálculos de fiabilidad 17 también lo harán. Pero, al trabajar con muestras de un tamaño tan grande, si los cálculos son correctos, las variaciones serán muy pequeñas. Igual ocurre con los siguientes gráficos, de forma aproximada han de ser así, pero habrá detalles que varíen un poco. Una vez que se tienen la cuatro nuevas variables (de C1 a C4). Podemos obtener como se hizo en la práctica 1 los tiempos de fallo de esta muestra de 5000 sistemas que se ha obtenido. Entonces se puede obtener la tasa de fallos acumulada y saber si el sistema tiene tasa de fallos creciente, decreciente o constante. Nota: Recordar que había que generar nuevas columnas, de nombres: S12, S123 y S1234; con los siguientes textos: • • • Para S12: C1*(C1<C2)+C2*(C2<=C1) Para S123: C3*(S12<C3)+S12*(C3<=S12) Para S1234: C4*(C4<S123)+S123*(S123<=C4) cumulative hazard Estimated Cumulative Hazard Function 10 8 6 4 2 0 0 2 4 6 8 S1234 10 (X 1000) Figura 42. Tasa de fallos acumulada de S1234. Quantile-Quantile Plot (X 1000) 10 S1234 8 6 4 2 0 0 2 4 6 8 Weibull distribution 10 (X 1000) Figura 43. QQ-plot de S1234 y Weibull El gráfico de la tasa de fallos acumulada de S1234 ofrece indicios de que la tasa de fallos del sistema es aproximadamente constante (figura 42). De hecho el QQ-plot de esa variable para un modelo Weibull (figura 43) muestra que el modelo se ajusta bastante bien (confirmado también por los tests de hipótesis), teniendo un parámetro de forma casi igual a 1 (en la simulación realizada para esta práctica vale 1.09). Por último, la fiabilidad en el instante 100 para este sistema es aproximadamente de 0.9128 (en 18 otras simulaciones se obtendrán otros resultados pero cercanos a este). Debido a que esta probabilidad es menor que la que se obtuvo en la práctica 1, que fue de 0.92 (con el primer método, el que se ha usado aquí) y 0.905 (con el segundo método) se concluiría que para montar este sistema, los componentes usados en la práctica anterior se comportan prácticamente de la misma manera que los simulados aquí. Autoevaluación de la práctica: Se puede dar por superada esta práctica cuando tras su realización el alumno sea capaz de: • • • • • Encontrar el/los modelo/s más adecuado/s a un conjunto de observaciones Identificar cuando un modelo no es adecuado para un conjunto de observaciones Calcular supervivencias en cualquier instante para un modelo ajustado a unos datos y lo mismo para los valores críticos (probability distributions) Calcular supervivencias en cualquier instante para un modelo ajustado a unos datos y lo mismo para los valores críticos (distribution fitting) Generar números aleatorios y combinarlos para obtener simulaciones de sistemas de varios componentes 19