probabilidad condicional - División de Ciencias Básicas

Anuncio

1.5

PROBABILIDAD

CONDICIONAL

E

n gran número de problemas prácticos, los eventos de mayor interés son

aquellos cuya ocurrencia está condicionada a la ocurrencia de otro evento. De aquí que interese introducir el concepto de probabilidad condicional,

esto es, la probabilidad condicionada a que haya ocurrido o pudiese ocurrir

cierto evento.

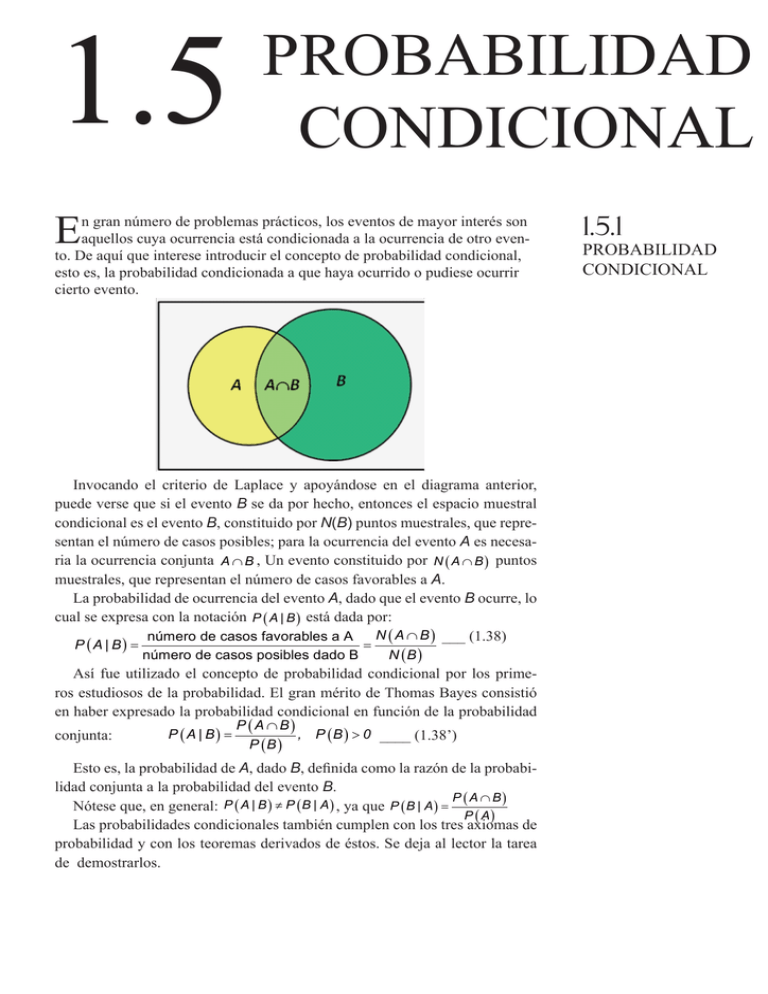

Invocando el criterio de Laplace y apoyándose en el diagrama anterior,

puede verse que si el evento B se da por hecho, entonces el espacio muestral

condicional es el evento B, constituido por N(B) puntos muestrales, que representan el número de casos posibles; para la ocurrencia del evento A es necesaria la ocurrencia conjunta A B , Un evento constituido por N A B puntos

muestrales, que representan el número de casos favorables a A.

La probabilidad de ocurrencia del evento A, dado que el evento B ocurre, lo

cual se expresa con la notación P A | B está dada por:

N A B ___ (1.38)

número de casos favorables a A

P A | B

número de casos posibles dado B

N B

Así fue utilizado el concepto de probabilidad condicional por los primeros estudiosos de la probabilidad. El gran mérito de Thomas Bayes consistió

en haber expresado la probabilidad condicional en función de la probabilidad

conjunta:

P A | B

P A B

, P B 0 ____ (1.38’)

P B

Esto es, la probabilidad de A, dado B, definida como la razón de la probabilidad conjunta a la probabilidad del evento B.

P A B

Nótese que, en general: P A | B P B | A , ya que P B | A

P A

Las probabilidades condicionales también cumplen con los tres axiomas de

probabilidad y con los teoremas derivados de éstos. Se deja al lector la tarea

de demostrarlos.

1.5.1

PROBABILIDAD

CONDICIONAL

144

PROBABILIDAD CONDICIONAL

1. No negatividad: P Ai | B 0

2. Normatividad: P S | B 1

3. Aditividad: P A B | C P A | C P B | C , A B

4. Probabilidad del complemento: P A | B 1 P A | B

5. Probabilidad del evento imposible: P | B 0

6. Ley de adición de probabilidades:

P A B | C P A | C P B | C P A B | C

Se denomina probabilidad marginal a la probabilidad de cualquier evento,

para distinguir que es incondicional, que no importa la ocurrencia de ningún

otro evento.

Ejemplo 1.54. SERVICIOS DE TELECOMUNICACIONES. Suponga que

es de interés conocer la probabilidad de que un usuario de Telex, que tiene señal de televisión satelital, tenga servicio ilimitado de larga distancia de cobertura nacional. El espacio muestral se reduce automáticamente, se condiciona

a la ocurrencia de un evento, se restringe a los usuarios que tienen televisión

satelital. Ahora bien, 1 de cada 5 usuarios tiene señal de televisión y 3 de cada

25 tiene tanto señal de televisión como larga distancia nacional, por lo que, por

cada 25 usuarios, habrá 5 que tengan señal de televisión y 3 de ellos también

tendrán servicio de larga distancia nacional; es decir, por cada 5 usuarios con

televisión satelital, habrá 3 con servicio de larga distancia nacional. Entonces,

la probabilidad de que un usuario tenga servicio de larga distancia nacional,

dado que tiene señal de televisión satelital, es 3/5.

Calcule las siguientes probabilidades de que un usuario de Telex:

a) Tenga señal de televisión satelital, dado que tiene Internet de banda ancha:

P T | I

P I T 0.10 1

0.333

P I

0.30 3

b) Tenga Internet de banda ancha, dado que tiene señal de televisión satelital:

P I | T

P I T 0.10 1

0.5

P T

0.20 2

c) No tenga Internet, dado que tiene señal de televisión satelital:

P I |T

P I T

P T

0.10 1 0.5

0.20

2

d) Tenga señal de televisión satelital, dado que no tiene servicio de larga distancia:

P T |L

P T L

P L

0

0

0.30

e) Tenga servicio de larga distancia, dado que tiene señal de televisión:

P L | T

P L T 0.20

1

P T

0.20

f) Tenga larga distancia o señal de televisión, dado que tiene Internet:

P L T | I P L | I P T | I P L T | I

P L I P T I P L T I 0.23 0.10 0.10 0.23

0.766

P I

P I

P I

0.30 0.30 0.30 0.30

14

PROBABILIDAD CONDICIONAL

Ejemplo 1.55. RÍOS CONTAMINADOS. Los desechos sólidos de la compañía papelera de Tuxtepec, Oax., contaminan eventualmente los ríos Tonto y

Papaloapan, con probabilidades de 2/5 y 3/4, respectivamente; además, se ha

observado que sólo en el 20% de los casos, ninguno de los dos ríos se contamina. El gerente quiere que se observe sistemáticamente sólo uno de los ríos

y a partir del comportamiento de éste, inferir el comportamiento del otro río.

¿Cuál de los dos ríos deberá observarse?

P T 0.40

Sean los eventos: T = {Tonto contaminado}

P = {Papaloapan contaminado} P P 0.75

P T P 0.20

Ninguno contaminado:

Para decidir cuál de los dos ríos conviene observar, es necesario calcular

las probabilidades condicionales del comportamiento de cada río, suponiendo

determinado comportamiento del otro río.

P T P 1 P T P 1 P T P 1 0.20 0.80

P T P P T P P P T P , 0.80 0.40 0.75 P T P

P T P 0.35, P T | P

P T | P 1 P T | P 1

P T P 0.35 7

0.466

P P

0.75 15

7

8

0.533

15 15

Si se observa primero el Papaloapan y resulta contaminado, el comportamiento del Tonto es muy dudoso.

P T |P

P T P

P P

P T P

1 P P

P T | P 1 P T | P 1

0.20

0.20 4

0.80

1 0.75 0.25 5

4 1

0.20

5 5

Si se observa el Papaloapan y no está contaminado, es muy probable que el

Tonto tampoco lo esté.

P P | T

P P T 0.35 7

0.875

P T

0.40 8

P P | T 1 P P | T 1

7 1

0.125

8 8

Si se observa primero el Tonto y resulta contaminado, es muy probable que

el Papaloapan también lo esté.

P P |T

P P T

P T

P P T

1 P T

P P |T 1 P P |T 1

0.20

0.20 1

0.333

1 0.40 0.60 3

1 2

0.666

3 3

Si se observa el Tonto y no está contaminado, es más probable que el Papaloapan esté contaminado a que no lo esté.

Podría concluirse entonces que sería más útil observar el río Papaloapan;

sin embargo, se están soslayando las consecuencias de cometer un error de

apreciación y que puede ser de dos tipos: suponer un río contaminado, cuando

no lo está, o suponer un río no contaminado cuando sí lo está.

146

PROBABILIDAD CONDICIONAL

Ley de multiplicación de probabilidades

En muchas ocasiones, las probabilidades condicionales están disponibles,

mientras que las incógnitas son las probabilidades conjuntas. Tal circunstancia

no implica dificultad alguna, porque la ecuación 1.57 se puede expresar como

un producto, dando por resultado la ley de multiplicación de probabilidades:

P A B P B P A | B

P A B P A P B | A

____ (1.39)

____ (1.39’)

Este resultado fue utilizado intuitivamente por todos los estudiosos de la

probabilidad en el siglo XVII, pero fue Abraham De Moivre quien habiendo

distinguido los sucesos dependientes y los independientes, luego formalizó el

teorema: “la probabilidad de que ocurran dos eventos dependientes es igual al

producto de la probabilidad de que ocurra el primero por la probabilidad de

que el otro ocurra cuando el primero ya ha ocurrido”

Ejemplo 1.56. ENTRONQUE VIADUCTO-PERIFÉRICO. Considere el

entronque Viaducto y Periférico, en el sentido sur-norte, conformado por los

tramos x, y, z, tal como se muestra en la figura

Se ha observado que los tramos x e y se congestionan con probabilidades

0.1 y 0.2, respectivamente, y que cuando el tramo y se congestiona, el tramo x

se congestiona con probabilidad 0.5. Considerando que los tres tramos tienen

la misma capacidad, con tres carriles, a una velocidad permisible de 80 km/h,

P x 0.1

Sean los eventos:

x = {tramo x saturado}

P y 0.2

y = {tramo y saturado}

P x | y 0.5

Calcule la probabilidad de que:

a) se saturen los tramos x e y:

P x y P y P x | y 0.2 0.5 0.1

b) se sature al menos uno de los tramos x o y:

P x y P x P y P x y 0.1 0.2 0.1 0.2

c) no se sature ni el tramo x ni el tramo y:

P x y P x y 1 P x y 1 0.2 0.8

Nótese que:

x y y;

xy x

xy

14

PROBABILIDAD CONDICIONAL

La regla de multiplicación de probabilidades puede generalizarse por inducción matemática a varios eventos y la expansión correspondiente es muy útil.

Sean los eventos A1, A2,…, An; su probabilidad de ocurrencia conjunta está

determinada por la denominada ley de multiplicación de probabilidades:

n

n i 1

P Ai P Ai Aj

i 1 i 1 j 1

1

1

Para i = 1: P Ai P Ai

i 1 i 1

Para i = 2:

2

2 1

P Ai P Ai Aj ,

i 1 i 1 j 1

0

A

j , P A1 P A1

j 1

P A1 A2 P A1 P A2 | A1

k

k i 1

Para i = k: suponiendo cierto que: P Ai P Ai Aj

i 1 i 1 j 1

Para i = k + 1:

k

k 0

k 1

k

P Ai P Ai Ak 1 P Ai Aj P Ak 1 Ai

i 1

i 1

i 1

i 1 j 1

k

P Ai | A1 A2 ... Ai 1 P Ak 1 | A1 A2 ... Ak

i 1

k 1

k 1

i 1

P Ai | A1 A2 ... Ai 1 P Ai Aj

i 1

i 1

j 1

La generalización de la ley de probabilidades para varios sucesos, De Moivre la explicó así: “Se necesita elegir uno de ellos como el primero, otro como

el segundo, y así. Luego, la ocurrencia del primero debe considerarse independiente de todas las demás; el segundo debe considerarse, con la condición

de que el primero ha ocurrido; el tercero con la condición de que tanto el

primero como el segundo han ocurrido, y así. De aquí, la probabilidad de

ocurrencia conjunta de todos los sucesos es igual al producto de todas las

probabilidades”

n

Existen n! fórmulas para obtener P Ai por ejemplo, si n = 3, cualquie i 1

ra de las siguientes 6 fórmulas nos permite obtener la probabilidad conjunta:

P A B C P A P B | A P C | A B

P A B C P A P C | A P B | A C

P A B C P B P A | B P C | A B

P A B C P B P C | B P A | B C

P A B C P C P A | C P B | A C

P A B C P C P A | C P B | A C

148

PROBABILIDAD CONDICIONAL

Ejemplo 1.57. ENTRONQUE VIADUCTO-PERIFÉRICO. Considere el

entronque Viaducto y Periférico, en el sentido sur-norte. Sabiendo que, cuando

los tramos x e y trabajan debajo de sus capacidades, la probabilidad de que el

tramo z se sature es de 0.20.

z = {tamo z saturado}

La información adicional es: P z | x y 0.20 ;

Previamente obtuvimos: P x y 0.1, P x y 0.2, P x y 0.8

Puesto que los tres tramos tienen las mismas capacidades, basta con que se

sature el tamo x o el tramo y, para que se sature el tramo z; por lo tanto:

P z | x y P z | x y P z | x y 1

Calcule la probabilidad de que:

a) se saturen los tres tramos:

P x y z P y P x | y P z | x y 0.2 0.5 1 0.1

b) se sature solamente el tramo z:

P xy z P x P y | x P z| xy

P x 1 P x 1 0.1 0.9;

P x y z 0.9

P y|x

P xy z P x P y | x P z| xy

P y x

P x

0.80 8 0.888

0.90

9

8

4

0.2

0.16

9

25

c) se sature solamente el tramo:

8 1

P y | x 1 P y | x 1 0.111

9 9

1

P x y z 0.9 0 0

9

P z | x y 1 P z | x y 1 1 0

d) no se sature ningún tramo:

P xy z P x P y | x P z| xy

P z | x y 1 P z | x y 1 0.2

P x y z 0.9

4

0.8

5

8 4 16

0.64

9 5 25

Ejemplo 1.58. DADO. Considere el experimento consistente en lanzar un

dado y observar la cara que queda hacia arriba. Sean los eventos: A = {cae

par}, B = {cae 2 o 4} y C = {cae 1 o 2}; las probabilidades correspondientes

son: P(A) = 1/2, P(B) = 1/3 y P(C) = 1/3.

Calcularemos las siguientes probabilidades condicionales, utilizando la interpretación clásica o a priori:

P A | B

N A B N cae 2 o 4

1

N B

N cae 2 o 4

P B | A

N A B N cae 2 o 4 2

N A

N cae par

3

P A | C

N A C

N cae 2

1

N C

N cae 1 o 2 2

P C | A

N A C

N cae 2

1

N A

N cae par 3

14

INDEPENDENCIA EN PROBABILIDAD

La ocurrencia de B afecta la probabilidad de ocurrencia de A: P A | B P A

y viceversa, la ocurrencia de A afecta la probabilidad de ocurrencia de B:

P B | A P B ; se dice entonces que los eventos A y B son estadísticamente

dependientes.

En contraparte, la ocurrencia de C no afecta la probabilidad de ocurrencia

, y viceversa, la ocurrencia de A no afecta la prode A: üüüü

; se dice entonces que los

babilidad de ocurrencia de C: üüüü

eventos A y C son estadísticamente independientes.

De Moivre discutió el concepto de independencia de sucesos aleatorios:

“Diremos que dos sucesos son independientes, si uno de ellos no tiene ninguna

relación con el otro”, e hizo lo propio para definir dependencia de sucesos:

“Dos sucesos son dependientes si están ligados el uno al otro y la probabilidad de ocurrencia de uno de ellos influye en la probabilidad de ocurrencia del

otro”

Cabe señalar, que la dependencia estadística entre eventos siempre tiene

una explicación física, siempre se pueden establecer relaciones causa efecto;

en el ejemplo anterior, los eventos A y B son físicamente dependientes, porque

la ocurrencia de uno de ellos hace más fácil la ocurrencia del otro. En cambio,

a la independencia estadística no siempre puede dársele un significado físico.

Considere las proposiciones lógicas siguientes:

p: A y B estadísticamente dependientes

~p: A y B estadísticamente independientes

q: A y B físicamente dependientes

~q: A y B físicamente independientes

Dependencia estadística implica dependencia física: p q ; en tanto que

dependencia física no implica dependencia estadística: q p

Independencia física implica independencia estadística: q p , en tanto que independencia estadística no implica independencia física: p q

Eventos estadísticamente independientes

Dos eventos son estadísticamente independientes, si y sólo si, la ocurrencia de

uno no afecta la probabilidad de ocurrencia del otro:

____ (1.40)

P A | B P A

____ (1.40’)

P B | A P B

Vemos que la independencia estadística es una relación simétrica: si el

evento A es independiente del evento B, entonces el B es independiente del A

y viceversa.

En efecto: P A B P A P B | A ; P A B P B P A | B

Igualando los segundos miembros: P A P B | A P B P A | B

Si P A | B P A P A P B | A P B P A , P B | A P B

Si P B | A P B P A P B P B P A | B , P A | B P A

Por lo tanto: P A | B P A P B | A P B

1.5.2

INDEPENDENCIA

EN PROBABILIDAD

150

PROBABILIDAD CONDICIONAL

Si P A B P A P B | A y P B | A P B P A B P A P B

Si P A B P B P A | B y P A | B P A P A B P B P A

Estos resultados corroboran la otra forma de definir formalmente independencia estadística: Dos eventos A y B son independientes si, y solo si, su probabilidad de ocurrencia conjunta es el producto de las probabilidades individuales P(A) y P(B) de ocurrencia:

____ (1.34)

üüüü

Esta expresión ya había sido obtenida en el apartado 1.4.3 para definir probabilidad conjunta de eventos independientes.

La dificultad en la aplicación de la ley de multiplicación de probabilidades

está en saber identificar cuándo dos eventos son o no independientes estadísticamente, y entonces usar la regla 1.34 o la regla 1.39, respectivamente.

Ejemplo 1.59 URNA. Considere una urna que contiene 6 bolas rojas, 4 blancas y 5 azules, de la que se extraen sucesivamente de la urna tres bolas, con

reemplazo.

P A 5 / 15 1 / 3

Sean los eventos: A = {sale bola azul}

B = {sale bola blanca} P B 4 / 15

P R 6 / 15 2 / 5

R = {sale bola roja}

Calcule las siguientes probabilidades:

a) Que salgan en el orden roja, azul, blanca:

P R A B P R P A | R P B | R A

6 5 4

120

8

15 15 15 3375 225

Después de haber salido una bola roja, ésta es devuelta a la urna, por lo que

sigue habiendo 15 bolas, 5 de las cuales son azules: P A | R 5 / 15 P A

Después de haber salido una bola azul, ésta es devuelta a la urna, por lo que sigue habiendo 15 bolas, 4 de las cuales son blancas: P B | R A 4 / 15 P B

b) Que salgan en el orden azul, roja azul:

P A R A P A P R | A P A | A R

5 6 5

150

2

15 15 15 3375 45

c) Que salgan tres bolas blancas:

P B B B P B P B | B P B | B B

4 4 4

64

15 15 15 3375

d) Que salgan una roja, una azul y una blanca, sin importar el orden:

8 16

P 1 roja, 1 azul y 1 blanca 6 P R A B 6

225 75

e) Que salgan dos azules y una roja:

2 2

P 2 azules y una roja 3

45 15

Vemos que cuando la extracción se hace con reemplazo, las probabilidades

de ocurrencia de eventos sucesivos no dependen, no están condicionadas a la

ocurrencia de eventos previos. La razón por la que las probabilidades se mantienen constantes, de extracción a extracción, es que físicamente las extracciones son independientes; en tal caso, los eventos son física y estadísticamente

independientes.

1

INDEPENDENCIA EN PROBABILIDAD

Ejemplo 1.60 URNA. Considere nuevamente la urna con 6 bolas rojas, 4

blancas y 5 azules, de la que se extraen sucesivamente tres bolas, sin reemplazo. Calcule las mismas probabilidades que las solicitadas en el ejemplo 1.59.

a) Que salgan en el orden roja, azul, blanca:

P R A B P R P A | R P B | R A

6 5 4

120

4

15 14 13 2730 91

Después de haber salido en primer lugar la bola roja, en la urna quedan 14

bolas, 5 de las cuales son azules: P A | R 5 / 14

Después de haber salido bola roja y bola azul, en la urna quedan 13 bolas,

4 de las cuales son blancas: üüüü

b) Que salgan en el orden azul, roja azul:

P A R A P A P R | A P A | A R

5 6 4

120

4

15 14 13 2730 91

c) Que salgan tres bolas blancas:

P B B B P B P B | B P B | B B

4 3 2

24

4

15 14 13 2730 455

d) Que salgan una roja, una azul y una blanca, sin importar el orden:

P 1 roja, 1 azul y 1 blanca

P R A B R B A A R B A B R B R A B A R

P R A B P R B A P A R B P A B R P B R A P B A R

4 24

6 P R A B 6

91 91

e) Que salgan dos azules y una roja:

4 12

P 2 azules y una roja 3 P A R A 3

91 91

Se aprecia que, cuando la extracción se hace sin reemplazo, las probabilidades de ocurrencia de eventos sucesivos se ven afectadas por la ocurrencia

de eventos previos, es decir, están condicionadas a esa ocurrencia. Después de

cada extracción, en la urna hay una bola menos, siendo ésta la causa principal

de que las probabilidades se alteren, en extracciones subsecuentes; en tal caso,

los eventos son física y estadísticamente dependientes.

Ejemplo 1.61. CIRCUITO ELÉCTRICO. Considere el circuito eléctrico

esquematizado en el diagrama siguiente. La probabilidad de que un interruptor

esté cerrado es p = 0.7 y se considera que los tres interruptores funcionan independientemente. Se trata de determinar la probabilidad de que fluya corriente

de la terminal 1 a la terminal 2.

La corriente fluye de la terminal 1 a la terminal 2, siempre que el interruptor

X esté cerrado, o que los interruptores Y y Z, ambos estén cerrados.

152

PROBABILIDAD CONDICIONAL

Lo resolveremos por tres procedimientos diferentes:

a) Considerando eventos mutuamente exclusivos:

Definimos el evento C = {corriente entre 1 y 2}, con dos posibles resultados

para cada interruptor: 1, cerrado, y 0, abierto.

P C P 1 1 1 1 1 0 1 0 1 0 1 1 1 0 0

P 1 1 1 P 1 1 0 P 1 0 1 P 0 1 1 P 1 0 0

P 1 3 P 1 P 0 P 1 P 0 p3 3 p2 1 p p 1 p

3

2

2

p3 3 p2 3 p3 p 1 2 p p2 p3 3 p2 3 p3 p 2 p2 p3

p3 p2 p 0.343 0.49 0.7 0.847

b) Considerando la ley de adición de probabilidades:

Definimos los eventos {x}, {y}, {z} como indicativos de que están cerrados

sendos interruptores.

P C P x y z P x P y z P x y z

P x P y P z P x P y P z p p2 p3

0.7 0.49 0.343 0.847

c) Considerando la regla del complemento:

P C P 0 1 0 0 0 1 0 0 0

P 0 1 0 P 0 0 1 P 0 0 0

2P 1 P 0 P 0 2 p 1 p 1 p

2 p 1 2 p p2 1 3 p 3 p2 p3

2

3

2

3

2 p 4 p2 2 p3 1 3 p 3 p2 p3 1 p3 p2 p

P C 1 P C 1 1 p3 p2 p p3 p2 p 0.847

Nótese la diferencia entre los circuitos de los ejemplos 1.53 y 1.61; en el

primero hay tres interruptores en paralelo y en este último son dos interruptores es serie con uno en paralelo. Ambos se analizan de manera similar, considerando independencia en el funcionamiento de los interruptores.

Ejemplo 1.62. FAMILIAS DE TRES HIJOS. Considere solo familias con

tres hijos y el experimento consistente en registrar el sexo de los hijos; si H =

{hombre}, M = {mujer}, con las probabilidades aceptadas: P(H) = 18/35 y

P(M) = 17/35.

El espacio muestral del experimento es:

S HHH , HHM , HMH , MHH , HMM , MHM , MMH , MMM

Las probabilidades de los cuatro diferentes puntos muestrales son:

3

Tres varones: P HHH P H P H P H 18 0.136

35

2

18 17

Dos varones: P HHM P H P H P M 0.128

35 35

2

18 17

Un varón: P HMM P H P M P M 0.121

35 35

1

INDEPENDENCIA EN PROBABILIDAD

Ningún varón: P MMM P M P M P M

3

17

0.115

35

Calcule las probabilidades de los siguientes eventos:

a) A = {familias con hijos de uno y otro sexo}

P A P HHM HMH MHH HMM MHM MMH

3P HHM 3P HMM 3 0.128 3 0.121 0.749

b) B = {familias con un máximo de un hijo varón}

P B P HMM MHM MMH MMM

3P HMM P MMM 3 0.121 0.115 0.479

c) La probabilidad conjunta de A y B

P A B P HMM MHM MMH 3 0.121 0.364

d) Determine si los eventos A y B son estadísticamente independientes.

Para establecer si los eventos A y B son estadísticamente independientes,

multiplicamos las probabilidades individuales y comparamos el resultado con

la probabilidad conjunta: P A P B 0.749 0.479 0.359 0.364 P A B

En virtud de que no hay coincidencia, concluimos que los eventos A y B

son estadísticamente dependientes, lo cual implica que debe existir una dependencia física entre ellos. Y efectivamente, la ocurrencia de uno favorece ligeramente la ocurrencia del otro, y eso ocurre porque la probabilidad de hijo varón

y de hija mujer no son simétricos. Si hubiéramos considerado equiprobabilidad

con P(H) = P(M) = 0.5, los resultados serían los siguientes:

P HHH P HHM P HMM P MMM 0.5 0.125

3

P A 6P HHM 6 0.125 0.75

P B 4P HMM 4 0.125 0.5

P A B 3P HMM 3 0.125 0.375

P A P B 0.75 0.5 0.375

y entonces, los eventos A y B serían independientes. Ahora sabemos que la

falta de simetría es la que provocó la dependencia, en este caso.

Ejemplo 1.63. CIRCUITO ELÉCTRICO. Sea el circuito mostrado en la

siguiente figura; los cuatro interruptores operan eléctricamente, cada uno tiene

un mecanismo de operación independiente y todos se controlan simultáneamente en el mismo impulso, esto es, se intenta que todos los interruptores

cierren o abran simultáneamente. Cada interruptor tiene, sin embargo, una probabilidad p de falla.

154

PROBABILIDAD CONDICIONAL

Sean los eventos: F = {falla el interruptor i}

N = {no falla el interruptor i}

C = {Hay corriente entre A y B}

El espacio muestral del experimento es:

NNNN , NNNF , NNFN , NFNN , FNNN , NNFF , NFNF , NFFN ,

FNNF , FNFN , NFNN , NFFF , FNFF , FFNF , FFFN , FFFF

Las probabilidades de los cinco diferentes puntos muestrales son:

Ninguna falla: P NNNN P N P N P N P N 1 p 4

3

Una falla: P NNNF P N P N P N P F 1 p p

Dos fallas: P NNFF P N P N P F P F 1 p p2

2

Tres fallas: P NFFF P N P F P F P F 1 p p3

Cuatro fallas: P FFFF P F P F P F P F p4

a) ¿Cuál es la probabilidad de que haya corriente entre las terminales A y B?

P C P NNNN NNNF NNFN NFNN FNNN NNFF FFNN

P NNNN 4P NNNF 2P NNFF 1 p 4 1 p p 2 1 p p2

4

3

2

1 4 p 6 p2 4 p3 p4 4 p 12 p2 12 p3 4 p4 2 p2 4 p3 2 p 4

1 4 p2 4 p3 p4

b) ¿Cuál es la probabilidad de falla del sistema?

P C 1 P C 1 1 4 p2 4 p3 p4 4 p2 4 p3 p4

c) ¿Mejoraría la operación del sistema la adición del conector 5?

Es obvio suponer que la adición del conector 5 mejoraría la operación del

sistema, es decir, la probabilidad de que haya corriente entre las terminales A

y B sería mayor si existe el conector 5, que si no existe.

Sea el evento K = {Hay corriente entre A y B, con conector 5}

NNNN NNNF NNFN NFNN FNNN

P K P

NNFF FFNN NFFN FNNF

P K P NNNN 4P NNNF 4P NNFF 1 p 4 1 p p 4 1 p p2

4

3

2

1 4 p 6 p2 4 p3 p4 4 p 12 p2 12 p3 4 p4 4 p2 8 p3 4 p 4

1 2 p2 p4

Debemos probar entonces que: 2 p 2 p 4 1 4 p 2 4 p 3 p

1 2 p2 p4 1 4 p2 4 p3 p4 0

2 p2 4 p3 2 p4 0, p2 2 p3 p4 0

p2 1 2 p p2 0, p2 1 p 0

2

p 0, p2 0, 1 p 0, 1 p 0

2

Efectivamente, el sistema es más eficiente con el conector 5 que sin él.

d) El espacio muestral cambia a:

1

INDEPENDENCIA EN PROBABILIDAD

NNNNN , NNNNF , NNNFN , NFNNN , FNNNN , NNNFF , NFNNF , NFNFN ,

FNNNF , FNNFN , NFNNN , NFNFF , FNNFF , FFNNF , FFNFN , FFNFF ,

S'

NNFNN , NNFNF , NNFFN , NFFNN , FNFNN , NNFFF , NFFNF , NFFFN ,

FNFNF , FNFFN , NFFNN , NFFFF , FNFFF , FFFNF , FFFFN , FFFFF

Sea el evento G = {Hay corriente entre A y B, con interruptor 5}

NNNNN NNNNF NNNFN NNFNN NFNNN FNNNN

P G NNNFF NNFNF NNFFN NFNFN FNNNF

FFNNN FNFNN NFFNN NNFFF FFFNN

P NNNNN 5P NNNNF 8P NNNFF 2P NNFFF

1 p 5 1 p p 8 1 p p2 2 1 p p3

5

4

3

2

1 5 p 10 p2 10 p3 5 p4 p5 5 p 20 p2 30 p3 20 p 4 5 p5

8 p2 24 p3 24 p4 8 p5 2 p3 4 p4 2 p5

1 2 p 2 2 p 3 5 p 4 2 p5

Se debe cumplir que: 1 2 p2 p4 1 2 p2 2 p3 5 p4 2 p5

1 2 p2 p4 1 2 p2 2 p3 5 p4 2 p5 0, 2 p3 4 p4 2 p5 0

2 p3 1 2 p p2 0,

p3 1 p 0,

2

p 0,

p3 0, 1 p 0,

1 p

2

0

También se debe cumplir: 1 2 p 2 p 5 p 2 p 1 4 p 4 p p4

2

3

4

5

2

3

1 2 p2 2 p3 5 p4 2 p5 1 4 p2 4 p3 p4 0, 2 p2 6 p3 6 p4 2 p5 0

2 p2 1 3 p 3 p2 p3 0,

p2 1 p 0,

3

p 0,

p2 0, 1 p 0,

1 p

3

0

e) Sea el evento D = {fallan exactamente 2 interruptores}

P D P NNFF NFNF NFFN FNNF FNFN FFNN

6P NNFF 6 1 p p2

2

P C D P NFNF FNFN 2P NNFF 2 1 p

P C D P NFNF FNFN 2P NNFF 2 1 p p2

2

2

p2

Nótese que a través de una función polinomial se establece el modelo probabilístico indicativo del comportamiento del sistema, bajo determinadas circunstancias: con 4 o 5 interruptores, con un conector adicional, etc. Mediante

el trazo de las curvas polinomiales es posible hacer un análisis de sensibilidad

del circuito para distintos valores de p.

156

PROBABILIDAD CONDICIONAL

Aunque generalmente la independencia mutua parece prácticamente asegurada si los eventos son independientes por pares:

P Ai Aj P Ai P Aj , i j , i 1,n en algunos casos, esta independencia no es suficiente para garantizar la independencia mutua.

Ejemplo 1.64. TETRAEDRO. Si en lugar de lanzar un dado, se lanza un tetraedro, cuyas caras están numeradas del 1 al 4, definimos los eventos:

A = {1, 2}, B = {1, 3}, C = {1, 4}, las probabilidades correspondientes son:

P(A) = 1/2, P(B) = 1/2, P(C) = 1/2. Ahora, utilizando el criterio de Laplace,

calculamos las siguientes probabilidades conjuntas:

N A B 1

N

4

N B C 1

P B C

N

4

P A B

N A C 1

N

4

N A B C 1

P A B C

N

4

P A C

Vemos que los eventos A, B y C son independientes por pares, pues:

1 1 1

2 2 4

1 1 1

P B C P B P C

2 2 4

P A B P A P B

P A C P A P C

1 1 1

2 2 4

Sin embargo, A, B y C no son mutuamente independientes, ya que:

P A B C P A P B P C

1.5.3

CONDICIONALIDAD

EN IMÁGENES

L

1 1 1 1 1

2 2 2 8 4

a probabilidad condicional se define como un cociente y, como tal, no

tiene problema alguno desde la perspectiva matemática; sin embargo, si

presenta serias dificultades conceptuales en su aplicación, las cuales conviene

identificar, distinguir qué circunstancias las provocan y solventarlas totalmente, a efecto de que el aprendizaje del tema sea significativo.

Cuando las personas empiezan a tratar con el concepto de condicionalidad, comúnmente lo confunden con el de causalidad, porque les cuesta mucho

trabajo aceptar que la ocurrencia de un evento posterior pueda condicionar

la ocurrencia de un evento previo. En el numerador del cociente que define

la probabilidad condicional P(A|B), aparece la probabilidad de la ocurrencia

conjunta P( A B ), que no expresa ocurrencia simultánea; el evento A puede

ocurrir 10 millones de años después que el evento B, 15 segundos antes, o al

mismo tiempo; ahí empieza la dificultad, y la mejor manera de solventarla es

desligando la variable tiempo de la ocurrencia de los eventos. Así, cuando se

hable de la probabilidad condicional de un evento A, dada la ocurrencia del

evento B, no se debe entender que el evento A habrá de ocurrir necesariamente

posterior al evento B. Más aún, en muchas ocasiones, aunque los dos eventos

hayan ocurrido, sin importar el orden temporal de ocurrencia, se pueden medir

ambas probabilidades condicionales, P(A|B) y P(B|A).

La segunda dificultad es de naturaleza práctica y se refiere a la complejidad

en la distinción de los eventos condicionados y condicionantes, con problemáticas inmersas en contextos muy diversos. La propuesta para resolver esto

es recurrir a la retroalimentación, que permita aclarar dudas, contextualizar el

problema y así poder plantearlo sin equívocos.

1

CONDICIONALIDAD EN IMÁGENES

Finalmente, la tercera dificultad proviene de lo variada que resulta la información de que se dispone para enfrentar problemas de probabilidad condicional, pues es en función de ella, que se tiene que proceder. No se trata de establecer un algoritmo para cada caso, que conduzca a la búsqueda de la fórmula

correcta, sino de conocer la gama de posibilidades y reconocer los diferentes

caminos para resolverlos, sin soslayar información relevante.

Considerando únicamente dos eventos A y B correspondientes a un cierto

espacio de probabilidad, al tomar en cuenta los eventos complementarios Ac y

Bc, se pueden establecer ocho relaciones de probabilidad condicional, considerando todos los denominadores diferentes de cero.

P A | B

P A B

;

P B

P Ac | B

P A | Bc

P A | B

c

c

P Ac B

P B

P A B

c

P Bc

P B | A

;

P Bc | A

;

P B | Ac

P Ac B c

P Bc

P B A

P A

;

P B | A

c

c

P Bc A

P A

P B Ac

P Ac

P B c Ac

P Ac

Todo el conocimiento posible involucrado en esas 8 relaciones se resume

en 16 elementos: 8 probabilidades condicionales, 4 probabilidades conjuntas

y 4 probabilidades marginales, y significa que un problema de probabilidad

condicional ha quedado totalmente resuelto sólo cuando se han evaluados los

16 elementos.

Para resolver totalmente un problema de probabilidad condicional sólo se

requieren tres elementos no complementarios, siendo las 9 posibilidades las

siguientes:

• 1 marginal y 2 conjuntas

• 1 marginal y 2 condicionales

• 1 conjunta y 2 marginales

• 1 conjunta y 2 condicionales

• 1 marginal, 1 conjunta y 1 condicional

• 2 marginales y 1 conjunta

• 2 marginales y 1 condicional

• 2 conjuntas y 1 condicional

• 3 condicionales

Hasta aquí, los problemas de probabilidad condicional los hemos resuelto

de la manera usual, utilizando el álgebra para considerar de manera simultánea

tres reglas básicas: la probabilidad del complemento y las leyes de adición y de

multiplicación de probabilidades. Existen otros recursos visuales, que vale la

pena explorar; ellos son las tablas de doble entrada, los árboles de probabilidad

condicional y los diagramas de cuadrado unitario, todos ellos de fácil manejo,

muy útiles para entender claramente los conceptos y para visualizar todos los

resultados simultáneamente, aunque ninguno de ellos es autosuficiente para

enfrentar cualquier tipo de problema de probabilidad condicional.

158

PROBABILIDAD CONDICIONAL

Tablas de doble entrada

En primera instancia consideramos problemas de probabilidad condicional

que involucran únicamente dos eventos y sus respectivos complementos; para

éllos, el elemento base es una tabla de doble entrada o matriz de 2 x 2, que

contiene o debe contener la información de las 4 probabilidades conjuntas:

Esta tabla se complementa adicionándole una columna, en la que se obtienen las dos probabilidades marginales correspondiente a A y Ac, sumando las

probabilidades conjuntas de cada uno de los renglones; y adicionándole un

renglón, en el que se obtienen las dos probabilidades marginales correspondientes a B y Bc.

La tabla ampliada incorpora las ocho probabilidades condicionales, cuatro

en dos columnas adicionales y las otras cuatro en do renglones adicionales.

Ejemplo 1.65. RÍOS CONTAMINADOS. Con referencia al ejemplo 1.55,

c

c

los datos del problema son: P(T) = 2/5, P(P) = 3/4, P T P = 0.20

1

CONDICIONALIDAD EN IMÁGENES

Las tablas de doble entrada son fáciles de manipular y facilitan los cálculos,

pero no son la panacea, pues cuando los datos disponibles son 3 condicionales

o bien 2 condicionales y 1 marginal, no se relacionadas, es necesario salirse

de la tabla y recurrir al álgebra para obtener al menos 1 probabilidad conjunta,

para luego continuar en la tabla y concluir el ejercicio. Como tarea para el

lector quedan los dos casos siguientes, con otros datos del problema:

a) P(P) = 0.75, P(P|T) = 0.875, P(Pc|Tc) = 0.333

b) P(Tc|Pc) = 1/4, P(T|P) = 7/15, P(P|Tc) = 2/3

Árboles de probabilidades condicionales

Otra manera de visualizar las probabilidades condicionales en contexto, es

a través de diagramas de árbol, que por la información que contienen, son denominados árboles de probabilidad condicional.

Se construyen dos árboles de probabilidades, uno para cada evento básico.

El árbol correspondiente al evento A es un arreglo como el siguiente:

La herramienta es fácil de construir, bajo las siguientes reglas:

a) Las ramas que parten de un mismo nodo corresponden a eventos complementarios

b) En las dos ramas que parten del nodo inicial se anotan las probabilidades

marginales P(A) y P(Ac)

c) En las ramas que parten de los segundos nodos se anotan las probabilidades condicionales P(A|B), P(Ac|B), P(A|Bc) y P(Ac|Bc), siguiendo la secuencia de la rama previa.

El árbol ampliado con toda la información complementaria es el siguiente:

d) Al final de cada rama terminal se anota la probabilidad conjunta correspondiente al producto de la marginal y la condicional, anotadas sobre ramas

consecutivas, conforme a la ley de multiplicación de probabilidades:

P B A , P B c A , P B Ac y P B c Ac .

160

PROBABILIDAD CONDICIONAL

e) Al margen derecho del diagrama se anotan las probabilidades marginales

del otro evento básico y su complemento: P(B) y P(Bc), sumando las probabilidades conjuntas asociadas; la suma de estas dos marginales debe sumar 1 y

es la manera de corroborar operaciones aritméticas.

El árbol correspondiente al evento B se construye de manera idéntica, intercambiando A por B y la B por A.

Ejemplo 1.66. ENTRONQUE. Con referencia al ejemplo 1.56, los datos del

problema son: P(x) = 0.1, P(y) = 0.2, P x | y 0.5

Como ocurre con las tablas de doble entrada, los árboles de probabilidad

condicional son recursos muy visuales, fáciles de manejar, pero no son infalibles; si los datos del problema son 3 condicionales, 2 de ellas se ubican en

un árbol y la tercera en el otro, o si son 2 condicionales con 1 marginal o una

conjunta que no están en línea de secuencia, hay que abandonar los diagramas

y recurrir al álgebra, para obtener al menos otra probabilidad conjunta u otra

marginal, para luego retornar a los diagramas y concluir el ejercicio. Al lector

le quedan estos dos ejercicios, con diferentes datos del problema:

a) P(xc|y) = 1/2, P(y|x) = 1, P(yc|xc) = 8/9

b) P x c y c 0.8 , P(x|y) = 0.5 , P(yc|x) =0

1

CONDICIONALIDAD EN IMÁGENES

Diagramas de cuadrado unitario

La dependencia o independencia de eventos no se puede identificar mediante de un diagrama de Venn tradicional; los eventos A y B pueden ser dependiente en cualquiera de los tres siguientes diagramas, y pueden ser independientes sólo en el segundo, pero no necesariamente.

De hecho, los dos diagramas de los extremos representan los dos casos límite del caso general, simbolizado por el segundo diagrama: cuando no hay

ocurrencia conjunta y cuando hay ocurrencia implicada, en esos dos casos, la

dependencia entre los eventos es total.

En el primer diagrama, donde A y B son eventos mutuamente exclusivos,

si B ocurre, entonces la probabilidad de A es nula; y si A ocurre, entonces la

probabilidad de B es nula; por eso son dependientes.

En el tercer diagrama, donde la ocurrencia de A implica la ocurrencia de B,

si B ocurre, entonces la probabilidad de A es la probabilidad conjunta de A y B;

y si A ocurre, entonces la probabilidad de B es uno; por eso son dependientes.

Entonces, cuando hay incompatibilidad o continencia, se puede asegurar

que los eventos no son independientes. De hecho se trata del mismo tipo de

relación entre eventos, como se puede apreciar en los siguientes diagramas:

El caso general es donde cuesta trabajo dilucidar si los eventos son independientes o no, y un diagrama de Venn no ayuda en nada. Para visualizar probabilidades condicionales, proponemos el uso de diagramas de cuadrado unitario,

que son aplicables en todos los casos y se construyen como sigue:

a) El segmento unitario horizontal se particiona en dos subintervalos que

representan los dos eventos que se pueden dar por ocurridos, asignando a cada

longitud de subintervalo, la probabilidad del evento correspondiente: P(B) y

P(Bc).

b) Sobre cada uno de los dos subintervalos definidos hay un rectángulo de

altura unitaria, el cual se particiona en dos regiones; la inferior con una altura

igual a la probabilidad condicional P(A|•) y cuya área corresponde a la probabilidad conjunta P( A ), y la superior con altura igual a la probabilidad

condicional P(Ac|•), delimitada automáticamente por el valor uno y cuya área

corresponde a la probabilidad conjunta P( Ac ).

c) Se puede construir un diagrama cuadrado unitario equivalente, en el que

verticalmente se representan las probabilidades condicionales P(B|•) y P(Bc|•)

como alturas de dos regiones de los rectángulos formados sobre los subintervalos horizontales en los que se representan las probabilidades P(A) y P(Ac).

162

PROBABILIDAD CONDICIONAL

Ejemplo 1.67. DIAGRAMAS DE CUADRADO UNITARIO. Sean los

eventos A y B, cuyas probabilidades fijaremos en P(A) = 0.4 y P(B) = 0.5.

Para ilustrar el procedimiento de construcción de un diagrama de cuadrado

unitario consideraremos cinco casos representativos:

a) Los eventos A y B son mutuamente exclusivos:

AB

P A B 0

P A | B 0, P Ac | B 1, P A | B c

P B | A 1, P B c | A 0, P B | Ac

P A

P B

c

P B

P A

c

0.4

0.8, P Ac | B c 0.2

0.5

0.5

0.833, P B c | Ac 0.166

0.6

b) El evento A está contenido en el evento B.

AB

P A | Bc

AB A

P A

P B

c

P A 0.4

0.8, P Ac | B 0.2

P B 0.5

P A | B

P B 0.5

0

0, P Ac | B c 1, P B | A

1

0.5

P B 0.5

P B | A 0, P B | A

c

c

P B Ac

P A

c

0.1

0.166, P B c | Ac 0.833

0.6

c) P A B 0.1

P A P B 0.4 0.5 0.2 0.1

P A | B

eventos dependientes

P A B c 0.3

P A B 0.1

0.2, P Ac | B 0.8, P A | B c

0.6

P B

0.5

0.5

P Bc

1

CONDICIONALIDAD EN IMÁGENES

P Ac | B c 0.4, P B | A

P B | A

c

P B Ac

P A

c

0.1

0.25, P B c | A 0.75

0.4

0.4

0.666, P B c | Ac 0.333

0.6

d) P A B 0.2

P A P B 0.4 0.5 0.2 P A B

P A | B

P B | A

eventos independientes

P A B c 0.2

P A B 0.2

0.4, P Ac | B 0.6, P A | B c

0.4

P B

0.5

0.5

P Bc

P Ac | B c 0.6, P B | A

c

P B Ac

P A

c

0.2

0.5, P B c | A 0.5

0.4

0.3

0.5, P B c | Ac 0.5

0.6

e) P A B 0.3

P A P B 0.4 0.5 0.2 0.3

P A | B

eventos dependientes

P A B c 0.1

P A B 0.3

0.6, P Ac | B 0.4, P A | B c

0.2

P B

0.5

0.5

P Bc

P Ac | B c 0.8, P B | A

P B | Ac

P B Ac

P A

c

0.3

0.75, P B c | A 0.25

0.4

0.2

0.333, P B c | Ac 0.666

0.6

164

PROBABILIDAD CONDICIONAL

La serie de diagramas de cuadrado unitario obtenidos en el ejercicio da pié

para distinguir no sólo los casos de dependencia o independencia de eventos,

sino también para identificar el tipo de relación que guardan los eventos entre

sí, cuando hay dependencia.

Considerando que los datos de partida fueron: P(A) = 0.4 y P(B) = 0.5,

que conllevan el producto P(A)P(B) = 0.2, en el siguiente cuadro resumen se

observan las conclusiones para diferentes valores de la probabilidad conjunta:

P(A

B)

P(A|B)

P(B|A)

0

0

0

0.1

0.2

0.25

la ocurrencia de uno desfavorece la ocurrencia del otro

0.2

0.4

0.5

eventos estadísticamente independientes

0.3

0.6

0.75

la ocurrencia de uno favorece la ocurrencia del otro

0.4

0.8

1

Relación

la ocurrencia de uno inhibe la ocurrencia del otro

la ocurrencia de uno obliga la ocurrencia del otro

De manera general: 0 P A B P A ; 0 P A B P B

Si P A B 0 A B

Si P A B P A A B, P B | A 1

Si P A B P B B A P A | B 1

Si P A B P A P B A B

Si P A B P A P B existe correlación positiva entre A y B

Si P A B P A P B existe correlación negativa entre A y B

La construcción de diagramas de cuadrado unitario se puede generalizar

muy fácilmente a cualquier número de eventos mutuamente exclusivos a incluir en el segmento unitario horizontal, con dos eventos complementarios a

considerar en el sentido vertical.

1

PROBABILIDAD TOTAL

onsidere una partición del espacio muestral , constituida por los eventos B1, B2,..., Bn que son mutuamente exclusivos y colectivamente exhaustivos. Un evento A cualquiera siempre se puede descomponer en los

eventos ( A B1 ), ( A B2 ),…, ( A Bn ), que son mutuamente exclusivos:

C

n

A A Bi

i 1

La probabilidad del evento A siempre puede expresarse como la suma de las

probabilidades de los eventos A Bi , i=1,2,…, n

n

P A P A Bi

____ (1.41)

i 1

Cada término puede expandirse conforme a la ley de multiplicación de probabilidades dada en (1.39), de manera que la ecuación (1.41) también puede

escribirse como:

n

P A P A | Bi P Bi ____ (1.42)

i 1

Este resultado se conoce como teorema de probabilidad total y representa la

expansión de la probabilidad de un evento en términos de sus probabilidades

condicionales, condicionadas sobre un conjunto de eventos mutuamente exclusivos y colectivamente exhaustivos.

En efecto:

n

P A P A B1 A B2 ... A Bn P A Bi

i 1

Pero Bi B j , i j por lo que: A Bi A B j , i j

n

Entonces: P A P A Bi

i 1

La probabilidad total obtenida a través de (1.41) o (1.42) es la probabilidad

marginal de A, es decir, es la probabilidad de ocurrencia de A, sin importar la

ocurrencia de cualquier otro evento.

1.5.4

TEOREMA DE

PROBABILIDAD

TOTAL

166

PROBABILIDAD CONDICIONAL

Hagamos ahora una pequeña transformación, renombrando las ocurrencias

conjuntas en la forma: Ci A Bi , de manera el evento A es la unión de n

n

eventos Ci mutuamente exclusivos: A Ci , Ci C j , i j , constitui 1

yendo una descomposición del evento A.

Por lo tanto, la probabilidad total del evento A es la suma de las probabilidades de los eventos Ci, lo cual replica el tercer axioma de probabilidad:

n

n

P A P Ci P Ci Ci C j , i j

i 1 i 1

Aunque no lo parecía, aquel que denominamos teorema de probabilidad

total en el capítulo 1.2 y que durante más de doscientos años fuera considerado

uno de los tres teoremas fundamentales de la probabilidad, es exactamente

el mismo que el tratado en este apartado, sólo que estaba presentado de otra

manera; con la adecuación realizada, se pudo ver claramente que se trata del

mismo concepto.

Ejemplo 1.68. URNAS. Se tienen tres urnas que contienen 24 bolas cada una.

La urna 1 tiene 16 bolas rojas y 8 blancas, la urna 2 tiene 20 bolas rojas y 4

blancas, y la urna 3 tiene 6 bolas rojas y 18 blancas. Se ha extraído una bola de

alguna de las urnas, ¿cuál es la probabilidad de que la bola sea blanca?

Cabe suponer cuatro soluciones: Si la bola salió de la urna 1, la probabilidad de que sea blanca es 1/3, porque hay 8 de 24 bolas, que son blancas. Si la

bola salió de la urna 2, la probabilidad de que sea blanca es 1/6, porque hay 4

de 24 bolas, que son blancas. Y si la bola salió de la urna 3, la probabilidad de

que sea blanca es 3/4, porque hay 18 de 24 bolas, que son blancas. Finalmente, si no sabemos de cuál de las tres urnas salió, entonces la probabilidad de

que sea blanca es 5/12, porque, en total, hay 30 de 72 bolas, que son blancas.

1

PROBABILIDAD TOTAL

¿Sería posible que las cuatro respuestas fueran correctas? Pues si suponemos que la bola salió de la urna 1, la respuesta correcta es la primera; es una

probabilidad condicional, condicionada a que la urna elegida haya sido la 1.

Se puede decir exactamente lo mismo, si suponemos la extracción de la urna

8

1

4 1

18 3

2, o de la 3: P B |1

, P B | 2

, P B | 3

24 3

24 6

24 4

La cuarta respuesta corresponde a una probabilidad no condicional, pues

aquí no hay necesidad de suponer nada; considerando que la urna elegida pudo

ser cualquiera de las tres, con igual probabilidad de 1/3, la probabilidad total

de que la bola sea blanca es: P B P B |1 P 1 P B | 2 P 2 P B | 3 P 3

1 1 1 1 3 1 1 1 1 4 2 9 15

5

3 3 6 3 4 3 9 18 4

36

36 12

Cuando se obtiene probabilidad total, el diagrama de cuadrado unitario se

puede simplificar omitiendo las probabilidades correspondientes a los complemetos, quedando únicamente una distribución de probabilidad:

Ejemplo 1.69. DEFECTUOSOS. Tres máquinas A, B y C producen, respectivamente, 50%, 30% y 20% del número total de artículos de una fábrica; los

porcentajes de desperfectos de producción de estas máquinas son, respectivamente, 4%, 2% y 3%. Existe interés en determinar cuál es el porcentaje de

artículos defectuosos en toda la fábrica.

Intuitivamente, tal porcentaje se puede obtener sumando los productos de

los porcentajes de producción de cada máquina por sus correspondientes porcentajes de desperfectos:

0.50 0.04 0.30 0.02 0.20 0.03 0.02 0.006 0.006 0.032

168

PROBABILIDAD CONDICIONAL

El porcentaje total de artículos defectuosos es de 3.2%

Formalmente: Sean los eventos:

A = {artículo producido por la máquina A}

B = {artículo producido por la máquina B}

C = {artículo producido por la máquina C}

D = {artículo defectuoso}

Con las siguientes probabilidades: P A 0.50, P D | A 0.04

P B 0.30, P D | B 0.02

P C 0.20, P D | C 0.03

P D P A P D | A P B P D | B P C P D | C

0.50 0.04 0.30 0.02 0.20 0.03 0.02 0.006 0.006 0.032

Nos damos cuenta que la manera en que resolvimos los problemas de probabilidad condicional fue aplicando intuitivamente el teorema de probabilidad

total, porque estuvimos tratando con eventos complementarios, y éstos son

mutuamente exclusivos y colectivamente exhaustivos:

A Ac B A B Ac

A Ac

B A B A B

c

P B P B A P B Ac P B | A P A P B | Ac P Ac

Ejemplo 1.70. ENTRONQUE. En el ejercicio del entronque Viaducto – Periférico, se desea obtener la probabilidad de que se sature el tramo z, usando el

teorema de probabilidad total.

Tomando los eventos: x y , x y , x y , x y , que son mutuamente exclusivos y colectivamente exhaustivos, calculamos la probabilidad

total: P z P z | x y P x y P z | x y P x y

P z | x y P x y P z | x y P x y

Y sustituyendo: P x y P x | y P y , P x y P x | y P y

P x y P x | y P y , P x y P x | y P y

1

PROBABILIDAD TOTAL

P z | x y P x | y P y P z | x y P x | y P y

P z P z | x y P x | y P y P z | x y P x | y P y

Los datos son:

P x 0.1, P y 0.2, P x | y 0.5, P z | x y 0.2

P z | x y P z | x y P z | x y 1, P x 0.9, P y 0.8

P x y 0.8

P x | y 1 P x | y 1 0.5 0.5; P x | y

1

0.8

P y

P x | y 1 P x | y 1 1 0

Ya se habían obtenido: P x y 0.1, P x y 0.8

P z 1 0.5 0.2 1 0 0.8 1 0.5 0.2 0.2 1 0.8

0.1 0 0.1 0.16 0.36

En un análisis más profundo, interesaría conocer la capacidad que debería

tener el tramo z para que la falla sea menos probable, tomando en cuenta el

costo social y el costo de la obra.

Ejemplo 1.71. CIRCUITO ELÉCTRICO. Considerando el conector 5, la

probabilidad de que haya corriente entre las terminales A y B se puede obtener utilizando el teorema de probabilidad total, considerando los 16 eventos

elementales del espacio muestral, que son mutuamente exclusivos y colectivamente exhaustivos.

P C P C | NNNN P NNNN P C | NNNF P NNNF ... P C | FFFF P FFFF

P C | NNNN P C | NNNF P C | NNFN P C | NFNN P C | FNNN 1

P C | NNFF P C | NFFN P C | FFNN P C | FNNF 1

P C | NFNF P C | FNFN 0

P C | NFFF P C | FNFF P C | FFNF P C | FFFN 0

P NNNN 1 p

4

P NNNF P NNFN P NFNN P FNNN p 1 p

3

P NNFF P NFFN P FFNN P FNNF P NFNF P FNFN p2 1 p

2

P NFFF P FNFF P FFNF P FFFN p3 1 p

P FFFF p4

P C 1 1 p 4 1 p 1 p 2 1 p2 1 p 4 0 p3 1 p 1 0 p4

4

3

1 p 4 p 1 p 2 p2 1 p

4

3

2

2

1 4 p 6 p2 4 p3 p4 4 p 12 p2 12 p3 4 p4 2 p2 4 p 3 2 p 4

1 4 p2 4 p3 p4

Este resultado coincide con el obtenido previamente, utilizando otras reglas

170

PROBABILIDAD CONDICIONAL

1.5.5

TEOREMA

DE BAYES

B

ajo los mismos supuestos establecidos para el teorema de probabilidad total, por definición de probabilidad condicional, la probabilidad de ocurren-

cia del evento B, dada la ocurrencia del evento Aj es: P B | Aj

P Aj B

P Aj

Y puesto que P B Aj P Aj P B | Aj P Aj B P B P Aj | B

, entonces: P Aj | B

P Aj B

P B

El numerador P Aj B representa un término de la ecuación 1.41, y puede ser reemplazado, como en la ecuación 1.42 por el producto P B | Aj P Aj

y en forma similar, el denominador puede ser reemplazado por la suma de tales

términos:

P Aj | B

P B | Aj P Aj

n

P B | Ai P Ai

, Aj ____ (1.43)

i 1

Este resultado es conocido como teorema de Bayes, el cual provee una regla

cuya validez es indiscutible para obtener, a partir de un conjunto de probabilidades a priori, asignadas objetiva o subjetivamente, un conjunto de probabilidades a posteriori, que permiten corroborar aquellas, si su asignación fue

objetiva, o permiten modificarlas y corregirlas, si su asignación fue subjetiva,

con fundamento en la evidencia de que un determinado evento ha ocurrido.

Cuando decimos: “dada la ocurrencia del evento B”, esto no se debe interpretar como que B es el resultado de un experimento determinístico, al suponer

que si ha ocurrido, entonces P(B) =1. La riqueza del español facilita expresar

la idea de una mejor manera, con la frase: “si el evento B ocurriera”.

Si bien la regla de Bayes parece una expresión complicada, sigue siendo en

esencia el mismo cociente que define probabilidad condicional, excepto que el

denominador, que corresponde a una probabilidad marginal, ahora está expandido conforme al teorema de probabilidad total. En esencia, el teorema invoca

únicamente dos leyes: adición y multiplicación de probabilidades.

17

TEOREMA DE BAYES

Revisemos con detenimiento el significado de los términos contenidos en la

denominada regla de Bayes:

• P(Ai) = Probabilidad a priori de ocurrencia del evento Ai

• P(B|Ai) = Probabilidad condicional de ocurrencia del evento B, dado que

el evento Ai ocurre. El evento Ai visto como la causa de ocurrencia del

evento B

• P(Ai|B) = Probabilidad condicional de ocurrencia del evento Ai, si es que

el evento B ocurriera. El evento B visto como el efecto de la ocurrencia del

evento Ai.

Tanto el teorema como la probabilidad subjetiva asociada a éste, siempre

han suscitado polémica. Las llamadas probabilidades a priori P(Ai) pueden

provenir de cualquiera de las interpretaciones de probabilidad: clásica, frecuentista o subjetiva; la objetividad en la asignación está condicionada, pues

sólo en los juegos de azar se puede invocar simetría y sólo disponiendo de

abundante información estadística es posible usar frecuencias relativas; en la

mayoría de los problemas reales, las llamadas probabilidades a priori han de

ser evaluadas subjetivamente, en el mejor de los casos con un criterio lógico.

En general, en el ámbito profesional, las probabilidades subjetivas no son

ocurrencias irresponsables de alguien; aunque no se basen en ningún cálculo

preciso, en general corresponden a evaluaciones razonables que realizan personas bien informadas y comprometidas, traduciéndolas en creencias; en el

teorema de Bayes, el término matemático para creencia se llama probabilidad

a priori, aquella que estaría cambiando permanentemente en función de nuevos

datos, siempre en el rango entre 0 y 1.

El conocimiento previo que tenemos de muchas cosas se basa en nuestras

creencias y suposiciones, influyendo en nuestra percepción; y nuestra percepción es más o menos sensible a la información en la medida en que ésta modifica nuestras creencias sobre el mundo. El teorema de Bayes permite fundir

las probabilidades subjetivas, a priori, con información experimental nueva,

para obtener unas segundas probabilidades revisadas o a posteriori. La regla

se puede aplicar iterativamente como un proceso de naturaleza secuencial y

adaptativa, que permite ir afinando las probabilidades a priori, a medida que se

va generando nueva evidencia.

El enfoque bayesiano ha sido útil en algunas estimaciones basadas en conocimiento subjetivo, pues el hecho de poder revisar tales estimaciones, en

congruencia con evidencia empírica adicional, abre nuevas formas de crear

conocimiento. La perspectiva bayesiana ha sido revolucionaria hasta el punto

de convertirse en el punto de vista mayoritario; la regla de Bayes es la fórmula

matemática de las creencias, la que mide qué tanto la nueva evidencia es capaz

de alterar las probabilidades a priori. Hoy en día es posible medir las creencias

de las personas y también medir los cambios de percepción producidos, luego

de recibir determinada información.

El teorema de Bayes se utiliza actualmente en una amplia variedad de problemas, que van desde la exploración petrolera fuera de costa, hasta la discriminación del “spam” en sistemas de correo electrónico.

172

PROBABILIDAD CONDICIONAL

El nombre del teorema honra la memoria de Thomas Bayes; sin embargo,

ahora se sabe que él sólo participó marginalmente en su expresión, pues hay

evidencia que nunca estuvo en condiciones de hacer formulaciones a partir de

probabilidades totales. El primero que lo enunció fue Abraham De Moivre,

pero quien realmente lo desarrolló fue Laplace, quien en 1812 expresó: “Sea A

un suceso que ocurre en conjunción con uno y sólo uno de los n sucesos disjuntos B1, B2,…, Bn. Si se sabe que el suceso A ha ocurrido, ¿cuál es la probabilidad de que el suceso Bj también? La probabilidad de existencia de una de

esas causas es igual a una fracción con un numerador igual a la probabilidad

del suceso que se sigue de esta causa y un denominador que es la suma de las

probabilidades similares relativas a todas las posibles causas”.

Ejemplo 1.72. URNAS. Como continuación del ejemplo 1.68, considere que

de alguna de las tres urnas se extrajo una bola que resultó ser blanca, ahora interesa calcular la probabilidad de que la urna elegida haya sido la 1, la 2 o la 3.

Probabilidades a priori, clásicas: P 1 1 / 3, P 2 1 / 3, P 3 1 / 3

P B |1 1 / 3, P B | 2 1 / 6, P B | 3 3 / 4

Ya se había calculado: P B 5 / 12, P R 7 / 12

a) Que haya sido la 1: P 1 | B

b) Que haya sido la 2: P 2 | B

c) Que haya sido la 3: P 3 | B

P B |1 P 1 1 / 3 1 / 3 4

0.266

P B

5 / 12

15

P B | 2 P 2 1 / 6 1 / 3 2

0.133

P B

5 / 12

15

P B | 3 P 3 3 / 4 1 / 3 3

0.6

P B

5 / 12

5

Ejemplo 1.73. DEFECTUOSOS. De los artículos producidos por tres diferentes máquinas, suponga que se ha elegido aleatoriamente un artículo y éste

ha resultado defectuoso; calcule la probabilidad de que provenga de la máquina A, de la B o de la C.

Probabilidades frecuentistas: P A 0.50, P B 0.30, P C 0.20

P D | A 0.04, P D | B 0.02, P D | C 0.03

Ya se había calculado: P D 0.032, P Dc 0.968

a) Que provenga de la A:

P A | D

P D | A P A 0.04 0.50

0.02

5

0.625

P D

0.032

0.032 8

b) Que provenga de la B:

P B | D

P D | B P B 0.02 0.30 0.006 3

0.1875

P D

0.032

0.032 16

c) Que provenga de la C:

P C | D

P D | C P C 0.03 0.20 0.006 3

0.1875

P D

0.032

0.032 16

17

TEOREMA DE BAYES

Ejemplo 1.74. ENTRONQUE. Para el caso del entronque Viaducto – Periférico, calcularemos algunas probabilidades condicionales.

Se tenían ya: P x 0.1, P y 0.2, P x | y 0.5, P z | x y 0.2

P x y 0.1, P x y 0.8, P z | x y P z | x y P z | x y 1

P x 0.9, P y 0.8, P x | y 0.5, P x | y 1, P x | y 0, P z 0.36

Suponiendo que el tramo z se satura:

a) Probabilidad de que los tramos x e y también se saturen:

P x y | z

P z | x y P x y P z | x y P x | y P y 1 0.5 0.2 5

P z

P z

0.36

18

b) Probabilidad de que se sature el tramo x, pero no el tramo y:

P xy |z

1 0 0.8 0

P z|xy P x|y P y

P z

0.36

c) Probabilidad de que se sature el tramo y, pero no el x,:

P xy |z

P z | x y P x | y P y

P z

1 0.5 0.2 5

0.36

18

d) Probabilidad de que no se sature ni el tramo x ni el tramo y:

P xy |z

0.2 1 0.8 4

P z|xy P x|y P y

P z

0.36

9

Suponiendo que el tramo z no se satura, calcularemos primero:

P z | x y P z | x y P z | x y 0

P z | x y 1 P z | x y 1 0.2 0.8

e) Probabilidad de que los tramos x e y si se saturen:

P xy |z

P z | x y P x | y P y

P z

0 0.5 0.2

0

0.64

f) Probabilidad de que se sature el tramo x, pero no el y:

P xy |z 0

g) Probabilidad de que se sature el tramo y, pero no el x:

P xy |z 0

h) no se sature ninguno de los dos tramos.

P xy |z

P z

0.8 1 0.8 1

P z|xy P x|y P y

0.64

Ejemplo 1.75. CIRCUITO ELÉCTRICO. Considerando el conector 5, y la

probabilidad p asignada empíricamente; dado que hay corriente entre las terminales A y B, calcule las siguientes probabilidades:

a) De esté cerrado el primer interruptor:

P N1 | C P NNNN NNNF NNFN NFNN

NNFF NFNF NFFN NFFF | C

174

PROBABILIDAD CONDICIONAL

P NNNN | C P NNNF | C P NNFN | C P NFNN | C

P NNFF | C P NFNF | C P NFFN | C P NFFF | C

P NNNN | C P NNNN

P C

P NNNF | C P NNNF

P C

P NNFN | C P NNFN

P NFNN | C P NFNN

P NNFF | C P NNFF

P NFNF | C P NFNF

P NFFN | C P NFFN

P NFFF | C P NFFF

P C

P C

P C

P C

P C

P C

1 1 p 3 1 p 1 p 2 1 p2 1 p 0

1 4 p2 4 p3 p4

1 4 p 6 p2 4 p3 p4 3 p 9p2 9p3 p4 2 p2 4 p3 p4

1 4 p2 4 p3 p4

4

3

2

1 p p2 p3

1 4 p2 4 p3 p4

b) De que estén cerrados los interruptores 1 y 4:

P N1N4 | C P NNNN NNFN NFNN NFFN | C

P NNNN | C P NNFN | C P NFNN | C P NFFN | C

P NNNN | C P NNNN

P C

P NFNN | C P NFNN

P C

P NNFN | C P NNFN

P C

P NFFN | C P NFFN

P C

1 1 p 2 1 p 1 p 1 p2 1 p

1 4 p2 4 p3 p4

4

3

2

1 4 p 6 p2 4 p3 p4 2 p 6 p2 6 p3 2 p4 p2 2 p3 p4

1 4 p2 4 p3 p4

1 2 p p2

1 4 p2 4 p3 p4

c) De que estén abiertos los interruptores 1 y 4:

P F1F4 | C P FFFF FFNF FNFF FNNF | C

P FFFF | C P FFNF | C P FNFF | C P FNNF | C

P FFFF | C P FFFF

P C

P FNFF | C P FNFF

P C

P FFNF | C P FFNF

P C

P FNNF | C P FNNF

P C

0 p4 2 0 p3 1 p 1 p2 1 p

p2 2 p3 p4

1 4 p2 4 p3 p4

1 4 p2 4 p3 p4

2

17

TEOREMA DE BAYES

d) De que estén cerrados los cuatro interruptores:

P NNNN | C

P FFFF | C P FFFF

P C

1 1 p

1 4 p 6 p2 4 p3 p4

1 4 p2 4 p3 p4

1 4 p2 4 p3 p4

4

Árboles de probabilidades a priori y a posteriori

Una manera gráfica de visualizar la aplicación de los teoremas de probabilidad total y de Bayes, es a través de los árboles de probabilidad condicional,

ahora en forma generalizada.

Las reglas para su construcción son prácticamente las mismas que las que

se vieron previamente y aquí se puntualizan. A partir de probabilidades marginales a priori, P(Ai) de los eventos A1, A2,…, An, mutuamente exclusivos y

colectivamente exhaustivos, y de las probabilidades condicionales asociadas

con ellos: P(B|Ai), se puede construir un diagrama que se denomina árbol de

probabilidades a priori:

De acuerdo con las siguientes reglas:

a) La suma de las probabilidades de los eventos correspondientes a ramas

que parten de un mismo nodo debe ser 1, lo cual implica que tales eventos deben ser mutuamente exclusivos y colectivamente exhaustivos.

b) Hay n ramas que parten del nodo inicial, en las que se anotan sendas

probabilidades marginales a priori conocidas de los n eventos A1, A2,…, An,

mutuamente exclusivos y colectivamente exhaustivos.

c) Hay dos ramas que parten de los n segundos nodos, en los que se anotan,

respectivamente, las probabilidades condicionales: P(B|Ai), que es conocida,

y P(Bc|Ai), que es calculada por complemento; estas dos probabilidades correspondientes al nodo i, i=1,2,…, n, deben sumar 1, pues se trata de eventos

complementarios en el espacio muestral condicional Ai; dentro de este espacio,

tales eventos son mutuamente exclusivos y colectivamente exhaustivos.

d) Las probabilidades conjuntas P B Ai y P B c Ai se anotan como

valores terminales de las ramas del árbol, y se obtiene respectivamente de los

productos P(B|Ai)P(Ai) y P(Bc|Ai)P(Ai), cuyos valores aparecen sobre ramas

consecuentes en el árbol. Esta es la ley de multiplicación de probabilidades.

176

PROBABILIDAD CONDICIONAL

e) Las probabilidades marginales P(B) y P(Bc), se obtienen respectivamente de las sumas P(B|Ai)P(Ai) y P(Bc|Ai)P(Ai), cuyos términos aparecen alternadamente como valores terminales del árbol. Este es el teorema de probabilidad total.

f) Las probabilidades marginales P(B) y P(Bc) obviamente deben sumar 1;

esta es la mejor manera de corroborar operaciones aritméticas.

Luego, partiendo del árbol de probabilidades a priori, se construye el respectivo árbol de probabilidades a posteriori:

De acuerdo a las siguientes reglas:

g) La suma de las probabilidades de los eventos correspondientes a ramas

que parten de un mismo nodo debe ser 1, lo cual implica que tales eventos deben ser mutuamente exclusivos y colectivamente exhaustivos.

h) Hay dos ramas que parten del nodo inicial, en las que se anotan, respectivamente, las probabilidades marginales P(B) y P(Bc) calculadas a través del

teorema de probabilidad total; los eventos B y Bc son complementarios y, por

consiguiente, mutuamente exclusivos y colectivamente exhaustivos.

i) Hay n ramas que parten de los 2 segundos nodos, en los que deben aparecer sendas probabilidades condicionales a posteriori: P(Ai|B), para el nodo

correspondiente a B, y P(Ai|Bc), para el nodo correspondiente a Bc; no ha sido

calculado todavía el valor de estas probabilidades, solo se sabe que la suma

correspondiente a cada uno de los nodos debe ser 1, pues se trata de eventos

mutuamente exclusivos y colectivamente exhaustivos en los espacios condicionales B y Bc, respectivamente.

j) Las probabilidades conjuntas P Ai B y P Ai B c , que ya se habían

calculado a través de la ley de multiplicación de probabilidades, se anotan

como valores terminales de las ramas de este segundo árbol, sabiendo que corresponden a los productos P(Ai|B)P(B) y P(Ai|Bc)P(Bc), cuyos valores aparecen sobre ramas consecuentes en este segundo árbol.

k) Las probabilidades condicionales a posteriori desconocidas P(Ai|B) y

P(Ai|Bc), se obtienen, respectivamente, dividiendo el valor terminal P Ai B

entre la probabilidad marginal P(B), y dividiendo el valor terminal P Ai B c

entre la probabilidad marginal P(Bc). Esto es el teorema de Bayes.

17

TEOREMA DE BAYES

l) Las probabilidades marginales P(Ai), i = 1, 2,…, n, se obtienen respectivamente de las sumas P Ai B + P Ai B c , cuyos términos aparecen salteados, como valores terminales del árbol.

m) La suma de las probabilidades marginales P(Ai) obviamente debe sumar

1; esta es la mejor manera de corroborar operaciones aritméticas.

Arreglos matriciales

1. Las dos ecuaciones que relacionan las probabilidades de eventos complementarios: P A P Ac 1, P B P B c 1 , se pueden expresar mediante

el producto de la matriz de probabilidades individuales por un vector unitario y

P A

da por resultado un vector unitario:

P B

P Ac 1 1

c 1

P B 1

2. Las ecuaciones que relacionan las probabilidades conjuntas con probabilidades marginales corresponden al teorema de probabilidad total:

P A B P A B c P A , P Ac B P Ac B c P Ac

P B A P B Ac P B , P B c A

P B c Ac P B c

y se pueden expresar a través del producto de una matriz de probabilidades

conjuntas por un vector unitario y da por resultado un vector de probabilidades

marginales complementarias:

P A B P A B c 1 P A

P Ac B P Ac B c 1 P Ac

P B A P B Ac 1 P B

P B c A P B c Ac 1 P B c

Nótese que en el segundo sistema de ecuaciones la matriz de probabilidades

conjuntas es la traspuesta de la matriz de probabilidades conjuntas del primero.

3. Las ecuaciones que relacionan las probabilidades condicionales con las

probabilidades marginales de dos eventos, también corresponden al teorema

de probabilidad total, pero con cada término expandido como producto:

P A | B P B P A | Bc P Bc P A

P Ac | B P B P Ac | B c P B c P Ac

P B | A P A P B | Ac P Ac P B

P B c | A P A P B c | Ac P Ac P B c

y se puede expresar mediante el producto de una matriz cuyos elementos son

productos de condicionales por marginales, por un vector de probabilidades

marginales y da por resultado el otro vector de probabilidades marginales:

P A | B P A | Bc P B P A

P Ac | B P Ac | B c P B c P Ac

P B | A P B | Ac P A P B

P B c | A P B c | Ac P Ac P B c

178

PROBABILIDAD CONDICIONAL

Nótese que el primer sistema de ecuaciones está asociado al árbol de probabilidades a priori y el segundo sistema de ecuaciones está asociado al árbol de

probabilidades a posteriori.

Ejemplo 1.76. DEFECTUOSOS. Los datos estadísticos indican que las máquinas A, B y C producen, respectivamente, 50%, 30% y 20% del número

total de artículos de una fábrica; los porcentajes de desperfectos de producción

de estas máquinas son, respectivamente, 4%, 2% y 3%. Construya árboles de

probabilidad a priori y a posteriori, para visualizar la aplicación de los teoremas de probabilidad total y de Bayes, a la solución de este problema.

Árbol a priori:

Árbol a posteriori:

Y matricialmente:

0.04

0.96

0.02

0.96

0.6250

0.1875

0.1875

0.5

0.03

0.032

0.3

0.97

0.968

0.2

0.4959

0.5

0.032

0.3037

0.3

0.968

0.2004

0.2

17

TEOREMA DE BAYES

La construcción de árboles de probabilidades se puede generalizar para

cuando se tienen k conjuntos de eventos mutuamente exclusivos y colectivamente exhaustivos.

Ejemplo 1.77. ENTRONQUE. En el entronque Viaducto y Periférico se ha

observado que los tramos x e y se congestionan con probabilidades 0.1 y 0.2,

respectivamente, que cuando el tramo y se congestiona, el tramo x se congestiona con probabilidad 0.5, y que cuando los tramos x e y trabajan debajo de

sus capacidades, la probabilidad de que el tramo z se sature es de 0.2. Construya árboles de probabilidad a priori y a posteriori, para visualizar la aplicación

de los teoremas de probabilidad total y de Bayes, al resolver este problema.

Toda la información requerida ya ha sido calculada previamente y resumida

en el ejemplo 1.74, misma que ahora se vacía en los árboles de probabilidades.

Árbol a priori:

Árbol a posteriori:

180

PROBABILIDAD CONDICIONAL

Independencia condicional

Si A, B y C son tres eventos que pueden ocurrir conjuntamente, entonces se

dice que los eventos A y B son condicionalmente independientes dada la ocurrencia del evento C, con P(C) > 0, si al ocurrir C, la ocurrencia o no ocurrencia de A no aporta ninguna información sobre la probabilidad de ocurrencia de

B y la ocurrencia o no ocurrencia de B no aporta ninguna información sobre la

probabilidad de ocurrencia de A:

P A | B C P A | C , P B C 0

P B | A C P B | C , P A C 0

Cuando A y B son condicionalmente independientes dado C, se escribe:

A B | C , y otra definición alternativa equivalente es:

P A B | C P A | C P B | C

En otro caso, se dice que A y B son condicionalmente dependientes dado C

y se escribe: A B | C

La independencia estadística no implica independencia condicional y la independencia condicional no implica independencia estadística. De hecho, cuando

la independencia es condicional, si el evento C ocurre, los eventos A y B son

independientes y si C no ocurre, entonces A y B son dependientes.

En los problemas de diagnóstico lo que interesa es identificar la hipótesis

más probable de acuerdo a la evidencia disponible, y la regla de Bayes es la

fórmula de recurrencia que formaliza el hecho de que los grados de creencia se

pueden renovar, abriendo un camino inductivo al método científico para crear

nuevo conocimiento.

Así es que el teorema de Bayes se ha convertido en el procedimiento genérico que combina iterativamente diferentes fuentes de información y hace diagnósticos basados en relaciones causales. Las probabilidades directas del tipo

P(efecto|causa), denominadas probabilidades causales, suelen ser más fáciles

de obtener que las probabilidades inversas del tipo P(causa|efecto), llamadas

probabilidades de diagnosis. En general, el teorema permite pasar de unas a

otras fácilmente, pero a medida que se va incorporando información relativa

a más y más efectos, el problema puede hacerse inmanejable, incluso en computadoras muy poderosas. Y es que el número n de efectos considerados, hace

que el número de probabilidades causales a evaluar, crezca exponencialmente

a 2n+1, presentándolas en una sola tabla de doble entrada, con dos renglones y

2n columnas; con la dificultad adicional de tener que asignar probabilidades a

eventos que involucran n efectos simultáneamente.

1

TEOREMA DE BAYES

Las evidentes limitaciones prácticas en la aplicación de la regla de Bayes,

por cuanto al crecimiento en el número de efectos, provocaron que la mayoría de los investigadores de todo el mundo descartaran por mucho tiempo los

métodos basados en el enfoque bayesiano. Sólo hasta que se introdujo como

hipótesis la independencia condicional, fue que el teorema de Bayes recobró

vigencia; la propuesta supone que la probabilidad de ocurrencia de un efecto es

independiente de los demás efectos que no dependen directamente de él. El supuesto se justifica plenamente, porque en los fenómenos reales, cada efecto se

relaciona solamente con algunos otros efectos, y no se relaciona directamente

con todos los demás. Por eso es necesario que en cada diagnóstico, se discriminen los efectos que son o pueden ser considerados independientes entre

sí, en presencia de una causa, de aquellos otros que manifiestan dependencia

estadística.

Con esa información se construyen las llamadas redes probabilísticas bayesianas, que representan gráficamente el conjunto de relaciones entre causas y

efectos de cada problema; asociada a cada aspecto consignado en esa red, se

dispone de una pequeña tabla que contiene las probabilidades de ese aspecto,

dados las aspectos directamente relacionados con él; así, en vez de una gran

tabla de números que relacione todos los aspectos, se requiere un conjunto de

pequeñas tablas con unas cuantas probabilidades en cada una.

En la representación de una red bayesiana, la presencia de un enlace indica

dependencia causal, y la ausencia de un enlace indica, de manera implícita, su

independencia mutua; por ello, estas redes poseen un cierto grado de modularidad, que facilita el cálculo de probabilidades elementales conjuntas de n+1

dimensiones. Si una causa C tuviese n efectos Ei, todos ellos independientes

entre sí, el número de probabilidades a evaluar se reduciría a n+1 en vez de ser

2n+1: P C E1 E2 ... En P C

n

P E

i

| C

i 1

Para hacer la inferencia probabilística lo único que se requiere es conocer

las probabilidades causales de cada evento por separado y multiplicarlas entre

sí; por eso el problema se hace mucho más manejable. Si los n efectos fuesen

estadísticamente independientes, sería muy simple calcular las 2n+1 probabilidades condicionales combinadas, a través del producto de n probabilidades

condicionales simples; pero no es común que esto suceda.

Actualmente se desarrollan infinidad de sistemas de inteligencia artificial

capaces de enfrentar y resolver problemas grandes y complejos; ellos están

soportados por redes bayesianas de las que se extraen soluciones probabilísticas inductivas racionales. Con ellos se puede predecir el precio del petróleo,

predecir las fluctuaciones de la bolsa de valores, se pueden hacer diagnósticos

médicos a control remoto, diagnosticar las fallas en el funcionamiento de todo

tipo de red, se puede hacer la selección del mejor cultivo en una determinada

región o la determinación del mejor prospecto de localización para un pozo

petrolero exploratorio.