Tema 5.- Ortogonalidad y mejor aproximación.

Anuncio

Ingenierı́a Civil.

Matemáticas I. 2012-2013.

Departamento de Matemática Aplicada II.

Escuela Superior de Ingenieros. Universidad de Sevilla.

Tema 5.- Ortogonalidad y mejor aproximación.

5.1.- El producto escalar.

Norma, distancia, ángulos y ortogonalidad.

Desigualdades y teorema de Pitágoras.

5.2.- El complemento ortogonal de un subespacio.

5.3.- Bases ortogonales.

Bases ortogonales de un subespacio.

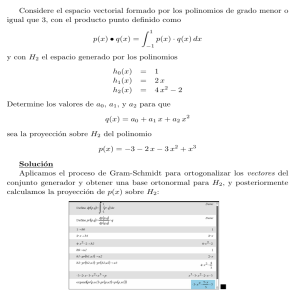

El método de Gram-Schmidt.

Matrices ortogonales.

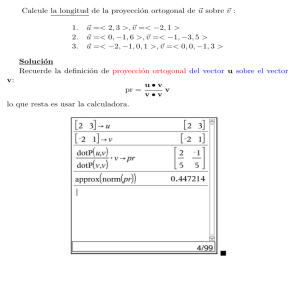

5.4.- La proyección ortogonal.

Proyección ortogonal sobre un subespacio.

El teorema de la mejor aproximación.

5.5.- Problemas de mı́nimos cuadrados. Ecuaciones normales de Gauss.

5.6.- Ejercicios.

Enunciados.

Soluciones.

En este tema estudiamos la estructura métrica de los espacios Rn , es decir, las cuestiones

relacionadas con distancias y ángulos con especial énfasis en la ortogonalidad entre vectores

y entre subespacios vectoriales. En el estudio de la resolución de sistemas de ecuaciones

lineales, el álgebra de matrices, etc., podı́amos considerar coeficientes reales o complejos de

manera indistinta sin afectar ni a los conceptos ni a los resultados. Aquı́ no sucede lo mismo.

El hecho de considerar vectores reales es esencial. Para poder considerar conceptos métricos

en los espacios Cn , de vectores de coordenadas complejas, habrı́a que considerar la definición

apropiada (coherente) de producto escalar de vectores complejos, que se suele denominar

producto hermı́tico y habrı́a que modificar el enunciado de algunas propiedades. Al aplicar

dicha definición, de vectores complejos, a vectores reales nos darı́a la definición usual que

vemos a continuación y que el alumno conoce en dimensiones dos y tres.

Además de considerar las definiciones y propiedades básicas estudiaremos algunos tipos de

matrices directamente relacionadas con la estructura metrica de los espacios de coordenadas

reales (matrices de proyección ortogonal sobre un subespacio, matrices ortogonales,...)

125

126

Tema 5.- Ortogonalidad y mejor aproximación.

5.1.- El producto escalar. Norma, distancia, ángulos y ortogonalidad.

El Producto escalar de dos vectores reales x, y ∈ Rn es el número real

x · y = x1 y1 + x2 y2 + · · · + xn yn ∈ R.

5.1.1.- Norma, distancia, ángulos y ortogonalidad.

Definiciones. Consideremos x, y ∈ Rn .

Se denomina Norma de un vector x ∈ Rn al número real no-negativo

q

√

||x|| = |x1 |2 + · · · + |xn |2 = x · x ≥ 0.

Se denomina Distancia entre dos vectores x, y ∈ Rn al número real no-negativo

d(x, y) = ||x − y|| .

Ortogonalidad.

(a) Se dice que dos vectores x, y ∈ Rn son ortogonales (x ⊥ y) si x · y = xT y = 0.

(b) Se dice que un conjunto de vectores {v1 , . . . , vm } de Rn es un conjunto ortogonal

si cada uno de los vectores vk es ortogonal a todos los demás,

vk · vj = 0, j 6= k.

(c) Se dice que un conjunto de vectores {v1 , . . . , vm } de Rn es un conjunto ortonormal si es un conjunto ortogonal y cada uno de los vectores vk tiene norma

uno,

vk · vj = 0, j 6= k; ||v1 || = · · · = ||vm || = 1.

Las propiedades del producto escalar, la norma, la distancia y la ortogonalidad son conocidas por el alumno para vectores en R2 y en R3 . En los espacios Rn , las propiedades son

esencialmente las mismas. Notemos que si considerasemos dichos conceptos de forma independiente de un sistema de referencia, en cada uno de ellos aparecen involucrados uno o dos

vectores. Algunas de las propiedades del producto escalar pueden obtenerse directamente

del hecho de que el producto escalar de dos vectores puede expresarse como un producto

matricial, vector-fila por vector-columna, x · y = xT y = y T x. Es inmediato comprobar que

se verifican las siguientes propiedades:

Propiedades.(1) El producto escalar es simétrico: x · y = y · x.

(2) El producto escalar es lineal en cada variable, es decir, siendo x, x′ , y, y ′ ∈ Rn y

α, β, λ, µ ∈ R,

(αx + βx′ ) · y = αx · y + βx′ · y,

x · (λy + µy ′) = λx · y + µx · y ′.

(3) ||x|| = 0 ⇐⇒ x = 0.

(4) ||αx|| = |α| ||x|| , ∀α ∈ R, x ∈ Rn .

Notemos que el producto escalar No es asociativo. Es decir, puede suceder que (x · y)z 6=

x(y · z). De hecho es lo más probable. Ejercicio. Busca un ejemplo e interpreta geométricamente el resultado.

Matemáticas I.

Ingenierı́a Civil

5.2.- El complemento ortogonal de un subespacio.

127

5.1.2.- Desigualdades y teorema de Pitágoras.

Teorema. Sean x, y ∈ Rn

(1) Desigualdad de Cauchy-Schwartz: |x · y| ≤ ||x|| ||y||.

(2) Desigualdad triangular: ||x + y|| ≤ ||x|| + ||y|| ( ||x − y|| ≤ ||x|| + ||y||)

(3) Teorema de Pitágoras: x ⊥ y ⇐⇒ ||x + y||2 = ||x||2 + ||y||2 .

El ángulo (los ángulos) determinado por dos vectores no-nulos x, y ∈ Rn puede caracterizarse (definirse) mediante la igualdad

x · y = ||x|| ||y|| cos(θ).

Los resultados clásicos de la geometrı́a métrica plana, como el Teorema del seno o el Teorema

del coseno, son válidos cuando consideramos vectores n−dimensionales.

5.2.- El complemento ortogonal de un subespacio.

Definición. (El complemento ortogonal de un subespacio) Dado un subespacio vectorial S

de Rn se denomina complemento ortogonal de S al conjunto

S ⊥ = {v ∈ Rn : v ⊥ u ∀u ∈ S} .

Es decir, S ⊥ está formado por todos los vectores que son ortogonales

a todos los vectores de

n o

S. Por tanto, el complemento ortogonal del subespacio nulo ~0 es Rn puesto que cualquier

vector es ortogonal al vector nulo. Por otra parte, el complemento ortogonal del espacio total

Rn es el subespacio nulo, puesto que el vector nulo (de Rn ) es el único que es ortogonal a

todos los vectores de Rn .

Ejemplos. Cuando se trabaja con el complemento ortogonal de un subespacio es conveniente tener presente cómo se puede caracterizar dicho complemento ortogonal cuando el

subespacio viene dado en forma paramétrica o cuando viene dado en forma implı́cita. En R2 ,

un subespacio vectorial de dimensión 1 es una recta que pasa por el origen y su complemento

ortogonal será (como es natural) la recta que pasa por el origen (es un subespacio vectorial)

y es perpendicular a la recta dada. En R3 , un subespacio vectorial de dimensión 1 es una

recta que pasa por el origen. Su complemento ortogonal será el plano que pasa por el origen

(es un subespacio vectorial) y es perpendicular a la recta dada. Un subespacio vectorial de

dimensión 2 es un plano que pasa por el origen. Su complemento ortogonal será la recta que

pasa por el origen (es un subespacio vectorial) y es perpendicular al plano dado.

(1) Consideremos un subespacio de dimensión 1 en R2 , dado en forma paramétrica, es decir,

una recta que pasa por el origen de coordenadas, dada por un vector dirección v1 . Por

ejemplo, para v1 = [2, −1]T

x1 = 2α

,

S = Gen {v1 } = {v = αv1 : α ∈ R} ≡

x2 = −α

Matemáticas I.

2012-2013

128

Tema 5.- Ortogonalidad y mejor aproximación.

su complemento ortogonal estará formado por los vectores v = [x1 , x2 ]T ∈ R2 que son

ortogonales a todos los vectores de la forma αv1 , α ∈ R

v ∈ S ⊥ ⇔ (αv1 ) · v = 0, ∀α ∈ R ⇐⇒ v1 · v = 0 ⇔ 2x1 − x2 = 0.

Es decir, el complemento ortogonal S ⊥ está formado por los vectores v = [x1 , x2 ]T ∈ R2

cuyas coordenadas verifican la ecuación 2x1 − x2 = 0. Por tanto, S ⊥ es un subespacio

vectorial (de dimensión 1) que viene dado en forma implı́cita y los coeficientes de la

ecuación implı́cita son las coordenadas del vector dirección de S. Si hubieramos considerado otro vector dirección de S (que será un múltiplo no-nulo de v1 ), habrı́amos

obtenido una ecuación equivalente.

(2) Si consideramos un subespacio vectorial S de dimensión 1 en Rn , es decir una recta que

pasa por el origen, generada por un vector no-nulo v1 ∈ Rn

a1

..

S = Gen v1 = .

an

su complemento ortogonal estará formado por los vectores v = [x1 , . . . , xn ]T ∈ Rn

cuyas coordenadas verifican la ecuación

v1 · v = 0 ≡ a1 x1 + · · · + an xn = 0

con lo cual S ⊥ es un subespacio vectorial (de dimensión n−1) que viene dado mediante

una ecuación implı́cita y los coeficientes de dicha ecuación son las coordenadas del

vector dirección de S.

Teorema. Sea S un subespacio vectorial de Rn .

(1) S ⊥ es un subespacio vectorial de Rn .

⊥

(2) S ⊥ = S.

(3) El vector nulo es el nico vector de Rn que pertenece a la interseccin de S con S ⊥ .

(4) Si S = Gen {v1 , . . . , vp }, entonces

v ∈ S ⊥ ⇐⇒ v ⊥ v1 , . . . , v ⊥ vp .

Ejemplo. Antes hemos obtenido el complemento ortogonal de un subespacio de Rn

de dimensión 1, que era un subespacio vectorial de dimensión n − 1 (estos subespacios se

suelen denominar hiperplanos). Las propiedades anteriores permiten obtener fácilmente el

complemento ortogonal de un subespacio de dimensión n − 1 dado en forma implı́cita

W ≡ a1 x1 + · · · + an xn = 0

(para que esta ecuación defina un subespacio de dimensión 1 alguno de los coeficientes

a1 , . . . , an tiene que ser no nulo). Puesto que, como vimos antes,

a1

..

⊥

W =S

siendo S = Gen .

a

n

Matemáticas I.

Ingenierı́a Civil

5.3.- Bases ortogonales.

tenemos que W ⊥ = S ⊥

paramétrica.

129

⊥

= S. Es decir, de manera inmediata obtenemos W ⊥ en forma

El hecho de expresar el complemento ortogonal de una u otra forma paramétrica/implı́cita

dependiendo de como venga expresado el subespacio vectorial:

S en forma paramétrica −→

S en forma implı́cita

−→

queda reflejado con el siguiente Teorema.

S ⊥ en forma implı́cita

S ⊥ en forma paramétrica

Teorema. (Los cuatro subespacios asociados a una matriz) Sea A una matriz real m × n.

Se verifica:

[Col (A)]⊥ = Nul (AT ),

[Nul (A)]⊥ = Col (AT ).

El espacio Col (AT ) se suele denominar espacio fila de la matriz A.

Notemos que en lo que se refiere a las dimensiones de los complementos ortogonales

tenemos

dim [Col (A)]⊥ = dim Nul (AT ) = m− pivotes de AT = m−rang (A) = m−dim (Col (A)) .

Puesto que cualquier subespacio vectorial se puede expresar como el espacio columna de una

matriz tenemos que para cualquier subespacio vectorial S de Rm se verifica

dim S ⊥ = m − dim (S).

5.3.- Bases ortogonales.

5.3.1.- Bases ortogonales de un subespacio.

Una base ortogonal de un subespacio vectorial S es una base de S formada por vectores

que son ortogonales dos a dos. Para calcular las coordenadas de un vector respecto de una

base genérica de S hay que resolver un sistema de ecuaciones lineales cuya soluci´’on son las

coordenadas del vector respecto de dicha base. Como veremos en la sección 6.4, la principal

ventaja, de tener una base ortogonal de un subespacio, es que el cálculo de las coordenadas

de un vector respecto de dicha base es particularmente sencillo y se tiene una fórmula para

dichas coordenadas (ver el desarrollo de Fourier). Una base ortonormal de un subespacio

vectorial es una base formada por vectores que son ortogonales dos a dos y unitarios (con

norma igual a 1).

Teorema. Si {v1 , v2 , . . . , vr } es un conjunto de vectores no-nulos ortogonales dos a dos,

entonces son linealmente independientes.

Cuando se tiene un conjunto ortogonal de vectores no-nulos y se normalizan (se divide

cada uno por su norma), obtenemos un conjunto ortonormal de vectores que formarán una

base ortonormal del subespacio vectorial que generan. Vamos a considerar ahora las propiedades de las matrices cuyas columnas son ortonormales. Más adelante veremos el caso

particular de las matrices cuadradas cuyas columnas son ortonormales.

Proposición. Sea U = [u1 , . . . , un ] una matriz real m × n.

Matemáticas I.

2012-2013

130

Tema 5.- Ortogonalidad y mejor aproximación.

(1) U tiene columnas ortonormales ⇐⇒ U T U = I.

(2) Si U tiene columnas ortonormales, entonces conserva ángulos y distancias. Es decir

(Ux) · (Uy) = x · y, ∀x, y ∈ Rn . En particular,

(a) ||Ux|| = ||x|| ,

∀x ∈ Rn .

(b) Ux ⊥ Uy ⇐⇒ x ⊥ y.

5.3.2.- El método de Gram-Schmidt.

En los temas anteriores hemos visto cómo obtener una base de un subespacio vectorial

a partir de un conjunto de vectores que genere dicho subespacio vectorial. El método de

ortogonalización de Gram-Schmidt, que vamos a describir, permite construir, de manera

progresiva, una base ortogonal de un subespacio vectorial a partir de una base de dicho

subespacio e incluso de un conjunto de vectores que genere el subespacio, sin necesidad de

que los vectores sean linealmente independientes.

Partiendo de una base {v1 , v2 , . . . , vp } de un subespacio S, el método consiste en generar uno a uno vectores que son ortogonales a los construidos. Denotamos por S1 , S2 , · · · los

subespacios vectoriales definidos por

S1 = Gen {v1 } , S2 = Gen {v1 , v2 } , . . . , Sp = Gen {v1 , v2 , . . . , vp } = S.

El método de Gram-Schmidt consiste en generar los vectores:

u1 = v1 ∈ S1 ,

u2 = v2 − proy S1 (v2 ) ∈ S2 , es decir, u2 es el único vector de la forma

u2 = v2 + αu1 que es ortogonal a u1 ,

u3 = v3 − proy S2 (v3 ) ∈ S3 , es decir, u3 es el único vector de la forma

u3 = v3 + αu1 + βu2 que es ortogonal a u1 y a u2 ,

...

Notemos que, puesto que los vectores {v1 , v2 , . . . , vp } son linealmente independientes, los

subespacios

S1 ⊂ S2 ⊂ · · · ⊂ Sp = S

son todos distintos (dim (Sk ) = k, k = 1, 2, . . . , p), los vectores u1 , u2 , . . . , up son todos nonulos y linealmente independientes y se verifica que

S1 = Gen v1

= Gen u1 ,

S2 = Gen {v1 , v2 }

= Gen {u1 , u2} ,

S3 = Gen {v1 , v2 , v3 } = Gen {u1 , u2 , v3 } = Gen {u1 , u2, u3 } ,

..

..

.

.

Sp = Gen {v1 , . . . , vp } = · · ·

= Gen {u1 , · · · , up } .

Teorema (Método de ortogonalización de Gram-Schmidt). Consideremos una base

{v1 , v2 , . . . , vp } de un subespacio vectorial S de Rn . Entonces, los siguientes vectores están

bien definidos

Matemáticas I.

Ingenierı́a Civil

5.3.2.- El método de Gram-Schmidt.

131

u1 = v1

u2 = v2 −

v2 · u1

u1

||u1 ||2

u3 = v3 −

v3 · u1

v3 · u2

u2

2 u1 −

||u1 ||

||u2 ||2

..

.

vp · up−1

vp · u1

up−1

up = vp −

2 u1 − · · ·

||u1 ||

||up−1 ||2

y son no-nulos y ortogonales dos a dos. Además, para cada k = 1, . . . , p, {u1 , u2 , . . . , uk }

es una base ortogonal de Sk = Gen {v1 , v2 , . . . , vk }. En particular {u1, u2 , . . . , up } es una

base ortogonal de S = Gen {v1 , v2 , . . . , vp }.

Observaciones.

(a) Si el objetivo es obtener una base ortonormal de S, una vez que se ha obtenido una base

ortogonal basta normalizar los vectores obtenidos.

(b) En cada paso del método de Gram-Schmidt que acabamos de describir podrı́amos multiplicar (o dividir) el vector obtenido por un coeficiente no-nulo y seguir los cálculos

con dicho vector.

(c) ¿Qué sucede al aplicar el método de Gram-Schmidt a un conjunto de vectores linealmente

dependientes?

5.3.3.- Matrices ortogonales.

Un caso particularmente importante de matrices reales con columnas ortonormales lo

constituyen las matrices cuadradas con dicha propiedad.

Definición. (Matriz ortogonal) Se denomina matriz ortogonal a toda matriz Q real cuadrada no-singular cuya inversa coincide con su traspuesta, Q−1 = QT .

Ejercicio. Prueba las siguientes propiedades de las matrices ortogonales

(1) Si Q es ortogonal =⇒ det (Q) = ±1

(2) Q es ortogonal ⇐⇒ QT es ortogonal.

(3) Si Q1 y Q2 son ortogonales, entonces Q1 Q2 es ortogonal.

Proposición. Sea Q una matriz real cuadrada n × n. Son equivalentes:

(1) Q es una matriz ortogonal.

(2) Las n columnas de Q son ortonormales (y por tanto forman una base ortonormal de

Rn ).

(3) Las n filas de Q son ortonormales (y por tanto forman una base ortonormal de Rn ).

Matemáticas I.

2012-2013

132

Tema 5.- Ortogonalidad y mejor aproximación.

Observación.- Notemos que el que las columnas de una matriz (real) sean ortonormales es equivalente a que lo sean las filas sólo en el caso de una matriz cuadrada. Una matriz real no cuadrada

puede tener columnas (o filas) ortonormales sin serlo sus filas (o columnas). Por ejemplo, las matrices

1

√1

√

√1

0

1 0

3

2

2

1

1

0 1 ,

0 1 , √3 − √2

√1

√1

0 0

0

0

2

3

tienen sus columnas ortonormales pero no sus filas. Las traspuestas tienen filas ortonormales pero

no columnas.

5.4.- La proyección ortogonal.

5.4.1.- Proyección ortogonal sobre un subespacio.

Si consideramos el subespacio vectorial S, de dimensión uno (una recta), generado por

un vector, u1 , no-nulo, S = Gen {u1 }, la proyección ortogonal de un vector v ∈ Rn sobre S

será el vector u = αu1 ∈ S que verifica que

v − u = v − αu1

es ortogonal a S. Es decir, tenemos que determinar α con la condición de que v − αu1 sea

ortogonal a u1 ,

v · u1

⇒

(v − αu1) · u1 = v · u1 − α ||u1 ||2 = 0 ⇐⇒ α =

||u1 ||2

v · u1 v · u1

.

u1 ,

=⇒ ||u|| = =⇒ u = proy S (v) =

||u1 || ||u1 ||2

No hay que confundir el vector proyección ortogonal de v sobre (la recta que genera)

otro,

v · u1 v · u1

, que

u1 , que es un vector

u1 , con la magnitud de dicha proyección ortogonal, ||u1|| ||u1 ||2

es un número real.

Para un subespacio de dimensión arbitraria puede darse una expresión de la proyección

ortogonal de un vector sobre dicho subespacio cuando disponemos de una base ortogonal de

dicho subespacio. Considerando una base ortonormal puede darse una expresión cómoda de

la matriz de la proyección ortogonal.

Teorema (de la descomposición ortogonal). Sea S un subespacio vectorial de Rn . Dado

cualquier vector v ∈ Rn existe un único vector u ∈ S (llamado proyección ortogonal de v

sobre S) tal que v−u ∈ S ⊥ . De hecho, si {u1 , u2, . . . , ur } es una base ortogonal de S, entonces

la proyección ortogonal de v sobre S es

v · ur

v · u1

ur .

u := proy S (v) =

2 u1 + · · · +

||u1 ||

||ur ||2

y la proyección ortogonal de v sobre S ⊥ es

w = v − u.

Notemos que:

Matemáticas I.

Ingenierı́a Civil

5.4.- La proyección ortogonal.

133

Si v ∈ S, entonces proy S (v) = v y proy S ⊥ (v) = 0.

Notemos que proy S ⊥ (v) = v − u = v − proy S (v), esto es

proy S (v) + proy S⊥ (v) = v.

Cada sumando de la expresión

v · ur

v · u1

ur

2 u1 + · · · +

||u1 ||

||ur ||2

nos da la proyección ortogonal del vector v sobre el subespacio generado por el correspondiente vector uk .

El vector u = proy S (v) verifica que ||u||2 ≤ ||v||2 y expresando ||u||2 en términos de

la base ortogonal dada esta desigualdad es la desigualdad de Bessel considerada en la

siguiente proposición.

Corolario. Sea {u1 , u2 , . . . , ur } una base ortogonal de un subespacio S de Rn . Entonces

u · uk

, es decir,

las coordenadas de un vector u ∈ S respecto de dicha base vienen dadas por

||uk ||2

se verifica que

u · u1

u · ur

u=

ur .

2 u1 + · · · +

||u1 ||

||ur ||2

La expresión anterior se suele denominar desarrollo de Fourier de v respecto a la base

{u1 , u2, . . . , ur }.

Corolario. (Matriz de una proyección ortogonal) Sea S un subespacio vectorial de Rn .

(a) Si {u1 , u2 , . . . , ur } es una base ortonormal de S, la proyeción ortogonal de un vector

v ∈ Rn sobre S es

u := proy S (v) = (v · u1 ) u1 + · · · + (v · ur ) ur .

(b) Siendo U una matriz cuyas columnas forman una base ortonormal de S, la matriz de la

proyección ortogonal sobre S es PS = UU T , es decir

proy S (v) = UU T v,

∀v ∈ Rn .

Aunque puedan considerarse distintas matrices U como en el enunciado, la matriz PS =

UU T que representa a la proyección ortogonal, respecto a la base canónica, es única. Las

propiedades caracterı́sticas de las matrices de proyección ortogonal son:

PS2 = PS ,

UU T

2

= U(U T U)U T = UIU T = UU T ,

PS

UU T

T

= (U T )T U T = UU T .

es simétrica,

Matemáticas I.

y

2012-2013

134

Tema 5.- Ortogonalidad y mejor aproximación.

5.4.2.- El teorema de la mejor aproximación.

El teorema de la mejor aproximación resuelve el problema de la mı́nma distancia de

un punto a un subespacio vectorial. Dado un subespacio vectorial S de Rn y un punto/vector x ∈ Rn , se trata de minimizar la distancia de x a un punto/vector genérico w ∈ S,

min {kx − wk : w ∈ S}, y de obtener el punto/vector donde se alcanza dicho mı́nimo. Este

problema se puede plantear como un problema de optimización en varias variables (cálculo

diferencial de varias variables) sin más que expresar un vector genérico w ∈ S como combinación lineal arbitraria de los vectores de un base de S. El teorema de la mejor aproximación

nos dirá que es equivalente resolver el problema de mı́nima distancia (la mejor aproximación

a x desde S) que el problema de la proyección ortogonal sobre S. La mı́nima distancia de x

a S se alcanza en proyS (x) (y en ningún otro punto).

Teorema (de la mejor aproximación). Sea S un subespacio vectorial de Rn y consideremos un vector x ∈ Rn y un vector y ∈ S. Son equivalentes:

(a) y es la proyección ortogonal de x sobre S, es decir,

y ∈ S,

x − y ∈ S ⊥.

(b) y es la mejor aproximación de x desde S, es decir,

y ∈ S,

||x − y|| ≤ ||x − w||

para todo w ∈ S.

S⊥

x

Sea y = proy S (x) y sea w ∈ S. Puesto que

x−w = (x−y)+(y−w),

y

O

S

w

x−y ∈ S ⊥ , y−w ∈ S,

aplicando el Teorema de Pitágoras

tenemos

||x − w||2 = ||x − y||2 +||y − w||2 ≥ ||x − y||2 .

5.5.- Problemas de mı́nimos cuadrados. Ecuaciones normales de

Gauss

En términos generales, resolver un problema en el sentido de los mı́nimos cuadrados es

sustituir un problema en el que hay que resolver un sistema de ecuaciones (que no tiene

solución) por el problema de minimizar una suma de cuadrados.

Ejemplo. El problema de la regresión lineal. Si consideramos dos magnitudes, x e

y, de las que suponemos que están relacionadas mediante una igualdad del tipo y = ax + b,

donde tenemos que determinar a y b mediante la obtención de resultados experimentales, y

dichos resultados son

Matemáticas I.

Ingenierı́a Civil

5.5.- Problemas de mı́nimos cuadrados. Ecuaciones normales de Gauss

135

x x1 x2 · · · xn

y y1 y2 · · · yn

los valores a y b los obtendremos de la resolución del sistema de ecuaciones lineales

x1 1

y1

ax1 + b = y1

x2 1 y2

ax2 + b = y2

a

≡ .. ..

= .. .

···

b

. .

.

axn + b = yn

xn 1

yn

Lo habitual es que un sistema de ecuaciones como el anterior no tenga solución. Resolver el

sistema anterior en el sentido de los mı́nimos cuadrados consiste en determinar los valores a

y b para los cuales la suma de cuadrados

(ax1 + b − y1 )2 + (ax2 + b − y2 )2 + · · · + (axn + b − yn )2

es mı́nima (si hubiera solución dicho

cuadrados es el cuadrado de la norma

x1

x2

..

.

xn

valor mı́nimo serı́a cero). Puesto que esta suma de

del vector

1

y1

1

y2

a

−

..

.

..

. b

1

yn

y los vectores de la forma

x1 1

x2 1

a

.. .. b

. .

xn 1

∀ a, b ∈ R

forman el espacio columna S de la matriz considerada, resolver el sistema en mı́nimos cuadrados es determinar el vector de S más cercano al término independiente considerado y

resolver el sistema (que será compatible) con ese nuevo término independiente.

Para un sistema genérico de ecuaciones lineales Ax = b, resolverlo en el sentido de los

mı́nimos cuadrados es determinar el vector (o vectores) x ∈ Rn para los cuales

||Ax − b||

es mı́nima.

Puesto que los vectores Ax recorren el espacio columna de A (cuando x recorre Rn ), ||Ax − b||

será mı́nima para los vectores x ∈ Rn tales que Ax es igual a la proyección ortogonal de b

sobre el espacio Col (A).

A

Rm

b

Rn

x

O

Matemáticas I.

O

proyS (b)

Ax

Col (A)

2012-2013

136

Tema 5.- Ortogonalidad y mejor aproximación.

Teorema. Consideremos un sistema de ecuaciones Ax = b, A matriz real m × n, b ∈ Rm ,

S = Col (A) y sea x̂ ∈ Rn . Son equivalentes:

(a) x̂ es solución en mı́nimos cuadrados del sistema Ax = b, es decir,

||Ax̂ − b|| ≤ ||Ax − b|| ,

∀x ∈ Rn .

(b) x̂ verifica Ax̂ = proy S (b).

(c) x̂ verifica las ecuaciones normales de Gauss AT Ax̂ = AT b.

Observaciones.

(a) El sistema de ecuaciones Ax = proy S (b) (sistema m × n) y el sistema AT Ax = AT b

(sistema n × n) son siempre compatibles y tienen el mismo conjunto de soluciones.

(b) El sistema Ax = proy S (b) será compatible determinado (es decir el problema en mı́nimos

cuadrados tendrá solución única) si y sólo si el sistema homogéneo asociado Ax = 0

tiene solución única. Por tanto,

las columnas de A son linealmente

el sistema Ax = b tiene solución

⇐⇒

independientes (rango(A) = n).

única en mı́nimos cuadrados

Matemáticas I.

Ingenierı́a Civil

5.6.- Ejercicios.

137

5.6.- Ejercicios.

5.6.1.- Enunciados.

Ejercicio 1. Sea u = [1, 2, 3]T .

(1) Describe geométricamente el conjunto de vectores v ∈ R3 que verifican, respectivamente,

v · u =√2

v·u=4

v·u=2

v·u =0

.

, (d)

, (c)

, (b)

(a)

||v|| = 1

||v|| = 1

||v|| = 1

||v|| = 2/ 14.

(2) Calcula el radio y el centro de la circunferencia dada por las siguientes ecuaciones

v·u =3

.

||v|| = 1

Ejercicio 2. Halla una base y unas ecuaciones implı́citas de E ⊥ y de F ⊥ siendo E y F los

subespacios

0

2

1

2x

+

y

+

3z

−

t

=

0

0 1 1

3x

+

2y

−

2t

=

0

yF ≡

.

E = Gen , ,

−2

2

2

3x + y + 9z − t = 0

1

3

1

Ejercicio 3. Expresa el vector (1, 3, −1, 4)T como suma de dos vectores u + v siendo u

proporcional a (2, 1, 0, 1)T y v ⊥ u.

Ejercicio 4. Halla la proyección ortogonal de los siguientes vectores sobre los subespacios

que se indican:

(1) (4, 1, 3, −2)T sobre el subespacio definido por x1 + x2 + x3 + x4 = 0.

(2) (1, 1, 1, 1)T sobre el subespacio de R4 dado por:

x − y + z − 2t = 0,

E≡

y + z = 0.

(3) (3, −4, 5)T sobre el subespacio f (E) siendo f

1

A = −1

0

la aplicación lineal dada por la matriz

0 1

1 0

1 −1

y E el subespacio de R3 dado por x − y − z = 0.

Matemáticas I.

2012-2013

138

Tema 5.- Ortogonalidad y mejor aproximación.

Ejercicio 5. Demuestra:

(1) El producto de matrices ortogonales es ortogonal.

(2) La suma de matrices ortogonales puede no ser ortogonal.

Ejercicio 6. Dadas las bases ortonormales de R2

√

√ T

√ T

√

B1 =

u1 = 1/ 2, 1/ 2 , u2 = −1/ 2, 1/ 2

T √

√ T

B2 =

w1 = 1/2, 3/2 , w2 = − 3/2, 1/2

y

halla la matriz correspondiente al cambio de una de esas bases a la otra. Comprueba que la

matriz de paso es ortogonal.

Ejercicio 7. Halla el vector perteneciente al subespacio de R4 generado por los vectores

(2, 0, −1, 2)T , (1, 2, −2, 0)T y(−1, 2, 0, −2)T

que está más cerca del vector (1, 1, 1, 1)T .

Ejercicio 8. Halla la matriz de la proyección ortogonal sobre cada uno de los siguientes

subespacios de R4 :

(1) el subespacio generado por (0, 2, 1, 0)T y (1, 1, 0, 1)T .

(2) el subespacio generado por (0, 0, 2, 1)T y (1, 1, −1, 0)T .

x − 3y + z + t = 0

⊥

(3) Sobre E y sobre E , siendo E ≡

Comprueba que, como debe

2x − 5y + z + 2t = 0

ser, la suma de ambas matrices vale I.

Ejercicio 9. Dado el subespacio S ⊂ R3 definido por x1 − 2x2 + 2x3 = 0, se pide:

(a) Halla la matriz de la proyección ortogonal sobre S. ¿Cuál es la matriz de la proyección

ortogonal sobre S ⊥ ?

(b) Determina una base de S ⊥ .

2 0

(c) Demuestra que Col (A) = S, siendo A = 0 1 .

−1 1

(d) Halla el vector de S que dista menos de v = (1, 1, 1)T .

Matemáticas I.

Ingenierı́a Civil

5.6.- Ejercicios.

139

Ejercicio 10. Aplica el método de Gram-Schmidt a:

(a) La base de R4 , (1, 0, 1, 0)T , (1, 1, 0, 0)T , (0, 1, 1, 1)T , (0, 1, 1, 0)T .

(b) Las columnas de las matrices

1 1

A = 0 1 ,

1 0

1 1

B = 1 2 .

2 1

Ejercicio 11. La proyección ortogonal del vector v = (5, −2, 3)T sobre la recta x = y, y = z

es:

(−1, −1, −1)T .

(3, 3, 3)T .

(2, 2, 2)T .

Ejercicio 12. Halla una base ortonormal de Col (A) y otra de Nul (A) siendo

1

1

0

0 −1

1

.

A=

1

1 −1

1

1

1

Ejercicio 13. Consideremos el subespacio E definido mediante

E = Gen (a, 0, 0, 0)T , (a, a, b, 0)T , (a, b, −a, 1)T , a, b ∈ R.

(a) Hallar una base ortonormal del subespacio E según los valores de a y b.

(b) Hallar la matriz de la proyección ortogonal sobre E, cuando a = 0.

(c) Calcular los valores de los parámetros a y b tales que el subespacio dado por las ecuaciones

x1 = 0

5x1 + x2 + 3x3 = 0

−2x1 + 3x2 − x3 + x4 = 0

sea ortogonal a E.

Ejercicio 14. Consideremos los vectores y el subespacio vectorial dados por

−1

2α

α

v1 = 1 , v2 = α , u = 0 ;

S ≡ x1 + x2 + αx3 = 0.

−3

3

−1

Determina α sabiendo que proy S (v1 ) = proy S (v2 ) = u. (un dibujo puede ayudar)

Matemáticas I.

2012-2013

140

Tema 5.- Ortogonalidad y mejor aproximación.

Ejercicio 15. Sean S1 y S2 los subespacios vectoriales de R4 definidos mediante

S1 ≡ x1 + x2 + x3 + x4 = 0,

y S2 ≡ x1 + x2 − x3 − x4 = 0.

Determina el vector v ∈ R4 cuyas proyecciones ortogonales sobre S1 y S2 son, respectivamente,

7

3

−5

, u2 = proy S (v) = −1

u1 = proy S1 (v) =

2

7

5

−1

−3

Ejercicio 16. Sea A una matriz 4 × 3 tal que

−3

Nul (A) = Gen 5 ,

1

2

1

−1

−1

Col (A)⊥ = Gen v1 =

1 , v2 = 0

1

0

.

(a) Calcula la proyección ortogonal del vector v = [1 1 1 1]T ∈ R4 sobre el subespacio

Col (A).

1 0 ∗

2 1 ∗

(b) Determina la matriz A sabiendo que es de la forma A =

∗ ∗ ∗ .

∗ ∗ ∗

Ejercicio 17. Resolver en el sentido de los mı́nimos cuadrados los siguientes sistemas de

ecuaciones

(1) x = 1, x = 7, x = −3, x = 12.

(2) x = a1 , x = a2 , ..., x = an , siendo a1 , a2 , ..., an números reales. ¿Qué se obtiene cuando

alguno de los valores ak aparece repetido?

2

1 1

.

yb=

(3) Ax = b siendo A =

4

1 1

Ejercicio 18. Resuelve en el sentido de los mı́nimos cuadrados los dos sistemas equivalentes

siguientes (que tendrı́an las mismas soluciones exactas si fueran compatibles)

Matemáticas I.

x1 + x2 = 3

2x1 + 2x2 = 4

y

x1 + x2 = 3

x1 + x2 = 1

.

Ingenierı́a Civil

5.6.- Ejercicios.

141

n

o

Ejercicio 19. Dados el subespacio E = Gen [1, 0, 0, 1]T , [0, 1, 0, 2]T , [0, 0, 1, 1]T y la matriz

a1 b1

a2 2

A=

a3 b2 .

−2 b3

(a) Calcular una base de E ⊥ .

(b) Hallar la matriz de la proyección ortogonal sobre E.

(c) Calcular A sabiendo que Col (A)) está contenido en E ⊥ .

(d) Resolver en el sentido de los mı́nimos cuadrados, el sistema Ax = b con b = (1, −1, 0, 0)t .

Ejercicio 20. Por el método de los mı́nimos cuadrados, ajustar una parábola, y = ax2 +

bx + c, a los puntos (1, −3), (1, 1), (−1, 2) y (−1, −1).

Ejercicio 21. Resolviendo el sistema sobredeterminado que se obtiene de la ecuación general

de la circunferencia x2 + y 2 + ax + by + c = 0, calcular la circunferencia que mejor se ajuste,

en el sentido de los mı́nimos cuadrados a los puntos (0, 0), (1, 0), (0, 1) y (1, 1), indicando

las coordenadas del centro y el radio de la misma.

Ejercicio 22. Consideremos el sistema

1

0 1 1

1 1 x

=

3

−1 1 y

3

2 1

.

Sus ecuaciones

de Gauss son:

normales

4

x

6 1

.

=

8

y

1 4

6 2

2 4

x

y

6 2

2 4

x

y

Ejercicio 23. Considera los vectores v1 , v2 , v3 y v4 de R4 y

−1

1

0

1

−8

−1

1

−1

v1 =

2 , v2 = 2 , v3 = 2 , v4 = 1

2

3

2

0

=

2

4

.

=

4

8

.

la matriz C dados por

;

C = v1 v2 .

(a) Calcular la matriz de la proyección ortogonal sobre S = Gen {v1 , v2 , v3 }, el vector de S

más cercano a v4 y la distancia de v4 a S.

(b) Resolver, en el sentido de los mı́nimos cuadrados, el sistema Cx = v3 .

Matemáticas I.

2012-2013

142

Tema 5.- Ortogonalidad y mejor aproximación.

5.6.2.- Soluciones.

Ejercicio

1. (1)

v·u=0

•

||v|| = 1

Corte de la esfera de centro el origen y radio 1 con el plano

x + 2y + 3z = 0. Circunferencia de centro el origen y radio 1.

•

v·u=2

||v|| = 1

Corte de la esfera de centro el origen y radio 1 con el plano

•

v·u=4

||v|| = 1

Corte de la esfera de centro el origen y radio 1 con el plano

x + 2y + 3z = 4. Nada.

x + 2y + 3z = 2. Circunferencia de centro C =

2 4 6

( 14

, 14 , 14 )

y radio

√

v·u =2

Corte de la esfera de centro el origen y radio 2/ 14

•

||v|| = √214 .

con el plano x + 2y + 3z = 2. Un punto.

q

5

3 6 9

(2) Radio r = 14

, Centro C = ( 14

, 14 , 14 ).

Ejercicio 2.

E⊥

F⊥

−1

−2

−1

2

x1 + 2x3 + x4 = 0,

,

, Ecuaciones implı́citas

Base

0

1

x2 − 2x3 + x4 = 0.

1

0

Base v1 =

3

2

2

1

,v =

3 2 0

−2

−1

−6x + 9y + z = 0,

, Ecuaciones implı́citas

y+t

= 0.

Ejercicio 3.

1

3

−1 = u + v,

4

−2

2

3

3

1

, v = 2

u=

−1

2 0

5

1

2

Ejercicio 4. (1) Para el vector v dado, tenemos

4

1

v=

3 ⇒ proy(v) =

−2

Matemáticas I.

.

5

1 −1

.

2

3

−7

Ingenierı́a Civil

q

10

.

14

5.6.- Ejercicios.

143

(2) Para el vector dado tenemos,

8

1 −1

.

proy(v) =

7 1

5

(3) En este caso la proyección viene dada por

3

47

1

−2 .

proy( −4 ) =

11

5

41

Ejercicio 5. (1) Si tomamos dos matrices ortgonales Q1 y Q2 de orden n, se verifica que

T

Q−1

1 = Q1

T

y Q−1

2 = Q2

y, por tanto, la matriz producto Q = Q1 Q2 es ortogonal pues se verifica que

QQT = (Q1 Q2 ) (Q1 Q2 )T = (Q1 Q2 ) QT2 QT1 = Q1 Q2 QT2 QT1 = Q1 QT1 = I.

(2) Las matrices Q1 = I y Q2 = −I son ortogonales, pero su suma Q1 + Q2 = 0 no lo es.

Ejercicio 6. Una de las matrices de cambio de base es

√

√ 1

1 + √3 −1 +√ 3

P

= √

B2 ← B1

2 2 1− 3 1+ 3

que es una matriz ortogonal porque los vectores columna forman una base ortonormal de

R2 . La otra matriz de cambio de base es la inversa (o traspuesta) de la matriz anterior

P

=

B1 ← B2

P

B2 ← B1

−1

=

P

B2 ← B1

T

1

= √

2 2

√

√ 1 + √3 1 − √3

.

−1 + 3 1 + 3

Ejercicio 7. Teniendo en cuenta el Teorema de la mejor aproximación, de los vectores

de un subespacio vectorial S, el que está más cerca de un vector dado b es el vector proyección

ortogonal de b sobre S, es decir, el vector pedido es

11

1 8

.

proyS (b) =

9 9

7

Matemáticas I.

2012-2013

144

Tema 5.- Ortogonalidad y mejor aproximación.

Ejercicio 8. (1) La matriz de la proyección ortogonal sobre el subespacio es

5 1 −2

5

1

9

4

1

.

PS =

3 −2

11

5

(Los elementos que faltan en la matriz anterior no son nulos, ¿quiénes tienen que ser?)

(2) La matriz de la proyección ortogonal sobre el subespacio generado

5

∗ ∗ ∗

1

5 ∗ ∗

.

5

P =

11 −1 −1 9 ∗

2

2 4 3

(Completa las posiciones donde aparece (∗))

(3) La matriz de la proyección ortogonal sobre

3

1

∗

PE =

4 ∗

∗

E,

1

1

∗

∗

1 −1

1

1

.

1

1

∗

3

(Completa las posiciones donde aparece (∗)). La matriz de la proyección ortogonal

sobre E ⊥

1 −1 −1

1

1 ∗

3 −1 −1

= I − PE .

PE ⊥ =

∗

3 −1

4 ∗

∗

∗

∗

1

(Completar las posiciones donde aparece (∗))

Ejercicio 9. (a) La matriz de la proyección ortogonal sobre S es

8 2 −2

1

4 .

PS = ∗ 5

9

∗ ∗

5

La matriz de la proyección ortogonal sobre S ⊥ es

1 −2

2

1

4 −4 .

PS ⊥ = I − PS = ∗

9

∗

∗

4

1

(b) Una base de S ⊥ es −2 .

2

Matemáticas I.

Ingenierı́a Civil

5.6.- Ejercicios.

145

(c) Tenemos Col (A) = S puesto que cada columna de A está en S y ambos subespacios

tienen dimensión 2.

(d) El vector u de S más cercano a v es el vector

decir,

8 2 −2

1

4

PS v = ∗ 5

9

∗ ∗

5

proyección ortogonal de v sobre S, es

1

8

1

1 = 11 .

9

1

7

La distancia de v a S es

1 1

1 ||v − PS v|| = ||PS ⊥ v|| = −2 = .

9 3

2 Ejercicio 10. (a)

(b)

A: Ortogonalizamos los vectores columna v1 y v2 de A,

1

1

1

v2 · u1

2 .

u1 = v1 = 0 , u2 = v2 −

2 u1 =

2

||u

||

1

1

−1

B: Ortogonalizamos los vectores columna v1 y v2 de B,

1

1

v2 · u1

1

7 .

u1 = v1 = 1 , u2 = v2 −

2 u1 =

6

||u

||

1

2

−4

Ejercicio 11. La proyección ortogonal del vector v = (5, −2, 3)T sobre la recta x = y, y = z

es: (2, 2, 2)T .

Ejercicio 12.

Col (A) Una base ortonormal de Col (A) es

0

1

−1

1

0

, q2 =

q1 = √

0

1

3

0

1

0

, q3 = √1 0 .

2 −1

1

Nul (A) Como el rango de A es 3 el espacio nulo tiene dimensión cero, luego sólo

puede ser Nul (A) = {0}.

Ejercicio 13. (a) Si a = 0 los vectores son ortogonales dos a dos y tenemos los siguientes

casos:

Matemáticas I.

2012-2013

146

Tema 5.- Ortogonalidad y mejor aproximación.

a = 0, b = 0. En este caso v1 = v2 = 0 y {v3 } es una base ortonormal de E.

a = 0, b 6= 0. En este caso,

0

0

, u3 = √ 1

E = Gen u2 =

1

1 + b2

0

deonde {u2 , u3} es una base ortonormal de E.

0

b

,

0

1

a 6= 0. Los tres vectores {v1 , v2 , v3 } son no nulos y no ortogonales entre sı́. Ortoganalizamos, normalizamos los vectores obtenidos y tenemos una base ortonormal

de E,

1

0

0

0

a

b

1

1

u1 = , u2 = √

.

, u3 = √

2 + b2 b

2 + b2 −a

0

a

1

+

a

0

0

1

(b) Para a = 0 tenemos los siguientes casos:

a = 0, b = 0. La matriz de la proyección ortogonal sobre E es

0 0 0 0

0 0 0 0

P =

0 0 0 0 .

0 0 0 1

a = 0, b 6= 0. La matriz de la proyección ortogonal sobre E es

0

0

P =

0

0

0

b2

1+b2

0

b

1+b2

0

0

1

0

0

b

1+b2

0

1

1+b2

.

(c) Se obtiene a = 1, b = 1.

Ejercicio 14. se obtiene α = −2.

6

−2

Ejercicio 15. Se obtiene v =

8 .

0

Matemáticas I.

Ingenierı́a Civil

5.6.- Ejercicios.

147

Ejercicio 16. (a) La proyección del vector v sobre

por

1

1

4

u=

3 3

2

el subespacio Col (A) es el vector dado

.

(b) La matriz A completa es:

1

2

A=

1

0

0

3

1

1

.

1 −2

1 −5

1 + 7 − 3 + 12

17

= .

4

4

a1 + a2 + · · · + an

. Cuando alguno de los valores ak aparece repetido, la expresión

(2) x =

n

anterior es válida y se trata de una media aritmética ponderada donde cada uno de los

distintos valores pesa según el número de veces que aparece repetido.

Ejercicio 17. (1) x =

(3) Mediante las ecuaciones normales de Gauss

3−α

x=

,α ∈ R .

α

Ejercicio 18. (a)

x1

x2

x1

x2

=

=

0

2

0

11

5

−1

1

−1

1

+α

, α ∈ R.

(b)

+β

, β ∈ R.

Es decir, las soluciones en mı́nimos cuadrados de cada uno de los sistemas es una recta

y ambas rectas son paralelas. Notemos que si en el sistema (a) a la segunda ecuación le

restamos la primera, se obtiene el sistema (b).

−1

−2

⊥

.

Ejercicio 19. (a) E = w =

−1

1

(b) La matriz de la proyección ortogonal sobre E es

6 −2 −1 1

1 −2

3 −2 2

.

PE =

6 1

7 −1 −2

1

2

1 6

Matemáticas I.

2012-2013

148

Tema 5.- Ortogonalidad y mejor aproximación.

(c) Obtenemos

2

1

4

2

.

A=

2

1

−2 −1

(d)

x1

x2

=

1

− 14

0

x2

+

2

−1

2

.

Ejercicio 20. Para cualquier valor de c ∈ R, todas las parábolas

1

3

y=−

+ c x2 − x + c

4

4

se ajustan igual de bien, en el sentido de los mı́nimos cuadrados, a los puntos dados y se

ajustan mejor que todas las demás. Siendo estrictos en la lectura del enunciado quizá habrı́a

que suprimir una de las curvas que se obtiene mediante la ecuación anterior, ¿cuál?

Ejercicio 21. La circunferencia que mejor se ajusta, en el sentido de los mı́nimos cuadrados,

a los puntos dados es

2 2

1

1

1

2

2

+ y−

= ,

x +y −x−y = 0

≡

x−

2

2

2

√

es decir, se trata de la circunferencia de centro 12 , 21 y radio 22 . Notemos que, de hecho, los

puntos dados están en la ciecunferencia obtenida es decir, la solución en mı́nimos cuadrados

es solución (en el sentido estricto) del sistema original.

Ejercicio 22. Sus ecuaciones normales de Gauss son:

6 2

x

4

=

.

2 4

y

8

Ejercicio 23. (a)

Matriz de la proyección ortogonal sobre S:

5 −8 4 0

1

−8 17 2 0 .

PS =

2 20 0

21 4

0

0 0 21

3

−6

Vector de S más cercano a v4 : PS v4 =

0 .

2

√

Distancia de v4 a S: La distancia de v4 a S es 21.

(b)

Matemáticas I.

x1

x2

1

=

5

3

4

Ingenierı́a Civil