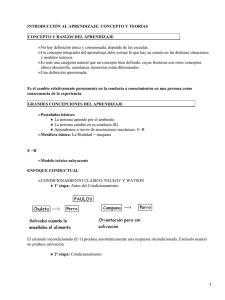

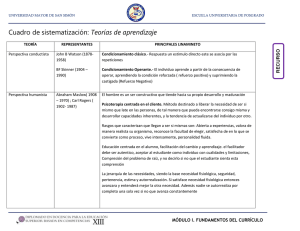

Condicionamiento operante

Anuncio