Estadística 4

Anuncio

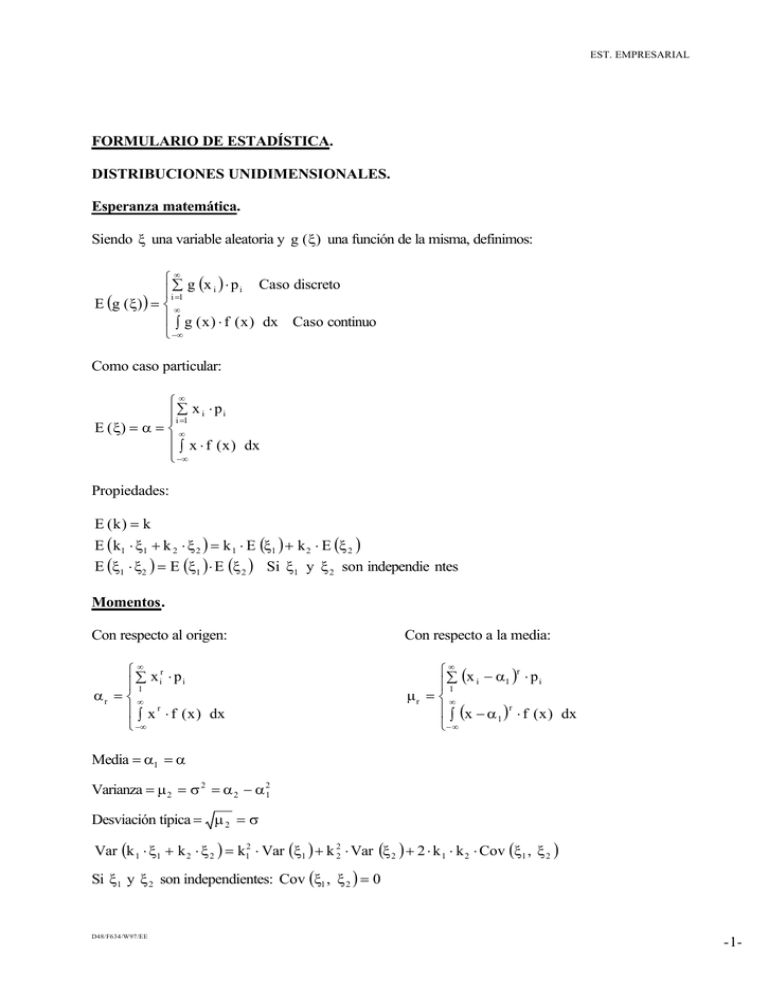

EST. EMPRESARIAL FORMULARIO DE ESTADÍSTICA. DISTRIBUCIONES UNIDIMENSIONALES. Esperanza matemática. Siendo ξ una variable aleatoria y g ( ξ) una función de la misma, definimos: ∞ ∑ g (x i ) ⋅ p i Caso discreto i =1 E (g ( ξ) ) = ∞ ∫ g ( x ) ⋅ f ( x ) dx Caso continuo −∞ Como caso particular: ∞ ∑ x ⋅p i =1 i i E ( ξ) = α = ∞ ∫ x ⋅ f ( x ) dx −∞ Propiedades: E (k ) = k E ( k1 ⋅ ξ1 + k 2 ⋅ ξ 2 ) = k 1 ⋅ E (ξ1 ) + k 2 ⋅ E (ξ 2 ) E (ξ1 ⋅ ξ2 ) = E (ξ1 ) ⋅ E (ξ 2 ) Si ξ1 y ξ 2 son independie ntes Momentos. Con respecto al origen: Con respecto a la media: ∞ ∑ xr ⋅p 1 i i αr = ∞ ∫ x r ⋅ f ( x ) dx −∞ ∞ r ∑ ( x i − α1 ) ⋅ p i 1 µr = ∞ ∫ (x − α 1 ) r ⋅ f ( x ) dx − ∞ Media = α1 = α Varianza = µ 2 = σ 2 = α 2 − α 21 Desviación típica = µ 2 = σ Var (k 1 ⋅ ξ1 + k 2 ⋅ ξ 2 ) = k12 ⋅ Var (ξ1 ) + k 22 ⋅ Var (ξ 2 ) + 2 ⋅ k 1 ⋅ k 2 ⋅ Cov (ξ1 , ξ 2 ) Si ξ1 y ξ 2 son independientes: Cov (ξ1 , ξ 2 ) = 0 D48/F634/W97/EE -1- EST. EMPRESARIAL µ3 σ3 Coeficiente de asimetría: g 1 = Coeficiente de apuntamiento o kurtosis: g 2 = Coeficiente de variación: C.V . = µ4 −3 σ4 σ α Función característica. ∞ ∑ ei t xi ⋅ p i Caso discreto i =1 itξ ϕξ ( t ) = E (e ) = ∞ ∫ ei t x ⋅ f ( x ) dx Caso continuo − ∞ En el caso continuo se verifica la siguiente propiedad: α1 = ϕ ′ (0) ; i α2 = ϕ′′ ( 0) ; i2 α3 = ϕ′′′ ( 0) ; y así sucesivamente. i3 DESIGUALDAD DE TCHEBYCHEFF. σ2 Pr ( α − k < ξ < α + k ) ≥ 1 − 2 k En el caso particular k = n ⋅ σ Pr ( α − n ⋅ σ < ξ < α + n ⋅ σ) ≥ 1 − 1 n2 DISTRIBUCIONES BIDIMENSIONALES. x y p Caso discreto ∑ ij i∑ =1 j =1 F ( x , y) = Pr (ξ1 ≤ x, ξ2 ≤ y ) = x y ∫ ∫ f ( x , y) dx dy Caso continuo −∞ −∞ En el caso continuo f ( x , y) = ∂ 2 F ( x, y ) ∂x ∂y Distribuciones marginales. ∞ p = ∑ p Caso discreto i. j=1 ij ∞ f1 ( x ) = ∫ f ( x , y) dy = F1′ ( x ) Caso continuo −∞ D48/F634/W97/EE ∞ p = ∑ p ij .j i =1 ∞ f 2 ( y) = ∫ f ( x , y) dx = F2′ ( y) −∞ -2- EST. EMPRESARIAL x ∞ x ∑ ∑ p ij = ∑ p i. i=1 j=1 i =1 F1 ( x ) = Pr (ξ1 ≤ x ) = F ( x, ∞ ) = x ∞ x ∫ ∫ f ( x, y ) dy dx = ∫ f1 ( x ) dx − ∞ − ∞ −∞ y ∞ p = y p ∑ ij ∑ . j ∑ j =1 i =1 j=1 F2 ( y ) = Pr (ξ 2 ≤ y ) = F ( ∞, y ) = y ∞ y ∫ ∫ f ( x, y ) dx dy = ∫ f 2 ( y ) dy −∞ − ∞ −∞ Distribuciones condicionadas. p ij Pr (x i y j ) = p .j f (x y ) = f ( x , y) f 2 (y ) p ij Pr (y j x i ) = p i. f ( x , y) f (y x ) = f1 ( x ) x p ij ∑ i=1 p . j F (x y ) = x f (x y ) dx −∫∞ y p ij ∑ j=1 p i. ( ) F y x = y f (y x ) dy −∫∞ Independencia. Decimos que ξ1 y ξ 2 son independientes si se verifica que: p ij = p i. ⋅ p. j f ( x, y ) = f 1 ( x) ⋅ f 2 ( y) que equivale a F ( x, y) = F1 ( x ) ⋅ F2 ( y) o bien: f (x y ) = f 1 ( x ) o f (y x ) = f 2 ( y) Momentos con respecto al origen. α hk ∞ ∞ h k ∑ ∑ x i ⋅ y j ⋅ p ij i=1 j=1 h k = E (x ⋅ y ) = ∞ ∞ ∫ ∫ x h ⋅ y k ⋅ f ( x, y) dx dy − ∞ − ∞ α 10 ∞ ∑ x ⋅p i=1 i i. = x = E (ξ1 ) = ∞ ∫ x ⋅ f 1 ( x ) dx −∞ D48/F634/W97/EE α 01 ∞ ∑ y ⋅p j=1 j . j = y = E (ξ 2 ) = ∞ ∫ y ⋅ f 2 ( y ) dy − ∞ -3- EST. EMPRESARIAL Momentos con respecto a la media. µ hk ∞ ∞ k h ∑ ∑ (x i − x ) ⋅(y j − y ) ⋅ p ij i = 1 j = 1 h k = E (x − x ) ⋅ (y − y ) = ∞ ∞ ∫ ∫ ( x − x ) h ⋅ ( y − y) k ⋅ f ( x , y) dx dy − ∞ − ∞ [ ] 2 µ 20 = Var (ξ1 ) = σ2ξ1 = α 20 − α10 ; σ ξ1 desviación típica de ξ1 µ 02 = Var (ξ2 ) = σ 2ξ2 = α 02 − α 201 ; σ ξ2 desviación típica de ξ 2 µ11 = Cov (ξ1 , ξ2 ) = α11 − α10 ⋅ α 01 El coeficiente de correlación es ρ = µ 11 , verificándose que − 1 ≤ ρ ≤ 1 . σξ1 ⋅ σ ξ2 Si las variables son independientes ρ = 0 , en cambio si ρ = 0 eso no implica que las variables sean independientes. El coeficiente de determinación es ρ 2 (0 ≤ ρ 2 ≤ 1) e indica el porcentaje de causas comunes (concausalidad) que influyen en las dos variables, también decimos que si ρ 2 = 0'55 una variable explica el 55% de la otra. REGRESIÓN. ∞ Curva de regresión de x sobre y: x = E (x y ) = ∫ x ⋅ f (x y ) dx −∞ ∞ Curva de regresión de y sobre x: y = E (y x ) = ∫ y ⋅ f (y x ) dy −∞ Regresión lineal. y = Ax + B A= µ11 σ 2x B = α 01 − A ⋅ α10 x = Cy + D C= µ 11 σ 2y D = α10 − C ⋅ α 01 A y C tienen el mismo signo. A ⋅ C = ρ 2 coeficiente de terminación. D48/F634/W97/EE -4- EST. EMPRESARIAL DISTRIBUCIONES DE PROBABILIDAD. n - Binomial (n, p): Pr ( ξ = k) = ⋅ p k ⋅ q n − k , k E ( ξ) = n ⋅ p k = 0, 1, ..., n ϕ ξ ( t ) = (q + e i t ⋅ p ) n Var ( ξ) = n ⋅ p ⋅ q - Poisson (λ ) : Pr ( ξ = k ) = e −λ E ( ξ) = λ λk , k! k = 0, 1, 2, ... ϕ ξ ( t ) = e λ (e Var ( ξ) = λ it - Uniforme (en el intervalo [a, b]): x ∈ [a, b] , f ( x) = E ( ξ) = a+b 2 Var ( ξ) = (b − a )2 12 −1 ) 1 b−a ϕ ξ (t ) = ei t b − ei t a i t (b − a ) 1 - Normal (0, 1): f ( x) = E (ξ) = 0 1 − t2 − x2 1 2 e ; ϕ ξ (t ) = e 2 2π E (ξ2 ) = 1 Var ( ξ) = 1 1 x −µ σ − 1 - Normal ( µ, σ ) : f ( x) = e 2 σ 2π Tipificación: ξ′ = E (ξ 4 ) = 3 2 ; x∈ℜ Var ( ξ) = σ2 E ( ξ) = µ E (ξ 3 ) = 0 ϕ ξ (t ) = e 1 i t µ − t 2 ⋅ σ2 2 ξ−µ → N (0, 1) . σ ( ) - Chi-cuadrado χn2 : Dadas las variables aleatorias ξ1 , ξ2 , ..., ξ n todas ellas N (0, 1) e independientes, la variable η = ξ12 + ξ22 + ... + ξ2n es una χ 2n . f (x ) = 1 n 2 n 2 ⋅ Γ 2 n −1 x 2 ⋅e E ( η) = n x 2 , x≥0 Var ( η) = 2n ( Se aproxima a una N n, D48/F634/W97/EE − ϕ η ( t ) = ( −2i t ) − n 2 ) 2n cuando n > 30 . -5- EST. EMPRESARIAL - t de Student ( t n ) : Dadas las variables aleatorias η1 , η2 , η3 ..., ηn todas ellas N (0, 1) e independientes, n la variable t n = es una t de Student con n grados de libertad. 1 2 2 2 (η1 + η2 + ... + ηn ) n E (t n ) = 0 tn ∈ ℜ Var (t n ) = n para n > 2 n− 2 Se aproxima a una N (0, 1) cuando n > 30 . Tiene el interés de que su función de densidad no depende de σ . - F de Snedecor (F ): m, n Consideremos m + n variables aleatorias independientes η1 , η2 , ..., ηm ; ξ1 , ξ2 , ..., ξ n todas ellas N ( 0, σ ) . La variable Fm, n Fm, n 1 2 (η1 + η22 + ... + η2m ) = m es una F de Snedecor con (m, n) grados de libertad. 1 2 2 2 (ξ + ξ 2 + ... + ξn ) n 1 1 η12 η22 η2 2 + 2 + ... + m2 mσ σ σ 1 2 χm m = = 1 2 1 ξ11 ξ22 ξ2n χn 2 + 2 + ... + 2 n n σ σ σ La gráfica de su función de densidad es similar a la de χ 2 y se verifica que Fm, n = 1 Fn , m TEOREMA CENTRAL DEL LÍMITE (DE LINDEBERG-LEVY). Sean ξ1 , ξ2 , ..., ξ n variables aleatorias independientes con la misma distribución, tales que E (ξ i ) = α , Var (ξi ) = σ2 (finita). Entonces formamos una nueva variable Sn = ξ1 + ξ2 + ... + ξ n , que sabemos que verifica E (S n ) = n α , Var (Sn ) = n σ2 . Pues bien este teorema dice que lim n→ ∞ Sn − n α nσ 2 Sn − n α n σ2 tiende a una N ( 0, 1) cuando n → ∞ . = ξ1 ( N (0, 1) ) ( ) Por tanto ξ1 + ξ2 + ... + ξn → N n α, σ n . n→ ∞ Se admiten aproximaciones por valores de n > 30 . D48/F634/W97/EE -6-