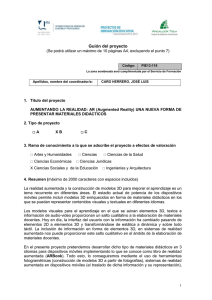

Análisis y Desarrollo de Sistemas de Realidad Aumentada - E

Anuncio