DATALOG SOLVE Un evaluador de consultas Datalog y su

Anuncio

Universidad Politécnica de Valencia

Facultad de Informática

Ingenierı́a Informática

Proyecto Fin de Carrera

DATALOG SOLVE

Un evaluador de consultas Datalog

y su aplicación

al análisis de código Java

Alumno:

Marco A. Feliú

Año Académico 2007/2008

Universidad Politécnica de Valencia

Camino de Vera, s/n

46022 Valencia

España

Índice general

Introducción al análisis de programas

III

I.1. Motivación . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

iii

I.2. Nuestra solución . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

v

I.3. OPEN/CÆSAR . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

vi

I.4. Aportaciones originales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

vi

I.5. Organización del documento . . . . . . . . . . . . . . . . . . . . . . . . . . . .

vii

1. Preliminares

1

1.1. Análisis de programas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.1.1. Conceptos básicos . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.1.2. Análisis interprocedimental . . . . . . . . . . . . . . . . . . . . . . . .

3

1.1.3. ¿Para qué es necesario el análisis interprocedimental? . . . . . . . . .

4

1.2. Datalog: una representación lógica del flujo de datos . . . . . . . . . . . . . .

6

1.2.1. Sintaxis y semántica . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6

1.2.2. Un algoritmo de análisis de punteros sencillo . . . . . . . . . . . . . .

11

1.2.3. Análisis interprocedimental insensible al contexto . . . . . . . . . . . .

17

1.2.4. Análisis de punteros sensible al contexto . . . . . . . . . . . . . . . . .

20

1.2.5. Implementación de Datalog mediante DDBs . . . . . . . . . . . . . . .

24

1.3. Pbes: un formalismo para analizar programas . . . . . . . . . . . . . . . . . .

28

2. De Datalog a Bes

31

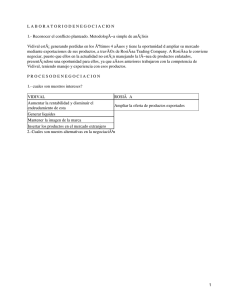

2.1. Representación de una consulta Datalog . . . . . . . . . . . . . . . . . . . . .

31

2.2. Instanciación a un BES sin parámetros . . . . . . . . . . . . . . . . . . . . . .

34

2.2.1. Optimizaciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

2.2.2. Extracción de soluciones . . . . . . . . . . . . . . . . . . . . . . . . . .

38

ÍNDICE GENERAL

ii

3. Arquitectura de la aplicación

39

3.1. Vista general . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

39

3.2. Una visión externa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

40

3.2.1. Entrada del programa . . . . . . . . . . . . . . . . . . . . . . . . . . .

40

3.2.2. Salida del programa . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

3.2.3. Modos de ejecución . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.3. Una visión interna . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.3.1. Primera fase: traducción . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.3.2. Segunda fase: resolución del Bes . . . . . . . . . . . . . . . . . . . . .

56

3.3.3. Tercera fase: extracción de respuestas . . . . . . . . . . . . . . . . . .

58

3.3.4. Versiones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

59

3.4. DATALOG SOLVE: Ejecutable . . . . . . . . . . . . . . . . . . . . . . . . . . .

59

Conclusiones y trabajo futuro

61

C.1. Trabajo relacionado . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

61

C.2. Evaluación experimental . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

62

A. DATALOG SOLVE API

Bibliografı́a

65

67

Introducción al análisis de

programas

I.1.

Motivación

En el proceso de transición desde una economı́a industrial hacia una economı́a global y

basada en el conocimiento, las tecnologı́as de la informática se han convertido en un factor

determinante de los avances de la productividad y, en consecuencia, del crecimiento económico.

Los resultados de estudios como [JV05] son concluyentes en relación con el hecho de que, a

partir de la segunda mitad de la década de los noventa, estas tecnologı́as han desempeñado

un papel determinante y creciente en la explicación de los avances de la productividad del

trabajo en los paı́ses del G7 [VT06].

Uno de los problemas actuales en el desarrollo de sistemas de software es la complejidad,

cada vez más alta, de analizar y garantizar el comportamiento fiable de estos sistemas. Con

el crecimiento de los sistemas de software, que han evolucionado hasta alcanzar tamaños y

complejidades extraordinariamente altos, su inestabilidad se está convirtiendo, lamentablemente, en algo cotidiano y asumido con resignación por los usuarios en una sociedad de la

información cada vez más exigente. La fiabilidad se ha convertido por este motivo en una necesidad reconocida y urgente en las industrias de desarrollo de software. Para garantizar esta

fiabilidad son necesarias técnicas, métodos y herramientas que soporten de forma adecuada

el proceso de desarrollo. Este proyecto se enmarca dentro del desarrollo de métodos, técnicas

y herramientas para la construcción de software fiable y de calidad, dedicando especial atención a su posible aplicación en los procesos reales de producción de la industria del software.

Dentro del amplio abanico de aproximaciones para mejorar la construcción del software, la

propuesta de este trabajo se centra en el uso “ágil” (lightweight) de los métodos formales, y

en particular los métodos basados en la lógica, en la Ingenierı́a del Software. La aproximación

ágil se basa en la utilización parcial de formalismos a distintos niveles (lenguaje, modelado,

análisis y composición), donde la idea fundamental es la de sacrificar el objetivo de lograr

métodos generalistas que soporten todo el proceso de desarrollo de software en beneficio del

INTRODUCCIÓN AL ANÁLISIS DE PROGRAMAS

iv

uso puntual de formalismos en determinadas etapas del ciclo de vida del software.

Métodos lógicos en la informática. La teorı́a, las técnicas y las herramientas basadas

en lógicas están teniendo un impacto cada vez mayor en muy diversas áreas de la informática,

pero también en la resolución de numerosos problemas computacionales en la industria y en

otras ciencias como la biologı́a.

Este auge de los métodos basados en la lógica tiene diversas razones. Por un lado, puesto

que la informática es aún una ciencia joven, sus numerosas técnicas ad-hoc todavı́a están evolucionando hacia fundamentos comunes más generales y mejor estudiados, y, como veremos, a

menudo estos fundamentos resultan estar basados en la lógica. El auge de los métodos lógicos

también tiene su explicación teórica: la mayorı́a de los formalismos (autómatas, lenguajes,

clases de complejidad, etc.) tienen sus contrapartidas lógicas. Existen correspondencias entre

mecanismos de cómputo y lógicas tales como las establecidas por el isomorfismo de CurryHoward. Pero sobre todo cabe destacar las repercusiones para la práctica, tal y como ya

predijo Alan Turing:

“I expect that digital computing machines will eventually stimulate a considerable

interest in symbolic logic (...). The language in which one communicates with these

machines (...) forms a sort of symbolic logic.”

Asimismo, McCarthy escribió, ya en los años 60, que la lógica estaba llamada a tener para la

informática una importancia comparable a la que tuvo el análisis matemático para la fı́sica en

el siglo XIX. Manna y Waldinger [MW85] han llamado a la lógica “The Calculus of Computer

Science” debido a que su papel en la informática tanto teórica como práctica es similar al de

las matemáticas en las ciencias fı́sicas y, en particular, al del cálculo en ingenierı́a.

Al igual que los arquitectos e ingenieros analizan matemáticamente sus construcciones,

los informáticos pueden analizar las propiedades lógicas de sus sistemas mientras los diseñan,

desarrollan, verifican y mantienen, especialmente cuando se trata de sistemas crı́ticos económicamente, en seguridad o en privacidad. Los análisis lógicos pueden ser reveladores también en

sistemas cuya eficiencia resulta crı́tica. Además, en todos los tipos de sistemas, los métodos

y herramientas basados en la lógica pueden mejorar la calidad y reducir costes.

Esta visión está ampliamente documentada en el artı́culo “On the Unusual Effectiveness

of Logic in Computer Science” [HHI+ 01], donde el papel crucial de la lógica en áreas como

las bases de datos, los lenguajes de programación, la complejidad, los sistemas de agentes y

la verificación es explicado por expertos mundiales en cada una de estas áreas; véase también

http://www.cs.rice.edu/~vardi/logic/.

NUESTRA SOLUCIÓN

Finalidad de este proyecto.

v

El objetivo principal de este proyecto es desarrollar una

técnica de análisis de programas Java usando el lenguaje de especificación Datalog para expresar los análisis y el formalismo de los sistemas de ecuaciones booleanas (Bes, del inglés

boolean equation systems) para su resolución.

En la literatura podemos encontrar una de las aproximaciones clásicas para el análisis y certificación de programas donde se utilizan los sistemas de tipos y efectos para establecer la

relación entre las propiedades de seguridad y los programas [NL96, NR01] para código de bajo

nivel ensamblador o bytecode. También se ha aplicado interpretación abstracta al bytecode

de Java en [BJP05] empleando el demostrador de teoremas Coq.

En este proyecto nos planteamos seguir una aproximación similar a la de

Bddbddb [WACL05] donde se especifica un análisis determinado como un programa escrito en un lenguaje lógico y se extraen los datos necesarios (la entrada del análisis) a partir

del bytecode de Java mediante un programa diseñado para tal propósito. De esta manera, la

resolución del programa lógico se corresponde esencialmente a la ejecución del análisis.

En nuestro caso, siendo la eficiencia uno de los factores clave para la aceptación de las

técnicas de análisis de programas a nivel práctico, la hemos buscado en los Besya que existen

motores de resolución para los mismos altamente eficientes. En la siguiente sección describiremos más detalladamende este proceso.

I.2.

Nuestra solución

Proponemos una traducción del lenguaje lógico de especificación Datalog a Bes de forma

que transformaremos un análisis determinado especificado mediante un programa Datalog a un

sistema de ecuaciones booleanas que será resuelto de forma eficiente gracias a los motores de

resolución existentes. La resolución del sistema de ecuaciones booleanas se corresponderá con

la resolución del análisis especificado inicialmente.

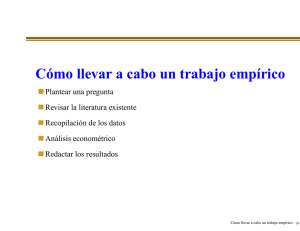

Esquemáticamente, nuestra aproximación al análisis estático consta de las siguientes fases:

1. Especificación de un análisis estático como un programa lógico en el lenguaje Datalog.

2. Extracción de la información del programa Java necesaria para el análisis mediante el

compilador JOEQ.

3. Evaluación del programa Datalog transformándolo a un Bes y evaluándolo.

4. Extracción de las soluciones del programa datalog a partir del resultado de la ejecución

del Bes asociado.

INTRODUCCIÓN AL ANÁLISIS DE PROGRAMAS

vi

Resolución guiada por objetivos. La resolución del programa Datalog propuesta

será top-down. Esto es, se partirá de las consultas u objetivos del programa y se computarán los predicados necesarios para probar la veracidad de los anteriores. En esencia, la

resolución top-down supone la construcción de un árbol de demostración desde la raı́z a las

hojas, como harı́a un demostrador de teoremas basado en resolución.

BESs on the fly.

En nuestra aproximación, la resolución del programa datalog se hace

resolviendo un Bes formalmente equivalente al primero. Este Bes no se desarrollará explı́citamente en memoria, lo que serı́a excesivamente costoso, sino que estará almacenado de forma

implı́cita en memoria y se irá generando de forma explı́cita on-the-fly, esto es, conforme avance

su resolución.

I.3.

OPEN/CÆSAR

En este proyecto usamos el marco de trabajo OPEN/CÆSAR especialmente apropiado para

desarrollar herramientas orientadas a la simulación y verificación de sistemas. OPEN/CÆSAR

ofrece la funcionalidad tı́picamente necesaria para este tipo de desarrollos tales como un

lenguaje genérico sobre el que trabajar, algoritmos de exploración o estructuras de datos

variadas. Este framework ofrece esta funcionalidad estructurada en 3 módulos distintos:

graph Ofrece una visión del sistema o programa a verificar como una sistema de transiciones

etiquetadas entre estados. Esto hace que OPEN/CÆSAR sea independiente del lenguaje

de especificación del sistema usado.

library Es un conjunto de bibliotecas. Cada una de ellas ofrece estructuras de datos y funciones para manipularlas (tablas, pilas, etc.).

exploration Determina cómo se explorará el sistema de transiciones etiquetadas entre estados, ya que contiene los algoritmos de verificación, simulación o testing.

Además, OPEN/CÆSAR está escrito en C. Por todo lo expuesto, tiene un diseño muy

genérico ofreciendo la flexibilidad necesaria para que formalismos con expresividad muy variable puedan ser adaptados al mismo. Usando las facilidades ofrecidas por OPEN/CÆSAR se

reduce el esfuerzo necesario para el desarrollo de este tipo de herramientas.

I.4.

Aportaciones originales

La aportación novedosa que supone este trabajo es doble. Por una parte, propone la

transformación de un programa datalog a un Bes equivalente, permitiendo la resolución de

ORGANIZACIÓN DEL DOCUMENTO

vii

consultas del primero mediante los motores de evaluación existentes para el segundo. Por otra

parte, aplica la idea anterior en el contexto del análisis estático a código Java.

Se ha demostrado la equivalencia formal entre un programa lógico datalog y las traducciones propuestas, fundamentando formalmente el trabajo realizado. De esta demostración,

se ha deducido que los sistemas de ecuaciones booleanas parametrizadas (Pbes, del inglés

parameterised boolean equation systems), y por ende los Bes, son al menos tan expresivos

como Datalog.

La traducción a Bes aporta todas las mejoras existentes para su resolución eficiente.

Desde este punto de vista es interesante considerar la existencia de algoritmos distribuidos

de resolucion de Bes que podrı́an aplicarse en un futuro cercano a nuestra aproximación al

análisis de programas.

En última instancia, además de las expectativas que puede suscitar la aproximación seguida, las ideas están concretadas en una herramienta real: DATALOG SOLVE.

I.5.

Organización del documento

El documento introduce progresivamente las nociones necesarias para la comprensión del

trabajo realizado dentro del proyecto.

La presente introducción expone los factores que motivan el trabajo realizado, ası́ como

en qué consiste a grandes rasgos éste. El primer capı́tulo expone los fundamentos requeridos

para la comprensión del formalismo desarrollado, ası́ como para la comprensión de la naturaleza de los problemas que éste pretende resolver y la principal aplicación del mismo. El

Capı́tulo 2 presenta el formalismo aportado para la resolución de análisis de programas. El

Capı́tulo 3 detalla, a un nivel medio, las caracterı́sticas de implementación de la aplicación

que da soporte al formalismo introducido. Las conclusiones finales presentan un resumen del

trabajo realizado, enumeran los estudios previos considerados de interés para el presente trabajo, exponen los resultados experimentales y, por último, describen la dirección que toma

en estos momentos el trabajo realizado.

viii

INTRODUCCIÓN AL ANÁLISIS DE PROGRAMAS

Capı́tulo 1

Preliminares

En este capı́tulo vamos a introducir los conceptos básicos que utilizaremos a lo largo del

texto. Estos conceptos estarán relacionados con el análisis de programas, el lenguaje lógico

Datalog y los sistemas de ecuaciones booleanas paremetrizadas.

1.1.

Análisis de programas

El análisis de programas es un subcampo de las ciencias de la computación que trata con la

obtención de aproximaciones estáticas1 lo más precisas posibles a la ejecución de programas.

1.1.1.

Conceptos básicos

Análisis de flujo de datos

El análisis de flujo de datos (del inglés data-flow analysis) se refiere a un conjunto de

técnicas que extraen información sobre el flujo de los datos a lo largo de los caminos de

ejecución de un programa.

La ejecución de un programa puede ser vista como una serie de transformaciones del

estado del programa, que consiste en los valores de todas las variables del mismo, incluyendo

aquéllas presentes en los registros de activación de la pila de ejecución. La ejecución de una

instrucción transforma un estado de entrada en un estado de salida. El estado de entrada se

asocia con el punto del programa anterior a la instrucción y el estado de salida se asocia con

el punto del programa posterior a la instrucción.

Al analizar el comportamiento de un programa, debemos considerar todas las posibles

secuencias de puntos de programa, que son llamadas caminos, a través del grafo de flujo

que puede seguir la ejecución del programa. A partir de los caminos se extrae, de todos los

1

En tiempo de compilación.

2

CAPÍTULO 1. PRELIMINARES

posibles estados del programa, la información necesaria para resolver el problema particular

de análisis de flujo de datos.

Grafo de llamadas

Un grafo de llamadas (del inglés call-graph) de un programa es un conjunto de nodos y

arcos tales que:

1. Hay un nodo por cada procedimiento en el programa

2. Hay un nodo por cada punto de llamada (del inglés call site), esto es, un punto del

programa donde se invoca un procedimiento.

3. Si el punto de llamada c puede invocar al procedimiento p, entonces existe una arista

desde el nodo asociado a c al nodo asociado a p.

Si la invocación a procedimientos es directa, el destino de la llamada puede conocerse

estáticamente. En tal caso, cada punto de llamada tendrı́a solamente un arco hacia un procedimiento en el grafo de llamadas.

Sin embargo, la norma en los lenguajes orientados a objetos con enlace dinámico es la

invocación indirecta a procedimiento —también se puede encontrar en lenguajes como C

mediante el uso de los punteros a función, o en Fortran mediante el uso de parámetros

que permiten recibir referencias a procedimiento. Especı́ficamente, cuando se sobrescribe un

método m en una subclase B de una clase A, una llamada a m sobre una variable polimórfica

de tipo A puede referirse a distintos métodos, dependiendo del objeto receptor de la misma.

El uso de esas invocaciones virtuales a método implica que se debe conocer el tipo del receptor

antes de que podamos determinar el método que es invocado.

En general, la invocación indirecta nos obliga a realizar una aproximación estática de las

condiciones en las que se realizan las llamadas a procedimientos —condiciones que pueden

ser valores de punteros a función, referencias a procedimientos o tipos de objeto receptores,

dependiendo del contexto. Dicha aproximación estática no es sino un caso particular de análisis

de programas.

Análisis intraprocedimental vs. interprocedimental

Una de las formas de clasificar el análisis de programas es según el alcance de sus técnicas

en un programa. Siguiendo esta clasificación, se distinguen los análisis intraprocedimentales

e interprocedimentales.

1.1. ANÁLISIS DE PROGRAMAS

3

Las técnicas de análisis intraprocedimental son una familia de técnicas de análisis de

programas cuyo alcance son los procedimientos a nivel local. Esto es, intentan analizar un

procedimiento independientemente de las relaciones de éste con el resto del programa. Dado

lo restringido de su ámbito, existen muchas técnicas eficientes para realizarlos. No obstante,

la información que extraen de los programas es mucho menos precisa que la que permiten

extraer técnicas cuyo ámbito sea mayor, esto es, técnicas que actúen sobre el programa de

forma global. Estas técnicas son calificadas como “interprocedimentales”, y son aquellas que

son de mayor interés dadas su gran complejidad y los valiosos resultados entregados por ellas.

1.1.2.

Análisis interprocedimental

El análisis interprocedimental es, como previamente se introdujo, un tipo de análisis cuyo

alcance es todo el programa. Por alcance total se entiende que el análisis tiene en cuenta todas

las divisiones del programa (procedimientos) a la hora de extraer información.

El análisis interprocedimental es complicado porque el comportamiento de cada procedimiento es dependiente del contexto en el cual es llamado.

Una aproximación simple al análisis interprocedimental pero a la vez muy imprecisa es

el llamado análisis insensible al contexto. En él, cada instrucción de llamada y retorno de

procedimiento se consideran instrucciones goto (salto incondicional), creando un super grafo

de flujo de control con arcos de flujo de control adicionales que unen:

1. Cada punto de llamada con el comienzo del procedimiento al que llama, y

2. cada instrucción de retorno con la siguiente instrucción a la del punto de llamada.

Además, se añaden instrucciones de asignación para copiar cada parámetro actual en

su correspondiente parámetro formal y cada valor retornado en la variable que recibe el

resultado. Entonces, se aplica un análisis estándar intraprocedimental sobre el super grafo de

flujo de control para obtener resultados interprocedimentales insensibles al contexto. Pese a

su simplicidad, este modelo elimina la relación entre los valores de entrada y salida en las

invocaciones a procedimiento. Esto se debe a que no se establece ninguna correspondencia

entre cada arco de entrada y salida a procedimiento, tratando todas las entradas y salidas al

mismo como un todo, lo que supone una fuente de imprecisión.

Cadenas de llamadas

Un contexto de llamada queda determinado por el contenido de la pila de llamadas en el

momento de realizar la invocación. Se define una cadena de llamadas (del inglés call string)

como la secuencia de puntos de llamada que hay en la pila.

4

CAPÍTULO 1. PRELIMINARES

Al diseñar un análisis sensible al contexto se puede elegir la precisión del mismo basándose

en la forma de distinguir contextos. Si se distinguen los contextos exclusivamente por los k

puntos de llamada más inmediatos tendrı́amos un análisis de contexto k-limitado. Por otra

parte, se podrı́an distinguir completamente todas las cadenas de llamadas acı́clicas (cadenas

sin ciclos recursivos) para acotar el número de contextos distintos a analizar. Las cadenas de

llamadas con recursión podrı́an simplificarse reduciendo cada secuencia recursiva de puntos

de llamada a un punto de llamada único. No obstante, aun para programas sin recursión, el

número de contextos de llamada puede ser exponencial con el número de procedimientos en

un programa.

Técnicas de análisis sensibles al contexto

Existen distintas aproximaciones para realizar análisis sensibles al contexto entre las que

destacamos dos: la que se basa en la clonación y la que se basa en el resumen.

Una análisis sensible al contexto basado en clonación consiste en clonar conceptualmente

cada procedimiento para cada contexto de interés. De esta forma, cada contexto tendrá un clon

exclusivo del procedimiento y, por lo tanto, podremos aplicar un análisis insensible al contexto

sin que haya ambigüedad (ya que cada invocación a procedimiento siempre se hará desde un

único contexto).

Un análisis sensible al contexto basado en resumen consiste en la representación de cada

procedimiento mediante una concisa descripción, el “resumen”2 , que describe parte del comportamiento observable del mismo, y usar éstas para calcular el efecto de todas las llamadas

ocurridas en el programa.

1.1.3.

¿Para qué es necesario el análisis interprocedimental?

Dada la dificultad del análisis interprocedimental, se deben remarcar las razones por las

que este tipo de análisis es útil como, por ejemplo, la optimización de invocaciones a métodos

virtuales, el análisis de punteros, la paralelización de programas, y la detección de errores y

vulnerabilidades.

Invocaciones a métodos virtuales

Los programas escritos en lenguajes orientados a objetos suelen estar compuestos de muchos métodos de tamaño reducido. Si solamente se intentaran optimizar los métodos por

separado (análisis intraprocedimental), las oportunidades para optimizar serı́an escasas dado

2

El fin del resumen es evitar analizar el cuerpo del procedimiento para cada punto de llamada que invoque

al mismo.

1.1. ANÁLISIS DE PROGRAMAS

5

su reducido tamaño. Resolver las invocaciones a métodos permite aumentar las oportunidades

de optimización.

Si el código fuente de un programa está disponible, es posible realizar un análisis interprocedimental para determinar los posibles tipos de objeto a los que podrı́a apuntar una variable

x en toda llamada a método x.m(). Si el tipo para una variable x fuera único, la invocación

al método podrı́a resolverse estáticamente y el método podrı́a desplegarse, evitando que se

realice una llamada a función al ejecutarlo.

Varios lenguajes, como Java, cargan dinámicamente sus clases, por lo que en tiempo de

compilación no sabemos qué método m será invocado para la llamada x.m(). Una optimización

común en compiladores JIT (del inglés Just-In-Time) es analizar la ejecución y ası́ determinar

los tipos más comunes. Los métodos de los tipos más comunes se despliegan y se inserta código

que compruebe dinámicamente los tipos para asegurar una ejecución correcta.

Análisis de punteros

El análisis de punteros es un tipo de análisis interprocedimental que permite saber a

qué puede apuntar un puntero en el programa. Los resultados de este análisis permiten mejorar

la precisión de otros análisis tanto interprocedimentales como intraprocedimentales.

Paralelización

La forma más efectiva de paralelizar una aplicación es encontrar la granularidad más grande de paralelismo. Para ello, el análisis interprocedimental es esencial debido a su actuación

en partes más grandes del programa (granularidad más gruesa) y a su mayor precisión, lo que

permitirá perder menos oportunidades de optimización.

Detección de errores en el software y vulnerabilidades

El análisis interprocedimental no sólo es útil para optimizar código. Sus técnicas pueden

usarse para analizar muchos tipos de errores de codificación comunes. Estos errores, que hacen

al software menos fiable, muchas veces no son detectables localmente a un procedimiento, sino

que su búsqueda requiere una exploración interprocedimental.

Si los errores son vulnerabilidades de la seguridad se hace incluso más importante su total

detección.

6

CAPÍTULO 1. PRELIMINARES

1.2.

Datalog: una representación lógica del flujo de datos

Las aproximaciones más tradicionales al análisis del flujo de datos usan una notación

basada en conjuntos del tipo “la definición D está en el conjunto ENTRADA[BLOQUE ]”.

En nuestra aproximación usamos una notación más general y condensada basada en la lógica

con la que escribiremos entrada(BLOQUE,D) para expresar lo mismo. Utilizando este tipo

de notación podremos expresar reglas, de una forma concisa, que nos permitirán deducir

hechos del programa. También nos permitirá implementar estas reglas de forma eficiente

independientemente del análisis concreto que se desee realizar. Finalmente, la aproximación

lógica nos permitirá combinar varios análisis aparentemente independientes en uno único

integrado.

1.2.1.

Sintaxis y semántica

Datalog es un lenguaje que usa una notación parecida a Prolog, pero cuya semántica

es mucho más simple. Para empezar, los componentes básicos de un programa Datalog son

átomos de la forma p(X1 , X2 , ..., Xn ), donde:

1. p es un sı́mbolo de predicado —un sı́mbolo que, por ejemplo en el caso de entrada,

podrı́a representar un tipo de afirmación como “una definición llega al comienzo de un

bloque”.

2. X1 , X2 , ..., Xn son términos que pueden ser variables o constantes.

Un átomo básico (del inglés ground atom) es un predicado con sólo constantes como argumentos. Todo átomo básico afirma un hecho particular y su valor es verdadero o falso. A

menudo es conveniente representar un predicado mediante una relación, o tabla de sus átomos

básicos verdaderos. Cada átomo básico está representado por una única fila, o tupla, de la

relación. Las columnas de la relación se llaman atributos, y cada tupla tiene un componente

para cada atributo. Los atributos correponden a los componentes de los átomos básicos representados por la relación. Todo átomo básico en la relación es verdadero y los átomos básicos

que no estén en la relación son falsos.

También se permitirán átomos con la forma de comparaciones entre variables y constantes. Un ejemplo podrı́a ser X! = Y o X = 10. En estos ejemplos, el sı́mbolo de predicado

es realmente el operador de comparación. Esto es, podemos pensar en X = 10 (una comparación) como si estuviera escrito en la forma de predicado: equals(X,10). De todas formas,

hay una diferencia importante entre los predicados de comparación y el resto. Un predicado

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

7

de comparación tiene su interpretación estándar, mientras que un predicado como entrada se

interpreta sólo en función de su definición en el programa Datalog.

Un literal es o un átomo o la negación de un átomo. Se indica la negación con la palabra

NOT delante del átomo. Ası́, N OT entrada(BLOQU E, D) es una afirmación que indica que

la definición D no alcanza el comienzo del bloque BLOQU E.

Reglas en Datalog

Las reglas son una forma de expresar inferencias lógicas. En Datalog, las reglas también

sirven para sugerir cómo deberı́a llevarse a cabo una computación de los hechos verdaderos.

La forma de una regla es:

H : −B1 &B2 &...&Bn

(1.2.1)

donde:

H y B1 , B2 , ..., Bn son literales —átomos o negaciones de átomos.

H es la cabeza y B1 , B2 , ..., Bn forman el cuerpo de la regla.

Cada uno de los Bi s a veces es llamado subobjetivo de la regla.

El sı́mbolo : − ha de ser leı́do como “si”. El sentido de una regla es “la cabeza es verdadera

si el cuerpo es verdadero”. Más precisamente, aplicamos una regla a un conjunto de átomos

básicos dado como sigue: se consideran todas las posibles sustituciones de constantes por

variables de la regla. Si una sustitución hace que todo subobjetivo del cuerpo sea verdadero

(asumiendo que solamente los átomos básicos dados son verdaderos), entonces podemos inferir

que la cabeza con esta sustitución de constantes por variables es un hecho verdadero. Las

sustituciones que no hacen todos los subobjetivos verdaderos no nos dan información; el

átomo de la cabeza podrı́a ser verdadero o no3 .

Un programa Datalog es una colección de reglas. Este programa se aplica a “datos”, esto

es, a un conjunto de átomos básicos. El resultado del programa es el conjunto de átomos

básicos inferidos mediante la aplicación sucesiva de las reglas hasta que no se puedan hacer

más inferencias.

3

El hecho de que una cabeza no se haga verdadera al aplicar una regla no implica que ésta sea falsa.

Podrı́a haber otra regla (o varias) que, al ser aplicadas, la hicieran verdadera. Por lo tanto, una cabeza sólo se

hará falsa si no es verdadera según ninguna regla.

8

CAPÍTULO 1. PRELIMINARES

Convenciones en Datalog

Los programas Datalog utilizan normalmente una serie de convenciones léxicas para facilitar su interpretación:

1. Todas las variables comienzan con letra mayúscula.

2. El resto de elementos comienzan con letra minúscula u otros sı́mbolos como los dı́gitos.

Estos elementos incluyen predicados y constantes.

Otra convención en los programas Datalog es distinguir los predicados entre:

1. EDB, del ingés Extensional Database, o Base de Datos Extensional, predicados definidos

a priori. Esto es, los hechos verdaderos de estos predicados se dan en una relación o tabla,

o se dan mediante el significado del predicado (como serı́a el caso para un predicado de

comparación).

2. IDB, del inglés Intensional Database, o Base de Datos Intensional, predicados que están

definidos mediante reglas.

Un predicado debe ser IDB o EDB, y puede ser solamente uno de estos. En consecuencia,

cualquier predicado que aparezca en la cabeza de una o más reglas debe ser un predicado

IDB. Los predicados que aparecen en el cuerpo pueden ser IDB o EDB.

Al usar programas Datalog para expresar análisis de flujo de datos, los predicados EDB

se computan a partir del grafo de flujo mismo. Los predicados IDB se definen mediante las

reglas, y el problema de flujo de datos se resuelve infiriendo todos los posibles hechos IDB a

partir de las reglas y los hechos EDB dados.

Ejecución de programas Datalog

Todo conjunto de reglas Datalog define relaciones para sus predicados IDB como una

función de las relaciones dadas por sus predicados EDB. Se comienza con la suposición de

que las relaciones IDB están vacı́as, esto es, que los predicados IDB son falsos para todos sus

posibles argumentos. Entonces, se aplican las reglas repetidamente, infiriendo nuevos hechos

cuando las reglas los requieran. Cuando el proceso converge, se finaliza, y las relaciones IDB

resultantes forman la salida del programa. Este proceso se formaliza en el Algoritmo 1:

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

9

Algoritmo 1 Evaluación simple de programas Datalog.

ENTRADA: Un programa Datalog y un conjunto de hechos para cada predicado EDB.

SALIDA: Un conjunto de hechos para cada predicado IDB.

MÉTODO: Para cada predicado p en el programa, sea Rp la relación de hechos que son

verdaderos para ese predicado. Si p es un predicado EDB, entonces Rp es el conjunto

de hechos dados para ese predicado. Si p es un predicado IDB, debemos computar Rp

ejecutando el Algoritmo 2.

Algoritmo 2 Cómputo de hechos IDB.

Para todo (predicado p ∈ IDB) hacer

Rp := ∅;

Fin Para

Mientras (Ocurran cambios a cualquier Rp ) hacer

Considera todas las posibles sustituciones de constantes por variables en todas las reglas.

Determina para cada sustitución, si todos los subobjetivo del cuerpo son verdaderos

usando los Rp s actuales para determinar la verdad de los predicados EDB e IDB.

Si (Una sustitución hace el cuerpo de una regla verdadero) Entonces

Añadir la cabeza a Rq si q es la cabeza del predicado.

Fin Si

Fin Mientras

Evaluación incremental de programas Datalog

Hay una mejora de eficiencia posible para el algoritmo anterior. Nótese que un hecho

IDB nuevo puede ser descubierto en la iteración i si se cumple que es el resultado de una

sustitución de constantes en una regla tal que al menos uno de los subobjetivos ha sido

descubierto en la iteración i − 1. La prueba para esta observación es que, si todos los hechos

entre los subobjetivos fueran conocidos en la iteración i − 2, entonces los hechos “nuevos” se

habrı́an descubierto al hacerse la sustitución de constantes en la iteración i − 1.

Para explotar esta observación, se introduce para cada predicado IDB p un predicado

nuevoP que contendrá solamente los hechos de p descubiertos en la iteración anterior. Cada regla que tenga uno o más predicados IDB entre sus subobjetivos se reemplazará por

una colección de reglas. Cada regla de la colección se forma reemplazando exactamente una

ocurrencia de algún predicado IDB q en el cuerpo, por un predicado nuevoQ. Finalmente,

para todas las reglas, se reemplazan los predicados h de la cabeza por nuevoH. Las reglas

resultantes se dice que están en forma incremental.

Las relaciones para cada predicado IDB p acumulan todos los hechos-p. En una iteración:

10

CAPÍTULO 1. PRELIMINARES

1. Se aplican las reglas para evaluar los predicados nuevoP .

2. Entonces, se substrae p de nuevoP para asegurar que los hechos en nuevoP son realmente nuevos.

3. Se añaden los hechos de nuevoP a p.

4. Se inicializan todas las relaciones nuevoX a ∅ para la siguiente iteración.

Estas ideas se formalizan en el Algoritmo 3.

Algoritmo 3 Evaluación incremental de programas.

ENTRADA Un programa Datalog y un conjunto de hechos para cada predicado EDB.

SALIDA Un conjunto de hechos para cada predicado IDB.

MÉTODO Para cada predicado p en el programa, sea Rp la relación de hechos que son

verdaderos para ese predicado. Si p es un predicado EDB, entonces Rp es el conjunto

de hechos dados para ese predicado. Si p es un predicado IDB, debemos computar Rp .

Además, para cada predicado IDB p, sea RnuevoP la relación de hechos “nuevos” para

el predicado p.

1. Modifar las reglas a su forma incremental según las explicaciones dadas anteriormente.

2. Ejecutar el Algoritmo 4.

Reglas Datalog problemáticas

Hay ciertas reglas Datalog que técnicamente no tienen sentido y, por lo tanto, no deberı́an

usarse. Los riesgos importantes son los siguientes:

1. Reglas inseguras: aquellas que tienen una variable en la cabeza que no aparece en el

cuerpo. En este caso, la variable en cuestión no está restringida y puede tomar cualquier

valor de su dominio.

2. Programas no estratificados: conjuntos de reglas que tienen recursión en la que interviene

una negación.

Para evitar las reglas inseguras cualquier variable que aparezca en la cabeza de una regla

debe también aparecer en el cuerpo. Además, la aparición no puede ser únicamente en un

átomo negado, en un operador de comparación, o en los dos. La razón para esta polı́tica es

evitar reglas que nos permitan inferir un número infinito de hechos.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

11

Algoritmo 4 Cómputo incremental de hechos IDB.

Para todo ( predicado p ∈ IDB) hacer

Rp := ∅

RnuevoP := ∅

Fin Para

Repite

Considera todas las posibles sustituciones de constantes por variables en todas las reglas.

Determina para cada sustitución si todos los subobjetivos del cuerpo son verdaderos,

usando los Rp s y RnuevoP s actuales para determinar la verdad de los predicados EDB

e IDB.

Si (Una sustitución hace el cuerpo de una regla verdadero) Entonces

Añadir la cabeza a Rn uevoH si h es la cabeza del predicado.

Fin Si

Para todo ( predicado p ) hacer

RnuevoP = RnuevoP − Rp

Rp = Rp ∪ RnuevoP

Fin Para

Hasta (∀RnuevoP = ∅)

Para que un programa esté estratificado, la recursión y la negación han de separarse. El

requisito formal es el siguiente. Debe ser posible dividir los predicados IDB en estratos, tal que

si hay una regla con un predicado p en la cabeza y un subobjetivo de la forma N OT q(· · ·),

entonces q es, o bien un predicado EDB, o es un predicado IDB en un estrato más bajo que

el de p. Mientras se satisfaga esta regla, se podrá evaluar el estrato más bajo mediante un

algoritmo convencional y, entonces, tratar las relaciones para los predicados IDB de ese estrato

como si fueran EDB para la computación de un estrato más alto. No obstante, si violamos

esa regla, entonces el algoritmo iterativo podrá no converger.

1.2.2.

Un algoritmo de análisis de punteros sencillo

En esta sección se introducirá un algoritmo muy sencillo de análisis de punteros insensible

al flujo de datos asumiendo que no hay llamadas a procedimiento. Más adelante se extenderá para que tenga en cuenta llamadas a procedimiento de forma sensible e insensible al

contexto. La sensibilidad al flujo añade mucha complejidad y es menos importante que la

sensibilidad al contexto para lenguajes como Java donde los métodos tienden a ser pequeños.

La pregunta fundamental del análisis de punteros es si dados un par de punteros, éstos

pueden ser aliados. Una forma de responder a esta pregunta es computando para cada puntero

la respuesta a esta otra pregunta: “¿a qué objetos puede apuntar este puntero?”. Si dos

punteros pueden apuntar al mismo objeto, entonces los punteros podrı́an estar aliados.

12

CAPÍTULO 1. PRELIMINARES

¿Por qué el análisis de punteros es difı́cil?

El análisis de punteros para programas en C es particularmente difı́cil porque los programas

C pueden realizar computaciones arbitrarias sobre los punteros. De hecho, se puede leer un

entero y asignarlo a un puntero, lo que convertirı́a este puntero en un potencial alias para todas

las otras variables puntero del programa. Los punteros en Java, conocidos como referencias,

son mucho más simples. No se permite realizar aritmética con ellos y sólo pueden apuntar al

comienzo de un objeto.

El análisis de punteros debe ser interprocedimental. Sin análisis interprocedimental, uno

debe asumir que cualquier método que sea llamado puede cambiar el contenido de todas las

variables puntero accesibles, haciendo inefectivo cualquier análisis intraprocedimental.

Los lenguajes que permiten llamadas a función indirectas representan un reto adicional

para el análisis de punteros. En C, se puede invocar una función indirectamente llamando a

un puntero a función. Es necesario conocer a qué puede apuntar el puntero a función antes de

que se pueda analizar la función llamada. Y, además, después de analizar la función llamada,

pueden descubrirse más funciones a las que el puntero a función podı́a apuntar, y, como

consecuencia de esto, el proceso necesita ser iterativo.

Mientras que la mayor parte de las funciones se llaman directamente en C, los métodos

virtuales en Java causan que muchas invocaciones sean indirectas. Dada una invocación x.m()

en un programa Java, puede haber muchas clases a las que el objeto x podrı́a pertenecer y que

tienen un método llamado m. Cuanto más preciso sea nuestro conocimiento del tipo real de

x, más preciso será nuestro grafo de llamadas. Idealmente, podrı́amos determinar en tiempo

de compilación la clase exacta de x y, ası́, saber exactamente a qué método se refiere m.

Es posible aplicar aproximaciones que reduzcan el número de objetivos posibles de una

llamada. Por ejemplo, se puede determinar estáticamente cuáles son todos los tipos de objetos

creados, y podemos limitar el análisis a esos tipos. Pero podemos ser más precisos si descubrimos el grafo de llamadas on-the-fly 4 , basándonos en el análisis de punteros obtenido de

forma simultánea. El aumento de la precisión del grafo de llamadas lleva no sólo a resultados

más precisos, sino a reducir también el tiempo de análisis.

Como ya hemos dicho, el análisis de punteros es complicado. A medida que se descubren

nuevos valores posibles para un puntero, todas las instrucciones que asignan los contenidos

de ese puntero a otro puntero deben analizarse otra vez.

4

Se puede traducir como “al vuelo” o “bajo demanda”.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

13

Un modelo para punteros y referencias

Supongamos que nuestro lenguaje tiene las siguientes formas de representar y manipular

referencias:

1. Algunas variables de programa son del tipo “puntero a T ” o “referencia a T ,” donde T

es un tipo. Estas variables son, o bien estáticas o bien viven en la pila de ejecución. Las

llamaremos simplemente variables.

2. Hay un heap de objetos. Todas las variables apuntan a objetos del heap y no a otras

variables. Estos objetos serán llamados “objetos del heap”.

3. Un objeto del heap puede tener campos, y el valor de un campo puede ser una referencia

a un objeto del heap (pero no a una variable).

Java se puede modelar adecuadamente con esta estructura. C se modela peor ya que las

variables puntero pueden apuntar a otras variables puntero y, en principio, cualquier valor

puede ser visto como un puntero.

Dado que estamos realizando un análisis insensible al flujo, solamente tenemos que afirmar

que una variable v puede apuntar a un objeto h del heap dado. Ası́ pues, no tenemos que

preocuparnos del problema de en qué lugar del programa v puede apuntar a h, o en qué contextos v puede apuntar a h. Las variables serán identificadas mediante sus nombres completos

—que podrı́a incluir el nombre del paquete, clase, método y bloque en el que está definida—,

permitiendo ası́ distinguir entre variables con el mismo identificador.

Los objetos del heap no tienen nombre. Una convención para referirse a estos objetos

es mediante la instrucción en la que fueron creados. Como una instrucción puede ejecutarse

varias veces creando múltiples objetos, una afirmación como “v puede apuntar a h” en realidad

quiere decir “v puede apuntar a uno o más de los múltiples objetos creados en la instrucción

etiquetada con h”.

El objetivo del análisis es determinar a qué puede apuntar cada variable y cada campo de cada objeto del heap. Nos referimos a esto como “análisis de punteros” (en inglés

points-to analysis); dos punteros están aliados si la intersección de sus conjuntos points-to 5

es no vacı́a. El análisis que se describirá será inclusion-based (basado en la inclusión); esto es,

una instrucción como v = w causa que una variable v pueda apuntar a todos los objetos a los

que puede apuntar w pero no al revés. Aunque esta aproximación parezca evidente, existen

otras alternativas como el análisis equivalence-based (basado en la equivalencia) en el que la

5

Por comodidad, usaremos la denominación en inglés, conjunto points-to, para referirnos al conjunto de

objetos del heap al que puede apuntar un puntero.

14

CAPÍTULO 1. PRELIMINARES

instrucción v = w convertirı́a a v y w en una clase de equivalencia, permitiendo ası́ que cada

una de ellas apunte a todos los objetos a los que puedan apuntar las dos. A pesar de que esta

última formulación no aproxima bien las alianzas de punteros, provee una rápida, y a menudo

buena, respuesta a la pregunta de qué variables apuntan al mismo tipo de objetos.

Insensibilidad al flujo

Un análisis sensible al flujo se guı́a por el flujo de control del programa añadiendo la

información de cada instrucción requerida para el análisis pero, a la vez, teniendo en cuenta

los efectos que la nueva información tiene sobre la que se tenı́a antes.

Un análisis insensible al flujo ignora el flujo de control, lo que, en esencia, asume que

toda instrucción del programa podrı́a ser ejecutada en cualquier orden. Computa un mapa

points-to indicando a qué puede apuntar cada variable en cualquier punto de ejecución del

programa. Si una variable puede apuntar a dos objetos diferentes en un programa, registramos

que puede apuntar a ambos objetos. En otras palabras, en un análisis insensible al flujo, una

asignación no “mata” ninguna relación points-to, sino que “genera” más relaciones points-to.

Para computar los resultados insensibles al flujo, se añaden repetidamente los efectos points-to

de cada instrucción sobre la relación points-to hasta que no se encuentren nuevas relaciones.

Claramente, la falta de sensibilidad al flujo hace que los resultados del análisis sean más

pobres pero tiende a reducir el tamaño de la representación de los resultados y hace que el

algoritmo converja más rápidamente.

La formulación en Datalog

Ahora se propondrá la formalización en Datalog del análisis de punteros insensible al

flujo discutido anteriormente. De momento se ignorarán las llamadas a procedimiento y nos

concentraremos en los cuatro tipos de instrucción que pueden afectar a los punteros:

1. Creación de un objeto “h : T v = new T ();”: Esta instrucción crea un nuevo objeto

del heap, y la variable v puede apuntar a él.

2. Instrucción de copia “v = w;”: Aquı́, v y w son variables. La instrucción hace a v

apuntar a todo objeto del heap al que w pueda apuntar en ese momento.

3. Almacenamiento en un campo “ v.f = w;”: El tipo de objeto al que apunta v debe

tener un campo f , y este campo debe ser de algún tipo referencia. Si v es un puntero a

un objeto del heap h, y w apunta a g, esta instrucción hace que el campo f de h ahora

apunte a g. Nótese que la variable v se deja inalterada.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

15

4. Cargar de un campo “v = w.f ;”: Aquı́, w es una variable apuntando a algún objeto

del heap que tiene un campo f , y f apunta a algún objeto del heap h. La instrucción

hace que la variable v apunte a h.

Nótese que accesos compuestos a campos en el código fuente, como v = w.f.g, se pueden

desglosar en varios accesos más primitivos como:

v1 = w.f ;

v = v1.g;

Sólo queda expresar formalmente el análisis en reglas de Datalog. Primero, definiremos dos

tipos de predicados IDB:

1. pts(V, H) quiere decir que la variable V puede apuntar al objeto del heap H.

2. hpts(H, F, G) quiere decir que el campo F del objeto del heap H puede apuntar al objeto

del heap G.

Las relaciones EDB se construyen a partir del programa mismo. Dado que la localización

de las instrucciones en un programa es irrelevante cuando el análisis es insensible al flujo,

sólo debe incluirse en la base de datos EDB la existencia de instrucciones que tengan ciertas

formas. En lo que sigue se hará una simplificación. En lugar de definir las relaciones EDB para

que guarden la información extraı́da del programa, usaremos una instrucción entre comillas

para sugerir la relación o relaciones EDB que representen la existencia de tal instrucción.

Por ejemplo, “H : T V

= new T ” es un hecho EDB que afirma que en la instrucción

en la posición H hay una asignación que hace que la variable V apunte a un nuevo objeto

de tipo T . Asumiremos que, en la práctica, habrá una relación EDB correspondiente que

contendrá átomos básicos, uno para cada instrucción de esta forma en el programa.

Con esta convención todo lo que necesitamos para escribir el programa Datalog es una

regla para cada uno de los cuatro tipos de instrucción:

En la Figura 1.1 la regla (1) dice que la variable V puede apuntar al objeto del heap H

si la instrucción H es una asignación del nuevo objeto a V . La regla (2) dice que si hay una

instrucción de copia V

= W , y W puede apuntar a H, entonces V puede apuntar a H.

La regla (3) dice que si hay una instrucción de la forma V.F = W , W puede apuntar a

G, y V puede apuntar a H, entonces el campo F de H puede apuntar a G. Finalmente, la

regla (4) dice que si hay una instrucción de la forma V = W.F , W puede apuntar a G, y el

campo F de G puede apuntar a H, entonces V puede apuntar a H. Nótese que pts y hpts son

mutuamente recursivos, pero este programa Datalog puede ser evaluado por cualquiera de los

algoritmos iterativos expuestos previamente ya que cumple las condiciones.

16

CAPÍTULO 1. PRELIMINARES

1) pts(V, H)

: − “H : T V = new T ”

2) pts(V, H)

: − “V = W ” &

pts(W, H)

3) hpts(H, F, G) : − “V.F = W ” &

pts(W, G) &

pts(V, H)

4) pts(V, H)

: − “V = W.F ” &

pts(W, G) &

hpts(G, F, H)

Figura 1.1: Programa Datalog para el análisis de punteros insensible al flujo.

Usando la información sobre tipos

Como Java tiene un sistema de tipos seguro, las variables pueden apuntar solamente a tipos

que sean compatibles con los tipos declarados. Una asignación que no sea segura generará una

excepción en tiempo de ejecución. Por ello introduciremos en nuestro análisis predicados EDB

que reflejen la importante información de tipos del código a analizar:

1. vT ype(V, T ) dice que la variable V se ha declarado como de tipo T .

2. hT ype(H, T ) dice que el objeto de heap H se creó con el tipo T . El tipo de un objeto

creado puede no ser conocido de forma precisa si, por ejemplo, el objeto es devuelto

por un método nativo. Esos tipos son modelados conservativamente como “todos los

posibles tipos”.

3. assignable(T, S) dice que un objeto del tipo S puede ser asignado a una variable del

tipo T . Esta información generalmente se extrae de la declaración de subtipos en el

programa, pero también incorpora información sobre las clases predefinidas del lenguaje.

El predicado assignable(T, T ) siempre es verdadero.

Podemos modificar las reglas propuestas anteriormente en la Figura 1.1 para permitir inferencias sólo si la variable asignada recibe un objeto del heap de un tipo asignable. Las reglas

se muestran en la Figura 1.2.

La primera modificación es para la regla (2). Los últimos tres subobjetivos dicen que

podemos concluir que V puede apuntar a H solamente si: V tiene tipo T , H tiene tipo S y

si los objetos de tipo S pueden ser asignados a las variables de tipo T . La regla (4) ha sido

modificada de forma similar. Nótese que no hay restricción adicional en la regla (3) porque

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

1) pts(V, H)

: − “H : T V = new T ”

2) pts(V, H)

: − “V = W ” &

pts(W, H) &

vT ype(V, T ) &

hT ype(H, S) &

assignable(T, S)

17

3) hpts(H, F, G) : − “V.F = W ” &

pts(W, G) &

pts(V, H)

4) pts(V, H)

: − “V = W.F ” &

pts(W, G) &

hpts(G, F, H)

vT ype(V, T ) &

hT ype(H, S) &

assignable(T, S)

Figura 1.2: Restricciones de tipo añadidas al análisis de punteros insensible al flujo.

todas los almacenamientos deben ir a través de variables. Cualquier restricción de tipo sólo

captarı́a un caso extra, cuando el objeto base fuera la constante “null”.

1.2.3.

Análisis interprocedimental insensible al contexto

Ahora consideraremos las invocaciones a método. Primero explicaremos cómo se puede

usar el análisis de punteros para computar un grafo de llamadas preciso que sea útil a la

hora de obtener resultados precisos del análisis de punteros. Después se formalizará el cálculo

del grafo de llamadas on-the-fly y se mostrará cómo se puede usar Datalog para describir

sucintamente los análisis.

Efectos de una invocación a método

Los efectos de una llamada a método como x = y.n(z) en Java sobre las relaciones

points-to pueden ser computados como sigue:

1. Se determina el tipo del objeto receptor, que es el objeto al que apunta y. Supongamos

que su tipo es t. Sea m el método llamado n en la superclase de t más cercana que tenga

un método llamado n. Nótese que, en general, el método que se invocará sólo podrá ser

determinado dinámicamente.

18

CAPÍTULO 1. PRELIMINARES

2. Los parámetros formales de m reciben la asignación de los objetos apuntados por los

parámetros actuales. Los parámetros actuales incluyen no sólo los parámetros pasados

directamente sino también el objeto receptor mismo. Toda invocación a método asigna

a la variable (implı́cita) this el objeto receptor. Nos referiremos a las variables this

como al parámetro formal número 0 de un método. En x = y.n(z) hay dos parámetros

formales: el objeto apuntado por y es asignado a la variable this y el objeto apuntado

por z es asignado al primer parámetro formal declarado para m.

3. Se asigna el objeto devuelto por m a la variable del lado izquierdo de la instrucción de

asignación.

En el análisis insensible al contexto los parámetros y los valores devueltos se modelan

mediante instrucciones de copia. La pregunta interesante que queda por contestar es cómo

determinar el tipo del objeto receptor. Podemos, de forma conservadora, determinar el tipo de

acuerdo con la declaración de la variable; por ejemplo, si la variable declarada tiene el tipo t,

entonces sólo métodos llamados n en subtipos de t pueden ser invocados. Desafortunadamente,

si la variable declarada tiene el tipo Object, entonces todos los métodos con nombre n son

destinos potenciales. En programas cotidianos que usan intensivamente jerarquı́as de objetos e

incluyen librerı́as enormes, una aproximación tal puede resultar en muchos destinos espurios,

haciendo el análisis lento e impreciso.

Necesitamos conocer a qué pueden apuntar las variables para calcular los destinos de las

llamadas; pero a menos que conozcamos los destinos de las llamadas, no podremos descubrir a

qué pueden apuntar todas las variables. Esta relación recursiva requiere que descubramos los

destinos on-the-fly mientras computamos las relaciones points-to. El análisis continúa hasta

que no hay nuevos destinos de llamada ni nuevas relaciones de tipo points-to.

Descubrimiento del grafo de llamadas en Datalog

Para formular las reglas Datalog para el análisis interprocedimental insensible al contexto,

introducimos tres predicados EDB, cada uno de los cuales se obtiene fácilmente a partir del

código fuente:

1. actual(S, I, V ) dice que V es el I-ésimo parámetro actual usado en el punto de llamada

S.

2. f ormal(M, I, V ) dice que V es el I-ésimo parámetro formal declarado en el método M .

3. cha(T, N, M ) dice que M es el método llamado cuando N es invocado sobre un objeto

receptor del tipo T —cha viene del inglés “class hierarchy analysis”, análisis de la

jerarquı́a de clases.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

19

1) invokes(S, M ) : − ‘‘S : V.N (. . .)’’ &

pts(V, H) &

hT ype(H, T ) &

cha(T, N, M )

2) pts(V, H)

: − invokes(S, M ) &

f ormal(M, I, V ) &

actual(S, I, W ) &

pts(W, H)

3) pts(V, H)

: − ‘‘S : V = W.N (. . .)’’ &

invokes(S, M ) &

returns(M, X) &

pts(X, H)

Figura 1.3: Programa Datalog para el descubrimiento del grafo de llamadas

Cada arco del grafo de llamadas está representado por un predicado IDB invokes. Mientras

descubrimos más arcos del grafo de llamadas, se crean más relaciones points-to al introducir

parámetros en el procedimiento y extraer valores de retorno. Este efecto se resume en las

reglas mostradas en la Figura 1.3.

La primera regla computa el destino de una invocación del punto de llamada. Esto es,

“S : V.N (. . .)” dice que hay un punto de llamada etiquetado como S que invoca a un método

llamado N sobre el objeto receptor apuntado por V . Los subobjetivos dicen que si V puede

apuntar al objeto del heap H, que se creó con el tipo T , y M es el método usado cuando N es

invocado sobre objetos del tipo T , entonces el punto de llamada S puede invocar al método

M.

La segunda regla dice que si el punto de llamada S puede llamar al método M , entonces cada parámetro formal de M puede apuntar donde pueda apuntar su correspondiente

parámetro actual de la llamada.

Si combinamos estas reglas con las explicadas en la Sección 1.2.2 tenemos un análisis de

punteros insensible al contexto que usa un grafo de llamadas que se calcula on-the-fly. Este

análisis tiene el efecto lateral de crear un grafo de llamadas usando un análisis de punteros

insensible al flujo y al contexto. No obstante, este grafo de llamadas es significativamente

más preciso que el que se podrı́a computar basándose sólo en declaraciones de tipo y análisis

sintáctico.

20

CAPÍTULO 1. PRELIMINARES

Carga dinámica y reflexión

Lenguajes como Java permiten la carga dinámica de clases. En este caso es imposible

analizar todo el código que puede ejecutar un programa, y, por lo tanto, es imposible proporcionar estáticamente aproximaciones conservadoras de los grafo de llamadass o de los análisis

de punteros. El análisis estático sólo puede proporcionar una aproximación basándose en el

código analizado.

Incluso si asumimos que se pretende analizar todo el código a ejecutar, hay una complicación adicional que imposibilita un análisis conservador: la reflexión. La reflexión permite a

un programa determinar dinámicamente los tipos de los objetos a crear, los nombres de los

métodos a invocar, y los nombres de los campos a los que se desea acceder. Los nombres de

tipo, método y campo pueden calcularse o bien ser datos de entrada de usuario, ası́ que, por

lo general, la única aproximación es la de asumir el universo.

A pesar de que un gran número de enormes programas en Java usan reflexión, éstos

suelen usar ciertas convenciones. En particular, mientras que la aplicación no redefina el

cargador de clases, se puede conocer la clase del objeto si se conoce su nombre. Un análisis de

punteros podrı́a permitirnos encontrar dicho nombre si está determinado estáticamente o, al

menos, podrı́a permitirirnos conocer en qué lugar del programa se define el mismo si es que

se construye con datos del usuario.

De forma similar, se pueden usar otras construcciones de los lenguajes como, por ejemplo,

los castings para aproximar el tipo de los objetos creados dinámicamente, siempre y cuando

no se redefina en el programa el comportamiento de dichas construcciones.

1.2.4.

Análisis de punteros sensible al contexto

Al principio de la Sección 1.1.2, se expuso cómo la sensibilidad al contexto puede aumentar considerablemente la precisión de los análisis interprocedimentales. Se habló de dos

aproximaciones al análisis interprocedimental, una basada en la clonación y otra basada en

los resúmenes.

El cálculo de resúmenes de información points-to es difı́cil. Primero, los resúmenes son

grandes: el resumen de cada método debe incluir el efecto de todas las actualizaciones en

función de los parámetros de entrada que la función, incluyendo los métodos llamados por

ésta, puede realizar. Esto es, un método puede cambiar la información points-to de todos

los datos alcanzables mediante variables estáticas, parámetros de entrada y todos los objetos

creados por el mismo método y sus métodos invocados. Pese a las muchas propuestas que ha

habido para realizar esta aproximación, ninguna ha podido escalar para analizar programas

grandes.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

21

Por lo tanto, se presentará una análisis sensible al contexto basado en clonación. Este tipo

de análisis clona los métodos para cada uno de los contextos de interés. Después, aplica un

análisis insensible al contexto sobre el grafo clonado. Aunque esta aproximación pueda parecer

sencilla, tiene la dificultad de la gestión de un número enorme de clones. En un aplicación

Java tı́pica es común encontrar 1014 contextos, cuya representación supone un reto.

La discusión del presente análisis se realizará en dos partes:

1. ¿Cómo manejar lógicamente la sensibilidad al contexto?

2. ¿Cómo representar el número exponencial de contextos?

Como se mostrará, esta aproximación es un ejemplo de la importancia de la abstracción.

Primero se eliminará la complejidad algorı́tmica debida a la gestión de información de la

especificación del análisis, que quedará reflejado en sólo algunas lı́neas en Datalog. Luego en

esta sección, se revisará una representación genérica de un programa Datalog en diagramas de

decisión binarios que permita su cómputo eficiente. Nuestra propuesta de representación de un

programa Datalog será expuesta en el Capı́tulo 2. Los beneficios de seguir esta aproximación

son numerosos:

1. Se podrá reutilizar todo el conocimiento aplicado a estructuras de datos altamente

eficientes a cualquier análisis especificado en Datalog.

2. La implementación del análisis será automática (una traducción de la especificación) y,

por lo tanto, es más probable su corrección.

3. Se podrán reutilizar los resultados de un análisis para mejorar otros.

4. Se podrá manipular las especificaciones de los análisis más fácilmente, permitiendo crear

nuevos análisis más complejos.

Contextos y cadenas de llamadas

El análisis de punteros sensible al contexto que se describirá asumirá que se posee un

grafo de llamadas ya computado. Este paso es necesario para poder representar de una forma

compacta la enorme cantidad de contextos que surgirán. Para obtener el grafo de llamadas,

primero se ejecutará un análisis de punteros insensible al contexto que compute el grafo de

llamadas on-the-fly, como se mostró en la Sección 1.2.3. A continuación, se mostrará como

crear un grafo de llamadas clonado.

Un contexto es la representación de la cadena de llamadas que forma la historia de las

llamadas a función activas. Otra forma de ver un contexto es como un resumen de la secuencia

22

CAPÍTULO 1. PRELIMINARES

de llamadas cuyos registros de activación están, en ese momento, en la pila de ejecución. Si

no hay funciones recursivas en la pila, entonces la cadena de llamadas —la secuencia de

posiciones desde las que las llamadas activas se hicieron— es una representación completa.

También es una representación aceptable en el sentido de que sólo hay una número finito de

contextos diferentes, aunque esa cifra pueda ser exponencial con el número de funciones en el

programa.

Sin embargo, si hay funciones recursivas en el programa, entonces el número de cadenas

de llamadas posibles es infinito, y no se pueden considerar todas las cadenas de llamadas

como contextos diferentes. Hay diversas formas de limitar el número de contextos distintos.

Se optará por usar un esquema sencillo, en el que se capturará la historia de las funciones no recursivas, mientras que las recursivas se considerarán demasiado complicadas para

desenmarañar.

Primero se buscan todos los conjuntos de funciones mutuamente recursivas en el programa. Para ello, se calcula el conjunto de componentes fuertemente conexas (CFCs) del grafo

obtenido a partir del programa en el que:

1. Los nodos son las funciones.

2. Existe un arco del nodo p al q si la función p llama a la función q.

Cada componente fuertemente conexa es un conjunto de funciones mutuamente recursivas. Se considerará CFC no-trivial, a aquella que tenga más de un miembro (mutuamente

recursivos), o si tiene un solo miembro recursivo. Un CFC con un único miembro no recursivo

será considerado un CFC trivial.

La limitación que se impondrá al número de contextos distintos posibles seguirá la siguiente

regla: dada una cadena de llamadas, se eliminará la ocurrencia del punto de llamada s si

1. s está en una función p.

2. La función q es llamada en el punto de llamada s (q = p es posible).

3. p y q están en la misma componente fuertemente conexa, esto es, si p y q son mutuamente

recursivos, o si p = q y p es recursivo).

El resultado de aplicar esta regla es que, cuando se invoca un miembro de una CFC notrivial S, el punto de llamada para esa llamada forma parte del contexto, pero las llamadas

realizadas dentro de S a otras funciones de la misma CFC no forman parte del contexto.

Finalmente, cuando se realiza una llamada afuera de S, se registra su punto de llamada como

parte del contexto.

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

23

1) pts(V, C, H) : − “H : T V = new T ()” &

CSinvokes(H, C, , )

2) pts(V, C, H) : − “V = W ” &

pts(W, C, H)

3) hpts(H, F, G) : − “V.F = W ” &

pts(W, C, G) &

pts(V, C, H)

4) pts(V, C, H) : − “V = W.F ” &

pts(W, C, G) &

hpts(G, F, H)

5) pts(V, D, H) : − CSinvokes(S, C, M, D) &

f ormal(M, I, V ) &

actual(S, I, W ) &

pts(W, C, H)

Figura 1.4: Programa Datalog para análisis de punteros sensible al contexto.

Ahora se describirá cómo derivar el grafo clonado. Cada método clonado está identificado

por el método en el programa M y un contexto C. Los arcos se definen añadiendo los correspondientes contextos a cada uno de los arcos del grafo de llamadas original. En el original, existirá un arco enlazando el punto de llamada S con el método M si el predicado invokes(S, M )

es verdadero. Con vistas a añadir contextos para identificar métodos en el grafo de llamadas clonado, podemos definir un predicado CSinvokes tal que CSinvokes(S, C, M, D) sea

verdadero si el punto de llamada S en el contexto C llama al contexto D del método M .

Añadiendo contexto a las reglas Datalog

Para realizar un análisis sensible al contexto, podemos aplicar el mismo análisis insensible

al contexto al grafo de llamadas clonado. Pero, ya que un método en el grafo de llamadas

clonado se representa mediante el método original y su contexto, revisaremos todas las reglas

de Datalog para tener esto en cuenta. Por simplicidad, las reglas mostradas en la Figura 1.4

no incluirán restricciones de tipo, y los “ ” representarán a cualquier variable nueva.

Se debe notar la necesidad de definir un argumento adicional que represente el contexto en

el predicado pts. pts(V, C, H) dice que la variable V en el contexto C puede apuntar al objeto

del heap H. Las reglas son auto-explicativas salvo, quizás, la número 5. La regla 5 dice que

si el punto de llamada S en el contexto C llama al método M con contexto D, entonces los

parámetros formales en el método M con contexto D podrı́an apuntar a los objetos apuntados

24

CAPÍTULO 1. PRELIMINARES

por sus correspondientes parámetros actuales en el contexto C.

Observaciones adicionales sobre la sensibilidad

La formulación de sensibilidad al contexto descrita en esta sección ha resultado lo suficientemente práctica como para manejar programas Java reales (usando la implementación

que se describirá en la siguiente sección). No obstante, este algoritmo aún no puede analizar

las aplicaciones Java más grandes.

Los objetos del heap en esta formulación se nombran a partir de su punto de llamada,

pero sin sensibilidad al contexto. Esta simplificación puede causar problemas. Por ejemplo,

con el patrón factorı́a de objetos, en el que los objetos del mismo tipo son creados por la

misma rutina. El esquema actual harı́a que todos los objetos de esa clase compartieran el

mismo nombre. Serı́a fácil resolver esa situación desplegando el código de creación en lugar

de tenerlo en una rutina. En general, es deseable aumentar la sensibilidad al contexto en la

nominación de los objetos. Aunque es fácil añadir sensibilidad al contexto a los objetos en la

formulación en Datalog, no lo es conseguir que dicho análisis escale bien a programas grandes.

Otro tipo de sensibilidad importante es la sensibilidad objetual. Una técnica sensible a los

objetos puede distinguir entre métodos invocados sobre distintos objetos receptores, haciendo

el análisis más preciso. En el hipotético caso en el que en un punto de llamada la variable

sobre la que se invoca el método pueda apuntar a dos objetos distintos de la misma clase

—por lo tanto los campos de dichos objetos podrı́an apuntar a objetos distintos. Si no se

distingue entre un objeto u otro durante la llamada, una copia de campos sobre los mismos

con la referencia implı́cita this crearı́a relaciones espurias, esto es, disminuirı́a la precisión del

análisis. Para ciertos análisis la sensibilidad objetual puede ser más útil que la sensibilidad al

contexto.

1.2.5.

Implementación de Datalog mediante DDBs

Los diagramas de decisión binarios (DDBs) son un formalismo para representar funciones

n

booleanas mediante grafos. Ya que hay 22 funciones booleanas de n variables, ningún tipo de

representación va a resultar compacta para todas ellas. No obstante, las funciones booleanas

que aparecen en la práctica tienden a ser muy regulares. Por lo tanto, es común encontrar

una representación compacta con DDBs para funciones de interés.

Es un hecho que las funciones booleanes descritas por los programas Datalog que especifican análisis no son una excepción. La aproximación mediante DDBs obtiene representaciones

compactas de la información de análisis y supera a los sistemas de gestión de bases de datos

1.2. DATALOG: UNA REPRESENTACIÓN LÓGICA DEL FLUJO DE DATOS

25

convencionales porque, estos últimos, están diseñados para patrones de datos más irregulares,

tı́picos de la información comercial.

A continuación se introducirá la notación DDB. Luego, se sugerirá cómo representar datos

relacionales como DDBs, y cómo manipular estos DDBs para reflejar las operaciones relacionales realizadas en la ejecución de un programa Datalog. Finalmente, se describirá el modo

de representar un número exponencial de contextos con DDBs, que es el factor clave para el

éxito del uso de DDBs en el análisis sensible al contexto.

Diagramas de decisión binarios

Un DDB representa una función booleana mediante un grafo dirigido acı́clico (GDA) con

raı́z. Cada uno de los nodos del interior del GDA está etiquetado con una de las variables de

la función representada. En el extremo del grafo hay dos hojas, una etiquetada con un 0 y

la otra con un 1. Cada nodo interior tiene dos arcos a sus hijos; estos arcos se llaman low y

high. El arco low está asociado con el caso en el que la variable del nodo origen de dicho arco

tiene valor 0, y el arco high está asociado con el caso en el que la variable anterior tiene valor

1.

Dada una asignación de valores de verdad a las variables, se puede comenzar en la raı́z

y en cada nodo etiquetado con una x, seguir el arco low o high, dependiendo de si el valor

de verdad para x es 0 o 1, respectivamente. Si se llega a una hoja etiquetada 1, entonces la

función representada es verdadera para esta asignación de valores de verdad; en otro caso, la

función es falsa.

Pese a no ser un requisisto necesario, es conveniente restringir el uso de los DDBs a DDBs

ordenados ya que es más fácil operar sobre los mismos. En un DDB ordenado, hay un orden

x1 , x2 , . . . , xn de las variables, y cada vez que haya un arco de un nodo padre etiquetado xi a

un nodo hijo etiquetado xj , se debe cumplir que i < j. En lo sucesivo, se asumirá que todos

los DDBs están ordenados.

Transformaciones sobre DDBs

Hay dos simplificaciones sobre los DDBs que ayudan a compactarlos:

1. Cortocircuito: Si un nodo N tiene arcos high y low que van al mismo nodo M , entonces

podemos eliminar N . Los arcos que antes incidı́an sobre N pasan a incidir sobre M .

2. Fusión de nodos: Si dos nodos N y M tienen arcos low que van al mismo nodo, y

también tienen arcos high que van al mismo nodo, entonces podemos fusionar N con

26

CAPÍTULO 1. PRELIMINARES

M . Los arcos que incidı́an sobre N o M pasan a incidir sobre el nodo resultado de la

fusión.

Representando relaciones mediante DDBs

Las relaciones con las que tratamos tienen componentes extraı́dos de “dominios”. Un

dominio para una componente de una relación es el conjunto de los posibles valores que

pueden tener las tuplas en ese componente. Por ejemplo, la relación pts(V, H) tiene el dominio

de todas las variables del programa para su primera componente y el dominio de todas las

instrucciones de creación de objetos para la segunda componente. Si un dominio tiene más de

2n−1 valores posibles pero no más de 2n valores, entonces requiere n bits o variables booleanas

para representar valores en ese dominio.

Luego una tupla en una relación puede ser vista como una asignación de valores de verdad

a las variables que representan los valores de los dominios para cada una de las componentes

de la tupla. Una relación, entonces, podrı́a ser vista como una función booleana que devuelva

verdadero para todas las asignaciones de valores de verdad que representan tuplas en la

relación.

Operaciones relacionales como operaciones sobre DDBs

Sabiendo cómo representar relaciones con DDBs, falta conocer el modo de manipularlos

para reflejar las operaciones relacionales que se llevan a cabo para implementar, por ejemplo, el

algoritmo de evaluación incremental de programas Datalog visto anteriormente (Algoritmo 3).