CAPITULO 5 Levantamiento de supuestos.

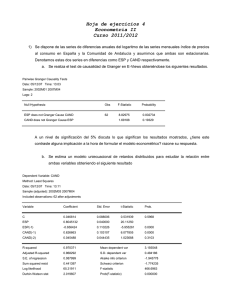

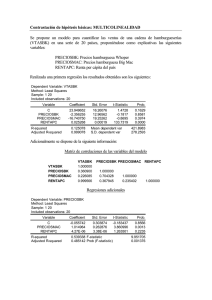

Anuncio