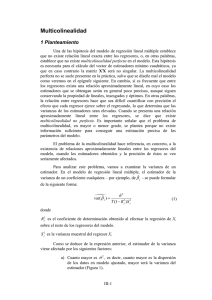

REGRESIÓN LINEAL 8. MULTICOLINEALIDAD Los modelos de regresión se usan en una gran diversidad de aplicaciones. El uso y la interpretación de un modelo de regresión múltiple dependen, en forma explícita o implícita, de los estimados de los coeficientes individuales de regresión. Un problema serio que puede influir mucho sobre la utilidad de un modelo de regresión es la multicolinealidad, entre las variables de regresión. La multicolinealidad implica una dependencia casi lineal entre los regresores, los cuales son las columnas de la matriz X, por lo que es claro que una dependencia lineal exacta causaría una matriz X'X singular. La presencia de dependencias casi lineales puede influir en forma dramática sobre la capacidad de estimar coeficientes de regresión. Si no hay relación lineal entre los regresores, se dice que éstos son ortogonales. Cuando los regresores son ortogonales se pueden hacer con relativa facilidad inferencias como: 1. Identificación de los efectos relativos de las variables regresoras. 2. Predicción y/o estimación. 3. Selección de un conjunto adecuado de variables para el modelo. Sin embargo, en la mayor parte de las aplicaciones de regresión, los regresores no son ortogonales. A veces no es grave la falta de ortogonalidad, sin embargo, en algunos casos los regresores tienen una relación lineal casi perfecta, y en esos casos, las inferencias basadas en el modelo de regresión pueden ser engañosas o erróneas. Cuando hay dependencias casi lineales entre los regresores, se dice que existe el problema de multicolinealidad. El problema de multicolinealidad fue mencionado al tratar la inadecuación de los modelos de regresión, en esta parte se ampliará su descripción, se describirá una diversidad de problemas y técnicas relacionados con este problema. Específicamente, se examinarán las causas de la multicolinealidad, algunos de sus efectos específicos perjudiciales sobre la inferencia, los métodos de diagnóstico o para detectar la presencia de multicolinealidad y algunas técnicas o medidas correctivas para enfrentar el problema. 8.1 COEFICIENTES NORMALIZADOS DE REGRESIÓN Se puede decir que es difícil comparar coeficientes de regresión en forma directa, porque la magnitud de ˆ j refleja las unidades de medida del regresor x j por lo que a veces ayuda trabajar con regresores y variables de respuesta escalados, que produzcan coeficientes de regresión adimensionales. A esos coeficientes adimensionales se les suele llamar coeficientes estandarizados de regresión y dos técnicas frecuentes de escalamiento son: las de escalamiento normal unitario y de escalamiento de longitud unitaria. Escalamiento normal unitario El primer método emplea el escalamiento normal unitario para los regresores y la variable de respuesta. Esto es, zi j = xi j − x j , i = 1, 2,..., n, sj j = 1, 2,..., k y yi * = yi − y , i = 1, 2,..., n sy en donde (x − x ) n s 2j = i =1 ij 2 j n −1 es la varianza muestral del regresor x j y n ( y − y) s y2 = i =1 2 i n −1 es la varianza muestral de la respuesta. Nótese la semejanza con la estandarización de una variable normal aleatoria. Todos los regresores escalados y la respuesta escalada tienen su media muestral igual a cero, y varianza muestral igual a 1. Con estas nuevas variables, el modelo de regresión se transforma en yi * = b1 zi1 + b2 zi 2 + ... + bk zik + i , i = 1, 2,..., n Al centrar las variables regresoras y de respuesta restando x j y y , se elimina la ordenada al origen del modelo (en realidad, el estimado de b0 por mínimos cuadrados es bˆ = y* = 0 ). El estimador de b por mínimos cuadrados es −1 bˆ = ( Z ' Z ) Z ' y * Escalamiento de longitud unitaria En este segundo método, xi j − x j wi j = j = 1, 2,..., k , S 1/2 jj y yi0 = yi − y , i = 1, 2,..., n SCT1/2 en donde S j j = ( xi j − x j ) n 2 i =1 es la suma de cuadrados corregida, para el regresor x j . En este escalamiento, cada nuevo regresor wj tiene promedio w j = 0 , y longitud ( w − w ) = 1 . En función de esas 2 n i =1 ij j variables, el modelo de regresión es yi0 = b1wi1 + b2 wi 2 + ... + bk wik + i , i = 1, 2,..., n El vector de los coeficientes de regresión por mínimos cuadrados es −1 bˆ = (W 'W ) W ' y 0 En el escalamiento de longitud unitaria, la matriz W'W tiene la forma de una matriz de correlación, esto es, 1 r12 r 1 W 'W = 21 rk1 rk 2 r1k r2 k 1 en donde ( x − x )( x − x ) = r = n u =1 ij ui i uj (S S ) 1/2 ii jj Sij j (S S ) 1/2 ii jj es la correlación simple entre los regresores xi y x j . De igual modo, r1 y r 2y 0 W 'y = rk y en la que ( x − x )( x − y ) = r = n u =1 jy uj j ( S SC ) 1/2 jj Sjy u ( S SC ) 1/2 jj T T es la correlación simple entre el regresor xi y la respuesta y. Si se usa escalamiento normal unitario, la matriz Z ' Z se relaciona en forma estrecha con W 'W ; de hecho, Z ' Z = ( n − 1)W 'W En consecuencia, los estimados de los coeficientes de regresión son idénticos, sin importar qué escalamiento se use; ambos producen el mismo conjunto de coeficientes adimensionales de regresión b. En consecuencia, el escalamiento produce el conjunto de coeficientes adimensionales de regresión b̂ . A los coeficientes de regresión b̂ se les suele llamar coeficientes estandarizados de regresión. La relación entre los coeficientes originales y los estandarizados de regresión es 1/2 SC ˆ j = bˆ j T , S jj j = 1, 2,..., k y ˆ = y − 0 k ˆ x j =1 j j Muchos programas de cómputo para regresión múltiple usan este escalamiento para reducir los problemas que se originan en errores de redondeo, en la matriz ( X ' X ) . Esos errores −1 pueden ser graves, si las variables originales difieren mucho en su magnitud. La mayor parte de los programas de cómputo muestran también los coeficientes originales de regresión y los normalizados, a los que con frecuencia se les llama "coeficientes beta". Al interpretar los coeficientes estandarizados de regresión se debe recordar que siguen siendo coeficientes de regresión parcial, es decir, que b j mide el efecto de x j , dado que los demás regresores xi , i j , están en el modelo. Además, las b j se afectan por el intervalo de valores de las variables regresoras. En consecuencia, puede ser peligroso usar la magnitud de las b j como medida de la importancia relativa del regresor x j . 8.2 FUENTES DE MULTICOLlNEALlDAD Se tiene el modelo de regresión múltiple en la forma y = X + en donde y es un vector de n × 1 de respuestas, X es una matriz de n × p de las variables regresoras, es un vector de p × 1 de las constantes desconocidas y es un vector de n×1 de los errores aleatorios, siendo i NID ( 0, 2 ) . Resulta conveniente suponer que las variables regresoras y la respuesta se han centrado y escalado a longitud unitaria, en consecuencia, X ' X es una matriz de correlaciones de p × p, entre los regresores, y X ' y es un vector de p × 1, de correlaciones entre los regresores y la respuesta. Sea X j la j-ésima columna de la matriz X, de modo que X = X1 , X 2 ,..., X p , entonces, X j contiene los n niveles de la j-ésima variable regresora. Se definirá, formalmente, la multicolinealidad en términos de la dependencia lineal de las columnas de X. Los vectores X1 , X 2 ,..., X p son linealmente dependientes si hay un conjunto de t1 , t 2 ,..., t p no todas cero, tales que p t X = 0 j =1 j j Si esta ecuación es exactamente válida para un subconjunto de las columnas de X, el rango −1 de la matriz X ' X es menor que p, y no existe ( X ' X ) . Sin embargo, supóngase que la ecuación es aproximadamente válida para algún subconjunto de las columnas de X. En ese caso habrá una dependencia casi lineal en X ' X , y se dice que existe el problema de multicolinealidad, nótese que la multicolinealidad es una forma de deterioro en la matriz X ' X , además, el problema es de grado, indicando con esto que cada conjunto de datos sufrirá cierto grado de multicolinealidad, a menos que las columnas de X sean ortogonales (que X ' X sea una matriz diagonal), en general, eso sólo sucederá en un experimento diseñado. Como se verá, la presencia de multicolinealidad puede hacer que el análisis del modelo de regresión, por mínimos cuadrados, sea terriblemente inadecuado. Hay cuatro fuentes de multicolinealidad principales: 1. El método de recolección de datos que se empleó. 2. Restricciones en el modelo o en la población. 3. Especificación del modelo. 4. Un modelo sobredefinido. Es importante comprender las diferencias entre estas fuentes de multicolinealidad, porque los datos y la interpretación del modelo resultante dependen, en cierto grado, de la causa del problema (véase Mason, Gunst y Webster [1975], para más descripción de las fuentes de multicolinealidad). El método de obtención de datos puede originar problemas de multicolinealidad cuando el analista sólo muestrea un subespacio de la región de los regresores definidos (en forma aproximada) por la ecuación anterior. La multicolinealidad causada por la técnica de muestreo no es inherente al modelo o a la población que se muestrea. Las restricciones en el modelo o en la población que se muestrea pueden causar multicolinealidad; por ejemplo, con frecuencia se presentan restricciones en problemas donde intervienen procesos de producción o químicos, cuando los regresores son los componentes de un producto y ésos suman una constante. También se puede inducir la multicolinealidad por la elección del modelo. Por ejemplo, en casos en que al agregar términos polinorniales a un modelo de regresión se produce un deterioro en X ' X , además, si el rango de X es pequeño, al agregar un término en x2 puede producirse una multicolinealidad importante. Con frecuencia se encuentran casos como ésos, cuando dos o más regresores tienen dependencia casi lineal, y el retener esos regresores puede contribuir a la multicolinealidad, en esos casos suele ser preferible algún subconjunto de regresores, desde el punto de vista de la multicolinealidad. Un modelo sobredefinido tiene más variables regresoras que observaciones. A veces se encuentran esos modelos en la investigación médica y conductual, cuando puede que sólo haya una pequeña cantidad de personas (unidades de muestra) disponibles, y se reúne información de una gran cantidad de regresores en cada persona. El método común para manejar la multicolinealidad en este contexto es eliminar algunas de las variables regresoras. Mason, Gunst y Webster [1975] presentan tres recomendaciones específicas: 1) redefinir el modelo en términos de un conjunto menor de regresores, 2) hacer estudios preliminares usando sólo subconjuntos de los regresores originales y 3) usar métodos de regresión del tipo de componentes principales, para decir cuáles regresores se van a quitar al modelo. Los dos primeros métodos no tienen en cuenta las interrelaciones entre los regresores y, por consiguiente, pueden conducir a resultados no satisfactorios. 8.3 EFECTOS DE LA MULTICOLlNEALlDAD La presencia de multicolinealidad tiene una gran cantidad de efectos graves sobre los estimados de coeficientes de regresión por mínimos cuadrados. Supóngase que sólo hay dos variables regresoras, x1 y x2 . El modelo, suponiendo que se escalan x1 , x2 y y a longitud unitaria, es y = 1 x1 + 2 x2 + y las ecuaciones normales de mínimos cuadrados son ( X ' X ) ˆ = X ' y 1 r 12 r12 ˆ1 r1 y = 1 ˆ2 r2 y en donde r12 es la correlación simple entre x1 y x2 , y rj y es la correlación simple entre x j y y, j = 1,2. Ahora bien, la inversa de X ' X es 1 1− r2 ( 12 ) −1 C =(X 'X ) = −r 12 2 (1 − r12 ) − r12 (1 − r122 ) 1 (1 − r122 ) y los estimados de los coeficientes de regresión son r − r12 r2 y ˆ1 = 1 y (1 − r ) , 2 12 r − r12 r1 y ˆ2 = 2 y (1 − r ) 2 12 Si hay fuerte multicolinealidad entre x1 y x2 el coeficiente de correlación r12 será grande. De acuerdo con la ecuación, se ve que cuando r → 1 , Var ˆ = C 2 → y ( ) 12 ( ) j jj Cov ˆ1 , ˆ2 = C12 → , dependiendo de si r12 → +1 o r12 → −1 , por consiguiente, la 2 fuerte multicolinealidad entre x1 y x2 da como resultado grandes variancias y covariancias de los estimadores de coeficientes de regresión por mínimos cuadrados. Esto implica que distintas muestras tomadas con los mismos valores de x podrían ocasionar estimaciones muy diferentes de los parámetros del modelo. Cuando hay más de dos variables regresoras, la multicolinealidad produce efectos parecidos. Se puede demostrar que los elementos diagonales de la matriz C = ( X ' X ) son Cjj = 1 , 1 − R 2j j = 1, 2,..., p −1 en donde R 2j es el coeficiente de determinación múltiple de la regresión de x j respecto a las demás p – 1 variables regresoras. Si hay fuerte multico1inealidad entre x j y cualquier subconjunto de los demás p – 1 regresores, el valor de R 2j será cercano a la unidad. Como ( ) −1 la variancia de ˆ j es Var ˆ j = C j j 2 = (1 − R 2j ) 2 , una fuerte multicolinealidad implica que la variancia del estimado del coeficiente de regresión ˆ j por mínimos cuadrados es muy grande, por lo general, la covariancia de ˆ y ˆ también será grande, si los j i regresores xi y x j intervienen en una relación multicolineal. La multicolinealidad tiende también a producir estimados de ˆ j que son demasiado grandes en valor absoluto; para visualizar eso, se examina la distancia de ˆ al vector del parámetro real, elevada al cuadrado, por ejemplo ( )( L12 = ˆ − ' ˆ − ) La distancia esperada, elevada al cuadrado, E ( L12 ) es ( )( ) E ( L12 ) = E ˆ − ' ˆ − ( p = E ˆ j − j j =1 ( ) p = Var ˆ j j =1 ) 2 2 = 2Tr ( X ' X ) −1 en donde la traza de la matriz es justo la suma de los elementos de la diagonal principal. Cuando hay multicolinealidad, algunos de los autovalores (eigenvalues) de X'X serán pequeños; como la traza de una matriz también es igual a la suma de sus eigenvalores, la ecuación anterior se transforma en E ( L12 ) = 2 p j =1 en donde j 0 1 j j = 1, 2, ... , p son los autovalores de X'X. Así, si la matriz X'X está mal acondicionada por la multicolinealidad, al menos una de las j será pequeña, y esta última ecuación implica que la distancia del estimado mínimo cuadrático ˆ a los parámetros puede ser grande. En forma equivalente se puede demostrar que ( )( ) E ( L12 ) = E ˆ − ' ˆ − ( = E ˆ ' ˆ − 2ˆ ' + ˆ ' ˆ ) o sea ( ) E ˆ ' ˆ = ˆ ' + 2Tr ( X ' X ) −1 En general, el vector ˆ es más grande que el vector , esto implica que el método de los mínimos cuadrados produce coeficientes de regresión estimados que son demasiado grandes en valor absoluto. Si bien el método de los mínimos cuadrados producirá, en general, malos estimados de los parámetros individuales del modelo cuando hay una fuerte multicolinealidad, eso no necesariamente implica que el modelo ajustado sea mal predictor. Si las predicciones se confinan a regiones del espacio de x donde la multicolinealidad es aproximadamente válida, con frecuencia el modelo ajustado produce predicciones satisfactorias, lo que puede suceder p porque se logra estimar bastante bien la combinación lineal j =1 ˆ j xi j , aun cuando los parámetros individuales j se estimen mal. Indica con esto que, si los datos originales están aproximadamente sobre el hiperplano definido por p t X = 0 , j =1 j j las observaciones futuras que también estén cerca de este hiperplano se podrán predecir con precisión, muy a menudo, a pesar de los estimad os inadecuados de los parámetros individuales del modelo. EJEMPLO. Suponga los datos Gráfica de matriz de Y %, PCuerpo, PHigado, Dosis 150 175 200 0.8 0.9 1.0 0.6 0.4 Y% 0.2 200 175 PCuerpo 150 10.0 7.5 PHigado 5.0 1.0 0.9 Dosis 0.8 0.2 0.4 0.6 5.0 7.5 10.0 En la gráfica de dispersión múltiple, como los dos regresores, PCuerpo y Dosis están muy correlacionados (la dosis real recibida por un animal fue determinada como 40 mg de la droga por kilogramo de peso corporal), hay un problema potencial de multicolinealidad en estos datos. Cada uno de los regresores originales se escaló con el escalamiento normal unitario de la sección 1 [restando el promedio (es decir, centrándolo) y dividiéndolo entre la desviación estándar]. Los términos del modelo se generan a partir de los términos lineales escalados. Como se dijo previamente, es conveniente centrar los términos lineales. DIAGNÓSTICO DE MULTICOLlNEALlDAD Se han propuesto varias técnicas para detectar la multicolinealidad. Las características deseables en un método de diagnóstico son que refleje el grado del problema de multicolinealidad, y que proporcione información de utilidad para determinar qué regresores están implicados. Examen de la matriz de correlación Una medida muy sencilla de la multicolinealidad es la inspección de los elementos ri j no diagonales en X'X. Si los regresores xi y x j son casi linealmente dependientes ri j será próximo a la unidad Correlación: PCuerpo, PHigado, Dosis PHigado Dosis PCuerpo 0.500 0.990 PHigado 0.490 Factores de inflación de varianza Los elementos diagonales de la matriz C = ( X ' X ) −1 son muy útiles para detectar la multicolinealidad. Recordando que Cjj = 1 , 1 − R 2j j = 1, 2,..., p 2 Siendo R j el coeficiente de determinación cuando la regresión es respecto a los p – 1 regresores. Se puede considerar que Cjj es el factor en el que aumenta la varianza de beta debido a dependencias casi lineales entre los regresores. Se define: VIFj = C j j = 1 1 − R 2j como Factor de Inflación de Variancia (VIF). Mide el efecto combinado que tienen las dependencias de los regresores sobre la varianza de ese término. Si hay uno o más VIF grandes, hay multicolinealidad. La experiencia indica que si cualquiera de los VIF es mayor que 5 o 10, es indicio de que los coeficientes asociados de regresión están mal estimados debido a la multicolinealidad. Los VIF tienen otra interpretación interesante, referido a la longitud del intervalo de confianza en la teoría normal. Análisis del eigensistema de X'X (Teoría de Análisis Multivariante) Otros diagnósticos Hay otras técnicas que a veces se usan para diagnosticar la colinealidad. Se puede usar el determinante de X'X como índice de colinealidad; ya que la matriz X'X está en forma de correlación, el intervalo de posibles valores del determinante esta entre 0 y 1. Los regresores son ortogonales si es 1, mientras que si es 0, hay una dependencia lineal exacta entre ellos. El grado de multicolinealidad se agrava a medida que tiende a cero. Si bien esta medida de multicolinealidad es fácil de aplicar, no proporciona información alguna sobre el origen de la multicolinealidad. MÉTODOS PARA MANEJAR LA MULTICOLlNEALlDAD Se han propuesto varias técnicas para manejar los problemas causados por la multicolinealidad. Entre los métodos generales están el reunir más datos, la reespecificación del modelo y el uso de métodos de estimación distintos de los mínimos cuadrados, diseñados en forma específica para combatir los problemas inducidos por la multicolinealidad. Recolección de datos adicionales Se ha sugerido la recolección de datos adicionales como el mejor método para combatir la multicolinealidad (véase, por ejemplo, Farrar y Glauber [1967], y Silvey [1969]). Los datos adicionales se deben reunir en una forma diseñada para eliminar la multicolinealidad en los datos actuales. Reespecificación del modelo Con frecuencia, la multicolinealidad se debe a la elección del modelo, como cuando dos regresores muy correlacionados se usan en la ecuación de regresión, en estos casos la reespecificación de la ecuación de regresión puede aminorar el impacto de la multicolinealidad. Encontrar la relación entre regresore por ejemplo. Otro método muy usado para reespecificar el modelo es la eliminación de variable. Esto es, si dos o más son casi linealmente dependientes, la eliminación de un regresor, puede ayudar a combatir la multicolinealidad. La eliminación de variable es frecuentemente una técnica muy efectiva, sin embargo, podrá no producir una solución satisfactoria si los regresores eliminados del modelo tienen un gran poder de explicación en relación de la respuesta y, lo que significa que la eliminación de los regresores para reducir la multicolinealidad puede dañar el poder predictivo del modelo. Se debe tener cuidado al seleccionar las variables, porque muchos de los procedimientos de selección se distorsionan mucho por la multicolinealidad y no hay seguridad de que el modelo final muestre menor grado de multicolinealidad que la que había en los datos originales.