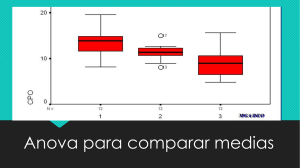

2015 Diseño de experimentos Beatriz Pérez de Vargas Moreno Universidad de Valladolid Profesor: Alfonso Gordaliza Ramos 16/03/2015 ÍNDÍCE BLOQUE I: TEMAS STATGRAPHICS. Tema 3: Experimentos con un solo factor. El análisis de la varianza……………………………………1 Tema 4: Bloques aleatorizados, cuadrados latinos y diseños relacionados.………………………22 Tema 5: Introducción a los diseños factoriales...……………………………………………………………….34 Tema 12: Experimentos con factores aleatorios...…………………………………………………………….69 Tema 13: Diseños anidados y de parcelas subdivididas ...……………………………………..………….95 Material adicional: Introducción al control estadístico de procesos (temas 12 y 13)…125 Tema 6: Diseño factorial 2k ...………………………………………………………………………………..………...131 Tema 7: Formación de bloques y confusión en el diseño factorial 2k ...………………..…………219 Tema 8: Diseños factoriales fraccionados de dos niveles....………………..………………………….239 Tema 14: Análisis de la covarianza....………………..………………………………………..………………….283 Tema 11: Metodología de superficies de respuesta....………………..………………………………….297 BLOQUE II: ENTREGABLES Entregable 1: Ejercicio 1 - Examen ordinario 13/14 – Datos CONTAMINACIÓN.sfx ……..316 Entregable 2: Ejercicio 2 - Examen ordinario 13/14....………………..…………………………………324 Entregable 3: Pimientos....…………………………………………………..……..…………………………………336 BLOQUE I: TEMAS STATGRAPHICS TEMA 3: Experimentos con un solo factor. El analisis de la varianza 1 Las observaciones obtenidas son: Para resolver este problema con Statgraphics lo primero que deberíamos hacer es crear el diseño. Para ello: Podemos pinchar en Labels para dar nombre a las etiquetas, en nuestro caso a los diferentes porcentajes utilizados. 2 Seguimos dando a OK, y la siguiente pantalla que nos aparece es: Siempre 1 menos, tenemos 5 réplicas en este caso pero Statgraphics siempre parte de que al menos hay 1. Lo tenemos que quitar, se supone que esto ya lo ha aleatorizado quien ha hecho el experimento. Con esto, si vamos a Databook vemos que se nos han rellenado unas columnas para que introduzcamos los datos de la tabla del enunciado: **Si hubiésemos marcado "randomize", esto nos mostraría el orden en que tendríamos que realizar las mediciones: 3 Número de factores Número de bloques Número de respuesta Número de corridas Grados de libertad que le queda al error Abrimos el archivo "Tabla 3-1" que ya viene los datos completados y vamos a realizar el análisis: Podemos seguir el camino anterior, pero aprovechando que ya tenemos el diseño creado a partir de DOE, vamos a hacer lo siguiente: 4 Y ponemos como datos: Resistencia. Ahora vamos a marcar los gráficos y las tablas que más nos interesen: Análisis gráfico: - Scatterplot: Como podemos ver se aprecia que la resistencias va subiendo como una "escalera" según aumentamos el porcentaje en el algodón y luego decrece de golpe con el 35% - Box-and-Whisker Plot: Para poner el gráfico en vertical vamos a Pane Options > Vertical. Como podemos observar nos queda algo parecido a la forma que seguía el gráfico anterior. 5 Tablas: - Summary Statistics: Para cada uno de los niveles nos da la media, la desviación.. Podemos añadir más cosas en Pane Options - ANOVA: La variabilidad total de las observaciones dan una suma total de 636,96. Las diferencias entre (between) grupos es de 475,76 y dentro de ellos (within) es de 161,2 Además el F-ratio es 14,76, un valor muy extremo por lo que estará en la cola derecha. El observar unas diferencias tan extremas entre los grupos no es atribuible al azar, luego podemos afirmar que existen diferencias significativas. Estimación de parámetros: Las estimaciones puntuales valen de poco, a nosotros nos interesan los intervalos de confianza. Para hallarlos en statgraphics lo que debemos hacer es: En tablas seleccionamos "Table of Means" y dentro de esta tenemos que ir a Pane Options y marcar lo siguiente ya que es lo correspondiente a la formula estudiada en teoría: (ecuación 312, pág.74) 6 Obteniendo como resultado: Lo que quiere decir que por ejemplo para un porcentaje de algodón del 15% el intervalo de confianza que tenemos es de [7,151 - 12,448] La tabla ANOVA nos dice si hay diferencias significativas, pero no nos dice entre que niveles, habría que hacer I.C para las diferencias entre las medias y si contienen al cero es que podemos dar por válido que las medias son iguales. Para realizar esto en statgraphics vamos a tablas y marcamos: Tenemos diferentes métodos aunque los más recomendados son LSD: diferencias menos significativa Duncan Tukey Estos se pueden ir alternando en Pane Options y nos ordenan los niveles de las medias de menos a más. Las cruces en la misma vertical quiere decir que no hay diferencias significativas entre las medias de esos niveles. En nuestro caso tenemos tres grupos: 15-35, 20-25 y 30. Hay veces que tendremos cruces enlazadas que nos muestran un efecto cadena. En este ejemplo lo encontramos con el método de Bonferroni, que nos da un efecto cadena ya que el 25 queda entre dos grupos 7 Gráficamente este lo podríamos ver marcando en gráficos Means Plot, que como vemos se aprecia claramente los grupos que comparten medias: Antes de haber realizado cualquiera de estas pruebas, sabemos que hay que verificar tres hipótesis a la hora de realizar cualquier problema: Homogeneidad de la varianza: el gráfico de residuos vs predichos no tiene que seguir ningún patrón. Normalidad: El plot de normalidad tampoco tiene que seguir ningún patrón Independencia: El gráfico tiene que hacer una línea recta. Para comprobar estas hipótesis en Statgraphics lo primero que tenemos que marcar es - Homogeneidad de la varianza: en Residual Plots damos a botón derecho, opciones de panel y seleccionamos la 2 opción: Como podemos observar el plot de residuales es bastante aceptable ya que no sigue ningún patrón. Igual que ocurre con el siguiente test de normalidad. -Test de normalidad: Igual pero marcando la tercera opción: 8 -Test de independencia: Nos vamos al botón y grabamos los residuales (estos nos aparecerán en el databook, nosotros hemos marcado que aparezca en la hoja A): Una vez que tengamos el gráfico de normal probability plot damos a Pane Options > 9 Si aún con los gráficos tuviéramos dudas sobre la homogeneidad de la varianza podemos ir en tablas y gráficos y marcar . Aquí vamos a tener diferentes pruebas: de le Levene's, Cochran, Barlets, etc. Para afirmar que hay igualdad en varianzas el p-valor de estas pruebas debe ser > 0,05 A la vista de estos resultados podemos asegurar la homogeneidad de la varianza. (Que el pvalor de la primera, por ejemplo, sea 0,63 quiere decir que el 63% de las veces salen diferencias como estas, no son valores extraños). 2. Verificación del modelo - Pág.83 Abrimos la tabla 3-7, donde aparecen recogidos estos datos: 10 Marcamos los gráficos 1 y 4, y dejamos las tablas que ya vienen seleccionadas. Además para comprobar si el modelo es correcto tendremos que mirar primero el plot de residuales y la prueba de varianza. Por tanto, marcamos también estas últimas. Verificación del modelo: Como vemos el plot de residuales tiene claramente forma de megáfono abierto y en todas las pruebas de la varianza el p-valor es menor de 0,05 por tanto tenemos que corregir la heterogeneidad de la varianza. Para ello, vamos a seguir el método empírico visto en clase: A partir de la fórmula: Y realizando un ajuste de regresión, determinaremos el estimador de α. Con este estimador sacaremos el ajuste más aproximado a partir de esta tabla: 11 Con Statgraphics se haría de la siguiente forma: 1. Ajuste de regresión: Vamos a y marcamos Level Means y Level Sigmas. Vamos a databook y: Nos vamos al plot of fitted Model: Comparando término a término vemos que α = 0,446 Vamos a la tabla anterior y vemos que para un α ≈ 1/2 la transformación que tenemos que hacer es Raíz Cuadrada, vamos a ONE-WAY a nuestro lado izquierdo ponemos sqrt: y en estimación Como podemos apreciar el plot de residuales ya no presenta forma de megáfono abierto y todas las p-valor de las pruebas de la varianza son > 0,05. Conclusión: hemos logrado corregir la heterogeneidad de la varianza. Además la tabla ANOVA muestra un p-valor=0,0000. 12 Abrimos el documento "3-16.sfx". Antes de empezar cualquier problema lo primero que tenemos que hacer el chequear el modelo. Para ello vamos a ver primero si la varianza es homogénea: Si observamos el plot de residuales vemos que presenta claramente forma de megáfono abierto, no hay dudas de que hay heterogeneidad. Para corregirlo lo primero que tenemos que hacer es realizar la regresión de la fórmula Vamos a y marcamos Level Means y Level Sigmas Obteniendo: Por tanto; como α≈1 la transformación que tenemos que hacer es logarítmica: 13 El plot de residuales aun no nos convence mucho, ya que presenta estrangulamiento en el medio, pero con variance check salimos de dudas ya que el p-valor de todas las pruebas es >0,05 3. Identificación de los efectos de dispersión. (Tabla 3-12. Pág. 111) 14 Abrimos el documento tabla 3-12, y realizamos un análisis como los que llevamos haciendo hasta ahora, poniendo en un principio la variable localización como dato. Vamos a verificar las hipótesis de validación del modelo: Ambos parecen correctos; el único que presenta una forma un poco preocupante es el plot de normalidad: Cuando tenemos puntos al principio por arriba de la recta que ajusta y después por debajo la distribución estaría a caballo entre una distribución normal y una uniforme, cuyo resultado sería una especie de distribución normal sin colas. Aún así, el p-valor de la prueba es 0,43 no tenemos por qué cuestionar la normalidad. Vamos a la tabla ANOVA y vemos que tiene un p-valor = 0.89 por lo que no tenemos diferencias significativas, de ahí que las pruebas de rango múltiple nos den un único grupo. 15 Para investigar los efectos de dispersión vamos a utilizar el log(s), para ello basta con cambiar el modelo actual, poniendo como dato: log(Dispersion) Como vemos el p-valor = 0, lo que nos indica que el algoritmo para controlar la proporción tiene un efecto de dispersión. Las pruebas estándares de la adecuación del modelo, incluyendo las gráficas de probabilidad normal de los residuales, indican que no hay problemas con la validez del experimento. Si hacemos las pruebas de rango múltiple, y escogiendo la de Bonferroni ya que no hay solapamiento vemos con toda claridad que el algoritmo 3 para controlar la proporción produce más ruido del crisol o una desviación estándar del voltaje de la celda mayor que los otros algoritmos. No parece haber gran diferencia entre los algoritmos 1, 2 Y 4. Si se diera el caso en el que no se pudieran validar las hipótesis del modelo; es decir, no podemos corregir ni la heterogeneidad de la varianza, ni el plot de normalidades, etc. Tenemos un método alternativo a la tabla ANOVA, llamado test de Kruskal - Wallis. Si queremos hacer este test en Statgraphics lo marcamos en tablas Su interpretación es idéntica a la de la tabla ANOVA. 16 4. Problemas (Pág. 120) Para empezar copiamos los datos a partir de la Excel, seleccionamos todo (incluido el nombre) y vamos a databook de statgraphics > marcamos la columna y seleccionamos colum names en este caso. a) Hacemos el análisis de la varianza (Compare > Analysis of Variance > One-Way ANOVA y lo primero que tenemos que comprobar es la validación del modelo. El único gráfico del que podíamos dudar es el de la homogeneidad de la varianza que tenemos a la izquierda ya que tiende un poco a forma de megáfono. Aun así, si miramos las pruebas de la varianza en todas obtenemos un p-valor>0,05, luego podemos afirmar que no hay diferencias estadísticamente significativas entre las varianzas. 17 Para responder al apartado a) tenemos que mirar la tabla ANOVA, en la que vemos un p-valor <0,05, con lo que se concluye que tenemos diferencias significativas de conductividad debido al tipo de recubrimiento. b) y c) Para estimar la media global, vamos a la tabla de medias (en pane options: confidence intervals (pooled)). Como podemos observar la media global es = 137, 938. Además de aquí ya podemos sacar el intervalo de confianza para el tipo 4, que es = [124.416 , 134.084] d) ,e) y f) Para probar los pares de medias lo hacemos a través de las pruebas de rango múltiple en donde vemos que se pueden distinguir entre dos grupos, por un lado podemos suponer que no hay diferencias significativas entre el tipo de recubrimiento 3 y 4, y por otro entre el tipo de recubrimiento 1 y 2. Lo mismo que podemos observar en el gráfico de medias. Por tanto, a la vista de los resultados y puesto que lo que se quiere es mejorar la conductividad entre el tipo 1 y 2 escogeríamos el más económico (o el que mejor nos convenga por otros factores) dado que no hay diferencias entre ambos. 18 5. Problemas (Pág. 120) a), b) y c) Primero tenemos que verificar las hipótesis del modelo para ello miramos los plots de residuales y el de normalidad. Además antes de nada echamos un vistazo al Scatterplot y al gráfico de cajas y bigotes. Como vemos a simple vista a más diámetro vamos a tener un menor porcentaje de radón liberado. En principio el gráfico de bigotes parece apuntar que si se va a cumplir la homogeneidad de la varianza. Vamos a ver que nos dicen los plots: 19 El único que presenta una ligera asimetría en los datos es el plot de normalidad pero no es suficiente para cuestionar los datos ya que el p-valor es 0,127 > 0,05. Así que en principio podemos afirmar que se cumplen las tres hipótesis. Con la ayuda de la tabla ANOVA podemos afirmar que el tamaño de los orificios afecta al porcentaje promedio de radón liberado ya que el p-valor es < 0,05. d) Para ver un I.C del porcentaje promedio de radón liberado para un diámetro de orifico de 1,40 vamos a la tabla de medias y como podemos observar este I.C es = [62.15 , 67.84] 20 e) Esto lo podemos realizar con la ayuda de means plot en el que vemos que ningún nivel de medias coincide, salvo el nivel 140 y 199, tal y como nos muestra Duncan. 21 TEMA 4: Bloques aleatorizados, cuadrados latinos y disenos relacionados Para hacer este diseño: También en podríamos haber marcado En la misma pantalla marcamos AyB 22 Abrimos el documento "tabla 4-1", donde ya vienen completados los datos. Obtenemos los datos a partir de DOE > Analyze design y dando todo a OK. Primero vamos a validar el modelo: - Homogeneidad de la varianza e independencia: cómo podemos observar en los gráficos inferiores ninguno presenta un patrón obvio. - Normalidad: Aunque hay una ligera asimetría en los datos no es suficiente para cuestionar la normalidad ya que el p-valor de la prueba nos da 0,3534 > 0,05. Por tanto, el análisis de la varianza es robusto con respecto al supuesto de normalidad. Una vez que estamos seguro de la validez del modelo ya podemos analizar la tabla ANOVA Que el p-valor del bloque sea 0 nos indica que hemos hecho bien en hacer bloques. Aún así lo podemos comprobar viendo que hubiera pasado si no hubiésemos bloqueado Compare > Analysis of variance > One - Way ANOVA 23 Como vemos si no hubiésemos bloqueado nos saldría que las diferencias no son significativas Además podemos ver que SSError + SSBloque del primero modelo = SSError del segundo modelo: 0, 08 + 0,825 = 0,905 CONCLUSIÓN: A la vista de los resultados de la primera tabla ANOVA, vemos que si tenemos diferencias estadísticamente significativas entre el tipo de punta. Tabla de Medias: Solo nos interesa la del factor, al igual que en Means Plot, que como vemos podemos hacer dos grupos: (3-1-2) y el 4. La punta 4 es significativamente más dura, cosa que vemos también en las pruebas de rango múltiple. Pegamos los datos a partir del excel Siempre tenemos que intentar poner el bloque al final 24 Si miramos la tabla ANOVA vemos que la diferencia entre productos químicos no son significativas. Ni si quiera bloqueando hemos sido capaces de detectar diferencias. Sin embargo, en las pruebas de rango múltiple vemos que algunos marcan la existencia de diferencias. *Suponemos que los datos de la tabla son las bacterias promedio. Compare > Analysis of variance > Multifactor ANOVA 25 Como vemos todos los plot son aceptables salvo el de normalidad que presenta una ligera curvatura, pero su p-valor es 0,38. Hay diferencias significativas entre las distintas soluciones, además suerte que hemos hecho bloques porque también afectaban para ver los resultados. Si lo quisiéramos comparar con el diseño sin bloques vamos a y quitamos el bloque. Suerte que hicimos bloques porque si no hubiésemos creído a juzgar por los resultados de la tabla ANOVA que no hay diferencias significativas entre las soluciones. Cuadrado latino. Pág 144 Para crear el modelo 26 Siempre tenemos que tener cuidado en el orden: Factor A: el importante, el de dentro de la matriz Factor B:filas Factor C:columnas El modelo resultante sería el que encontramos en "Tabla 4-9" DOE> Design Analyze - > si lo hicíeramos con multiple Regression: Lo primero que vemos es que todos los plot de residuales son aceptables. El único que está al límite es el de normalidad, pero lo damos por bueno ya que su p-valor es > 0,05 Los efectos del factor principal (Formulación) son relevantes; es decir, hay diferencias significativas entre formulaciones. El factor operador también era relevante suerte que lo hemos bloqueado. No ocurre así con el factor Lote, entre los cuales no hay diferencias significativas. 27 Además en la tabla de medias y en las pruebas de rango múltiple vemos que tenemos diferentes grupos: EAD en un nivel más alto que BC, aunque hay un efecto cadena. Elegiríamos entre ABC (las más rápidas). Ninguno de los métodos no ha mostrado una partición limpia. Todos los residuos son aceptables. Vamos a ver que dice la tabla ANOVA Hay diferencias significativas entre catalizadores. Sino hubiésemos bloqueado no hubiese pasado nada ya que el p-valor de los bloques > 0,05. Además cuando el scatterplot es muy claro significa que los bloques no están activos; es decir, que no influyen en la respuesta. 28 Tenemos una partición limpia: nos quedamos con E, D, B que son los menores. 4.3 Diseño de cuadrado grecolatino (Pág. 151) Para hacer este diseño: El factor B serían las filas, el C las columnas, el A factor de interés (letras latinas) y el D el cuadrado latino superpuesto (letras griegas) Abrimos el documento Tabla 4-20 y tenemos dos formas de hacerlo: - Mediante Análisis de la varianza: 29 - Mediante Analyze Design (no siempre podremos hacer el diseño con DOE, ya que con Statgraphics esta opción solo nos deja hacer cuadrados latinos estándar por lo que es interesante aprender a manejar las dos maneras) Vamos a analizar los resultados: Scatterplot: para ver qué diferencias podemos observar desde el punto de vista descriptivo: Plots: todos OK; incluso el de normalidad presenta una recta bastante ajustada: Tabla ANOVA: El factor de interés presenta diferencias significativas, pero de los factores bloqueados solo uno es significativo; luego no hubiese hecho falta hacer un cuadrado grecolatino, bastaría con haber bloqueado el factor operador solamente -> Diseño en bloques completamente aleatorizado. Multiple Range Test: Ya que hay diferencias significativas vamos a ver cuáles son: Tenemos un efecto cadena, no hay partición 30 limpia; pero como lo que buscamos son valores altos en rapidez lo que está claro es que tenemos que elegir entre el E, el A y el D. El cuadrado latino es estándar ya que sigue la forma: A B C D E B C D E A C D E A B D E A B C E A B C D Sin embargo, el grecolatino es totalmente aleatorizado, por lo que no podremos hacerlo con DOE. Copiamos los datos del excel: Filas Columnas Letras latinas Letras griegas 31 Compare > Analysis of Variance > Vamos a analizar los datos: Scatterplot: Sólo con ver el gráfico de la derecha podemos intuir que va a haber diferencias significativas. Plots: Se cumplen todas las hipótesis, además vemos que la recta en el plot de normalidad es bastante ajustada. 32 ANOVA: El tiempo, que es el factor de estudio, es el único que presenta diferencias significativas. El resto tienen un pvalor >0,05. Por lo que podemos concluir que hubiese dado igual si no hubiésemos bloqueado el resto de los factores. Esto lo podemos comprobar haciendo un One-Way ANOVA de Yield y usando como factor el Tiempo: Como vemos, podemos observar las diferencias significativas en función del tiempo de procesamiento sin necesidad de bloquear más factores. En la prueba de rango múltiple da igual que método cojamos porque aunque nos aparezcan solapados unos niveles con otros no hay duda de que el que tenemos que escoger es el A pues presenta un mayor rendimiento. 33 TEMA 5: Introduccion a los disenos factoriales Para hacer estos diseños vamos a DOE> Create New Design> Multifactor categorical > Nº of experimental factors:2 > Quitamos randomize y en réplicas ponemos 4-1= 3. Abrimos el archivo "tabla 5-1". Para analizar el modelo: Compare > Analysis of varianza > Multifactor ANOVA: Si pusiéramos aquí que el Order Interaction es 1, estaríamos haciendo otro modelo distinto -> yijk = µ + Ʈi + βj + ɛijk Después de verificar las hipótesis del modelo pasamos a analizar los datos.Como podemos observar en la tabla ANOVA todos los factores son significativos, al igual que lo es la interacción entre el material y la temperatura: 34 Dado que la interacción es significativa, si vamos al gráfico de interacción no tendríamos que ver líneas paralelas, dado que entonces tendríamos un modelo aditivo -> Tal y como habíamos predicho, podemos observar que efectivamente la interacción es significativa: (Dando a Pane Options podemos cambiar el factor) En la tabla de medias podemos distinguir 3 grupos: - Media general - Media por filas - Media por columnas - Media por celdas Si quisiéramos elegir la mejor combinación (la que da valores más altos) no basta con ver el Multiple Range Test de los dos factores, ya que incurriríamos en el error de tratar con un diseño aditivo de nuevo. Si hiciéramos esto cogeríamos el material 3 y temperatura 15º. Sin embargo si miramos la tabla de medias de arriba vemos que la media más alta la da la 35 combinación del material 2 con 15º (cuando habíamos visto que el material idóneo no era el 2) ¿Cómo podemos comprobarlo? Tene mos que crear una columna nueva con la interacción: Vamos a databook, marcamos la columna donde queremos depositar los datos > Botón derecho > Generate Data: (Además hemos llamado a esta columna mat * temp) Compare > Analysis of Variance > One-Way ANOVA > Si vamos a Pane Options vemos que podemos combinar tanto el material y la temperatura de 4 formas distintas que nos va a dar valores muy parecidos. Como podemos deducir, cuando hay interacción el análisis de las comparaciones múltiples por separado pueden ser insuficientes. 36 DOE >Create New Design>Multifactorcategorical> 3 factores experimentales > respuestas: 1. Podemos poner en cada factor las etiquetas en pinchando en label. Replicas = 2-1 = 1. Y quitamos randomize. Copiamos los datos desde el Excel: Scatterplot: a medida que hay más factores vemos menos en este gráfico. El plot de residuales no muestra ningún patrón y frente al número de corrida tampoco vemos nada en especial. Vamos a ver qué ocurre con el plot de normalidad de residuos: 37 Tenemos cierta anomalía, ya que el p-valor es 0,02 < 0,05 -> la normalidad está un poco en entredicho y además vemos cierta curvatura ya que los datos están muy discretizados (son muy parecidos todos: el 90 lo tienen todos en común: 90,1 90,2...) -> Mal arreglo: para resolver problema de normalidad no tenemos ninguna transformación que nos garantice que vamos a arreglar el problema sin alterar otras cosas. Gráfico de interacción: vemos que estas líneas son paralelas por lo que seguramente la interacción no va a ser significativa. Aunque hay un cierto cruce en el descenso es más o menos de la misma magnitud. Lo comprobamos con la tabla ANOVA. ANOVA: Tal y como vaticinábamos la interacción no es significativa, pero ambos factores si lo son por separado; tanto la temperatura como la presión afectan al rendimiento : 38 Aunque hemos ajustado el modelo de interacción la tabla ANOVA nos muestra que el modelo que necesitaríamos es el aditivo. Vamos al “max orde interaction” y quitamos la interacción (ponemos 1) Como vemos la fila de residual absorbe a la de la interacción pero las filas de A y B no han cambiado para nada, tan sólo los F-ratios. (esto ocurre siempre) En lo que sigue utilizaremos ya el modelo aditivo. Vamos a volver a mirar en este nuevo modelo la normalidad. -> Ya se ha corregido: p-valor > 0,05 -> nos quedamos más tranquilos. Multiple Range Test: Hemos llegado a la conclusión de que hay diferencias pero queremos analizar estas diferencias para ver cual nos interesa desde el punto de vista industrial. Si miramos las gráficas elegiríamos de Temperatura: 150 ó 170 ya que ofrecen rendimientos parecido; 160 ofrece un rendimiento significativamente menor. Presión: tampoco es lineal, la mejor es la presión media. Por tanto, desde el punto de vista industrial deberíamos combinar 150 o 170 grados de temperatura con una presión de 215. Ya que el modelo es aditivo nos serviría con este único análisis. 39 DOE >Create New Design>Multifactor categorical> 2 factores experimentales > Factor A: 3 niveles > Factor B: 4 niveles > respuestas: 2. Podemos poner en cada factor las etiquetas en pinchando en label. Replicas = 2-1 = 1. Y quitamos randomize. Copiamos los datos desde el Excel (primero tenemos que modificar el Excel dando a buscar y remplazar los puntos por las comas. Ya que Statgraphics no trabaja con puntos): EXCEL 40 Scatterplot: Si miramos el scatterplot (aunque son visiones parciales del problema) vemos que parece que crece la variable respuesta en los dos casos a medida que aumenta el factor: Plots de residuales: Todos los residuos parecen correctos (contra predichos, contra el número de filas, etc). El plot de normalidad: hay una ligera curvatura pero pasa el test de normalidad p-valor =0,3737 > 0,05 Gráfico de interacción: las líneas son casi paralelas pero hay una cierta convergencia, cuando la velocidad es baja los valores de la respuesta están más separadas que luego. Y en cuanto a la profundidad: las dos de arriba son bastantes paralelas y la de abajo va convergiendo hacia ello. A lo mejor hay diferencias significativas, vamos a verlo en la ANOVA: Efectivamente hay interacción. Los otros dos factores son claramente significativos. Por tanto influye la profundidad de corte y velocidad de alimentación pero no de forma aditiva sino que hay una cierta interacción. En este caso si tenemos que dar recomendaciones tenemos que hacer un análisis mayor. 41 Lo primero que tenemos que mirar es la tabla de medias. Vemos que la variable respuesta crece a medida que crecen ambos factores. Y si miramos los cruces como los dos factores apuntan en la misma dirección vemos que el valor máximo está en la combinación de los dos niveles que producen por separado valores más grandes, y el siguiente igual. Aunque podemos observar que hay un 104 mucho más atrás. Vamos a hacer una comparación de medias múltiples. (4*3 = 12: haríamos la comparación de las 12 medias) Vamos a databook> llamamos a la columna A*B >Generate data (si no nos deja convertimos todas las columnas en caracteres): La combinación que produce valores más grandes es 0,3 0,25. Pero hay otras combinaciones que en principio nos ofrecería resultados equivalentes: (0,3 0,25 y 0.25 0.25) 42 Apartado 5.3.6 -> El supuesto de no interacción en un modelo de dos factores Abrimos estos datos y hacemos una ANOVA de la duración en función de la temperatura y el material sin interacción. En este plot se observa una especie de curvatura, de unos grupos a otros hay oscilaciones hacia arriba y hacia abajo. Esto es fruto de que al modelo le faltan parámetros relevantes que no hemos medido (le falta la interacción) –> Falta de parametrización del modelo. Si metemos la interacción vemos que cambian las cosas: el plot de residuos deja de tener esta dolencia; los bloques están centrados en la línea del cero. Otro ejemplo: Para verlo con más claridad vamos a crear un diseño 3x3 Factor A y B con tres niveles cada 1. Replicas: 3, quitamos la aleatorización: 43 Vamos a formular el siguiente modelo: Y = A + B +A*B + ε el error sigue una normal N(0, 0.5). En la columna 4 del databook>Generate Data (primero ponemos todas las columnas en numérico) BNORMAL(corridas, medias, desviación típica) Vamos a compare >ONE WAY anova> SIN INTERACCIÓN. Vemos el plot de residuales con mucha curvatura. Si metemos un orden de interacción 2 desaparece la curvatura. 44 Antes estábamos queriendo predecir las observaciones sumando solamente un efecto fila y un efecto columna. Si omitimos la interacción es imposible recuperar la validez del modelo. ¿Que hemos hecho en este modelo? Y = A+B+A*B Así por ejemplo en la fila 1,2 tenemos = 1 + 2 +1*2 ≈ 5. En la 2,3 -> 2 + 3 + 2*3 ≈ 11 Y el parámetro sigma si recordamos lo habíamos estimado como 0.5 (N(0, 0.5)) -> MSE de la tabla ANOVA = 0,259 = √0.5 Apartado 5.3.7- Una observación por celda Si solo hay una observación cuando queremos ajustar el modelo no hay datos suficientes… Si sumamos los grados de libertad vemos que el resultado es a*b Tenemos a*b datos + 1 (porque tenemos σ) 1 a-1 b-1 (a-1)*(b-1) ab-a-b-1 Y en estadística esto es imposible no podemos estimar más datos que parámetros tengamos. Conclusión: SOLO PUEDE UTILIZARSE ESTE MODELO CUANDO HAY INTERACCIÓN Para verlo mejor vamos a la tabla 5- 10 Compare > Analysis of Variance > Multifactor ANOVA > Metemos orden de interaccion 2: 45 No hay F-ratios porque no hay residual. El modelo está saturado: no hay residuos. EL modelo pasa por todos los puntos ya que tiene tantos datos como parámetros. Todos los residuos son ceros -> se dice que el modelo está saturado. Si que tenemos tabla de medias que es el valor en sí mismo ya que solo hay un dato -> La media de un dato es el propio dato. 46 No tenemos un contraste de hipótesis para la interacción pero si podemos hacer un análisis gráfico. No podemos estar seguros pero si podemos apreciar que las líneas son razonablemente paralelas, puede ser útil estimar el modelo sin interacción. Vamos a las opciones de análisis y quitamos la interacción -> ya sí que tenemos tabla ANOVA: Prescindiendo de una interacción que no parece que vaya a ser muy importante visto el gráfico de interacción y ajustando un modelo aditivo vemos que son significativas la temperatura y la presión sobre las impurezas. Como lo que buscamos es obtener valores pequeños de impureza, nos interesa temperatura baja (150) y con 40 y 30 de presión. No necesitamos hacer más porque el modelo es aditivo. ¡¡¡Ojo cuando hay una sola réplica, si no vemos claro el plot de interacción no nos fiemos!!! 47 Ejemplo 5-3 – Pág. 197 Abrimos tabla 5-13. Compare > Analysis of variance > Multifactor ANOVA Scatterplot: Los gráficos descriptivos frente a los factores (scatteplot) nunca son concluyentes. Si se muestran diferencias claras lo más seguro es que sea significativo. Pero también puede ocultares. Grafico de interacciones : solo se pueden dobles. Parecen poco importantes, casi todas paralelas. Vemos las 3 pares de combinaciones cambiando desde pane options 48 plots de residuales: Vemos que los plots de residuales son OK, el de residuos frente a predichos como solo hay dos replicas en cada celda hay dos observaciones, que no nos llame la atención porque cuando hay uno por arriba lo hay también por abajo no nos asustemos. y el hecho de que los valores sean enteros también le quitan variabilidad. SI vamos a la ANOVA vemos que no hay interacciones. La AB (Carbonatación- Presión -> Marcada en Rojo) está en el límite: la más cerca de ser significativa, pero desde el punto de vista estadístico si queremos mantener un alfa = 0,05 no lo es. Tenemos un modelo razonablemente aditivo con una ligera interacción entre AB, que a lo mejor no la estamos viendo por tener solo dos replicas. Multiple Range Test y tabla de Medias: En este caso interesa para la variable respuesta que este lo más cerca del cero, vamos a la tabla de medias y vemos que habría que combinar la carbonatación 10, con la presión 25 y la rapidez 200. 49 Queda más cerca del 0 la combinación 10,30 que la 10, 25 puede ser porque el modelo no es del todo aditivo. Si queremos ver la combinación de las 3 en un Multple Range Test: generate data en la columna 6 Hacemos un ONE WAY anova de la rapidez de llenado frente a la columna 6: Las combinaciones que más se parecen al 0 son la (10 25 250), la (10 30 200) y la (10 25 200). 50 Lo mismo que observamos en el test de Rango Multiple de la página siguiente. Es un análisis un poco pobre ya que solo tenemos dos datos por celda. Apartado 5-6 - FORMACIÓN DE BLOQUES EN UN DISEÑO FACTORIAL 51 En definitiva, tenemos que intentar asociar las réplicas al factor bloque. En este caso tendríamos como parámetros A, B, A*B Y interacciona con los demás). (factor bloque que va sólo y no Tabla 5-18 Compare > analysis of variance > Multifactor ANOVA. Metemos primero el Operador porque es el que queremos bloquear, tenemos que meter max order = 2, pero tenemos que dar al botón exclude de la derecha, y sacar la de operador y ruido y operador con filtro Como vemos la tabla ANOVA tiene las 3 filas de los efectos principales y la interaccion solo tiene la del ruido con el filtro, vemos que el ruido y el filtro son significativoS. La interaccion aunque es mayor que 0,05 no la podemos obviar porque esta muy cerca. Si hubiesemos obviado el operador (que ahora aparece como significativo) los resultados de haber ignorado el posible efecto de los operadores no modifica ni la suma de los cuadros ni los ms (nunca cambian). El residual absorbe los 402,167 del operador. De ahí que en la nueva tabla ANOVA, el residual sea 568,5 (=166.33+ 402,167). Al engrosar el denomiandor los pvalores son menos rotundos que antes. Y la interaccion esta mucho mas lejos de ser significativa. No tendriamos demasiada mala suerte porque el ruido del factor operador no nos oculta las cosas. 52 Abrimos el archivo tabla 5-18. Compare > Analysis of variance > Multifactor ANOVA > Max Order interaction: 2, excluyendo: 53 Gráfico de interacciones: No está muy claro sólo con el gráfico. No son paralelas pero tampoco se cruzan ni se ve una clara tendencia de las interacciones. A ver que nos dice la tabla ANOVA Plots de residuales: Vemos que los plots de residuales son OK. SI vamos a la ANOVA vemos que todos los factores por si solos son significativos, pero no lo es la interacción entre el ruido y el filtro aunque tampoco la podemos obviar ya que el pvalor es muy próximo a 0,05. Multiple Range Test: dado que la interacción no es significativa se trataría como un modelo aditivo, por lo que para ver que combinación nos da la mejor solución basta con mirar las pruebas de rango múltiple. Tendríamos que coger (si lo que se pretende es tener la menor intensidad) un ruido bajo, combinado con el filtro 2. Además puesto que los operarios difieren en habilidad, el operario que menos tarda en desempeñar la tarea es el operario 4. 54 Compare > Analysis of variance > Multifactor ANOVA > Max. order interaction = 3. Lo primero que tenemos que asegurarnos es que el modelo sea valido -> Todos los plots ok; aunque parecen un poco extraños es porque son completamente simétricos (sólo 2 réplicas) por lo que no tenemos que preocuparnos. Vamos a ver las gráfica de interacción: 55 A la vista de las gráficas, parece que ninguna es completamente paralela, sobre todo la marcada en rojo ya que mientras que para el mismo valor de "hardwood" con una presión (400) la resistencia baja y para otra (500) sube. Por el contrario, la gráfica de la izquierda aunque hay cruce los niveles de la respuesta son bastante parecidos. Vamos a ver si esto coincide con la tabla ANOVA: Efectivamente, vemos que todos los factores son significativos de manera individual y de las interacciones tan solo es significativa la AC, aunque las demás no están lejos de serlo (en términos estadísticos si podríamos prescindir de ellas). La interacción triple no parece que sea significativa. Si hubiésemos ajustado el modelo a una interacción doble no hubiesen cambiado las cosas. Tenemos que buscar la mejor combinación de los tres factores implicados en el modelo para conseguir la mayor resistencia del papel, para ello y poder saber que combinación de niveles entre los factores nos proporciona la mayor resistencia, utilizamos JUXTAPOSE para crear una variable artificial combinando los tres factores y realizamos un estudio de análisis de la varianza con esa nueva variable. Aunque el factor B no aparece en ninguna interacción doble y triple como significativa hay que tenerlo en cuenta porque como factor sí que lo es, ya lo vimos en el análisis de tabla ANOVA. Hacemos un ONE WAY anova de la resistencia frente a esta nueva columna -> Podemos coger cualquier combinación de las filas señaladas en azul que son las que nos daran mayor resistencia. 56 Compare > Analysis of Variance > Multifactor ANOVA > Score frente al resto. Lo primero que tenemos que verificar es la validez del modelo -> Todos los plots ok incluido el de normalidad con un p- valor de 0,2727. Vamos a ver las gráficas de interacciones a ver que nos muestran: Las tres gráficas parecen indicar una clara significación de la interacción entre los factores; sobre todo las dos primeras. La gráfica de la izquierda (operador-temperatura) sin embargo no es tan "escandalosa" como las demás: al pasar del operador 2 al 3 el descenso es casi paralelo con ambas temperaturas. 57 Como vemos en la tabla ANOVA todos los factores son significativos, al igual que todas las interacciones salvo de la que hablábamos anteriormente. Parece claro que el operador no fuese in simple factor bloque; ya que interacciona con el factor A de manera rotunda. Y la interacción triple también. Si tuviéramos que dar nuestra opinión en cuanto a la mejor combinación vamos a databook> Generate Data> Y hacemos un análisis de la varianza de la puntuación frente a esta nueva columna. Si vamos a multiple Range Test vemos que podemos coger cualquier combinación de las señaladas en azul que nos darán puntuaciones parecidas (suponemos que buscamos las máximas). 58 El día aparece como un tercer factor pero en realidad queremos bloquearlo. En este caso, está claro que no podemos estudiar las interacciones triples y se supone que las interacciones dobles solo nos interesaría la de presión y temperatura porque el otro factor seria bloque Tenemos un modelo Si el modelo está recogiendo muy bien la variabilidad el plot de interacción no tiene por qué ser significativo. 59 Si miramos la tabla ANOVA vemos que la interacción no parece significativa -> Se puede ajustar al modelo aditivo porque el termino de la interacción no parece significativo. Lo que aporta al modelo es ruido Si lo quitamos aumenta el σ. Vamos a ver qué ocurre si no tenemos en cuenta el factor bloque: Si desbloqueamos el factor día, el efecto presión no va a ser significativo según la tabla ANOVA y eso es erróneo porque el estudio anterior nos muestra que si lo es. Esto se debe a que aumenta el error y por tanto su MSE por lo que los F-ratios disminuyen ya que F = /MSE Desde el punto de vista industrial pretendemos maximizar el rendimiento. Como el modelo es aditivo podemos ir a la tabla de medias y no haría falta utilizar el JUXTAPOSE La mejor es 270- high La media mejor por celdas es la combinación optima individual. 60 Como siempre lo primero que tenemos que hacer es validar las hipótesis del modelo. Nos encontramos con un plot de residuales que tiende a forma de megáfono abierto, luego ya viola la hipótesis de heterogeneidad de la varianza: Vamos a ver qué trasformación es la mejor para corregir esto: Para ello, vamos a seguir el método empírico visto en clase: A partir de la fórmula: Y realizando un ajuste de regresión, determinaremos el estimador de α. Con este estimador sacaremos el ajuste más aproximado a partir de esta tabla: 61 Con Statgraphics se haría de la siguiente forma: Lo primero que tenemos que hacer es un juxtapose en la siguiente columna de la frecuencia y el medio ambiente para realizar un anális de varianza con un sólo factor (aunque en realidad es la suma de los dos), para poder sacar level means y level sigmas, ya que esta opción solo está disponible en ONE-WAY anova. Una vez que tenemos esto: Ajuste de regresión: Vamos a y marcamos Level Means y Level Sigmas. Vamos a databook y: Nos vamos al plot of fitted Model: Comparando término a término vemos que α ≈ 1 Vamos a la tabla anterior y vemos que para un α ≈ 1 la transformación que tenemos que hacer es Logaritmo, vamos a ONE-WAY a nuestro lado izquierdo log: y en Crack Growth ponemos 62 Como podemos apreciar el plot de residuales ya no presenta forma de megáfono abierto y todas las p-valor de las pruebas de la varianza son > 0,05. Conclusión: hemos logrado corregir la heterogeneidad de la varianza. Ya podemos volver a nuestro multifactor ANOVA y hacer la transformación de forma que comprobamos que los plots ya están corregidos: Con esta corrección vemos que tanto los factores de forma individual como la interacción son significativos: Para comprobar con cual nos quedaríamos desde el punto de vista industrial ya tenemos nuestro ONE-WAY Anova hecho de antes, bastaría con ir a Multiple Range Test y como vemos las combinaciones que más rápido hacen crecer las grietas son 0,1 con agua, ya sea salada o normal. 63 Copiamos los datos del fichero Excel. La variable Dopping es el factor A, que cuenta con dos niveles. El otro factor es la temperatura del revenido (3 niveles) Compare > Multifactor Anova> Max order interaction: 2 Aunque estos gráficos no nos dan mucha información, sí que parece que la corriente base va aumentando a medida que aumenta la temperatura de revenido. Además comprobamos que todos los plots de residuales están OK 64 Los gráficos de interacciones parecen paralelos, luego veremos que dice la tabla ANOVA: Vamos a la tabla ANOVA, y vemos que la interacción está al borde, no es significativa al 5% pero prescindir de ella en el modelo es un poco temerario ya que su p-valor esta cerca del límite. Los efectos principales asociados a los factores son significativos, especialmente la temperatura. Si prescindiéramos de la interacción (bajando el orden de la interacción del análisis), vemos que aumentando el MSE al factor A le cuesta más ser significativo, ya no lo es al 1%. La variabilidad explicada también disminuye un poco. Además, al quitar la interacción vemos que el plot de residuales tiene un grupo negativo, otro positivo, luego por debajo, luego por encima.. -> falta de ajuste. 65 Aunque el grueso de la variabilidad lo recoge el factor B, al meter la interacción aparentemente no ganamos mucho, pero a pesar de eso el modelo ha ganado mucho en ajuste, aunque no a nivel de explicación. Aunque la mayoría de la variabilidad está recogida en el modelo con los parámetros que le metemos y pensemos que podemos eliminar los parámetros no significativos, si los eliminarnos puede haber falta de ajuste. A la vista de los resultados lo volvemos a poner con la interacción de orden 2. Si quisiéramos ver que nos interesa más desde el punto de vista industrial podemos ir a la tabla de Medias, pero como la interacción estaba al límite debemos mirar las celdas cruzadas. Si quisiéramos hacer una comparación de los niveles desde el punto de vista estadístico hacemos un juxtapose y posteriormente el análisis de varianza de una vía. Como vemos los mejor resultados, son los marcados en azul. Además en el apartado d) tenemos que analizar este modelo de regresión Si solo tenemos dos niveles no hay diferencia entre hacer regresión o análisis de la varianza, cuando queremos ajustarlo es como intentar ajustar una recta por dos puntos, ésta va a pasar por ella si o si. Por ello da igual si estas variables son cuantitativas o cualitativas. Si hubiera 3 niveles ya no valdría Con el x2 lo que estamos haciendo es meter un término más otro término cuadrático 66 Y el penúltimo factor lo que quiere intentar es meter la interacción, dando una forma matemática esta aunque no tiene por qué ser como la fórmula ajustada. Vamos a estudiarlo con el Statgraphics: Relate >Multiple factor >multiple regression El modelo es significativo y además todos los términos que hemos metido son significativos en presencia de los demás. Este modelo se ajusta razonablemente a los datos, además tiene un R2 del 98% En los plots como hay pocos puntos se ven constelaciones extrañas, pero son razonables. Si comparamos las dos tablas ANOVA (regresión con multifactor): Análisis de la varianza Regresión 67 En la regresión la variabilidad explicada es de 112. La suma de todos los termino suman los mismo que la regresión = 0,399 y 0,388, de tal forma que meternos en las celdas a estimar las medias es prácticamente equivalente a este modelo matemático de regresión en la que estamos dando una ecuación global a lo que ocurre en estas celdas, ya que las medias estimadas son prácticamente las mismas en las dos. Además si comprobamos los plots de residuos (que tienen la característica de cuando hay dos replicas solo) se parece bastante el de regresión con el Multifactor Anova. 68 TEMA 12: Experimentos con factores aleatorios Hasta ahora todos los factores eran considerados como efectos fijos, todos los factores tenían unos niveles específicos que interesaban a la solución. Esto no siempre es así, en algunas situaciones experimentales, los niveles de los factores se eligen al azar de una población más grande (teóricamente infinita) de niveles posibles. No nos importa en absoluto como afectan estos niveles elegidos a la respuesta, lo que quiero es sacar conclusiones sobre la población completa de niveles. En esta situación se dice que se trata de un factor aleatorio –> modelo de efectos aleatorios: un modelo en el que los factores tienen niveles que no se representan a sí mismos sino que son representantes de una población de niveles. También se conoce como modelo de componentes de la varianza, porque en vez de aportar parámetros que tienen que ver con las medias aportan parámetros que tienen que ver con las varianzas. Los experimentos no van a ser puramente con efectos aleatorios o efectos fijos, tendremos situaciones mixtas. Ejemplo: Y = rendimiento A = método de fabricación (3 métodos concretos) B= operador con controla el proceso (son muchos y elijo varios al azar para el experimento) Lo que vamos a estudiar es como el rendimiento se ve afectada por trabajar con un método u otro y cuanta variabilidad aporta el trabajador a la respuesta. Lógicamente también nos vamos a encontrar con la interacción (A*B) en la que con que uno de los términos sea un factor aleatorio, convierte el producto en aleatorio. 12.1. MODELO CON EFECTOS ALEATORIOS Para entender este modelo vamos a basarnos en el siguiente ejemplo: 69 Este ejemplo ilustra un uso importante de los componentes de la varianza: la separación de las diferentes fuentes de variabilidad que afectan un producto o sistema. Vamos a tener: Y = respuesta = Resistencia A = factor de efectos aleatorios con a niveles (elegidos al azar) – 4 telares al azar i = 1…a = 4 (los telares elegidos al azar) j = 1..n = 4 (las 4 determinaciones de la resistencia = 4 observaciones por cada telar) *Se supone que el diseño es completamente aleatorizado. ¿Cómo podemos modelar esto matemáticamente? Donde tanto τi como ɛ¡j son variables aleatorias, por lo que vamos a tener dos parámetros sigmas: στ y σ. Para probar hipótesis en este modelo se requiere que: τi v.a. N(0, στ) ɛ¡j v.a. N(0 , σ) Además vamos a suponer que son independientes todos de todos; entonces la varianza de las observaciones Var (yij) = Por eso a este modelo se le llama de componentes de la varianza. Ahora las hipótesis de interés son: Si στ = 0, todos los tratamientos son idénticos; pero si στ > 0, existe variabilidad entre los tratamientos. En nuestro ejemplo aceptar la hipótesis nula implica aceptar que la varianza es 0; es decir, que da igual estar fabricado en un telar que en otro que no va a haber una variabilidad extra. * Ocasionalmente, el método del análisis de varianza produce una estimación negativa de uno de los componentes de la varianza; si ocurre puede ser por un mal diseño del problema, pero a efectos prácticos cuando salga negativo vamos a considerarlo como 0. En cuanto a la ANOVA, las cosa no van a cambiar mucho 70 Que hacemos con estos SS para contrastar estas hipótesis. Vamos a hacer un test F en el que: . Cuanto más grande sea más se rechaza la hipótesis nula Intuitivamente la mecánica es la misma, dividimos lo que explica el factor entre lo que no explica. Pero además de ser de sentido común la clave está en esto: Como siempre, esta ecuación es invariante en todos los modelos Matemáticamente en muy diferente, pero en la práctica lo resolvemos igual. Estimación de los parámetros: En el modelo de efectos aleatorios el rechazar o aceptar una hipótesis nula resulta pobre. Nos interesa dar una estimación de los parámetros Es decir, cuánto vale aproximadamente στ y σ y luego dar un porcentaje de estos para poder ver así los márgenes de mejora. Lo que no tiene ningún interés aquí es la prueba de rango múltiple, ya que elegimos los telares en este caso al azar. Solo miramos la variabilidad que nos da los telares a la respuesta para ver si tenemos que buscar proveedores más homogéneos etc. Las medias carecen de interés, lo que cuentan son los componentes de la varianza. ¿Cómo se estiman los componentes de la varianza? -> Con el método de los momentos. E(MSE) = σ2 -> MSE = σ2 sustituimos el estadístico por su valor esperado E(MStratamientos) = σ2 + nστ2 (como ya tenemos estimado el sigma^2) - > MSEtrat = MSE +nστ2 ->despejamos el estimador de στ2 Vamos a resolver este problema con statgraphics Abrimos tabla 12-1 Compare >analysis of variance > one-way anova : resistencia vs telar Como podemos observar todos los plots ok, se cumplen las hipótesis de validez del modelo. 71 Vamos a ver que dice la tabla ANOVA: El total de la variabilidad es 111, 937. Rechazamos la hipótesis nula ya que p-valor < 0,05, es decir podemos afirmar que hay una variabilidad extra que añade la diferencia de los telares al proceso de fabricación. Nos gustaría estimar los componentes de la varianza y porcentualizarlo. Tenemos que coger los MS (el σ2 ya está estimado ya que y es = 1.8958 2 Para estimar el στ -> Compare>Analysis of variance > variance components > Resistencia vs telar (hay que meter los factores en orden de anidamiento). Como vemos la tabla ANOVA cambia: El στ2 se estima en 6,95. Las diferencias entre los telares son casi del 80%: este proceso tiene importante oportunidad de mejora si somos capaces de proveernos de telares que trabajen de valores de manera más homogénea. **Esta manera de estimar el στ2 sólo es válida con los modelos factoriales de un factor. Esto puedo tener mucha importancia en el ámbito de control de la calidad. Imaginemos que tenemos unos límites de especificación: la respuesta tiene que estar metida entre unos límites. A la vista de esta imagen vemos que tenemos una alta tasa fuera de especificaciones. Esta curva tiene la varianza VAR (ij) que como sabemos tiene dos componentes, una que no es atribuible a nada en concreto y otra a la variabilidad de los telares. Si fuéramos capaces de disminuir esta varianza (en el caso extremo erradicar la variabilidad debida a los telares) tendríamos una curva como la siguiente: 72 Compare >analysis of variance > one-way anova : calcium vs Batch Rechazamos la hipótesis nula ya que p-valor < 0,05, es decir podemos afirmar que hay una variabilidad extra que añade los lotes en el contenido del calcio. Nos gustaría estimar los componentes de la varianza y porcentualizarlo. Tenemos que coger los MS (el σ2 ya está estimado ya que y es = 0.00438 Para estimar el στ2 -> Compare>Analysis of variance > variance components > Calcium vs Batchs (hay que meter los factores en orden de anidamiento) . Como vemos la tabla ANOVA cambia: 73 Nuestro suministrados de lotes tiene un problema porque tiene mucha variabilidad, o a lo mejor es muy complejo el proceso y no podemos disminuir la variabilidad. Lo importante es saber que la hay para poder analizarlo; no siempre vamos a poder disminuir esta variabilidad. 74 Es muy frecuente diseñar experimentos estadísticos para valorar la capacidad de actitud de los sistemas de medida (R&R) ya que cualquier sistema de medida añade variabilidad a la respuesta. Se han seleccionado 20(= a) piezas del proceso de producción -> Factor A Factor B -> Tres operadores elegidos al azar (b=3). Cada operador mide cada una de las piezas un número n de veces (n = 2). Si lo modelamos matemáticamente : 75 Como todas las variables son aleatorias independientes, vamos a tener 4 varianzas: reproductibilidad Variabilidad total Varianza de las piezas **Algunos autores llaman (calibrador) Varianza de los operadores repetibilidad Varianza de la interacción Error experimental aleaotrio a reproductibilidad del instrumento de medición ya repetibilidad del instrumento de medición. De ahi el nombre de experimentos R&R (reproductibilidad y repetibilidad) En statgraphics: Abrimos la tabla 12-3 Compare > Analysis of Variance > Multifactor ANOVA Operador vs pieza y operario. En la tabla ANOVA no nos sirve de nada los p-valores dado que los F-ratios ahora no nos interesa que se hagan siempre usando MSE como denominador: damos a pane options y nos deja cambiar el término de error 76 Entonces tenemos que las piezas tienen un p-valor = 0, son diferentes entre si. EL operario y la interaccion no son significativos pero lo que nos interesa es la interacción. Tenemos que hacer estas estimaciones a mano. Que son los resultados que veiamos Una vez que tenemos el valor de todos los estimadores calcularíamos su porcenaje (sabiendo que la suma de todos los estimadores es 11,285: 0.99 = 0.0887 = 8.77% 11.285 0.015 = 0.0001 = 0.1% 11.285 10.28 = 0.91 = 91% 11.285 El error de medida es del entorno al 9%. Las diferencias entre unas medidas y otras en este caso son del 9% debido a nuestra incapacidad para medir. Dentro del error de medida: = 0.1 + 0 = 0,1% se debe a la reproductibilidad = 8.77% se debe a la repetibilidad. 77 Como nos ha salido un componente negativo, el de la interacción, y por ello lo consideramos como nulos podríamos haber ajustado este modelo a un modelo reducido (sin interacción) y así la reproducibilidad solo tendría un componente. (Bajamos el orden de interacción a 1) Puesto que no hay término de interacción, los dos efectos principales se prueban contra el término del error, y las estimaciones de los componentes de la varianza son Por último, la varianza del calibrador podría estimarse como La variabilidad del calibrador parece ser pequeña en comparación con la variabilidad del producto. Se trata generalmente de una situación deseable, la cual implica que el calibrador tiene la capacidad de distinguir entre las diferentes gradaciones del producto . 12.3. MODELOS MIXTOS CON DOS FACTORES: Hace alusión a modelos donde en el mismo diseño experimental podemos tener efectos fijos y aleatorios. Tenemos un factor A con a niveles fijos cuya influencia en la variable respuesta queremos estudiar, mientras que el factor B es aleatorio: hace alusión a toda una población de niveles posibles que tiene ese factor; es decir, lo que quiero es averiguar cuanta variabilidad añade este factor a la variable respuesta. ¿Cómo se formula? El modelo estadístico lineal es: 78 Este modelo con esta restricción sería un modelo restringido. Es una restricción muy artificial y de difícil justificación. Muchos paquetes estadísticos no tienen este modelo. Las expresiones de los cuadrados medios en este caso son: Porque es un efecto fijo En este modelo los parámetros de interés son: τ1, ..., τa -> Factor A σβ -> Factor B στβ -> Interacción Las hipótesis que tenemos que contrastar ahora son: H0 = τ1, ..., τa =0 MSA H1= τi ≠0 MS(AB) 2 H0 = σβ =0 H1= σβ2 ≠0 H0 = στβ2 =0 2 H1= στβ ≠ 0 MSB MSE MS(AB) MSE Cuando el modelo es mixto también hay que estimar los parámetros. 79 Nosotros vamos a utilizar el modelo no restringido. El modelo no restringuido es más sencillo. Ahora tenemos que las varianzas de los betas, que en este caso llama gammas, etc. y no se hace ninguna restricción sobre los Las esperanzas de los cuadrados medios serían: También tenemos que estimar los parámetros. Para verlo en Stagraphics hacemos el ejemplo 12-3, para el cual abrimos el archivo tabla 1203. Si hacemos un multifactor anova, todos los f- ratios están basados en el MSE, con las opciones de panel tenemos la posibilidad de cambiar los denominadores de los F-test. Por ejemplo, en este modelo el operario y la pieza se hace contra la interacción y la interacción contra el residual (lo que manda el modelo no restringido). 80 Otra manera de hacerlo: Si no le pongo nada mas - modelo aditivo. Lo que tenemos que hacer es: Solo con marcar la primera opción de las tablas, nos ofrece unos datos muy relevantes, donde vamos a encontrar dentro de este panel: La primera tabla nos muestra un test de significación del modelo genérico, donde podemos comprobar que existen diferencias significativas entre las medidas ya que el p-valor es 0. 81 La segunda tabla es la que tiene los tres efectos por separado, sería la misma que el multifactor ANOVA que acabamos de hacer. La tercera tabla son estas fórmulas de las esperanzas de los cuadrados medios Los números entre paréntesis son los sigmas cuadrados de las filas correspondientes a la tabla anova, el (4) quiere decir σ2. Para entenderlo mejor, la varianza de la fila cuatro (residual) es = σ2. Si lo que queremos comprobar es la E(MSA) = E(MSOperario): Operario -> (4) + 2(3) + Q1: (4) = σ2 2*(3) = 2* (sigma cuadrado de la interacción -> 3 fila) = 2*στβ2 Las Q son términos del tipo de suma de cuadrados asociados a efectos fijos. Cuando tengamos un modelo de tres factores, tendremos hasta (8): efectos por separados, efectos dobles, efecto triple y error. La siguiente tabla F-test denominators nos indica quien son los denominadores Por último tenemos los componentes de la varianza (si todos fueran aleatorios tendríamos 4 componentes de la interacción) en este caso solo tenemos tres: el asociado al factor, a la interacción y al error. 82 El operario*pieza sale negativo -> nulidad de ese efecto, evidencia muy claro en favor de la hipótesis nula de sigma beta. Solo nos faltaría la porcentualización También nos encontramos con información sobre los los R^2 Antes deberíamos haber comprobado los plots. El plot de residuos tiene un aspecto un poco extraño pero tienen que ver con la discreción de la variable. El plot de normalidad lo podemos hacer desde este mismo gráfico, botón derecho > Pane Options: 83 También tenemos l opción de realizar el Multiple Range Test; solo nos interesaría el operador, ya que para los efectos aleatorios carece de sentido. Tal como decía la tabla ANOVA no hay diferencias entre operarios. 12.6. PRUEBAS F APROXIMADAS -> PSEUDO F-TEST A partir de dos factores, en modelos que no sean puramente de efectos fijos (si fuera solo de efectos fijos es el sigma cuadrado más otras expresiones) se complican. Los pseudo f-test lo que hacen es buscar combinaciones lineales de los MS de tal manera que arriba y abajo quede el parámetro de contraste: Combinaciones Lineales de MS Combinaciones Lineales de MS de forma que me quede MS del efecto a contrastar / Combinaciones lineales de MS sumando y restando. Mediante fórmulas aproximadas podemos dar unos grados de libertad aceptables. Vamos a ver por ejemplo como sería en algunos casos: Por ejemplo, ¿cómo contrastaríamos el efecto A, aquí arriba nos da una pista: Si sumamos MSA + MSABC / MSAB + MSAC ≈ MSA / MSAB + MSAC - MSABC MSA + MSABC MSA ≈ MSAB + MSAC MSAB − MSAC + MSAC 84 Para hacer esto en statgraphics, metemos la tabla 12-13 que proviene del ejemplo 12-7 ¿Cómo se han hecho estos test -f? 85 Los denominadores son: Cuantos componentes tendrá la varianza, el número de filas menos el factor fijo Temperatura: operador, manómetro,..., en total: 7 Todos aquellos que sean efectos fijos tendrán en sus esperanzas medias un término Q. Problema 12-21. Copiamos los datos del ejercicio 21. El operador es de efectos aleatorios, cosa bastante razonable. Y la temperatura y la duración de ciclo son efectos fijos. Si queremos analizar estos datos: 86 Todos los plots parecen correctos, veamos el de normalidad. 87 Podemos apreciar algo de curvatura pero es normal. Aun así si queremos ver el p-valor, tendríamos que grabar los residuos y realizar un Normal probability plot. Obtenemos un pvalor = 0,27 Ahora miramos en el primer panel de los cuadrados medios esperados. Tenemos dos efectos fijos (Temperatura y tiempo de ciclo) por tanto la interacción entre ambos también va a ser fijo. El más complicado es el del operador porque no tiene ningún denominador exacto. Entonces para este efecto haremos un pseudo F-test, es decir, una aproximación de F-test. 88 Además, si echamos un ojo a la tabla ANOVA: Desde el punto de vista estadístico vemos que los p-valores son bastante altos. Pero tenemos el de triple interacción y el de ciclo con operador que son menores de 0,05. Luego, aunque por sí solos no encontramos diferencias significativas, sí que lo hay en las interacciones. El tiempo de ciclo no es significativo, la temperatura tampoco y la interacción entre ellos dos tampoco. Por lo tanto, los efectos fijos en este modelo no son significativos desde el punto de vista estadístico. Nos centramos entonces en los modelos de efectos aleatorios. En este caso no interesan las pruebas de rango, nos interesa porcentualizar los componentes de la varianza. La única información relevante tiene que ver con la variabilidad que aporta al proceso la intervención del operador, como vemos en la tabla anterior todo lo que aporta variabilidad tiene entre sus factores el operador. El σ2=3.28 por lo tanto no es el componente de la varianza más importante, es decir, si pusiéramos las estimaciones de las varianzas de los factores del modelo en % respecto del total de la variabilidad obtendríamos que el mayor porcentaje de variabilidad del modelo es debido a la interacción "cycle*operator". Para obtener la variabilidad total, sumamos 2.64+12.89+2.75+3.28= Sobre la variabilidad total que observamos en la producción el 85% está influenciada por distintos aspectos debidos a la labor del operador, es decir, que vamos a tener un amplio recorrido de mejora que tiene que ir en la dirección de adiestramiento, formación... dado que son los operadores los que añaden una mayor variabilidad al resultado. 89 Abrimos los datos HICK TAB 10-03. Tenemos dos factores aleatorios (days and operators) y uno fijo (gate settings). Los operadores son siempre los mismos cada día, luego no están anidados -> General Lineal Models 90 Todos los plots OK Lo primero que miramos es la tabla de p-valores. Lo más significativo estadísticamente es la interacción triple. Los demás son algo significativos, pero todos vinculados al operador. Otra cosa muy reseñable es que el primero de los p-valores es prácticamente nulo. Si que vamos a tener que decir algo sobre los efectos aleatorios, es decir, cuál es la puerta que nos conviene (MRT) La tabla de los componentes de la varianza tiene un valor nulo, y el resto son muy pequeños. No por ello, no van a ser importantes, lo que tenemos que hacer es porcentualizarlo. Llegamos a la misma conclusión que antes, el operador juega con un papel muy importante en la variabilidad, adiestramiento, formación, etc. Source Estimate DAY 0 OPERATOR 0,00373472 GATE*DAY 0,000531944 GATE*OPERATOR 0,00205833 DAY*OPERATOR 8,47222E-05 GATE*DAY*OPERATOR0,00107639 Residual 0,000325 Total 0,007811106 Porcentaje 0,00 % 47,81 % 6,81 % 26,35 % 1,08 % 13,78 % 4,16 % Si miramos la tabla de los cuadrados medios esperados solo aparece un Q1, es decir solo hay un parámetro de efectos fijos 91 Cuando esta tabla tiene saltos bruscos y no “baja” en escalera, nos indica que vamos a tener que utilizar f-test. Efectivamente, como vemos en la tabla siguiente las 3 primeras son combinaciones: Con respecto a las puertas tendríamos que hacer el MRT; los tres tipos de puertas se comportan de manera diferente: Vamos a hacer otro problema de R&R (Reproducibilty & Repetibilty) - Problema 12-9 Como todas las variables son aleatorias independientes, vamos a tener 4 varianzas: reproductibilidad Variabilidad total Varianza de las piezas Varianza de los operadores repetibilidad Varianza de la interacción Error experimental aleaotrio 92 **Algunos autores llaman a reproductibilidad del instrumento de medición (calibrador) ya repetibilidad del instrumento de medición. De ahí el nombre de experimentos R&R (reproductibilidad y repetibilidad) En este modelo los dos factores son de efectos aleatorios: Lo primero, como siempre, es mirar los plots de residuales que como vemos parecen bastante aceptables. Los R&R requieren de un análisis más detallado. Nosotros vamos a ir a los componentes de la varianza, la única variabilidad que aporta al sistema de medida tiene que ver con la repetibilidad, el ruido está en las distintas mediciones que hace el operador en cada pieza, en el aparato. De reproductibilidad no hay nada, ya que = 0. Como este Stagraphics es muy utilizado industrialmente tenemos un paquete especial dedicado a la calidad - SPC - gage studies > ANOVA method: 93 Ahora tenemos que decir si lo ajustamos con o sin interacción; en un principio vamos a poner la interacción. Esta tabla ANOVA es la misma, pero nos saca una columna al final con los porcentajes, ésta nos dice que la repetibilidad es el 100% de la medida. La columna a su izquierda indica la variabilidad debido a las piezas (56%) y debida a la repetibilidad 46%. Una vez que sabemos que no hay interacción quitamos del modelo la interacción. Como vemos es muy parecida a la anterior. La columna a su izquierda indica la variabilidad debido a las piezas (56%) y debida a la repetibilidad 45%. 94 TEMA 13: Disenos anidados y de parcelas subdivididas Para entender este capítulo vamos a ver el ejemplo 13. 1 Los diseños anidados lo que plantean es otra forma de relacionarse los factores entre sí. Lo que tenemos aquí es una variable respuesta (pureza) y otros dos factores: proveedor y lote. Y = pureza Factor A = Proveedor -> a =3 (efectos fijos) Factor B = Lote -> b = 4 (efectos aleatorios) n = 3 -> número de réplicas 95 La diferencia fundamental con los diseños que veíamos antes es que ahora cada lote va a ser de un proveedor, no podemos hacer una tabla cruzada. En este caso tenemos un esquema anidado o jerarquizado. P1 P2 L1 L2 L3 L4 L1 L2 L3 L4 P3 L1 L2 L3 L4 Modelo jerarquizado en dos niveles en este caso. Estos niveles se caracterizan porque los niveles de un factor están anidados bajo otro factor. La interacción ahora deja de tener sentido, antes la interacción era el efecto particular que producía la interacción de los niveles de los distintos factores. Por lo que vamos a tener un término menos. ¿Cómo se formula este modelo matemáticamente? Necesitamos un subíndice para la rama principal (i), otra para la rama secundaria (j) y otro para la replicaciones (k). Se suele poner j(i) para indicar el anidamiento de B en A. Resulta conveniente considerar que las réplicas están anidadas dentro de la combinación de los niveles de A y B; por lo tanto, se usa el subíndice (ij)k para el término del error. Se trata de un diseño anidado balanceado, ya que hay el mismo número de niveles de B con cada nivel de A y el mismo número de réplicas. El no balanceo aquí podía tener muchas fuentes. ¿Cómo hacemos ahora el ANOVA? - El primer término mide el efecto del factor A. El segundo término pretende explicar el efecto del factor B anidado en A; es decir, las diferencias entre las subramas. Finalmente, el último factor representa el error aleatorio; las diferencias dentro de las subramas. Entonces la variabilidad total se compone de: 96 ¿Qué hacemos ahora con estos cuadrados medios para construir los F-test? Necesitamos conocer las esperanzas; esto va a depender de muchos factores. Existen tres posibilidades: que ambos fueran de efectos fijos, de efectos aleatorios, o A fijo y B aleatorio (el A aleatorio y B fijo no existe, no tiene sentido). De ahí que al modelo matemático haya que añadirle unas restricciones, similares a las que hacíamos en los efectos factoriales. Contraste de hipótesis Para saber cómo tenemos que hacer los contrastes de hipótesis en cada caso, la siguiente tabla resume los tres modelos que podemos encontrarnos. - Para contrastar el factor A y B en el caso de efectos fijos dividimos el MS(A) y el MS(B) entre el MSE. - En el caso de efectos aleatorios, nos queda una batería de expresiones telescópica, de abajo arriba se va sumando la fila anterior más otro término. En este caso para los test-F tendremos que dividir cada fila por la siguiente. - En el modelo mixto también queda telescópico, la única diferencia es el término asociado al factor A. Vamos a hacer el ejemplo con Statgrpahics. Abrimos la tabla 13-3. Todos los modelos se resuelven con general lineal models, salvo cuando todos los factores son completamente aleatorios para lo cual vamos a tener una herramienta específica. 97 Ahora sí que son interesantes los scatterplot: buscamos las diferencias entre proveedor. En el caso del lote no interesa tanto ya que es un factor aleatorio. Los gráficos de residuos son más o menos correctos. En el caso de la tabla ANOVA, vemos que está descompuesta en dos: La primera de ellas tiene que ver con el ajuste general y una especie de test de significación de la regresión. Pero sobre todo, la que más nos interesa a nosotros es la segunda, donde tenemos las tres filas de efectos a estudiar. A la vista de esta tabla vemos que las diferencias entre purezas no están causas por las diferencias entre proveedores. La primera fila lo que muestra es el contraste: H0 = τi = 0 H1 = τi≠ 0 para todo i Con lo que concluimos a la vista de los resultados que el cambio del proveedor no es la causa de las diferencias globales que observamos en la respuesta. 98 En el segundo caso, lo que estamos contrastando es: H0 = σβ2 = 0 H1 = σβ2 ≠ 0 para todo i A la vista de la tabla ANOVA vemos que las diferencias entre lotes sí que proporcionan un aumento de la variabilidad de la pureza. Pero lo importante es decir cuánto representa en tanto por ciento. Para ello miramos la tabla de variance check que si lo hacemos porcentualmente vemos que más o menos el 40% se debe diferencias entre lotes y 60% variabilidad de residual. Para el caso del proveedor, factor fijo como ya habíamos visto en la ANOVA, no tiene diferencias significativas. Los comprobamos con el MRT. Los cuadrados medios esperados, para el proveedor es una suma de tres componentes donde aparece un Q1 (señal de que es efecto fijo). También podemos ver los denominadores asociados. 99 Vamos a suponer que ambos factores son aleatorios. Compare > Analysis of variance >general lineal models: Tenemos el típico plot de residuos simétricos porque solo hay dos réplicas. El plot de normalidad sigue una distribución muy uniforme; si grabamos los residuos vemos que el plot de normalidad nos ofrece un p-valor <0,05. Mal arreglo... 100 Si vemos el gráfico de bigotes (del análisis de normalidad), y vemos que los cuartiles son idénticos, es el gráfico típico de una distribución uniforme. Este hecho se deberá seguro a que los datos son artificiales. Como tiene mal arreglo no vamos a hacer nada, simplemente tomar con cautela los p-valores. Para hacer este gráfico, tenemos que ir a: Y meter como variables respuesta: Residuals. Volvemos a la tabla ANOVA, y vemos el esquema telescópico de las esperanzas de los cuadrados medios. Al ser los dos efectos aleatorios vamos a la tabla de variance componentes para porcentualizarlos. Las diferencias entre máquinas son del 39 % y de las maquinas en función de cada operador casi también -> Mucha oportunidad de mejora. También podíamos haberlo hecho (solo cuando sea un modelo con TODOS los efectos aleatorios y jerarquizados) con: Compare >Analysis of variance> componentes de la varianza ¡¡Ojo al orden en que lo metemos!! 101 Esta tabla ANOVA es diferente a la que estamos acostumbrados, nos saca los componentes de la varianza y su porcentualización. No se molesta en poner los p-valores porque interpreta que no son necesarios. *¿Qué pasaría si quisiéramos abordar estos datos desde el punto de vista de un multifactor ANOVA? Si comparamos esta tabla con la anterior, vemos que el ANOVA tiene elementos en común: la suma de cuadrados total va a ser la misma. La suma de cuadrados del factor A, que es el primero en la línea de anidamiento va a ser el mismo, lo que cambia es que la fila del operador bien analizada (jerarquizado) se compone de lo que resulta de sumar el B más la interacción. Los grados de libertad también son la suma. Si solo tuviéramos programada la herramienta del multifactor ANOVA, podríamos hacer este análisis sumando la suma de cuadrados del B más la interacción. Sólo valdría para esto, la suma de cuadrados tendríamos que analizarla. Resumiendo, tenemos una herramienta específica para los modelos jerarquizados, por cuando son puros, (todo con factores aleatorios) tenemos una herramienta especial. Lo que no vale es hacer un multifactor ANOVA, habría que arreglar la tabla. Abrimos HICK 11.2 Todos los plots OK. Miramos la tabla ANOVA; la máquina no es significativa, pero la cabeza casi sí. No tenemos ningún componente de la varianza al ser todos fijos. 102 Podemos mirar en la tabla de medias, para ver las diferencias, habría que buscar los valores más bajos. Tendríamos que ir sincronizando en cada rama donde hay problemas. Si hubiera diferencia entre las máquinas iríamos al test de comparaciones múltiples. 103 Todos los plots ok Vamos a la tabla ANOVA y tenemos que las diferencias entre la aleación no son significativas. Las diferencias entre hornadas están en el borde de ser significativos, si que hay que tenerlas en cuenta. Aunque no sea significativo el factor anidado desde el punto de vista del componente de la varianza, el 35% aproximadamente de la variabilidad se debe entre las diferencias de los lingotes. El modelo es un poco pobre, las hornadas en sí mismas se prestan mucho más a ser de efectos aleatorios. Estas hornadas deberían ser representantes de la infinita población que puedo tener. Por ello volvemos a plantear el modelo poniendo la hornada como un efecto aleatorio: Los cuadrados medios esperados de la aleación son diferentes cuando la hornada es fija que cuando es aleatorio. Esta forma telescópica sólo se produce cuando el diseño tiene el primer efecto fijo (que siempre sea el primero) y el resto aleatorios 104 Las hornadas nos afectan un componente de la varianza muy grande: más del 50%. No hay diferencias entre aleaciones. Tenemos que armonizar las hornadas ya que introducen mucha variabilidad, y dentro de las hornadas también hay que armonizar los lingotes. No lo podemos analizar con Variance components, porque no son todos aleatorios; la porcentualización no sería correcta. EJEMPLO CALIDAD: No pensemos que las unidades son un factor, son las réplicas. Abrimos los datos “Calidad” Recordemos que estamos en un Modelo de componentes de la varianza: - Todos los efectos son aleatorios - Completamente aleatorizado. E(MSA) = σ2+ O*σγ2 + O*σβ2 + O*στ2 E(MSB(A)) = σ2+ O*σγ2 + O*σβ2 E(MSC(AB))= σ2+ O*σγ2 E(MSE) = σ2 Esto es lo que decimos forma telescópica, cada uno de ellos se calcula restando el MS correspondiente a la fila anterior menos la fila suya y la constante que corresponda, en este caso lo hemos representado por O. Si analizamos estos datos con General Lineal Models: 105 Lo único que no tenemos aquí son los componentes de la varianza que los tenemos debajo, lo que pasa es cuando un componente sale negativo, modifica las expresiones de los componentes de la varianza. El tercer componente sería (2.93-0.756)/5, el segundo saldría de hacer (1,532-2,93)/10. Para conocer el numerador basta con mirar la tabla ANOVA, el denominador lo sacamos de: También podemos estudiar este problema con VarianceComponents: 106 ¡Muy importante el orden! Todos los plots de residuales parecen aceptables. Pasamos a mirar la tabla ANOVA: Lo normal es que las sumas de cuadrado vayan en orden creciente. En este caso como la suma de los cuadrados es 9, que es menor que la de las máquinas (23) sale negativa. Tendríamos ya la porcentualización de los componentes de la varianza: el 60% variabilidad residual atribuible a otras cosas que no hemos considerado en el experimento. La heterogeneidad de la fabricación producen diferencias entre los lotes que representan un 34%, las maquinas sólo un poco. ¿Por qué cambian los compontes de la varianza? General Lineal Models: Variancecomponents Las dos últimas coinciden pero a partir de operarios no, ya que la tabla ANOVA nos dice que el σβ2es 0. Ahora el 0(2) de la tabla siguiente va a ser 0. 107 Si lo quitamos de estas fórmulas, vemos que al MS(A) le restamos el MS(C(AB)), no con el MS(AB). Tendríamos que hacer caso al segundo análisis (componentes de la varianza), ya que no tiene en cuenta al signo negativo de los componentes de la varianza, sino que lo considera nulo, como debe ser. Tenemos que prestar especial atención cuando el componente sea muy negativo. MODELO FACTORIAL ANIDADO O ANIDADO FACTORIAL (Pág 569): En experimentos con factores múltiples, algunos factores pueden estar incluidos en un arreglo factorial yotros estar anidados. En ocasiones a estos diseños se les llama diseños factorialesanidados. Por supuesto, vamos a seguir teniendo la posibilidad de que unos efectos sean de efectos fijos y otros aleatorios. El análisisestadístico de un diseño así con tres factores se ilustra en el ejemplo siguiente. 108 Los arreglos y los dispositivos son fijos y los operadores son elegidos al azar-->Modelo mixto El operador está anidado en el arreglo (parámetro γ), como esta anidado no tiene sentido la interacción betta- gamma (operador-arreglo). Pero sí que va a haber interacción del operador con el arreglo y operador-dispositivo. Si hiciéramos el ANOVA factorial, consideraría los términos de interacción que no son, ya que no tendría en cuenta el anidamiento. Abrimos la "tabla 13-09" Recordemos que nosotros utilizamos los modelos NO RESTRINGIDOS si queremos compararlo con los datos que ofrece el libro de Montgomery. 109 Vemos que tiene tres componentes paramétricos; el del dispositivo, el arreglo y la interacción. (Q1,Q2 Y Q3) Vamos a tener 3 componentes de la varianza: todo lo relacionado con el operador, ya que éste es aleatorio. Si observamos el plot de residuos, éste muestra una estructura simétrica con respecto al 0, debido a que sólo hay dos réplicas. El plot de normalidad tiene una ligera curvatura pero no especialmente llamativa. Sin embargo si grabamos los residuos y hacemos el plot de normalidad con ellos el test de Shapiro–Wilk nos muestra un p-valor muy próximo a cero -> rechaza la normalidad. Tenemos que tomar los datos con precaución. 110 Pasamos a ver la tabla ANOVA: Los dispositivos sin son importantes pero la interacción y el arreglo no. Los p-valor de los componentes de la varianza no nos importan. Miramos en variance components.. Todo lo que hace referencia a los operadores es digno de tener en cuenta a la hora de pensar en mejora, ya que más de la mitad de la variación es debido a ello. (1,57 + 1,08)/total(5) = 53% Ahora tenemos que elegir que dispositivo nos interesa más. SI vamos a MRT vemos que claramente que entre el dispositivo 1 y 3 no hay diferencias significativas en cuanto al tiempo medio; sin embargo el dos es diferente y bastante mayor.Como interesa minimizar el tiempo escogemos el 1 y 3. Los arreglos como era de esperar no tiene diferencias. No hace falta ver la justa posición ya que los p-valores no son muy importantes. 111 Siempre: para los efectos fijos buscar las diferencias y para los aleatorios los componentes de la varianza. ... .. ... 1. Plantear el modelo y explicar sus términos: Variable respuesta Y = disparos por minutos (DPM) A = Métodos: Efecto fijo -> Nuevo y antiguo B = Constitución física-Grupo-> Efecto fijo -> Ligeros, medianos y pesados C = Hombres- Equipo- > Efectos aleatorio, anidado en constitución física. 2 réplicas 112 El modelo lineal para este diseño es: 1,2 1,2,3 1,2,3 1,2 Donde τi es el efecto del método i-ésimo, βj es el efecto de la constitución física j-ésimo, es el efecto del hombre k-ésimo dentro del nivel j-ésimo de la constitución física, interacción método-constitución física, constitución física y es la es la interacción método-hombre dentro de es el término de error usual. Tanto , , como ɛ(ijk)l son variables aleatorias independientes, supondremos también que estas variables aleatorias siguen una distribución normal con media cero y varianzas dadas por V( observación es: )=σγ, V[(τγ)ik(j = στγ y V(ɛ(ijk)l) = σ. Por tanto, la varianza de cualquier V(yijkl) = σγ + στγ + σ y σγ , στγ y σ son los componentes de la varianza. En cambio, τi , βj y son efectos fijos tales que ∑𝑎𝑖=1 𝜏𝑖 = 0: ∑𝑏𝑗=1 𝛽𝑗 = 0 y ∑𝑎𝑖=1 𝜏𝛽(𝑖𝑗) = 0 ∀j ∑𝑏𝑗=1 𝜏𝛽(𝑖𝑗) = 0 ∀𝑖 . Es decir, la suma de los efectos del tratamiento A(métodos) y la suma de los efectos del tratamiento B(grupos) , así como la suma de los efectos de la interacción, es cero. - Validar el modelo 113 Vemos que tiene tres componentes paramétricos; el del método, la constitución física y la interacción. (Q1,Q2 Y Q3) Vamos a tener 3 componentes de la varianza: todo lo relacionado con el equipo, ya que éste es aleatorio. Si observamos el plot de residuos, éste muestra una estructura simétrica con respecto al 0, debido a que sólo hay dos réplicas. Es razonablemente aleatorio. El gráfico de residuos frente al número de fila nos da mala espina: todas las observaciones de la primera parte tienen signo negativo y la segunda signo positivo. Si vamos a los datos, vemos que siempre la segunda réplica es mayor, lo que quiere decir que de la primera réplica a la segunda globalmente ha habido un aumento. Esto lo que quiere decir es que no se ha aleatorizado convenientemente, puede ser que haya habido un aprendizaje que se manifiesta en que la primer réplica siempre sea menor. Lo que pasa es que como está repartido no va a afectar mucho pero hay una estructura inadecuada. Lo único bueno es que ha afectado a todos los factores por igual. 114 El plot de normalidad tiene una ligera curvatura pero no especialmente llamativa. Si grabamos los residuos y hacemos el plot de normalidad con ellos vemos que el test de Shapiro–Wilk nos muestra un p-valor>0,05 -> Soporta la normalidad. 115 - Estimar los efectos fijos, si los hubiere. Una vez que ya tenemos validado el modelo pasamos a ver la tabla ANOVA: El método utilizado si es importante pero la interacción y el grupo no. Con lo cual lo relevante es el método. Los p-valor de los componentes de la varianza no nos importan. Ahora tenemos que elegir que método interesa más, sólo tenemos en cuenta el método ya que es el único. SI vamos a MRT vemos que el método nuevo es mejor que el antiguo ya que buscamos maximizar los disparos por minuto. Entre los grupos, como era de esperar no hay diferencias; es decir no importa la constitución física de los hombres. Estimar los componentes de la varianza y sacar conclusiones. Los componentes de la varianza que tenemos son: el equipo dentro del grupo y la interacción de éste con el método. Si miramos los p-valores de estos componentes vemos que en el caso del equipo estaba en el borde de ser significativo y el de la interacción era muy grande. Aunque no tiene una relación lineal si vamos a Variance Components vemos que para la interacción, que tenía el p-valor tan grande da negativo, en el caso del Equipo(Grupo) que estaba en el borde de ser significativo tenemos una estimación de la varianza en 1,19. Miramos los cuadrados medios esperados para rehacer esta tabla considerando el componente negativo como 0. y además porcentualizamos. 116 Ahora el estimador del equipo viendo la tabla izquierda será: (MS(C(B)) – MSE )/ a = 1.05 Source EQUIPO(GRUPO) METODO*EQUIPO(GRUPO) Residual Mean Square Estimate 6,54306 1,058125 1,78694 0 2,31056 2,31056 TOTAL 3,368685 Porcentaje 31,41 % 0,00 % 68,59 % Conclusión: de las metodologías las nuevas son sustancialmente mejor, produce en promedio 8 disparos más o menos y de los factores aleatorios que el grupo hay que tenerlo en cuenta ya que introduce una variabilidad extra. ** Recordemos que el gráfico de residuos frente al número de fila nos daba mala espina. Si ponemos en el fichero de datos una nueva columna llamada réplica, donde las 18 primeras sean un 1 y las 18 segundas 2. Vamos a general lineal models y ponemos los mismos efectos que antes pero añadiendo el factor D Como vemos en la tabla ANOVA la réplica es significativa de manera clara. 117 Además vemos que ya el método*equipo ya no tiene un estimador negativo Es decir una parte de la que antes veíamos como variabilidad residual está asociado a los equipos. Estaría mejor analizado este modelo. Variable respuesta Y = rendimiento A = Ajustes de potencia: Efecto fijo -> 1,2 B = Máquinas-> Efecto fijo -> 1,2,3 C(B) = Estaciones- > Efecto fijo, anidado en máquina -> 1,2,3 3 réplicas El modelo lineal para este diseño es: 1,2 1,2,3 1,2,3 1,2,3 Donde τi es el efecto del ajuste i-ésimo, βj es el efecto de la máquina j-ésima, de la estación k-ésima dentro del nivel j-ésimo de máquinas, Máquina, error usual. es el efecto es la interacción Ajuste- es la interacción ajuste-estación dentro de máquina y es el término de 118 Todos los efectos, salvo el error son fijos luego habría que añadir las restricciones: ∑𝑎𝑖=1 𝜏𝑖 = 0: ∑𝑏𝑗=1 𝛽𝑗 = 0 ∑𝑐𝑘=1 γk(j) = 0 ∑𝑐𝑘=1(τγ)ik(j) = 0 ∀i ∑𝑎𝑖=1 𝜏𝛽(𝑖𝑗) = 0 ∀j ∑𝑎𝑖=1(τγ)ik(j) = 0 ∀k ∑𝑏𝑗=1 𝜏𝛽(𝑖𝑗) = 0 ∀𝑖 Si miramos el scatterplot en principio sí que parece que puede haber diferencias en el ajuste de potencia, el de la máquina no está tan claro y el del anidado no nos dice prácticamente nada. El gráfico de interacción las tres líneas son paralelas (Power Machine). También lo son en el segundo factor (Yield Machine) 119 Vemos que todos tienen componentes paramétricos; ya que todos son de efectos fijos.Por ello, el único componente de la varianza va a ser el relacionado con el error. Todos los cocientes de la tabla ANOVA son contra el error como estábamos acostumbrados en los multifactoriales. Antes de empezar a sacar conclusiones tenemos que validar el modelo: Como vemos, ambos son bastante aceptables. El plot de normalidad tiene una ligera curvatura pero no especialmente llamativa Una vez que ya tenemos validado el modelo pasamos a ver la tabla ANOVA: Todos los factores resultan significativos, además de la interacción del ajuste con la estación (anidada en máquina). No ocurre esto con la interacción ajuste-máquina. 120 Ahora tenemos que elegir que combinación nos interesa más, teniendo en cuenta que hay que maximizar los rendimientos, vamos a MRT: La potencia como vemos tendríamos que elegir la 1 que tiene en promedio 8 puntos de diferencias más. En cuanto a la máquina dos son comparables: la 3 y la 2. En cambio preferimos la 1. Lo que pasa es que hay interacción, vamos a la tabla de medias y vemos que la de mayor rendimiento es la potencia 1 en la máquina 1 y la potencia 1 en la máquina 2. Como ya sabíamos la potencia 1 producía más rendimiento y dentro de esta la maquina 1, que es lo que nos decía también las pruebas de rango múltiple. La interacción ha empujado en la misma dirección * ¿Qué pasaría si hubiesen sido las máquinas de efectos aleatorios? Solo tendríamos que poner que B es aleatorio porque si un factor cuelga de otro aleatorio, como es el caso de C, este pasa directamente a ser aleatorio. Como podemos observar en la tabla inferior, aunque no hayamos marcado C como random, tiene componente de la varianza. En este caso los test F cambian de manera radical los contrastes de hipótesis. Además de la tabla ANOVA que vemos ahora la maquina no es significativa. La estación y la interacción tampoco. El último sí. Es decir la estructura es completamente diferente por eso no es trivial comprender bien el modelo y formularlo bien. 121 Variable respuesta Y = resistencia Tamaño de la barra: efecto fijo -> 1.0, 1.5 o 2.0 pulgadas -> 1,2,3 Fabricante-> Efecto fijo -> 1,2,3 Hornadas- > Efectos aleatorio, anidado en fabricante -> 1,2,3 2 réplicas El modelo lineal para este diseño es: 1,2 1,2,3 1,2,3 1,2,3 Donde τi es el efecto del tamaño de barra i-ésimo, βj es el efecto del fabricante j-ésimo, es el efecto de la hornada k-ésima dentro del nivel j-ésimo de fabricantes, interacción Tamaño de la barra- Fabricante, hornada dentro de fabricante y es la es la interacción tamaño de la barra- es el término de error usual. 122 Vemos que tiene tres componentes paramétricos; el de la barra, el fabricante y la interacción. (Q1,Q2 Y Q3) Vamos a tener 3 componentes de la varianza: todo lo relacionado con la hornada, ya que éste es el factor aleatorio. Si observamos el plot de residuos, éste muestra una estructura simétrica con respecto al 0, debido a que sólo hay dos réplicas. 123 El plot de normalidad tiene una ligera curvatura pero no especialmente llamativa. Si grabamos los residuos y hacemos el plot de normalidad con ellos vemos que el test de Shapiro–Wilk nos muestra un p-valor>0,05 -> Aceptamos normalidad. Una vez que ya tenemos validado el modelo pasamos a ver la tabla ANOVA: Ni los efectos fijos ni su interacción presentan diferencias significativas. Miramos en variance components y además porcentualizamos Source Heat(Vendor) Bar Size*Heat(Vendor) Residual Estimate 0,00263 0,000257 0,000404 0,003292 Porcentaje 79,90 % 7,82 % 12,28 % Todo lo que hace referencia a las hornadas es digno de tener en cuenta a la hora de pensar en mejora; casi el 88% de la variabilidad de la respuesta es debida al a la hornada; tendremos que intentar armonizar las hornadas. No hace falta hacer los multiple range test ya que ningún efectos fijo ha sido significativo. 124 Material adicional: Introduccion al control estadístico de procesos (temas 12 y 13) LIE LSE En este caso se dice que el sistema tiene capacidad 1, ya que la distribución está justo dentro de los intervalos LIE y LSE. La varianza total de cualquier observación va a ser igual VarY = σy2 + 𝝈𝟐𝒎𝒆𝒅𝒊𝒅𝒂 . Si soy capaz de desprenderme de σmedida2 la campana se hace más ajustada, mucho mejor. Vamos a tener dos ratio para medir la capacidad: P/T (Razón Precisión/Tolerancia): !Ojo! El el sigma no la varianza - > √𝝈𝟐𝒎𝒆𝒅𝒊𝒅𝒂 Interpretación: Porcentaje de la variabilidad de medida sobre variabilidad del producto: 125 2. En el fichero MEDIDA.sf3 se muestran los datos de un estudio para valorar la capacidad de un sistema de medida. Se han tomado al azar 20 piezas y se han realizado dos mediciones en cada pieza. e) Valorar la capacidad del sistema de medida aplicando un modelo de componentes de la varianza. f) Hacer lo mismo aplicando el método de Medias y Rangos. g) Valorar la capacidad del sistema de medida si los límites de especificación para el producto son 22 ± 2. e) Valorar la capacidad del sistema de medida aplicando un modelo de componentes de la varianza. Es un experimento de un único factor A = piezas. Estas se han elegido al azar, luego es de efectos aleatorios. Esquema de árbol de un solo nivel, el más sencillo posible. El modelo lineal sería: Yij = µ + τi + ɛij i = 1...20 j = 1,2 τi v.a. N(0, στ) ɛ¡j v.a. N(0 , σ) Además vamos a suponer que son independientes todos de todos; entonces la varianza de las observaciones Var (yij) = Variabilidad entre las piezas Variabilidad sistema de medida Vamos a Analysis of Variance > Variance components: Vemos que la variabilidad total se divide en dos partes: 9,566 se debe a las piezas (la varianza que yo tendría si el sistema de medida fuese impecable) y el 0,75 es la varianza del sistema de medida. 126 c) Valorar la capacidad del sistema de medida si los límites de especificación para el producto son 22 +- 2. Entonces el P/T ratio lo podemos calcular: (ojo el sigma que nos da la tabla ANOVA es al cuadrado, tenemos que hacer su raíz) Este es igual a 𝑃 𝑇 = 6∗√𝝈𝟐 𝒎𝒆𝒅𝒊𝒅𝒂 𝐿𝑆𝐸−𝐿𝐼𝐸 = 6∗0.866 4 = 1,3 Estamos hasta por encima de 1, este sistema de medida es un desastre o los límites de especificaciones son irreales. 3. En el fichero EXAMP 9-8bis.sf3 se muestran los datos de un estudio R&R para valorar la capacidad de un sistema de medida. Se han tomado al azar 20 piezas y 3 operarios y cada operario ha realizado dos mediciones en cada pieza. a) Estimar los componentes de la variabilidad del sistema de medida mediante un modelo de análisis de la varianza. b) Hacer lo mismo aplicando el método de Medias y Rangos. c) Valorar la capacidad del sistema de medida si los límites de especificación para el producto son 22 ± 2. a) Estimar los componentes de la variabilidad del sistema de medida mediante un modelo de análisis de la varianza. Todos los plots OK. Vamos a ver la tabla ANOVA: 127 El que las piezas tengas un p-valor 0 es lógico y esperable lo que importa es lo demás, para ello miramos la tabla de componentes de la varianza. Tenemos un componente negativo, que es el operario, pero no podemos quitarlo porque está la interacción. A veces, hay que dejar los modelos más sencillos pero manteniendo un principio de jerarquía; si yo tengo la interacción AB porque es importante no puedo quitar el factor B. Reproducibilidad Repetibilidad De estos componentes los que tienen que ver con la medida son las 3 última filas. La pieza no está dentro ni de repetibilidad ni de reproductibilidad. *En este caso convertir en 0 el 𝜎 2 de los operarios no modifica los otros valores. Statgraphics tiene un paquete especial para estos análisis: Vemos que es la misma tabla que habíamos obtenido antes. Sin embargo, no ofrece una tabla más (la que tenemos debajo) que nos da el porcentaje de reproductibilidad y repetibilidad. 128 **Nosotros tratamos la interacción como reproducibilidad. Lo de las piezas solo nos interesa para ver qué porcentaje representa lo otro. El porcentaje en el R&R no nos da el sigma de medida. Para hacer el P/T ratio hay que tener la raíz cuadrada de la suma de (1,197+0,99) = σβ2 𝟐 𝑃 6 ∗ √𝝈𝒎𝒆𝒅𝒊𝒅𝒂 6 ∗ 1.478 = = = 2,21 𝑇 𝐿𝑆𝐸 − 𝐿𝐼𝐸 4 P/t ratio = 2,21 – la situación no es creíble, tener una situación tan mala es insostenible. c) Valorar la capacidad del sistema de medida si los límites de especificación para el producto son 22 ± 2. 1.478 √7.83 = 1.478 ∗ 100 = 52.8% 2.79 1. En el fichero PULIDO.sf3 se muestran los datos tomados en un proceso de pulido de piezas de mármol para ensolado. En la fábrica hay una gran cantidad de máquinas pulidoras que son controladas por distintos trabajadores cada una. La piedra bruta se recibe de distintos proveedores. Para controlar las distintas fuentes de variabilidad en el resultado de la calidad del pulido se elige al azar una muestra de seis máquinas, se eligen al azar dos operarios para probar cada máquina y se eligen al azar dos proveedores para tomar cinco piezas de cada uno para cada operario en cada máquina. Posteriormente se valora con un índice adecuado la calidad del pulido. g) Plantear un modelo de componentes de la varianza. h) Estimar los distintos componentes de la varianza. i) Extraer conclusiones. Dado que el esquema de relaciones entre los efectos es en árbol, aunque los proveedores fueran los musmos aportarían componentes de la varianza, porque en un modelo de efectos aleatorios, todos los que llevan debajo también lo son. Por tanto lo hacemos con variance componentes: 129 ¡¡Ojo al orden de anidamiento!! Todos los plots OK Si nos fijamos en la tabla ANOVA vemos que va a haber un componente nulo porque se rompe la progresión de los cuadrados medios, ya que estos tienen que tienen que ir de menos a más. Donde hay que poner el énfasis para mejorar el proceso es en proveedores ya que provocan más de un tercio de la variabilidad en el pulido. Sin embargo la variabilidad de las máquinas es pequeña en comparación con la otra. 130 Tema 6: Diseno factorial 2k 1. INTRODUCCIÓN: Como su propio nombre indica, se trata de diseños factoriales, por tanto vamos a aplicar toda la metodología estudiada en el capítulo 5. Regresamos al terreno en el que todos los experimentos son factoriales y de efectos fijos. Por supuesto son completamente aleatorizados, y las hipótesis siguen siendo la misma: homogeneidad de la varianza, linealidad y normalidad. Se trata de un tipo de diseño que presenta unas peculiaridades especiales con una gran importancia en la investigación industrial. ¿Cual son estas peculiaridades? K factores en dos niveles -> El nombre de 2k les viene ya que para correr una réplica completa tendríamos 2x2x2..2 K veces k El diseño 2 es de particular utilidad en las etapas iniciales del trabajo experimental, cuando probablemente se estén investigando muchos factores. Gracias a estos diseños se descartan cosas y se profundizan en otra. De ahí que se les conozcan como experimentos de cribado, tamizado (screening). Experimento rápido para quedarme con lo esencial. Estos diseños tienen la ventaja de que permiten una cierta investigación con el menor número de corridas. Reducir todo a dos niveles simplifica mucho, aunque claro está que la información será menor. Es decir, una de las razones por las que se emplean estos diseños es por la economía que supone. Esta economía tiene una serie de desventajas, si para cada factor solo experimentamos dos niveles asumimos que la respuesta va a seguir un modelo lineal, no tengo más"ingredientes" para estimar este tipo de experimentos. Esta estimación a veces va a ser inapropiada pero funciona más veces de las que podemos imaginar. No solo se utilizan en la industria, etc. También son buenas aproximaciones de la realidad, aunque la relación globalmente del modelo con la respuesta no sea lineal, si puede ser que con el rango de operaciones lo sea. No se pierde tanto por entender que en este tramo hay linealidad, aunque en algunas ocasiones sí que es verdad que esta linealidad será absurda. En un diseño experimental 2k pueden coexistir factores cuantitavos (presión, temperatura, etc) y cualitativos (operario, maquina, etc). En el caso de que un factor sea cuantitativo, evidentemente es absurdo pensar que solo hubiese 2 temperaturas, para ello cogemos el nivel bajo (-/-1) y el nivel alto (+/+1) del rango de aplicaciones. 131 2. DISEÑO FACTORIAL 22: El primer diseño de la serie 2k es el que sólo tiene dos factores, por ejemplo, A y B; cada uno se corre a dosniveles. A este diseño se le llama diseño factorial 22 Se suele representar en cuadrado como el de la figura de la derecha. Por convención, elefecto de un factor se denota con una letra mayúscula latina. Por lo tanto, "A" se refiere al efecto del factor A, "B" al efecto del factor B, y "AB" a la interacciónAB. El valor - (15) y + (25) de A, por ejemplo, no son los únicos valores que puede tomar; Claro está que podríamos trabjar a 16 grados o incluso a 30, estos valores no representan los valores absolutos. Una novedad en cuanto a notación, es que a los vértices del cuadrado se les denomina con la siguiente nomenclatura: las mismas letras minúsculas que los factores que intervienen que correspondan a cuales de los factores estén en el nivel alto. Al vértice de abajo a la izquierda, como los dos factores están a nivel bajo se denota con (1). a = nivel alto del factor A b = nivel alto del factor B ab = niveles altos de A y B 1= niveles bajos de A y B Además, vamos a usar estas letras como la suma de las observaciones en cada uno de los vértices. Es decir las letras 1,a,b y ab representan por una parte el vértice correspondiente del cuadrado; es decir, la combinación de niveles correspondientes y por otra parte van a representar también la suma de las operaciones realizas en cada vértice. 132 Vamos a distinguir los efectos principales: A y B y la interacción AB. ( Efecto principal A Efecto principal B Interacción AB Los efectos principales y las interacciones se van a distinguir de la siguiente manera: Básicamente en A, por ejemplo, sería el promedio de cuando A esta en el nivel alto (ab-a) menos la media de cuando a está en lo bajo (b-1). Análogamente llamaríamos efecto principal de B a la media de b alto – b en bajo. Por último, la interacción sería la diagonal principal menos la diagonal secundaria, los dos factores en alto frente a lo que ocurre cuando están cambiados; uno en el alto y otro en el bajo. Entonces cuando analicemos un diseño 2k uno de los aspectos que vamos a considerar la estimación de los efectos. De los efectos vamos a examinar tanto la magnitud como la dirección. Si a es positivo quiere decir que movernos de nivel bajo a nivel alto contribuye a aumentar la respuesta. A estas combinaciones lineales de las letras se les llama contrastes. Contraste asociado a A -> ab +a – b –(1) Contraste asociado B->ab-a+b-(1) Contraste asociado C -> ab-a-b + (1) Para estos contrastes nos ayudamos como siempre de la tabla ANOVA, la única peculiaridad que tiene es que los grados de libertad de todos los efectos van a ser siempre 1; ya que para 133 los efectos principales los grados de libertad es el número de niveles -1 = 1, y la de los productos (n-1)*(n-1) = 1. Por tanto,la suma de cuadrado es igual a los cuadrados medios. Además resulta que si calculamos estos contrastes: Contraste asociado a A -> ab +a – b –(1) Contraste asociado B->ab-a+b-(1) Contraste asociado C -> ab-a-b + (1) Las formulas serian las siguientes, mera curiosidad aritmética: En definitiva iríamos a una tabla ANOVA como la siguiente: En Statgraphics: Para los 2k es recomendable tenerlo como un diseño, no como datos. (Recomendable dejarlo así, con el -1 y +1) 134 Siempre nos va a crear una columna bloque asociada a la réplica: Vamos a DOE >design analyze: Marcamos ignore block numbers, salvo que nos digan lo contrario: 135 Pasamos entonces a analizar los datos: Primero vemos el grafico de residuos, hay cierta heterogeneidad de la varianza, pero no especialmente significativa. Frente al número de fila tampoco tiene mayor importancia que las constelaciones sigan esa forma se debe a los pocos datos. El plot de normalidad no nos deja ajustarlo a mínimos cuadrados, pero esta OK. Si vemos la tabla de Estimatedeffects ; vemos que de los efectos son importantes tanto la magnitud como el signo. Estos son contrastes /2n. Si nos fijamos en la primera sería la media: ab+a+b+(1) ->Solo nos interesa para saber en qué entorno se mueve la variable respuesta El factor A tiene un efectos positivo, pasar de – a + aumenta la respuesta 8.33 En cambio, en el caso del factor B pasar de alto a bajo produce un efecto negativo, disminuye la respuesta en 5. La interacción también hace que aumente la respuesta al pasar de más a menos. Aunque estos dos últimos tienen una magnitud sensiblemente inferior. Esto se suele representar en el diagrama de Pareto, llamado así por la tipología, ya que en realidad no es un diagrama de Pareto como tal: ordena los efectos por orden de magnitud, los positivos son grises y los negativos azules. (Se pueden cambiar estos colores en Pane Options) 136 Aquí vemos las diferencias notables en magnitud. La línea azul es la línea de la significación estadística. Los efectos significativos son los que van a llegar por encima de la línea de corte, en este caso ambos factores. Efectivamente si vemos la tabla ANOVA, vemos que estos dos factores son significativos, cosa que no ocurre con la interacción AB. También tenemos una gráfica de efectos principales, que nos muestra cómo cambia la respuesta al pasar de alto a bajo. La interacción también tiene grafico. 137 Activamos también los plots de superficie de respuesta: Estimated response Surface: estamos ante dos factores cuantitativos. Tiene sentido hablar del 0: punto central del rango de valores (interpolación lineal) el 0,5 sería la interpolación que le corresponda. Este tipo de grafico no tiene sentido cuando solo tuviéramos por ejemplo que utilizar el método h o el j. (Esta superficie de respuesta se puede mover para verlo mejor). Esto no es exactamente un plano porque hay interacción; podemos quitarla para purgar el modelo ya que no es significativa. Si miramos las curvas de nivel (Contours of Estimated Response Surface) conjunto de puntos que tienen valores iguales en la función. Si quitamos la interacción, vemos que la superficie se convierte exactamente en un plano. La relación es puramente lineal y aditiva y por ello las curvas de nivel son totalmente rectas. Sería como ajustar un modelo de regresión. 138 MODELOS DE REGRESIÓN El coeficiente de un contraste es siempre es + 1, -1, y puede usarse una tabla de signos positivos y negativos como la tabla 6-2 para determinar el signo correcto para cada combinación de tratamientos. Los encabezados de las columnas de la tabla 6-2son los efectos principales (A y B), la interacción AB e 1, que representa el total o promedio del experimento completo. Observe que la columna que corresponde a 1 incluye únicamente signos positivos. Las etiquetas de los renglones son las combinaciones de los tratamientos. Para encontrar el contraste para estimar cualquier efecto, simplemente se multiplican los signos de la columna apropiada de la tabla por la combinación de tratamientos correspondiente y se hace la suma. Por ejemplo, para estimar A, el contraste es -(1) + a - b + ab En un diseño factorial2k es sencillo expresar los resultados del experimento en términos de un modelo de regresión. Por ejemplo, para un diseño 22 el modelo matemático sería: y = β0 + β1x1 + β2x2 + β12x1x2 Asique la siguiente matriz sería la matriz X de regresión: 139 *Si tuviéramos más replicas iría debajo otro paquete como este. Si quisiera escribir este modelo matemático con la metodología que estamos usando hasta el momento tendríamos: (modelo ANOVA- diseño experimentos): Y = µ+ τi + αj + ταij + εijk Media general Efecto factor A Efecto factor B Efecto interacción ̂ = (XtX)-1 Xt*Y obtendríamos que: Si desarrollamos la matriz X de regresión ->β ̂0 µ=β (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴) = β̂1 2 (𝐸𝑓𝑒𝑐𝑡𝑜 𝐵) = β̂2 2 (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴𝐵) = β̂12 2 ¿Por qué? Las betas es lo que aumenta la variable respuesta por aumentar en una unidad la variable. Por ejemplo β1 es lo que aumenta la variable respuesta al aumentar x1 en una unidad manteniendo el resto fijas. Sin embargo, el efecto mide cuanto aumenta la variable respuesta por aumentar dos unidades, por eso hay que dividirlo entre 2. Vamos a verlo con el mismo ejemplo anterior en Stratgraphics: Abrimos Fig6-1 Como ya está hecho como diseño, tan sólo tenemos que ir a Analyze Design: Abrimos la tabla de coeficientes de regresión: 140 Si lo comparamos con el panel de los efectos, vemos que efectivamente coincide lo que habíamos dicho, es justo el doble ya que efecto A/2 = estimador: Esto mismo podríamos haberlo comprobado haciéndolo como si fuera un modelo de regresión múltiple: Como vemos la tabla de regresión coincide con la que habíamos obtenido antes. Obviamente los p-valores son los mismos. Los parámetros no cambian aunque quitemos la interacción dado que las columnas de la matriz de diseño son ortogonales entre sí salvo la de los 1 como es lógico, pero esa no la vamos a cuestionar. Cuando las columnas son ortogonales las estimaciones de los parámetros independientes son equivalentes. Entonces siempre que en una matriz de diseño tengamos matrices ortogonales la estimación de los efectos no se va a ver afectado por quitar unos parámetros u otros. 141 Si yo trato a los factores que están en el modelo como numéricos me permiten hacer predicciones, calcular los residuos, etc. Los residuos son las diferencias entre las predicciones y las observaciones. Si son variables numéricas lo que estamos haciendo es una interpolación. Por ejemplo en el catalizador el nivel bajo era 15 y el 25 el alto. +1 15 25 Recta de interpolación -1 La recta de interpolación es la ecuación de la recta que pasa por los puntos (15-25 en el caso de X1) y el catalizador entre (1,7 y 2 libras): Si lo tuviéramos en códigos también podemos utilizar estas ecuaciones para pasarlo a los números reales. La ecuación que hemos estimado es y = 27,5 + 4,167x1 – 2.5x2: Si queremos ponerlo en las variables originales sustituimos x1 y x2 por sus fórmulas correspondientes. 142 Podemos ver también el plano de esta ecuación con las variables codificadas (-1/+1) en Estimated Response Surface: Si metemos la interacción: plano torsionado (no tiene cimas ni valles porque no tenemos ningún término al cuadrado), en este caso por tanto nunca tendríamos curvas de nivel en forma de circulo. Si añadimos a la tabla de datos por ejemplo los valores 0,9 y -0,7 y vamos a la tabla de Predictions nos dice la estimación que tendría la respuesta y un i.c de predicción futura. La relación entre la variable respuesta y la regresión asumimos que es aceptable en el rango de datos en el que nos movemos. La siguiente tabla trata de buscar la combinación de los factores que aumenta optimiza la respuesta. Nos interesa movernos en la región de máxima pendiente para buscar el máximo lo más pronto posible. Si queremos alcanzar la cima lo más rápido posible tenemos que hacerlo perpendicular a las curvas de nivel. 143 Muchas veces esta estrategia de cribado nos sirve para cambiar la región de operación; si no estamos conforme con la actual podemos buscar otra, pero ya sabemos en qué dirección; en la que indica la flecha.. Para esta tabla podemos definir con que variables queremos dar los pasos en este caso: concentración. Las curvas de nivel son RENDIMIENTO = 27,5 + 4,16667*CONCENTRACION - 2,5*CATALIZADOR = CTE El vector perpendicular a una recta de tipo ax1 + bx2 = c será (-b,a) por tanto la pendiente es (-b/a) = (-2.5/4,6) = -0.6 El último panel se llama optimizar respuesta: este módulo nos da el óptimo, el óptimo estará el vértice de abajo a la derecha. En pane options podemos poner minimizar o maximizar. 144 Vamos a Statgrphics: (Recomendable dejarlo así, con el -1 y +1) Quitamos la aleatorización y en replicas ponemos 3 + + Por defecto los el diseño se crea en el orden natural (bloques = réplicas) 145 Si no queremos copiar todos los datos, vamos a Montgomery datashet; y copiamos los valores de las tres tablas sin su nombre; teniendo en cuenta que hay que cambiar el factor bloque, que ya no va 1111222..sino 123412341234.. Damos a aceptar sin olvidar marcar Ignore blocks: Pasamos a analizar los datos: 1. Miramos los efectos (en dos paneles). En el primero vemos los efectos de manera numérica, en la primera fila vemos el efecto que resulta de promediar todos los factores, aunque no nos dice nada; sólo donde se mueven los datos. Lo que si nos dice que el estimador de A es ≈ 16 y el B y el AB en torno a 8. Como los grados de libertas son 1, la magnitud de los efectos ya nos dice mucho. Es decir, los efectos y la suma de cuadrados no son lo mismo pero están relacionados funcionalmente. Lo que veamos aquí grande en sus contrastes de hipótesis los p-valores van a ser pequeños. Esta tabla tiene una contrapartida gráfica. Además nos anticipa a través de esta línea azul la significación ya que esta línea es la línea de corte de la significación. Además vemos que todos los efectos son del mismo signo, esto nos va a facilitar mucho a la hora de interpretar los resultados para decidir qué es lo correcto para minimizar la respuesta Como ya vaticinábamos los p-valores eran muy pequeños. 146 2. Miramos los residuos, como vemos el plot de residuos frente al número de fila, muchas positivas al principio y luego todas negativas. Puede ser porque los datos sean artificiales, si fueran datos de verdad esto indicaría que hay una asociación entre el ir avanzando en la réplicas y la variable respuesta. Puede haber algún factor espurio con el que no contábamos y que induce a diferencias entre las réplicas. Podemos quitar del análisis la opción Ignore Block Numbers; esto hará que se vean con más claridad los efectos; aunque los efectos no van a cambiar dado que las columnas son ortogonales; el álgebra que va detrás hace que todo sea independiente. Además si miramos la tabla ANOVA vemos que el efecto de los bloques sí que era importante -> p-valor pequeño 3. Abrimos la tabla de los coeficientes de regresión: recordando que ̂0 µ=β (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴) = β̂1 2 (𝐸𝑓𝑒𝑐𝑡𝑜 𝐵) = β̂2 2 (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴𝐵) = β̂12 2 147 Este modelo de regresión es el que nos va a permitir hacer todo tipo de predicciones, optimizar, calcular de una manera sencilla los residuos (observado-pronosticado por el modelo), etc. Vamos a hacer predicciones. Por ejemplo, que ocurriría si operamos a 0,0953pulgadas de ranura y 50 rpm de velocidad? Lo primero que tenemos que hacer es interpolarlo. Estas predicciones serían para el caso de la velocidad 𝑉𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 − ((𝑣𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 𝑏𝑎𝑗𝑎 + 𝑣𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 𝑎𝑙𝑡𝑎)/2) (𝑣𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 𝑎𝑙𝑡𝑎 − 𝑣𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 𝑏𝑎𝑗𝑎)/2 = 50 − 65 = −𝟎, 𝟔 25 Y para el caso de la ranura: 40 + 90 50 − ( ) 𝑉𝑒𝑙𝑜𝑐𝑖𝑑𝑎𝑑 − 𝑝𝑢𝑛𝑡𝑜 𝑚𝑒𝑑𝑖𝑜 2 = 90 − 40 𝑠𝑒𝑚𝑖𝑎𝑚𝑝𝑙𝑖𝑡𝑢𝑑 ( 2 ) = 𝑝𝑢𝑙𝑔𝑎𝑑𝑎𝑠 − ((𝑝 𝑏𝑎𝑗𝑎 + 𝑣𝑝 𝑎𝑙𝑡𝑎)/2) 𝑝𝑢𝑙𝑔𝑎𝑑𝑎𝑠 − 𝑝𝑢𝑛𝑡𝑜 𝑚𝑒𝑑𝑖𝑜 = (𝑝 𝑎𝑙𝑡𝑎 − 𝑝 𝑏𝑎𝑗𝑎)/2 𝑠𝑒𝑚𝑖𝑎𝑚𝑝𝑙𝑖𝑡𝑢𝑑 0,0625 + 0,125 ) 0,0953 − 0,09375 0.1 − ( 2 = = = 𝟎, 𝟎𝟓 0,125 − 0,0625 0,03125 ( ) 2 Lo copiamos en databook; y nos vamos al panel de predicciones, obteniendo una respuesta de 21, 85 con unos márgenes de predicción de [20,70 - 23,006] al 95% de confianza. Siguiente panel: panel de optimización lo primero que tenemos que hacer es cambiarlo a minimizar. Como vemos es factor A= -1, Factor B = 1. El menos está en el A porque es el dominante. 148 Esto lo podríamos haber predicho con el gráfico de efectos. Si queremos minimizar a la vista del análisis de Pareto parece razonable que tendría que ir a nivel bajo, el B pensamos que también pero si ponemos a los en el nivel bajo la interacción es positiva, por lo que lo que va a empujar B nos lo quita la interacción. ¡Ojo cuando tengamos muchos factores! Si vamos a ver el gráfico de la respuesta estimada, vemos que el vértice más bajo está en consonancia a los resultados. En las curvas de nivel vemos una especie de "silla de montar", y vemos que el valor más bajo también está en el -1,1 El gráfico de Path of SteepestAscent solo funciona bien cuando maximizamos, como vemos si intentamos minimizar no lo hace bien. No está sincronizado con el panel en el que le decimos que queremos minimizar. Si lo cambiamos en su panel, nos da una trayectoria inversa a la de maximizar, pero no es la correcta. Nos ha faltado ver la gráfica de los efectos: gráfico elemental que indica cómo cambia la respuesta al pasar de - 1 a + 1, además el hecho de que el efecto de A sea mayor que el de B se demuestra porque tiene mayor pendiente. 149 En el siguiente gráfico vemos el gráfico de interacción, que como vemos al haber cruce si que es significativo. El último sería el grafico de probabilidad de los efectos, que aun no estamos en condiciones de interpretar. 150 EL DISEÑO 23 151 Se están estudiando tres factores: porcentaje de carbonatación, la presión de operación y la velocidad de la línea (botellas/minuto). Como vemos tenemos 8 combinaciones y hemos hecho dos réplicas. A la derecha de la tabla muestra los verdaderos rangos (no codificados) En general vamos a poder tener una representación geométrica de estos diseños, sería como un cubo. Vamos a utilizar la misma nomenclatura para denotar los 8 vértices del cubo. En estos diseños vamos a tener 7 efectos (23 -1). En general, para cualquier modelos vamos a tener (2k-1 efectos): A Efectos principales: (𝑘1) B Interacciones dobles: (𝑘2) Si sumamos todos estos obtenemos la C 𝑘 Interacciones triples: ( ) fórmula general: 2k-1 efectos 3 AB …… AC Interacciones K-uple(𝑘𝑘) BC ABC *Por muchos efectos que tengamos en general más allá del 2 o 3 orden de interacción no solemos tener nada. Considere la estimación de los efectos principales. Primero, considere la estimación del efecto principal A. El efecto de A cuando B y C están en el nivel bajo es [a (1)]/n. De manera similar, el efecto de A cuando B está en el nivel alto y C está en el nivel bajo es [ab -b]/n. El efecto de A cuando C está en el nivel alto y B está en el nivel bajo es [ac -c]/n. Por último, el efecto de A cuando tanto B como e están en el nivel alto es [abc -bc]/n. Por lo tanto, el efecto promedio de A es sólo el promedio de estos cuatro efectos, o: 152 De nuevo hay una relación algebraica entre las estimaciones y los efectos. Para calcular fácilmente dichos efectos tenemos también la tabla de signos: Esto es lo que tendríamos que llevar a la matriz de diseño para realizar la regresión. Además resulta que las sumas de cuadrados tienen que ver también con estas combinaciones lineales. Por ejemplo, el efecto de A daba 3 en este ejemplo: Lo que es el contraste en sí da 24; que al dividirlo por 8 es cuando nos da el 3. La suma de cuadrados es entonces el cuadrado del contraste entre 16: Vamos a analizar este ejemplo nosotros en Statgraphics: Abrimos TAB6-4 y seguimos el siguiente procedimiento: Lo más sencillos posibles pero guardando un principio de jerarquía en la purga o refinado de los modelos (si una interacción es importante, pero sus efectos no, los tenem que dejar) Que efectos van a favor de la respuesta, temas de optimización, de rutas de máxima pendiente donde tengamos mejor respuesta, etc. 153 Design Analysis, ignorando el número de bloque. Y max order: 3 Los tres efectos más importantes son los efectos principales. Si vamos a la tabla ANOVA vemos que los tres efectos principales son significativos. La interacción AB no es como para ignorarla pero su importancia es significativamente más pequeña. El 0,75 estimado es menos de la mitad que cualquiera de los 3 efectos principales que son mucho más significativos. Para refinarlo está claro que podemos quitar la interacción triple, y la BC y la AC. En principio dejamos la AB porque está cerca del borde y como además se han hecho pocas observaciones (2 réplicas) no tenemos la suficiente contundencia para descartar este término. Para refinarlo, antes de ir al exclude, bajamos el orden de interacción y después excluimos los siguientes términos (AC y BC). Este es el modelo que nos deja Statgrpahics: (como mucho se nos va a modificar los p-valores, nunca el resto. El R2 también cambia.) 154 Ahora sí que merece la pena ver el gráfico de residuos. Volvemos a tener el problema en el gráfico de residuos vs order: primero todos negativos, y luego todos positivos. Vamos a ver si mejoran las cosas poniendo el bloque como efecto. Sin embargo, vemos que no es significativo. Ni si quiera ha bajado el p-valor a la interacción AB. Si vamos al diagrama de Pareto de nuevo vemos que todos los efectos son positivos, la presión la carbonatación y la velocidad hacen aumentar la respuesta; así como la interacción. 155 Podemos hacer también predicciones, (velocidad 240…) obteniendo una Desviación respecto al nivel de llenado de 0,85. En el caso de optimización y teniendo en cuenta que el objetivo es minimizar (en concreto buscamos tener una desviación 0). El óptimo va a estar en el medio, no buscamos minimizar en general, sino el 0. Por eso el óptimo no está en un vértice. 156 Los planos los descompone ahora en 3 dejando cada vez uno de los efectos fijos; al igual que ha hecho con las curva de nivel. Esto lo vamos a ir cambiando en Pane Options en la pestaña Factors. En este problema no interesa tanto ver la ruta de máxima pendiente ya que esta solo tiene sentido cuando vamos a maximizar. Cuando vamos hacia un valor esto carece de interés. EL DISEÑO GENERAL 2k La tabla ANOVA sería: 157 Abrimos el archivo 6-1 Vemos que hay tres efectos que dominan, la interacción AC es muy importante pero uno de los factores que están en ella no lo está; por lo que no vamos a poder simplificarlo. Vemos que en cuanto a los signos tenemos de todo. En el caso de las interpretaciones tienen que ser muy cuidadosas; la interacción AC es positiva; en cambio A es negativo. Cuando pongamos A en el bajo y C en el alto su producto es negativo; con lo cual se da a la vuelta la interacción. En cuanto a magnitud, vemos los efectos en valores numéricos (no vienen ordenados en orden de importancia, desventaja frente al diagrama de Pareto): 158 Vamos a la tabla ANOVA, aunque no vamos a ver más de lo que ya sepamos; dado que el diagrama de Pareto nos resume estas dos tablas. Podemos marcar los bloques para ver si sin significativos, pero tienen un p-valor muy grande por lo que lo dejamos. Empezamos a purgar el modelo; primero le bajamos la interacción y luego quitamos AB y BC Tenemos que deja el factor A por el principio de jerarquía. El modelo que hemos ajustado es: 159 Ahora es cuando tenemos que validar el modelo. Como vemos todos los plots son correctos. Hay que tener cuidado también con el gráfico de residuos frente a factores; el que veamos una columna de residuos mucho más extensa que otra sería malo; iría en contra dela homogeneidad de la varianza, pero no es el caso -> Modelo válido. Vamos a ver la optimización. En este caso se busca maximizar: La velocidad que parecía inofensiva resulta que el hecho de ponerla en el menos implica que como el ángulo lo ponemos en el más; cuando multiplicamos AC es negativo, y por tanto contrarresta el efecto negativo de la interacción. Vamos a ver la geometría imaginando que el factor B es un factor cualitativo. Lo que aprovecharíamos de este modelo es que como la geometría suele tomar dos valores, se convertiría en dos rectas. Con lo cual lo que tendríamos que hacer es ir al modelo y sustituir el C por 1 y por -1. 160 Con las opciones de panel de los planes, y dando a Factors quitamos la geometría y lo ponemos en el 1. Sería la superficie de respuesta cuando la geometría es la correspondiente al +1. Lo mismo haríamos en el gráfico de las curvas de nivel. De igual forma tendríamos que hacer poniendo geometría en el nivel bajo. Vamos a nuestro modelo; si sustituimos 5,666*Geometría por 1 y por -1; este 5,666 ó -5,666 se van al término independiente, por lo que vamos a tener dos superficies exactamente paralelas. La más alta sería la correspondiente a la geometría (+1). Aquí la ruta de máxima pendiente pierde un poco de interés porque no tiene sentido. 161 Nos encontramos ante un diseño 24 vamos a analizar los datos: 1. Estimar los efecto de los factores: A la vista de estas dos tablas podemos concluir que el efecto más importante va a ser el factor A; sin dejar atrás las interacciones ABC, ABD, AB y el factor D que también son muy dominantes. El factor C, el ABCD y el AD tampoco los podemos obviar puesto que son significativos. El diagrama de Pareto cuando tienen un decrecimiento así, lineal (aunque el factor A destaca mucho mas), son los más complicados de analizar porque no se ve un corte fácil. Lo ideal es tener unos pocos efectos muy significativos y otros que no lo sean, así a la hora de purgar y analizar el modelo es más fácil. 162 2. Construir la tabla del análisis de varianza y determinar cuáles factores son importantes para explicar el rendimiento. Si miramos la tabla ANOVA; no vamos a ver nada nuevo que no sepamos, dado que la significación de los factores la podemos ver gracias a la línea del diagrama de Pareto: 3. Escribir un modelo de regresión para predecir el rendimiento, suponiendo que los cuatro factores se hicieron variar en el rango de -1 a + 1 (en unidades codificadas). Puesto que la interacción de orden 4 es significativa siguiendo el orden de jerarquía a la hora de purgar, no se podría simplificar ningún factor ni interacción a pesar de que no sean significativos. Por tanto, este sería nuestro modelo de regresión: 4. Validación del modelo Una vez que ya tenemos el modelo final vamos a pasar a analizar los plots de residuales para validar el modelo: 163 Todos parecen aceptables, el único del que podríamos dudar un poco es del del residual vs factor, en el cual se ve una cierta heterogeneidad de la varianza. Vamos a grabar los residuos para hacer una prueba de igualdad de varianzas. Para ello, guardamos los residuos studentizados: Tenemos que marcar la siguiente tabla: Comparaison of StandarDesviation Como vemos el p-valor es 0.03 por tanto al 5% se podría rechazar la hipótesis de que las varianzas son nulas. Esto es especialmente grave cuando vemos el megáfono en la respuesta predicha Si volvemos a nuestro análisis del diseño podemos “corregir” la ligera heterogeneidad de la varianza mediante logaritmos. Tomando logaritmos vemos que no hay diferencias a penas con el anterior modelo, por lo tanto vamos a analizar el anterior. 164 5. Analizar resultados. Vamos al panel de optimización teniendo en cuenta que lo que pretendemos es maximizar el modelo El factor A puesto que es el dominante lo ponemos en -1 para contrarrestar su efecto negativo; la interacción ABC también nos interesa que sea negativa y por el contrario la ABD que se quede positiva, por lo que AB han de tener el mismo signo y C y D distinto para que en un caso la multiplicación sea positiva y en el otro negativa; el D es quien se va a quedar con el +1 puesto que es bastante dominante y va a tirar mucho hacía de la respuesta. Además el producto de AB también va a salir positivo, cosa favorable puesto que es muy dominante. De los otros tres factores significativos; el C tiene asignado el -1 como ya hemos visto lo que favorece para contrarresta su signo negativo, la interacción ABCD no la hemos podido optimizar y restará. A partir de 3 factores, el gráfico de respuesta estimada y demás gráficos no son de mucho interés. Sí que nos interesaría, por ejemplo, hacer predicciones. 165 1. Estimar los efecto de los factores: Como vemos la interacción AC es la más significativa, seguida de factor B, C, la interacción triple y el A. El factor D y la interacción AB también son significativos aunque tienen una importancia menor. Hay una interacción triple en la zona alta y todos los efectos principales también se encuentran en esta zona; esta es la forma del gráfico que buscamos: unos efectos que sean muy significativos y el resto que no lo sean. Además si vamos a poder purgarlo con facilidad, ya que la interacción triple ABC (la única triple significativa) contiene las interacciones dobles que también lo son (AC y AB: BC aunque no es significativa la tenemos que dejar si queremos respetar el principio de jerarquía). Además, este modelo digamos que tiene dos partes; por un lado la interacción D y por otro todo lo demás. Además al no ser significativa la interacción cuádruple podríamos decir que es un modelo 23 2. Construir la tabla del análisis de varianza y determinar cuáles factores son importantes para explicar el rendimiento. Si miramos la tabla ANOVA; no vamos a ver nada nuevo que no sepamos, dado que la significación de los factores la podemos ver gracias a la línea del diagrama de Pareto. 166 3. Escribir un modelo de regresión para predecir el rendimiento, suponiendo que los cuatro factores se hicieron variar en el rango de -1 a + 1 (en unidades codificadas). Vamos a ver de qué interacciones podríamos prescindir: lo primero podemos bajar el orden de interacción ya que la interacción de orden 4 (ABCD) no es significativa. Y además podemos quitar otros términos como los que tenemos a la izquierda (El BC no le tenemos que quitar por el principio de jerarquía) Este sería nuestro modelo: Var_1 = 11,9881 + 1,50944*Factor_A + 1,98794*Factor_B - 1,79812*Factor_C + 0,978875*Factor_D + 0,967063*Factor_A*Factor_B - 2,00387*Factor_A*Factor_C + 1,56875*Factor_A*Factor_B*Factor_C + .. BC 4. Validación del modelo Una vez que ya tenemos el modelo final vamos a pasar a analizar los plots de residuales para validar el modelo: 167 Todos parecen aceptables. Además si miramos los R2 de tabla ANOVA. Cuando el R2 y R2 ajustado coinciden significa que el modelo está bien ajustado. 5. Analizar resultados. Vamos al panel de optimización teniendo en cuenta que lo que pretendemos es minimizar el modelo; en concreto buscamos tener 0 fisuras: El factor B puesto que es el segundo más dominante lo ponemos en -1 para contrarrestar su efecto positivo y así disminuir la respuesta; El factor C es positivo luego no nos interesa que cambie su signo, se queda con +1. Entonces para que la interacción AC se quede con el mismo signo, el factor A también tiene que ser +1. La interacción ABC también nos interesa que sea negativa por lo que el producto de estos tres ha de ser negativa; el signo de B es -, el de C es +, luego el de A tiene que ser +. Aunque esto suponga que luego A por sí sola vaya a hacer que aumente la respuesta. Por último, el factor D nos interesa que sea -1, puesto que su efecto es positivo. Si vamos a ver el gráfico de la respuesta estimada: A la vista de este gráfico de la interacción AC vemos que A tiene que estar en 1 y C en +1 también. En AB el vértice más bajo está cuando A toma el valor 1 y el B -1 aunque está un poco dudoso. En las curvas de nivel vemos que el valor más bajo también está en el 1,-1, para el caso de la interacción AB. Y de 1, 1 para AC 168 El gráfico de Path of SteepestAscent no funciona bien cuando pretendemos minimizar. Nos ha faltado ver la gráfica de los efectos: gráfico elemental que indica cómo cambia la respuesta al pasar de - 1 a + 1, además el hecho de que el efecto de B y C sean los dominante se demuestra porque tienen mayor pendiente, aunque la de C es bastante parecida. 169 En el siguiente gráfico vemos el gráfico de interacción, que como vemos la más significativa como ya sabíamos es la AC 170 El factor C, a diferencia del resto es una variable categórica. Es decir, o usamos un tratamiento (-1) u otro (+1) pero no vamos a tomar valores intermedios. Por tanto, este modelo se descompondría en dos planos; uno cuando C vale -1 y otro cuando vale +1. En este caso si que nos va ser de gran ayuda los modelos de tres dimensiones. (3D-Mesh dentro de Estimated Surface) Cuando C = 1: En este caso, puesto que los que queremos es minimizar los interesa el vértice inferior derecho. Sin embargo, cuando C vale -1, nos interesa el vértice inferior izquierdo. El modelo resultante sería el siguiente: (todo estimado ^) ̂0 + 𝛽 ̂1 𝑥1 + 𝛽 ̂2 𝑥2 + 𝛽 ̂3 𝑥3 + 𝛽̂ ̂ ̂ 𝑌=𝛽 12 𝑥1 𝑥2 + 𝛽13 𝑥1 𝑥3 + 𝛽123 𝑥1 𝑥2 𝑥3 Tenemos que sustituir C=X3=+1 y luego por C = X3 = -1. 171 6.5. UNA SOLA REPLICA DEL DISEÑO 2K ¿Qué es lo que puede ocurrir si se hace solo una réplica? El número de efectos a estimar es 2k-1, con lo cual como el número de datos también es el mismo, cuando queramos hacer la tabla ANOVA vamos a ver que no vamos a tener grados de libertad para el error, el modelo está saturado. Es como si tenemos dos puntos y queremos ajustar una recta; el modelo va a pasar por ambos puntos. El tener más réplicas sirve para tener más potencia en los contraste de hipótesis; es decir, al tener mayor información voy a poder rechazar la hipótesis nulas con más claridad. Cuando tengo pocas replicas puedo acabar viendo como importantes cosas que pueden no serlo. Si he tomado la zona de operación muy cerca; es decir lo que representa el +1 y el -1 está muy cerca entre sí, si el ruido es grande (el sigma), puede ocurrir que en realidad el efecto que haya no lo vea así y por tanto voy a tener una percepción equivocada. Para evitar esto, tengo que estudiar a fondo la zona de operación, separando cuanto me sea posible los valores -1 y +1. 172 En definitiva; el ruido puede dominar el sistema. Cuando tengo más observaciones esto es más improbable que ocurra. En el ejemplo 6.2 solo hay una réplica. Pero vamos a meter hasta orden de interacción 4. Vemos que Statgraphics nos calcula aun así los coeficientes; sin embargo no tenemos el pvalor para ver cuál son significativos y cuáles no. 173 Si vemos el diagrama de Pareto, al tener solo un codo me da idea de cosas que se pueden simplificar en el modelo; como vemos no aparece la línea de significación dado que el modelo está saturado. Para ver cómo podemos simplificar el diseño, nos va a ser muy útil los plots de interacción: Además tenemos que ir a una gráfica que aun no habíamos utilizado; el plot de normalidad de los efectos. En la cual todos los efectos que se salgan de la normalidad (que no sean lineales) vamos a considerarlos como significativos. 174 Lo que vamos a ver dos estrategias para abordar estos casos: - El principio de dispersión de los efectos - La proyección de los residuos. Lo primero que vamos a hacer es un diseño experimental 25. Para la variable respuesta Y vamos a simular por ejemplo una normal N(µ,σ) y vamos a hacerlo con réplica única. Una vez que ya tenemos el modelo, vamos a generate data en la columna de la respuesta: Como vemos obtenemos un diagrama de Pareto que crece de forma progresiva; lo cual nos dificulta bastante el análisis de resultados. 175 Si vamos al gráfico de normalidad de los efectos; Vemos que esta todo bastante alineado, todo lo que se desvíe es por puro azar. Lo que representamos aquí son los efectos estimados. Si volvemos a regenerar los datos, siempre que tengamos efectos aleatorios alguno de los efectos se va a alejar de esta linealidad (efectos significativos). Aunque no tengamos grados de libertad, los efectos y las sumas de cuadrados siempre las vamos a poder estimar (y los cuadrados medios también; que son los mismos valores que las sumas de cuadrados ya que los grados de libertado son 1). 176 Teorema: si la Y es independiente de los factores, estos 2k -1 efectos se comportan como una muestra aleatoria de distribución normal. Si cogemos los efectos estimados en el plot tendrán que salir más o menos alineados. Cuando esto no ocurra; es decir, que una buena parte se desvía por arriba o por abajo; es que va a ver unos efectos más significativos. La masa que quede debajo de la diagonal serán efectos importantes positivos, y por encima tendremos los efectos negativos. Para comprobarlo vamos a suponer el siguiente modelo: Y = 10 + 5x1 – 5x2 + 4x3 – 6x4 + 3x5 + ε ->N(0,1) Vamos a Statgrpahics y en la columna donde habíamos generado los datos, lo cambiamos, copiando esta fórmula: Ahora en el diagrama de Pareto vemos que hay un codo muy claro en estos efectos: Si vamos al plot de normalidad: la mayoría de los puntos están alineados (estos son los efectos irrelevantes) y luego tenemos 5 puntos que sobresalen; los dominantes: 2 en la parte negativa y 3 positivos. 177 Si vamos a los efectos estimados, como era de esperar el modelo de regresión tiene como parámetros el efecto /2; por ello vemos que todos los valores son más o menos el doble de los factores que habíamos metido en la fórmula. ¿Qué tendríamos que hacer en estos casos? Diseñar estrategias para poder diseñar los contrastes de hipótesis, porque no siempre vamos a tener estos efectos tan definidos; es decir, un diagrama de Pareto tan claro. Estrategia 1: Principio de dispersión de los efectos La primera de ellas es el principio de dispersión de los efectos (principio de los efectos esparcidos):la naturaleza generalmente es generosa, no nos lo pone difícil. La mayoría de los sistemas están dominados por efectos de órdenes bajos. Es poco frecuente modelos que estén modelados por interacciones. Para el modelo que hemos simulado, sería lógico bajar el orden de interacción a 1. (Pero esto no tiene por qué ser siempre así, a veces nos tenemos que seguir quedando con orden 2 ó 3). 178 Si hacemos esto ya no tiene sentido mirar el plot de normalidad, dado que los puntos que buscamos eran los que no se alineaban. Una vez que hacemos un purga drástica, este plot ya no tiene sentido. Lo que nos interesa es el diagrama de Pareto: Como vemos en la tabla ANOVA estos efectos son muy significativos. Y como sabemos, la suma de cuadrados y los efectos estimados siguen siendo los mismos independientemente de los términos que deje en el modelo. Lo que no son iguales son los F-ratio y los p-valores ya que dependen del denominador (el error), ya que todos los términos que quiten van a ir al error. En esencia tampoco tienen que cambiar mucho los F-ratios, dado que hemos tenido que quitar aquellos aspectos irrelevantes. Entonces, más o menos en la misma medida que aumentan el SSE aumentan los grados de libertad. 𝑆𝑆𝐸 MSE = 𝑔.𝑙 ¿Qué pasaría si metiéramos más ruido en la simulación en la que estamos? Duplicamos el ruido, pero aun así vemos todavía un codo bastante definido; además el plot de los efectos siguen estando claros: 2 negativos y 3 positivos. 179 Por tanto, vamos a aumentar más el ruido para verlo más claro, para ello subimos la desviación típica a 4: Y como podemos ver cada vez aumentan más los irrelevantes, y el plot de normalidad de los efectos ya no es tan claro: 180 Vamos a seguir metiendo más ruido; por ejemplo 10. El tercer efecto en magnitud es triple que como sabíamos antes era nula, y ya vemos que cada vez va cayendo de forma más lineal. Si empezáramos a purgar el modelo no sabríamos donde empezar; porque la interacción cuádruple están en cabeza. Por último si subimos la desviación a 20; se confunde todo con ruido. La señal se pierde entre el ruido, digamos que la dependencia que tienen la variable respuesta con los factores (la fórmula) está escondida entre el ruido. Esto se mejoraría si se replica el modelo. Sin embargo, tenemos que volver a construirlo: Generando los mismos datos en databook: 5*Factor_A-5*Factor_B+4*Factor_C-6*Factor_D+3*Factor_E+RNORMAL(160;10;20) **Ahora tenemos que poner 160 porque es el número de datos que tenemos Analizamos el diseño ignorando el factor bloque: En cada una de la línea de la tabla ANOVA, lo que estamos haciendo es analizar si cada uno de ellos es significativo o no; tenemos 25– 1 = 31 efectos. Por tanto, por puro azar, a un determinado nivel, los contrastes de hipótesis dan fallo y es por el riesgo que asumimos (error de tipo 1: no acepta la hipótesis nula siendo ésta verdadera; equivalente a encontrar un resultado falso positivo). 181 Sin embargo, si alguno de los efectos importantes no saliera significativo (error de tipo 2: no rechaza la hipótesis nula siendo ésta falsa; es decir no encontramos diferencias significativas cuando sí las hay). Este error se combate con la potencia; en este caso como hemos hecho 5 réplicas y el hecho de que los dominantes tengan un p-valor 0,000 quiere decir que el modelo tienen mucha potencia. 182 Y por último si pasamos a una desviación típica de 20; incluso con esta desviación típica tan grande, de los 5 efectos significativos 4 de ellos quedan en cabeza y el C que es uno de los más pequeños (no es de extrañar ya que en la fórmula es uno de los cuales se multiplica por un factor pequeño = 4) Todos los modelos estadísticos que estamos ajustando tienen estas dos partes: señal y ruido, la única vacuna contra esto es la replicación. En los casos de réplica única, afortunadamente, vamos a ser capaces de reconocer muchas cosas. 183 Estrategia 2: proyección del diseño Hay otra estrategia que se llama proyección del diseño para cuando tenemos un sistema en el que tenemos unos pocos efectos que dominan y lo demás es ruido: 5 factores, sin replicas. Aquí, aparte de purgar el modelo de interacciones altas a interacciones bajas; nos sugiere que hay dos factores que no intervienen para nada; el E y el D. Este modelo de 25 se podría convertir en un 23 si quitamos todos los efectos en los que intervienen el D y el E. Tendríamos 23 que estaría replicado 4 veces ya que: 25 = 32 réplicas; si los convertimos en un modelo 23= 8 cada uno de estos efectos estaría replicado 32/8 = 4 veces. Diseños con réplica única (resumen) Los efectos se pueden estimar Los efectos no se pueden contrastar (no hay MSE) Se procede de manera exploratoria: - Diagrama de Pareto de los efectos: diagrama muy potente a pesar de su sencillez; lo que vamos a buscar es el codo que es la diferencia entre lo que es realmente relevante y lo que no lo es. - Plot de normalidad de los efectos donde vamos a buscar los puntos singulares de las colas; es decir todo aquello que se sale de la normalidad. Cuando el diseño no tienen ningún efecto relevante: todo ruido, el diseño no se comporta de manera normal. Si hay algo relevante aparece separado de esta normalidad. 184 Tenemos dos estrategias después de ver estos gráficos para poder tener los MSE y por tanto tener los test de la tabla ANOVA. Estas 2 estrategias son: - Principio de dispersión de los efectos: lo normal es que estén activos los efectos de orden bajo; esta estrategia nos permitirá bajar el orden del modelo. Este principio nos será útil en el caso de que sea cierto; no podemos acumular el error a costa de quitar términos que no se deben quitar. De esta manera consigo error a raíz de quitar efectos. - Proyección del diseño: eliminar de raíz todos los términos que afectan a uno o más factores. El factor C no parece que vaya a tener mucha relevancia, nos lo “cargamos”. Así podremos convertir un diseño 2k en un diseño 2k-r; siendo r los factores irrelevantes. De esta manera consigo error porque en definitiva es como si estuviera analizando un diseño replicado. Habitualmente combinaremos estas dos estrategias, con el modelo que nos quedemos habrá que validarlo y a partir de ahí analizar resultados. 185 Volvemos al ejemplo 6-2, donde lo que buscamos maximizar. Metemos un orden de interacción 4 y al no estar replicado no es necesario ignorar la columna bloque. El diagrama de Pareto nos ofrece una situación en la que hay una diferencia clara entre los 5 primeros efectos, que está formado por los factores principales, y por interacciones dobles que además resultar ser combinación de los factores principales significativos. Si miramos el plot de normalidad de los efectos vemos que es muy claro: Como estrategia de actuación tendríamos una mezcla de ambas; por un lado tendríamos que bajar el orden de interacción y por otro proyectar el diseño para purgar el modelo. - > Bajamos la interacción a 2 y con el exclude quitamos: 186 Una vez que hemos comprobado que todos los plots de residuales son aceptables, vamos a la tabla de regresión: la interacción AC es negativa, y al ser grande, el C irá en negativo, para contrarrestar esta negatividad. Vamos directamente al panel de optimización: El formaldehido en nivel bajo es lo que conviene, luego queda confirmado lo que buscaba el investigador. Grabamos los residuos studentizados para ver cómo afectan las variables que hemos quitando del modelo a la homogeneidad de la varianza, en este caso hemos quitado el facto B=Presión : sresiduals vs Presión 187 Si hubiéramos detectado aquí una diferencia muy grande en variabilidad; es decir en un lado muy juntos y en otro muy dispersos querría decir que tiene un efecto de dispersión sobre la respuesta; por lo cual, como la variabilidad interesa que sea lo menos posible tendríamos que poner el factor en el -1 ó el +1; es decir, en el que esté este más concentrada la nube de puntos. 188 El factor B (tipo de lodo) podría ser una variable dicotómica, aunque el enunciado no dice nada al respecto. Todos los efectos son positivos, luego las interpretaciones van a ser muy fáciles; si queremos maximizar todos los efectos positivos y viceversa si lo que queremos es minimizar. El codo es un poco confuso; el B muy superior y el resto van bajando de formar general hasta la interacción BC, y luego otro grupo. La duda está en donde vamos a cortar. Si vamos al plot de normalidad parece que un modelo de 5 términos será suficiente: Purgamos el modelo, dejando solo estos 5 datos: 189 Sin embargo, si vemos el plot de residuales vemos que hay heterogeneidad. Vamos a probar con la trasformación logarítimica; sino lo arreglamos tendríamos que hacer lo que aprendimos en el tema 3. A partir de la fórmula: Y realizando un ajuste de regresión, determinaremos el estimador de α. Con este estimador sacaremos el ajuste más aproximado a partir de esta tabla: Con Statgraphics se haría de la siguiente forma: 1. Ajuste de regresión: Vamos a y marcamos LevelMeans y Level Sigmas. Vamos a databook y: Nos vamos al plot of fittedModel: Comparando término a término vemos que α = 0,446 190 Una vez que cambiamos al modelo logarítmico tenemos que volver al modelo grande, porque el modelo cambia radicalmente. Ahora el factor A ha ganado peso: Si dejamos solo orden de interacción 1: Además vemos el R2ajustado es muy parecido al R2 191 Además como vemos el A tiene poca importancia en cuanto al empuje. Podemos quitarlo (mejora el R2 ajustado) Y como no, tenemos que comprobar el plot de residuales: Desde el punto de vista de la optimización no vamos a tener mucha sorpresa, hay que ponerlos todos en el nivel alto. Además si queremos representar los hipersuperficie, podemos poner A en el máximo. 192 Si observamos el diagrama de Pareto vemos que la disminución es muy parsimoniosa. Además podemos ver el plot de normalidad de los efectos que suele ser más contundente: 193 A la vista de estos datos podemos hacer una purga radical del modelo dejando solo el A y el C: Tenemos un 77% de R cuadrado. Igual nos hemos pasado Vamos a hacer una purga más parsimoniosa: en varias etapas: 1. Bajamos a orden 2 y quitamos AB, BC, AC, B, AD y el BD. En cuanto a variabilidad ajustada hemos ganado unos cuantos puntos porcentuales: Todos los gráficos están aceptables. 2. El libro solo lo deja con A y C, vamos a ver qué ocurre: Y miramos los gráficos de residuos frente al factor. Estos nos indican que el que el A o el C no contribuyen a la variabilidad, solo contribuyen a la media. Sin embargo, tenemos que hacer esto también para los factores que hemos quitado del modelo: el B y el D. Vamos a grabar los residuos y los vamos a plotear frente al factor B y el D en dos pasos: 194 1. Factor B Vemos que el factor B si que afecta a la variabilidad. Podemos obtener el p-valor Si hacemos lo mismo con el factor D (que no está en el modelo) vemos que no afecta tanto a la respuesta -> Desde el punto de vista de la optimización además de mirar en qué nivel ponemos los factores significativos tenemos que dejar el factor B en el nivel bajo para evitar la variabilidad. Para optimizar, en este caso minimizar, los factores que importan hay que ponerlos él A en el – y el C en el +, y el B aunque no afecta a la media sí que lo hace a la variabilidad. Por tanto lo dejamos en el -1. Por último tendríamos el D que no afecta ni a la media ni a la variabilidad, por lo que elegiríamos nivel alto o bajo por otros factores, como coste, etc. Ya que no afecta a la respuesta; en este caso podemos ponerlo -, ya que se trata de tiempo (D = tiempo de prensado) 195 Lo que vamos a hacer es hacer un modelo para estudiar las medias por un lado y las varianzas por otro. ¿Por qué esto no es lo mismo que decir que tenemos 4 réplicas? Aquí se está rompiendo la idea de que las observaciones tienen que ser independientes entre sí. Los experimentos se han hecho en las mismas consideraciones experimentales porque se han hecho a la vez. No son replicas, son mediciones duplicadas. En estos caso se aprovecha la media y la desviación y ajustamos un modelo para las medias (como afectan las posiciones de los factores a la respuesta media ) y otro modelo para la variabilidad. 196 Abrimos tab 6-16. Si hubiéramos teclado solo los datos de los espesores. Podemos ir a: Y los resultados obtenidos los podemos grabar igual que grabamos los residuales. Primero vamos a analizar el efecto de localización: el de la media ->orden 4 En el cual nos encontramos un efecto que domina de manera importante, y luego dos parejas consecutivas EL grafico de normalidad también me marca estos tres niveles escalonados, el resto parece que va a ser irrelevante De nuevo tenemos las dos estrategias: bajamos hasta orden 2 y con exclude quitamos todo lo que afecta a D y también el BC: 197 Lo que ya no están satisfactorio es plot de residuos: aparte de haber una zona con mayor variabilidad hay una curvatura. El modelo tiene alguna carencia. Hay que reajustar el modelo (viendo el gráfico con todos los efectos para tomar decisiones): Podemos hacer el corte después de BD y BC puesto que están al límite de la significación. Esto nos llevaría a meter también el D por orden de jerarquía. Pero aunque el modelo no gane mucho en explicación teniendo más factores, igual nos corrige la heterogeneidad. 198 Como el vemos el R cuadrado crece pero lo realmente importante es que se corrige bastante la heterogeneidad. En este caso: Para ello vemos la curva de nivel de A y C Nos quedaríamos con la franja rosa y la verde, como zona de operación y copiamos esto en el Statgallery para luego compararlo (Botón derecho >Copy at Statgallery> Y en la ventana que queramos de las que se nos abren > Botón derecho > Paste) Volvemos a DOE para analizar los SIGMAS - > siempre hay que estudiarlos en logaritmos: 199 Típico modelo parsimonioso de disminución donde no vemos nada relevante, de hecho la interacción cuádruple está en cabeza. No obstante, por jugar un poco con esta idea multiobjetivo (comportamiento de la media y el de la dispersión) el libro de Montgomery se queda con el A, el B, el D y el BD (sin dejar de ser puro ruido) y crea un modelo en el cual desprecia la interacción cuádruple quedándose con A y B que son los más importantes y la interacción BD por ser la más importante (el D se mete por puro orden de jerarquía). Aun así siguen sin ser significativos. Por puro azar podríamos haber tenido uno significativo. 200 Los valores más bajos de la varianza se conseguirían cerca del vértice gris ->Copy to stagallery y pegamos. (Para pegar encima ->Overlay) Los colores indican cómo nos movemos hacia una región de menor varianza, tenemos que irnos hasta el gris. Las curvas eran las regiones de equi-valor de la respuesta media. Habíamos dicho que nos interesaba estar entre 390 y 400. 6. 6 ADICIÓN DE PUNTOS CENTRALES EN EL DISEÑO 2k (pag 284) Hasta ahora los modelos que estamos ajustando son términos lineales y términos de la interacción. Para poder conseguir picos y valles tiene que haber términos cuadráticos. En este tema lo único que vamos a hacer es chequear si es suficiente con estos términos o nos estamos quedando cortos al no meter términos cuadráticos. Esto se consigue añadiendo puntos centrales al proceso. 201 Es decir, con hacer una observaciones en el (0,0) vamos a poder hacer un test de falta de ajuste sobre ese modelo, de forma que nos juzgue si el modelo es correcto o no. Lo que nos va a permitir estos puntos centrales es una suma de cuadrados de falta de ajuste ó curvatura cuadrática. Estos modelos tienen una peculiaridad: en el origen vale lo que vale el promedio en el valor de los vértices. Lo que vamos a hacer es comparar los valores de la muestra que yo he tomado en el origen con la media que me ha salido en los vértices. La suma de cuadrado de la curvatura cuadrática pura con un solo grado de libertad está dada por: Donde n es el número de corridas en el punto central y n es el número de puntos del diseño factorial. Haciendo esto, solo vamos a poder rechazar o aceptar la validez del modelo. Lo unico que se contrasta es esto: Este diseño tiene una utilidad añadida, no hace falta replicar, con las estimaciones que tengo en el centro ya tenemos estimación de la varianza. Lo que hace que este supeditado a que se cumpla la hipótesis de la varianza. Statgraphics: Para crear estos modelos: DOE >Create> 2 factores y el resto como está. 202 Y metemos los datos: Para analizarlos: DOE >Análisis> orden 2 En la tabla ANOVA; con el botón derecho vamos a opciones de panel para decirle que incluya el lackof fit: El p-valor es muy alto, lo cual aceptamos la hipótesis nula (este modelo es correcto). Es el único test que se programan con el propósito de confirmar la hipótesis nula, es decir, buscamos p-valores grandes. A partir de aquí ya podríamos quitarlo de la tabla ANOVA. Además como la interacción no es significativa podemos purgar el modelo: 203 Hay mayor variabilidad en el centro, como era de esperar. Sin prejuicio de esta mayor variabilidad en el centro, lo que pretendíamos con este modelo es maximizar . 204 Aquí los 3 factores son cualitativos, no tiene sentido realizar superficies de respuesta. a) Analizar los datos de este experimento como si se tratara de ocho réplicas de un diseño 23. Comentar losresultados. Hay un solo efecto significativo; el factor A. Es decir, solo importa el material de molde. En cuando al método de batido y la marca de la harina usada no hay diferencias. Lo único que tendríamos que hacer para maximizar la exquisitez de los brownies es usar moldes de aluminio (nivel alto del A). ** Podemos meter el factor bloque para ver si influye y ver su valor en el p-valor. En este caso de 0,06 pero ignorarlos no altera significativamente el resultado. Aunque no es muy importante porque ya tenemos línea de corta podemos mirar el plot de normalidad. Si purgamos dejamos el A y el B, pero si miramos la tabla ANOVA es un modelo muy pobre. R2 muy pequeño: hay mucha variabilidad que no recogen los factores. En estos problemas de factores cualitativos, no esperemos encontrar R2 muy grandes. 205 b) ¿El análisis del inciso a es el enfoque correcto? Hay únicamente ocho lotes; ¿se tienen en realidad ocho réplicas de un diseño factorial 23? ¿Por qué esto no es lo mismo que decir que tenemos 8 réplicas? Aquí se está rompiendo la idea de que las observaciones tienen que ser independientes entre sí. Los experimentos se han hecho en las mismas consideraciones experimentales porque se han hecho a la vez. No son replicas, son mediciones duplicadas. En estos caso se aprovecha la media y la desviación y ajustamos un modelo para las medias (como afectan las posiciones de los factores a la respuesta media) y otro modelo para la variabilidad. e) Analizar el promedio y la desviación estándar del puntaje de la exquisitez. Comentar los resultados. ¿Este análisis es más apropiado que el del inciso a? ¿Por qué sí o no? Lo que vamos a hacer es hacer un modelo para estudiar las medias por un lado y las varianzas por otro. Como el diseño está considerado como si fueran réplicas tenemos que crear el nuevo: para ello lo único que tenemos que tener en cuenta es poner nº de variables respuesta = 8, y sin réplicas. Y los resultados obtenidos los podemos grabar igual que grabamos los residuales. Para cambiar el modelo, podíamos haber hecho una combinación de las tres en un justapoxe. Cogemos los 3 factores y los copiamos en las columnas de a continuación con nombres incluido: Las convertimos en carácter. Y en la siguiente columna, generar datos: Hacemos un One-way ANOVA de Var-1 frente a esta nueva columna. Procedemos a grabar Level Means y Level Sigmas. 206 Abrimos un nuevo databook, creamos el diseño (nº respuesta =2 y numero de factores 3; no replicas, no aleatorización) Y ya pegaríamos los datos obtenidos. Cuando tenemos medidas duplicadas tenemos posibilidad de ver efectos de dispersión. 1. Primero vamos a analizar el efecto de localización: el de la media ->orden 3 En el cual nos encontramos un efecto que domina de manera importante, el C (marca de la harina), seguido de B (método de batido) y luego una pareja de interacciones. El grafico de normalidad marca claramente la importancia de los dos primeros factores, el C y el B. De nuevo tenemos las dos estrategias: bajamos hasta orden 1 y con exclude quitamos el factor A. 207 El plot de residuos tiene cierto estrangulamiento, aunque no demasiado importante. El resto parecen aceptables Si lo que queremos ver es en que niveles tenemos que poner los factores, aunque a la vista del fácil Diagrama de Pareto que teníamos ya podríamos deducir en qué nivel ponerlo, vamos a la tabla de optimización: 2.Volvemos a DOE para analizar los SIGMAS - >siempre hay que estudiarlas en logaritmos: 208 Destaca la interacción AC y luego tenemos el típico modelo parsimonioso de disminución donde no vemos nada relevante. No obstante, si miramos el plot de normalidad de los efectos nos quedaríamos solo con la interacción. Sin embargo, para respetar el principio de jerarquía debemos quedarnos también con A y C, por suerte eran los siguientes más relevantes. Estos tres factores afectan a la variabilidad de la respuesta. El A tiene un efecto positivo: pasar del menos al más incrementa la dispersión pero luego la interacción es negativa. Tenemos que ir al panel de optimización y decir que lo que queremos es minimizar: El A y el C, que son los factores que afectan a la variabilidad, interesan en el nivel bajo. Sin embargo para la media nos interesaba que C estuviera en +1. Es decir, con C en +1 obtenemos mejores resultados en media aunque peores en dispersión. Aquí no estamos ajustando un modelo de regresión, la variabilidad es una respuesta secundaria lo que nos importa es la media. Si podemos dar una variabilidad pequeña mejor, pero hay veces que no se puede. Por tanto, como respuesta final dejaríamos: El A en el nivel bajo puesto que no afecta a la media. Y el B y C en el alto para maximizar el sabor. 209 a) Considere únicamente la respuesta del peso molecular. Graficar las estimaciones de los efectos en una escala de probabilidad normal. ¿Qué efectos parecen ser importantes? A la vista del diagrama de Pareto, consideraríamos como efectos más importantes el C, el A y la interacción AB. Por orden de jerarquía, aunque quisiéramos purgar el modelo tendríamos que dejar el factor B. 210 b) Usar un análisis de varianza para confirmar los resultados del inciso a. ¿Hay algún indicio de curvatura? A la vista de la tabla ANOVA, los únicos efectos significativos, como era de esperar son los que comentábamos con el diagrama de Pareto. Además, gracias a los puntos centrales hemos podido hacer una prueba de falta de ajuste. Como el p-valor > 0,05 no hay falta de ajuste. Los plots de residuales tampoco muestran nada extraño. e) Escribir un modelo de regresión para predecir el peso molecular como una función de las variables importantes. PESOMOLECULAR = 2499,5 + 61,875*TEMPERATURA + 100,625*TIEMPO + 60,0*TEMPERATURA*CATALIZADOR 211 d) Analizar los residuos y comentar la adecuación del modelo. Todos parecen aceptables salvo el plot de normalidad, muy difícil corregirlo… Además si vemos la tabla ANOVA, el modelo está bien ajustado p-valor Lack of Fit grande. e) Repetir los incisos a-d utilizando la respuesta de la viscosidad. Como podemos ver hay dos efectos que predominan sobre los demás: el A y el B; el resto no son significativos. 212 Vamos a ajustar el modelo dejando únicamente estos dos: No hay falta de ajuste. El modelo de regresión se podría ajustar como: Como vemos tenemos que cierta heterogeneidad de la varianza: megáfono abierto. Esto igual podemos corregirlo con logaritmos: Con el modelo entero de nuevo, vemos que se corrige la heterogeneidad: 213 Vamos a ver cómo podemos purgar el modelo, de forma que no tengas este problema de la varianza. Si únicamente dejamos los factores A y B: 214 a) Construir una gráfica de probabilidad normal de las estimaciones de los efectos. ¿Qué efectos parecen ser grandes? A la vista del Diagrama de Pareto vemos que tenemos una situación ideal; 4 efectos destacados (sobre todo el B) y el resto parecen irrelevantes. Además, de los 4 efectos significativos 3 son efectos principales y otro es una interacción doble que por suerte engloba dos de los 3 factores más significativos; con lo que no nos obliga a dejar ningún valor irrelevante por orden de jerarquía. Todos los efectos importantes son del mismo signo lo que nos van a facilitar mucho las cosas: como lo que pretendemos es maximizar el rendimiento: todos los efectos tendrán que aparecer en positivos. Además el plot de Normalidad de los efectos también parece contundente. Vamos a combinar las dos estrategias que hemos visto; por un lado bajar el nivel y por otro eliminar factores irrelevantes. b) Efectuar un análisis de varianza para confirmar los resultados obtenidos en el inciso a. Como no tenemos réplicas, la tabla ANOVA no nos muestra ni los F-ratios ni los p-valores; de ahí que tengamos que basarnos en el plot de normalidad. 215 e) Escribir el modelo de regresión que relacione el rendimiento con las variables significativas del proceso. Dejamos únicamente estas 4 variables que mencionábamos, quedando el siguiente modelo de regresión: Var_1 = 30,5313 + 5,90625*Factor_A + 16,9688*Factor_B + 4,84375*Factor_C + 3,96875*Factor_A*Factor_B Como sabemos los coeficientes de la regresióm son la mitad de los efectos. Además, el R2 ajustado es muy grande y muy similar al R2. El modelo explica el 99,34% de los términos. d) Graficar los residuales en papel probabilidad normal. ¿La gráfica es satisfactoria? La gráfica está bastante bien ajustada. Además el pvalor es > 0,05, luego aceptamos hipótesis de normalidad. e) Graficar los residuales contra los rendimientos predichos y contra cada uno de los cinco factores. Comentar las gráficas. 216 El plot de residuales es bastante aceptable. Además, de los 5 factores el único que presenta cierta heterogeneidad es el factor B, que resulta ser de los significativos. Mientras que para la respuesta es conveniente que este en nivel alto, para la variabilidad es mejor en nivel bajo... f) Interpretar cualquier interacción significativa. La única interacción significativa que tenemos es AB, que puesto que ambos son del mismo signo, al igual que la interacción no vamos a tener problemas para identificar que ambos factores van a ir en positivo. g) ¿Qué recomendaciones se harían respecto de las condiciones de operación del proceso? Como ya decíamos, los 3 factores: A = ajuste de apertura, B = tiempo de exposición y C= tiempo de desarrollo interesan que esten en el nivel alto. Mientras que para el factor D y el E cogeríamos el que más nos interesase por precio, trato con el proveedor, etc. Ya que no afecta a la respuesta ni a la variabilidad de la respuesta. No merece la pena graficar los 3 factores ya que el factor A es cualitativo; sólo puede tomar dos valores. Lo que tenemos que hacer es dos gráficos, fijando A en -1 y en +1 respectivamente: Estas rectas serían paralelas si la interacción AB no estuviera viva. El cambiar x1 = A si no tuviera interacción este término iría al factor beta 0. En cambia la b12 afecta a la pendiente del plano. ̂0 + 𝛽 ̂1 𝑥1 + 𝛽 ̂2 𝑥2 + 𝛽 ̂3 𝑥3 + 𝛽̂ 𝑌=𝛽 12 𝑥1 𝑥2 217 Tenemos que hacer un nuevo modelo para poder poner los puntos centrales: DOE >Create New Design> N respuestas = 1, Nº factores = 5 y centerpoints = 4 (quitamos randomize) y copiamos los datos: De nuevo tenemos el mismo modelo que antes, donde ningún factor es significativo: Además si vamos a la tabla ANOVA, vemos que el p-valor es =0,0002. Como el contraste de hipótesis que se contrasta aquí es: H0 = Modelo sin término cuadráticos es suficiente H1 = No es suficiente Por lo que no vamos a poder seguir analizándolo. Y buscar un modelo más complejo. 218 TEMA 7: Formacion de bloques y confusion en el diseno factorial 2 k Vamos a ver como se hacen bloques cuando no hay ni siquiera réplicas –> Confusión. Factores cuya presencia se conoce y quizá pueda tener algún efecto se puede bloquear. Todo esto dentro del marco de 2k. 219 En el caso de que sea un diseño replicado la idea más intuitiva es relacionar los bloques con las réplicas. Lo que vamos a tener con las réplicas es la estructura 2k varias veces. Además en la tabla ANOVA tendremos una nueva fila: el factor bloque. (En este caso no tenemos que ignorar el factor bloque). La inclusión de los bloques en la ANOVA nos sirve para retirar del error toda la variabilidad del bloque para que me deje ver con nitidez los resultados. La creación del modelo sería idéntica; lo único que tendríamos que hacer es no dar a ignorar el factor bloque a la hora de analizarlo. Abrimos el archivo EJE.7-1. A la vista de la tabla ANOVA el factor bloque es irrelevante. Si vamos al diagrama de Pareto, los resultados no hubiesen sido muy diferentes a la tabla actual. Los dos factores principales son significativos, ignoremos o no el factor bloque. 220 En este caso, el factor bloque si es significativo: el cambio de lote o lo que hayamos considerado como bloque afecta variabilidad a la respuesta. Sin embargo, en comparación con los efectos no es de suficiente entidad como para haber desdibujado al problema. 7-3 CONFUSIÓN DEL DISEÑO FACTORIAL 2k Hay muchos problemas en lo que es imposible realizar réplicas completas de un diseño factorial. Supongamos que tenemos cierta sospecha bastante fuerte de que el efecto bloque va a afectar a la respuesta. Además por lo costosa que es la experimentación sólo vamos a poder hacer una réplica. Imaginemos que tenemos un diseño 22 de réplica única. 22= 4 corridas. Y además queremos hacer dos bloques. Se nos puede ocurrir que cada uno de los laterales del cuadrado sea un bloque; es decir las pruebas de la cara izquierda se han corrido con un bloque y las de la otra con otro. Sin embargo, cuando vaya a la tabla ANOVA y estime los efectos voy a tener la duda de que si lo que veo en A es atribuible efectivamente al factor A o al bloque. Esto es lo que se llama CONFUSIÓN: el efecto del bloque se mezcla o confunde con otros efectos, en este caso el A. Si el no tuviera ningún efecto, y el bloque muy grande. Estaríamos viendo en A cosas que no son. De igual modo, si el efecto A tuviera un efecto de -20 y el error de 20 no vería nada -> Elección mala. Lo mismo pasaría para el factor B. Corrida en el Corrida en el bloque 2 boque 1 221 B A La única opción que tengo es hacerlo en las diagonales, pero el bloque se va a confundir con la interacción. Sin embargo, esta es la mejor opción ya que siempre vamos a tener en mente el principio de dispersión de los efectos y vamos a confiar en que la naturaleza no nos pone las cosas muy difícil: la naturaleza está dominada por órdenes bajos. Esta sería la estrategia menos mala, ya que es más habitual que los efectos A y B tengan importancia antes que la interacción. Entonces la estrategia que vamos a seguir es confundir el bloque con la interacción máxima. Imaginemos que tenemos un diseño 2k de réplica única y que queremos hacerlo en dos bloques; lo que tenemos que hacer es confundir el bloque con la interacción más alta. Esto lo vemos muy bien con una tabla de signos (supongamos que es la del 23) (1) a b ab c ac bc abc I 1 1 1 1 1 1 1 1 A -1 +1 -1 +1 -1 +1 -1 +1 B -1 -1 +1 +1 -1 -1 +1 +1 AB +1 -1 -1 +1 +1 -1 -1 +1 C -1 -1 -1 -1 +1 +1 +1 +1 AC +1 -1 +1 -1 -1 +1 -1 +1 BC +1 +1 -1 -1 -1 -1 +1 +1 ABC -1 +1 +1 -1 +1 -1 -1 +1 *Siempre tiene que haber para cada columna mismo número de positivos que de negativos. Confundir el bloque con la interacción más alta significa que las corridas que corresponden al +1 del bloque ABC forman el bloque 1 y las otras 4 forman el bloque 2 Bloque 1 = ABC = +1 Bloque 2 = ABC = -1 De forma general: Bloque +1 = 2k-1 (la mitad) Bloque -1 = 2k-1 (la mitad) 222 Se pueden reconocer los bloques por la paridad del número de letras: el bloque 1 está formado por los que tienen un número impar de letras (a,b,c,abc) . Y el otro bloque tiene un número par de letras contando al cero como par. (1, ab,bc,ac) Para crear nosotros este diseño: La novedad es que las filas en lugar de estar ordenadas en orden natural, están ordenadas por el bloque. 223 Siempre que queramos hacer dos bloques sabemos que vamos a perder una interacción. En este caso la de orden máxima. La estrategia de confundir la interacción de orden más alto ABCD con los lotes es la óptima. Entonces cuando vayamos a analizar estos datos tenemos que seguir el mismo orden de interacción. Al ver el diagrama de Pareto de los efectos, que por supuesto no tiene línea de corte porque el modelo está saturado, vemos que la interacción ABCD es ABCD + bloque. A partir de aquí, para simplificar el modelo no me queda más remedio que confiar en este principio de dispersión de los efectos, que la naturaleza se organiza a través de efectos sencillos; entonces lo que voy a considerar es que el efecto de ABCD es el bloque. Sin tener ninguna certeza, voy a pensar en todo momento que la interacción cuádruple no es significativa y la vamos a quitar. El diagrama de normalidad de los efectos si que nos muestra el corte claro: 224 Vamos a bajar a orden 2 y proyectar eliminando todo lo que engloba al factor B y el CD ya que no perdemos jerarquía en el modelo: A partir de aquí todo sería igual que en el tema anterior. A la vista de los resultados de la tabla ANOVA, vemos que el factor bloque no es significativo, por lo que lo podemos quitar ya que su p-valor es grande y seguiríamos teniendo los mismos resultados. Si vamos al Diagrama de Pareto vemos que podemos purgar el modelo: por orden de jerarquía tendremos que dejar los tres factores principales y la interacción AC ya que es significativa. 225 Quedándonos el siguiente modelo: Lo primero que tenemos que comprobar son los gráficos que como vemos todos parecen aceptables. El modelo de regresión es: DURACIÓN = 40,8333 + 0,166667*VELOCIDAD + 5,66667*GEOMETRÍA + 3,41667*ANGULO - 4,41667*VELOCIDAD*ANGULO Puesto que lo que se quiere es maximizar la vida (en horas) de las máquinas, tendremos que dejar estos niveles en: 226 Cosa que cabía esperar ya que tanto el B como el C que eran los factores significativos tenían signo positivo; estos se quedan en el +1 y puesto que la interacción AC tiene signo negativo, para contrarrestar su efecto ponemos a A en el -1. Lo primero que tenemos que hacer es ver si el factor bloque es significativo. Como vemos en la tabla ANOVA lo podemos quitar ya que es irrelevante. De nuevo vamos a poder seguir las dos estrategias: bajar el orden y proyectar el modelo eliminado datos con el exclude. 227 Antes de hacer alguna recomendación miramos los plots para ver si el modelo es adecuado. Todos son correctos, el único del que tenemos cierta sospecha es del plot de normalidad, pero al grabar los residuales vemos que el p-valor de Shapiro Wilk es > 0,05 En este problema lo que buscamos es minimizar el número de fisuras, por lo tanto: Tenemos que crear un diseño nuevo, de 2 variable respuesta con 3 factores experimentales. Lo único que cambia del tema anterior es que ahora tenemos que poner factorial en 2 bloques: Y copiamos los datos de la réplica 1 del problema 6-1: No ignoramos el factor bloque. El modelo es bastante parsimonioso, vamos a tener que basarnos en el plot de normalidad para hacernos una idea de donde "dar el corte" 228 Seguramente con la interacción AC y el factor C nos sea suficiente, aunque por orden de jerarquía tenemos que dejar el factor B. Vamos a suponer que la interacción ABC no es significativa, que lo es el bloque. Y nos quedamos con el siguiente modelo: (Antes de hacer cualquier predicción nos hemos asegurado de que el modelo es adecuado mirando los plots). En este problema lo que pretendíamos es maximizar la duración de la herramienta, luego sabemos que el factor C va a ir en positivo, y el Factor A en negativa ya que nos interesa que la interacción contrarreste su efecto negativo. Para el caso del B podemos mirar cómo afecta a la variabilidad para decidir su signo: 229 Tampoco afecta demasiado a la variabilidad por lo que para la elección de B nos basaremos en menor coste, u otro parámetro que la empresa estime oportuno. Se nos presenta un modelo difícil ya que la interacción triple es uno de los efectos que está en cabeza. La cuadruple la podemos obviar si pensamos que es tan grande por el efecto del bloque. El test de normalidad de los efectos tampoco nos lo deja muy claro. Vamos a empezar quedándonos con un modelo 7 efectos, en realidad de 6 porque vamos a quitar el ABCD: Podemos seguir purgando: 230 Aunque el R cuadrado ajustado no es muy grande... Todos los plots son aceptables incluido el de normalidad del que en principio teníamos sospecha: Teniendo en cuenta que en este modelo lo que se pretendía era maximizar: En resumen: cuando hay bloques en réplica única tenemos la estrategia de la confusión. Para ello se necesita que el número de bloques sea del tipo 2r; es decir, potencias de 2: 2 bloques, 4, 8... Lo que vamos a pretender es mezclar el error. 21 bloques -> 2k en 21 bloques -> I=ABCD… El decir esto quiere decir que los dos bloques son: el bloque 1 cuando ABCD está en el más y el bloque 2 cuando ABCD esté en menos 1. Si pienso que la interacción no va a estar activa lo atribuimos al bloque. 22 bloques – 2k en 22 bloques -> Tengo que sacrificar 2 efectos y ya no vamos a poder ir directamente a por la interacción de mayor orden porque tendremos que sacrificar otro efecto relevante. Imaginemos que tenemos un 25, tenemos que coger una estrategia por ejemplo 43-3 -> I = ABC = CDE = ABDE. El problema es que Statgraphics no es flexible para coger la estrategia de confusión. 23 bloques – Perdemos tres productos dobles y los 3 triples; hay que busca equilibrios. Al final, afortunadamente si tenemos una estructura de confusión igual al que tiene Statgraphics, esto aparece gráficamente bien detallado. 231 Ejercicios bloques B = factor cualitativo, C = no está muy claro que se pudiera tratar como cuantitativo, es un poco cualitativo y D = cualitativo. Réplica única pero se hacen 4 bloques. DOE – Analizar diseño – Orden de interacción: 4 y no ignoramos el número de bloque. Si miramos el plot de normalidad de los efectos, no se ve ningún punto que se salga claramente de la linealidad. Lo mismo que vemos en el diagrama de Pareto cuya disminución es parsimoniosa, lo cual nos dificulta bastante las cosas. Además vemos la estructura de confusión: ACD – ABD (elegidos para sacrificar) y como consecuencia se va a confundir también su producto (BC). Empezamos con orden 3, pero se nos confunde un orden 2 que no es tan agradable. Sabemos que en un 24-2 está claro que no va 232 haber una combinación mejor para juntar 8 letras en 3 bloques (3+3+2, 4+2+2 y 4+3+1), por ello esta elección es la menos mala de todas. Cuando vemos el diagrama, el segundo efecto en importancia es ACD + bloque, voy a tener la sospecha de que se deba al bloque y no a la interacción. Vamos a bajar de orden al modelo para empezar a analizar: bajamos a orden 2 y quitamos el BC: A estas alturas si miramos la tabla ANOVA, el R cuadrado está bien pero el R 2 ajustado aun es muy pequeño = 61,3. Tenemos que seguir purgando: Ya empieza a verse el B como significativo. Lo único sustancial que queda es el B, si quito todo se queda en el límite de la significación. Modelo muy pobre. Estudiar las condiciones que maximizan la respuesta. Teniendo en cuenta que el único factor es importante, y es positivo, lo que más interesa desde el punto de vista industrial es el horno 3. Si tenemos en cuanta el modelo B, C, A, AC y teniendo en cuenta que todos los factores son positivos no tenemos ninguna duda, todos en el máximo. 233 Dar un Intervalo de Predicción al 90% para la respuesta obtenida a 1660ºC, en el horno nº 1, Una bobina de diámetro Grande y SIN humidificación por Gas. El 1660 sería el -0,6 y el resto Ahora vamos al panel correspondiente y primero cambiamos el nivel de significación al 90%. Estudiar posibles efectos de dispersión. Los que presentan variabilidad son el Horno y el diámetro Pero para ver su p-valor, si no estamos muy seguros vamos a: Comparar dos muestras – XY independientes – Sresiduals vs C: 234 Efectivamente, el p-valor es 0,04 hay una variabilidad significativa asociada al cambio de horno. Produce menos variabilidad el horno 3 (+1) de manera significativa. En el caso del C también tenemos variabilidad asociada al diámetro. Ahora tendríamos que hacerlo frente al factor que hemos quitado: humidificación. Frente a este no hay efecto de dispersión: p-valor grande. En este modelo tan pobre que estamos ajustando, resulta que además los factores B y C encima tienen efectos de dispersión, es decir, no está bien ajustado; es un modelo deficiente. ** Cambiamos el 55 por 75 en el databook por si nos hubiéramos confundido al meter los datos. Esto hace más claro y más evidente la importancia del factor B. Podíamos dejarlo solo en el modelo con un R2 de 63% 235 Como es un 25 tenemos que hacer 4 bloques = 8*4 = 32 - Analizar los datos. Comentar la estructura de confusión elegida y valorar su idoneidad. Es un 25 por lo que vamos a perder 10 letras. Las opciones de esquemas de confusión que tenemos son: 4+3+3, 4+4+2, 5+3+2+, 5+4+1. Quedándonos con la primera opción ya que es el óptimo. ABD, CDE y ABDE A la vista del diagrama hay una clara diferencia entre una cabeza de efectos, un segundo nivel de importancia y por último una cola irrelevante. Lo que tiende uno a pensar a la vista de las interacciones CDE y ABD se deben al bloque. Entonces bajamos a 2 el orden de interacción: 236 Y proyectamos en el D y el E; es decir, eliminamos todo lo que hay a la cola. Cosa que nos respalda el diagrama de normalidad. - Estudiar el efecto de no haber considerado los bloques. Como el bloque está siendo realmente importante, si hubiéramos ignorado el número de bloque me hace ver más difícil las cosas; aunque en esencia no cambian las cosas. El ruido de los bloques nos dificulta ver la señal. Estudiar las condiciones que minimizan la respuesta. - Dar un Intervalo de Predicción al 90% para todos los factores en +0,5. 237 Estudiar posibles efectos de dispersión. Como vemos, no hay efectos de dispersión. CONCLUSIÓN DEL TEMA: Lo que se pretende con los bloques es bloquear el efecto de factores indeseables. Sin embargo, no podemos meter bloques en un diseño de réplica única sin perder algún efecto. Lo que tendremos que tener en cuenta es elegir la mejor estructura de confusión. 238 TEMA 8: Disenos factoriales fraccionados de dos niveles Empezamos los factoriales replicando, luego dimos un segundo paso a la réplica única para reducir coste. Y ahora vamos a poner las cosas más difíciles, muchos factores. Si por ejemplo tenemos un 2k = 10 completo de réplica única ya son 1024 pruebas – Muy caro. Tenemos 210-1 efectos principales = 1023 (uno es la media general). En este modelo tenemos: (10 ) + (10 ) + (10 ) 1 2 3 120 = interacciones triples Efectos principales 45 = interacciones dobles El total si nos quedamos aquí tenemos 175 efectos de interés. No solo no vamos a perder efectos sino que se van a mezclar que es aún peor. Si tengo la suerte de que los efectos dominantes son de orden bajo hay mucha cola que recortar. 239 Los diseños fraccionados se usan con el ánimo de que la experimentación sea más económica en todos los sentidos. Vamos a ver de qué manera se puede, aun haciendo esto, recuperar mucha información. 240 Imaginemos que queremos hacer un 23 y queremos hacer únicamente la mitad. Esto lo vamos a nombrar como: 1 3 ∗ 2 = 23−1 2 Aquí tendríamos la tabla de los signos. Organizamos la tabla de los signos como si fuéramos a hacer bloques. Pero solo vamos a correr uno de ellos. En este caso, nos quedaríamos con las 4 filas de arriba que se caracterizan porque en este caso I = ABC (fracción principal). La otra parte sería la que I es distinta de ABC (fracción alterna). 241 Imaginemos que solo nos quedamos con las cuatro primeras filas. Como podemos ver la columna de A = BC, la de B = AC y la C = AB. Por lo cual al analizar los datos se van a mezclar. Esto era de esperar porque en definitiva en vez de tener 8 efectos, tengo 4, con lo cual no tengo 8 efectos principales tengo 4. Además de dar por perdido la interacción ABC ya que se inyecta en la I. Esta apuesta inicial de sacrificar la interacción es igual a ABC = I = relación de definición. I = ABC A = BC B = AC C = AB Estas 4 igualdades indican que los efectos van a aparecer sumados. Esta estructura recibe el nombre de estructura de alias. Se dice que el BC es alias del A, el B es alias de AC. Todos estos efectos aparecen empaquetados y son indistinguibles. No me va a quedar más remedio que creer que la naturaleza es buena y que va a estar siempre gobernada por los efectos de nivel bajo. ** No tenemos dudas en por qué escogemos la interacción más grande mezclado con I. Si hubiéramos escogido I = ABC -> A = BC, B, AC… y pero aun si hubiéramos igualado I = AB ya que se me mezclarían los factores principales. Construcción de fracciones un medio – Pág. 320 2 4-1 I = ABCD A = BCD B = ACD C = ABD D = ABC AB = CD AC = BD AD = BC Estructura de alias Esto es mejor que antes, pero aun así esta estructura de alias es muy pobre; aún no tengo disponibles las interacciones dobles. Imaginemos que en la tabla de Pareto vemos que están fuertes los que están en negrita. Vamos a pensar, que los importantes son A, B y su interacción. En los bloques perdíamos un bloque, pero ahora es peor ya que no sólo lo perdemos sino que se mezclan. 242 Create New Desigin – Screening – 4 factores. Esto quiere decir que cuando voy a experimentar los factores A, B, C por ejemplo en – voy a poner D = Si en Statgraphics ponemos en – en lugar del + nos haría los bloques alternativos. 243 Si metemos orden de interacción 3: Pero vamos a poner interacción 2. A la vista de estos resultados nos quedaríamos con que el factor A, C y D, la interacción AC y la AD. 244 Vamos a ver cómo nos da los mismos resultados que en el ejercicio 6-2. En resumen: 2k-1 = Fracción ½ de un diseño 2k +1 – Fracción principal I = ABCD -1 – Fracción alterna 245 A = No sabemos si es cualitativo o cuantitativo al igual que el C. En la tabla anterior se muestra la estructura del diseño y las observaciones y exactamente cuál es la fracción. Si voy a hacer un diseño 25-1 tendría despliegue suficiente para combinar los 4 primeros factores y ya veríamos que hacer con el quinto. Vamos a hacerlo coincidir con la interacción de los 4 factores anteriores. Si multiplicamos todas las columnas no tiene que dar +1 pues es la fracción que hemos elegido. Para hacer el diseño – Create New Design – 5 factores y ponemos Half Fraction. Quitamos la aleatorización y en este caso no tiene ningún interés mirar los generadores. Abrimos el ejemplo 8-2: El orden de interacción 5 ni siquiera nos deja meterlo y si metemos interacción 4 nos aparecen los 16 paquetes de 2 en 2 de los que consta la estructura de alias de este diseño. Nos da igual ponerlo en orden 4 – 3 – 2 que el diagrama va a ser el mismo. 246 Vemos que el efecto B domina sobre todos los demás, y luego los otros dos factores principales A y C. Después tenemos dos interacciones dobles (con su alias, pero no vamos a apostar por estas interacciones triples). Si miramos el gráfico de normalidad de los efectos, los efectos con los que nos vamos a quedar están bastante claros: 4 efectos únicamente. Proyectamos: Nos queda un modelo muy sencillo en el que todo es fácil de interpretar dado que todo son efectos positivos. Tendríamos que verificar el modelo mirando los plots de residuales los cuales no parecen significativos. Sin embargo tenemos una sospecha de dispersión por lo que vamos a grabar los residuos y los vamos a enfrentar en un diagrama de dispersión con los factores que hemos quitado (el D y el E). ** Como están en modo Character, tenemos que copiar estos datos en una nueva columna. 247 - Factor D: Los residuos frente al tiempo de grabado parecen un poco dispersos. Para ello hemos tenido que hacer Scatterplot – Exploratory plots – X-Y plot. Ante esta sospecha, podemos ir a compare – two samples y enfrentamos los sresiduals vs tiempo de grabado_1 vemos que el p-valor es = 0,0662, por los pelos… - Factor C: Hacemos lo mismo, pero en este caso sólo con ver el gráfico sabemos que no hay variabilidad al pasar de nivel bajo a nivel alto. El p-valor además es muy grande: 0,91907 En este caso, como lo que se pretende es maximizar tenemos las cosas claras ya que todos los factores son de carácter positivo. Y en cuanto al C y el D tendremos que darlos aquellos valores que minimicen la variabilidad. En el caso del D estará en -1 y C puede estar en el nivel que la empresa determine por otros factores ya que no afecta ni a la variabilidad ni a la respuesta. 248 Aquí se nos plantea correr la otra fracción = -ABC. En una fracción ½ correr las fracciones y combinar los resultados equivale a realizar el modelo completo, luego no tendría mucho sentido. 8.3 LA FRACCIÓN UN CUARTO DEL DISEÑO 2k En un diseño 2k-2 que es lo mismo que decir fracción ¼ de un 2k solo voy a poder estimar la cuarta parte de los efectos, y además se me van a confundir de 4 a 4. Considere una situación en la que tres factores, cada uno con dos niveles, son de interés, pero los experimentadores no están en posición de correr las 23 = 8 combinaciones de tratamientos. Sin embargo, pueden llevar a cabo cuatro corridas. Esto sugiere una fracción un medio de un diseño 23 Puesto que el diseño contiene 23-1 = 4 combinaciones de tratamientos, es común llamar diseño 23-1 a una fracción un medio del diseño 23 ¿Cómo se genera un diseño? Elijo 2 efectos a sacrificar P, Q: I = P = Q (los igualo y los hago coincidir con el efecto general). Y por una cuestión elemental I = P = Q = P*Q -> Relación de definición. ¿De dónde sale la fracción? P = +1, Q = -1 -> Fracción principal (la que se suele correr) P = -1, Q = +1 P = +1, Q = -1 P = -1, Q = -1 Estructura de alias: I = ABCE = BCDF = ADEF Las letras tienen que sumar 2*k. En este caso como K = 6 = 12 letras Esta es la estructura de alias óptima – > 4-4-4 249 Tendríamos 16 paquetes de 4 en 4: soy capaz de reconocer 16 efectos, pero 16 efectos que no son puros, están mezclados de 4 en 4. Otra manera de enfocarlo, si yo tengo un 26-2, tengo 16 pruebas experimentales, lo cual me daría perfectamente para combinar completamente los 4 primeros factores y luego elijo a que vincular los otros dos que me quedan; el E y el F lo tengo que asociar a algo de los restantes factores. Entonces mi estructura de confusión sería I = ABCE = BCDF dando lugar a ADEF. Así tendríamos que ir multiplicando A = BCE = … Sin embargo, vamos a tener el problema de que las interacciones dobles se me van a mezclar. ¿Cómo se hace esto con Statgraphics? Create New Desing – 6 factores – Quarter Fraction – Generadores: E = ABC y F = BCD lo cual nos coincide con el esquema con el que trabaja el libro. El programa me dejaría elegir con + y con – las distintas combinaciones, pero no me deja cambiar los generadores. Abrimos los datos EJ 8-4. Sabemos que el objetivo es reducir la contracción. No se puede ir hasta el orden máximo de interacción (6) porque está confundida dicha interacción. Tenemos que bajar hasta orden 3: 250 A = ACE = CDF AB = CE = ACDF Y así sucesivamente.. Por lo demás, el análisis es igual. Lo que si que es importante es el tratar de interpretar los efectos confundidos en término de los efectos importantes. Cuando tenemos interacciones dobles confundidas tenemos dudas de sobre quien es la importante: vamos a pensar que ya que los factores A y B son los significativos, la interacción significativa será la AB. En el plot de normalidad vemos que 3 van a ser los factores significativos, o como mucho 5. Vamos a purgar el modelo: una vez bajado el orden de interacción a 2, proyectamos en el C, D E y en el F. Esto representa una variabilidad recogida del 96% - bastante importante. Por último, tenemos que analizar los efectos de dispersión: grabamos los residuos studentizados y los comparamos con respecto los factores C, D, E y F que son los que hemos quitado (¡¡¡OJO!!! Marcar la segunda opción): 251 De todos ellos, el que nos ha mostrado una posible dispersión es el factor C = tiempo. Como vemos tiene un p-valor muy pequeño, lo cual indica que sí que ofrece variabilidad al pasar de un nivel a otro. La recomendación para minimizar la contracción es ponerlos todos en el nivel bajo, además después de saber que el tiempo tiene un efecto sobre la dispersión hay que ponerle en nivel bajo. El resto, no influyen en el modelo por lo que se busca para ellos otro tipo de asignación en base a otro criterio. RESOLUCIÓN DEL DISEÑO Si yo tengo un diseño factorial 2k-p = una fracción 1/2p de un diseño 2k, quiere decir que el diseño 2k se puede partir en estos trozos y solo vamos a correr uno; es decir, vamos a correr 2kp experimentos. Digamos que los efectos se organizan en paquetes de 2p efectos mezclados o confundidos entre sí. Es decir, que lo que voy a tener es lo siguiente: Un efecto-i1 confundido con un efecto-i2 confundido con … efecto-ir 2k-p Relación de definición De las misma forma efecto-j1 = efecto-j2 =… = efecto-jr … 2p Tenemos una longitud de 2k-p y una anchura de 2p La primera de estas líneas es lo que llamamos la relación de definición Tenemos que coger efectos a sacrificar y con ellos se genera la relación de definición; y a partir de ahí surge la estructura de alias. Una cuestión adicional a mayores de que los efectos se ordenan en bloques indistinguibles; la idea es procurar que todo aquello que sea importante no se confunda con otras cosas que sean importantes. Por ejemplo, los efectos principales no se pueden confundir entre sí. Las interacciones dobles también son importantes. Es decir, cuando estamos haciendo diseños fraccionarios lo esencial es descubrir efectos principales e interacciones dobles. A lo demás vamos a renunciar. 252 La resolución de un diseño es una medida del precio que pagamos en perdida de potencia por no haber experimentado tanto como lo que supone realizar el experimento completo. Un diseño fraccionario se dice que tiene resolución R cuando ningún efecto que se escribe con p letras es alias de otro efecto que se escribe con R-p letras. O sea, un diseño tiene resolución r si ningún efecto de orden p (el que requiere p letras para ser escritos: factores principales orden 1, interacciones dobles orden 2…) es alias de un efecto que contiene menos de R-p letras. - - - Como poco vamos a considerar diseños de resolución III. En este caso los efectos principales se confunden con interacciones dobles (3-1=2). Es decir los efectos principales no se pueden confundir entre sí, ya que como mínimo se tienes que confundir con las interacciones dobles. Y además es el índice más bajo que se le puede dar. La resolución se expresa en número romanos y se suele poner la resolución como subíndice del 2. Diseño de resolución IV: los efectos más bajos a los que los dejamos confundirse a los efectos principales son como máximo de orden 3 (4-1=3). Es decir, en un diseño de resolución IV los efectos principales son alias de las interacciones triples como mínimo; no se pueden confundir con las dobles ni entre sí. Y las interacciones dobles no se van a poder confundir con las que tengan menos de 4-2 = 2, es decir, no se pueden confundir con los efectos principales pero se pueden confundir entre sí. Diseños de resolución V: Los efectos principales no se confunden ni con interacciones dobles ni triples. Se confunden con cuadruples como mínimo. En el caso de las dobles 5-2=3, no se pueden confundir entre sí. Si uno quiere hacer un diseño en el cual las interacciones dobles y los efectos principales libres como mínimo tenemos que irnos a la resolución V. Si solo queremos tener los factores principales libres nos valdría con resolución III. A la vista de la tabla 8-14 que nos muestra las mejores combinaciones posibles tenemos que: **Cuando se dice que los generadores son C = AB, es equivalente a decir I = ABC. Con 5 factores vemos que hay factores que pueden llegar hasta resolución 5, ya que los factores principales se confunden con las interacciones cuádruples y las dobles con las triples. Podríamos decir que la resolución es el orden más bajo de los efectos que se confunden con los principales +1, y expresar este número en números romanos. 253 Cuando llegamos ya a diseños con muchos factores, como es el caso de 8 podemos jugar con muchas cosas en función de lo que queramos gastarnos. Si yo tengo un 28-1 de resolución 8, tendría que hacer 128 pruebas, siendo 8 los efectos principales, (8*7)/2 = 28. Es decir, en total hay 36 efectos probablemente importantes. Ni si quiera aparece esta opción en la tabla porque es mucho despilfarro. Esta sería la fracción ½. Además con la interacción ¼ ( ) seguimos teniendo resolución 5. Los efectos principales no se confunden ni con interacciones dobles ni triples. Se confunden con cuadruples como mínimo. En el caso de las dobles 5-2=3, no se pueden confundir entre sí. La fracción 1/8 y 1/16 ambas tienen resolución 4. Lo más probable es que con el 1/16 se confundan todas las interacciones dobles. En cambio, en el 1/8 se perderán solo algunas. En el apéndice tenemos el complemento a esto, la estructura de alias para varios factores, como se ve en la imagen inferior: Orden de interacción 4. 254 El diagrama de Pareto muestra que el factor D domina de manera “brutal”. Y luego tenemos otros dos paquetes, lo está claro es que a partir del AE ya nada va a ser importante. Si miramos el plot de normalidad de los efectos, vemos que nos quedamos con el D sólo, o con los tres primeros factores. Como el C está muy abajo y todas las interacciones también, proyectamos sobre C. Que equivaldría a tener los 4 factores replicados completos con réplica única. Miramos como queda esta primera etapa. Aun así hay que seguir purgando, quitamos todo a partir del E. 255 Una vez que ya tenemos este modelo final, pasamos a analizar los residuos. Todos ellos parecen aceptables. Nos quedaría mirar cómo influyen a la dispersión los efectos que hemos quitado, el C y el E. Para ello – Scatterplots – Exploratory plots – X-Y plots: 256 a) Escribir la estructura de los alias de este diseño. ¿Qué resolución tiene este diseño? b) Analizar los datos. ¿Qué factores influyen en la altura libre promedio? Al tener el diseño 5 factores los experimentadores tendrían que haber corrido: 25 = 32 combinaciones de tratamientos. Sin embargo, han corrido 25-1 = 16 combinaciones; es decir, han hecho la fracción ½ del diseño. Sin embargo tienen la peculiaridad de que la estructura de alias no es como la estandar, lo que se está haciendo es que el D es lo resultante de multiplicar ABC. Por tanto, tenemos un 25-1 replicado 3 veces (aunque esto no afecta) en cual tenemos D = ABC o lo que es lo mismo I = ABCD. Sin embargo, esta no es la estructura óptima. La recomendación para estos diseños era: I = ABCDE y es lo que implementa Statgraphics. Esta estructura haría que los factores principales se confundieran con una cuádruple y las dobles con las triples (resolución V: 25−1 𝑉 ), 5−1 al contrario que hace el problema (resolución IV 2𝐼𝑉 : los efectos principales se confunden con triples y las dobles entre sí): I = ABCD A = BCD D = ABC -> B = ACD C = ABD D = ABC E = ABCDE AB = CD ….. Entonces estamos perdiendo resolución sin necesidad. Vamos a analizar los datos, escogiendo en el desplegable la última opción User especifacation, sin necesidad de poner réplicas ni nada, copiamos los datos desde el Montgomery pero sin el nombre las columnas. Aparece la estructura de alias óptima, solo falta el I = ABCD ya que no se deja. Aquí vemos todos los efectos principales mostrados con las triples (la E aparece sola porque está mezclada con la quíntuple). Afortunadamente, el desastre a la hora de elegir la estructura de alias no ha sido muy castigado ya que todas las interacciones dobles confundidas entre sí están a la cola, y no hemos tenido que dudar con cuál de las dos nos quedamos. 257 Por el hecho de tener replicas nos aparece la línea de corte, no había necesidad de fraccionar el modelo: teníamos potencia suficiente. Los efectos significativos son el A, E, B, D y la interacción BE. Podría ser que al purgar el modelo el factor D se perdiera o al revés, que la interacción AE sea ahora significativa. Lo primero que tenemos que hacer es bajar el orden a 2 y quitar más a mayores. Una vez elegido este modelo como modelo final tendríamos que analizar los plots de residuales. Incluso tenemos que ver si en el factor que hemos quitado hay un efecto de dispersión. c) Calcular el rango y la desviación estándar de la altura libre para cada corrida. ¿Hay algún indicio de que cualquiera de estos factores afecta la variabilidad de la altura libre? Lo que se pretende aquí es que se traten los datos como si fueran dúplicas, por lo que tenemos que meter los datos de otra manera. Tenemos que volver a generar el diseño 258 1) Efecto sobre la media: No podemos, no tenemos calculada la media. Tendríamos que volver a nuestro modelo anterior. Ponemos todas las columnas incluida la 8, en modo carácter. Vamos a Comparar > Anlysis of varianza > One – Way Anova Columna 6 – Columna 8. El problema es que no sabemos a qué media pertence cada uno. Abrimos de nuevo el 7c y copiamos los datos que hemos obtenido en la combinación correspondiente: Vamos a analizar el diseño y ponemos la variable media. Llegamos a los mismos resultados que antes. 2) Efecto de dispersión Tenemos que poner la variable respuesta (tanto la 1 como la 2 ya que miden prácticamente lo mismo la desviación típica y el rango) como logaritmos. Además ponemos orden 5 y excluimos ABCD ya que es la relación de definición Este diagrama de Pareto y el gráfico de normalidad nos hacen abandonar esto, todo es ruido. 259 a) Verificar que los generadores que se utilizaron en el diseño fueron I = ACE e I = BDE. Esta sería la estructura óptima. 3+3+4 (el 4 surge como multiplicación de ambas ABCD) Creamos un 25-2 para ver la estructura de alias Como no sigue la estructura de alias que creíamos volvemos a realizar el modelo pero ahora generándolo como usuario. Haríamos las 8 corridas, (e = todos en -1 y e en +1, etc) Pero ya están metidos los datos: Hasta orden 3 no nos deja meter, por lo que una interacción triple está perdida con un factor principal. Metemos orden 2. Comprobamos que la estructura de alias es la que nos dice el enunciado: B = DE o lo que es igual I = BDE C = AE o lo que es igual I = ACE Y por ello sale ABCD Y así sucesivamente: 260 I = BDE = ACE = ABCD -> Relación de definición B = DE = ABCE = ACE C = BCDE = AE = ABC E = BD = AC = ABCDE … (Tenemos que calcular tanta estructura de alias como nos sea necesaria para conocer la resolución) Es decir, tenemos resolución III -> Esto solo se puede hacer cuando solo vamos a apostar por los efectos preliminares. Vamos a purgar, y para ello lo bajamos a orden 1, dejando solo el factor B ya que es el único significativo. Es decir, la variable respuesta es: Y = β0 + β1*Factor B Se corre una fracción 1/8 con tres réplicas. Con alguna razón se trabaja de esta manera con el objeto de estimar el promedio y el rango; es decir, tratarlas como duplicas en lugar de réplicas. Y así con todos. Afortunadamente tenemos los datos ya metidos. 261 Efecto de la media (Var 1): Tenemos una resolución 3, ya que las interacciones dobles no nos la deja meter en el modelo, se entiende que están mezcladas. Además es un 26-3 = 8 corridas, que dan para estimar 7 cosas. Tenemos 6 efectos principales, 15 (6*5/2) interacciones dobles… Aparentemente todo es no significativo pero si quitamos el B y el C, queda un modelo aditivo en los 4 restantes y además todos apoyan positivamente a la respuesta. Como hay que minimizar la recomendación es todos los significativos en el -1 y para los dos que hemos quitado hemos comprado que no hay efecto de dispersión. Digamos que una experimentación tan a bajo coste nos ha servido al menos para saber que en la respuesta actúan 4 efectos en los que hay que poner más énfasis para reducir aún más el modelo. Pero imaginemos que el factor D es alias de EF, no sabríamos quien es el importante, estarían totalmente confundidos. O sea, que este experimento solo sirve para descartar los factores C y B aún queda mucho por estudiar. Vamos a ver qué pasaría si estudiamos los efectos de dispersión (Var 2) Es puro ruido, no hay nada relevante. El R2 ajustado es del 0% 262 263 Todos los factores (6) son cuantitativos. De nuevo aparece el tratamiento de réplicas como dúplicas. Es una fracción 1/4 (16/64). Si está bien hecha la fracción podemos tener una resolución considerablemente buena. MEDIA: Para meter nosotros los datos – DOE – 6 factores – 2 respuestas (media y desviación típica o rango) Si en los factores metemos letras, tenemos que quitar el tic del continuos. – Diseño especificado por el usuario. Pasamos a analizar los datos sabiendo que la variable 1 tiene los promedios y la variable 2 las desviaciones típicas. Orden 3: Aquí tenemos los 15 posibles efectos con sus alias, el 16ª sería el paquete que está con la I (Identidad) por eso no tenemos línea de corte porque el modelo está saturado, se trata de un hipermodelo que pasa por todos los puntos. En el plot de normalidad solo hay un efecto dominante y al estar en la cola por encima de la diagonal el efecto va a ser negativo. 264 Tenemos una resolución 4, ya que la resolución es una unidad más de los efectos de menor tamaño que se confunden con los efectos principales. En este caso, los factores principales están confundidos con las interacciones triples. Sin embargo, tienen la pega de que las interacciones dobles están confundidas entre sí. El modelo es 26−4 𝐼𝑉 La estructura de alias es: F + ACD + BDE I = ACDF = BDEF = ABCE – Relación de definición A = CDF = ABDEF = ABCE … AC = DF = ABCDEF = BE (Así con los 16 paquetes) Para empezar a purgar bajamos a orden 2 y ya vemos que los efectos principales se ven claramente. A continuación tendríamos que proyectar en B ya que está abajo del todo A partir de aquí, tendríamos claro que se trataría de un modelo aditivo con esos 4 factores principales. (El E lo dejamos porque es prácticamente significativo y además su R2 y su R2 ajustado disminuyen) 265 Además si observamos los residuos, vemos que todas las gráficas son aceptables. Al final vemos que el modelo que nos queda es: Si lo que pretendemos es minimizar la respuesta: Es decir, la duración del ciclo y el Punto de rocío de la cocción tienen que ser altos, y la temperatura de laminación y la presión han de ser bajos. Los efectos de dispersión lo vamos a estudiar a través de la desviación típica: Quitamos las interacciones triples. El A y el B son los más importantes. Y de las siguientes interacciones dobles las importantes serían por lógica la AF y la AB. Resulta que lo más importante es que el factor B no estaba en el modelo de las medias, asi que vamos a poder cambiarlo en función de cómo actúe frente la dispersión. Vamos a ver la optimización minimizándola. 266 El A tanto para optimizar la media como la dispersión nos interesa tenerlo en el nivel bajo. El B lo tenemos que poner en el alto. El F nos interesaba que estuviera en alto y para minimizar la dispersión bajo; tenemos una contradicción y aunque el F por sí mismo tiene un pequeño efecto pero aparece fuertemente en dos interacciones. Tendríamos que optar por optimizar la media. 267 Cada placa la han medido en tres sitios, por tanto está claro el tema de las dúplicas. De nuevo tenemos los datos con las unidades naturales (no con 1 y -1). Si quisiéramos poner lote 1 y lote 2 tenemos que quitar continuo. Tenemos 6 factores y 32 observaciones. Por tanto tenemos una fracción 1/2, por tanto la interacción óptima es confundir la I con la interacción máxima. Vemos un diagrama de Pareto con un orden muy marcado: 268 Empezamos a purgar, bajamos el orden a 2 y proyectamos en A y C Si el R2 y el R2 ajustado es muy próximo es que no le sobran muchas más variables al modelo. El plot de residuos frente a “run number” es un poco feo. Además en el factor B y el E presentan mucha dispersión. Cosa que vamos a poder comprobar ahora con la siguiente variable: dispersión. 269 Modelo muy difícil, empieza por interacciones triples. En perjuicio de lo que salga cuando empecemos a purgar, aparece el F que no salía…Como suele ser en la realidad, no merece mucho trabajar mucho este problema en esta parte ya que además es muy parsimoniosa. Lo bajamos a orden 2 y dejamos el E, F y su interacción. Los 3 son significativos aunque nos hemos cargado la interacción triple – R2 muy bajo. 270 La variable respuesta es un poco peculiar, los números van del 1 (el mejor) al 16 (el peor vino). Tenemos 8 factores. El diseño completo tendría 256 corridas de las cuales sólo hemos hecho 16. Por tanto hemos cogido la fracción 1/16. La resolución es 4, por lo que los efectos principales se van a confundir con las interacciones triples y las interacciones dobles van a estar confundidas entre sí. 28−4 𝐼𝑉 Cosa que nos preocupa más. Todos los factores salvo la temperatura. 271 Vemos que afortunadamente las 3 cosas de mayor tamaño son efectos principales; los hallazgos son interpretables. **La única estructura óptima única es la de la fracción ½ en la que siempre tenemos que confundir I con la interacción máxima. El plot de normalidad de los efectos es un poco confuso, no vemos con claridad lo que va a pasar. Sin embargo, el de Pareto nos lo ofrece más claro, los dos primeros efectos principales son los más destacados. a) ¿Cuáles son las relaciones de los alias en el diseño seleccionado por Harry y Judy? Tenemos 16 paquetes de 16 efectos. No aparecen todos, soplo los que tienen interés. Lo que si se ve claramente es que tienen resolución IV. Efectos principales con triples. b) Usar las calificaciones promedio (Y) como variable de respuesta. Analizar los datos y sacar conclusiones. Bajamos a orden 1 y dejamos G y D. Es decir, lo que determina como los catadores ven los vinos son el factor D = levadura y el G = Racimos completos. Como buscamos minimizar, el factor D interesa ponerle en el nivel alto y el G en el bajo. (El R2 no llega ni al 40%, lo cual no es demasiado preocupante tratándose de opiniones) Antes de hacer esto nos hemos cerciorado de la validez del modelo. 272 c) Usar la desviación estándar de las calificaciones (o alguna transformación apropiada tal como log s) como variable de respuesta. ¿Qué conclusiones pueden sacarse acerca de los efectos de las ocho variables sobre la variabilidad de la calidad del vino? Es un modelo muy parsimonioso, además es un modelo gobernado por interacciones dobles. No merece la pena seguir con este modelo, no nos va a salir nada significativo. d) Después de mirar los resultados, Rarry y Judy coincidieron en que uno de los miembros del panel (DCM) sabía más de cerveza que de vino, por lo que decidieron eliminar su calificación. ¿Qué efecto tendría esto en los resultados y las conclusiones de los incisos b y c? Abrimos los datos 26.d y volvemos a analizar los datos. Al quitar la opinión de este experto ya no está tan claro la importancia del factor G. De hecho ahora ya no es significativo. e) Suponga que justo antes de empezar el experimento, Rarry y Judy se enteraron de que las ocho nuevas barricas que ordenaron de Francia para usarlas en el experimento no llegarían a tiempo, y que las 16 corridas tendrían que hacerse con las barricas viejas. Si Harry y Judy simplemente eliminan la columna e de su diseño, ¿qué ocurre con las relaciones de los alias? ¿Es necesario que empiecen de nuevo y construyan otro diseño? En realidad, se dieron cuenta, que el factor C no se utilizó. El diagrama de Pareto es el mismo, lo único que cambia es a quien tiene puesto detrás. De nuevo (aunque ponga C, es el D de antes) el modelo está gobernado por D y por G. 273 Esta sería la estructura renombrada correctamente: El eliminar un factor en una estructura de alias es muy predecible, únicamente tenemos que quitar la fila donde aparece: 274 f) Rarry y Judy saben por experiencia que es improbable que algunas de las combinaciones de tratamientos produzcan buenos resultados. Por ejemplo, la corrida con las ocho variables en el nivel alto generalmente resulta en un vino con una calificación baja. Esto se confirmó el 8 de marzo de 1986 en la prueba del vino. Quieren establecer un nuevo diseño para su Pinot Noir 1986 utilizando estas mismas ocho variables, pero no quieren correr el experimento con los ocho factores en el nivel alto. ¿Qué diseño sugeriría el lector? Tendríamos que experimentar otra fracción. La que estábamos haciendo es la que todos los generadores están el más. Un diseño 28-4 tiene que tener 4 generadores I =G1 = G2 = G3 = G4 y el resto serían los productos de 2 en 2, de 3 en 3 y de 4 en 4. Los generadores, además de decirnos la estructura de alias que tenemos, nos indica que fracción estamos corriendo. Si ponemos todos los generadores en +1, esta se llama fracción principal. Pero tenemos 16 combinaciones de signos en estos generadores, trabajar con una u otra no nos va a propiciar ninguna ventaja. 275 Tenemos 5 factores, por tanto tendríamos que haber hecho 32 corridas. Solo tenemos 16, por lo que hemos optado por la fracción ½ pero la fracción alterna. Entonces podemos alcanzar hasta resolución V. Es decir, los efectos principales se confunden con la interacción cuádruple. 25−1 𝑉 Lo purgamos dejando únicamente el factor A, B y E. Y validamos los plots de residuales. 276 Tenemos 10 factores, el número de corridas que tendríamos que haber hecho es 1024. Sin embargo, hemos optado por un diseño con sólo 16 corridas -> Fracción 1/64 -> 210−6 𝐼𝐼𝐼 277 Diseño factorial fraccionado de 10 factores con 16 corridas, es decir, nos encontramos ante un diseño factorial 210−6 = 24 = 16 𝑐𝑜𝑟𝑟𝑖𝑑𝑎𝑠 Y = proporción de vaciado defectuoso; y queremos saber qué consecuencias tienen los 10 efectos de estudio en el diseño. 𝑝̂ = 𝑝𝑟𝑜𝑝𝑜𝑟𝑐𝑖ó𝑛 𝑑𝑒 𝑣𝑎𝑐𝑖𝑎𝑑𝑜𝑠 𝑛𝑜 𝑑𝑒𝑓𝑒𝑐𝑡𝑢𝑜𝑠𝑜𝑠. Vamos a estudiar la variable respuesta proporción de vaciados no defectuosos queremos maximizarlo. Como es un diseño de resolución III, el grado de interacción con el que vamos a poder analizarlo no va a ser superior a 2. Modelo parsimonioso, aunque se ve claramente que predomina el factor F y K sobre el resto. El modelo está saturado, no se puede ver la línea de cortes de p-valores. Purgamos el modelo: 278 El modelo lo purgamos más aun, y dejamos un modelo puramente aditivo con los dos efectos principales de interés La respuesta Y=binomial b(N,P) donde N es el tamaño de la muestra y P la proporción de defectos. Plot de residuos: este nos tiene que salir como un doble megáfono (rombo) En este tipo de problemas la homogeneidad de la varianza no se resuelve con el logaritmo sino con la fórmula que vemos en el libro de Montgomery. Volvemos a realizar el análisis del diseño pero con la col_13 que es la respuesta corregida con la transformación seno. Aunque corrijamos los datos no tiene por qué variar demasiado el plot de Pareto pero en cambio al ver el plot de residuos, vemos que el problema se ha corregido. 279 Tenemos 9 factores y 16 corridas: fracción 1/32 = 29−5 𝐼𝐼𝐼 . Los generadores del diseño son: E = BD, F= BCD, G = AC, H = ACD y J = AB. 280 Es un modelo muy parsimonioso, no está muy claro que el sistema esté dominado por el F y el D. Si miramos el diagrama de normalidad de los efectos, nos dejaría 7 efectos. En principio bajamos a nivel 1 y todo queda bastante lejos de ser significativo. Por lo que dejamos solo el F y el D, aunque este último no es significativo. Solo explicamos un 40% de los datos. Si miramos el plot de residuales, al tener una distribución de Poisson, aparece: 281 Para corregir esta heterogeneidad, tendríamos que hacer la raíz cuadrada. Sin embargo, esta no logra corregirlo. Probamos a hacer la raíz cúbica donde el diagrama de Pareto se ve más claro. Por tener un plot de residuos con megáfono no se invalida todo, sobre todo lo que afecta es aquello que tiene que ver con la estimación del error. 282 TEMA 14: Analisis de la covarianza ANÁLISIS DE COVARIANZA: Pág. 604 Imaginemos que queremos ver cómo influyen unos determinados factores sobre la variable respuesta y sabemos que además tenemos presente en el experimento una variable que no nos interesa pero puede afectar. Supongamos también que la información de los factores de interés es cualitativa. En definitiva, se trataría del siguiente modelo: Y = variable respuesta A = Factor de interés cualitativo (Puede haber varios) X = Variable cuantitativa que queremos bloquear – Covariable (también pueden ser varias) Quiero ver cómo afecta “A” a la respuesta. A la vez tengo la variable “X” que no la puedo evitar pero la puedo medir. ¿Cómo lo hacemos? - Hacer un análisis de la varianza de Y frente a “A” es inapropiado, pues no consideramos el posible efecto que pueda tener la variable X. La regresión Y frente a X la hacemos para justificar el interés del bloque. Es decir, la regresión lineal de Y frente a X sirve para ver el interés de bloquear la X. En tercer lugar y la opción que vamos a seguir es relacionar el análisis de la varianza con la regresión múltiple de la Y frente a la X y la A (introducida al modelo a través de variables codificadas 0-1 dummies). *El análisis de la covarianza se hace en Statgraphics a través del General Lineal Models. Si solo hay una X podemos haciendo comparándolo rectas de regresión. Como un ejemplo de un experimento en el que puede emplearse el análisis de covarianza, considere el estudio realizado para determinar si existe una diferencia en la resistencia de una fibra de monofilamento producida por tres máquinas diferentes. Los datos de este experimento se muestran en la tabla 14-8. En la figura 14-3 se presenta un diagrama de dispersión de la resistencia (v) contra el diámetro (o grosor) de la muestra. Evidentemente, la resistencia de la fibra también se afecta por su grosor; por consiguiente, una fibra más gruesa será por lo general más resistente que una delgada. El análisis de covarianza podría usarse para eliminar el efecto del grosor (x) sobre la resistencia (y) cuando se prueban las diferencias en la resistencia entre las máquinas. 283 Y = variable respuesta (Resistencia) A = Falta de interés (Máquina) X = Covariable (Grosor) De la variabilidad de la variable Y vamos a quitar la variabilidad de X y de lo que queda vemos cuanto es atribuible a “A”. Puede ocurrir que yo tenga una percepción rápida de cómo afecta la respuesta a la variable máquina; sin embargo tenemos que mirar que no sea a causa de la variable X. Abrimos la TAB 14 -08: 1. Hacemos una regresión simple de la resistencia frente al diametro para ver si hay relación entre ellos. Efectivamente vemos que estos datos están fueretemente asociado. A mayor diametro, mayor resistencia. De hecho la regresión es significativa (p-valor = 0). Esto es igual a al p-valor de la pendiente (slope). 284 2. Si hacemos el ANOVA de una vía, ignorando la covariable. Vemos que desde el punto descriptivo (box-and-Whisker Plot) la máquina 3 está dando unos valores de resistencia más bajo que las otras dos. Aunque no sabemos cuanto se debe a los diametros. Si miramos el p-valor de este análisis, podríamos decir que hay diferencias significativas entre las máquina (p-valor = 0,04). Si vamos al test de Rango Múltiple, hay una diferencia clara entre la 3 y la 2. 285 Sin embargo, como hemos explicado al principio ninguno de estos dos métodos sería correcto. ¿Cuál es la forma de hacerlo? Mismos supuestos que siempre Así, crearíamos un modelo asumiendo que existe una relación lineal entre la respuesta y la covariable. **Tenemos un modelo alternativo, aunque menos utilizado: Lo que queremos ver es de la variable Y saber cuánto es atribuible a la variable, quitarlo y ver cuánto explica el modelo de factor A. Volvemos a nuestro problema y hacemos: Relate – Multiple Factor – General lineal Models La siguiente tabla nos indica los p-valores de la contribución del diámetro (me da igual el p-valor que tenga, solo que si tiene valor 0 sabemos que si lo hubiera quitado estaría camuflado). La máquina tiene un p-valor 0,11. Recordamos que cuando hacíamos RESISTENCIA by MAQUINA, la máquina tenía un p-valor = 0,04. 286 Parte de este efecto es atribuible a la covariable. Es decir, que después de quitar la covariable las diferencias entre máquinas no son tan fuertes; de hecho no son significativas. Tras esto deberíamos analizar los plots para validar el modelo, que como vemos son aceptables: CONCLUSIÓN: Lo que obtenemos es que un análisis incorrecto nos llevaría a atribuir a las maquinas un papel que no tienen porque se está camuflando el efecto de la covarianza. También podemos hacer un modelo de regresión múltiple. Al tener el factor A con tres valores (M1, M2, M3) hay que meter en el modelo variables 0,1… tantas como el número de categorías -1. Aquí tendríamos dos variables z1 y z2. A M1 M2 M3 Z1 1 0 0 Z2 0 1 0 Y = β0 + β1x + δ1z1 + δ2z2 + ε Las variables mudas no hace falta crearlas físicamente en el fichero. Regresión múltiple: 287 Para la M1 hay un 1,58 adicional pero no es significativo Ajustamos tres rectas: - Una recta que tiene 15,77 de término independiente Otra tiene 15, 77 + 1,58 de término independiente pero no es significativa Y la otra = 15,77 + 2,62 de término independiente que si es significativa. Además podemos mejorar el modelo metiendo las interacciones que equivalen a xz1 + xz2 = γ1W1 + γ2W2. Así nos quedaría el siguiente modelo: Y = β0 + β1x + δ1z1 + δ2z2 + γ1W1 + γ2W2 + ε Para realizar esto tenemos una herramienta muy útil. Dentro de Relate – One Factor – Comparación de modelos de regresión: Si doy al tick de abajo estaríamos ajustando el modelo sin las interacciones (rectas paralelas). Si marcamos el segundo estaríamos ajustando un modelo con rectas con el mismo término independiente (un poco raro). Y si no le damos a ninguno estamos obervando el modelo general; el último que hemos visto -> Y = β0 + β1x + δ1z1 + δ2z2 + γ1W1 + γ2W2 + ε Si no marcamos nada nos queda un modelo desmedido: 288 Muy próximas a ser paralelas. Pasamos a purgar el modelo, marcando el segundo tick (modelo aditivo): De las cuales ninguna presenta una diferencia significativa; p-valores grandes. En definitiva, cuando uno tiene en un modelo un factor y una covariable es que a nosotros no nos interesa como está relacionada la Y con la X, lo que pretendemos es quitar dicha relación. Y estos análisis no nos lo ofrecen. Para ello vamos a usar en estos casos en General Lineal Models: factor como explicativo de la variable respuesta. 289 Como es obvio si no aplicamos los métodos de descarga que presentan las carretillas al mismo volumen, tendremos un efecto que nos puede confundir – volumen (x). Relate – Multiple Factor – General lineal Models No hay efecto carretilla. Aceptamos la hipótesis nula. En este caso el contraste de hipótesis es: Ho: τi = 0 ∀i H1: τi ≠ 0 Tendríamos que pasar ahora a validar el modelo: El plot de sresidual vs predicted no parece conflictivo y el plot de normalidad también queda razonable; con tan pocos puntos no podemos pedir más 290 Ejercicio 14-14 Relate – Multiple Factor – General lineal Models El pegamento (Glue) no es significativo. Vamos a ver qué hubiese pasado entre la regresión y la covariable como un modelo de regresión – Simple Regression - Strenght vs Thick. Donde vemos que la fuerza de la adhesión está relacionada inversamente con el espesor. Además el p-valor de este modelo es 0. ¿Y si hubiésemos hecho el ANOVA de una vía ignorando la covariable One – Way ANOVA Strenght by Glue. Donde vemos que la regresión tampoco es significativa: En este caso, descontando o sin descontar el efecto de la covariable, esta regresión no es significativa. 291 Ejercicio 14-16 Relate – Multiple Factor – General lineal Models Una vez descontando el valor de la dureza, vemos que el p-valor es muy grande. Luego no es significativo. Si vamos a los plots de residuales, vemos que hay heterogeneidad: Siempre hemos optado por hacer transformaciones de la respuesta (sqrt, logarítmicas, etc). Esta vez, vamos a coger la covariable y la vamos a meter también al cuadrado. 292 Como vemos el plot de residuales se corrige bastante. Los modelos tratan de reflejar la realidad a través de aproximaciones matemáticas. Como estamos resolviendo algo muy local, podemos tener varias funciones que representen estas aproximaciones de la realidad. *El resto de plots siguen siendo razonable. Experimentos factoriales con covariables – Pág. 620 La primera mitad de la tabla es la primera réplica, y la segunda parte; la segunda. Abrimos la tabla 14-14 Es un fichero sfx, por lo que podemos analizarlo con DOE. Vamos a ver qué ocurriría. Ignoramos la covariable Variable respuesta = Y - max order = 3. 293 Tendríamos que quitar solo la interacción triple y la BC. Quedaría este modelo: Y = 25,0287 + 11,1988*Factor_A + 18,055*Factor_B + 7,2425*Factor_C - 18,905*Factor_A*Factor_B + 14,7975*Factor_A*Factor_C. Pero es un análisis inadecuado ya que si hacemos la regresión Y vs X, hay una relación creciente aunque no lineal que puede tener un efecto sobre el modelo que hemos hecho. Además su p-valor es pequeño. 294 Entonces analizamos el modelo con General Lineal Models: La D es la covariable: Esta también puede tener interacción con los factores, por lo que el modelo final sería: Tengo el modelo saturado; no nos queda más remedio que jugárnosla y bajar el orden de interacción ya que sino no vemos nada; (quitando el ABC y la interacción ABC*D) Como vemos la interacción ACX y BCX tienen un p-valor muy grande, vamos a ir purgando y para ello lo vamos quitando. Además vamos a quitar el AC, el BC y el CD. Como vemos el modelo ha cambiado radicalmente, ahora todos los términos que hemos dejado significativos. Y además un tiene un R2 = 99. 295 Con este modelo podríamos hacer ahora todo tipo de estudios tal y como vimos con los modelos lineales generales –> Multiple Range Test, etc. 296 TEMA 11: MSR – Metodología de superficies de respuesta. Cuando metíamos puntos centrales en el diseño y la prueba de Lack of Fit era menor que 1, teníamos falta de ajuste y no podíamos continuar. ¿Cómo solucionamos esto? Diseños de superficie de respuesta Características del diseño Una o varias variables respuesta, Y1, Y2, ... Varios factores experimentales continuos X1, X2, X3, ... Objetivo: - Optimizar una de las respuestas (maximizar o minimizar): Buscar la combinación de niveles de los factores que producen el óptimo. - Optimizar una respuesta restringida a un área de valores de otra respuesta. - Determinar una región del espacio de factores en la que se satisfacen las especificaciones de operación Modelo: Lo que vamos a hacer es parametrizar las cosas. Habitualmente vamos a suponer f es un polinomio de grado bajo (Aprox. Taylor). O bien que la aproximación que me daría esta aproximación es más que suficiente. 297 Vamos a suponer que la Y está relacionada con las X a través de una determinada función. Imaginemos que mi proceso está operando en una pequeña región y vamos a reproducir observaciones para ver hacia donde tenemos que mover esta región de operación; según sean mis objetivos (maximizar, minimizar…). Sin embargo, no vamos a tener ningún óptimo absoluto, solo local. Organizando convenientemente la organización uno se puede mover hacia la zona correcta. METODOLOGÍA Procedimiento secuencial en tres etapas: 1. Aproximación lineal en las condiciones actuales de operación: explorar el espacion en donde estamos operando. 2. Método de ascenso por pasos: nos va a indicar cómo caminar por ladera hacia algo que puede ser la cima. Cuando tengamos unas ciertas garantías de que estamos en la cima ya podemos pasar a orden 2. 3. Ajuste de una superficie de respuesta de orden dos. *Sólo se garantiza convergencia a un óptimo local. PASO 1: Aproximación lineal en las condiciones actuales de operación - - - Se realiza un diseño factorial 2k en las condiciones actuales de operación; no nos va a hacer falta replicarlo ya que le vamos a añadir puntos centrales. Si tuviera la suerte de que ya estoy en la cima, veríamos que hay curvatura por lo que el modelo lineal ya no sería razonable. Esto querría decir que estamos bastante cerca del óptimo y pasaríamos al paso 3. En cambio, cuanto más no significativo salga el Lack of Fit, más lejos estamos y vamos a tener que ir al paso 2. Se añaden puntos centrales para chequear la curvatura cuadrática. Si hay curvatura cuadrática, pasamos directamente al Paso 3. Si estamos lejos del óptimo, la aproximación lineal es razonable. Después de descartar curvaturas, tenemos el modelo: **También tendríamos que poner las interacciones Se determina la ruta de ascenso (o descenso) máximo: Ruta desde el centro del diseño factorial perpendicular a las curvas de nivel del modelo lineal (líneas rectas). 298 PASO 2: Método de ascenso por pasos - Hemos determinado previamente la ruta de ascenso. Se fija el tamaño de los pasos en función de información previa sobre el proceso. Se realizan varios experimentos a lo largo de la ruta de ascenso hasta que cambia de tendencia la variable respuesta. En la zona de cambio de tendencia puede haber un óptimo local. Ajustaremos un modelo cuadrático (Paso 3). Si la curvatura no fuera significativa buscamos una nueva ruta de ascenso (Repetir Paso 1 y Paso 2) desde la nueva zona de operación. PASO 3: Ajuste de un modelo de superficie de respuesta de segundo orden - Si se está relativamente cerca del óptimo, se requerirá un modelo de segundo grado (al menos) para recoger la curvatura. - Para ajustar este modelo no sirve un diseño factorial con puntos centrales. Sólo - permite contrastar si algún , pero no permite saber cuáles ni estimarlos. La parte factorial no se suele replicar; estamos hablando de estimación a bajo coste. Se realiza un DISEÑO CENTRAL COMPUESTO. Consta de tres tipos de puntos: 299 - La forma de elegir α es muy variopinta, lo más habitual es que sea ROTABLE Una propiedad deseada del diseño es que sea ROTABLE: El error de predicción (desviación típica de la variable 𝑦̂ ) sólo depende de la distancia del punto al centro del diseño. El diseño se hace ROTABLE eligiendo adecuadamente el espaciamiento axial: (F = puntos factoriales) EJEMPLO: Estudio del porcentaje de conversión o rendimiento de un proceso químico. FACTORES: - Tiempo de reacción (x1) - Temperatura de Reacción. (x2) RESPUESTAS: - Rendimiento. Respuesta principal a maximizar. – Respuesta primaria - Viscosidad. Respuesta secundaria que tiene que estar en un determinado rango de valores prefijado. – Respuesta secundaria Es decir; nos interesa maximizar el rendimiento pero no con cualquier viscosidad. CONDICIONES ACTUALES DE OPERACIÓN: - TIEMPO en torno 35 minutos. - TEMPERATURA en torno a 155 ºF. Hacemos el diseño factorial completo, sin replicar porque ya tenemos 5 puntos centrales. Para crearlo: DOE – Screening – 2 factores – 1 respuesta – Diseño factorial 2^2 con 5 puntos centrales colocados al final y quitamos la aleatorización. Abrimos el ejercicio TAB 11-01: Analizamos este diseño, poniendo con las opciones de panel que nos saque la prueba del Lack of Fit. 300 No tenemos falta de ajuste ya que el p-valor es alto. Ya podemos quitar el Lack-of Fit. Además vemos que el modelo es puramente lineal, ya que la interacción no es significativa. Por tanto, la quitamos: El modelo sería: Si pasamos a analizar los plots, en las zonas donde solo he hecho una observación; esta hace de atractor de modelo lineal. Sin embargo, en la zona de los puntos centrales hay mayor variabilidad. En este tipo de problema los plots de residuos son un poco complicados. 301 Si miramos el plano que hemos ajustado, es fácil ver que tenemos que ascender en este plano para ir ganando rendimiento. También podemos verlo buscando las líneas perpendiculares: Las curvas de nivel serían Rendimiento estimado = C. =C ¿Cómo serían las recta perpendiculares a estas? Si la recta es: ax1 + bx2; el vector perpendicular es: (-b,a); que en este caso sería (0,775, 0,335) 302 Aumenta a un ritmo sostenido al principio y luego vemos el punto de inflexión; donde tenemos un rendimiento próximo a 67. Vamos a la trayectoria de máxima pendiente que nos ofrece Statgrpahics; predicción de lo que debería pasar si se mantuviera la linealidad. Sin embargo no debemos fiarnos del rendimiento estimado. El ritmo de los pasos los podemos cambiar si damos al botón derecho. 303 Podemos pensar que el 67 está cerca del óptimo y pasamos al paso 3: Ajuste de un modelo de orden 2. Podríamos haber hecho solo la parte central y los puntos centrales hasta determinar que había curvatura. Hemos elegido el diseño rotable con √2 y -√2 = 1,414 y -1,414 La parte de estrella. Como se crearía este diseño: DOE – Response Surface – 2 factores experimentales – 2 respuestas – Central composite desing – 2^2 + star. Ahora tendríamos que dejar marcado rotable, y poner que queremos 5 puntos centrales poniéndolos al final y sin aleatorizar. Abrimos el ejercicio TAB 11-01.CONT: Analizamos el rendimiento hasta orden 2. Aquí, si saliera falta de ajuste muy alto querría decir que ni siquiera el modelo cuadrático estima bien la curvatura. De hecho no tenemos ni porque comprobar esta falta de ajuste. Este modelo se podría purgar quitando la interacción AB, digamos que por el principio de jerarquía lo tendríamos que dejar. 304 También podríamos mirar las curvas de nivel: Modelo estimado: RENDIMIENTO = 69,1 + 1,633*TIEMPO + 1,083*TEMPERATURA 0,968751*TIEMPO^2 + 0,225*TIEMPO*TEMPERATURA - 1,21875*TEMPERATURA^2 En este ejemplo concreto, hemos llegado a la cima de esta montaña. Una de las diferencias notables cuando relacionamos los modelos experimentales con los modelos de regresión; es que si yo quito las interacciones no se modifica ni la estimación ni la suma de cuadrados La ortogonalidad algebraica es la absoluta independencia en términos estadísticos: El término independiente y los términos cuadráticos se condicionan entre sí. En los modelos cuadráticos perdemos cierta linealidad; hay que comprobar si cuando quitamos algún valor afecta al resto. También podríamos haber hecho un modelo de regresión múltiple: Relate – Multiple Regression: Llegamos al mismo modelo; lo que pasa es que no podemos ver las superficies de respuesta. 305 Para elegir la combinación que maximiza el rendimiento tendríamos no solo que mirar el panel de optimización: Dado que tenemos un doble objetivo; la viscosidad tenemos que continuar con el análisis DOE – Viscosidad: Podemos bajar a orden 1 ya que tiene un comportamiento lineal: Como el objetivo era mantenerlo entre 38 a 42; modificamos en opciones de panel para que salga esos valores exactos. Convertimos este diagrama con las opciones de panel en regiones pintada y lo copiamos en Statgallery 306 Como vemos el óptimo está fuera del rango de viscosidad. Sin embargo, el comportamiento de toda la región que está dentro del círculo es extrapolable al óptimo. Hay veces que podemos ampliar los diseños - DOE – Create Desing – Augment Existing Desing: Esto me permite replica, añadir una fracción o añadir puntos estrella que es lo que nos compete en este caso. Nos añade tanto puntos centrales como ya teníamos. Ejemplo 11-1 pág. 432 (Adobe) Abrimos DEXP TAB 11-01 Hacemos el diseño factorial con puntos centrales. Normalmente se hace con 5 puntos centrales, pero con dos datos sería suficiente. Rendimiento – Max order interaction = 2. Incluye el test de falta de ajuste. Como el p-valor de falta de ajuste es muy alto, no hay curvatura reseñable; es decir, no hay falta de ajuste. Seguramente estemos muy lejos del óptimo (del pico o valle) Simplificamos el modelo, ya que la interacción no es significativa; obteniendo la siguiente relación: 307 Si miramos la superficie de respuesta y las curvas de nivel, ya sabemos que para avanzar más deprisa en la búsqueda de la cima hay que moverse perpendicularmente. Si de la expresión anterior quitamos la variable “Y” y el término constante, tendríamos la curva de nivel: 0,7775x1 + 0,325x2 = cte. Vamos a coger el factor que tiene el efecto más grande para definir el paso; normalmente el paso va a ser de orden 1 en la dirección de este efecto. La pendiente de todas las rectas de nivel es 0,325/0,775 =0,42. Partimos del centro de cuadrado (35, 155) Obteniendo los siguientes resultados en el laboratorio: 308 Para analizar estos datos abrimos DEXP 11-04 (creado como diseño factorial con puntos centrales) El test de falta de ajuste es muy significativo, mucha curvatura. Sin embargo, si vemos las curvas de nivel no vemos forma de valle; estos puntos centrales solo sirven para estimar si hay curvatura o no, mediante una aproximación lineal no podemos hacernos a la idea de cómo es la superficie. Tenemos que completar el diseño. Si aquí de nuevo no hubiésemos tenido curvatura volveríamos a buscar el óptimo reorientando nuestra ruta tantas veces como sea necesario mientras no se detecte la curvatura. ¿Cómo completamos el diseño? 309 Así, nos genera la parte estrella; un diseño como el de antes pero rotado. Los datos los tenemos metidos en el fichero Tabla 11-06; añadiendo dos variables respuesta, tal como nos dice el enunciado: viscosidad y peso molecular. Ignorando los números de bloque. 310 El efecto de la interacción sigue siendo no significativo: Por primera vez vemos una superficie de pico, de valle: Si queremos maximizar el rendimiento deberíamos ir al centro del pico: 311 Pero como el enunciado nos dice que la viscosidad tiene que estar entre 62 y 68 y el peso molecular no puede ser superior a 3400. Sin cerrar este análisis: El único término que no es significativo es un término cuadrático pero no podemos quitar nada porque ya es un modelo de segundo orden. Vamos a dibujar las curvas de nivel para que nos coincidan las líneas con los valores entre los que tiene que estar la respuesta: 312 Tenemos que estar en la zona rosa. Vamos a ver qué ocurre para el peso molecular; abrimos otro análisis ignorando de nuevo el número de bloque. Si miramos la tabla ANOVA: La curvatura no es significativa y podríamos dejarlo como un modelo de orden 1 Superponemos las tres gráficas y vemos que tenemos que estar en la zona rosa, y por debajo de la diagonal del peso molecular, tendríamos que situarnos… 313 El programa tiene un paquete para hacer esto podemos analizar las respuestas múltiples sin cerrar los anteriores: Nos dibuja un gráfico similar al de antes. Además crea una especie de función sincronizando las 3. Tenemos que ir a Multiple Response Optimization y en opciones de panel podemos: En el caso del rendimiento maximizar; en el caso de viscosidad: Hit 65 (media entre los valores deseados) y el p-molecular minimizarlo. 314 BLOQUE II: BLOQUE II: ENTREGABLES ENTREGABLES 315 EXAMEN ORDINARIO 13/14 - 1ª entrega Beatriz Pérez de Vargas Moreno Ejercicio 1.-Se compara la eficacia de 6 agentes biológicos distintos en la eliminación de un contaminante químico presente en los residuos de un proceso industrial alimentario. Se toman 30 muestras de residuos, que son asignadas al azar a los agentes biológicos, 5 a cada uno. El experimento consiste en someter los residuos a la acción del agente biológico durante un periodo de tiempo fijo y medir la presencia de contaminante químico tras el tratamiento, en ppm. Las pruebas se realizan de manera completamente aleatorizada. (Datos en CONTAMINACIÓN.sfx) **Aunque el enunciado no lo dice, en todo el ejercicio utilizaré un α = 0,05 Antes de empezar cualquier problema debemos echar un vistazo al gráfico de dispersión y al gráfico de cajas y bigotes para hacernos una idea de lo que nos vamos a encontrar. En principio podemos ver que si que va a haber diferencias entre los distintos agentes, y que posiblemente tengamos algo de heterogeneidad de la varianza, ya que las cajas tienen anchuras diferentes. Vamos a ver qué ocurre. a) Ajustar el modelo oportuno para este tipo de diseño experimental y validar dicho modelo. En el caso de que se detecte alguna violación de las hipótesis, actúese en consecuencia, justificando convenientemente la manera de actuar. El modelo oportuno para este diseño experimental es elmodelo de efectos fijos de un factor. Queremos ver cómo afecta la variable categórica “agente biológico” con a=6 niveles a los valores medios de que toma la variable respuesta “presencia de contaminante químico”. Buscamos aquel agente biológico cuya eficacia sea máxima y, por lo tanto, que la presencia de contaminante químico sea la mínima. El número de réplicas es 5 para cada agente biológico, todas ellas asignadas de forma aleatoria. Lo primero que tenemos que hacer es verificar la validez del modelo, para ello tenemos que comprobar si se cumplen estas tres hipótesis: 316 Homogeneidad de la varianza: si el modelo es correcto y se satisfacen los supuestos el gráfico de residuos vs predichos no tiene que seguir ningún patrón. Independencia: Igual que antes; si el modelo es correcto y se satisfacen los supuestos el gráfico de residuos contra el tiempo no tiene que seguir ningún patrón obvio. Normalidad: Para comprobar esta hipótesis construiremos una gráfica de probabilidad normal de los residuales. Si la distribución fundamental de los errores es normal, esta grafica tendrá la apariencia de una línea recta. Vamos a ver que nos dice Statgraphics: - Homogeneidad de la varianza: El gráfico de residuos frente a predichos es el siguiente: Claramente vemos como los residuales tienden a forma de megáfono abierto, luego la primera de las hipótesis no se cumple. Es más, aunque a la vista del gráfico parece claro el incumplimiento de la hipótesis podemos asegurarnos marcando . Si el p-valor es <0,05 podemos afirmar que hay heterogeneidad en la varianza: 2 de las 3 pruebas nos dan un p-valor < 0,05. Ya no haría falta si quiera verificar la normalidad y la independencia, ya que con unas de las hipótesis que falle el modelo no es válido; luego parece lógico llevar a cabo un reajuste que corrija la heterogeneidad de la varianza. Para ello, vamos a seguir el método empírico visto en clase: A partir de la fórmula: Y realizando un ajuste de regresión, determinaremos el estimador de α. Con este estimador sacaremos el ajuste más aproximado a partir de esta tabla: 317 Hacemos la regresión con Statgraphics, y en el Plot of FittedModel podemos encontrar el siguiente ajuste de la regresión: Comparando término a término vemos que α = 1,133≈ 1 Con lo cual si miramos en la tabla superior, cuando α = 1, λ = 0 y por tanto hay que realizar una TRANSFORMACIÓN LOGARÍTMICA. (Señalado en la tabla anterior) Para comprobar si hemos acertado con la transformación volvemos a mirar los gráficos que nos permiten chequear la validez del modelo: - Homogeneidad de la varianza: El gráfico de residuos frente a predichos y las distintas pruebas de las varianzas que nos ofrece Statgraphics tras las transformación son los siguientes: Como podemos observar el gráfico es bastante aceptable, aún así si no estuviéramos seguros podemos ver que todas las pruebas de chequeo de la varianza han dado un p-valor > 0,05. Luego ya cumplimos la hipótesis de homogeneidad de la varianza. Vamos a ver qué ocurre con las otras 2 hipótesis de las que hablábamos al principio: -Test de independencia: El gráfico de residuos frente al tiempo vemos que no sigue ningún patrón obvio, luego también podemos afirmar que se cumple la hipótesis de independencia. 318 -Test de normalidad: Para comprobar esta hipótesis construiremos una gráfica de probabilidad normal de los residuales. Si la distribución fundamental de los errores es normal, esta grafica tendrá la apariencia de una línea recta. Veamos a ver qué ocurre: Aunque hay una ligera asimetría en los datos no es suficiente para cuestionar la normalidad ya que el p-valor de la prueba nos da 0,4185 > 0,05. Por tanto, el análisis de la varianza es robusto con respecto al supuesto de normalidad. CONCLUSIÓN: a la vista de todos estos resultados podemos afirmar la validez de nuestro nuevo modelo; por ello, en lo que resta de ejercicio utilizaremos el modelo ya transformado. b) Formular matemáticamente el modelo matemático ajustado y explicar sus componentes. Tenemos un diseño totalmente aleatorizado. Variable respuesta -> y = presencia de contaminante químico tras el tratamiento, en ppm (aleatoria). Aunque en el modelo ajustado la variable respuesta es log(y). xi= agente biológico - > factor fijo (cualitativo) con a niveles a = 6 niveles n = 5 réplicas a=6 1 n=5 2 3 4 5 6 1 2 3 4 5 Total = 6 x 5 = 30 corridas 319 Este modelo se puede formular de dos maneras: Modelo de medias:Una manera de escribir este modelo es: donde yjj es la observación ij-ésima, µi es la media del nivel del factor o tratamiento i-ésimo, y ɛij es un componente del error aleatorio que incorpora todas las demás fuentes de variabilidad del experimento, incluyendo las mediciones, la variabilidad que surge de factores no controlados, las diferencias entre las unidades experimentales a las que se aplican los tratamientos, y el ruido de fondo general en el proceso (ya sean la variabilidad con el tiempo, los efectos de variables ambientales, etc.). Modelo de los efectos:Una forma alternativa de escribir un modelo de los datos es definiendo de tal modo que la ecuación del modelo de medias se convierte en: En esta forma del modelo, µ es un parámetro común a todos los tratamientos al que se llama la media global, y Ʈi es un parámetro único del tratamiento i-ésimo al que se le llama el efecto del tratamiento i-ésimo. * Recordemos que para probar las hipótesis se tienen que cumplir las tres hipótesis: ɛijv.a.i.i.d ~ N(0,σ) Independencia Normalidad Homogeneidad de la varianza c) Comparar la eficacia de los distintos agentes en la eliminación del contaminante y hacer la recomendación más conveniente desde el punto de vista industrial. Lo que queremos probar es la igualdad de las medias de los 6 agentes. Las hipótesis apropiadas son: Para ver si existen diferencias significativas entre los diferentes agentes basta con mirar el p-valor de la tabla ANOVA (una vez que hemos validado el modelo): 320 Como el p-valor es ≈ 0, rechazamos la hipótesis nula y por tanto podemos afirmar que existen diferencias significativas entre la eficacia de los distintos agentes. Sin embargo, la tabla ANOVA nos dice que hay diferencias pero ¿entre que agentes? Como los datos que obtenemos son de la cantidad de contaminante presente tras la actuación de los agentes lo que nos va a interesar son aquellos cuyos valores obtenidos de contaminante hayan sido los más bajos. Para responder a esta pregunta podemos fijarnos primero en la gráfica de medias que tenemos a la derecha donde observamos que podemos distinguir entre tres grupos comparando la eficacia de los agentes. Por un lado el Agente 1 y el 6, por otro el 2 y el 5 y finalmente el último par de agentes similares sería el 3 y 4. Estos resultados han de coincidir con las pruebas de Rango Múltiple donde tenemos diferentes métodos aunque los más recomendados son LSD: diferencias menos significativa Duncan Tukey Estos se pueden ir alternando en PaneOptions y nos ordenan los niveles de las medias de menos a más. Como vemos todos los métodos, incluido Bonferroni(que es el más conservador) nos da la misma solución que vaticinábamos con el gráfico de medias. Los agentes cuyas X están en la misma columna no presentan diferencias significativas entre sus medias, pero sí entre ellos y los agentes cuya X está en una columna diferente. Esto es lo que pretende explicar la tabla de la derecha , donde están marcados con un asterisco los pares de agentes cuyas medias presentan diferencias estadísticamente significativas. 321 CONCLUSIÓN: Por tanto, como los datos que obtenemos son de la cantidad de contaminante presente tras la actuación de los agentes lo que nos va a interesar son aquellos cuyos valores obtenidos de contaminante hayan sido los más bajos, en nuestro caso el 3 y el 4. Desde el punto de vista industrial, entre estos dos agentes elegiríamos el más económico o cualquiera que sea el factor en quese base la empresa después de saber que la eficacia de ambos es el mismo. d) Obtener un IC al 95% para la contaminación media restante tras aplicar el AGENTE 1. Tenemos diferentes fórmulas para obtener el I.C, nosotros nos vamos a basar en la vista en clase: En lugar de realizarlo a mano, Statgraphics nos da dicho resultado en su tabla de medias. Nos pide un I.C al 95 % para el agente 1, que como vemos es: [9,68131 , 9,81203]; sin embargo recordemos que habíamos aplicado logaritmos, asique aunque no es del todo cierto habrá que hacer el anti-logaritmo; por tanto el I.C es: [e9,68131 , e9,81203] = [16015.46 , 18252] e) Explicar qué quiere decir que el diseño es completamente aleatorizado y para qué sirve esta estrategia experimental. En un diseño completamente aleatorizado el orden de los experimentos se elige de forma totalmente aleatoria. Si el experimentador ha decidido obtener 4 observaciones para cada factor y suponiendo que hay un solo factor con 4 niveles, el diseño completamente aleatorizado de un solo factor consistiría en asignar al azar cada una de las 4 x 4 = 16 corridas a una unidad experimental. Esta estrategia experimental sirve para evitar que los efectos de factores externos que actúan como variables perturbadoras desconocidas contaminen los resultados. Mediante la aleatorización de la prueba conseguimos repartir estos factores indeseables de manera neutra e imparcial durante todo el experimento. f) Qué diseño experimental habrías usado si las 30 muestras se hubieran tomado en 5 días distintos, 6 muestras cada día. Explica en qué consiste ese diseño, qué estrategia experimental se está usando y qué utilidad tiene dicha estrategia. Hubiese utilizado el Diseño en Bloques completos aleatorizados (RCBD) en el cual tenemos: - Un factor principal= Factor realmente objeto de estudio con a niveles, en este caso sería el agente. - Un factor bloque= Factor que no es objeto directo de estudio pero quepuede afectar a la respuesta con b niveles, en nuestro caso sería los días. 322 Por cada nivel del factor bloque se reparten de forma aleatoria todoslos niveles del factor principal, es decir, cada día realizaríamos una medida por cada uno de los agentes. Día 1 2 3 4 5 1 5 6 3 4 2 2 5 6 4 1 2 1 2 5 3 6 4 3 6 1 2 5 4 1 2 6 5 4 3 Esta estrategia se utiliza cuando la fuente perturbadora es conocida y controlable, lo que se pretende es bloquear al factor; de ahí el nombre de formación de bloques. La principal utilidad de esta estrategia experimental es que elimina una fuente de variación del error, aumentando de esta forma la precisión del ensayo. Son numerosas las ocasiones en las que el RCBD es apropiado, por ejemplo: las unidades de equipo o maquinaria de prueba son con frecuencia diferentesen sus características de operación y serían un factor de formación de bloques típico. Lotes de materiaprima, personas y el tiempo también son fuentes de variabilidad perturbadora comunes en un experimentoque pueden controlarse de manera sistemática mediante la formación de bloques. 323 EXAMEN ORDINARIO 13/14- 2ª Entrega Beatriz Pérez de Vargas Moreno Ejercicio 2.- Se usan dos tipos de máquinas para enrollar bobinas de cobre. Un tipo de máquina opera manualmente y el otro con motor. Se dispone de dos máquinas de cada tipo. Se enrollaron tres bobinas con cada máquina con la misma longitud de alambre proveniente de dos rollos distintos elegidos al azar del almacén. Para cada bobina se mide el diámetro exterior en la parte central y se obtienen los siguientes resultados (en unidades de 10-5 pulgadas). El objetivo es que las bobinas tengan un diámetro lo menor posible. a) Explicar el diseño experimental realizado y todos los elementos que lo componen. b) Formular matemáticamente el modelo matemático más apropiado para este diseño. c) Ajustar el modelo anterior y validar dicho modelo. En el caso de que se detecte alguna violación de las hipótesis, actúese en consecuencia, justificando convenientemente la manera de actuar. d) Plantear y contrastar las hipótesis de interés en este problema. Estimar los parámetros de interés. e) Extraer conclusiones desde el punto de vista industrial f) Explicar y justificar los denominadores de los F-tests. g) Explicar en qué cambiaría el diseño y el análisis si se dispusiera de muchas máquinas de cada tipo y las utilizadas en el experimento se hubieran elegido al azar. a) Explicar el diseño experimental realizado y todos los elementos que lo componen. Se trata de un diseño factorial-anidado ya que tenemos un experimento con factores múltiples en los cuales algunos factores como el Rollo y el Tipo de máquina están incluidos en un arreglo factorial y otros, como es el caso del nº de máquina está anidado al tipo de máquina. Puesto que sólo tenemos dos tipos de máquina y dos máquinas dentro de estos tipos, y los rollos se escogen al azar, se trata de un modelo mixto. Variable respuesta Y = diámetro Rollos: efecto aleatorio -> 1,2 Tipo de máquina -> Efecto fijo -> Manual y Motor -> 1,2 Nº de máquina- > Efecto fijo anidado en tipo de máquina -> 1,2 3 réplicas 324 b) Formular matemáticamente el modelo matemático más apropiado para este diseño. El modelo lineal para este diseño es: 1,2 1,2 1,2 1,2,3 Donde µ es el término general, τi es el efecto del rollo i-ésimo, βj es el efecto del tipo de máquina j-ésimo, γk(j) es el efecto del número de máquina k-ésimo dentro del nivel j-ésimo de cada tipo de máquina, (τβ)ij es la interacción rollo-tipo de máquina, (τγ)ik(j) es la rollo-número de máquina dentro de cada tipo y ɛ(ijk)l es el término de error usual. Tanto τi , como ɛ(ijk)l y las interacción del efecto τ con el resto de factores, (τβ)ij y (τγ)ik(j) , son variables aleatorias independientes, supondremos también que estas variables aleatorias siguen una distribución normal con media cero y varianzas dadas por V(τi) =στ2, V[(τβ)ij] = στβ2, V[(τγ)ik(j = στγ2 y V(ɛ(ijk)l) = σ2. Por tanto, la varianza de cualquier observación es: V(yijkl) = στ2 + στβ2 + στγ2 + σ2 y στ2, στβ2 , στγ2 y σ2 son los componentes de la varianza. En cambio, βj y γk(j) son efectos fijos tales que: ∑2𝑗=1 𝛽𝑗 = 0 y ∑2𝑘=1 𝛾𝑘(𝑗) = 0. Es decir, la suma de los efectos del tratamiento B(tipo de máquina) y la suma de los efectos del tratamiento C(número de máquina) es cero dentro de cada nivel B. c) Ajustar el modelo anterior y validar dicho modelo. En el caso de que se detecte alguna violación de las hipótesis, actúese en consecuencia, justificando convenientemente la manera de actuar. Vamos a analizar estos datos con la ayuda de "General Linear Models" 325 Para validar los modelos recordamos que estos habían de cumplir tres hipótesis: Homogeneidad de la varianza: si el modelo es correcto y se satisfacen los supuestos el gráfico de residuos vs predichos no tiene que seguir ningún patrón. Independencia: Igual que antes; si el modelo es correcto y se satisfacen los supuestos el gráfico de residuos contra el tiempo no tiene que seguir ningún patrón obvio. Normalidad: Para comprobar esta hipótesis construiremos una gráfica de probabilidad normal de los residuales. Si la distribución fundamental de los errores es normal, esta grafica tendrá la apariencia de una línea recta. Vamos a comprobar cada una de ellas: - Homogeneidad de la varianza: Como vemos el gráfico es bastante aceptable. Por lo que podemos aceptar la hipótesis de homogeneidad. - Independencia: el gráfico de residuos contra el tiempo no sigue tampoco ningún patrón obvio. Luego aceptamos la hipótesis de independencia. 326 - Normalidad: El plot de normalidad tiene una ligera curvatura . Si grabamos los residuos y hacemos el plot de normalidad con ellos, vemos que el test de Shapiro–Wilk nos muestra un p-valor= 0,08 muy próximo 0,05 -> Aceptamos normalidad pero tenemos que tomar los datos con precaución. d) Plantear y contrastar las hipótesis de interés en este problema. Estimar los parámetros de interés. Una vez que hemos demostrado la valided del modelo, pasamos a plantear y contrastar las hipótesis del modelo, que como hemos dicho antes es el siguiente: Por lo que los contrastes de hipótesis que tenemos que hacer son: 1 H0 = στ2 = 0 H1 = στ2 ≠ 0 Para saber si los rollos aportan variabilidad extra a la respuesta: Si στ2 = 0, todos los tratamientos son idénticos; pero si στ2 > 0, existe variabilidad entre los tratamientos. 2 H0 = βj = 0 H1 = βj ≠ 0 Para contrastar si hay diferencias estadísticamente significativas entre los tipos de máquina. H0 = γk(j) = 0 H1 = γk(j) ≠ 0 Para contrastar si hay diferencias estadísticamente significativas entre el número de máquina, dentro de cada tipo de máquina. 4 H0 = στβ2 = 0 H1 = στβ2 ≠ 0 Para saber si la interacción "rollos-tipo de máquina" aporta variabilidad extra a la respuesta. 5 H0 = στγ2 = 0 H1 = στγ2 ≠ 0 Para saber si la interacción "rollos-número de máquina de cada tipo" aporta variabilidad extra a la respuesta. 3 327 Para contrastar estas hipótesis vamos a la tabla ANOVA: 1 2 3 4 5 Vemos que esta tabla nos da los p-valores para todas las hipótesis que pretendíamos contrastar. A la vista de estos datos concluimos que el tipo de máquina y el número de máquina dentro de cada tipo presentan diferencias significativas. En cuanto a los efectos aleatorios, más que su p-valor lo que nos importan es porcentualizar los componentes de la varianza para ver cómo afectan a la respuesta. . Aunque no tiene una relación lineal si vamos a Variance Components vemos que normalmente los que tienen p-valores muy grandes tienen un efecto menor sobre la respuesta (muy bajo o incluso su estimador sale negativo como es este caso). Los que han salido negativos, los consideramos como 0, esto implica que vamos a tener que corregir los estimadores con la ayuda de la siguiente tabla: Ahora tenemos que considerar nulos el "0(1)"y el "0(5)", que son στ2 y στγ2 Con la tabla ya corregida, nos va a resultar más fácil ver cómo sacar estos estimadores. De momento ya sabemos que στ2 y στγ2= 0. El σ no se ve afectado, por lo que sólo nos queda calcular el estimador de σ2τβ σ2τβ = MS(AB) − MS(E) 34352,7 − 15747,2 = 6 6 = 3100,916 = 𝛔𝟐𝛕𝛃 328 Con estos datos ya podemos rehacer la tabla de los componentes de la varianza, que quedaría de la siguiente forma: Source Estimate Rollos 0 Rollos*Tipo de máquina 3100,916 Rollos*Nº máquina(Tipo de máquina) 0 Residual 15747,2 TOTAL 18848,12 Porcentaje 0,00 % 16,45 % 0,00 % 83,55 % Como vemos el 16,5% de la variabilidad de la respuesta es atribuible al tipo de rollo que utilicemos, tenemos que intentar homogeneizar el tipo de rollo usado, siempre y cuando sea posible, para disminuir esta variabilidad. e) Extraer conclusiones desde el punto de vista industrial En lo que respecta al factor aleatorio, ya hemos dicho que convendría armonizar los tipos de rollos. Para analizar los efectos fijos vamos a ver las pruebas de Rango Múltiple. Como podemos ver entre el tipo de máquina si tenemos diferencias tal y como indicaba la tabla ANOVA y la vista de estos resultados nos decantaríamos por la máquina que operar a motor, ya que el objetivo es minimizar el diámetro. f) Explicar y justificar los denominadores de los F-tests. A partir de dos factores, y más aún cuando se trata de modelos mixtos los F-test se complican. Los pseudo f-test lo que hacen es buscar combinaciones lineales de los MS, por ejemplo: MS' = MSr + ...+ MSg MS'' = MSu + ... MSv Estos cuadrados medios se seleccionan de modo que E(MS')- E(MS") sea igual a un múltiplo del efecto (el parámetro del modelo o el componente de la varianza) considerado en la hipótesis nula. Entonces el estadístico de prueba sería: 𝑭= 𝑴𝑺′ 𝑴𝑺" 329 Vamos a verlo para el caso de este problema: 0(6) = σ2 0(5) = στγ2 0(4) = στβ2 0(1) = στ2 1 2 3 4 5 6 Rollos: Como acabamos de decir tenemos que buscar que E(MS') - E(MS") sea múltiplo del efecto que queremos contrastar. Si miramos la tabla esta lo que indica es que: E(MSA) = σ2 + 3*στγ2 + 6*στβ2 +12* στ2 Entonces ahora lo que tenemos que buscar es un E(MS), de forma que restándole al E(MSA) no quedase sólo el 12* στ. ¿Cuál es? -> Vamos a la tabla superior y vemos que sería la fila 4, es decir: E(MS(AB)) = σ2 + 3*στγ2 + 6*στβ2. Como podemos comprobar E(MSA) - E(MS(AB)) = σ2 + 3*στγ2 + 6*στβ2 +12*στ2 -(σ2 + 3*στγ2 + 6*στβ2) = 12* στ2 Entonces el estadístico de esta prueba sería: 𝑀𝑆𝐴 𝐹= 𝑀𝑆(𝐴𝐵) Si a cada una de las filas de la tabla anterior las numeramos, vemos que este denominador sería la fila nº4 (Rollos*Tipo de máquina). Lo cual podemos comprobar con la tabla que nos proporciona Statgraphics: Tipo de máquina: Su esperanza es = E(MSA) = σ2 + 3*στγ2 + 6*στβ2 +Q1 . Las Q son términos del tipo de suma de cuadrados asociados a efectos fijos. Para dejar sólo a este término, de nuevo tendríamos que restarle la fila 4. Entonces el estadístico de esta prueba sería: 𝑀𝑆𝐵 𝐹= 𝑀𝑆(𝐴𝐵) 1 2 3 4 5 6 Si miramos la numeración de las filas vemos que este denominador sería la fila nº4 (Rollos*Tipo de máquina). Los comprobamos con la tabla de Statgraphics: 330 Nº máquina: Su esperanza es: E(MSC) = σ2 + 3*στγ2 + Q2. Para dejar sólo al término Q2 ahora deberíamos restar la fila 5: Rollos*Nº máquina(Tipo de máquina). Entonces el estadístico de esta prueba sería: 𝑀𝑆𝐶(𝐵) 𝐹= 𝑀𝑆(𝐴𝐶(𝐵)) 1 2 3 4 5 6 Rollos * Tipo de máquina: Su esperanza es = E(MSC) = σ2 + 3*στγ2 + 6*στβ 2. Para dejar sólo al término 6*στβ2 deberíamos restar de nuevo la fila 5: Rollos*Nº máquina(Tipo de máquina). Entonces el estadístico de esta prueba sería: 𝑀𝑆𝐴𝐵 𝐹= 𝑀𝑆(𝐴𝐶(𝐵)) 1 2 3 4 5 6 331 Rollos * Tipo de máquina: Su esperanza es = E(MSC) = σ2 + 3*στγ2 + 6*στβ2 . Para dejar sólo al término 6*στβ2 deberíamos restar de nuevo la fila 5: Rollos*Nº máquina(Tipo de máquina). Entonces el estadístico de esta prueba sería: 𝑀𝑆𝐴𝐵 𝐹= 𝑀𝑆(𝐴𝐶(𝐵)) 1 2 3 4 5 6 Rollos * Número de máquina(Tipo de máquina): Su esperanza es = E(MSC) = σ2 + 3*στγ2. Para dejar sólo al término 3*στγ2 deberíamos restar la fila 6: la del residual. Entonces el estadístico de esta prueba sería: 𝑀𝑆(𝐴𝐶(𝐵)) 𝐹= 𝑀𝑆𝐸 1 2 3 4 5 6 332 g) Explicar en qué cambiaría el diseño y el análisis si se dispusiera de muchas máquinas de cada tipo y las utilizadas en el experimento se hubieran elegido al azar. Ahora tendríamos 2 efectos aleatorios (Rollo y nº de máquina) y un efecto fijo (tipo de máquina). El modelo lineal sería el mismo: 1,2 1,2 1,2 1,2,3 Donde µ es el término general, τi es el efecto del rollo i-ésimo, βj es el efecto del tipo de máquina j-ésimo, γk(j) es el efecto del número de máquina k-ésimo dentro del nivel j-ésimo de cada tipo de máquina, (τβ)ij es la interacción rollo-tipo de máquina, (τγ)ik(j) es la rollo-número de máquina dentro de cada tipo y ɛ(ijk)l es el término de error usual. Sin embargo lo que cambiaría son las restricciones: Ahora, τi , γk(j) , (τβ)ij, (τγ)ik(j) y ɛ(ijk)l son variables aleatorias independientes que siguen una distribución normal con media cero y varianzas dadas por V(τi) =στ2, V(γk(j) ) =σγ2, V[(τβ)ij] = στβ2, V[(τγ)ik(j = στγ2 y V(ɛ(ijk)l) = σ2. Por tanto, la varianza de cualquier observación es: V(yijkl) = στ2 + σγ2 + στβ2 + στγ2 + σ2 y στ2, σγ2, στβ2 , στγ2 y σ2 son los componentes de la varianza. En cambio, ahora βj es el único efecto fijo tal que: ∑2𝑗=1 𝛽𝑗 = 0. Es decir, la suma de los efectos del tratamiento B(tipo de máquina) es cero. Además, el único contraste de hipótesis que cambia es: 3 H0 = γk(j) = 0 H1 = γk(j) ≠ 0 3 H0 = σγ2 = 0 H1 = σγ2 ≠ 0 Ahora lo que pretendemos saber es si el nº de máquina aporta variabilidad extra a la respuesta -> si σγ2 = 0, todos los tratamientos son idénticos; pero si σγ2 > 0, existe variabilidad entre los tratamientos. Vamos a pasar a analizar este nuevo modelo, siguiendo los mismos pasos que antes: 1. Efectos fijos: 333 Como vemos el único efecto fijo es el tipo de máquina, que además resulta ser significativo dado que su pvalor es pequeño <0,05. Tenemos que analizar con qué tipo de máquina nos quedaríamos, para ello vamos a las pruebas de rango múltiple. De nuevo nos quedamos con las que funcionan a motor ya que el objetivo es minimizar el diámetro. 2. Efectos aleatorios: Aunque ya hemos dicho que lo que nos importan son los componentes de la varianza, vamos a echar un vistazo a la tabla ANOVA: Vemos que va a haber al menos un componente nulo porque se rompe la progresión de los cuadrados medios (Rollo*Nºmáquina(Tipo de máquina)), ya que estos tienen que tienen que ir de menos a más. Además, aunque no siempre ocurre ni sigue una relación lineal, los componentes con p-valores más bajos suelen tener valores más altos en los componentes de la varianza (como es el caso de Nº máquina(Tipo de máquina)). Si miramos la tabla de Componentes de la Varianza, vemos que tampoco estábamos muy mal encaminados. Con respecto a lo que vaticinábamos, tenemos otro componente negativo además del estimador de στγ2 (Rollo*Nºmáquina(Tipo de máquina)): el estimador de στ2 . Además, como decíamos antes el componente de menor p-valor es el que suele tener mayor peso en los componentes de la varianza. 334 Tenemos que reajustar esta tabla como vimos en el apartado d) y con la ayuda de la tabla de los cuadrados medios esperados (corregida): σ2γ = MS(C(B)) − MS(E) 214108 − 15747,2 = = 33060,13 6 6 σ2τβ = MS(AB) − MS(E) 34352,7 − 15747,2 = = 3100,92 6 6 Source Rollos Nº máquina(Tipo de máquina) Rollos*Tipo de máquina Rollos*Nº máquina(Tipo de máquina) Residual Mean Square 20650,7 214108 34352,7 10520,3 15747,2 Total Estimate 0 33060,13 3100,92 0 15747,2 51908,25 Porcentaje 0% 63,69 % 5,97 % 0% 30,34 % A la vista de los resultados, podríamos decir que casi el 64% de la variabilidad es debida a la máquina que cogemos dentro de cada tipo, por tanto tendremos que estudiar todas estas máquinas ya que hay algunas notablemente mejores que otras; si conseguimos quedarnos sólo con las mejores, o poner a punto las que dan peores resultados podremos mejorar mucho. Los rollo aportan también un 6% de la variabilidad pero esto es bastante pequeño en comparación al número de máquina; no obstante podemos revisarlo e intentar dejar a 0, si es posible, esta variabilidad. 335 PIMIENTOS - 3ª Entrega Beatriz Pérez de Vargas Moreno Para investigar los factores que influyen sobre el grado de picor de los pimientos de Padrón se realizan una serie de pruebas cuyos resultados se recogen en la tabla siguiente. La variable respuesta se mide en una escala de 0 a 3, donde 3 corresponde a los pimientos muy picantes y 0 a los nada picantes. Las pruebas se realizaron en condiciones homogéneas y completamente aleatorizadas. a) Explique el diseño realizado. b) Analizar los datos. c) Explique cómo influyen sobre la respuesta los distintos factores y señale cuáles son significativos al 5%. Haga lo mismo al 10%. Simplifique el modelo dejando los términos significativos al 10%. d) Construya un modelo de regresión para predecir la respuesta en función de los factores. Coméntelo. e) Diga qué valoración media obtendría el picor de un pimiento de tamaño medio, grosor medio y frito en un grado medio. f) Formule un consejo para los consumidores que no deseen padecer las molestias ocasionadas por el picor de los pimientos de Padrón. g) Haga algún comentario general sobre la necesidad de validar los modelos usados en Diseño de Experimentos. h) Diga qué puede observarse en este caso al respecto. a) Explique el diseño realizado. Se están estudiando tres factores de interés: Tamaño, Grosor y Grado de fritura de los pimientos. A este modelo se lo conocer como diseño factorial 23. Como vemos en esta tabla tenemos 8 combinaciones y hemos hecho 6 réplicas para cada una de estas combinaciones, utilizando la notación “+” y “-“ para representar los niveles alto y bajo de los factores. Factores codificados Corrida 1 2 3 4 5 6 7 8 A -1 1 -1 1 -1 1 -1 1 B -1 -1 1 1 -1 -1 1 1 C -1 -1 -1 -1 1 1 1 1 Picor Rep. 1 1 3 2 2 1 2 0 0 Rep. 2 1 2 1 2 0 1 1 2 Rep. 3 2 3 0 2 1 2 0 0 Rep. 4 0 2 0 1 1 1 0 1 Rep. 5 1 3 0 1 0 3 0 1 Rep. 6 1 3 0 2 0 2 1 0 336 Niveles del factor A = Tamaño B = Grosor C = Grado de fritura Bajo (-1) Pequeño Delgado Poco frito Alto (+1) Grande Gordo Muy frito En general para cualquier modelo vamos a tener (2k-1 efectos), por lo que en este caso nos encontramos con 7 efectos (23 -1) A B (𝑘1) Efectos principales: C AB AC (𝑘2) Interacciones dobles BC ABC (𝑘) Interacciones triples 3 b) Analizar los datos. Previo a realizar este análisis de datos hemos contrastado que el factor bloque carecía de interés, ya que su p-valor era grande, por lo que en lo que sigue de problema ignoraremos el factor bloque. Para analizar los datos, lo primero que tenemos que hacer es estimar los efectos de los factores. Como ya hemos comentado se trata de un diseño de orden 3, para el cual tenemos el siguiente diagrama de Pareto: 337 Se trata de un diagrama de Pareto bastante parsimonioso, no tenemos un corte claro de efectos principales y efectos irrelevantes. Lo ideal es tener unos pocos efectos muy significativos y otros que no lo sean, así a la hora de purgar y analizar el modelo nos resulta más fácil. Por suerte, el modelo está gobernado por los efectos principales: la naturaleza normalmente es generosa, no nos lo pone difícil: la mayoría de los sistemas están dominados por efectos de órdenes bajos como en este caso. Vemos que domina el factor A (tamaño), con carácter positivo, seguido del factor B (Grosor) y C (grado de fritura) ambos con carácter negativo. Es decir, lo más influyente en el picor de los pimientos es su tamaño, siendo los pimientos más grandes los que más harán sufrir a nuestras papilas gustativas. c) Explique cómo influyen sobre la respuesta los distintos factores y señale cuáles son significativos al 5%. Haga lo mismo al 10%. Simplifique el modelo dejando los términos significativos al 10%. Como ya hemos visto el factor A (Tamaño) incide de manera positiva en la respuesta; es decir, a mayor tamaño, mayor picor. En tanto, que los factores B (Grosor) y C (Grado de fritura) lo hacen de manera negativa: cuanto más gruesos y más fritos estén los pimientos menos picantes estarán. En cuanto a que factores son significativos: - Al 5%, tenemos 3 factores significativos: A, B y C. Esto lo podemos ver tanto en la tabla ANOVA (los efectos significativos serán aquellos cuyo p-valor sea < 0,05) como en el diagrama de Pareto, siendo los efectos significativos los que superan la línea de significación (línea azul). 338 - Al 10%, si miramos la tabla ANOVA anterior nos quedaríamos con los 3 factores principales y la interacción AB, ya que se p-valor es < 0,1. Cosa que podemos ver de nuevo en el diagrama de Pareto cambiando en las opciones de panel el α a 10% El enunciado nos dice que nos quedemos con los efectos significativos al 10% por lo que pasamos a depurar el modelo, dejando únicamente los 3 factores principales y la interacción AB. **Una vez que tenemos el modelo final, tendríamos que validar el modelo antes de continuar. En este problema esta validación la tenemos en el apartado h). d) Construya un modelo de regresión para predecir la respuesta en función de los factores. Coméntelo. El modelo de regresión será: Donde las variables codificadas x1,x2 y x3 representan a A, B y C respectivamente. El término x1x2 es la interacción AB. 339 Para conocer el valor de estos estimadores, sabemos que: β̂0 = µ β̂1 = (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴) 2 β̂2 = (𝐸𝑓𝑒𝑐𝑡𝑜 𝐵) 2 β̂12 = (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴𝐵) 2 ¿Cuál es el valor de estos efectos? Para calcularlos vamos a ayudarnos del cubo que representa las ocho combinaciones de tratamientos. Las combinaciones de los tratamientos en orden estándar se escriben como (1), a, b, ab, c, ac, bc y abc. Además estos símbolos representan también el total de las n observaciones hechas con esa combinación de tratamientos en particular. Factores codificados Picor Corrida A B C Rep. 1 Rep. 2 Rep. 3 Rep. 4 Rep. 5 Rep. 6 Etiquetas 1 2 3 4 5 6 7 8 -1 1 -1 1 -1 1 -1 1 -1 -1 1 1 -1 -1 1 1 -1 -1 -1 -1 1 1 1 1 1 3 2 2 1 2 0 0 1 2 1 2 0 1 1 2 2 3 0 2 1 2 0 0 0 2 0 1 1 1 0 1 1 3 0 1 0 3 0 1 1 3 0 2 0 2 1 0 (1) a b ab c ac bc abc Total Valor = ∑ 𝑹𝒆𝒑 6 16 3 10 3 11 2 4 55 340 - Factor A: Para calcula el efecto de A, sabemos que el efecto de A cuando B y C están en el nivel bajo es [a - (1)]/n. De manera similar, el efecto de A cuando B está en el nivel alto y C está en el nivel bajo es [ab -b]/n. El efecto de A cuando C está en el nivel alto y B está en el nivel bajo es [ac -c]/n. Por último, el efecto de A cuando tanto B como e están en el nivel alto es [abc -bc]/n. Por lo tanto, el efecto promedio de A es sólo el promedio de estos cuatro efectos, o: Esta ecuación también puede desarrollarse como un contraste entre las 4 combinaciones de tratamientos de la cara derecha del cubo que vemos en la imagen. Es decir, el efecto de A es sólo el promedio de las cuatro corridas donde A está en el nivel alto (YA+) menos el promedio de las cuatro corridas donde A está en el nivel bajo (YA-): En definitiva: 1 1 [𝑎 − (1) + 𝑎𝑏 − 𝑏 + 𝑎𝑐 − 𝑐 + 𝑎𝑏𝑐 − 𝑏] = [16 − 6 + 10 − 3 + 11 − 3 + 4 − 2] 𝐴= 4𝑛 4∗6 1 [27] = 1,125 = 4∗6 Por consiguiente: (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴) 2 - = β̂1 = 0,5625 Factor B: De manera similar, el efecto de B es la diferencia en los promedios entre las cuatro combinaciones de tratamientos de la cara frontal del cubo y las cuatro de la cara posterior. 𝐵= 1 1 [𝑏 + 𝑎𝑏 + 𝑏𝑐 + 𝑎𝑏𝑐 − (1) − 𝑎 − 𝑎 − 𝑎𝑐] = [3 + 10 + 2 + 4 − 6 − 16 − 3 − 11] 4𝑛 4∗6 1 [−17] = −0,7083 = 4∗6 Por consiguiente: (𝐸𝑓𝑒𝑐𝑡𝑜 𝐵) 2 = β̂2 = −0,3541 341 - Factor C: es la diferencia en los promedios entre las cuatro combinaciones de tratamientos de la cara superior del cubo y las cuatro de la cara inferior, es decir: 1 1 𝐶 = 4𝑛 [𝑐 + 𝑎𝑐 + 𝑏𝑐 + 𝑎𝑏𝑐 − (1) − 𝑎 − 𝑎 − 𝑎𝑏] = 4∗6 [3 + 11 + 2 + 4 − 6 − 16 − 3 − 1 10] = 4∗6 [−15] = −0,625 → - (𝐸𝑓𝑒𝑐𝑡𝑜 𝐶) 2 = β̂3 = −0,3125 Interacción AB: Una medida de la interacción AB es la diferencia entre los efectos promedio de A con los dos niveles de B. Por convención, a la mitad de esta diferencia se le llama la interacción AB. Utilizando símbolos: Puesto que la interacción AB es la mitad de esta diferencia: Así: 𝐴𝐵 = 1 1 4𝑛 [𝑎𝑏𝑐 − 𝑏𝑐 + 𝑎𝑏 − 𝑏 − 𝑎𝑐 − 𝑎 + (1)] = 6] = 4∗6 [−9] = −0,375 → - (𝐸𝑓𝑒𝑐𝑡𝑜 𝐴𝐵) 2 1 4∗6 [4 − 2 + 10 − 3 − 11 + 3 − 16 + = β̂12 = −0,1875 ̂ 0 que es igual a la Constante: Tan sólo nos quedaría calcular la constante del modelo de regresión β media, es decir: 55 55 β̂0 = 8 𝑐𝑜𝑟𝑟𝑖𝑑𝑎𝑠∗6𝑟é𝑝𝑙𝑖𝑐𝑎𝑠 = 48 = 1,14583 = β̂0 Podemos comprobar tanto el valor de los efectos como de los coeficientes de la regresión en los paneles de Statgraphics: %2 342 Ya tendríamos entonces nuestro modelo de regresión: En el cual vemos que el factor A, como ya sabíamos es el más importante y tiende a aumentar la respuesta. Este factor está seguido de los factores B y C, cuyo efecto es bastante parecido, además ambos minimizan la respuesta; es decir, cuanto mayor sea el nivel de estos factores menor será el picor producido por los pimientos, lo mismo que ocurre con la interacción AB, la cual es la menor en orden de magnitud, en torno a 1/3 del efecto de A. e) Diga qué valoración media obtendría el picor de un pimiento de tamaño medio, grosor medio y frito en un grado medio. Nos vamos a libro de datos y en la última fila (en nuestro caso fila 49) escribimos 0 en cada uno de los factores, ya que el 0 sería el valor medio entre el nivel alto (+1) y el valor bajo (-1). Si vamos a la tabla de los valores estimados vemos que la respuesta predicha para este un pimiento de estas características es de: 1,14583. Teniendo en cuenta que la escala es 0 para nada picante y 3 para muy picante, si usted padece intolerancia al picante será mejor que no compre pimientos de tamaño y grosor medio. Además ha de preocupar dejarlos bien fritos. f) Formule un consejo para los consumidores que no deseen padecer las molestias ocasionadas por el picor de los pimientos de Padrón. 343 A la vista del diagrama de Pareto está claro que si lo que queremos es minimizar el picor, el factor A (tamaño) debe estar en el nivel bajo para contrarrestar su efecto positivo; es decir, buscaremos pimientos pequeños. Los otros dos factores, el B (Grosor) y el C (grado de fritura) al ser de carácter negativo nos interesa que estén en el alto de forma que sigan minimizando la respuesta: pimientos gruesos y bien fritos. La interacción AB va a ir en contra de la minimización, debido a que el factor A está en el nivel “-1” y B en el “+1” su interacción será negativa (“-1”) pero al ser ésta interacción de carácter negativo su comportamiento será positivo (-1)*(-1)= +1 y por tanto aumentará la respuesta. Sin embargo nos interesa más sacrificar el signo de la interacción que el de cualquier otro factor, debido a que de los 4 este es el que tiene una influencia menor en la respuesta. En definitiva, si no deseamos padecer molestias por el picor de los pimientos debemos comprarlos pequeños, gruesos y freírlos mucho. Si bien es verdad, que esto no nos va a garantizar la nulidad del picor que experimentemos en nuestra boca, dado que como vemos en el panel de optimización de Statgraphics el valor optimo esperado no es 0. Además podemos ver como va aumentando el picor en función del nivel que tomen cada uno de los factores en la siguiente gráfica: En la que de nuevo podemos comprobar que los valores más bajos de picor se encuentran en la zona azul oscura. Es decir, pimientos pequeños, gruesos y bien fritos. g) Haga algún comentario general sobre la necesidad de validar los modelos usados en Diseño de Experimentos. Antes de tomar cualquier decisión es necesario que validemos el modelo; es decir, tenemos que probar formalmente que no hay diferencias en las medias de los tratamientos. En particular, se requiere que se satisfagan ciertos supuestos. Estos supuestos son que el modelo: 344 Describe de manera adecuada las observaciones, y que los errores siguen una distribución normal e independiente con media cero y varianza σ2 constante pero desconocida. Si estos supuestos se satisfacen, el procedimiento del análisis de varianza es una prueba exacta de la hipótesis de que no hay diferencias en las medias de los tratamientos. Por el contrario, no es prudente confiar en el análisis de varianza hasta haber verificado estos supuestos. Las violaciones de los supuestos básicos y la adecuación del modelo pueden investigarse con facilidad mediante el examen de los residuales. Si el modelo es adecuado, los residuales deberán estar sin estructura; es decir, no deberán contener patrones obvios. h) Diga qué puede observarse en este caso al respecto. Vamos a verificar la validez del modelo, para ello, como acabamos de comentar tenemos que comprobar si los residuales no siguen ningún patrón obvio. 345 346 Como vemos ningún gráfico muestra patrones obvios. El único del que podemos dudar es del plot de normalidad el cual presenta cierta curvatura. Si grabamos los residuos y hacemos el plot de normalidad con ellos, vemos que el test de Shapiro–Wilk nos muestra un p-valor= 0,0656 muy próximo 0,05 -> Aceptamos normalidad pero tenemos que tomar los datos con precaución. Por tanto, podemos aceptar la validez del modelo. 347