Concepto de informática

Anuncio

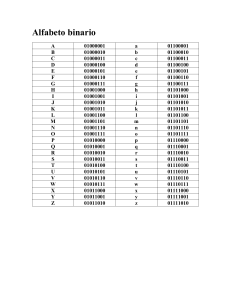

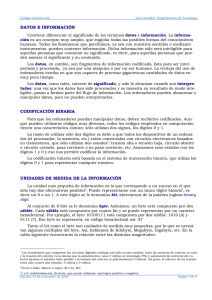

Trabajo de informática INFORMÁTICA Concepto de informática La informática es la ciencia que estudia los ordenadores. El concepto de informática viene dado de la unión de dos palabras Información y automática. En inglés se habla de conceptos tales como Computer Science, Electronic Data Processing, etc.. Procesamiento de la información La concepción del humano como un procesador de información se basa en la analogía entre la mente humana y el funcionamiento de una computadora. En otras palabras, se adoptan los programas informáticos como metáfora del funcionamiento cognitivo humano. Existen pues dos versiones de esta metáfora: 1. Versión fuerte: admite una equivalencia funcional de ambos sistemas. 2. Versión débil: se limita a aceptar el vocabulario de la informática sin llega a aceptar una equivalencia. Sistemas Informáticos: HARDWARE Y SOFTWARE Un sistema informático es la síntesis de hardware y software. Un sistema informático típico emplea un ordenador que usa dispositivos programables para almacenar, recuperar y procesar datos. HARDWARE: Se denomina hardware o soporte físico al conjunto de elementos materiales que componen un computador. Hardware también son los componentes físicos de una computadora tales como el disco duro, dispositivo de CD-Rom, disquetera, etc.. En dicho conjunto se incluyen los dispositivos electrónicos y electromecánicos, circuitos, cables, tarjetas, armarios o cajas, periféricos de todo tipo y otros elementos físicos. El hardware se refiere a todos los componentes físicos (que se pueden tocar) de la computadora: discos, unidades de disco, monitor, teclado, ratón, impresora, placas, chips y demás periféricos. Marta Martín Lobato 1 Trabajo de informática SOFTWARE: Se denomina software (también programática, equipamiento lógico o soporte lógico) a todos los componentes intangibles de un ordenador o computadora, es decir, al conjunto de programas y procedimientos necesarios para hacer posible la realización de una tarea específica, en contraposición a los componentes físicos del sistema (hardware). Esto incluye aplicaciones informáticas tales como un procesador de textos, que permite al usuario realizar una tarea, y software de sistema como un sistema operativo, que permite al resto de programas funcionar adecuadamente, facilitando la interacción con los componentes físicos y el resto de aplicaciones. Codificación de la información Código binario El proceso de hacer corresponder a cada símbolo del alfabeto fuente el código se llama codificación. Al proceso contrario Decodificación. Propiedades - Un código binario es ponderado cuando a cada dígito binario, le corresponde un peso según su posición. - Distancia del código es la distancia menor (diferencia de bits). - Un código continuo es que dos palabras código consecutivas son adyacentes. Ej. Códigos Gray o Johnson" - Código cíclico aquel que además de ser continuo, la primera palabra y la última también lo son. - En informática y en electrónica se han empleado a lo largo del tiempo códigos binarios, entre ellos BCD (con las variantes Natural, Aiken y Exceso 3) y Gray, códigos escritos puramente en binario pero usando otras reglas. Los códigos binarios que se utilizan en los sistemas digitales para almacenar información, hacer operaciones aritméticas, reparar errores... Los códigos binario pueden ser numéricos o alfanuméricos, dependiendo de si sólo codifican números o caracteres (incluidos números), respectivamente. Marta Martín Lobato 2 Trabajo de informática El código binario de un programa, denominado código máquina es una codificación en sistema binario que es el único que puede ser directamente ejecutado por un ordenador. Sin embargo, para los seres humanos, programar en código máquina es molesto y propenso a errores. Incluso con la abreviatura octal o hexadecimal, es fácil confundir una cifra con otra y trabajoso acordarse del código de operación de cada una de las instrucciones de la máquina. Por esa razón se inventaron los lenguajes simbólicos o nemónicos, que se llaman así porque utilizan símbolos para representar o recordar las operaciones a realizar por cada instrucción y las direcciones de memoria sobre las que actúa. El código ASCII El código ASCII (acrónimo inglés de American Standard Code for Information Interchange — Código Estadounidense Estándar para el Intercambio de Información), pronunciado generalmente [áski], es un código de caracteres basado en el alfabeto latino tal como se usa en inglés moderno y en otras lenguas occidentales. Fue creado en 1963 por el Comité Estadounidense de Estándares (ASA, conocido desde 1969 como el Instituto Estadounidense de Estándares Nacionales, o ANSI) como una refundición o evolución de los conjuntos de códigos utilizados entonces en telegrafía. Más tarde, en 1967, se incluyeron las minúsculas, y se redefinieron algunos códigos de control para formar el código conocido como US-ASCII. El código ASCII utiliza 7 bits para representar los caracteres, aunque inicialmente empleaba un bit adicional (bit de paridad) que se usaba para detectar errores en la transmisión. A menudo se llama incorrectamente ASCII a otros códigos de caracteres de 8 bits, como el estándar ISO8859-1 que es una extensión que utiliza 8 bits para proporcionar caracteres adicionales usados en idiomas distintos al inglés, como el español. ASCII fue publicado como estándar por primera vez en 1967 y fue actualizado por última vez en 1986. En la actualidad define códigos para 33 caracteres no imprimibles, de los cuales la mayoría son caracteres de control obsoletos que tienen efecto sobre como se procesa el texto, más otros 95 caracteres imprimibles que les siguen en la numeración (empezando por el carácter espacio). Marta Martín Lobato 3 Trabajo de informática Casi todos los sistemas informáticos actuales utilizan el código ASCII o una extensión compatible para representar textos y para el control de dispositivos que manejan texto. Unidades de medida en informática Como sabemos, el sistema binario (binary) es un sistema de numeración que tiene por base el 2 Utiliza sólo dos guarismos: "0" (cero) y "1" (uno) para representar cualquier información. Los ordenadores utilizan el sistema binario porque no conocen -no pueden interpretar- más que dos estados: pasa la corriente (“on”, “abierto”, ó “1”) o no pasa la corriente (“off”, “cerrado” ó, “0”). De esta forma un ordenador sí que pueden manejar y almacenar la información. El BIT y el BYTE La unidad más pequeña de información representable en el ordenador se llama bit. Bit significa dígito binario (del ingles "binari digit") y sólo puede tomar dos valores: el 0 y el 1. El conjunto de cuatro bits se denomina cuarteto. En los ordenadores, para transmitir la información se utilizan grupos de 8 bits. A cada grupo de 8 bits se le llama byte. El byte es, por tanto la agrupación más utilizada en informática Cada vez que se pulsa una tecla llega la unidad central una serie de impulsos eléctricos que equivale a una combinación de 8 bits, es decir 1 byte. Así la letra "A" llega a la Unidad Central como la combinación de 8 bits: 01000001 El tamaño que posee la memoria de un ordenador normalmente se mide en Kilobytes (KB= 210=1.024 bytes), aunque también se mide en Megabytes (MB= 220=1.048.576 bytes=1.024 kilobytes). Un Megabyte puede almacenar más de un millón de caracteres. Con el aumento de las capacidades de las memorias, también se emplea la medida del Gibabyte (GB=230=1.073.741.824 bytes=1.024 Megabytes) Marta Martín Lobato 4 Trabajo de informática Unidad Abrev. Se habla de bit bits Byte bytes 1 kiloByte KB kas 1 MegaByte MB megas 1 Gigabyte GB gigas 1024 MB (1.073.741.824 bytes) 1 Terabyte TB teras 1024 GB (un billón de bytes) 1 Bit 1 Byte Representa unidad mínima conjunto de 8 bits 1024 Bytes 1024 KB (1.048.576 bytes) Marta Martín Lobato 5