Lenguas artificiales - Código binario

Anuncio

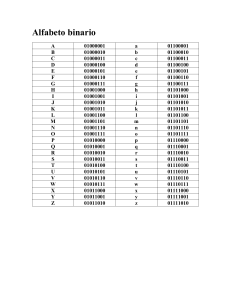

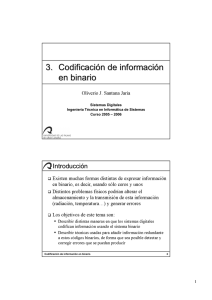

ASIGNATURA: LINGÜÍSTICA GENERAL PROFESORA: ELENA GARAYZÁBAL Tema: Lenguas artificiales - Código binario Grupo de trabajo: Bilyana Aleksieva, Alberto Gómez, Carmen Mendoza, Spela Jenko, Sergio Villanueva 9 de Marzo de 2012 INTRODUCCIÓN GENERAL El código binario es un método de representación de textos o procesadores de instrucciones de ordenador utilizando el sistema binario, un sistema numérico que se basa en la alternancia progresiva y sucesiva de dos dígitos o bit como son el "0" y el “1”. Por ello, estaríamos hablando de un código intermedio propio de un sistema que no es lingüístico, sino lógico-matemático. En ese sentido, aunque no es una lengua en sentido estricto, sí es un sistema de comunicación y transmisión de la información a través del desarrollo de códigos matemáticos y principios de lógica formal que permite desarrollar un volumen de significado suficiente para interpretarlo desde cada una de las lenguas y, recientemente, entre las propias lenguas a través de códigos de traducción existentes entre ellas. De hecho, a nivel universal el número 1" posee un significado de abierto o verdadero y el “0” posee un significado de cerrado o de falso. Del mismo modo, podemos afirmar que posee un sentido artificial basado en las elaboraciones teóricas llevadas a cabo por Shannon desde 1930, que ha sido la base de lo que podríamos denominar “mensaje automático de las máquinas”, y que les habilita para realizar acciones programadas por las personas y desarrolla principios interpretables de manera universal. Dicho proceso es asimilado a los mecanismos de actuación de nuestro cerebro, ya que la sistematización que se lleva a cabo depende del método de adaptación propuesto, un punto que tiende a destacar la psicología funcionalista actual. En ese sentido, posee una complejidad muy grande que sin estructurar la comunicación como las lenguas al uso, sí establece una serie de códigos que concretan y corrigen un sistema de transmisión de información con carácter universal (esto es, comprensible en cualquier circunstancia cuando parte de sus propia codificación). Actualmente, se ha llegado a establecer una teoría de la comunicación matemática que constituye una nueva fase de integración de este modelo dentro del paradigma de la comunicación humana universal. 1. ORIGEN E HISTORIA DEL SISTEMA BINARIO Se podría pensar que el origen del sistema binario esta ligado a la invención de la computadora, pero esto no es así ya que el origen del sistema binario data del s III a.C. cuando el matemático hindú Pingala aportó sus tres características esenciales: decimal, cifrado y posicional (auxiliándose de la palabra sunya [vacío] para representar al cero). Esta peculiaridad es debida a que el sistema binario no nació de la informática, sino de los cálculos matemáticos. Existen analogías en China como el antiguo texto I Ching que contiene 8 trigramas y 64 hexagramas (estructura idéntica a 3 bit) y se conocían números de hasta 6 bit. El sistema binario también fue usado en geomancia medieval y se sabe que algunas tribus africanas transmiten sus adivinanzas en binario. El sistema binario fue tratado por varios filósofos como Francis Bacon en 1605, que defendía la idea de expresar las letras en binario, o Leibniz que explicó el funcionamiento de este sistema en su Explication de l'Arithmétique Binaire. En 1854, el matemático británico George Boole publicó un artículo que marcó un antes y un después, detallando un sistema de lógica que terminaría denominándose álgebra de Boole. Dicho sistema desempeñaría un papel fundamental en el desarrollo del sistema binario actual, particularmente en el desarrollo de circuitos electrónicos. El álgebra de Boole inspiró a Claude Shannon en su tesis Un Análisis Simbólico de Circuitos Conmutadores y Relés, considerada la fundadora del diseño práctico del circuito digital. Gracias a esta tesis Shannon consiguió el Premio a ingenieros americanos del Instituto Americano Alfred Nobel en 1940 y pasó quince años en los laboratorios Bell, que le permitió una asociación muy fructífera con muchos matemáticos y científicos de primera línea como Harry Nyquist, Walter Houser Brattain, John Bardeen y William Bradford Shockley, inventores del transistor; George Stirbitz y Warren Weaver, quien le ayudó en muchos de sus trabajos, como en su The Mathematical Theory of Communication, publicado en 1948. Durante este periodo Shannon estudió diversas áreas, siendo la más productiva la que concernía a la teoría de la información. En 1937 George Stibitz incluyó en su computadora Modelo K el sistema binario para realizar cálculos, gracias a esto los Laboratorios Bell (lugar donde trabajaba Stibitz) financiaron un complejo programa de investigación a finales de 1938, poniendo a Stibitz al mando del equipo. En 1940 terminaron el diseño de una “Calculadora de números complejos”. Dicho invento fue presentado ante la Sociedad Americana de Matemáticas. Stirbitz consiguió enviar comandos de manera remota a la Calculadora de Números Complejos a través de la línea telefónica mediante un teletipo. Fue la primera máquina computadora utilizada de manera remota a través de la línea de teléfono. 3. EL BYTE COMO UNIDAD CUANTITATIVA DE REFERENCIA Es la unidad fundamental de medida para la memoria matemática, principalmente de los ordenadores, siendo su unidad el equivalente a un carácter. Se usa como unidad básica de almacenamiento de datos en combinación con los prefijos de cantidad. Un byte son ocho bits contiguos, cuyo tamaño depende del código de información o código de caracteres en que sea definido. La palabra proviene de inglés y equivale a octeto (es decir a ocho bits). El término lo propuso Werner Buchholz en 1957, por el desarrollo de la computadora IBM 7030 Stretch. En un principio, byte se utilizaba para mencionar las instrucciones de 4 bits, que permitían la inclusión de entre uno y dieciséis bits por byte. Después el diseño de producción redujo el byte hasta campos de 3 bits, lo que permitió entre uno y ocho bits en un byte. Un poco más tarde 8 bits se declaró como un estándar a partir de IBM S/360. La unidad byte no tiene símbolo establecido internacionalmente, aunque en países anglosajones es frecuente la "B" mayúscula, mientras que en los francófonos es la "o" minúscula (de octet). El término "octeto" se utiliza ampliamente como un sinónimo preciso donde la ambigüedad es indeseable (por ejemplo, en definiciones de protocolos). Los ordenadores son construidos sobre todo en números binarios, así que los bytes se cuentan en potencias de dos (que es por lo que alguna gente prefiere llamar los grupos de ocho bits octetos). 3. TIPOS DE CÓDIGOS DE REPRESENTACIÓN 1) Códigos numéricos. Se utilizan cuando no se emplea el código binario natural para tratar la información numérica. Se dividen en: - Códigos BCD: permiten la representación de dígitos decimales a través de 4 bits. Es la conversión más sencilla decimal – binaria. - Códigos BCD autocomplementarios: se obtienen a partir del código BCD natural. 2) Código Gray. También denominado autorreflejado o cíclico. Es no ponderado y sus códigos paradígitos decimales sucesivos difieren en un sólo bit. El código Gray se puede: - Pasar a binario. - Aplicar a sensores ópticos: se emplea para codificar la posición (angular o lineal) mediante discos o cintas codificadas en Gray, dependiendo del caso. 3) Códigos alfanuméricos. El más generalizado en la actualidad es el denominado ASCII (American Standard Code for Information Interchange). Este es un código de 7 bit. (imagen 1) Un tipo de estos códigos es: - Código de siete segmentos: consiste en el arreglo de siete indicadores luminosos (LED’s) u ópacos (cristal líquido). Mediante displays se sucede la representación de información de tipo numérico. (imágenes 2 y 3). 3.1 Códigos de detección y corrección de errores A veces, se pueden producir errores por polvo en las cabezas lectoras de una unidad de disco o por la incorrecta transmisión de datos a distancia. La información que se transmite por modem, es decir, a través de línea telefónica, por lo tanto tambíen pueden recibirse incorrectamente si la línea tiene ruidos. Las perturbaciones en el suministro de energía eléctrica pueden ser fuentes de alteraciones. Así, entre los códigos para detección y corrección de errores podemos citar: 1) Transmisión en paralelo y en serie Existen dos métodos básicos: - Transmisión de datos digitales en paralelo: se utiliza a distancias reducidas. Ocupa una línea física por cada bit de los datos a enviar. (imagen 4) - Transmisión en serie: se emplea a distancias grandes. Las líneas físicas son menos necesarias. (imagen 5). 2) Código de paridad Consiste en añadir un bit de paridad (p) a cada carácter, normalmente en la posición más significativa. Es ampliamente utilizado, ya que se caracteriza por una secillez. (imagen 6) 3) Código de Hamming Se llama así por el nombre de su creador. Richard Hamming lo idea. Este código detecta y corrige los errores. En él se añaden k bits de paridad a un carácter de n bits, formando un nuevo carácter de n + k bits. Los bits se enumeran empezando por 1, no por 0, siendo el bit 1, el de la izquierda, el más significativo. Todo bit cuyo número sea potencia de 2 es un bit de paridad y todos los demás se utilizan para datos. 4. LA TEORÍA DE LA INFORMACIÓN Shannon y Weaver elaboran su fórmula de cinco elementos y lanzan una teoría matemática de la comunicación en 1948, casi al mismo tiempo que Laswell. Más que un modelo de comunicación se trata de una teoría de la información pensada en función de la cibernética, siendo esta el estudio del funcionamiento de las máquinas, especialmente las electrónicas. Cuando Shannon habla de información, se trata de un sentido totalmente diferente del que nosotros le atribuimos generalmente (noticias de prensa, radio y TV). Para él se trata de una unidad cuantificable que no tiene en cuenta el contenido del mensaje. Podemos decir que el modelo de Shannon se aplica entonces a cualquier mensaje, independientemente de su significación. Esta teoría nos permite estudiar la cantidad de información de un mensaje en función de la capacidad del medio. Según el sistema binario esta capacidad se mide (dos posibilidades 0 o 1) en bites asociados a la velocidad de transmisión del mensaje, pudiendo esta velocidad ser disminuida por el ruido. El modelo de Shannon se representa por un esquema compuesto de cinco elementos que son la fuente, el transmisor, el canal, el receptor y el destino. Dentro de este modelo incluimos el ruido, que aporta una cierta perturbación. La fuente es el elemento emisor inicial del proceso de comunicación, que produce un cierto número de palabras o signos que forman el mensaje a transmitir. El segundo elemento de este modelo es el transmisor que es, a su vez, el emisor técnico. Transforma el mensaje emitido en un conjunto de señales o códigos que serán adecuados al canal encargado de transmitirlos. Como tercer modelo tenemos al canal, que es el medio técnico que debe transportar las señales codificadas por el transmisor. La actividad inversa a la del transmisor y la fuente la realizarían el receptor (o receptor técnico) y el destinatario a través de un canal común. El receptor desarrolla la cuarta función, que consiste en decodificar el mensaje transmitido y vehiculizado por el canal, para transcribirlo en un lenguaje que sea comprendido por el verdadero receptor, que es llamado destinatario y constituye el quinto elemento. Como sexto y último elemento tenemos al ruido; es un elemento que parasita en diverso grado la señal durante su transmisión, como la ``nieve´´ en la pantalla de TV. En el plano visual puede ser una mancha sobre la pantalla. Debemos considerar también el ruido no técnico, esto es, aquel que proviene del contexto psicosocial. Todos los elementos procedentes son considerados como ruidos que pueden, entonces, provenir del canal, del emisor, o del receptor, del mensaje, etc.