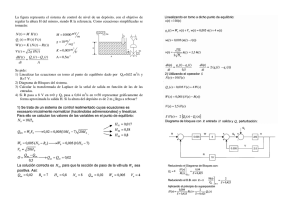

Apuntes de Transformadas y Ecuaciones Jose S. Cánovas Peña 1 de junio de 2012 Índice General Advertencia. Estos apuntes no han sido corregidos. Cualquier errata o error que se detecte, por favor, escribid a mi dirección [email protected], para que en un futuro se pueda subsanar. No son los apuntes de la asignatura. Son una guía que no tiene porqué corresponderse al cien por cien con lo explicado en clase. ∗ Se ha utilizado el símbolo = para denotar un paso en alguna demostración que, siendo cierto, no está bien justificado. Normalmente cuando se trata de permuta de límites, como una integral con un sumatorio. Para un estudio de las pruebas rigurosas al cien por cien nos remitimos a la bibliografía al final de estas notas. i Índice General ii Índice general 1. Transformada de Laplace 1.1. Introducción . . . . . . . . . . . . . . . . . . . . . . 1.2. Funciones continuas a trozos. Función de Heaviside 1.3. Definición de Transformada de Laplace . . . . . . . 1.3.1. Definición y primeros ejemplos . . . . . . . . 1.3.2. Dominio de definición de la Transformada de 1.4. Propiedades de la Transformada de Laplace . . . . 1.4.1. Linealidad . . . . . . . . . . . . . . . . . . . 1.4.2. Transformada de la derivada . . . . . . . . . 1.4.3. Transformada de la integral . . . . . . . . . 1.4.4. Transformada de la convolución . . . . . . . 1.4.5. Primer Teorema de Traslación . . . . . . . . 1.4.6. Segundo Teorema de Traslación . . . . . . . 1.5. Propiedades de la función Transformada de Laplace 1.5.1. Derivabilidad de la Transformada de Laplace 1.5.2. Teoremas del valor inicial . . . . . . . . . . 1.5.3. Teorema del valor final . . . . . . . . . . . . 1.6. Transformada de Laplace inversa . . . . . . . . . . 1.6.1. Inyectividad de la Transformada de Laplace 1.6.2. Transformada de Laplace inversa . . . . . . 1.6.3. Fórmula de inversión compleja . . . . . . . . 1.7. Aplicaciones: una primera aproximación . . . . . . 1.8. Uso de la convolución . . . . . . . . . . . . . . . . . 1.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Laplace . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2. Estabilidad de ecuaciones diferenciales 2.1. Ecuaciones y sistemas lineales: generalidades . . . . . . . . . 2.1.1. Sistemas de ecuaciones diferenciales lineales . . . . . 2.1.2. Teoría general para ecuaciones lineales de orden . . 2.2. Resolución desistemas lineales de coeficientes constantes . . . 2.2.1. Resolución del sistema homogéneo . . . . . . . . . . . 2.2.2. Resolución de sistemas. La exponencial de una matriz 2.2.3. El método de variación de constantes . . . . . . . . . 2.3. Resolviendo sistemas mediante la transformada de Laplace . 2.4. Problemas con funciones discontinuas . . . . . . . . . . . . . iii . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1 1 3 4 4 6 7 7 9 10 10 11 12 13 13 14 15 15 15 16 17 19 19 20 . . . . . . . . . 25 25 27 32 35 35 37 43 44 46 Índice General 2.5. Sistemas autónomos, puntos críticos y noción de estabilidad . . . . . . . . . . 2.6. Estabilidad de sistemas lineales . . . . . . . . . . . . . . . . . . . . . . . . . . 2.6.1. ¿Por qué un sistema estable es útil en ingeniería? . . . . . . . . . . . . 2.7. Funciones de transferencia. Estabilidad y control de sistemas lineales . . . . . 2.8. Estabilidad local de sistemas autónomos . . . . . . . . . . . . . . . . . . . . . 2.8.1. Método de linealización de Lyapunov. Teorema de Hartman—Grobman 2.8.2. El método directo de Lyapunov . . . . . . . . . . . . . . . . . . . . . . 2.9. Ejercicios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3. Ecuaciones en derivadas parciales 3.1. Introducción a las EDP . . . . . . . . . . 3.2. Ecuaciones de orden uno? . . . . . . . . 3.3. Ecuaciones lineales de orden 2 . . . . . . 3.4. Ecuación del calor. Método de separación 3.5. Series de Fourier . . . . . . . . . . . . . 3.5.1. Funciones pares e impares . . . . 3.5.2. Aplicación a la ecuación del calor 3.6. Ecuación de ondas . . . . . . . . . . . . 3.7. Ecuación de Laplace . . . . . . . . . . . 3.8. Problemas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . de variables. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4. Transformada de Fourier 4.1. Definición y primeros ejemplos . . . . . . . . . . . 4.2. Propiedades básicas . . . . . . . . . . . . . . . . . 4.2.1. Linealidad . . . . . . . . . . . . . . . . . . 4.2.2. Transformada de la derivada . . . . . . . . 4.2.3. Cambios de escala . . . . . . . . . . . . . 4.2.4. Derivada de la transformada . . . . . . . . 4.2.5. Convolución . . . . . . . . . . . . . . . . . 4.3. Transformada de Fourier inversa . . . . . . . . . . 4.4. Relación con la transformada de Laplace . . . . . 4.5. Aplicación a los sistemas estables . . . . . . . . . 4.5.1. Respuesta a una señal sinusuidal . . . . . 4.5.2. Respuesta a señales periódicas . . . . . . . 4.5.3. Aplicación de la transformada de Fourier . 4.6. Aplicación a las ecuaciones en derivadas parciales 4.7. Ejercicios . . . . . . . . . . . . . . . . . . . . . . iv . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 49 52 53 55 55 58 60 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 63 63 64 64 68 70 72 74 75 77 78 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83 83 84 85 85 86 86 87 88 88 89 89 90 91 91 93 Capítulo 1 Transformada de Laplace Sumario. Funciones continuas a trozos. Definción de Transformada de Laplace. Propiedades Básicas. Transformada de Fourier inversa: propiedades básicas. Fórmula de inversión compleja. Aplicaciones a la resolución de ecuaciones diferenciales lineales con coeficientes constantes. 1.1. Introducción Vamos a desarrollar un tema sobre la Transformada de Laplace y su aplicación a la resolución de ecuaciones y sistemas de ecuaciones diferenciales lineales con coeficientes constantes. Estas ecuaciones surgen de manera natural en el contexto de los circuitos eléctricos. Consideremos por ejemplo el típico circuito LRC de la figura donde la inductancia , la resistencia y la capacidad de condensador se consideran constantes. Se tiene entonces que la carga () que circula por el circuito está dada por la ecuación 00 () + 0 () + () = () y dado que la intensidad () es la derivada de la carga, ésta puede calcularse por la ecuación Z 0 () + () + () = () 0 1 Transformada de Laplace o equivalentemente con la ecuación diferencial 00 () + 0 () + () = 0 () en el caso en que () sea una función derivable. De forma similar, si tenemos un circuito con varias ramas y más elementos, como por ejemplo podemos deducir a partir de las leyes de Kirchoff que las intensidades que circulan por los hilos eléctricos del circuito vienen dadas por ⎧ ⎨ 0 = 1 − 2 − 3 0 () = 10 1 + 1 1 + 20 2 ⎩ 0 = −20 2 + 300 + 3 2 Si suponemos los elementos del circuito constantes, salvo a lo mejor el voltaje (), que supondremos una función derivable, tenemos un sistema de ecuaciones diferenciales lineales con coeficientes constantes. La Transformada de Laplace es una herramienta que permite transformar los problemas anteriores en problemas algebraicos y, una vez resuelto este problema algebraico más fácil a priori de resolver, calcular a partir de la solución del problema algebraico la solución del problema de ecuaciones diferenciales. Esta es la forma en que los ingenieros abordan el estudio de estos problemas, como pone de manifiesto las referencias [Oga1], [Sen] o [Jam]. Además este método es explicado en algunos libros de ecuaciones diferenciales como [BoPr], [Bra], [Jef] o [MCZ]. Sin embargo, para entender en su justa dimensión la Transformada de Laplace hay que dominar contenidos básicos de variable compleja que nuestros alumnos ya han estudiado durante el curso 2 Transformada de Laplace (ver por ejemplo [Mur]). Así, vamos a presentar la Transformada de Laplace en un primer lugar usando los conocimientos que el alumno tiene de funciones de variable compleja y una vez explicada ésta, procederemos a indicar algunas aplicaciones a las ecuaciones y sistemas citadas anteriormente. Nuestros alumnos también deben conocer y dominar contenidos relativos a integrales impropias que fueron explicados en la asignatura de primer curso fundamentos matemáticos de la ingeniería. A modo de introducción histórica, diremos que la expresión () = Z +∞ − () −∞ fué acuñada en primer lugar por Pierre—Simon Laplace en 1782. Su utilización dentro de la técnica se debe en su forma rigurosa a Thomas Bromwich, el cual formalizó utilizando las funciones de variable compleja y la Transformada de Laplace un cálculo operacional inventado por Oliver Heaviside para la resolución de circuitos eléctricos. 1.2. Funciones continuas a trozos. Función de Heaviside Previamente a introducir la Transformada de Laplace, hemos de concretar qué tipo de funciones vamos a considerar para nuestros problemas. Las funciones que van a ser de importancia dentro de la ingeniería son aquellas llamadas continuas a trozos, que a continuación definimos. Dados los números reales , se dice que la función : [ ] → C es continua a trozos si existe una partición de [ ], = 0 1 = , de manera que es continua en ( +1 ), 0 ≤ , y existen y son finitos los límites laterales de en cada uno de los puntos , 0 ≤ ≤ . Una función : [0 +∞) → C se dice que es continua a trozos si para cada intervalo compacto [ ] ⊂ [0 +∞) se verifica que : [ ] → C es continua a trozos. Uno de los primeros ejemplos de función continua a trozos es : [0 +∞) → C donde es un número real mayor o igual que cero. Esta función está definida por ½ 0 si () = 1 si ≥ y se conoce en ingeniería con el nombre de función de Heaviside. Físicamente, la función de Heaviside realiza la función de interruptor, de manera que si : [0 +∞) → C es una función continua se tiene que · es la función ( · )() = ½ 0 si () si ≥ 3 Transformada de Laplace lo que representa que la función “enciende” a la función o señal en el instante de tiempo = . Adicionalmente, si consideramos 0 ≤ y la función − : [0 +∞) → C, ésta tiene la forma ½ 0 si ∈ [ ) ( − )() = 1 si ∈ [ ) Así, si tomamos ahora la función · − · , la función tiene el efecto físico de “apagar” la función , ya que ⎧ si ⎨ 0 () si ≤ ( · − · )() = ⎩ 0 si ≤ Además de estas interpretaciones físicas, la función de Heaviside es útil para describir funciones continuas a trozos que a su vez sean continuas por la derecha. Por ejemplo, la función ⎧ si 0 ≤ 1 ⎨ − 1 si 1 ≤ 3 () = ⎩ sin si 3 ≤ puede escribirse como () = · [0 () − 1 ()] + ( − 1) · [1 () − 3 ()] + sin · 3 () Esta forma de describir funciones continuas a trozos será útil en los siguientes apartados del tema debido a las propiedades de la Transformada de Laplace que posteriormente estudiaremos. Por otra parte hemos de comentar que al venir la Transformada de Laplace definida como una integral, la condición de ser la función continua por la derecha es irrelevante y todas las funciones pueden tomarse de esta forma. 1.3. Definición de Transformada de Laplace 1.3.1. Definición y primeros ejemplos Sea : [0 +∞) → C una función localmente integrable, esto es, existe la integral de Riemann de en todo intervalo compacto [0 ] ⊂ [0 +∞). Se define la Transformada de Laplace de en ∈ C como Z +∞ L[]() = − () (1.1) 0 siempre que tal integral impropia exista. Como el alumno debe conocer, la convergencia de la integral Z +∞ |− ()| 0 implica la convergencia de la integral (1.1). Denotaremos por D el dominio de L[], es decir, el subconjunto del plano complejo donde la expresión (1.1) tiene sentido. A continuación vamos a ver ejemplos de Transformadas de Laplace de algunas funciones elementales. 4 Transformada de Laplace Función de Heaviside. Sea ≥ 0 y consideremos la función de Heaviside definida anteriormente. Entonces para todo ∈ C tal que Re 0 se verifica Z +∞ Z +∞ − L[ ]() = () = − 0 µ − ¶ Z − − − − = = lı́m = lı́m →+∞ →+∞ En particular, cuando = 0 obtenemos 1 L[0 ]() = Función exponencial. Sea ∈ C y consideremos la función exponencial () = . Se verifica entonces para todo ∈ C tal que Re Re Z +∞ Z +∞ − L[]() = = −(−) 0 0 µ ¶ Z 1 −(−) 1 −(−) = lı́m = lı́m − = →+∞ 0 →+∞ − − − En particular, si = 0 se verifica que () = 1, con lo que nuevamente L[ ]() = 1 para todo ∈ C tal que Re 0. Potencias. Sea un número natural y consideremos la función () = . Vamos ver que la Transformada de Laplace de viene dada por la expresión L[ ]() = ! +1 para todo ∈ C tal que Re 0. Para ver esto procedemos por inducción calculando en primer lugar la Transformada de 1 . Integrando por partes obtenemos Z Z +∞ − = lı́m − L[1 ]() = →+∞ 0 0 µ − ¶ 1 1 − − = + = lı́m →+∞ 2 2 A continuación, por la hipótesis de inducción supongamos que L[ ]() = ! +1 y calculemos la Transformada de +1 . Consideremos Z +∞ Z − +1 = lı́m − +1 (1.2) L[+1 ]() = →+∞ 0 0 Tomando partes en la expresión anterior Z Z +1 − + 1 − − +1 + = − 0 0 5 (1.3) Transformada de Laplace Combinando (1.2) y (1.3) concluimos que L[+1 ]() = +1 ( + 1)! L[ ]() = +2 Funciones periódicas. Las funciones periódicas son bastante importantes en ingeniería debido a que su periodicidad las hace controlables. Sea : [0 +∞) → C una función periódica con periodo . Entonces Z Z −1 Z (+1) −1 X X − − − () = () = − () 0 =0 =0 0 realizando cambios de variable en las integrales y usando que la función es periódica de periodo . Tomando límites cuando → +∞, se verifica para todo ∈ C tal que Re 0 la relación Z 1 L[ ]() = − () 1 − − 0 1.3.2. Dominio de definición de la Transformada de Laplace Los ejemplos que anteriormente hemos explicado ponen de manifiesto que la función Transformada de Laplace de una función : [0 +∞) → C no tiene porque estar definida en todo el plano complejo. Vamos a estudiar con precisión cómo es el dominio de definición de estas funciones, pero consideraremos una clase especial de funciones que tienen lo que llamaremos orden exponencial. Una función : [0 +∞) → C se dice que tiene orden exponencial si existen constantes 0 y ∈ R de manera que para todo ≥ 0 se satisface la condición | ()| ≤ (1.4) Denotaremos por E el conjunto de funciones continuas a trozos con orden exponencial, que serán las funciones con las que trabajaremos a partir de ahora. El siguiente resultado ofrece una primera aproximación sobre el dominio de definición de la Transformada de Laplace de funciones con orden exponencial. Proposition 1 Sea : [0 +∞) → C una función continua a trozos cumpliendo la condición (1.4). Entonces L[]() está definida para todo número complejo tal que Re Proof. Vamos a ver que la función − () es absolutamente integrable para todo complejo tal que Re . Para ello consideramos Z +∞ Z +∞ − | ()| = − Re | ()| 0 0 Z +∞ ≤ −(Re −) 0 Z = lı́m −(Re −) →+∞ µ0 ¶ 1 −(Re −) 1 = lı́m − = →+∞ − Re − Re − Re 6 Transformada de Laplace con lo que la Transformada de Laplace existe en el subconjunto { ∈ C : Re } Este resultado prueba que { ∈ C : Re } ⊂ D . Si definimos = inf{ ∈ R : ∃ 0 con |()| ≤ para todo ≥ 0} y denotamos por D∗ = { ∈ C : Re } La Proposición 1 nos asegura que D∗ ⊆ D . 1.4. Propiedades de la Transformada de Laplace Una vez estudiada la definición de Transformada de Laplace y caracterizadas algunas condiciones para que una función tenga Transformada de Laplace L[] definida en un dominio del plano complejo D , pasamos a estudiar algunas propiedades básicas de esta transformada integral. La primera propiedad que vamos a estudiar es la linealidad. 1.4.1. Linealidad Esta propiedad será muy útil para resolver ecuaciones diferenciales lineales con coeficientes constantes, a la vez que permitirá el cálculo de la transformada de algunas funciones. Theorem 2 Sean ∈ E y ∈ C. Entonces para todo ∈ D ∩ D se verifica que L[ + ]() = L[ ]() + L[]() Proof. La demostración se sigue inmediatamente de la linealidad de la integral. Consideremos Z +∞ L[ + ]() = − (() + ()) 0 Z = lı́m − (() + ()) →+∞ 0 Z Z − () + lı́m − () = lı́m →+∞ →+∞ 0 0 = L[ ]() + L[]() lo que concluye la prueba. A partir de la linealidad de la Transformada de Laplace podemos obtener nuevas Transformadas de funciones elementales, como muestran los siguientes ejemplos. Función seno. Sea ∈ R y consideremos la función − − () = sin() = 2 7 Transformada de Laplace Entonces ¢ 1 ¡ L[ ]() − L[− ]() 2 µ ¶ 1 1 1 − = 2 = 2 − + + 2 L[ ]() = siempre que Re 0 Función coseno. Sea ∈ R y consideremos la función () = cos() = + − 2 De forma análoga a la anterior se obtiene que L[]() = 2 + 2 siempre que Re 0. Función seno hiperbólico. Sea ∈ R y consideremos la función () = sinh() = − − 2 Entonces ¢ 1 ¡ L[ ]() − L[− ]() 2µ ¶ 1 1 1 − = 2 = 2 − + − 2 L[ ]() = si Re ||. Función coseno hiperbólico. Sea ∈ R y consideremos la función () = cosh() = + − 2 De forma análoga a la anterior se obtiene que L[]() = siempre que Re ||. 8 2 − 2 Transformada de Laplace 1.4.2. Transformada de la derivada Se dice que la función ∈ E es derivable a trozos si es continua, existen las derivadas laterales de en cada punto de [0 +∞) y en cada subintervalo [ ] ⊂ [0 +∞) existen a lo sumo una cantidad finita de puntos donde no es derivable. Si es derivable a trozos, definimos 0 : [0 +∞) → C como 0 () = +0 () para todo ∈ [0 +∞). Es claro entonces que 0 es una función continua a trozos, que coincidirá en casi todos los puntos con la derivada ordinaria. Se tiene entonces el siguiente resultado. Theorem 3 Bajo las condiciones anteriores se verifica para todo ∈ D∗ L[ 0 ]() = L[ ]() − (0) (1.5) Proof. Sean ∈ D∗ y 0 y consideremos 0 1 2 −1 los puntos de discontinuidad de 0 en el intervalo (0 ) y fijemos 0 = 0 y = . Entonces, dividiendo el intervalo de integración y utilizando la fórmula de integración por partes Z − 0 () = 0 = Z X =1 X − 0 () −1 − [ =1 −−1 ( ) − = − () − (0) + Z (−1 )] + Z X =1 − () −1 − () 0 Tomando límites cuando → +∞, y teniendo en cuenta que ∈ D∗ y que por tanto existen ∈ R, 0, Re , tales que |()− | ≤ (−Re ) → 0 si → +∞ obtenemos inmediatamente (1.5). Procediendo por inducción a partir de la fórmula (1.5) se prueba una fórmula general para la derivada —ésima de la función en el caso de que −1) sea derivable a trozos para ∈ N. Esta fórmula viene dada para todo ∈ D∗ por L[ ) ]() = L[ ]() − −1 (0) − −2 0 (0) − − −2) (0) − −1) (0) (1.6) donde las derivadas sucesivas de en 0 se entienden como derivadas por la derecha. Las fórmulas 1.5 y 1.6 serán claves para resolver ecuaciones y sistemas diferenciales lineales con coeficientes constantes, como veremos en el apartado de aplicaciones de este tema. 9 Transformada de Laplace 1.4.3. Transformada de la integral Sea ∈ E y definamos la función () = Z () 0 que obviamente está bien definida y es continua para todo ∈ [0 +∞). La relación entre las Transformadas de Laplace de ambas funciones viene dada por el siguiente resultado. Theorem 4 En las condiciones anteriores, para todo ∈ D∗ ∩ { ∈ C : Re 0} se verifica L[]() = L[]() (1.7) Proof. Sea 0 y consideremos 0 = 0 1 −1 = de manera que no es continua en para 1≤ . Obviamente es derivable en ( +1 ) para 1 ≤ . Entonces Z −1 Z +1 X − () = − () 0 =0 −1 µ X − −+1 ( ) = − (+1 ) =0 Z − 1 − () + = −() 0 ¶ 1X + =0 −1 Z +1 − () teniendo en cuenta la continuidad de y (0) = 0. Vamos a comprobar que lı́m ()− = 0. →+∞ Para ello y dado que ∈ E, existirán reales y 0 de manera que | ()| ≤ para todo ≥ 0. Sea Z Z − − |() | ≤ () ≤ − Re 0 µ ¶0 1 = − Re − → 0 si → +∞ Entonces tomando límites en la expresión anterior obtenemos el resultado. 1.4.4. Transformada de la convolución Sean ∈ E y definamos () = () = 0 para todo 0. Se define la convolución de y como la función Z +∞ Z ( ∗ )() = ( − )() = ( − )() 0 0 Puede verse con el cambio de variable = − que ∗ = ∗ . El principal interés de la convolución respecto a la Transformada de Laplace se concreta en el siguiente resultado. 10 Transformada de Laplace Theorem 5 En las condiciones anteriores, para todo ∈ D∗ ∩ D∗ se verifica la fórmula L[ ∗ ]() = L[]()L[]() Proof. En primer lugar, existen números reales y 0, = 1 2, de manera que para todo ≥ 0 se verifica |()| ≤ 1 y |()| ≤ 2 Entonces para todo ≥ 0 ¯ Z ¯Z ¯ ¯ ¯ | ( − )||()| |( ∗ )()| = ¯ ( − )()¯¯ ≤ 0 0 Z = 1 2 ≤ 1 2 0 − con lo que se ve fácilmente que ( ∗ )() es absolutamente integrable para todo Re , con lo que L[ ∗ ]() existe para todo con Re . Por otra parte, como las funciones − () y − () también son absolutamente integrables para todo Re , por el Teorema de Fubini (ver [PiZa, pag. 187]) se tiene que ∙Z ¸ Z +∞ − L[ ∗ ]() = ( − )() 0 0 ¸ Z +∞ ∙Z −(−) − ( − ) () = 0 0 ¸ Z +∞ ∙Z +∞ −(−) − ( − ) () = 0 ¸ Z +∞ ∙Z +∞ −(−) = ( − ) − () 0 ¸ Z +∞ ∙Z +∞ − () − () = 0 0 Z +∞ = L[ ]()− () = L[]()L[]() 0 con lo que termina la prueba. La demostración de este resultado no la haremos a los alumnos, debido a que pensamos que sus conocimientos le impedirán comprenderla completamente. No obstante la fórmula será bastante útil en las aplicaciones. 1.4.5. Primer Teorema de Traslación Fijemos un número complejo y consideremos ∈ E. El primer teorema de desplazamiento hace referencia a la transformada de la función () y afirma lo siguiente. Theorem 6 Bajo las condiciones anteriores L[ ()]() = L[]( − ) para todo ∈ D + Re := { + Re : ∈ D }. 11 (1.8) Transformada de Laplace Proof. Sea Z +∞ − () = lı́m →+∞ 0 de donde se deduce inmediatamente (1.8). Z −(−) () = 0 Z +∞ −(−) () 0 A partir de este resultado podemos obtener las Transformadas de las funciones siguientes: () = sin(), ∈ R, cuya Transformada de Laplace para todo número complejo tal que Re Re es L[]() = ( − )2 + 2 () = cos(), ∈ R, cuya Transformada de Laplace para todo número complejo tal que Re Re es − L[]() = ( − )2 + 2 () = sinh(), ∈ R. Si Re || + Re , entonces L[]() = ( − )2 − 2 () = cosh(), ∈ R. Si Re || + Re , entonces − L[]() = ( − )2 − 2 () = con ∈ N. Entonces L[]() = siempre que Re Re . 1.4.6. ! ( − )+1 Segundo Teorema de Traslación Sea ahora 0 un número real y supongamos que ∈ E está definida por () = 0 para todo 0. Recordemos que es la función de Heaviside. Entonces tenemos el siguiente resultado. Theorem 7 Bajo las anteriores condiciones se verifica para todo ∈ D L[ ()( − )]() = − L[]() Proof. Tomamos Z 0 +∞ − ()( − ) = = = lı́m →+∞ lı́m →+∞ lı́m →∞ = − Z Z0 Z − () ( − ) − ( − ) − Z0 +∞ 0 12 −(+) () − () (1.9) Transformada de Laplace haciendo el cambio de variable = − . De aquí se obtiene inmediatamente (1.9). Este resultado es útil para obtener la Transformada de Laplace de funciones continuas a trozos. Por ejemplo consideremos la función ½ si 0 ≤ 1 () = 0 si ≥ 1 Esta función puede describirse como () = [0 () − 1 ()] Entonces L[]() = L[0 ()]() − L[1 ()]() = L[]() − − L[ + 1]() µ ¶ +1 1 1 1 1 − = 2 − + = 2 − − 2 2 para todo ∈ C tal que Re 0. 1.5. Propiedades de la función Transformada de Laplace En esta sección estudiamos la propiedades de la función Transformada de Laplace considerándola como una función de variable compleja definida en un semiplano { ∈ C : Re }, ∈ R. Dividimos la sección en tres subsecciones. 1.5.1. Derivabilidad de la Transformada de Laplace Consideremos una función ∈ E y su Transformada de Laplace L[ ] : { ∈ C : Re } → C Theorem 8 Bajo la notación anterior, la función L[ ] es holomorfa para todo ∈ C tal que Re y además se verifica Z +∞ − () L[]() = − 0 En las condiciones del resultado anterior, obtenemos por inducción la fórmula para la derivada —ésima de la Transformada de Laplace Z +∞ L[ ]() = (−1) − () 0 Claramente la demostración de este resultado no es apropiada para hacerla en clase, pues presupone muchos contenidos que no hemos explicado en la misma. Nos centraremos en que el alumno entienda el resultado y sepa aplicarlo. Por ejemplo, calculando las Transformadas de las siguientes funciones. 13 Transformada de Laplace () = sin(), ∈ N y ∈ R. Se tiene siempre que Re 0 la relación µ ¶ L[]() = (−1) L[sin()]() = (−1) 2 + 2 () = cos(), ∈ N y ∈ R. Se tiene análogamente siempre que Re 0 µ ¶ L[ ]() = (−1) L[cos()]() = (−1) 2 + 2 De forma similar se obtienen fórmulas equivalentes para el coseno y seno hiperbólicos. 1.5.2. Teoremas del valor inicial Estos resultados hacen alusión a aspectos cualitativos de la Transformada de Laplace de funciones de la clase E. Theorem 9 Sea ∈ E. Entonces lı́m Re →+∞ L[ ]() = 0 (1.10) Proof. Sea ∈ D∗ . Existen números reales 0 y de manera que | ()| ≤ para todo ≥ 0. Entonces Z Z − |L[]()| ≤ lı́m | ()| ≤ lı́m (−Re ) →+∞ →+∞ 0 0 (−Re ( − 1) = lı́m = →+∞ − Re Re − de donde claramente obtenemos (1.10) al hacer Re → +∞. Continuamos esta sección con otro resultado que estudia cuestiones cualitativas de la Transformada de Laplace. Theorem 10 Asumamos que ∈ E es derivable a trozos y que 0 ∈ E. Entonces lı́m Re →+∞ L[ ]() = (0) (1.11) Proof. Sea ∈ D∗ . Por el Teorema 3 tenemos que L[ ]() = (0) + L[ 0 ]() (1.12) Aplicando el Teorema 9 a (1.12) se tiene que lı́mRe →+∞ L[ 0 ]() = 0, de donde se deduce inmediatamente (1.11). Los resultados anteriores muestran que no todas las funciones de variable compleja pueden ser √ Transformadas de Laplace de funciones de E. Por ejemplo, la función 1 no puede serlo al tenerse que lı́m √ = ∞ Re →+∞ 14 Transformada de Laplace 1.5.3. Teorema del valor final Al igual que los resultados de la sección anterior el Teorema del valor final aporta información cualitativa de la Transformada de Laplace en conexión directa con la función de la cual es transformada. Theorem 11 Sea ∈ E una función derivable a trozos tal que 0 ∈ E. Supongamos que 0 ∈ D∗ y que existe y es finito lı́m→+∞ (). Entonces lı́m L[ ]() = lı́m () →0 →+∞ Proof. Por el Teorema 3, 0 L[ ]() − (0) = L[ ]() = Z +∞ − 0 () 0 Por el Teorema 8, L[ 0 ]() es derivable y por lo tanto continua. Entonces 0 0 lı́m L[ ]() = L[ ](0) = →0 Z +∞ 0 () = lı́m () − (0) →+∞ 0 lo cual concluye la demostración. 1.6. Transformada de Laplace inversa 1.6.1. Inyectividad de la Transformada de Laplace Al intervenir en la definición de Transformada de Laplace la integración, está claro que puede haber infinitas funciones en E teniendo la misma Transformada, por lo que la ésta no será inyectiva. Sin embargo este problema puede paliarse en parte para así poder hablar de la Transformada inversa de una función holomorfa definida en un semiplano complejo. Como veremos en las aplicaciones del tema, este punto será de vital importancia. Consideremos : [0 +∞) → C una función localmente integrable. Diremos que es nula o nula casi por todas partes si para todo ∈ (0 +∞) se verifica que Z 0 |()| = 0 Dos funciones : [0 +∞) → C localmente integrables se dirán iguales casi por todas partes si − es nula. Se tiene entonces el siguiente resultado. Proposition 12 Sean ∈ E iguales casi por todas partes. Entonces L[]() = L[]() para todo ∈ D ∩ D . 15 Transformada de Laplace Proof. Sea 0 y ∈ D ∩D . Por el Teorema del Valor Medio del Cálculo Integral existe ∈ (0 ) tal que Z Z − 0 Así | − () − − Re | () − ()| = 0 ()| = 0 ¯Z ¯ |L[]() − L[]()| = lı́m ¯¯ →+∞ − 0 ≤ − Re lı́m →+∞ Z () − 0 Z − 0 ¯ ¯ ()¯¯ | () − ()| = 0 lo que termina la demostración. El siguiente resultado establece una especie de recíproco para el resultado anterior. Theorem 13 (Lerch) Sean ∈ E tales que L[ ]() = L[]() para todo ∈ D ∩ D . Entonces y son iguales salvo a lo mejor en los puntos de discontinuidad de ambas, con lo que además D = D . La demostración de este resultado no la haremos en clase y no lo hemos incluido en la lección ya que no puede obtenerse de forma autocontenida con las técnicas que tenemos a nuestra disposición. 1.6.2. Transformada de Laplace inversa Consideremos la función L : E → L(E) El Teorema 13 permite definir clases de equivalencia en E del siguiente modo. Dadas ∈ E se dirá que ambas están relacionadas, ∼ si y sólo si son iguales salvo a lo sumo en los puntos de discontinuidad de ambas. Podemos definir entonces la Transformada de Laplace inversa L−1 : L(E) → E ∼ para ∈ L(E) como L−1 [ ] = [] donde [] denota la clase de ∈ E de manera que L[] = . En general con nuestros alumnos tenderemos a identificar clases con funciones que normalmente podrán ser calculadas. Así diremos que dada ∈ L(E) su Transformada inversa es una función L−1 [ ]() = () de forma que L[ ] = , aunque está perfectamente claro que tal no es única. En este contexto, destacamos las siguiente propiedades de Transformada inversa que serán especialmente interesantes a la hora de las aplicaciones. Linealidad. Dadas ∈ L(E) y ∈ C se verifica L−1 [ + ]() = L−1 [ ]() + L−1 []() Traslación. Dada ∈ L(E) y 0 se cumple la relación L−1 [− ()]() = ()L−1 [ ]( − ) 16 Transformada de Laplace Convolución. Dadas ∈ L(E) se cumple L−1 [ ]() = (L−1 [ ] ∗ L−1 [])() Estas propiedades son particularmente interesantes a la hora de obtener Transformadas inversas de Laplace una vez conocidas las Transformadas directas. 1.6.3. Fórmula de inversión compleja Aparte de las técnicas estudiadas en el apartado anterior para hallar Transformadas inversas, estudiaremos la siguiente fórmula de inversión compleja. Theorem 14 Supongamos que () es holomorfa en C \ {1 2 }, y que existe ∈ R tal que es holomorfa en { ∈ C : Re }. Supongamos además que existen constantes positivas , y tales que | ()| ≤ si || ≥ (1.13) || Para ≥ 0 sea () = X Res( () ) =1 Entonces L[ ]() = () si Re Proof. Sea y consideremos el rectángulo Γ de la figura, suficientemente grande para que las singularidades de estén contenidas en su interior y además todo ∈ Γ cumpla la condición || . Separamos Γ en la suma de dos caminos cerrados 1 y 2 divididos por la recta Re = . 17 Transformada de Laplace Como las singularidades de están contenidas en el interior de 1 , por definición de tenemos que Z () = 2() 1 Entonces 2L[]() = = lı́m →+∞ lı́m →+∞ Z − Z ∙Z 0 1 0 ∙Z ¸ () ¸ (−) () 1 aplicando el Teorema de Fubini. Por integración directa Z ¢ () ¡ (−) −1 2L[ ]() = lı́m →+∞ − 1 Para fijo en el semiplano Re , el término (−) converge uniformemente a 0 si → +∞ y el integrando converge a − ()( − ) en 1 . Así Z Z Z () () () 2L[ ]() = − = − 1 − 2 − Γ − Z () = 2 () − Γ − Por otra parte, sea () = , ∈ [0 2] una circunferencia de radio y conteniendo a Γ. Entonces Z Z () () = Γ − − de donde ¯ ¯Z ¯ () ¯ ¯ ¯ ¯ − ¯ ≤ || ( − ) 2 → 0 si → +∞ Así Z () = 0 Γ − y como era arbitrario, la fórmula L[]() = () es válida para todo Re . Remarquemos aquí que la condición (1.13) del resultado anterior se cumple para funciones de la forma () = ()() donde y son polinomios tales que deg ≥ 1 + deg , donde deg denota el grado de . Así por ejemplo, la Transformada inversa de la función () = 2 +1 puede calcularse como L−1 [ ]() = () = Res( () ) + Res( () −) = + − = cos 2 −2 18 Transformada de Laplace 1.7. Aplicaciones: una primera aproximación La Transformada de Laplace es una herramienta útil para resolver ecuaciones y sistemas de ecuaciones diferenciales lineales con coeficientes constantes. Como comentamos en la introducción del tema, estas ecuaciones aparecen de forma natural en la teoría de circuitos eléctricos. Para ilustrar el método, consideremos el siguiente ejemplo: la ecuación 00 + = cos (1.14) (0) = 0; 0 (0) = 1 (1.15) junto con las condiciones iniciales Básicamente se trata de aplicar la Transformada de Laplace y sus propiedades a (1.14) de manera que teniendo en cuenta (1.15), nuestro problema se convierte en el problema algebraico 2 L[]() − (0) − 0 (0) + L[]() = 2 +1 de donde 2 + + 1 L[]() = ( 2 + 1)2 Una vez obtenida L[], hemos de usar la Transformada inversa para volver atrás y recuperar la solución del problema . En este caso, L[] satisface las condiciones del Teorema 14, por lo que ¶ µ ¶ µ 2 2 + + 1 + + 1 + Res − () = Res ( 2 + 1)2 ( 2 + 1)2 = (1 + 2) sin una vez realizados los cálculos. 1.8. Uso de la convolución Otra forma de abordar el problema anterior, sin necesidad de tener que calcular la Transformada de Laplace de la función coseno es la siguiente. Consideremos los cálculos realizados anteriormente, pero sin obtener L[]() donde () = cos . Nos quedará entonces la ecuación algebraica 2 L[]() − 1 + L[]() = L[ ]() de donde L[]() = 2 1 1 + 2 L[]() +1 +1 Entonces () = L−1 [1( 2 + 1)]() + L−1 [L[ ]()( 2 + 1)]() = sin + (L−1 [L[]()] ∗ L−1 [1( 2 + 1)])() Z = sin + sin( − ) cos 0 ¸ ∙ 1 = sin + (cos(2 − ) + 2 sin 4 0 = sin + sin = (1 + 2) sin 2 19 Transformada de Laplace que era la solución obtenida anteriormente. Así, el uso del producto de convolución presenta una vía alternativa para la resolución de estos problemas, aunque a veces el cálculo de las integrales que aparecen en el producto de convolución pueden ser bastante complicado. 1.9. Ejercicios 1. Calcular la transformada de Laplace de las siguientes funciones (a) () = sin(3) (b) () = 5 (c) () = 5 cos 3 (d) () = (e) () = 3 − (f) () = sinh (g) () = cos sin (h) () = cos sin(2) 2. Una función : [0 +∞[ → R se dice que es periódica con periodo 0 o -periódica si para cada ≥ 0 se tiene que () = ( + ). Comprobar que en caso de existir la transformada de Laplace de , se verifica la igualdad Z 1 L()() = − () 1 − − 0 3. Usar el resultado de la actividad anterior para calcular la transformada de Laplace de la función peródica de periodo 2 definida en [0 2] por ½ si ∈ [0 1] () = 2 − si ∈ [1 2] 4. Dada la función, () = Z − sin 0 ≥0 calcular su transformada de Laplace. Calcular asimismo la transformada de Laplace de () = (). 5. Dada la función (), definimos la función () = (), que puede verse como un cambio de escala en . Comprobar que 1 L[]() = L[ ()]() = L[]() Utilizar dicha fórmula para calcular la transformada de la función sin() a partir de L[sin ]() = 1 1 + 2 6. Calcular la transformada de Laplace de la función, ⎧ ⎪ ⎨ si 0 ≤ ≤ 1 1 si 1 ≤ 2 () = ⎪ ⎩ 0 si 2 20 Transformada de Laplace 7. Calcular la transformada de Laplace de las siguientes funciones. ½ 2 ½ − 1 si 0 ≤ ≤ 2 0 si 0 ≤ ≤ 1 (c) () = (a) () = | sin | (b) () = si 1 2 si 2 8. Calcular la transformada de Laplace de la función escalonada ½ 0 ≤ ≤ 1 () = 0 1 ≤ 2 extendida a todo [0 +∞[ como 2-periódica. 9. ¿Existirá la transformada inversa de Laplace de las siguientes funciones de variable compleja? Razonar las respuestas. (a) () = sin (b) () = − (c) () = 1 + 2 (d) () = − 1 + cos ( 2 ) 10. Calcular la transformada inversa de Laplace de las funciones siguientes (a) () = 2 1 + 3 (b) () = () () = 1 ( − 1)( 2 − 2) (c) () = 2 +7 + 2 + 5 1 ( + 1)( + 2)( 2 + 2 + 10) 11. Calcular la transformada inversa de Laplace de las siguientes funciones: (a) () = − 2 + 2 + 5 (b) () = ( − 1)− 3 + 2 (c) () = +1 + 9) 2 ( 2 (d) () = +1 4 12. Calcular las transformadas inversas de Laplace de las funciones: (a) () = − ( 0) (b) () = 1 + 2 ( − 1)( + 2)2 () () = (c) () = − −1 + 2 +2 2 ( − 2)( 3 − 1) 13. Utilizar la transformada de Laplace para resolver los siguientes problemas de Cauchy asociados a ecuaciones diferenciales lineales con coeficientes constantes: ¾ ¾ 0 () + 3() = −2 000 () + 5 00 () + 17 0 () + 13() = 1 (0) = 0 (0) = 1 00 (0) = 0 (0) = 2 ¾ ¾ 00 () + () = 00 () + 0 () − 2() = 54 () (0) = 1 0 (0) = 0 (0) = 1 0 (0) = −2 21 Transformada de Laplace 14. Resolver los siguientes problemas de valores iniciales: ½ 1 00 0 () + () = () con () = 0 ≥ 1 0 (0) = 0 (0) = 2 15. Consideremos un circuito LCR como el de la figura ⎫ ⎪ ⎬ ⎪ ⎭ 00 () + () = sin (0) = 0 (0) = −1 ) de forma que = 2 henrios, = 16 ohmios, = 002 faradios y la fuerza electromotriz va oscilando con el tiempo siguiendo la relación () = 100 sin(3). a) Utilizar las leyes de Kirchhoff para obtener la ecuación diferencial que verifica la función que describe la carga en función del tiempo. b) Determinar la carga en función del tiempo si en el momento de de conectar el circuito, = 0, la carga del condensador es igual a cero. c) Determinar la carga del condensador en función del tiempo si inicialmente es de 1.5 culombios. 16. En el caso de un circuito LCR en el que no se tiene ninguna resistencia, la ecuación diferencial que describe la carga del condensador en función del tiempo es de la forma, 2 () () + = () 2 y se denomina oscilador armónico. Resolver la ecuación anterior en los siguientes casos: a) La fuerza electromotriz es constante y la carga e intensidad de corriente en el momento inicial son ambas nulas. b) La fuerza electromotriz es de la forma sin( + ), con ∈ R, mientras que (0) = 1 al conectar el circuito. 17. Usar la transformada de Laplace para resolver el siguiente sistema de ecuaciones diferenciales lineales: ) 2100 () − 200 () − 10 () − 20 () + 91 () − 32 () = 0 2100 () − 200 () + 10 () + 20 () + 71 () − 52 () = 0 22 Transformada de Laplace con las condiciones iniciales: 1 (0) = 10 (0) = 1 2 (0) = 20 (0) = 0 18. Encuentra la solución del siguiente problema de Cauchy, 00 () + () = sen( ) (0) = 0 0 (0) = 1 ) con 1. 19. Encuentra la solución del oscilador armónico dado por la ecuación diferencial: 00 () + () = sin ( ) ( ∈ R 0) que verifica las condiciones iniciales: 0 (0) = 0 (0) = −12 (06-09-99) 20. Resuelve el siguiente problema de Cauchy: 00 () + () = cos () (0) = −1 0 (0) = 0 distinguiendo los casos en que 0 y 0 . 21. Obtener la solución del siguiente sistema de ecuaciones diferenciales, ) 310 () + 20 () − 21 () = 3 sin + 5 cos 210 () + 20 () + 2 () = sin + cos para las condiciones iniciales, 1 (0) = 0, 2 (0) = −1. 23 Transformada de Laplace 24 Capítulo 2 Estabilidad de ecuaciones diferenciales Sumario. Ecuaciones y sistemas de ecuaciones lineales. Funciones de transferencia. Nociones de estabilidad. Criterios de estabilidad. Estabilidad de sistemas autónomos no lineales. 2.1. Ecuaciones y sistemas lineales: generalidades Para nosotros, un sistema de ecuaciones diferenciales es una expresión de la forma ⎧ 0 ⎪ 1 ( 1 10 2 20 ) = 0; ⎪ ⎪ ⎨ 2 ( 1 0 2 0 0 ) = 0; 1 2 .. ⎪ . ⎪ ⎪ ⎩ ( 0 0 0 ) = 0; 1 1 2 2 donde 1 2 son funciones reales a determinar que dependen de y : ⊆ R1+2 → R, 1 ≤ ≤ , son funciones reales de varias variables. Se suele suponer que hay igual número de ecuaciones que de incógnitas de manera que todas las ecuaciones son independientes, es decir, ninguna puede deducirse de las demás. Estamos interesados en aquellos sistemas de ecuaciones diferenciales en los que podemos despejar la primera derivada de cada una de las funciones incógnita, es decir, sistemas de la forma ⎧ ⎪ 10 = 1 ( 1 2 ); ⎪ ⎪ ⎨ 0 = 2 ( 1 2 ); 2 .. ⎪ . ⎪ ⎪ ⎩ 0 = ( ); 1 2 donde : ⊆ R1+ → R, 1 ≤ ≤ , son funciones reales. Ejemplos de estos sistemas son ½ 0 1 = 1 + 22 ; 20 = + 1 + 2 ; ⎧ 0 ⎨ 1 = 1 + 22 − 3 ; 0 = + 1 + 2 3 ; ⎩ 20 3 = 1 2 3 ; 25 Estabilidad de ecuaciones diferenciales En general la resolución de estos sistemas no es posible, salvo en casos excepcionales. Sólo para el caso de los sistemas de ecuaciones diferenciales lineales con coeficientes constantes, que veremos un poco más tarde existen algoritmos que permiten el cálculo explícito de las soluciones. Sin embargo, es relativamente sencillo saber cuándo un sistema tiene solución, o más precisamente cuándo un problema de condiciones iniciales asociado tiene solucón. Primero claro está, debemos definir qué entendemos por un problema de condiciones iniciales para sistemas de ecuaciones diferenciales. Dicho problema es un sistema de ecuaciones diferenciales ⎧ ⎪ 10 = 1 ( 1 2 ); ⎪ ⎪ 0 ⎪ ⎪ ⎨ 2 = 2 ( 1 2 ); .. . ⎪ ⎪ 0 ⎪ = ( 1 2 ); ⎪ ⎪ ⎩ ( ) = ( ) = ( ) = 1 0 1 2 0 2 0 junto con las condiciones (0 ) = , donde 0 1 2 son números reales. Por ejemplo ⎧ 0 = 1 + 22 − 3 ; ⎪ ⎪ ⎨ 10 2 = + 1 + 2 3 ; 0 = 1 2 3 ; ⎪ ⎪ ⎩ 3 1 (0) = 2 2 (0) = 0 3 (0) = 1 es un problema de condiciones iniciales. Nótese que todas las condiciones iniciales implican el conocimiento de la función en 0, es decir, lo siguiente ⎧ 0 = 1 + 22 − 3 ; ⎪ ⎪ ⎨ 10 2 = + 1 + 2 3 ; 0 = 1 2 3 ; ⎪ ⎪ ⎩ 3 1 (0) = 2 2 (1) = 0 3 (0) = 1 no sería un problema de condiciones iniciales, ya que conocemos 2 en 1 e 1 e 3 en 0. Para el caso de los problemas de condiciones iniciales para sistemas de ecuaciones diferenciales tenemos el siguiente resultado análogo al de ecuaciones diferenciales de orden uno. Theorem 15 Sea el problema de condiciones iniciales ⎧ ⎪ 10 = 1 ( 1 2 ); ⎪ ⎪ 0 ⎪ ⎪ ⎨ 2 = 2 ( 1 2 ); .. . ⎪ ⎪ 0 ⎪ = ( 1 2 ); ⎪ ⎪ ⎩ ( ) = ( ) = ( ) = 1 0 1 2 0 2 0 donde (0 1 ) ∈ , : ⊆ R1+ → R, 1 ≤ ≤ , son funciones reales continuas en el abierto . Supongamos además que las funciones existen y son continuas en . Entonces existe una solución del problema de condiciones iniciales anterior : → R, 1 ≤ ≤ definido en un intervalo abierto de la recta real. 26 Estabilidad de ecuaciones diferenciales Este resultado es fácil de aplicar. Por ejemplo el problema que consideramos anteriormente ⎧ 0 1 = 1 + 22 − 3 ; ⎪ ⎪ ⎨ 0 2 = + 1 + 2 3 ; 0 = 1 2 3 ; ⎪ ⎪ ⎩ 3 1 (0) = 2 2 (0) = 0 3 (0) = 1 es tal que 1 ( 1 2 3 ) = 1 + 22 − 3 , 2 ( 1 2 3 ) = + 1 + 2 3 y 3 ( 1 2 3 ) = 1 2 3 son funciones definidas en R4 , continuas y las derivadas parciales de cada función respecto de 1 2 e 3 son continuas. Entonces este problema de condiciones iniciales tiene solución única, aunque no tengamos ni idea de cómo calcularla. Se verá en la asignatura de cuarto curso métodos numéricos cómo obtener soluciones aproximadas, y en esta misma asignatura estudiaremos cómo obtener información parcial sobre el sistema incluso sin conocer las soluciones. 2.1.1. Sistemas de ecuaciones diferenciales lineales Como hemos comentado anteriormente en general no va a ser posible resolver sistemas de ecuaciones diferenciales salvo en ciertos casos particulares. Uno de ellos va a ser el de los sistemas de ecuaciones diferenciales lineales de coeficientes constantes, cuya teoría general pasamos a estudiar. Vamos a ver a continuación cómo son las soluciones de un sistema de este tipo, pero antes necesitamos conocer un poco más sobre éstos. Un sistema de ecuaciones diferenciales lineales es una expresión de la forma ⎧ 0 = 11 ()1 + 12 ()2 + + 1 () + 1 () ⎪ ⎪ ⎨ 10 2 = 21 ()1 + 22 ()2 + + 2 () + 2 () ⎪ ⎪ ⎩ 0 = 1 ()1 + 2 ()2 + + () + () donde para cada 1 ≤ ≤ , y son funciones reales definidas sobre un intervalo . Si denotamos por ⎛ ⎞ 11 () 12 () 1 () ⎜ 21 () 22 () 2 () ⎟ ⎜ ⎟ A() = ( ())1≤≤ 1≤≤ = ⎝ ⎠ 1 () 2 () () y por ⎛ ⎞ 1 () ⎜ 2 () ⎟ ⎟ b() = (1 () 2 () ()) = ⎜ ⎝ ⎠ () e ⎛ ⎞ 1 ⎜ 2 ⎟ ⎟ y = (1 2 ) = ⎜ ⎝ ⎠ el sistema anterior puede escribirse de forma matricial como y0 = A() · y + b() 27 (2.1) Estabilidad de ecuaciones diferenciales donde por y0 se entenderá la derivada coordenada a coordenada, es decir, ⎛ 0 ⎞ 1 0 ⎟ ⎜ 2 ⎟ y0 = (10 20 0 ) = ⎜ ⎝ ⎠ 0 Por ejemplo, los sistemas ½ 10 = 1 + 2 + 1 − 2 20 = 1 − 2 + − ⎧ 0 ⎨ 1 = 1 + 2 2 + 3 + 1 − 2 0 = 1 − 2 2 + − ⎩ 20 3 = 1 + (1 − )2 + 3 son lineales. Un sistema se dirá homogéneo si b() = (0 0 0) , es decir, el sistema ⎧ 0 ⎨ 1 = 1 + 2 2 + 3 0 = 1 − 2 2 ⎩ 20 3 = 1 + (1 − )2 + 3 es homogéneo. Se dirá no homogéneo en caso contrario. Nosotros le prestaremos una gran atención a los sistemas lineales con coeficioentes constantes. Un sistema de ecuaciones diferenciales lineales se dirá de coeficientes constantes si la matriz A() = A es constante. Ejemplos de tales sistemas, tanto homogéneos como no homogéneos son ½ 0 1 = 21 + 2 + 1 − 2 20 = 1 − 2 + − ⎧ 0 ⎨ 1 = 21 − 2 + 3 0 = 1 − 2 + 73 ⎩ 20 3 = −41 + 2 + 3 Veremos en los sucesivos temas cómo resolver estos últimos sistemas, dando un algoritmo que permitirá el cálculo de la solución general del mismo. Previamente, estudiaremos la teoría general de los sistemas de ecuaciones lineales y para posteriormente particularizarla al caso de las ecuaciones lineales de orden mayor o igual que dos (ver la última sección de este tema). Esta teoría general de los sistemas de ecuaciones diferenciales lineales se sustenta en la noción de espacio vectorial de dimensión finita estudiadas en la parte de álgebra lineal impartida durante el curso y utiliza el siguiente resultado sobre existencia y unicidad de soluciones de ecuaciones y sistemas que se deducen directamente del Teorema 15. Theorem 16 Sea y0 = A() · y + b() un sistema de ecuaciones diferenciales lineales donde A y b están definidas en un intervalo 0 = [0 − 0 + ]. Si estas funciones son continuas en dicho intervalo, entonces el problema de condiciones iniciales ½ 0 y = A() · y + b() y(0 ) = y0 tiene solución única definido en todo 0 . 28 Estabilidad de ecuaciones diferenciales Recordemos por un instante dos nociones que será importante tener claras para entender la teoría que a continuación vamos a desarrollar. Por un lado hemos de tener presente que bajo la notación que estamos utilizando, una solución de un sistema lineal es una función y : ( ) ⊆ R → R , o dicho de otro modo, un vector cuyas componentes son funciones reales. Por ejemplo, dado el sistema ½ 0 1 = 2 20 = −1 una solución del mismo es y() = (sin cos ) , es decir, 1 () = sin e 2 () = cos . Por otra parte, recordemos una noción de básica del álgebra lineal. Si tenemos vectores cuyas componentes son funciones y1 y2 y , se dicen linealmente independientes si para toda combinación lineal 1 · y1 + 2 · y2 + + · y = 0 donde ∈ R, 1 ≤ ≤ , y 0 es el vector que tiene a la función nula en cada componente, entonces necesariamente = 0, 1 ≤ ≤ . Vamos a empezar el estudio de los sistemas homogéneos, empezando por el siguiente resultado. Las demostraciones de los siguientes resultados están basados en el Teorema 16. Theorem 17 El conjunto de soluciones del sistema homogéneo y0 = A() · y (2.2) tiene estructura de espacio vectorial de dimensión sobre R, esto es, cualquier solución y del mismo es de la forma y = 1 · y1 + 2 · y2 + + · y donde 1 2 ∈ R e y1 y2 y son soluciones linealmente independientes del mismo. Proof. En primer lugar, veamos que cualquier combinación lineal de soluciones del sistema (2.2) es una solución del mismo. Para ello, sean y1 y2 y soluciones de (2.2) y 1 2 ∈ R. Consideramos el vector de funciones z = 1 · y1 + 2 · y2 + + · y y derivamos respecto de la variable independiente (notar que z = z()), obteniéndose, por ser y1 y2 y soluciones de (2.2) que z0 = = = = 1 · y10 + 2 · y20 + + · y0 1 · A() · y1 + 2 · A() · y2 + + · A() · y A() · [1 · y1 + 2 · y2 + + · y ] A() · z que prueba que z es solución. Sea ahora C = {u1 u2 u } la base canónica de R , es decir, para cada ∈ {1 2 }, u es el vector de R que tiene 0 en todas las componentes salvo en la —ésima, donde tiene un 1. Sea 0 29 Estabilidad de ecuaciones diferenciales un número real y supongamos que A() está definida en 0 (ver Teorema 16). Para cada 1 ≤ ≤ , consideramos el problema de condiciones iniciales ½ 0 y = A() · y; y(0 ) = u En virtud del Teorema 16, para cada ∈ {1 2 } existe una única solución de dicho problema, que denotaremos por y , definida en 0 . Vamos a ver que B = {y1 y2 y } forman una base del conjunto de soluciones del sistema 2.2. Veamos primero que son linealmente independientes. Para ello sea 1 · y1 + 2 · y2 + + · y = 0. Particularizamos en 0 y obtenemos que 1 · y1 (0 ) + 2 · y2 (0 ) + + · y (0 ) = 0(0 ) = 0, y por ser cada y solución del problema de condiciones iniciales, y (0 ) = u , 1 ≤ ≤ , de donde 1 · u1 + 2 · u2 + + · u = 0 Como los vectores u son los elementos de la base canónica de R , son linealmente independientes y por tanto = 0, 1 ≤ ≤ , de donde y1 y2 y son linealmente independientes. Acto seguido, vamos a ver que B es un sistema generador del conjunto de soluciones del sistema (2.2). Para ello sea z una solución arbitraria del sistema (2.2). Sea 0 el número real del apartado anterior. Como C es una base de R , se verifica que existen 1 2 ∈ R tales que z(0 ) = 1 · u1 + 2 · u2 + + · u Sea el vector de funciones z1 = 1 · y1 + 2 · y2 + + · y y consideremos el problema de condiciones iniciales ½ 0 y = A() · y; y(0 ) = z(0 ) Claramente tanto z como z1 son soluciones de dicho problema. Como la solución es única en virtud del Teorema 16, se tiene que z = z1 = 1 · y1 + 2 · y2 + + · y por lo que B también es un sistema generador y la demostración concluye. Aunque el resultado anterior caracteriza las soluciones del sistema homogéneo, el cálculo explícito de las soluciones dista mucho de estar al alcance. Un primer avance en el objetivo del cálculo de las soluciones lo proporciona el determinante wronskiano, definido de la manera siguiente. 30 Estabilidad de ecuaciones diferenciales Dadas y1 y2 y : ⊂ R → R se define su determinante wronskiano como la función real [y1 y2 y ] : ⊂ R → R definida todo ∈ como [y1 y2 y ]() := |y1 (); y2 (); ; y ()| El determinante wronskiano resulta ser útil a la hora de determinar si soluciones del sistema homogéneo son o no linealmente independientes, como pone de manifiesto el siguiente resultado. Proposition 18 Sean y1 y2 y : ⊂ R → R soluciones del sistema homogéneo y0 = () · y. Son equivalentes: (a) y1 y2 y son linealmente independientes. (b) [y1 y2 y ]() 6= 0 para todo ∈ . (c) Existe 0 ∈ tal que [y1 y2 y ](0 ) 6= 0. Proof. Veamos en primer lugar que (a) implica (b). Procedemos por reducción al absurdo suponiendo que (b) es falso, esto es, existe 0 ∈ tal que [y1 y2 y ](0 ) = 0. Entonces los vectores de R son linealmente dependientes, es decir, existen 1 2 ∈ R, no todos nulos, tal que 1 · y1 (0 ) + 2 · y2 (0 ) + + · y (0 ) = 0 Consideremos el problema de condiciones iniciales ½ 0 y = A() · y; y(0 ) = 0 Obviamente el vector de funciones 0 (cuyas componentes son la función nula) es solución de dicho problema. Por otra parte, procediendo como en el final de la demostración del Teorema 2.18, vemos que la función z = 1 · y1 + 2 · y2 + + · y también es solución de dicho problema. Como la solución debe ser única por el Teorema 16, tenemos que z = 0 = 1 · y1 + 2 · y2 + + · y Como los escalares no eran todos nulos, tenemos que las funciones y1 y2 y no pueden ser linealmente independientes, lo que nos lleva a una contradicción. (b) implica (c) es trivial. La demostración de (c) implica (a) es análoga a la demostración del Teorema 2.18, cuando se comprueba que las funciones son linealmente independientes. Ahora bien, seguimos todavía muy lejos de resolver un sistema homogéneo. De hecho, los métodos que permitirán dar soluciones explícitas a los sistemas planteados tendrán que esperar a los próximos temas. La teoría general, en lo que a la estructura de las soluciones, queda cerrada al establecer la siguiente caracterización de los sistemas no homogéneos. 31 Estabilidad de ecuaciones diferenciales Theorem 19 El conjunto de soluciones del sistema y0 = A() · y + b() (2.3) es de la forma y = 1 · y1 + 2 · y2 + + · y + y donde 1 2 ∈ R, y1 y2 y son soluciones linealmente independientes del problema homogéneo e y es una solución particular del problema no homogéneo. Proof. Sea y una solucion particular del sistema (2.3) y sea y otra solución. Consideremos el vector de funciones z = y − y y veamos que es solución del sistema homogéneo asociado a (2.3). Para ello calculamos z0 = = = = y0 − y0 A() · y + b() − [A() · y +b()] A() · [y − y ] A() · z Por el Teorema 2.2, existen soluciones del sistema homogéneo asociado linealmente independientes y1 y2 y tales que z = 1 · y1 + 2 · y2 + + · y donde 1 2 ∈ R. Teniendo en cuenta la definición de z concluimos que y = 1 · y1 + 2 · y2 + + · y + y con lo que se concluye la demostración. 2.1.2. Teoría general para ecuaciones lineales de orden Una ecuación diferencial de orden 1 es una expresión de la forma ) = ( 0 −1) ) (2.4) donde : ⊆ R+1 → R. Esta ecuación puede transformarse en un sistema de ecuaciones diferenciales de orden uno de la manera siguiente. Introducimos las variables dependientes 1 = , 2 = 0 , 3 = 00 ,..., = −1) y entonces la ecuación (2.4) puede escribirse como el sistema ⎧ 0 1 = 2 ⎪ ⎪ ⎪ ⎪ ⎨ 20 = 3 ⎪ ⎪ 0 = ⎪ ⎪ ⎩ −1 0 = ( 1 2 ) Por ejemplo, la ecuación de orden tres 3) = + 0 − 00 32 Estabilidad de ecuaciones diferenciales puede escribirse como el sistema ⎧ 0 ⎨ 1 = 2 0 = 3 ⎩ 20 3 = + 1 2 − 3 De aqui se ve que para tener un problema de condiciones para la ecuación, necesitamos condiciones iniciales 1 (0 ) = (0 ) = 0 , 2 (0 ) = 0 (0 ) = 00 ,..., (0 ) = −1) (0 ) = 0−1 , es decir, necesitamos conocer el valor de la función y de las sucesivas derivadas hasta la − 1 en un punto 0 . Entonces, en virtud del Teorema 15 vemos que si es continua y las derivadas , 1 ≤ ≤ , son continuas, el problema de condiciones iniciales tiene solución única. Por ejemplo, el problema de condiciones iniciales ½ 3) = + 0 − 00 (0) = 0 0 (0) = 1 00 (0) = 2 tiene solución única. Nos ocuparemos expecialmente de ecuaciones diferenciales de orden que llamaremos lineales y que a continuación describimos. Por una ecuación diferencial lineal de orden entenderemos una expresión de la forma () ) + −1 () −1) + + 1 () 0 + 0 () = () (2.5) donde para 0 ≤ , y son funciones reales de variable real definidas en un intervalo de la recta real . Siempre que () sea diferente de cero, podemos escribir la ecuación como ) + −1 () −1) + + 1 () 0 + 0 () = () (2.6) donde () = () (), 0 ≤ , y () = () (). Por ejemplo, las ecuaciones 000 + 2 0 = 00 + 2 0 + = 6) − 7 3) + 2 00 + (log ) = 0 son ecuaciones lineales de órdenes tres, dos y seis, respectivamente. Como hemos visto anteriormente, una ecuación de orden puede escribirse como el sistema ⎧ 0 1 = 2 ⎪ ⎪ ⎪ ⎪ ⎨ 20 = 3 ⎪ ⎪ 0 = ⎪ ⎪ ⎩ −1 0 = () − [−1 () + + 1 ()2 + 0 ()1 ] que en forma matricial se escribe como y0 = A() · y + b() donde ⎛ ⎜ ⎜ A() = ⎜ ⎜ ⎝ 0 1 0 0 0 0 1 0 0 0 0 1 −0 () −1 () −2 () −3 () 33 0 0 0 −−1 () ⎞ ⎟ ⎟ ⎟ ⎟ ⎠ Estabilidad de ecuaciones diferenciales y b() = (0 0 0 ()) . Diremos entonces que la ecuación (3.1) es homogénea o no homogénea según se sea b() nulo o no, es decir, si () = 0 para todo . Además, la ecuación se dirá de coeficientes constantes cuando A() sea constante, es decir, cuando () = ∈ R para todo 0 ≤ . Tanto los Teoremas 2.18 y 2.19 como la Proposición 18 admiten la siguiente lectura en términos de ecuaciones lineales. A la vista de que cualquier ecuación lineal puede escribirse como un sistema añadiendo las derivadas como funciones, cualquier solución del sistema y es de la forma ( 0 −1 ), donde : ⊆ R → R es una función suficientemente derivable. En esta línea, destacamos entonces que el wronskiano puede escribirse como [1 2 ]() = [y1 y2 y ]() := |y1 (); y2 (); ; y ()| ¯ ¯ ¯ 1 () 2 () ¯ () ¯ ¯ 0 0 0 ¯ 1 () 2 () ¯ () ¯ = ¯¯ ¯ ¯ −1) ¯ −1) −1) ¯ ¯ () () () 1 2 donde 1 2 son las primeras componentes de y1 y2 y . Podremos enunciar entonces los siguientes resultados. Theorem 20 El conjunto de soluciones de la ecuación homogénea ) + −1 () −1) + + 1 () 0 + 0 () = 0 tiene estructura de espacio vectorial de dimensión sobre R, esto es, cualquier solución de la misma es de la forma = 1 · 1 + 2 · 2 + + · donde 1 2 ∈ R e 1 2 son soluciones linealmente independientes del mismo. Proposition 21 Sean 1 2 : ⊂ R → R soluciones de la ecuación homogénea ) + −1 () −1) + + 1 () 0 + 0 () = 0 Son equivalentes: (a) 1 2 son linealmente independientes. (b) [1 2 ]() 6= 0 para todo ∈ . (c) Existe 0 ∈ tal que [1 2 ](0 ) 6= 0. Theorem 22 El conjunto de soluciones de la ecuación ) + −1 () −1) + + 1 () 0 + 0 () = () es de la forma = 1 · 1 + 2 · 2 + + · + donde 1 2 ∈ R, 1 2 son soluciones linealmente independientes del problema homogéneo e es una solución particular del problema no homogéneo. 34 Estabilidad de ecuaciones diferenciales 2.2. Resolución desistemas lineales de coeficientes constantes Vamos a considerar sistemas de la forma y0 = A · y + b() (2.7) donde A = ( )1≤≤ 1≤≤ es una matriz cuadrada, b() = (1 () 2 () ()) donde para 1 ≤ ≤ , son funciones reales definidas sobre un intervalo de la recta real e y = (1 2 ) . Los métodos que vamos a estudiar son matriciales por lo que es necesario tener frescos conceptos sobre la teoría de matrices y especialmente con la diagonalización de éstas. 2.2.1. Resolución del sistema homogéneo Vamos a introducir un método matricial para la resolución de sistemas de ecuaciones lineales con coeficientes constantes que puede verse en [DeGr, pg. 384—402] y que está basado en el cálculo de la exponencial de una matriz utilizando el Teorema de Cayley—Hamilton. Explicaremos en primer lugar en qué consiste el Teorema de Cayley—Hamilton y posteriormente introduciremos la exponencial de una matriz, que nos va a proporcionar la solución de sistemas homogéneos de la forma y0 = A · y donde A = ( )1≤≤ 1≤≤ es una matriz cuadrada. Teorema de Cayley—Hamilton −1 + + 1 + 0 , Supongamos que A = ( )1≤≤ 1≤≤ es una matriz cuadrada y () = + −1 es un polinomio de coeficientes reales. Si intercambiamos por A construimos lo que denominaremos un polinomio matricial (A) = A + −1 A−1 + + 1 A + 0 I Nótese que el término independiente del polinomio aparece multiplicado por la matriz identidad I . Por ejemplo, si µ ¶ 1 2 A= 3 4 y () = 3 + 2 − 1, entonces (A) = A3 + 2A − I2 ¶ ¶3 ¶ µ µ µ 1 0 1 2 1 2 − = +2 0 1 3 4 3 4 ¶ µ 38 58 = 87 125 El Teorema de Cayley—Hamilton afirma lo siguiente. Theorem 23 (Cayley—Hamilton). Sea A = ( ) una matriz cuadrada y sea () = |A − · I | su polinomio característico. Entonces (A) = 0. 35 Estabilidad de ecuaciones diferenciales Demostración. Como sabemos del tema inicial, |A − · I | · I = () · I = (A − · I ) · (A − · I ) donde (A − · I ) es la matriz traspuesta de la adjunta de A − · I . Entonces (A − · I ) = ( ()), donde () son polinomios reales en de grado a lo sumo − 1. Podemos reordenar dicha matriz como (A − · I ) = B1 · −1 + B2 · −2 + + B−1 · + B donde B ∈ M× (R). Entonces () · I = (B1 · −1 + B2 · −2 + + B−1 · + B ) · (A − · I ) = −B1 · + (B1 · A − B2 ) · −1 + + (B−1 · A − B ) · + B · A de donde sustituyendo por la matriz A tenemos (A) = (A) · I = −B1 · A + (B1 · A − B2 ) · A−1 + + (B−1 · A − B ) · A + B · A = 0 con lo que termina la demostración.¤ A modo de ejemplo, dada la matriz anterior, su polinomio característico es () = 2 − 5 − 2 y si calculamos (A) = A2 − 5A − 2I2 ¶ ¶ µ ¶ µ µ 2 0 5 10 7 10 − − = 0 2 15 20 15 22 µ ¶ 0 0 = 0 0 Este teorema será clave para poder obtener una fórmula que permita resolver sistemas de ecuaciones diferenciales lineales con coeficientes constantes. El polinomio característico de una matriz cuadrada A no tiene porqué ser el de menor grado que satisfaga el teorema de Cayley—Hamilton. Un polinomio () se dice mínimo para la matriz cuadrada A si (A) = 0. En general se sabe que () divide al polinomio característico de A, es decir, dicho polinomio será de la forma () = ( − 1 )1 · · ( − ) donde , 1 ≤ ≤ son los valores propios de A y = 1 + + ≤ , donde es el grado del polinomio característico (). Como sabemos, para que la matriz A sea diagonalizable tiene que cumplirse que si () = (−1) ( − 1 )1 · · ( − ) entonces para cada valor propio debe cumplirse que su multiplicidad algebraica = dim Ker(A − · I ), donde Ker(A − · I ) es el subespacio propio asociado al valor propio . Esta condición es equivalente a que = 1, siendo el exponente del monomio − en el polinomio mínimo. 36 Estabilidad de ecuaciones diferenciales Veamos un par de ejemplos. Consideremos la matriz ⎛ ⎞ 0 1 1 A = ⎝ −1 2 1 ⎠ −1 1 2 que tiene valores propios 1 (doble) y 2 (simple). Esta matriz será diagonalizable si su polinomio mínimo es () = ( − 1)( − 2). Calculamos (A) = (A − I3 ) · (A − 2 · I3 ) = 0, por lo que dicha matriz es diagonalizable.Sin embargo ⎛ 1 1 A = ⎝ −1 2 0 1 la matriz ⎞ 0 1 ⎠ 1 tiene los mismos valores propios con las mismas multiplicidades y sin embargo ⎛ ⎞ −1 0 1 (A) = (A − I3 ) · (A − 2 · I3 ) = ⎝ 0 0 0 ⎠ −1 0 1 por lo que no puede ser diagnalizable. Además, si es valor propio de A, para comprobar la relación = dim Ker(A − · I ), basta comprobar que 1 (A) = 0, siendo 1 () = ( − ) 2.2.2. () ( − ) Resolución de sistemas. La exponencial de una matriz En esta sección vamos a obtener una fórmula para resolver sistemas de ecuaciones de la forma y0 = A · y (2.8) donde A es una matriz cuadrada de coeficientes reales. Para esto, debemos recordar un caso particular de éste cuando la matriz es de una fila y una columna, es decir, cuando tenemos la ecuación lineal homogénea de orden uno 0 = ∈ R En este caso, la solución general de esta ecuación es de la forma () = ∈ R Por analogía con el caso unidimensional, para el caso general la solución del sistema (2.8) va a ser de la forma y() = A· · C donde C es un vector columna constante y A· es la exponencial de la matriz A · definida por la serie ∞ X A · A· := ! =0 Para hacer más comprensible este capítulo, vamos a dar algunas nociones sobre la exponencial de una matriz. 37 Estabilidad de ecuaciones diferenciales La exponencial de una matriz Consideremos una matriz cuadrada A. Como hemos definido anteriormente, la exponencial de dicha matriz viene definida, en analogía con la exponencial de un número real, viene dada por la serie ∞ X 1 A = A · ! =0 donde supondremos que A0 = I . Esta serie siempre es convergente, es decir, para toda matriz cuadrada con coeficientes reales la serie anterior nos proporciona una matriz de coeficientes reales. Hay casos en los que es bastante sencillo calcular la exponencial de una matriz. Por ejemplo, si D = diag(1 ) es una matriz diagonal, entonces para todo número natural se tiene que D = diag(1 ) y entonces D = = ∞ X =0 ∞ X =0 D · 1 ! diag(1 ) · = diag Ã∞ X 1 =0 1 ! ∞ X =0 = diag( ) Por ejemplo, si 1 ! ! ! ⎛ ⎞ 1 0 0 D = ⎝ 0 2 0 ⎠ 0 0 −2 entonces ⎞ 0 0 D = ⎝ 0 2 0 ⎠ 0 0 −2 ⎛ Además, la exponencial de una matriz cumple la siguientes propiedades (que no justificaremos). Si A y B son matrices cuadradas que conmutan, esto es A · B = B · A, entonces A+B = A · B (2.9) Dado el vector columna C, la función y() = A· · C está definida para todo ∈ R, es derivable y y0 () = A· · C = A · A· · C = A · y() es decir, es solución del sistema de ecuaciones diferenciales lineales con coeficientes constantes (2.8). Ahora bien, consideremos el sistema µ 0 ¶ µ ¶ µ ¶ 1 1 1 1 = · 1 −1 20 2 38 Estabilidad de ecuaciones diferenciales La solución de este sistema es la matriz ⎛ ⎝ 1 1 1 −1 ⎞ ⎠ · µ 1 2 ¶ pero ¿cómo calculamos dicha matriz? A continuación vamos a ver un método basado en el Teorema de Cayley—Hamilton que permite hacer el cálculo con cierta facilidad, aunque los cálculos sean laboriosos. Cálculo práctico de la exponencial Para fijar ideas supongamos que () es el polinomio característico de la matriz A y que tiene raíces reales o complejas 1 2 con multiplicidades 1 2 . Buscamos entonces polinomios 1 () 2 () () con grado a lo sumo − 1 para cada 1 ≤ ≤ , de manera que se verifique la igualdad 1 () 2 () () 1 = + + + 1 2 () ( − 1 ) ( − 2 ) ( − ) de donde (2.10) 1 = 1 ()1 () + 2 ()2 () + + () () con () = ()( − ) , 1 ≤ ≤ . Sustituyendo en (2.10) por A tendremos I = 1 (A)1 (A) + 2 (A)2 (A) + + (A) (A) (2.11) Dado que para todo 1 ≤ ≤ ·I = ∞ X I =0 ( ) = · I · ! entonces A· = ·I (A− I )· = · ∞ X (A − I ) · ! =0 De aquí, multiplicando por la izquierda ambos miembros por (A) A· (A) = · = · ∞ X =0 X −1 =0 (A)(A − I ) · ! (A)(A − I ) · ! dado que por el Teorema de Cayley—Hamilton, para todo ≥ se tiene que (A)(A − I ) = (A)(A − I )− = 0. Multiplicando nuevamente por la izquierda por (A) obtendremos (A) (A)A· = · X −1 =0 (A) (A)(A − I ) · 39 ! (2.12) Estabilidad de ecuaciones diferenciales Sumando (2.12) desde 1 hasta y teniendo en cuenta (2.11) concluimos que la exponencial de la matriz puede calcularse con la fórmula à ! X −1 X A· = · (A) (A) (2.13) (A − I ) · ! =1 =0 Consideremos por ejemplo el sistema ½ 10 = 41 + 22 ; 20 = 31 + 32 La matriz asociada al sistema es A= µ 4 2 3 3 ¶ y el polinomio característico () = 2 − 7 + 6 que tiene por raíces 1 = 1 y 2 = 6. Calculamos ahora 1 y 2 a partir de 1 1 2 (1 + 2 ) − 61 − 2 = + = () −1 −6 () de donde obtenemos el sistema ½ 1 + 2 = 0 −61 − 2 = 1 que tiene por solución 1 = −15 y 2 = 15. Además 1 () = ()( − 1) = − 6 y 2 () = ()( − 6) = − 1 Aplicamos ahora la fórmula (2.13) y tenemos que A· = (−15I2 ) · I2 (A − 6I2 ) + 6 (15I2 ) · I2 (A − I2 ) ¶ µ 6 1 3 + 2 26 − 2 · = 36 − 3 26 + 3 5 La solución del sistema será ¶ µ 1 1 () = 2 () 5 1 = 5 esto es 1 () = ¶ µ ¶ 1 · · 2 µ 6 ¶ (31 + 22 ) + (21 − 22 ) · 6 (31 + 22 ) + (−31 + 32 ) µ 36 + 2 26 − 2 36 − 3 26 + 3 ¢ 1 ¡ 6 (31 + 22 ) + (21 − 22 ) 5 40 Estabilidad de ecuaciones diferenciales e ¢ 1 ¡ 6 (31 + 22 ) + (−31 + 32 ) 5 donde 1 y 2 son dos constantes reales. Si tuviésemos alguna condición inicial, por ejemplo, 1 (0) = 1 2 (0) = 0, entonces planteando el sistema 2 () = 1 (0) = 1 = 1 2 (0) = 2 = 0 obtendríamos que 1 1 () = (36 + 2 ) 5 e 1 2 () = (36 − 3 ) 5 es la única solución de dicho problema de condiciones iniciales. Consideremos ahora el sistema ½ 10 = 31 + 2 ; 20 = −1 + 2 ; cuyo polinomio característico asociado a la matriz A es () = 2 − 4 + 4, que tiene por solución la raíz doble = 2. Entonces 1 1 1 = = 2 () ( − 2) () de donde 1 = 1 y 1 = ()( − 2)2 = 1 Aplicando la fórmula (2.13) tenemos que A· 1 X = 1 (A)1 (A) (A − 2I2 ) · ! µ µ=0 ¶ ¶ 1 1 = 2 I I I + −1 1 ¶¶ µµ 1+ 2 = − 1 + 2 con lo que la solución del sistema µ ¶ µ ¶µ ¶ 1 () (1 + )2 1 2 = 2 () −2 (1 + )2 2 donde 1 y 2 son dos constantes reales (la expresión definitiva de 1 e 2 se deja como ejercicio al lector). Si por último tomamos el sistema ½ 10 = 31 − 52 ; 20 = 1 − 2 ; 41 Estabilidad de ecuaciones diferenciales podemos ver que el polinomio característico asociado a la matriz A es () = 2 − 2 + 2 que tiene por raíces los números complejos conjugados 1 = 1 + y 2 = 1 − . De la expresión 1 1 2 (1 + 2 ) + 1 (−1 + ) + 2 (−1 − ) = + = () ( − 1 − ) ( − 1 + ) () que da lugar al sistema ½ 1 + 2 = 0 1 (−1 + ) + 2 (−1 − ) = 1 que nos da como solución 1 = 1 2 y 2 = − 21 . Teniendo en cuenta que 1 () = − 1 + y 2 () = − 1 − se tiene aplicando la fórmula (2.13) 1 1 A· = (1+) · I2 (A − (1 − )I2 ) − (1−) · I2 (A − (1 + )I2 ) 2µ ¶ ¶¶ µ 2 µ 2+ −5 2− −5 1 − 1 − = 1 −2 + 1 −2 − 2 2 ⎞ ⎛ − − + − + −5 ⎟ ⎜ 2 2 2 2 = ⎝ − − − + ⎠ −2 + 2 2 2 ¶ µ 2 sin + cos −5 sin = · sin −2 sin + cos dado que cos = y + − 2 − − sin = 2 Entonces toda solución del sistema viene dada por la expresión ¶ µ ¶ ¶ µ µ 1 2 sin + cos −5 sin 1 () · = · sin −2 sin + cos 2 () 2 donde 1 y 2 son dos constantes reales. Los tres ejemplos anteriores resumen los casos que pueden darse para el caso de sistemas de dos ecuaciones con dos incógnitas, es decir, que el polinomio característico tenga dos soluciones reales distintas, una real doble o dos complejas conjugadas. Cuando el número de ecuaciones es mayor, pueden aparecer otros casos, pero básicamente la matriz exponencial contiene en sus coordenadas funciones de la forma cos() y sin() donde ≥ 0 y y son números reales. En cualquier caso, resolveremos sistemas que a lo sumo tienen cuatro ecuaciones con cuatro incógnitas, pues a partir de ese número de ecuaciones los cálculos suelen ser muy largos y engorrosos en general. 42 Estabilidad de ecuaciones diferenciales 2.2.3. El método de variación de constantes Volvamos ahora sobre el sistema no homogéneo (2.7) y supongamos conocida la solución general del sistema homogéneo asociado. Para terminar de resolver el sistema no homogéneo usaremos el método de variación de constantes. Para ello supongamos que la solución es de la forma y() = A· · C() donde C() es una función a determinar. Derivando respecto de obtendremos que y0 () = AA· · C() + A· · C0 () = A · y() + A· · C0 () Sustituyendo en el sistema no homogéneo tendremos A · y() + A· · C0 () = A · y() + b() o equivalentemente A· · C0 () = b() Dado que la matriz A· es invertible (recordar la Proposición 18) y teniendo en cuenta que A· · −A· = 0 = I concluimos que −A· es la inversa de A· y entonces Z C() = −A· · b() Una vez calculada C() obtenemos la solución del sistema no homogéneo. Por ejemplo, consideremos el sistema ½ 10 = 41 + 22 + ; 20 = 31 + 32 que también podemos escribir como µ 0 ¶ µ ¶ µ ¶ µ ¶ 1 4 2 1 = · + 0 3 3 2 2 0 Ya vimos que la exponencial de la matriz del sistema era ¶ µ 6 1 3 + 2 26 − 2 A· = · 36 − 3 26 + 3 5 por lo que a partir de (2.14) obtenemos ¶ µ ¶ µ ¶ Z µ −6 1 3 + 2− 2−6 − 2− 1 () · = −6 − −6 − 2 () − 3 2 + 3 0 5 3 ¶ Z µ −5 1 3 +2 = 3−5 − 3 5 ¶ µ R 1 R (3−5 + 2) = (3−5 − 3) 5 µ ¶ 1 −3−5 5 + 2 + 1 = 5 −3−5 5 − 3 + 2 43 (2.14) Estabilidad de ecuaciones diferenciales con lo que la solución µ 6 1 3 + 2 y() = · 36 − 3 5 µ 6 1 3 + 2 · = 36 − 3 25 ¶ µ 1 −3−5 5 + 2 + 1 · 5 −3−5 5 − 3 + 2 ¶ ¶ µ ¶ µ 1 1 10 − 3 26 − 2 · + · 3 − 15 26 + 3 2 25 26 − 2 26 + 3 ¶ Nótese que una solución particular del sistema es 1 y () = · 25 µ 10 − 3 3 − 15 ¶ por lo que haciendo = 5, = 1 2, tenemos que µ ¶ 1 A· + y () y() = 2 tal y como el Teorema 2.19 afirmaba. Si por ejemplo consideramos el problema de condiciones iniciales ⎧ 0 ⎨ 1 = 41 + 22 + ; 0 = 31 + 32 ; ⎩ 2 1 (0) = 0 2 (0) = 1; se verificará que µ 1 (0) 2 (0) ¶ = µ 0 1 ¶ 1 = 25 µ 1 2 ¶ 1 + 25 µ −3 3 ¶ de donde 1 = 3 y 2 = 22 de donde sustituyendo en la solución general concluimos que µ µ ¶ ¶ 1 1 () 136 + (10 − 13) = 2 () 25 136 + (12 − 15) es la única solución de dicho problema de condiciones iniciales. 2.3. Resolviendo sistemas mediante la transformada de Laplace Supongamos que tenemos un sistema de ecuaciones lineales de la forma y0 () = A · y()+f() 44 (2.15) Estabilidad de ecuaciones diferenciales donde A es una matriz cuadrada de filas por columnas con coeficientes reales, f = (1 2 ) donde son funciones dadas e y = (1 2 ) es la función vectorial incógnita. Supongamos además las condiciones iniciales (2.16) y(0) = y0 donde y0 = (10 20 0 ) con 0 números reales para 1 ≤ ≤ . Sea L[y]() = (L[1 ]() L[2 ]() L[ ]()) Entonces, tomando la Transformada de Laplace en (2.15) y teniendo en cuenta (2.16) obtenemos que L[y]() − y0 = A · L[y]() + L[f]() de donde, si I denota la matriz identidad, (I − A) · L[y]() = y0 + L[f]() y de aquí L[y]() = (I − A)−1 · (y0 + L[f]()) (2.17) Una vez calculada de este modo L[y]() obtendremos y tomando la Transformada inversa. Por ejemplo consideremos el sistema ¶µ µ 0 ¶ µ ¶ µ ¶ 1 1 2 −3 1 = + 3 2 0 20 2 junto con las condiciones iniciales µ 1 (0) 2 (0) ¶ = µ 2 −1 ¶ De (2.17) µ L[1 ]() L[2 ]() ¶ ¶−1 µ −2 3 = −3 − 2 µ 1 −2 = 2 3 − 4 + 13 à ! 2 µ = 2 −2 ( 2 −4+13) − 2 +8+3 ( 2 −4+13) 2 + 1 −1 −3 −2 ¶ ¶µ 2+1 −1 Entonces la solución del problema viene dada por ! à µ ¶ 2 −2 L−1 [ (22−4+13) ]() 1 () = − 2 +8+3 2 () L−1 [ ( 2 −4+13) ]() ¶ µ 1 282 cos(3) + 162 sin(3) − 2 = 13 282 sin(3) − 162 cos(3) + 3 45 ¶ Estabilidad de ecuaciones diferenciales 2.4. Problemas con funciones discontinuas Supongamos que el problema ½ 00 + = (); (0) = 0 0 (0) = 1; viene dada ahora con la función discontinua ½ si 0 ≤ () = cos(2) si ≥ Podemos escribir ahora ( 2 + 1)L[]() = 1 + L[]() Por otra parte () = (0 () − ()) + () cos(2) con lo que L[]() = L[0 ()]() + L[ ()]() + L[ () cos(2)]() Desarrollando cada sumando por separado, obtenemos L[0 ()]() = 1 2 L[ ()]() = L[( − ) ()]() + L[ ()]() − − + = 2 L[ () cos(2)]() = L[ () cos(2( − ))]() = − 2 +4 Combinando estas expresiones tenemos 2 + 1 ( + 1)L[ ]() + 1 = + − 2 2 µ ¶ 1 + + 2 2 + 4 Entonces 2 + 1 L[]() = 2 2 + − ( + 1) µ ¶ + + 2 ( 2 + 1) ( 2 + 1) ( 2 + 4)( 2 + 1) 1 y así ¸ ∙ ∙ ¸ ¸ 1 1 1 −1 − −1 − () = L () + L () + L () 2 2 ( 2 + 1) ( 2 + 1) ∙ ¸ −1 − () +L ( 2 + 4)( 2 + 1) = + 1 ( − ) () + 2 ( − ) () + 3 ( − ) () −1 ∙ 46 Estabilidad de ecuaciones diferenciales donde las funciones 1 , 2 y 3 se determinan de la siguiente manera. ∙ ∙ ¸ ∙ ¸ ¸ 1 1 1 −1 −1 −1 () − L () = L () = − sin 1 () = L 2 ( 2 + 1) 2 2 + 1 ∙ ∙ ¸ ∙ ¸ ¸ 1 −1 −1 1 −1 2 () = L () = L () − L () = 1 − cos ( 2 + 1) 2 + 1 ∙ ¸ () 3 () = L ( 2 + 4)( 2 + 1) ∙ ∙ ¸ ¸ 1 −1 1 −1 1 1 = L () − L () = cos − cos(2) 3 2 + 1 3 2 + 4 3 3 −1 Entonces 1 1 cos( − ) − cos(2 − 2)] 3 3 = (1 − ()) + ()[2 + sin + (3 − 1)3 cos − cos(2)3] () = + ()[( − ) − sin( − ) + − cos( − ) + o equivalentemente () = 2.5. ½ si 0 ≤ 2 + sin − (3 − 1)3 cos − cos(2)3 si ≥ Sistemas autónomos, puntos críticos y noción de estabilidad Consideremos un sistema de ecuaciones diferenciales y0 = f( y) donde f : Ω ⊆ R+1 → R es una función con regularidad suficiente para satisfacer la unicidad de soluciones para un problema de condiciones iniciales o de Cauchy. Si la variable independiente no aparece explícitamente en las ecuaciones del sistema, es decir, el sistema es de la forma y0 = f(y) donde f : Ω ⊆ R → R , se dice que el sistema de ecuaciones es autónomo. Por ejemplo, el sistema ½ 0 = − + 0 = es no autónomo mientras que o ½ 0 = − 0 = 0 = 4(1 − ) 47 (2.18) (2.19) Estabilidad de ecuaciones diferenciales son autónomos. Aunque estos sistemas pueden no ser fáciles de resolver, es sencillo encontrar determinadas soluciones particulares. Entre ellas destacan las soluciones constantes, cuyascondiciones iniciales vienen dadas por las soluciones del sistema algebraico f(y) = 0. Si y0 ∈ Ω y verifica que f(y0 ) = 0, entonces la solución constante de la forma y() = y0 es la única solución del problema de condiciones inciales ½ 0 y = f(y) y(0 ) = y0 para todo 0 ∈ R. Así, resolviendo el sistema ½ − = 0 = 0 vemos que (0 0) es el único punto crítico del sistema (2.18), mientras que al resolver la ecuación 4(1 − ) = 0 comprobamos que 0 y 1 son los puntos críticos de la ecuación (2.19). Como veremos posteriormente, estos puntos serán de gran importancia en el análisis de la estabilidad de un sistema. Veamos que se entiende por estabilidad. Definition 1 Sea el sistema autónomo y0 = f(y) (2.20) donde y = (1 2 ) y f : Ω ⊆ R → R es una función con funciones coordenadas 1 2 . Una solución y() de (2.20) definida para todo ≥ 0 se dice estable si para todo 0 existe 0 tal que si z() es otra solución que cumple la condición ||y(0) − z(0)|| entonces z() está definida para todo ≥ 0 y se verifica que ||z() − y()|| para todo ≥ 0. Si además se verifica que lı́m ||z() − y()|| = 0 →∞ la solución y() se dirá asintóticamente estable. La solución y() se dirá inestable si no es estable. Por ejemplo, consideremos la ecuación 0 = cuyas soluciones son de la forma () = 0 −0 48 Estabilidad de ecuaciones diferenciales para condiciones iniciales (0 ) = 0 . Claramente, para dos soluciones 1 () e 2 () se verifica que lı́m |2 () − 1 ()| = +∞ →+∞ por lo que dicha ecuación es iniestable en todas sus soluciones. Lo contrario ocurre con la ecuación 0 = − que es asintóticamente estable. Finalmente, dado que las soluciones del sistema ½ 0 = 0 = − son circunferencias concentricas con centro (0 0), se tiene que las soluciones del sistemas son estable aunque no asintóticamente estables. 2.6. Estabilidad de sistemas lineales Consideremos ahora un sistema lineal y0 = A · y donde la matriz A tiene filas y columnas. Aunque en este caso no disponemos de la representación de los diagramas de fases del mismo, sí que es posible determinar la estabilidad del mismo, con un resultado análogo al anterior. Para establecer el mismo, dada la matriz A, denotaremos por 1 los valores propios de A con multiplicidades 1 . Asímismo, denotaremos por 1 las dimensiones sobre C de los subespacios propios Ker(A − 1 I ) Ker(A − I ). Theorem 24 Sea el sistema lineal plano y0 = A · y, A ∈ × (R) no nula. Entonces (a) El sistema es estable si Re ≤ 0, 1 ≤ ≤ , y además si verifica que Re = 0, entonces = . (b) El sistema es asintóticamente estable si Re 0 para todo = 1 . (c) El sistema es inestable si o bien existe tal que Re = 0 y , o bien existe tal que Re 0. Example 1 Consideremos el sistema ⎧ 0 ⎨ = −3 + 2 + 2 0 = −2 + + 2 ⎩ 0 = −2 + 2 + Es fácil ver que 1 y −1 son los valores propios de la matriz asociada al sistema, por lo que en virtud del Teorema 24 (c), éste es inestable. Example 2 Sea ahora el sistema ⎧ 0 ⎨ = −2 + − 0 = − 2 − ⎩ 0 = − + − 2 Podemos ver ahora que los valores propios de la matriz asociada son −1, −2 y −3, por lo que por el Teorema 24 (b), el sistema es asintóticamente estable. 49 Estabilidad de ecuaciones diferenciales Example 3 Sea el sistema ⎧ 0 ⎨ = −4 + + 3 0 = 2 ⎩ 0 = −2 Puede comprobarse que ±2 y −4 son los valores propios de la matriz del sistema. Cómo las dimensiones de los subespacios propios de los valores propios ± son 1 y coincide con la multiplicidad de éstos, por el Teorema 24 (a) y (b) el sistema será estable, aunque no será asintóticamente estable. Exercise 1 Dados los siguientes sistemas lineales, decidir si son estables o no. ⎧ 0 ⎧ 0 ⎧ 0 ⎨ = −5 + − ⎨ = − − 2 ⎨ = − 5 + 5 0 0 = −2 − 2 + 2 (b) = −2 − 2 + 2 (c) 0 = 3 − 2 (a) ⎩ 0 ⎩ 0 ⎩ 0 = 3 − 3 + 3 = −3 + 3 − 3 = 4 + ⎧ 0 ⎧ 0 ⎧ 0 ⎨ = −5 + − ⎨ = −2 − 2 + 2 ⎨ = −9 + − 2 0 0 = 3 − 9 = −3 − + 3 0 = −2 − 2 + 2 (e) (f) (d) ⎩ 0 ⎩ 0 ⎩ 0 = 4 + + = −4 + 4 − 2 = 0 La aplicación del Teorema 24 tiene a priori un punto flaco puesto de manifiesto por el siguiente ejemplo. Consideremos el sistema ⎧ 0 ⎨ = −2 + − 2 0 = 3 − 9 ⎩ 0 = 4 + + Este sistema coincide con el del apartado (d) del ejercicio anterior en todos los coeficientes de la matriz asociada excepto el primero. El polinomio característico es () = −3 −102 −12−63, pero resolver la ecuación () = 0 no resulta sencillo, y quizás ni siquiera factible para los conocimientos de los que se disponen. Ahora bien, para aplicar el Teorema 24 en la mayoría de los casos sólo necesitamos conocer los signos de las partes reales de los valores propios de la matriz asociada. Para este objetivo podemos usar el siguiente criterio de Routh-Hurwitz que, aunque no siempre es aplicable, supone una gran ayuda para determinar al menos si el sistema es asintóticamente estable. Proposition 25 Sea () = (−1) + 1 −1 + + −1 + el polinomio característico de la matriz A ∈ × (R). Las raíces de () tienen parte real negativa si y sólo son estrictamente positivos los menores principales de la matriz ⎞ ⎛ 1 3 5 0 ⎜ 1 2 4 0 ⎟ ⎟ ⎜ ⎜ 0 1 3 0 ⎟ ⎟ ⎜ HA = ⎜ ⎟ 0 1 0 2 ⎟ ⎜ ⎝ ⎠ 0 0 0 Example 4 Consideremos el sistema ⎧ 0 ⎨ = 3 + − 2 0 = −3 − − ⎩ 0 = −4 − − 50 Estabilidad de ecuaciones diferenciales El polinomio característico de la matriz asociada es ⎛ 1 3 ⎝ 1 11 0 1 () = 3 + 11 + 2 − 3 y la matriz HA ⎞ 0 0 ⎠ 3 cuyos menores principales son 1, 8 y 24. Está claro entonces que todos los valores propios de la matriz A tienen parte real negativa, por lo que el sistema será asintóticamente estable. Además puede ser de utilidad el siguiente resultado que denominaremos Teorema de círculo de Gershgorin. Theorem 26 Sea A = ( ) ∈ M× (R) con valores propios 1 . Entonces todos los valores propios están en el conjunto del plano de la forma p p { + ∈ C : ( − 11 )2 + 2 1 } ∪ ∪ { + ∈ C : ( − )2 + 2 } donde = P =1 | | − | |, = 1 2 . Demostración. Si es valor propio de A con vector propio v = (1 ) ∈ C y = máx{| | : = 1 }. Definimos 1 u= · v = (1 ) que también es vector propio de tal que máx{| | : = 1 } = | | = 1. Entonces X 0 = 0 =1 con lo que X =1 6=0 Así 0 = ( − 0 0 )0 ¯ ¯ ¯ ¯ ¯X ¯ X X ¯ ¯ ¯ ¯ | − 0 0 | = ¯ 0 ¯ ≤ |0 || | ≤ |0 | = 0 ¯ =1 ¯ =1 =1 ¯6=0 ¯ 6=0 6=0 con lo que el resultado queda probado. Vemos cómo se aplica este resultado en el siguiente ejemplo. Example 5 Consideremos el sistema ⎧ 0 ⎨ = −4 + + 0 = −2 + ⎩ 0 = 4 − 5 51 Estabilidad de ecuaciones diferenciales El conjunto a que hace referencia el resultado anterior es p p p {( ) : ( + 4)2 + 2 2} ∪ {( ) : ( + 2)2 + 2 1}{( ) : ( + 5)2 + 2 4} que gráficamente representamos por por lo que todos los valores propios tienen parte real negativa y el sistema es por tanto asitóticamente estable. Exercise 2 Determinar si es posible la estabilidad asintótica de los siguientes sistemas ⎧ 0 ⎧ 0 ⎧ 0 5 − 14 + 14 ⎨ = −3 − + ⎨ = − 12 ⎨ = − 12 1 1 5 5 0 0 0 = − − 2 (b) = − 5 − = 12 − 13 − 12 (c) (a) 12 ⎩ ⎩ ⎩ 0 12 1 2 2 5 0 0 = 2 − 2 − = 2 − 2 − 4 = 3 − 3 − 6 2.6.1. ¿Por qué un sistema estable es útil en ingeniería? Supongamos que tenemos un sistema de ecuaciones diferenciales lineales no autónomo y0 = A · y + f() donde A ∈ × (R) y supongamos que el sistema autónomo asociado y0 = A · y es asintóticamente estable. Entonces toda solución del sistema autónomo y () = A· · C C ∈ R verifica que lı́m y () = 0 →∞ 52 Estabilidad de ecuaciones diferenciales Ahora bien, toda solución del sistema no autónomo es de la forma y() = y () + y () (2.21) donde y () es una solución particular del sistema no homogéneo. Si tomamos límites cuando tiende a infinito, tenemos que y() ' y () es decir, para tiempos grandes (aquí lo de grande depende de cada sistema) la solución del sistema no autónomo es básicamente la solución particular del mismo y la parte de la solución correspondiente al sistema homogéneo se va reduciendo con el tiempo. En ingeniería a la función f() se le llama entrada del sistema e y () es la salida del mismo. Si el sistema es estable, al variar la entrada, varía la salida sin que la parte homogénea intervenga en el proceso. Esto es lo que ocurre en la mayoría de los sistemas lineales utilizados en las ciencias experimentales, como en circuitos eléctricos o vibraciones mecánicas. 2.7. Funciones de transferencia. Estabilidad y control de sistemas lineales Supongamos un sistema dado por la ecuación ) + −1 −1) + + 1 0 + 0 = ) + −1 −1) + + 1 0 + 0 (2.22) donde , ∈ R para 0 ≤ ≤ y ∈ R para 0 ≤ ≤ . es una señal entrada del sistema e es la respuesta que produce en sistema a la excitación que representa. Aplicando formalmente la transformada de Laplace a (2.22) con todas las condiciones iniciales nulas obtenemos ()L[]() = () L[]() donde es un polinomio de grado y es un polinomio de grado . La función de transferencia del sistema, se define como L[]() () () = = L[ ]() () La estabilidad del sistema puede estudiarse a partir de los polos de la función de transferencia, entendiendo por estabilidad de un sistema lo siguiente. El sistema será asintóticamente estable si en ausencia de excitación ( = 0) y para cualquier condición inicial que consideremos se verifica que |()| → 0 si → +∞. Será estable si existen 0 y 0 0 tales que |()| si ≥ 0 . Finalmente es sistema es inestable si lı́m→+∞ |()| = +∞. Se tiene entonces el siguiente resultado. Theorem 27 Sea () = Q =1 ( − ) , P =1 = . Entonces el sistema (2.22) es (a) Asintóticamente estable si Re 0 para todo = 1 2 . (b) Estable si Re ≤ 0 y Re = 0 implica que la multiplicidad de es 1. (c) Inestable si no se cumplen algunas de las condiciones (a) o (b) anteriores. 53 Estabilidad de ecuaciones diferenciales Proof. Sean , 1 ≤ ≤ las raíces de () con multiplicidades . Para 1 ≤ ≤ , consideremos los polinomios Y () = ( − ) −1 ( − ) 1 ≤ ≤ 6= Es fácil comprobar que B = { () : 1 ≤ ≤ ; 1 ≤ ≤ } es una base del conjunto de polinomios con coeficientes en el cuerpo de los números complejos de grado a lo sumo − 1. Consideremos el problema de condiciones iniciales ) + −1 −1) + + 1 0 + 0 = 0 (2.23) (0) = 1 0 (0) = 2 −1) (0) = (2.24) donde 1 2 son números reales arbitrarios. Supongamos en primer lugar que Re 0 para todo = 1 2 . Entonces, sean cuales fueran las condiciones (2.24) se tiene que la solución del problema es de la forma () = X X =1 =1 = X X L−1 [1( − ) ]() =1 =1 −1 ( − 1)! donde los coeficientes , 1 ≤ ≤ , 1 ≤ ≤ vienen determinados a partir de las condiciones iniciales del problema. Como Re 0, es claro que lı́m→+∞ |()| = 0. Supongamos ahora que existe ∈ {1 2 } de manera que Re 0. Como B es una base, existen condiciones iniciales de manera que para las mismas la solución () contiene un término de la forma L−1 [1( − )]() = con ∈ C \ {0}. Entonces claramente lı́m→+∞ |()| = +∞. Consideremos ahora que toda raíz de (), con Re = 0 tiene multiplicidad uno ( = 1) y las restantes raíces tienen parte real negativa. Entonces para cualquier condición inicial la solución () verifica que si Re = 0, entonces existe ∈ C tal que L−1 [1( − )]() = = (cos( Im ) + sin( Im )) aparece en la solución. Teniendo en cuenta que todas las raíces tienen parte real menor o igual que cero y el primer apartado, existirá 0 tal que si es suficientemente grande se verifica X | | + |()| ≤ Re =0 lo que prueba que el sistema es estable. 54 Estabilidad de ecuaciones diferenciales Por último, supongamos que existe una raíz de (), con Re = 0 y con multiplicidad mayor que uno. En estas condiciones existen condiciones iniciales de manera que () contiene un término no nulo de la forma L−1 [1( − )2 ]() = = (cos( Im ) + sin( Im )) obviamente lı́m→+∞ |()| = +∞. 2.8. 2.8.1. Estabilidad local de sistemas autónomos Método de linealización de Lyapunov. Teorema de Hartman—Grobman Analizaremos a continuación la estabilidad de puntos críticos de sistemas autónomos mediante un método que es comúnmente usado en las ciencias experimentales, el método de linealización. Supongamos un sistema autónomo y0 = f(y) (2.25) con f definido sobre el abierto Ω ⊆ R y sea y0 ∈ R un punto crítico aislado del mismo (un punto crítico es aislado si existe 0 tal que la bola abierta de centro y0 y radio no contiene puntos críticos aparte de y0 ). Consideremos el sistema linealizado dado por y0 = Jf(y0 ) · y (2.26) donde Jf(y0 ) es la matriz Jacobiana de f en el punto y0 . Por ejemplo consideremos el sistema ½ 0 = 2 + 2 + 2 0 = −23 + 2 Es evidente que (0 0) es un punto crítico del sistema. La matriz Jacobiana en (0 0) es ¶ µ 2 0 Jf(0 0) = 0 2 y el sistema linealizado será ½ 0 = 2 0 = 2 Es de esperar que localmente (cerca del punto crítico y0 ), el comportamiento asintótico de los sistemas (2.25) y (2.26) sea parecido. Este parecido se precisará con el Teorema de Hartman—Grobman, para cuya compresión necesitaremos algunas definiciones previas. En primer lugar necesitamos una herramienta para comparar localmente sistemas autónomos. Esta herramienta es la conjugación topológica [Jim, pag. 239]. Los sistemas (2.25) y (2.26) se dice topológicamente conjugados si existe una aplicación continua, biyectiva con inversa continua h : Ω → R verificando la condición h(y( y0 )) = z( h(y0 )) para todo y0 ∈ Ω [aquí z( h(y0 )) representa la solución maximal de (2.26) con condición inicial h(y0 )]. Si existen abiertos de R y de manera que son topológicamente conjugados los sistemas restringidos a estos abiertos, entonces los sistemas 55 Estabilidad de ecuaciones diferenciales (2.25) y (2.26) se dirán localmente topológicamente conjugados. Para entendernos, una conjugación topológica lleva órbitas de un sistema en órbitas del otro sistema, preservando la orientación temporal. La segunda definición que interviene en el enunciado del Teorema de Hartman—Grobman es el de punto crítico hiperbólico. Con la notación anterior y0 se dice hiperbólico si los valores propios de la matriz Jacobiana Jf(y0 ) tienen parte real no nula. En caso contrario y0 se dirá no hiperbólico. En el ejemplo anterior, el valor propio de la matriz Jacobiana es 2 con multiplicidad 2, por lo que (0 0) es un punto crítico hiperbólico. Theorem 28 (Hartman—Grobman) Sea y0 un punto aislado crítico hiperbólico de (2.25). Entonces existen entornos de y0 y de 0 tales que los sistemas (2.25) y (2.26) son localmente topológicamente conjugados. En virtud del teorema anterior sabemos que los sistemas ½ y 0 = 2 + 2 + 2 0 = −23 + 2 ½ 0 = 2 0 = 2 son localmente topológicamente conjugados en un entorno del punto (0 0). Así, si el diagrama de fases del sistema linealizado es sin conocer exactamente las órbitas del sistema no linealizado sabemos que cerca de (0 0) se obtienen “deformando” de forma continua las órbitas del sistema linealizado, como por ejemplo muestra la 56 Estabilidad de ecuaciones diferenciales siguiente figura: Obsérvese como en el dibujo las rectas del sistema linealizado son deformadas y transformadas en curvas. Además, como la orientación temporal se conserva, la estabilidad del punto crítico puede estudiarse a partir del sistema no linealizado. Así, el punto crítico (0 0) es inestable para el sistema no linealizado dado que es inestable para el sistema linealizado. Hemos de enfatizar el carácter local del Teorema de Hartman—Grobman. Por ejemplo consideramos el sistema ½ 0 = − (2.27) 0 = 1 − 2 − 2 con dos puntos críticos hiperbólicos, (0 1) y (0 −1). A partir del resultado anterior vemos que (0 1) es asintóticamente estable y (0 −1) es inestable, pero obviamente el sistema (2.27) no puede ser globalmente conjugado a los sistemas y0 = Jf(0 1) · y o y0 = Jf(0 −1) · y, dado que éstos sólo tienen un punto crítico. Exercise 3 Obtener los puntos críticos de los siguientes sistemas y determinar si son o no hiperbólicos: ½ 0 ½ 0 ½ 0 ½ 0 = − = = − = (a) (b) (c) (d) 0 2 0 3 0 = − + = − + =− 0 = 3 ½ 0 ½ 0 ½ 0 = − = − = −2 + − + (e) (f) (g) 0 = + − 0 = 1 − 2 − 2 0 = −2 + 2 + − 4 + 2 Exercise 4 Determinar las isoclinas de los sistemas del ejercicio 3, así como la dirección del vector velocidad a las órbitas en las regiones que las isoclinas determinan. Exercise 5 Obtener el sistema linealizado en los puntos críticos de los sistemas del ejercicio 3. Determinar su diagrama de fases e indicar si es posible la naturaleza del punto crítico en un entorno del mismo. Exercise 6 Esbozar el diagrama de fases de los siguientes sistemas no lineales: ½ 0 ½ 0 ½ 0 = (2 − ) = = (a) (b) (c) 0 0 2 = ( − 2)( − 2) = 0 = 2 57 Estabilidad de ecuaciones diferenciales Exercise 7 Consideremos la ecuación de Van Der Pol 00 + − 0 (1 − 2 ) = 0 donde es un parámetro real. Transformar dicha ecuación en un sistema plano y determinar los puntos críticos del mismo. Determinar la naturaleza de los puntos críticos en función del parámetro . Exercise 8 Idem para la ecuación 00 + 20 + (1 − 2 ) = 0 Exercise 9 Sea el sistema ½ 0 = + ( + 1) 0 = 2( − 1) + donde es un parámetro real. Se pide: (a) Discutir la estabilidad de los puntos de equilibrio del sistema en función del parámetro . (b) Esbozar el diagrama de fases del sistema para el valor = 1. 2.8.2. El método directo de Lyapunov Aunque el Teorema de Hartman—Grobman proporciona una herramienta útil para distinguir la estabilidad de puntos críticos hiperbólicos, resulta ineficaz para tratar la misma cuestión con puntos críticos no hiperbólicos. Una opción alternativa válida también en el caso de no hiperbolicidad es el método directo de Lyapunov, de clara inspiración física. Consideremos nuevamente el sistema autónomo y0 = f(y) (2.28) y sea y0 un punto crítico, hiperbólico o no, del mismo. El método directo de Lyapunov consiste en encontrar una función escalar : → R, con un entorno de y0 , satisfaciendo ciertas condiciones. Esta función puede ser considerada como una medida de la “energía potencial” del sistema, de manera que a lo largo de las órbitas ésta decrece cuando → ∞, indicando estabilidad, o bien crece, indicando inestabilidad. Precisemos a continuación estas ideas. Dada una solución y = (1 2 ) de (2.28), la derivada de a lo largo de y() es X (y()) X (y()) 0 () = (y()) = grad (y()) · f(y()) (y()) = =1 =1 donde f = (1 2 ) y grad denota el gradiente de . Definimos entonces la derivada total de como (y) := grad (y) · f(y) El siguiente resultado nos garantiza la estabilidad del punto crítico en cuestión. 58 Estabilidad de ecuaciones diferenciales Theorem 29 Sean y0 un punto crítico del sistema (2.28) y : → R, con un entorno de y0 , continua en y derivable en \{y0 }. Supongamos que (y0 ) = 0 y (y) 0 para todo y ∈ \{y0 }. Entonces (a) Si (y) ≤ 0 para todo y ∈ \ {y0 }, entonces y0 es estable. (b) Si (y) 0 para todo y ∈ \ {y0 }, entonces y0 es asintóticamente estable. Si satisface las condición (a) [resp. (b)] del resultado anterior, se dirá una función de Lyapunov para y0 [resp. una función de Lyapunov estricta para y0 ]. Por ejemplo, el sistema ½ 0 = − 3 0 = − Es claro que (0 0) es un punto crítico aislado del sistema. La matriz Jacobiana en dicho punto es ¶ µ 0 1 Jf(0 0) = −1 0 que como puede comprobarse tiene por valores propios ±, por lo que dicho punto crítico no es hiperbólico. Vamos a comprobar que la función ( ) = 2 + 2 es una función de Lyapunov estricta para el mismo, por lo que (0 0) será un punto crítico asintóticamente estable. En primer lugar, está claro que (0 0) = 0 y ( ) 0 para todo ( ) ∈ R2 \ {(0 0)}. Por otra parte, la derivada total es ( ) = grad ( ) · f( ) = (2 2) · ( − 3 −) = −24 ≤ 0 para todo ( ) ∈ R2 \ {(0 0)}. En virtud del Teorema 29 el punto crítico es estable. También la inestabilidad de los puntos críticos puede ser discutida, según muestra el siguiente resultado. Theorem 30 Sean y0 un punto crítico del sistema (2.28) y un abierto de R conteniendo a y0 en su frontera Fr(). Supongamos que existe una función : → R, con un entorno de y0 , con ∪ Fr() ⊂ , de clase 1 y tal que (y) 0 y (y) 0 para todo y ∈ , y (y) = 0 si y ∈ Fr(). Entonces y0 es inestable. Consideremos ahora el sistema ½ 0 = + 3 0 = Sea la función : ⊂ R2 → R, donde = {( ) ∈ R2 : 0 || } y ( ) = 2 − 2 . Es fácil darse cuenta de que ( ) 0 para todo ( ) ∈ , y que la derivada total ( ) = grad ( ) · f( ) = (2 −2) · ( + 3 ) = 24 0 para todo ( ) ∈ . Además (0 0) ∈ Fr() y ( ) = 0 para todo ( ) ∈ Fr(). Por el Teorema 30 el punto crítico (0 0) es inestable. La principal desventaja de este método, que de hecho hace que su utilización sea cuando menos limitada, es la dificultad en encontrar la función . 59 Estabilidad de ecuaciones diferenciales Exercise 10 Sea el sistema ½ 0 = − + 2( + )2 0 = − 3 + 2 3 ( + )2 Determinar los puntos críticos del mismo y su hiperbolicidad. Determinar la naturaleza del punto crítico (0 0) a partir de la función ( ) = 12 (2 + 2 ). Exercise 11 Idem para el sistema ½ y la función ( ) = 14 4 + 12 2 . Exercise 12 Idem con el sistema ½ y la función ( ) = 12 (2 + 2 ). 0 = − 2 0 = −3 0 = 3 − − 0 = Exercise 13 Idem con el sistema ½ 0 = + 2 + + 2 0 = 2 + + 2 y la función ( ) = 2 − 2 definida sobre el conjunto del plano real = {( ) ∈ R2 : 0 || }. Exercise 14 Un sistema ½ 0 = 1 ( ) 0 = 2 ( ) ( ) y 2 ( ) = se dice Hamiltoniano si existe una función derivable ( ) tal que 1 ( ) = − ( ), de tal manera que es una integral primera del sistema. Se puede comprobar que para un punto crítico de un sistema Hamiltoniano, las funciones de Lyapunov pueden construirse sumando una constante a la función . Con esta idea, verificar el carácter de los puntos críticos del sistema ½ 0 = − 2 0 = − 2 2.9. Ejercicios 1. Resolver los siguientes sistemas de ecuaciones lineales de la forma y0 = A · y donde la matriz A es la siguiente: ⎞ ⎛ ¶ ¶ µ µ 3 −1 1 1 −2 1 −5 ⎝ ⎠ −1 5 −1 (a) (c) (b) 2 −2 2 −1 1 −1 3 60 Estabilidad de ecuaciones diferenciales (d) ⎛ µ −3 −1 1 −1 ¶ (e) µ 2 1 ⎞ ⎛ −1 1 1 0 ⎝ ⎠ ⎝ 1 −1 1 0 (g) (h) 1 1 1 2 ¶ ⎛ 0 1 −9 (f) ⎝ 1 0 8 1 1 ⎞ ⎛ 8 0 0 ⎠ ⎝ 0 −2 3 (i) 8 −2 3 ⎞ 1 1 ⎠ 0 ⎞ 1 1 0 1 ⎠ 1 0 2. Resolver los siguientes problemas de condiciones iniciales: ⎧ 0 ⎧ 0 ⎧ 0 ⎨ = −4( + ) ⎨ = 3 + 8 ⎨ = 0 0 0 = − + 4 = −4 0 = −3 − (b) (c) (a) ⎩ ⎩ ⎩ (0) = (0) = 1 (0) = 1 (0) = 0 (0) = 6 (0) = −2 ⎧ 0 ⎧ 0 =− =+ ⎪ ⎪ ⎪ ⎪ ⎨ 0 ⎨ 0 = 2 = − + (d) (e) 0 0 = + = − − ⎪ ⎪ ⎪ ⎪ ⎩ ⎩ (0) = −2 (0) = 2 (0) = −1 (0) = (0) = (0) = −1 3. Resolver los siguientes sistemas y problemas de condiciones iniciales ⎧ 0 ⎧ 0 ⎨ = + 2 ⎨ = 4 + 3 + 5 + sin 2 0 2 0 = − − 4 = −2 + 3 + (a) (b) ⎩ ⎩ 0 = 2 + 3 (0) = 1 (0) = −1 ⎧ 0 ⎛ ⎞ ⎛ ⎞ = 2 + − ⎪ ⎪ 2 −1 1 0 ⎨ 0 = −3 − + + (c) y0 = ⎝ 3 −1 2 ⎠ y+ ⎝ 1 ⎠ (d) 0 = 9 + 3 − 4 ⎪ ⎪ 2 −1 1 0 ⎩ (0) = (0) = 0 (0) = 3 ⎧ ⎧ 0 ¶ ¶ µ µ 0 −3 −1 ⎨ 0 ⎨ = −2 − 5 + y = + sin 2 −1 0 = + 2 + 2 (f) (e) ⎩ ⎩ (0) = −1 (0) = 0 (0) = 1 (0) = 0 61 Estabilidad de ecuaciones diferenciales 62 Capítulo 3 Ecuaciones en derivadas parciales Sumario. Definiciones básicas. Ecuaciones lineales de segundo orden: clasificación. Método de separación de variables. Series de Fourier. Resolución de las ecuaciones canónicas: calor, ondas y Laplace. 3.1. Introducción a las EDP Por una ecuación en derivadas parciales entederemos una expresión de la forma (1 1 1 ) = 0 donde 1 son variables independientes, = (1 ) es una variable dependiente (incógnita de la ecuación) y 1 son las derivadas parciales de de orden , 1 ≤ ≤ , respecto de las variables 1 . La derivada de mayor orden indica el orden de la ecuación. Por ejemplo + + = 0 es una ecuación de orden uno, mientras que − + · = es una ecuación de orden dos, que será el orden máximo que estdiaremos en este curso. Las ecuaciones en derivadas parciales (EDP) se utilizan para modelar procesos que además de tener una variación temporal, tienen una variación de tipo espacial. Ejemplos conocidos son la variación de calor con el tiempo en un sólido, la distribución de poblaciones en un cierto habitat o la propagación del sonido de las cuerdas de una guitarra. En general, las EDP van a ser bastante difíciles de resolver. De hecho, no existe un teorema de existencia y unicidad "sencilloçomo el que se estudiaba para problemas de condiciones iniciales de sistemas de ecuaciones diferenciales ordinarias. Por todo ello, las EDP son fuente de estudio en la actualidad para muchos matemáticos siendo una de las áreas de la matemáticas con mayor investigación en la actualidad. Como ocurre con las ecuaciones diferenciales, normalmente se suelen asociar varios tipos de condiciones a una EDP. Según se trate, hablaremos de ellas como condiciones iniciales o condiciones de 63 Ecuaciones en derivadas parciales contorno. Consideremos por ejemplo el problema siguiente ⎧ ⎨ = 0 ∈ (0 1) (0 ) = () ∈ [0 1] ⎩ ( 0) = ( 1) = 0 ≥ 0 que, como veremos posteriormente modela la varición temperatura de una varilla unidimensional de longitud 1 a lo largo del tiempo. La ecuación de segundo orden = 2 se conoce como ecuación del calor, que en este problema tiene asociados dos tipos de condiciones. La condición (0 ) = () establece la temperatura inicial de la varilla para todo punto de ésta ∈ [0 1], por lo que hablamos de ella como una condición inicial. Sin embargo, la condición ( 0) = ( 1) = 0 nos indica que los valores de la temperatura en los extremos de la varilla son fijos para cada instante de tiempo. Estas condiciones se llaman de frontera o contorno. 3.2. Ecuaciones de orden uno? 3.3. Ecuaciones lineales de orden 2 Una ecuación lineal de segundo orden es de la forma ( ) + ( ) + ( ) + ( ) + ( ) + ( ) = ( ) (3.1) donde : Ω ⊆ R2 → R son funciones de regularidad suficiente para cada problema que vayamos a estudiar. Es fácil comprobar que si 1 ( ) y 2 ( ) son soluciones de (3.1) para el caso homogéneo ( ) = 0, entonces una combinación lineal de ellas 1 ( ) + 2 ( ) ∈ R es también solución de la ecuación, por lo que ésta recibe el calificativo de lineal. Dicha ecuación se dirá de coeficientes constantes si las funciones son constantes. En este caso, se pueden introducir nuevas variables independientes y , y una nueva variable dependiente de manera que la ecuación (3.1) se escribe de una de las siguientes formas: + + = ( ) (3.2) − + = ( ) (3.3) + = ( ) (3.5) − = ( ) (3.4) donde es una constante que toma los valores −1, 0 y 1. Si la ecuación original verifica que 2 −4 0 esta se dirá elíptica y se reducirá a una ecuación del tipo (3.2). Si verifica que 2 −4 0 se dirá hiperbólica y puede reducirse a una ecuación de la forma (3.3). Finalmente, si 2 − 4 = 0 la ecuación puede reducirse a la forma (3.4) y se dirá parabólica o a la forma (3.5) que se conoce con el nombre de degenerada. Veamos por ejemplo cómo transformar la ecuación 3 − 2 + 6 − 12 − 9 − 5 = 0 64 Ecuaciones en derivadas parciales en una de las formas anteriores. En primer lugar, démonos cuenta que 2 − 4 = −68 0 por lo que se trata de una ecuación elíptica. La transformación se hace en tres etapas. Cambio en las variables independientes para eliminar el término . Para ello consideramos una rotación en el plano de ángulo que tendrá la forma ½ = cos + sin = − sin + cos y cuya transformación inversa es ½ = cos − sin = sin + cos Por la regla de la cadena, tenemos que = + = cos − sin = + = sin + cos De este modo µ ¶µ ¶ 2 = cos − sin cos − sin = 2 2 2 2 2 2 cos + sin − 2 cos sin = 2 2 µ ¶µ ¶ 2 = = sin + cos sin + cos 2 2 2 2 2 2 cos sin sin + cos + 2 = 2 2 µ ¶µ ¶ 2 = = cos − sin sin + cos 2 2 2 cos sin − 2 cos sin + 2 (cos2 − sin2 ) = 2 y sustituyendo en la ecuación original tenemos 0 = 3 − 2 + 6 − 12 − 9 − 5 ¢ ¡ = 3 cos2 + sin2 − 2 cos sin ¢ ¡ −2 cos sin − cos sin + 2 (cos2 − sin2 ) ¢ ¡ +6 sin2 + cos2 + 2 cos sin −12 ( cos − sin ) − 9 ( sin + cos ) − 5 ¢ ¡ = 3 cos2 − 2 cos sin + 6 sin2 ¡ ¢ + 3 sin2 + 2 cos sin + 6 cos2 ¡ ¢ + 6 cos sin − 4(cos2 − sin2 ) − (12 cos + 9 sin ) + (12 sin − 9 cos ) − 5 65 Ecuaciones en derivadas parciales Si buscamos que el coeficiente que multiplica a sea 0, debe verificarse que 6 cos sin − 4(cos2 − sin2 ) = 0 o equivalentemente 4 tan2 + 6 tan − 4 = 0 de donde obtenemos que, considerando en el primer cuadrante, 1 tan = 2 con lo que √ √ 5 2 5 cos = sin = 5 5 quedando la ecuación original como √ √ 14 31 33 5 6 5 + − − − 5 = 0 5 5 5 5 o equivalentemente √ √ 14 + 31 − 33 5 − 6 5 − 25 = 0 (3.6) La siguiente etapa consiste en la eliminación de los términos de y , en dos pasos. En primer lugar eliminaremos el término de introduciendo la variable dependiente = y calculamos para que el término que acompaña a sea cero. Para ello tenemos en cuenta que = − y derivamos = = = = −− + − − 2 − − 2− + − − y sustituimos en la ecuación (3.6) teniéndose √ √ 0 = 14 + 31 − 33 5 − 6 5 − 25 = 0 = 14( 2 − − 2− + − ) + 31− √ √ −33 5(−− + − ) − 6 5− − 25− ³ ´ √ √ √ = − 14 + 31 − [28 + 33 5] − 6 5 + [14 2 + 33 5 − 25] de donde obtenemos la condición de donde √ 28 + 33 5 = 0 √ 33 5 =− 28 66 Ecuaciones en derivadas parciales y teniendo en cuenta que − 6= 0, la ecuación se simplifica a √ 6854 14 + 31 − 6 5 − = 0 56 (3.7) Procediendo del mismo modo con la variable , introduciendo la variable dependiente = la ecuación (3.7) se reduce a 14 + 31 − 95737 = 0 868 (3.8) Finalmente, introducimos la variables dependiente e independientes para reescalar la ecuación (3.8) de la siguiente forma. En primer lugar introducimos la variable dependiente = 95737 868 y como 868 95737 868 = 95737 = la ecuación (3.8) se reduce a 12152 26908 + − = 0 95737 95737 Finalemente, los cambios de variables independientes hacen que teniendo en cuenta que ⎧ q ⎨ = 12152 q 95737 ⎩ = 26908 95737 95737 12152 95737 = 26908 = nos quede la ecuación reducida + − = 0 67 Ecuaciones en derivadas parciales 3.4. Ecuación del calor. Método de separación de variables. Partamos del problema ⎧ ⎨ = 2 0 ∈ (0 ) (0 ) = () 0 ⎩ ( 0) = ( ) = 0 0 que es la ecuación del calor en una varilla unidimensional de longitud con temperatura inicial (). La incógnita ( ) mide la temperatura en cada instante de tiempo y en cada punto de la barra. Una manera de resolver el problema anterior es intentar reducirlo a un problema de ecuaciones diferenciales ordinarias. Para ello suponemos que la solución puede expresarse de la forma ( ) = () () es decir, como el producto de dos funciones reales de variable real () e (). Derivando obtenemos ( ) = 0 () () ( ) = () 00 () Sustituyendo en la ecuación original tenemos 0 () () = 2 () 00 () y suponiendo que las fuciones no se anulan rescribimos la ecuación como 0 () 00 () = ()2 () Un lado de la igualdad solo depende de , mientras que el contrario lo hace solo respecto de , por lo que necesariamente ambos deben ser constantes, es decir 0 () 00 () = = − ()2 () de donde obtenemos las ecuaciones diferenciales 0 + 2 = 0 00 + = 0 Por otra parte, las condiciones de contorno se escriben como () (0) = (0 ) = 0 () () = ( ) = 0 por lo que debe verificarse que (0) = () = 0. Si escribimos el problema para la función tenemos lo que se conoce como un problema de contorno ½ 00 + = 0 (0) = () = 0 Como sabemos, la solución general de la ecuación 00 + = 0 es de una de las siguientes formas 68 Ecuaciones en derivadas parciales Si = 0, entonces () = 1 + 2 , donde 1 y 2 son dos constantes arbitrarias. √ √ + 2 − , donde 1 y 2 son dos constantes arbitrarias. √ √ Si 0, la solución es () = 1 cos( ) + 2 sin( ), donde 1 y 2 son dos constantes arbitrarias. Si 0, la solución es () = 1 El problema se presenta a lo hora de calcular las constantes anteriores. En el primer caso tendríamos que (0) = 1 = 0 e () = 1 + 2 = 0 de donde 1 = 2 = 0 y la solución sería nula. En el segundo caso, las condiciones de contorno se escriben como (0) = 1 + 2 = 0 e √ () = 1 que da lugar al sistema lineal ½ √ + 2 − = 0 1 + = 0 √ √ 2 + 2 − = 0 1 y dado que el determinante de la matriz asociada ¯ ¯ √ √ ¯ 1 1 ¯¯ − √ ¯ √ = − 6= 0 ¯ − ¯ tenemos que la única solución posible es 1 = 2 = 0 y la solución sería nuevamente nula. Finalmente, en el tercer caso (0) = 1 = 0 e de donde √ √ () = 1 cos( ) + 2 sin( ) = 0 √ 2 sin( ) = 0 √ Como las soluciones de la ecuación sin( ) = 0 son = 2 2 , ∈ N 2 Si definimos 2 2 2 tenemos que el problema de condiciones de contorno tiene soluciones no nulas de la forma ³ ´ p () = sin( ) = sin = 69 (3.9) Ecuaciones en derivadas parciales para los valores de dados en (3.9). Para estos valores, la ecuación para la función queda de la forma 0 + 2 2 2 = 0 2 que para cada valor de proporciona la solución () = − 2 2 2 2 lo que da lugar a la solución ³ ´ 2 2 2 − 2 La linealidad de la ecuación nos lleva a plantear como posible solución ( ) = sin ( ) = ∞ X sin =1 ³ ´ 2 2 2 − 2 y utilizando la condición inicial ³ ´ (0 ) = sin = () =1 ∞ X (3.10) lo que nos lleva a plantearnos si cualquier función () puede desarrollarse como en (3.10). La solución a esta cuestión será el desarrollo en serie de Fourier. 3.5. Series de Fourier Consideremos una función real de variable real () que sea 2 periódica, es decir, para todo se verifica la expresión () = ( + 2) Por ejemplo, las funciones seno y coseno son 2 periódicas. Definimos los coeficientes de Fourier Z ³ ´ 1 = 0 1 2 () cos = − y 1 = La serie Z − () sin ³ ´ = 1 2 ³ ´ ³ ´´ 0 X ³ cos + + sin 2 =1 ∞ se conoce como serie de Fourier asociado a (). Por ejemplo, consideremos la función () tal que ½ 0 ∈ [−1 0) () = 1 ∈ [0 1) 70 Ecuaciones en derivadas parciales y es 2 periódica. Para dicha función tenemos que los coeficientes de Fourier son Z 1 Z 1 0 = () = 1 = 1 −1 y para ≥ 1 = Z 0 Z 1 1 () cos () = cos () 0 ∙ ¸1 1 1 = sin () = (sin () − sin (0)) = 0 0 −1 = Z ∙ 1 () sin () = −1 Z 1 sin () 0 ¸1 −1 −1 = cos () = (cos () − cos (0)) 0 ½ 0 = 2 por lo que la serie de Fourier asociada a () será 1 X 2 + sin ((2 − 1)) 2 =1 (2 − 1) ∞ La cuestión radica en saber si la igualdad 1 X 2 () = + sin ((2 − 1)) 2 =1 (2 − 1) ∞ (3.11) se verifica, es decir, si () puede aproximarse en forma de la serie anteriormente calculada. La respuesta a esta pregunta es afirmativa para una familia notable de funciones, que precisa de unas definiciones previas para su compresión. Recordemos que una función es continua en 0 si lı́m () = (0 ) →0 y () es continua si es continua en todos sus puntos. Si () no es continua en 0 pueden existir sus límites laterales (0− ) = → lı́m () 0 0 y (0+ ) = → lı́m () 0 0 y la discontinuidad se tipo salto finito si (0− ) − (0+ ) es finito. Finalmente, () se dice continua a trozos en [− ] si es continua salvo en una cantidad finita de puntos y las discontinuidades son de tipo salto finito. Se verifica entonces el siguiente resultado. 71 Ecuaciones en derivadas parciales Theorem 31 Sea : R → R una función 2 periódica de manera que y su derivada 0 son de continuas a trozos. Entonces la serie de Fourier de dada por ³ ´ ³ ´´ 0 X ³ + + sin cos 2 =1 ∞ converge a () en los puntos de continuidad de , a 12 [ (0− )− (0+ )] en los puntos de discontinuidad y a 12 [(− ) − (−+ )] cuando = ±. El teorema anterior garantiza que la igualdad a la que hacíamos alusión en (3.11) se verifica para ∈ (−1 1) \ {0} es igual a 12 para ±1 y 0. 3.5.1. Funciones pares e impares La series de Fourier tienen expresiones particulares cuando las funciones son pares o impares. Recordemos que es par si se cumple que () = (−) para todo ∈ R. Se dice que la función es impar si por el contrario la relación que se cumple es () = −(−) Veamos cómo se obtiene la serie de Fourier para cada una de estas funciones. Si es par, se verifica que 0 = = = = 1 = Z () Z Z 1 1 = {=−} () + () 0 0 Z 2 () = 0 − Z ³ ´ 1 () cos − Z Z ³ ´ ³ ´ 1 0 1 + () cos () cos − 0 Z Z ³ ´ ³ ´ 1 1 () cos () cos + {=−} 0 0 Z ³ ´ 2 () cos 0 72 Ecuaciones en derivadas parciales mientras que = = = = Z ³ ´ 1 () sin − Z Z ³ ´ ³ ´ 1 0 1 () sin () sin + − 0 Z Z ³ ´ ³ ´ 1 1 + − () sin () sin {=−} 0 0 0 por lo que para una función par tendremos que ³ ´ 0 X () = + cos 2 =1 ∞ Si es impar 0 = = = = 1 = Z () Z Z 1 1 = {=−} − () + () 0 0 = 0 − Z ³ ´ 1 () cos − Z Z ³ ´ ³ ´ 1 0 1 + () cos () cos − 0 Z Z ³ ´ ³ ´ 1 1 () cos () cos + {=−} − 0 0 0 mientras que = = = = Z ³ ´ 1 () sin − Z Z ³ ´ ³ ´ 1 0 1 () sin () sin + − 0 Z Z ³ ´ ³ ´ 1 1 + () sin () sin {=−} − 0 0 Z ³ ´ 2 () sin 0 por lo que para una función par tendremos que () = ∞ X =1 73 sin ³ ´ Ecuaciones en derivadas parciales 3.5.2. Aplicación a la ecuación del calor Si retomamos la ecuación del calor ⎧ ⎨ = 2 0 ∈ (0 ) (0 ) = () 0 ⎩ ( 0) = ( ) = 0 0 la teoría de Fourier nos dice que su solución formal es ( ) = ∞ X sin =1 donde ³ ´ 2 2 2 − 2 ³ ´ sin (0 ) = = () =1 ∞ X Ahora bien, si pensamos en () como una función impar 2 periódica tendremos que Z ³ ´ 2 () sin = 0 y por tanto dicha solución formal será Z ∞ ∙ ³ ´ 2 2 2 ³ ´ ¸ X 2 ( ) = sin − 2 () sin 0 =1 (3.12) Hablamos de solución formal ya que no podemos asegurar que la expresión dada en (3.12) sea una solución. Por una parte, aunque la linealidad garantiza que una combinación lineal finita de soluciones sea solución, nuestra combinación lineal es infinita, por lo que tendríamos que comprobar que efectivamente es solución, es decir que es dos veces derivable y cumple la ecuación del calor. En general comprobar que las soluciones formales son soluciones es un problema bastante díficil, que en 2 2 2 el caso de la ecuación del calor se garantiza por el término − 2 . Cualitativamente hablamos de un proceso de difusión, en el que la barra va disipando calor convergiendo muy rápidamente a 0 y suavizando cualquier irregularidad que la función () pudiera presentar. Por ejemplo, si nuestra barra es de aluminio (con un coeficiente 2 = 086) y mide 10 cm., y la temperatura inicial en la barra es de 100 C, la evolución de la tempreatura con el tiempo vendrá determinada por la expresión Z ∞ ∙ ³ ´ 0862 2 ³ ´ ¸ X 2 10 ( ) = sin − 100 100 sin 10 10 10 0 =1 y como Z 0 10 ∙ ³ ´¸10 ³ ´ 10 = −100 cos 100 sin 10 10 0 1000 = − (cos() − cos 0) ½ 0 = 2000 74 Ecuaciones en derivadas parciales tenemos ( ) = ∞ X =1 µ ¶ 086(2−1)2 2 (2 − 1) 400 100 sin − (2 − 1) 10 Hemos de destacar que en el desarrollo anterior tienen una gran importancia que las condiciones de contorno sean nulas. En general esto no tiene porqué ser así, es decir la ecuación del calor sería ⎧ ⎨ = 2 0 ∈ (0 ) (0 ) = () 0 ⎩ ( 0) = 1 (); ( ) = 2 () 0 donde 1 () y 2 () son las funciones que miden la temperatura de la varilla. Un cambio de variable en la variable dependiente permite llevar condiciones de contorno no nulas a un problema que sí las tenga mediante la nueva función ( ) = ( ) − 1 () − (2 () − 1 ()) Es fácil ver que ahora ( 0) = ( 0) − 1 () = 1 () − 1 () = 0 mientras que ( ) = ( ) − 1 () − (2 () − 1 ()) = 2 () − 1 () − (2 () − 1 ()) = 0 por lo que tendremos condiciones de contorno nulas. La ecuación original se reescribe 0 = − 2 = + 10 () + (20 () − 10 ()) − 2 por lo que tendríamos el problema ⎧ ⎨ − 2 = −10 () − (20 () − 10 ()) 0 ∈ (0 ) (0 ) = () − 1 (0) − (2 (0) − 1 (0)) 0 ⎩ ( 0) = ( ) = 0 0 Si la temperatura en los extremos de la varilla permanece constante, esto es, 1 () = 1 y 2 () = 2 , el problema anterior se reduce a ⎧ ⎨ = 2 0 ∈ (0 ) (0 ) = () − 1 − (2 − 1 ) 0 ⎩ ( 0) = ( ) = 0 0 3.6. Ecuación de ondas Poner el modelo? Consideremos el problema hiperbólico ⎧ = 2 0 ∈ (0 ) ⎪ ⎪ ⎨ (0 ) = () 0 (0 ) = () 0 ⎪ ⎪ ⎩ ( 0) = ( ) = 0 0 75 Ecuaciones en derivadas parciales que modela la vibración mecánica de una cuerda, donde ( ) mide el desplazamiento respecto de la horizontal en cada instante de tiempo y en cada posición de la cuerda. Con el método de separación de variable planteamos soluciones de la forma ( ) = () (), que nos da lugar a los problemas de ecuaciones diferencales 00 + 2 = 0 y el problema de contorno ½ 00 + = 0 (0) = () = 0 que como sabemos tiene una familia de soluciones no nulas para los valores = por ³ ´ () = sin Para dichos valores tenemos las ecuaciones ¡ ¢2 00 + 2 = 0 que tendrá por solución general ³ ´ ³ ´ + sin () = cos pudiendo entonces plantear la solución formal ( ) = ∞ X () () =1 ∞ h ³ ´ ³ ´ ³ ´i X = + sin sin cos =1 De la condición inicial ³ ´ sin (0 ) = () = =1 ∞ X Derivando formalmente ( ) respecto a obtenemos ∞ h ³ ´ ³ ´i ³ ´ X sin + cos sin − ( ) = =1 que aplicada a la otra condición inicial (0 ) = () = ∞ X =1 ³ ´ sin Considerando de nuevo y como funciones impares 2 periódicas, concluimos que Z ³ ´ 2 () sin = 0 76 , ∈ N, dadas Ecuaciones en derivadas parciales y 2 = Z 0 ³ ´ () sin para todo ≥ 1. Poner la interpretación fisica de armónicos? Poner algo de la solución de D’Alambert? 3.7. Ecuación de Laplace Al contrario que las ecuaciones del calor y ondas, la ecuación de Laplace es estática y representa una condición de equilibrio en, por ejemplo, la temperatura de una sección plana. La ecuación del calor en dos dimensiones espaciales tiene la forma = 2 ( + ) y si suponemos un equilibrio de esta función invariante respecto al tiempo, obtendríamos + = 0 (3.13) que es la ecuación de Laplace. Estas ecuaciones se plantean sólo con condiciones de contorno sobre la frontera del recinto, que para los calculos prácticos tiene que tener alguna regularidad. Estas condiciones de contorno son en general de dos tipos. Si es el recinto donde se verifica la ecuación (3.13), podemos suponer conocido ( ) para todo ( ) en la frontera de en cuyo caso estaríamos hablando de una condición tipo Dirichlet. Si por el contrario suponemos que el vector normal a en la frontera es conocido, se trata de una condición de Neumann. En cualquiera de los casos, la geometría del conjunto es muy importante y sólo podemos calcular soluciones cuando ésta cumple adecuadas condiciones de regularidad. Supongamos por ejemplo que es el rectángulo [0 ] × [0 ] y tenemos el problema ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎨ ( 0) = ( ) = 0 0 ≤ ≤ (0 ) = 0 0 ≤ ≤ ⎪ ⎪ ⎩ ( ) = () 0 ≤ ≤ que es de tipo Dirichlet. Si planteamos una solución de la forma ( ) = () (), construimos las ecuaciones diferenciales 00 − = 0 00 + = 0 La segunda ecuaición da lugar al problema de contorno ½ 00 + = 0 (0) = () = 0 77 Ecuaciones en derivadas parciales que como sabemos tiene por soluciones no nulas las funciones ³ ´ () = sin ¡ ¢2 para los valores = , ∈ N. La primera ecuación se reescribe entonces 00 − = 0 que tiene por solución general () = 1 − + 2 De la condición (0 ) = 0 obtenemos que (0) = 0, por lo que (0) = 0 = 1 + 2 por lo que 2 = −1 = 2, por lo que para todo natural obtenemos la solución ³ ´ − − ( ) = sin ³ ´ ³2 ´ sin = sinh Planteamos entonces la solución formal ( ) = ∞ X sinh =1 ³ ´ ³ ´ sin Utilizando la condición de contorno que nos queda ( ) = () tenemos que () = ∞ X sinh =1 ³ ´ sin ³ ´ y considerando como 2 periódica e impar, tenemos que ³ ´ 2 Z ³ ´ = () sin sinh 0 Poner ejemplo condiciones de Neumann? Poner problemas de Poisson? 3.8. Problemas 1. Encontrar las soluciones de los siguientes problemas de contorno: a) 00 + = 0 (0) = 0 0 () = 0 78 Ecuaciones en derivadas parciales b) 00 + = 0 0 (0) = 0 0 () = 0 c) 00 + = 0 0 (0) = 0 () = 0 d) 00 + = 0 (0) = 0 () − 0 () = 0 e) 00 + = 0 (0) − 0 (0) = 0 (1) = 0 f ) 00 + = 0 (0) − 0 (0) = 0 () − 0 () = 0 2. Para qué valores de tienen soluciones no triviales los siguientes problemas de contorno: a) 00 − 2 0 + (1 + ) = 0 (0) = 0 (1) = 0 b) 00 + = 0 (0) = (2) 0 (0) = 0 (2) 3. Clasificar las siguientes EDP y encontrar su forma canónica: a) 3 + 4 − = 0 b) 4 + + 4 + = 0 c) + + 3 − 4 + 25 = 0 d) − 3 + 2 − + = 0 e) − 2 + + 3 = 0 4. Encontrar los desarrollos en serie de Fourier de las siguientes funciones periódicas (se da su valor en el intervalo [− ] con 2 el periodo). a) () = b) () = ½ ½ −1 ∈ [−1 0) 1 ∈ [0 1] ∈ [−2 0) 0 ∈ [0 2] c) () = ∈ [−1 1] ½ − ∈ [−1 0) d) () = ∈ [0 1] ⎧ ⎨ 1 ∈ [−2 0) 0 ∈ [0 1) e) () = ⎩ 1 ∈ [1 2] ½ 0 ∈ [−2 1) f ) () = 1 ∈ [1 2] ½ 0 ∈ [− 0) g) () = ∈ [0 ] ½ − ∈ [− 0) h) () = ∈ [0 ] 79 Ecuaciones en derivadas parciales 5. Los extremos de una barra de aluminio (2 = 086) de longitud 10 metros se mantienen a temperatura de 0 . Encontrar la expresión de la temperatura de la barra para las siguientes condiciones iniciales a) (0 ) = 70, 0 ≤ ≤ 10. b) (0 ) = 70 cos , 0 ≤ ≤ 10. ½ 10 ∈ [0 5) c) (0 ) = 10(10 − ) ∈ [5 10] ½ 0 ∈ [0 3) d) (0 ) = 65 ∈ [3 10] 6. Los extremos de una barra de cobre (2 = 114) de longitud 2 metros se mantienen a temperatura de 0 . Encontrar la expresión de la temperatura de la barra para las siguientes condiciones iniciales a) (0 ) = 65 cos2 (), 0 ≤ ≤ 2. b) (0 ) = 70 sin , 0 ≤ ≤ 2. ½ 60 ∈ [0 1) c) (0 ) = 60(2 − ) ∈ [1 2] ½ 0 ∈ [0 1) d) (0 ) = 75 ∈ [1 2] 7. Un estado de equilibrio para la ecuación del calor = 2 es aquella que no varía con el tiempo. Demostrar a) Todos los equilibrios de la ecuación del calor son de la forma () = + b) Encontrar los estados de equilibrio de la ecuación del calor que cumplen ( 0) = 1 y ( ) = 2 . c) Resolver el problema ⎧ ⎨ = 2 0 ∈ (0 1) (0 ) = 75 0 1 ⎩ ( 0) = 20 ( ) = 60 0 Ayuda: Calcularla como ( ) = () + ( ) donde () es el estado de equilibrio asociado a las condiciones de contorno ( 0) = 20 ( ) = 60, y ( ) es la solución del problema con condiciones de contorno nulas. 8. Los extremos de una barra de cobre (2 = 114) de longitud 10 centímetros se mantienen a temperatura de 0 mientras que el centro de la barra es mantenido a 100 mediante una fuente de calor externa. Encontrar la temperatura de la barra con el tiempo para la condición inicial ½ 50 ∈ [0 5) (0 ) = 100 ∈ [5 10] Ayuda: Descomponer el problema en dos problemas de contorno con uno de los estremos en la mitad de la barra. 80 Ecuaciones en derivadas parciales 9. Resolver el problema ⎧ ⎨ = + 0 ∈ (0 1) (0 ) = cos 0 1 ⎩ ( 0) = 0 ( ) = 0 0 10. Resolver los siguientes problemas ⎧ = 2 0 ∈ (0 2) ⎪ ⎪ ⎨ (0 ) = cos − 1 0 2 a) (0 ) = 0 0 2 ⎪ ⎪ ⎩ ( 0) = 0 ( 2) = 0 0 ⎧ = 2 0 ∈ (0 1) ⎪ ⎪ ⎨ (0 ) = 0 0 1 b) (0 ) = 1 0 1 ⎪ ⎪ ⎩ ( 0) = 0 ( 1) = 0 0 ⎧ ⎧ = 2 0 ∈ (0 3) ⎪ ⎪ ∈ [0 1) ⎨ ⎨ (0 ) = () 0 3 1 ∈ [1 2) c) donde () = (0 ) = 0 0 3 ⎪ ⎩ ⎪ 2 − ∈ [2 3] ⎩ ( 0) = 0 ( 3) = 0 0 11. Una cuerda de 10 metros fijada en sus extremos se levanta por el medio hasta la distancia de un metro y se suelta. Describe su movimiento suponiendo que 2 = 1. 12. Demuestra que el cambio de coordenadas ½ = + = − transforma la ecuación de ondas = 2 en la ecuación = 0. Concluir que la solución general de la ecuación será de la forma ( ) = ( − ) + ( + ) para funciones apropiadas y . 13. Demostrar que la solución del problema ⎧ = 2 0 ∈ (0 ) ⎪ ⎪ ⎨ (0 ) = () 0 (0 ) = () 0 ⎪ ⎪ ⎩ ( 0) = 0 ( 3) = 0 0 es de la forma 1 1 ( ) = ( ( − ) + ( + )) + 2 2 donde es la extensión 2 periódica e impar de . 81 Z + − () Ecuaciones en derivadas parciales 14. Resolver el problema ⎧ = 2 + 0 ∈ (0 ) ⎪ ⎪ ⎨ (0 ) = () 0 (0 ) = 0 0 ⎪ ⎪ ⎩ ( 0) = 0 ( 3) = 0 0 15. Resolver los problemas ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎨ ( 0) = 0 0 a) ( ) = () 0 ⎪ ⎪ ⎩ (0 ) = ( ) = 0 0 ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎨ ( 0) = ( ) = 0 0 b) (0 ) = () 0 ⎪ ⎪ ⎩ ( ) = 0 0 ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎪ ⎪ ⎨ ( 0) = () 0 ( ) = 0 0 c) ⎪ ⎪ (0 ) = () 0 ⎪ ⎪ ⎩ ( ) = 0 0 16. Resolver los problemas de Neuman ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎨ ( 0) = ( ) = 0 0 a) (0 ) = () 0 ⎪ ⎪ ⎩ ( ) = 0 0 ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎨ (0 ) = ( ) = 0 0 b) ( 0) = () 0 ⎪ ⎪ ⎩ ( ) = 0 0 ⎧ + = 0 ( ) ∈ (0 ) × (0 ) ⎪ ⎪ ⎪ ⎪ ⎨ (0 ) = 1 0 ( ) = 0 0 c) ⎪ ⎪ ( 0) = 1 0 ⎪ ⎪ ⎩ ( ) = 0 0 17. Resolver el problema ⎧ + = ( ) ∈ (0 1)2 ⎪ ⎪ ⎨ ( 0) = ( 1) = 0 0 1 (0 ) = () 0 1 ⎪ ⎪ ⎩ (1 ) = 0 0 1 82 Capítulo 4 Transformada de Fourier Sumario. Definición y propiedades básicas. Transformada de Fourier inversa. Relación con la transformada de Laplace. Aplicación a las ecuaciones diferenciales y en derivadas parciales. 4.1. Definición y primeros ejemplos Dada una función : R → C, se define la transformada de Fourier de como F[]() = Z ∞ ()− −∞ en todo donde la expresión anterior tenga sentido, es decir la integral impropia anterior sea convergente. Esta convergencia es más difícil de verificar que en el caso de la transformada de Laplace. Supongamos por ejemplo que y son reales, por o que − = cos() − sin(), que como sabemos tiene módulo 1. Si () es también real, para garantizar la convergencia absoluta de la integral anterior debe de satisfacerse que lı́m |()− | = lı́m |()| = 0 →±∞ →±∞ 83 Transformada de Fourier por lo que las funciones reales que tendrán transformada de Fourier tienen que tener una gráfica como la siguiente o bien ser nulas fuera de un intervalo compacto [ ]. Veamos algunos ejemplos. Consideramos la función () = − () − (), donde () es la función de Heaviside en ∈ R. Como vemos es no nula con valor uno en el intervalo [− ). Su transformada de Fourier se calcula como Z ∞ Z − F[]() = () = − − ¸ ∙−∞ − ¢ 2 −1 ¡ − = − = sin() = − − Tomemos ahora la función () = −|| . Su transformada de Fourier vendrá dada por F[]() = Z ∞ − () = −∞ Z Z 0 (1−) + = −∞ Z 0 − −∞ ∞ −(1+) + Z ∞ − − 0 0 ∙ −(1+) ¸∞ ¸0 (1−) + − = 1 − −∞ 1 + 0 1 2 1 + = 2 = 1 − 1 + +1 ∙ 4.2. Propiedades básicas Al igual que la transformada de Laplace, la transformada de Fourier tiene unas propiedades básicas que permiten operar con ella con más facilidad. Las enumeramos a continuación suponiendo siempre buenas condiciones de convergencia de las funciones implicadas. 84 Transformada de Fourier 4.2.1. Linealidad Dadas dos funciones y y dos números se verifica que F[ + ]() = F[]() + F[]() La prueba de esta propiedad viene directamente de la linealidad de la integral de la siguiente forma Z ∞ ( + )()− F[ + ]() = −∞ Z ∞ Z ∞ − () + ()− = −∞ = F[ ]() + F[]() −∞ Por ejemplo, si () = − () − () + −|| , su transformada de Fourier vendrá dada por F[ ]() = F[1 ]() + F[2 ]() = 2 2 sin() + 2 +1 siendo 1 () = − () − () y 2 () = −|| . La linealidad no puede aplicarse al calculo de 1 del siguiente modo F[1 ]() = F[− ]() − F[ ]() ya que las funciones − y no tienen transformada de Fourier. 4.2.2. Transformada de la derivada Dada una función derivable a trozos, se tiene que F[ 0 ]() = F[ ]() La demostración se hace con la fórmula de integración por partes del siguiente modo ½ ¾ Z ∞ = − = −− 0 0 − F[ ]() = () = = () = 0 () −∞ Z ∞ ¤ £ ∞ ()− = F[ ]() = ()− −∞ + −∞ ya que lı́m | ()− | = 0 →±∞ para garantizar la convergencia. En general, puede comprobarse que la derivada —ésima se calcula como F[ ) ]() = () F[ ]() Esta fórmula, junto con la linealidad, tiene, al igual que ocurría con la transformada de Laplace, utilidad potencial para la resolución de ecuaciones diferenciales. 85 Transformada de Fourier 4.2.3. Cambios de escala Sea una función y un número real. Podemos calcular la transformada de Fourier de la función () = (), que puede verse como un cambio de escala en , con la fórmula 1 F[]() = F[ ()]() = F[]() Esta fórmula es consecuencia del cambio de variable en la integral ya que Z ∞ ()− F[]() = F[ ()]() = ¾ −∞ Z ∞ ½ 1 1 = = ()− = F[]() = = −∞ A modo de ejemplo, si suponemos que () = −|| con 0, podemos calcular F[ ]() = F[−|| ]() = F[−|| ]() 1 2 2 1 = F[−|| ]() = = 2 2 + 1 2 + 2 4.2.4. Derivada de la transformada La fórmula para calcular la derivada de la trasnforma de Fourier de una función es F[]() = F[()]() Esta relación es consecuencia de un cambio de orden en el cálculo de límites ya que Z ∞ Z ∞ − () = (∗) F[]() = ()− −∞ Z ∞ Z ∞ −∞ − ()(−) = − ()− = −F[ ()]() = −∞ −∞ 2 2 Vamos a aplicar esta fórmula al cálculo de la transformada de Fourier de la función () = − En primer lugar, la función () verifica el problema de condiciones iniciales ½ 0 () = − () (0) = 1 Por otra parte, transformando la ecuación anterior tenemos que F[ ]() = −F[ ()]() = − F[ ]() por lo que F[]() satisface la ecuación diferencial F[ ]() = −F[ ]() 86 . Transformada de Fourier que tiene por solución F[ ]() = − Por otra parte, como Z ∞ 2 2 √ 2 − = −∞ tenemos que mediante un cambio de variable Z ∞ √ 2 − 2 = 2 −∞ y por tanto F[](0) = = por lo que Z ∞ 2 2 4.2.5. = √ 2 −∞ F[]() = es decir, la transformada de Fourier de − 2 2 − √ 2 2− 2 es ella misma salvo el factor multiplicativo √ 2. Convolución Dadas dos funciones y con transformadas de Fourier F[] y F[], no se verifica que F[ · ] = F[] · F[]. Vamos a buscar qué función verificaría que F[] = F[] · F[], es decir, cómo puede definirse a partir de las funciones iniciales y . Para ello calculamos Z ∞ Z ∞ − F[ ] · F[] = () ()− −∞ Z−∞ ∞ Z ∞ ()()−(+) = ½−∞ −∞ ¾ Z ∞Z ∞ += ( − )()− = = = −∞ −∞ ¸ Z ∞ ∙Z ∞ = ( − )() − −∞ −∞ por lo que hemos derivado formalmente1 que Z () = ∞ −∞ ( − )() que se conoce con el nombre de producto de convolución, denotado por Z ∞ () ∗ () = ( − )() −∞ Como veremos, esta fórmula tiene aplicaciones en la resolución de diferentes ecuaciones diferenciales. 1 Aquí hemos hecho un cambio en la integración, es decir, una permuta de límites de la que no hemos probado su validez. 87 Transformada de Fourier 4.3. Transformada de Fourier inversa Dada una función sabemos cómo obtener su transformada de Fourier de dicha función F[]. Ahora bien, como en el caso de la transformada de Laplace a veces es necesario recorrer el camino inverso, es decir, dada una función (), ¿es posible encontrar una función real tal que F[] = . En términos de función inversa sería la relación = F −1 [ ], donde F −1 [ ] denota la transformada inversa de Fourier. Al tratarse de una transformada integral, no existirá una única función verificando ser la transformada inversa de (). Sin embargo, en general la fórmula de inversión establece que para una función suficientemente buena la relación Z ∞ Z ∞Z ∞ 1 1 () = F[ ]() = ()− (4.1) 2 −∞ 2 −∞ −∞ se verifica por lo que la transformada inversa de Fourier podría definirse como Z ∞ 1 −1 () F [ ]() = 2 −∞ En particular, las condiciones de Dirichlet establecen que si se verifica que R∞ | ()| ∞ −∞ tiene un número finito de extremos relativos y un número finito de discontinuidades, todas ellas evitables, en cada subintervalo compacto de la recta real, entonces la fórmula (4.1) se verifica en todos los puntos de continuidad de . En los puntos de discontinuidad la integral valdría el promedio de (+) y (−). Así, por ejemplo, dada la función 2 () = 2 + 2 se verifica que F −1 [ ]() = || 0 Por tratarse de una fórmula integral, dicha función hereda las propiedades de la integración, en particular la linealidad F −1 [ + ]() = F −1 [ ]() + F −1 []() 4.4. Relación con la transformada de Laplace Como sabemos, la transformada de Laplace de una función : (0 ∞) → C se define como Z ∞ ()− L[]() = 0 que tendrá validez en un dominio de definición dado por Re para algún real. Si 0, el eje imaginario estará contenido en el dominio de definición de la transformada de Laplace de . En particular, la integral Z ∞ 0 ()− ∈ R 88 Transformada de Fourier tendrá sentido al ser finita. Si consideramos () = 0 definida como para todo ≤ 0, podemos calcular su transformada de Fourier como Z ∞ Z ∞ − F[ ]() = () = ()− −∞ 0 integral que tendrá sentido para todo ∈ R. Por lo tanto, se tendría la igualdad L[]() = F[ ]() ∈ R Consideremos por ejemplo la función () = − , que como sabemos tiene transformada de Laplace L[ ]() = 1 +1 para todo tal que Re −1. Si estendemos como nula en valores negativos, es decir, definimos () = ()0 () siendo 0 () la función de Heaviside, tendremos para todo número real que F[]() = L[]() = 1 + 1 4.5. Aplicación a los sistemas estables 4.5.1. Respuesta a una señal sinusuidal Supongamos un sistema asintóticamente estable con función de transferencia () de manera que es estimulado por una función de tipo seno de la forma () = sin( + ) donde 0 es la amplitud, es la frecuencia y es la fase inicial. Como sabemos, el seno es una función 2 periódica, por lo que sin( + ) = sin( + + 2) = sin(( + 2) + ) por lo que = 2 se llama periodo de la señal, siendo la frecuencia = 1 . Como sabemos, si la fase inicial = 0, la transformada de Laplace de dicha señal será de la forma () = 2 + 2 y la respuesta a largo tiempo del sistema () vendrá dada por la expresión () = () () Ahora bien, dicha respuesta se calculará como () = L−1 [ () ()]() y dado que el sistema era asintóticamente estable, se tiene que los polos de la función de transferencia tienen parte real negativa, por lo que ninguno de ellos coincidirá con los polos de () que son 89 Transformada de Fourier ±. En el cálculo de la transformada inversa, los polos de la función de transferencia dan lugar a términos que aparecen multiplicados por factores de la forma − , con 0, y que tienden a cero muy rápidamente cuando → +∞. Por ello, al calcular la transformada inversa para tiempo suficientemente grande basta con tomar los polos ±, es decir, podemos asumir que ( − ) ( + ) ) + Res( () 2 −) 2 2 + + 2 − = () − (−) 2 2 () = Res( () Tomando la forma polar de () y (−), y teniendo en cuenta que los coeficientes del sistema son reales obtenemos que () = | ()| arg () y () = (−) = | (−)| arg (−) = | ()|− arg () Sustituyendo en la relación anterior − − (−) 2 2 − = | ()| arg () − | ()|− arg () 2 2 (+arg ()) −(+arg ()) − = | ()| 2 = | ()| sin( + arg ()) () = () que se conoce como respuesta en frecuencia a la señal. El término | ()| mide si la respuesta amplifica o atenua la señal, mientras que arg () representa un variación de la fase respecto de la incial. Asímismo, () puede ser determinado experimentalmente introduciendo una señal sinusuidal. 4.5.2. Respuesta a señales periódicas Supongamos una ecuación diferencial lineal con coeficientes constantes con función de transferencia (). Supongamos que el sistema es asintóticamente estable, de tal manera que si () = sin( + ) es la entrada del sistema, se verifica que su salida para tiempos suficientemente grandes (régimen estacionario) viene dada por () = | ()| sin( + + arg ()) Supongamos ahora que la señal es periódica de periodo 2. Dicha función puede expresarse en su serie de Fourier ∞ ³ ´ ³ ´´ 0 X ³ () = + + sin cos 2 =1 0 X = + ( cos () + sin ()) 2 =1 ∞ 90 Transformada de Fourier donde = . Por otra parte, si escribimos ( ) en coordenadas polares mediante la expresión ½ = cos = sin podemos reescribir la expresión anterior como () = 0 X + ( cos () + sin ()) 2 =1 ∞ 0 X = ( sin cos () + cos sin ()) + 2 =1 ∞ 0 X = + sin( + ) 2 =1 ∞ Si ahora () es la entrada al sistema anterior, entonces su salida en el régimen estacionario, es decir, para tiempos suficientemente grandes vendrá dada por ∞ X 0 () = (0) + | ()| sin( + + arg ()) 2 =1 Dado que para casos prácticos lı́m→∞ | ()| = 0, por lo que lı́m→∞ | ()| = 0, como consecuencia la series de Fourier de () converge a cero más rápidamente que la serie de Fourier de la señal inicial (). 4.5.3. Aplicación de la transformada de Fourier Si tenemos un sistema asintóticamente estable con función de transferencia (), sabemos que su respuesta a una señal sinusuidal de la forma sin( + ) viene dada por la expresión () = | ()| sin( + + arg ()) pero () es la transformada de Fourier. Esta función () se conoce como función de transferencia de frecuencias del sistema. En particular, para sistemas estables estos pueden verse como F[]() = ()F[]() que relaciona la transformada de Fourier de la salida F[]() con la de la entrada F[](). 4.6. Aplicación a las ecuaciones en derivadas parciales Consideremos la ecuación del calor en una barra infinita ½ = ∈ R 0 (0 ) = () ∈ R 91 Transformada de Fourier Como vemos no hay condiciones de frontera y por tanto sólo existen condiciones iniciales. Para resolver dicho problema tomamos la transformada de Fourier de la función ( ), para cada valor fijo del tiempo , es decir Z ∞ F[( ·)]() = ( )− −∞ Entonces F[ ( ·)]() = − 2 F[( ·)]() y por la fórmula de derivación bajo el signo de la integral Z ∞ F[ ( ·)]() = ( )− −∞ Z ∞ ( )− = F[( ·)]() = −∞ por lo que la ecuanción = se transforma en − 2 F[( ·)]() = F[( ·)]() La condición incial se transforma en F[(0 ·)]() = = Z ∞ Z−∞ ∞ −∞ (0 )− ()− = F[]() por lo que tenemos el problema de condiciones iniciales ½ − 2 F[( ·)]() = F[( ·)]() 0 F[(0 ·)]() = F[]() que como sabemos del cálculo de soluciones de ecuaciones diferenciales ordinarias tiene por solución 2 F[( ·)]() = F[ ]()− La solución de la ecuación la escribimos formalmente como 2 2 ( ) = F −1 [F[ ]()− ]() = () ∗ F −1 [− ]() Z ∞ 2 ( − )F −1 [− ]() = −∞ 2 Calculamos entonces F −1 [− ]() teniendo en cuenta que √ 2 2 F[− 2 ]() = 2− 2 por lo que F −1 Z ∞√ √ 1 2 2 − 2 2 [ 2 ]() = 2− 2 = − 2 2 −∞ 92 Transformada de Fourier √ Partiendo de esta expresión y haciendo el cambio de variable = 2 tenemos que F −1 − 2 [ Z ∞ Z ∞√ 1 1 1 2 − 2 ]() = = √ 2− 2 −∞ 2 2 −∞ √ ¾ ½ Z ∞√ √ 1 1 2 = √ 2 =√ 2− 2 ( 2) √ = = 2 2 2 −∞ 2 Z ∞√ √ 1 1 2 2− 2 ( 2) = √ 2 2 −∞ √ √ 1 2 = √ F −1 [ 2− 2 ]( 2) 2 √ 2 1 1 2 = √ −( 2) 2 = √ − 4 2 2 Entonces ( ) = 4.7. Z ∞ 1 2 ( − ) √ − 4 2 −∞ Ejercicios 1. Encontrar la transformada de Fourier de las siguientes funciones ( 0): ½ cos || 2 a) () = 0 || ≥ 2 ½ || b) () = 0 || ≥ ½ − || || c) () = 0 || ≥ ⎧ 0 −2 ⎪ ⎪ ⎪ ⎪ ⎨ −1 ∈ (−2 −1) 1 ∈ (−1 1) d) () = ⎪ ⎪ −1 ∈ (1 2) ⎪ ⎪ ⎩ 0 2 ½ sin() || ≤ e) () = 0 || 2. Sea () una señal con transformada de Fourier F[ ](). Demostrar que F[ ()]() = F[]( − ) Este resultado es conocido como la propiedad del despalzamiento en frecuencia y es la base del proceso de modulación en teoría de la comunicación. Como aplicación calcular la trasformada de Fourier de las siguientes funciones: a) () = 0 ( + 12) − 0 ( − 12), siendo 0 la función de Heviside. 93 Transformada de Fourier b) () = [0 ( + 12) − 0 ( − 12)] cos(). Ayuda: poner el coseno como combinación de exponenciales complejas. c) () = [0 ( + 1) − 0 ( − 1)] sin(2). 3. Calcular la convolución ∗ es los siguientes casos ( 0): ½ 1 || a) () = 0 || ≥ b) () = −|| 2 4. Calcular la transformada de Fourier inversa de la función () = − (1 + 2 ). 5. Si () = ( − ), demostrar la fórmula F[]() = − F[]() 6. Resolver el problema donde: ½ = ∈ R 0 (0 ) = () ∈ R 2 a) () = − ½ 1 || b) () = 0 || ≥ c) () = 0 () siendo 0 la función de Heaviside. 7. Utilizar la transformada de Fourier para obtener la solución formal del problema ½ = + ∈ R 0 (0 ) = () ∈ R 8. Utilizar la transformada de Fourier para obtener la solución formal del problema ⎧ ⎨ + = 0 ∈ R 0 1 ( 0) = 0 ∈ R ⎩ ( 1) = () ∈ R 9. Supongamos un circuito eléctrico LRC donde = 002, = 300Ω y = 4 × 10−6 . Determinar las salidas en régimen estacionario para los potenciales a) () = sin b) () = cos c) () es la función 002 periódica tal que ½ 10 ∈ [0 001) () = 0 ∈ [001 002) 94 Transformada de Fourier 10. Repetir el ejecicio 9 para el caso = 04, = 100Ω y = 10−5 , siendo el potencial () es una función 004 periódica tal que ½ 10 ∈ [0 002) () = −10 ∈ [002 004) 11. Determinar la función de transferencia de frecuencias de los ejercicios de los circuitos de los ejercicios 9 y 10, y determinar la relación entre las transformadas de Fourier de la respuesta de los sistemas a los voltajes: ½ 10 ∈ [0 001) a) () = 0 ∈ [001 002) ½ 10 ∈ [0 002) b) () = −10 ∈ [002 004) 95 Transformada de Fourier 96 Bibliografía [BaJi] F. Balibrea y V. Jiménez López, Ecuaciones diferenciales para las ciencias químicas y físicas, DM—Universidad de Murcia, 2001. [BoPr] W. E. Boyce y R. C. DiPrima, Ecuaciones diferenciales y problemas con valores en la frontera, Limusa, Mexico, 1996. [Bra] M. Braun, Differential equations and their applications, Springer—Verlag, Berlin, 1993. [Dav] B. Davies, Integral transforms and their applications, Springer—Verlag, Berlin, 1985. [DeGr] W. R. Derrick y S. I. Grossman, Ecuaciones diferenciales con aplicaciones, Fondo Educativo Interamericano, 1984. [Jam] G. James y otros, Advanced modern engineering mathematics ( 2 edición), Addison—Wesley 1999. [Jef] A. Jeffrey, Linear algebra and ordinary differential equations, CRC Press, 1993. [Jim] V. Jiménez López, Apuntes de ecuaciones diferenciales, Servicio de publicaciones, Universidad de Murcia, 2000. [Oga1] K. Ogata, Ingeniería de control moderna, Prentice Hall, 1998. [MaHo] J. E. Marsden y M. J. Hoffman, Basic complex analysis, W. H. Freeman & Co., 1999. [MCZ] F. Marcellán, L. Casasús y A. Zarzo, Ecuaciones diferenciales. Problemas lineales y aplicaciones, McGraw—Hill, 1990. [Mur] J. A. Murillo, Variable compleja y transformadas, DM—Universidad de Murcia, 2000. [NaSa] R. K. Nagle y E. B. Saff, Fundamentos de ecuaciones diferenciales ( 2 edición), Addison Wesley Longman, 1992. [PiZa] A. Pinkus y S. Zafrany, Fourier series and integral transforms, Cambridge University Press, 1997. [Sen] T. B. A. Senior, Mathematical methods in electrical engineering, Cambridge University Press 1986. [Sim] G. F. Simmons, Ecuaciones diferenciales (con aplicaciones y notas históricas), 2 Edición, McGraw—Hill, 1993. 97 Bibliografía [Sot] J. Sotomayor, Licoes de ecuaciones diferenciais ordinárias, Rio de Janeiro: Instituto de Matemática Pura e Aplicada, 1979. 98