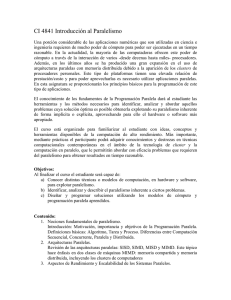

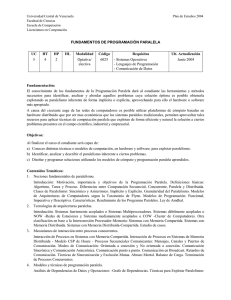

Desarrollo de aplicaciones con técnicas de programación paralela

Anuncio