UN FACTOR COMPLETAMENTE ALEATORIO Decimos que

Anuncio

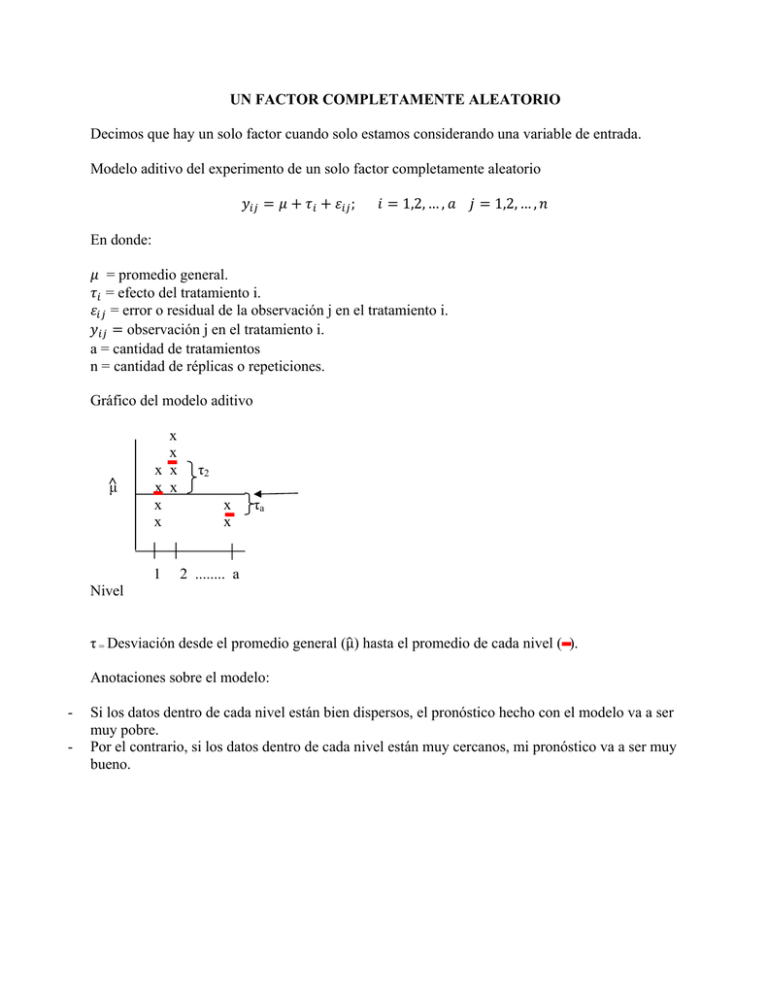

UN FACTOR COMPLETAMENTE ALEATORIO Decimos que hay un solo factor cuando solo estamos considerando una variable de entrada. Modelo aditivo del experimento de un solo factor completamente aleatorio ; 1,2, … , 1,2, … , En donde: = promedio general. = efecto del tratamiento i. = error o residual de la observación j en el tratamiento i. observación j en el tratamiento i. a = cantidad de tratamientos n = cantidad de réplicas o repeticiones. Gráfico del modelo aditivo μ x x x x x x x x 1 τ2 x x τa 2 ........ a Nivel τ = Desviación desde el promedio general (µ) hasta el promedio de cada nivel ( ). Anotaciones sobre el modelo: - Si los datos dentro de cada nivel están bien dispersos, el pronóstico hecho con el modelo va a ser muy pobre. Por el contrario, si los datos dentro de cada nivel están muy cercanos, mi pronóstico va a ser muy bueno. Fundamentos para el análisis de varianza Estimador de varianza: ∑ 1 ó √ á Interpretación del concepto de grados de libertad Es un indicador de la pureza de información que se va perdiendo a medida que un mismo conjunto de datos se utiliza más y más para calcular estadísticas. Definición: Es la cantidad de datos – el número de estimaciones que se han calculado con ese mismo conjunto de datos. Ejemplos para ilustrar este concepto Cuando se calcula media muestral no se ha utilizado el conjunto de datos para hacer ningún cálculo. Por tanto, los grados de libertad para la media son iguales a la cantidad de datos. Para la varianza muestral, como se requiere el uso de la media muestral, ya los datos han sido usados 1 vez para calcular un estadístico (la media muestral), por tanto, los grados de libertad son iguales a la cantidad de datos menos 1. Para el caso de la varianza de dos muestras provenientes de distribuciones normales con varianzas poblacionales iguales, como se requiere el cálculo de las varianzas muestrales de ambas muestras menos 2. entonces los grados de libertad serán iguales a la cantidad de datos ( + • Dos poblaciones ∑ ∑ Si 1 " " 1 2 Análisis de varianza (ANOVA) El ANOVA es una prueba de hipótesis en la que la hipótesis nula es que los factores tomados en cuenta no influyen sobre la variable respuesta y la hipótesis alternativa es que si influyen. Decir que un factor no influye es lo mismo que decir que todos los efectos de sus niveles son iguales a cero, por tanto la formulación de la hipótesis nula se hace de la siguiente manera: Ho: τ1 = τ2 =…=τa = 0 Una formulación equivalente sería: Ho: μ1 = μ2 =…= μa En donde μi = μ + τi Una forma gráfica de visualizar la hipótesis nula es la siguiente: x x x x x x x x x x x x 1 2 3 Media general Como se puede observar en el gráfico un cambio en el tratamiento no produce ningún cambio en la variable respuesta, es decir, sus promedios son iguales entre si y a su vez iguales a la media global, por tanto podemos concluir que los efectos de los tratamientos son iguales a cero. Para hacer esta prueba, ANOVA hace una descomposición de las fuentes de variación en donde se expresa lo siguiente: Variación Total= Variación debida a los factores tomados en cuenta en el experimento + Variación debida a los factores no tomados en cuenta (Error) A la variación debida a los factores tomados en cuenta también se le llama variación entre subgrupos (Between) y a la debida a factores no tomados en cuenta se le llama variación dentro de los subgrupos (Within). En forma resumida: Un Factor La forma estándar de presentar los datos cuando trabajamos con un factor es la siguiente: 1 y11 y12 y13 2 a y21 y22 y23 ya1 ya2 ya3 . . . . . . . . y1n y1 y1. . y2n y2 y2. yan ya ya. y.. yi. = Total (suma) de las observaciones en el nivel i. yi. = Promedio de las observaciones en el nivel i y.. = Promedio general a = Cantidad de niveles n = Cantidad de réplicas o repeticiones para cada nivel Partición de la variabilidad total SS = Sum of squares (suma de cuadrados) SSTotal = Suma de cuadrados totales ∑ ∑ ∑ ∑ ∑ ∑ .. . . .. . . .. 0 ∑ ∑ . ∑ ∑ . . Dentro Grados de libertad = (an-a) + (a-1) .. 2 . .. Entre 0 . . .. ANOVA La forma tradicional de presentar los resultados de ANOVA es la siguiente: Fuentes Grados de libertad a-1 Tratamiento (entre) Error (dentro) an-a Promedio de cuadrados SSTRAT (N-a) SSERROR F calculada F calculada MSTRAT = SSTRAT a-1 MSERROR = SSERROR N-a Fc = MSTRAT MSERROR N-1 Total En donde y2 1 a SSTratamientos = ∑ yi2. − .. n i =1 N Para Tamaños de Muestra Iguales a SST = ∑ i =1 y..2 y − ∑ N j =1 n 2 ij SS E = SST − SSTratamientos La estadística F La prueba de ANOVA se hace utilizando la distribución F. La distribución F es una familia de distribuciones cuyos parámetros son v1 (grados de libertad del numerador) y v2 (grados de libertad del denominador). La curva es asimétrica. Nivel de confianza (1- α) α = P (rechazar Ho / Ho es cierta) α Fc Para tomar decisiones con ésta distribución lo podemos hacer con cualquiera de estos procesos: Método del valor p Valor p= P (F>Fc) En otras palabras, el valor p para ésta prueba es el área a la derecha de Fc . Si el valor p es mayor que el nivel de significancia elegido (α) entonces no se rechaza la hipótesis nula. Método del estadístico de prueba Se busca el valor crítico , , Si el F calculado (Fc) es menor que el valor crítico Los softwares en vez de usar el , , , , no se rechaza la hipótesis nula. , utilizan el p value. Supuestos del ANOVA ANOVA supone que los errores (residuales) son independientes, normalmente distribuidos con promedio cero y varianza constante. Supuesto de normalidad La distribución F solicita que los datos del numerador y del denominador, provengan de distribuciones normales. Si observamos la composición del F calculado, Fc = MSTRAT MSERROR , nos damos cuenta de que podemos considerar que el numerador cumple con el supuesto de normalidad si nos auxiliamos del Teorema del límite central1. Lamentablemente, dado que el MSerror se obtiene de las observaciones individuales, no podemos utilizar éste teorema, por tanto, es necesario comprobar, ya sea de forma gráfica y/o analítica, que estos cumplen con el supuesto de normalidad. Método gráfico para comprobar el supuesto de normalidad Se procede a graficar los residuales vs el percentil. El percentil se calcula con la fórmula P= (i-0.5)/n, en donde i es la posición del residual dentro de un arreglo ordenado de menor a mayor. La conclusión de éste gráfico es que dado los residuales parecen ajustarse a una línea recta, podemos concluir que los mismos provienen de una distribución normal. 1 Teorema del límite central: Si en lugar de mirar los datos individuales “y” observamos los promedios, a medida que “n” aumenta -no importa la distribución original- de los datos, la distribución de los promedios tenderá a ser normal. La conclusión de éste gráfico es que dado los residuales no se ajustan a una línea recta, podemos concluir que los mismos no provienen de una distribución normal. Entre los métodos analíticos para probar la normalidad se encuentran: i) K - S (Kolmogorov – Smirnov) ii) Anderson – Darling iii) Prueba de Geary Supuesto de homocedasticidad u homogeneidad de varianza El método gráfico para comprobar éste supuesto consiste en graficar los residuales vs el nivel del factor lo que resulta equivalente a graficar los residuales vs los pronósticos para cada nivel. Para decidir con éste gráfico se revisa si la variabilidad del nivel que más varía es menos del doble de la variabilidad del nivel que menos varía. Si éste es el caso, entonces no hay razón para preocuparse por la heterocedasticidad (Varianza no constante). Ejemplo de gráfico donde no hay varianza constante: Versus Fits (response is Conductivity) 10 Residual 5 0 -5 -10 -15 130 132 134 136 138 Fitted Value 140 142 144 146 En este gráfico podemos notar que la variabilidad para el nivel 3 del factor es más del doble del nivel 1, por ésta razón podemos decir que la varianza no es constante para todos los niveles del factor. Entre los métodos analíticos para hacer pruebas de homocedasticidad se encuentran: i) Prueba Levene’s (no presume ninguna distribución) ii) Bartlett (presume normalidad). Independencia Para la independencia se grafican los residuales vs el orden. En éste gráfico no se debe observar ningún tipo de tendencia para que los residuales cumplan con el supuesto de independencia. De éste gráfico podemos concluir que dado que no se observa ninguna tendencia los residuales son independientes. El método analítico para probar la independencia es utilizando la Prueba Durbin–Watson. Ejemplo práctico de los cálculos para ANOVA de un factor Se desea probar si el tipo de batería influye sobre el voltaje obtenido. y = Voltaje 1 1.235 1.406 1.44 4.101 y.. = 14.453 n =3 (repeticiones) a = 4 (niveles) 2 1.118 1.157 1.277 3.552 TIPOS BATERIA DE 3 1.171 0.912 0.99 3.082 4 1.276 1.144 1.298 3.718 . . 1.255 0.26 1.406 0.1782 Fuentes Grados de libertad Batería 4-1=3 . 1.44 . 1.144 = 0.1782 1.298 14.453 12 0.26 0.0818 8 Error . Promedio de cuadrados 0.1782 0.0818 F calculada 0.1782 3 0.0594 F calculada 0.0594 0.0102 5.82 0.0818 8 0.0102 Valor p = 0.21 Mientras mayor la F; p es más pequeña. Fc= 5.82 Conclusión: Al 5% de error se concluye que el tipo de batería influye sobre el voltaje obtenido. ANOVA solo detecta si existe diferencia significativa entre por lo menos un par de medias, pero no puede detectar cuál es el par de medias que difiere. Para poder detectar el par que difiere hay que utilizar una prueba “ad hoc” (prueba después de ANOVA). Pruebas después de ANOVA Scheffé. Newman Keuls Duncan Multiple Range Tukey. LSD Fisher (Minitab). [Least Significant Difference]. Dunnett. LSD Ho: μi = μj μi – μj = 0 0 . – Si ni = nj = n quiere decir que el experimento está balanceado. . LSD = Si . . t a/2, n1 + n2 – 2 > LSD i, difieren significativamente. El objetivo de la prueba LSD es probar todos contra todos. Por otro lado, la prueba de Dunnett sirve para probar todos contra una de las muestras que se toma como control.