Análisis de las series temporales de los precios del mercado

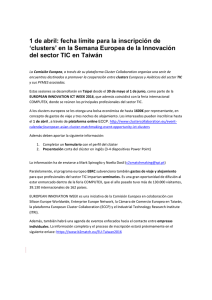

Anuncio