tesis de maestría en ciencias

Anuncio

Centro Nacional de Investigación y Desarrollo Tecnológico

Departamento de Ciencias Computacionales

TESIS DE MAESTRÍA EN CIENCIAS

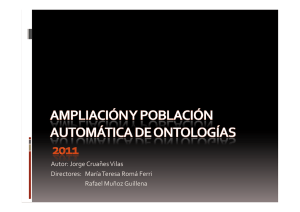

Poblado Automático de Ontologías Espaciales a Partir de Texto no

Estructurado

Presentada por

Juan Diego Gómez Fierros

Ing. en Sistemas Computacionales por el I.T. de Zacatepec

Como requisito para la obtención del grado de:

Maestría en Ciencias en Ciencias de la Computación

Directora de tesis:

Dra. Azucena Montes Rendón

Co-Director de tesis:

Dr. David Eduardo Pinto Avendaño

Jurado:

Dr. Juan Gabriel González Serna – Presidente

M.C. Javier Ortiz Hernández – Secretario

M.C. José Alejandro Reyes Ortiz – Vocal

Dra. Azucena Montes Rendón – Vocal Suplente

Cuernavaca, Morelos, México.

30 de noviembre de 2012

Dedicatorias

Quiero dedicar este trabajo de tesis a mi madre la cual me ha apoyado siempre

brindándome su amor desde el primer día que me cargo en sus brazos y me ha enseñado el

valor de la vida y el conocimiento de las cosas más importantes que se puedan aprender, el

respeto, amor y los valores inculcados por su constante dedicación. Este trabajo es tuyo al

igual que yo.

A mi padre que siempre supo brindar su constante ayuda económica para que nada faltara

en el hogar y me mostró el camino que debe seguir un verdadero hombre siempre al lado de

su familia, ayudando, respetando, amando. Te dedico este trabajo.

A mis hermanos que siempre me mostraron su incondicional apoyo para salir adelante sé

que para cualquier cosa que necesite puedo contar con ellos y con su particular forma de ser

lo cual los hace únicos y valiosos. Gracias por todo

Cada quien en su forma de pensar y en su educación puede creer en lo que considera mejor

y desde la más tierna infancia me fue inculcado el amor a Dios, por eso sé que gracias a él

puedo estar ahora en el lugar en el que estoy, y ya lo menciono Blaise Pascal “En el

corazón de todo hombre existe un vacío que tiene la forma de Dios. Este vacío no puede ser

llenado por ninguna cosa creada. Él puede ser llenado únicamente por Dios, hecho

conocido mediante Cristo Jesús.”

I

Agradecimientos

Quiero expresar mi más profundo agradecimiento a la directora de esta tesis: la Dra.

Azucena Montes Rendón su dedicación al conocimiento científico y su espíritu enérgico y

afectivo son un ejemplo a seguir y han incitado mi ilusión por el estudio gracias por

depositar su confianza en mí. Puedo asegurar que he tenido el privilegio de poder trabajar,

no bajo su dirección, sino con su ayuda y su colaboración.

A mis revisores de tesis: M.C. José Alejandro Reyes Ortiz, Dr. Juan Gabriel González

Serna y el Dr. Javier Ortiz Hernández, los cuales dedicaron parte de su tiempo a realizar las

revisiones necesarias para poder realizar un trabajo digno de una investigación de maestría.

Gracias por su ayuda apoyo y consejos.

De mi familia poco hace falta decir. Mis padres y hermanos siempre han estado ahí a mi

lado incondicionalmente, siempre brindándome su ayuda, comprensión apoyo pero sobre

todo su amor, quiero agradecerles porque gracias a ellos me encuentro en donde estoy

ahora.

A mis compañeros que los considero como una auténtica fortuna repartida en varios sitios

distintos. Muchas gracias a todos mis amigos, a los de siempre que han sobrellevado con

gran paciencia las innumerables horas de mi ausencia y a los de ahora, que espero

conservar por mucho tiempo, ambos grupos forman parte inseparable en esta etapa de mi

vida.

Al centro nacional de investigación y desarrollo tecnológico cenidet por aceptarme como

alumno, que gracias a sus profesores tengo las herramientas necesaria para poder ser un

investigador de éxito y gracias al apoyo económico brindado por el CONACYT pude

dedicarme íntegramente al estudio de mi carrera.

II

Abstract

The process for creation automatic of ontologies also called ontology learning involves

several activities, which can be simplified into: a) find the relevant terms of the domain

(Classes) and taxonomic relationships between them; b) establish no taxonomic

relationships between classes; c) find instances of classes and relationships. This process

has been an area of study for several investigations that attempt to ontologies from text.

There are several proposals to automate the process of building of ontologies, which

have some common characteristics differences by distinguishing factors very precise, some

of these proposals use statistical approaches (Sánchez & Moreno, 2004), other natural

language processing (NLP) (Sabou, Wroe, Goble, & Mishne, 2005) and finally there are

some that combine both techniques (Cimiano & Vaolker, 2005).

The type of data they handle the tools vary in format, can make populated ontological

for structured data, semi-structured data or even plain text which implies a high degree of

analysis and using NLP techniques.

Currently, in the CENIDET in the group of Web Technologies, is developing a project

in which the main objective is extraction and information retrieval from ontologies. An

important part of this project is the transformation of the information contained in a text to

ontology and using the latter for the extraction and recovery of information.

In this work thesis is instantiated ontology with spatial information which complements

the ontology “OntoEvento (Reyes, 2011)” in their part of spatiality indicating the place of

occurrence of an event, to do this using various techniques for recognizing spatial entities

and for populating semi-automatic of ontologies, as the use of patterns lexical - syntactic.

Keywords: ontology population, PLN, Ontologies, lexical patterns

.

III

Resumen

El proceso de creación semiautomático de ontologías también llamado aprendizaje

ontológico involucra varias actividades, las cuales se pueden simplificar en: a) encontrar los

términos relevantes del dominio (clases) y las relaciones taxonómicas entre ellas; b)

establecer las relaciones no taxonómicas entre las clases; c) encontrar las instancias de las

clases y las relaciones. Este proceso ha sido un campo de estudio para varias

investigaciones que intentan obtener ontologías a partir de texto.

Existen varias propuestas para automatizar el proceso de construcción de ontologías en

la parte de poblado ontológico, las cuales tienen algunas características en común

diferenciándose entre ellas por factores distintivos muy precisos, algunas de estas

propuestas utilizan enfoques estadísticos (Sánchez & Moreno, 2004), otras procesamiento

de lenguaje natural (Sabou, Wroe, Goble, & Mishne, 2005) y finalmente existen algunos

que mezclan ambas técnicas (Cimiano & Vaolker, 2005).

El tipo de datos que manejan las herramientas mostradas en el párrafo anterior, varía en

su formato, pudiendo realizar el poblado ontológico de datos estructurados, semiestructurados o incluso de textos sin formato (texto plano) lo cual implica un alto grado de

análisis y el uso de técnicas del PLN (Procesamiento de Lenguaje Natural).

Actualmente, en el cenidet, en el grupo de Tecnologías Web se está desarrollando un

proyecto donde el objetivo principal es la extracción y recuperación de información a partir

de ontologías. Una parte importante de este proyecto es la transformación de la información

contenida en un texto a una ontología y utilizar esta última para la extracción y

recuperación de información.

En los siguientes capítulos que integran este trabajo de tesis se explica cómo se realiza

la instanciación de una ontología con información espacial, la cual complementa la

ontología OntoEvento (Reyes, 2011) en su parte de espacialidad, indicando el lugar de

ocurrencia de un acontecimiento, para realizar esto se utilizan diversas técnicas para el

reconocimiento de entidades espaciales y para el poblado semiautomático de ontologías,

como el uso de patrones léxicos - sintácticos.

Palabras clave: Poblado Ontológico, PLN, Ontologías, Patrones léxicos.

IV

Contenido

Capítulo 1. Introducción ....................................................................................................................1

1.1

Motivación .........................................................................................................................2

1.2

Planteamiento del problema ..............................................................................................2

1.3

Objetivos ............................................................................................................................3

1.3.1

Objetivo principal .......................................................................................................3

1.3.2

Objetivos particulares .................................................................................................3

1.4

Alcances y limitaciones .......................................................................................................3

1.4.1

Alcances ......................................................................................................................3

1.4.2

Limitaciones ................................................................................................................4

1.5

Organización de la tesis ......................................................................................................4

Capítulo 2. Fundamento teórico........................................................................................................5

2.1

Ontologías ..........................................................................................................................6

2.2.1

Principales componentes del modelado de ontologías ..................................................6

2.2.2

Aprendizaje de ontologías ..............................................................................................8

2.3

Procesamiento del lenguaje natural (PLN) .......................................................................10

2.3.1

Clasificación del PLN en función de los niveles de análisis lingüístico ..........................13

2.4

Extracción de información ................................................................................................14

2.5

Patrones lingüísticos .........................................................................................................17

2.6

Espacialidad y eventos ......................................................................................................18

2.6.1

Espacialidad ..................................................................................................................18

2.6.1.1 Espacialidad en textos ...............................................................................................19

2.6.2

Eventos .........................................................................................................................19

2.6.2.1 Características de los eventos ...................................................................................20

Capítulo 3. Estado del arte ..............................................................................................................22

3.1

Introducción .....................................................................................................................23

3.2

Enfoques para aprendizaje ontológico .............................................................................24

3.2.1

Enfoque estadístico ......................................................................................................25

3.2.2

Enfoque lingüístico .......................................................................................................26

3.2.3

Enfoques híbridos .........................................................................................................28

3.2.4

Enfoque basado en patrones lingüísticos .....................................................................29

3.2.4.1 Patrones construidos manualmente .........................................................................30

3.2.4.2 Patrones construidos automáticamente ...................................................................31

V

3.3

Herramientas ....................................................................................................................34

3.3.1

OpenCalais ....................................................................................................................34

3.3.2

AlchemyAPI ..................................................................................................................35

3.3.3

Extractiv ........................................................................................................................36

3.3.4

STILUS NER ...................................................................................................................38

3.3.5

ZEMANTA .....................................................................................................................39

3.3.6

Comparativa entre herramientas .................................................................................40

Capítulo 4. Metodología de solución ...............................................................................................42

4.1

Identificación de patrones ................................................................................................43

4.1.1

Características del método ...........................................................................................44

4.1.2

Metodología para extracción de patrones ...................................................................45

4.1.3

Extracción de patrones léxicos .....................................................................................46

4.2

Selección de patrones relevantes .....................................................................................48

4.3

Aplicación de los patrones ................................................................................................51

4.4

Instanciación de OntoEspacio en espacialidad .................................................................52

4.5

Prototipo ..........................................................................................................................53

Capítulo 5. Pruebas y resultados .....................................................................................................57

5.1

Introducción .....................................................................................................................58

5.2

Métricas de evaluación.....................................................................................................58

5.2.1

Precisión .......................................................................................................................58

5.2.2

Recuerdo ......................................................................................................................59

5.2.3

Medida F .......................................................................................................................59

5.3

Plan de pruebas ................................................................................................................60

5.3.1

Elementos de prueba ...................................................................................................60

5.3.1.1 Características probadas ...........................................................................................60

5.3.1.2 Características excluidas ...........................................................................................61

5.3.1.3 Enfoque ....................................................................................................................62

5.3.1.4 Criterio éxito/fracaso de los casos de prueba ..........................................................62

5.3.1.5 Criterios de suspensión y requerimientos de reanudación .......................................62

5.3.1.6 Documentos entregables de las pruebas ..................................................................63

5.3.1.7 Tareas de pruebas .....................................................................................................63

5.3.1.8 Requerimientos necesarios para realizar las pruebas ...............................................64

5.3.1.9 Responsabilidades .....................................................................................................64

VI

5.3.1.10 Riesgos y contingencias ............................................................................................64

5.3.2

Aprobación ...................................................................................................................64

5.3.3

Casos de prueba ...........................................................................................................65

5.3.4

Especificación del procedimiento de prueba ................................................................65

5.4

Pruebas.............................................................................................................................68

5.4.1

Reconocimiento de entidades espaciales .....................................................................68

5.4.2

Identificación de conceptos relacionados a eventos ....................................................70

5.4.3

Solución a anáfora lingüística .......................................................................................70

5.4.4

Poblado ontológico.......................................................................................................72

Capítulo 6. Conclusiones y trabajos futuros ....................................................................................75

6.1

6.1.1

Conclusiones.....................................................................................................................76

Contribuciones .............................................................................................................77

6.2

Publicaciones ....................................................................................................................77

6.3

Trabajos futuros ...............................................................................................................78

Anexos .............................................................................................................................................84

Herramientas utilizadas................................................................................................................85

PETRA Tag ....................................................................................................................................85

OpenCalais ...................................................................................................................................87

VII

Figuras

Figura 1. Ejemplo de una ontología........................................................................................ 8

Figura 2. Capas del aprendizaje ontológico (Cimiano, 2006) .............................................. 10

Figura 3. Niveles del Procesamiento de Lenguaje Natural (Castellanos, Fernández, &

Valencia, 2008)..................................................................................................................... 13

Figura 4. Ejemplo de anuncio de un seminario “Ontologies and Information Extraction” .. 16

Figura 5. Entramado de conceptos formales para el ejemplo, el turismo (Cimiano, Hotho, &

Staab, 2005) .......................................................................................................................... 28

Figura 6. Jerarquía de conceptos ontológicos para el ejemplo, el turismo (Cimiano, Hotho,

& Staab, 2005) ...................................................................................................................... 28

Figura 7. Clasificación de entidades en Open Calais ........................................................... 35

Figura 8. Extracción de entidades en AlchemyAPI .............................................................. 36

Figura 9. Extracción de entidades en Extractiv .................................................................... 38

Figura 10. Etiquetado de entidades en STILUS NER .......................................................... 39

Figura 11. Extracción de entidades en ZEMANTA ............................................................. 40

Figura 12. Gráfica comparativa de las herramientas ............................................................ 41

Figura 13 Arquitectura general del método propuesto para la extracción de patrones ........ 46

Figura 14. Entidades espaciales ............................................................................................ 47

Figura 15. Estructura de entidades espaciales ...................................................................... 48

Figura 16. Modelo general de solución ................................................................................ 51

Figura 17. Interfaz del prototipo ........................................................................................... 53

Figura 18. Explorador de archivos ....................................................................................... 53

Figura 19. Texto de noticia procesado.................................................................................. 54

Figura 20. Extracción de argumentos y RA ......................................................................... 55

Figura 21. Extracción de candidatos espaciales ................................................................... 55

Figura 22. OntoEspacio instanciada ..................................................................................... 56

Figura 23. Ecuación de la precisión (Salton & McGill, 1983) ............................................. 58

Figura 24. Ecuación del recuerdo (Salton & McGill, 1983) ................................................ 59

Figura 25. Grafica de precisión y recuerdo en el reconocimiento de entidades mediante

patrones................................................................................................................................. 69

Figura 26. OntoEspacio ........................................................................................................ 73

Figura 27. Gráfica de precisión y recuerdo para el poblado ontológico............................... 74

Figura 28. Precisión de las herramientas .............................................................................. 88

Figura 29. Exhaustividad de las herramientas ...................................................................... 88

Figura 30. Precisión y Exahustividad interpoladas .............................................................. 88

VIII

Tablas

Tabla 1 Ccomparativa entre enfoques .................................................................................. 33

Tabla 2. Comparativa entre herramientas ............................................................................. 40

Tabla 3. Formato de las entidades espaciales en textos de noticias ..................................... 43

Tabla 4. Actividades planeadas en el plan de pruebas ......................................................... 63

Tabla 5. Resultados en el reconocimiento de entidades espaciales ...................................... 69

Tabla 6. Pruebas de anáfora lingüística ................................................................................ 70

Tabla 7. Resultados en el poblado ontológico ...................................................................... 73

Tabla 8. Comparativa entre herramienta para la extracción de entidades ............................ 87

IX

Capítulo 1. Introducción

En este capítulo se presentan los principales temas que llevaron a la realización de esta

tesis, tales como, los objetivos, limitaciones y la metodología de solución propuesta para

realizar el poblado de la ontología espacial.

Capítulo 1.- Introducción

1.1

Motivación

El uso de ontologías en diferentes tareas ha tenido un crecimiento acelerado, es por ello

que se necesita crear ontologías de forma rápida y precisa. El desarrollo de esta tarea de

manera manual implica altos costos y consume bastante tiempo al desarrollador de éstas o

al experto del dominio. Por lo tanto, surge la idea del aprendizaje semiautomático y

automático de elementos ontológicos, esta idea se propone como solución a los problemas

que origina la creación manual de ontologías.

El proceso de creación semiautomático de ontologías también llamado aprendizaje

ontológico involucra varias actividades, las cuales se pueden simplificar en: a) encontrar los

términos relevantes del dominio (clases) y las relaciones taxonómicas entre ellas; b)

establecer las relaciones no taxonómicas entre las clases; c) encontrar las instancias de las

clases y las relaciones. Este proceso ha sido un campo de estudio para varias

investigaciones que intentan obtener ontologías a partir de texto.

En el cenidet, en el grupo de Tecnologías Web se está desarrollando un proyecto donde

el objetivo principal es la extracción y recuperación de información a partir de ontologías.

Una parte importante de este proyecto es la transformación de la información contenida en

un texto a una ontología y utilizar esta última para la extracción y recuperación de

información.

1.2

Planteamiento del problema

En (Reyes, 2011) el objetivo principal es diseñar una metodología para la creación de

ontologías de dominio a partir de texto no estructurado mediante el Procesamiento

automático del lenguaje natural, con un enfoque lingüístico. En este trabajo se ha

desarrollado una ontología llamada “OntoEvento” que representa la conceptualización de

un evento para abordar esta problemática.

La conceptualización de un evento está fundada prácticamente en tres aspectos:

Espacio: todo evento sucede en algún lugar, (Miller, 1999)

Tiempo: todo evento transcurre en un intervalo de tiempo (Desclés, 2010)

Agentividad: la mayoría de los eventos son realizados por algún ente animado o

inanimado. (Tesnière, 1976) y (Halliday, 1994)

Por lo tanto, en este trabajo de tesis se pretende abordar los problemas relacionados al

reconocimiento de entidades espaciales, para instanciar la ontología OntoEvento en su parte

de espacialidad.

Juan Diego Gómez Fierros

2|Página

Capítulo 1.- Introducción

Utilizando técnicas de Procesamiento de Lenguaje Natural (PLN) y un análisis

lingüístico profundo de los textos para la extracción de los elementos espaciales relevantes.

1.3

Objetivos

En esta sección se presenta el objetivo principal y los objetivos particulares de esta

tesis.

1.3.1 Objetivo principal

El objetivo principal de este trabajo de tesis consiste en:

“Desarrollar una metodología que permita identificar información espacial de un texto no

estructurado para instanciar la ontología OntoEvento”

1.3.2 Objetivos particulares

1.4

Identificar y extraer conceptos relacionados a eventos.

Identificar y extraer conceptos relacionados al lugar donde sucede un evento.

Implementar los métodos propuestos en (Reyes, 2011a) para tratamiento de

elipsis y anáfora.

Desarrollar una herramienta que implemente la metodología creada.

Evaluar los resultados de la extracción de la información.

Alcances y limitaciones

1.4.1 Alcances

La metodología sólo identifica lugares y eventos.

Se identifican eventos de tipo verbo y eventos nominalizados.

Se consideran los fenómenos de elipsis y anáfora.

Se desarrolló una herramienta que implementa la metodología.

Se instancia OntoEvento en la clase de espacio y evento.

Se evaluaron los resultados con la intervención de un experto.

Juan Diego Gómez Fierros

3|Página

Capítulo 1.- Introducción

1.4.2 Limitaciones

1.5

Los textos de los que se extrae la información para tomar los conceptos

espaciales son de tipo periodístico, no se toman en cuenta otros dominios.

Los textos se encuentran en formato de texto plano.

La ontología resultante sólo contiene información relacionada con lugares y

eventos

Sólo se obtiene la ontología espacial de documentos en idioma español.

No se considera la información temporal ni causal

Organización de la tesis

En el capítulo uno se muestra la principal motivación, planteamiento del problema,

objetivos, metodología de solución, alcances y limitaciones a los que se acotó la tesis,

mostrando las principales ideas y la solución para poblar una ontología.

En el capítulo dos se muestra el marco teórico en el cual se explica el fundamento

teórico necesario para el desarrollo de esta tesis como las ontologías, extracción de

información, técnica de PLN (Procesamiento de Lenguaje Natural) y los patrones

lingüísticos.

En el capítulo tres se observa el estado del arte, que es una recopilación de diferentes

trabajos los cuales fueron analizados para conocer las técnicas utilizadas por otros

investigadores en la solución de una problemática similar a la presentada en esta tesis.

En el capítulo cuatro se describe el trabajo principal de esta tesis, se desglosa la

metodología desarrollada explicando cada una de las partes que la componen y como se

llegó a la conclusión de utilizar las diferentes herramientas y módulos que la conforman,

también se muestran imágenes del prototipo desarrollado explicando cada una de sus

funcionalidades, insumos y salidas.

En el capítulo cinco se muestran las pruebas planteadas primeramente en un plan de

pruebas, en el que se describen los pasos a seguir para la realización de cada una de estas,

posteriormente se muestran los resultados obtenidos al aplicar cada una de las pruebas

definidas.

En el capítulo seis se resumen todas las conclusiones obtenidas durante la realización de

este trabajo de tesis y se explican los trabajos futuros pendientes planteados durante la

realización de la misma.

Juan Diego Gómez Fierros

4|Página

Capítulo 2. Fundamento teórico

En este capítulo se presentan las diversas y principales definiciones, técnicas y conceptos

abordados como, técnicas de PLN (Procesamiento de Lenguaje Natural), Extracción de

información, aprendizaje ontológico y patrones lingüísticos, todo esto necesario para el

desarrollo de los métodos que componen la metodología de solución.

Capítulo 2.- Fundamento teórico

2.1

Ontologías

Después del nacimiento de la Web Semántica, la cual se convirtió en un gran avance,

las ontologías se convirtieron en sinónimo para la solución a muchos problemas sobre el

hecho de que las computadoras no entienden el lenguaje humano: si hubiera una ontología

en la que todos los documentos fueran marcados con ella y además cuente con agentes

capaces de entender el marcado, los equipos finalmente serían capaces de procesar nuestras

consultas de una manera más eficiente. El éxito de Google nos muestra que la misión no se

ha hecho realidad, se ve obstaculizada por la increíble cantidad de trabajo extra que se

requiere para la codificación semántica intelectual del marcado (en comparación con

simplemente cargar una página HTML). Para disminuir este cuello de botella, el ámbito

para el aprendizaje de ontologías ha surgido como un importante sub-campo de la

ingeniería de la ontológica.

Es ampliamente aceptado que las ontologías pueden facilitar la comprensión de texto y

Procesamiento automatizado de los recursos textuales. Pasar de las palabras a los conceptos

no sólo mitiga los problemas de escasez de datos, pero también promete atractivas

soluciones a la polisemia y la homonimia, encontrando conceptos no ambiguos que pueden

mapearse para diversos usos, en lugar del uso de palabras posiblemente ambiguas.

El término ontología puede entenderse de diferentes formas y se ha utilizado en la

filosofía por muchos siglos. Por el contrario, la noción de la ontología en el ámbito de la

informática es más reciente, pero ha sido utilizado de manera distinta a la expresada en lo

referente a los detalles de la definición (Biemann, 2005).

2.2.1 Principales componentes del modelado de ontologías

Las ontologías tienen los siguientes componentes que sirven para representar el

conocimiento de algún dominio (Corcho, Fernández, Gómez, & López, 2003):

Los conceptos son objetos o entidades, considerados desde un punto de vista amplio.

Por ejemplo, en el dominio legal los siguientes términos son utilizados como conceptos:

persona física, tribunal, menor de edad, etc.

Los conceptos de una ontología están normalmente organizados en taxonomías en las

cuales se pueden aplicar mecanismos de herencia. Por ejemplo, se puede representar una

taxonomía de entidades legales, donde una persona jurídica es subclase de persona, una

compañía es subclase de persona jurídica, una compañía privada es subclase de compañía,

etc.

Juan Diego Gómez Fierros

6|Página

Capítulo 2.- Fundamento teórico

Las relaciones representan un tipo de asociación entre conceptos del dominio. Si la

relación une dos conceptos –por ejemplo, la relación se celebra en que une un juzgado y un

juicio– se denomina relación binaria. Una relación binaria relevante es Subclase-de, ya que

se utiliza para construir taxonomías de clase.

Las instancias se utilizan para representar individuos en la ontología. Ejemplos de

instancias del concepto tribunal son la Audiencia Estatal de México o el Tribunal

Constitucional. Las relaciones también se pueden instanciar. Por ejemplo, se podría

expresar que en la Audiencia estatal de México se celebra el juicio 127/2004.

Las constantes son valores numéricos que no cambian en un largo período de tiempo.

Por ejemplo, en España la edad de mayoría de edad es de 18 años.

Los atributos describen propiedades. Se pueden distinguir dos tipos de atributos: de

instancia y de clase. Los atributos de instancia describen propiedades de las instancias de

los conceptos, en las cuales toman su(s) valor(es). Estos atributos se definen en un concepto

y se heredan a sus subconceptos e instancias. Por ejemplo, el nombre de una persona física

es propio de cada instancia.

Los atributos de clase describen conceptos y toman su(s) valor(es) en el concepto en el

cual se definen. Estos atributos no se heredan ni a los subconceptos ni a las instancias. Un

ejemplo es el atributo tipo de control del concepto compañía, que puede ser utilizado para

determinar el tipo de control de una compañía privada, de una compañía pública y de una

compañía de control privado y público.

Los axiomas formales son expresiones lógicas siempre verdaderas que suelen utilizarse

para definir restricciones en la ontología. Un ejemplo de axioma es que una persona no

puede ser el demandado y el demandante en el mismo juicio.

Las reglas se utilizan normalmente para inferir conocimientos en la ontología, tales

como valores de atributos, instancias de relaciones, etc. Un ejemplo de una regla es la

siguiente: un juicio donde el acusado es un menor de edad que tiene más de 14 años se

celebra en un tribunal de menores.

Para ejemplificar los elementos de una ontología se muestra la figura 1 que presenta una

ontología en el dominio de instrumentos musicales.

De esta ontología se puede identificar los siguientes elementos: la clase instrumentos

musicales, la cual tiene dos subclases instrumentos de viento e instrumentos de cuerda; la

relación taxonómica subclase_de entre instrumentos de viento e instrumentos musicales y

la relación es_un que conecta los conceptos instrumentos de viento e instrumentos de metal;

y por ultimo una instancia de la clase instrumentos con traste que es La guitarra de Paul.

Juan Diego Gómez Fierros

7|Página

Capítulo 2.- Fundamento teórico

Figura 1. Ejemplo de una ontología

Existen tres tipos fundamentales de ontologías según (Steve, Gangemi, & Pisanelli.,

1998):

Ontologías de un dominio, en las que se representa el conocimiento especializado

pertinente de un dominio o subdominio, como la medicina, las aplicaciones militares, la

cardiología.

Ontologías genéricas, en las que se representan conceptos generales y fundacionales

del conocimiento como las estructuras parte/todo, la cuantificación, los procesos o los

tipos de objetos.

Ontologías representacionales, en las que se especifican las conceptualizaciones que

subyacen a los formalismos de representación del conocimiento, por lo que también se

denominan meta-ontologías (meta-level o top-level ontologies).

A estos tres tipos se añade las ontologías que han sido creadas para una actividad o

tarea específica (denominadas task ontologies), como por ejemplo la venta de productos o

el diagnóstico de una enfermedad y las ontologías creadas para una aplicación específica.

2.2.2 Aprendizaje de ontologías

Una ontología proporciona una estructura y un vocabulario común para la organización

del conocimiento de un dominio específico, en la cual se encuentran todos los conceptos

interconectados a través de relaciones.

Juan Diego Gómez Fierros

8|Página

Capítulo 2.- Fundamento teórico

Por tanto el uso de las ontologías en el PLN nos permite representar la estructura

conceptual del lenguaje, proporcionando una riqueza semántica mayor que un lexicón

computacional o que un tesauro. La relación que se establece entre las ontologías y las

técnicas de PLN es bidireccional: por un lado son herramientas para la representación de

redes semánticas y por otro el PLN es una técnica importante en la construcción automática

de ontologías (ontology learning)

Las ontologías se utilizan como redes semánticas que representan los conceptos del

mundo extralingüístico. De este modo, a través de las relaciones entre los conceptos,

permiten identificar el contexto de un término. La identificación del contexto es esencial

para saber cuál es el sentido de ese término en el discurso. Una de las aproximaciones del

uso de PLN y las ontologías se centra en la construcción automática de ontologías y en la

detección de los elementos ontológicos (conceptos, clases, relaciones y atributos) a partir de

texto en lenguaje natural.

La construcción automática de ontologías (ontology learning en inglés) se ha

convertido en uno de los principales focos de investigación dentro del ámbito de la Web

Semántica. Las ontologías en la Web Semántica se utilizan como estructura compleja para

la representación del conocimiento, generalmente de un dominio. Dicho conocimiento está

contenido en muchas ocasiones en textos escritos en lenguaje natural. La construcción de

ontologías es un proceso lento y costoso que ralentiza el avance de la Web Semántica, por

esto es necesario desarrollar métodos eficaces para la generación automática de ontologías

a partir de lenguaje natural. El aprendizaje de ontologías tiene diferentes capas o sub-tareas

(Cimiano, 2006), las cuales se describen a continuación y se muestran en la figura 2.

Adquisición de terminología relevante

Identificación de sinónimos (posiblemente a través de lenguajes)

Formación de conceptos

Organización jerárquica de los elementos

Aprendizaje de relaciones, propiedades, atributos, junto con su respectivo rango

y dominio

Organización jerárquica de las relaciones

Instanciación de los axiomas del esquema

Definición de los axiomas arbitrarios

Juan Diego Gómez Fierros

9|Página

Capítulo 2.- Fundamento teórico

Axiomas

generales

Axiomas

del esquema

toda ciudad tiene una única capital

Disjunta (rio, montaña)

capital_de ≤R localizado_en

Jerarquía de relaciones

fluye_a_través_de (dom: rio, rango: ciudad)

capital ≤c ciudad

C:= país

Relaciones

Jerarquía de conceptos

Conceptos

[país, nación]

río, ciudad, país, capital

Sinónimos

Términos

Figura 2. Capas del aprendizaje ontológico (Cimiano, 2006)

Para los propósitos de la figura 2 se incluyen algunos ejemplos concretos para el

dominio de la geografía, dentro del paso de adquisición de terminología se extraen los

términos como, ríos, ciudades, naciones, capitales, país. En el paso de descubrimiento de

sinónimos se agrupan los términos nación y país que en un cierto contexto son sinónimos.

En la fase de descubrimiento de conceptos se hace una separación entre las instancias y los

conceptos o clases, para los cuales se crea una jerarquía de conceptos, por ejemplo en el

dominio geográfico se descubre que capital ≤C ciudad.

También se ejemplifica el aprendizaje de relaciones junto con su dominio y su rango

con la relación fluye_a_través_de entre un rio y ciudad. La siguiente capa es el

ordenamiento jerárquico de las relaciones que se ejemplifica con que capital_de es una

especialización de localizado_en. En el nivel de la instanciación de axiomas del esquema se

deriva que la clase rio y montaña son conceptos disjuntos, es decir que ninguna instancia

que aparezca en la clase rio puede aparecer en la clase montaña. Finalmente, también se

pueden derivar relaciones complejas entre los conceptos y las relaciones en forma de

axiomas, un ejemplo de esto es que cada instancia de la clase ciudad sólo puede tener

asociada una única capital.

2.3

Procesamiento del lenguaje natural (PLN)

El Procesamiento del Lenguaje Natural (PLN) es una sub-disciplina de la Inteligencia

Artificial y de la lingüística computacional. El PLN se ocupa de la formulación e

investigación de mecanismos eficaces computacionalmente para la comunicación entre

personas o entre personas y máquinas por medio del lenguaje natural.

Juan Diego Gómez Fierros

10 | P á g i n a

Capítulo 2.- Fundamento teórico

El PLN trata de diseñar mecanismos para comunicarse que sean eficaces

computacionalmente. Los modelos aplicados se enfocan no sólo a la comprensión del

lenguaje de por sí, sino a aspectos generales cognitivos humanos y a la organización de la

memoria. El lenguaje natural sirve sólo de medio para estudiar estos fenómenos.

El Procesamiento del Lenguaje Natural (PLN) puede ser visto como un intento de

simular el comportamiento lingüístico humano, de manera que, el sistema de signos que

constituye la lengua, sea adquirido y procesado por el computador, siendo éste capaz de

reconocer, comprender, interpretar y generar lenguaje humano, ya sea escrito o hablado.

Desde los años 50, dentro del marco de la Inteligencia Artificial, se han llevado a cabo

numerosas investigaciones con el objetivo establecer mecanismos computacionales que

permitieran la comunicación eficaz hombre-máquina en lenguaje natural.

Las primeras décadas (50’s - 70’s) se caracterizaron por un optimismo inicial en el que

se pretendía dotar a la máquina de competencia lingüística plena, pero los resultados

obtenidos no fueron los esperados. Por este motivo, en las décadas siguientes, hasta la

actualidad, los esfuerzos se han centrado en el desarrollo de aplicaciones específicas, tales

como, el reconocimiento del habla, el procesamiento del texto a nivel morfosintáctico, el

desarrollo de herramientas para la adquisición de conocimiento semántico, etc.

En el intento por la automatización de los procesos lingüísticos han confluido distintas

disciplinas, tanto informáticas como lingüísticas, dando lugar a denominaciones que

sintetizan esa “hibricidad”.

Éste es el caso de la lingüística computacional, que puede ser vista como un conjunto

heterogéneo de teorías, métodos, herramientas, aplicaciones y productos que tienen en

común la consideración de la lengua como un objeto susceptible de ser tratado mediante

procedimientos informáticos (Llisterri, 2003).

En sus inicios el PLN se centró principalmente en tres áreas: la traducción automática,

el reconocimiento del habla y el acceso a bases de datos (Jackson & Schilder, 2006).

Aunque estos tres elementos siguen siendo objeto de las investigaciones en PLN, a lo largo

de las décadas y con el desarrollo de nuevas tecnologías como Internet, se han incorporado

nuevos usos, entre ellos la recuperación de información, los sistemas de diálogo, la

búsqueda de respuestas (question answering), extracción de información o el resumen

automático.

Pero, a pesar de los avances continúa sin resolver uno de los problemas nucleares en IA,

esto es, cómo dotar a las máquinas de conocimiento suficiente del mundo extralingüístico,

de forma que sean capaces de producir oraciones con sentido pleno e inferir conocimiento

de ellas.

Juan Diego Gómez Fierros

11 | P á g i n a

Capítulo 2.- Fundamento teórico

Lo que se pretende con el desarrollo de las distintas técnicas de procesamiento de

lenguaje natural, es el acercamiento a los mecanismos de funcionamiento de la lengua, al

conjunto de operaciones y de reglas que relacionan todos y cada uno de los elementos del

sistema de signos que es la lengua (Marín, 2000). No hay que olvidar a respecto a esto, los

estudios pragmáticos y socio-culturales que permiten enmarcar una determinada

producción textual en su contexto discursivo.

Estos aspectos han sido estudiados por las distintas áreas de la lingüística: fonética,

morfología, sintaxis, semántica y pragmática, por tanto, los diferentes niveles o fases de las

técnicas empleadas para el procesamiento del lenguaje natural se corresponden, a grosso

modo, con las áreas más arriba mencionadas. Además, puede haber tareas previas de

procesamiento formal del texto, tales como la identificación y segmentación de las

unidades a analizar.

Las disciplinas relacionadas con el PLN son:

Lingüística:

Ofrece una descripción y modelización del lenguaje humano y de las lenguas

naturales.

Proporciona teorías, herramientas y técnicas para el Procesamiento automático de la

lengua.

Informática

Proporciona teorías, herramientas y técnicas para el Procesamiento automático de la

lengua.

Inteligencia artificial

Desarrollo de sistemas informáticos que simulan el comportamiento humano.

Adquisición de conocimientos.

Razonamiento a partir de los conocimientos adquiridos.

Representación de los conocimientos adquiridos.

Ingeniería de telecomunicación

Centrada en la transmisión y el Procesamiento de la señal del habla.

Psicología

Proporciona una descripción y modelización de la interacción y del comportamiento

lingüístico humano.

Juan Diego Gómez Fierros

12 | P á g i n a

Capítulo 2.- Fundamento teórico

2.3.1 Clasificación del PLN en función de los niveles de análisis lingüístico

Las fases o niveles de procesamiento no son independientes unas de otras, sino que

están interrelacionadas. A medida que se va avanzando en el análisis, será necesario

recurrir al conocimiento extraído en niveles anteriores, e incluso posteriores.

Por ejemplo, para la desambiguación de las categorías morfológicas es necesario

recurrir a la sintaxis para determinar la función de un término en la oración. Por otro lado

aunque el procesamiento en los niveles inferiores como el análisis morfológico y la

desambiguación han alcanzado cotas aceptables de eficacia, no se puede decir lo mismo de

niveles superiores como la semántica y la pragmática debido a su complejidad.

Las fases o niveles del procesamiento del lenguaje natural son los siguientes (Figura 3):

Figura 3. Niveles del Procesamiento de Lenguaje Natural (Castellanos, Fernández, & Valencia, 2008)

Juan Diego Gómez Fierros

13 | P á g i n a

Capítulo 2.- Fundamento teórico

• Pre-procesamiento textual: Consiste en identificar las partes que lo forman y

dividirlas adecuadamente para el análisis. Las principales partes del texto que se suelen

identificar son: las palabras, las oraciones y los párrafos. Se pueden distinguir también

elementos como encabezados, notas al pie, hipervínculos, etc.

Si se trata de un texto escrito, ésta es la primera parte del análisis, si por el contrario se

trata de discurso oral, será necesario utilizar en primer lugar el procesamiento fonético.

• Procesamiento fonético: la fonética se encarga de la descripción de las dimensiones

físico-acústicas, articulatorias y auditivas de los sonidos del lenguaje. Esta parte es

necesaria para el desarrollo de tecnologías del habla.

• Procesamiento léxico-morfológico: La morfología estudia la estructura de la forma

de las palabras, básicamente a través del uso de morfemas (flexivos y derivativos).

Basándose en esos morfemas y en la posición que ocupan con respecto al lexema, se

pueden determinar aspectos como el tiempo, el género, el número, el grado etc. Por otro

lado, el procesamiento morfológico clasifica las unidades lingüísticas en las distintas

categorías gramaticales: sustantivo, verbo, adjetivo, adverbio, etc.

• Procesamiento sintáctico: La sintaxis estudia las relaciones que se establecen entre

las palabras dentro de la oración y las reglas que rigen estas relaciones. Para el

procesamiento sintáctico es necesario contar con los patrones sintácticos más frecuentes en

una lengua determinada.

Se suele recurrir a un corpus anotado sintácticamente en donde los patrones han sido

representados en forma de arborescencia.

• Procesamiento semántico: La semántica es el estudio del significado del lenguaje,

por lo que con el procesamiento semántico se intenta establecer la relación que existe entre

las formas lingüísticas analizadas y el sentido con el que están utilizadas en una secuencia

textual determinada.

• Procesamiento pragmático: La pragmática estudia las estrategias comunicativas

enmarcándolas en un contexto socio-cultural. Uno de los principales problemas con los que

se enfrenta el procesamiento pragmático es la anáfora.

2.4

Extracción de información

El considerable desarrollo de la comunicación multimedia va de la mano con un

aumento exponencial del volumen de la información textual.

Juan Diego Gómez Fierros

14 | P á g i n a

Capítulo 2.- Fundamento teórico

Hoy en día, las tecnologías de recuperación de información (RI) no son capaces de

satisfacer las necesidades de información específica, ya que proporcionan información a

nivel de colección de documentos. El desarrollo de herramientas inteligentes y métodos,

que dan acceso al contenido del documento y extraer la información pertinente, es más que

nunca una cuestión clave para el conocimiento y la gestión de la información. La

Extracción de información es una de las principales líneas de investigación que tratan de

satisfacer esta necesidad.

El campo de la Extracción de información se inició por el DARPA’s MUC program

(Grishman & Sundheim, 1996). MUC definió originalmente la extracción de información y

la tarea de extracción de los tipos específicos y bien definidos de información del texto en

los conjuntos homogéneos de documentos con dominios restringidos y espacios

predefinidos a rellenar o plantillas de formularios con la información extraída.

MUC también ha dado lugar a una nueva evaluación del paradigma: comparar la

información extraída de forma automática con los resultados producidos por el hombre.

MUC ha inspirado una gran cantidad de trabajos en Extracción de información y se ha

convertido en una referencia importante en el campo de la minería de textos. Incluso, sigue

siendo una tarea difícil construir un sistema eficiente de Extracción de información con

buenos rangos de memoria (cobertura) y de precisión (exactitud) (Aone & Ramos, 2000) y

(Aussenac, Biébow, & Szulman, 2000).

Una típica tarea de Extracción de información se ilustra en la Figura 3 de un corpus de

un anuncio para un seminario CMU “Freire 1998”. EI proceso reconoce un nombre (John

Skvoretz) y lo clasifica como un nombre de persona.

También se reconoce un evento de seminario y se crea un formulario de eventos

seminario (John Skvoretz es el ponente de seminarios cuya presentación se titula

"Compromiso Embebido" (“Embedded commitment”). Incluso en un ejemplo tan sencillo,

no debe considerarse como un simple método de filtrado de palabras claves. Llenar un

formulario con palabras extraídas y fragmentos de texto implica un proceso de

interpretación.

Cualquier fragmento debe interpretarse con respecto a su "contexto" (es decir, el

conocimiento del dominio o de otras piezas de información extraída del mismo documento)

y de acuerdo a su "tipo" (es decir, la información es el valor de un atributo / función / rol

representado por un valor del formulario). En el documento de la Figura 4, "4-5:30" se

entiende como un intervalo de tiempo y es necesario interpretar el "4" como "4 pm" y como

el tiempo de inicio del seminario.

Juan Diego Gómez Fierros

15 | P á g i n a

Capítulo 2.- Fundamento teórico

Formulario para rellenar (parcial)

lugar: ?

hora de inicio:?

título: ?

ponente: ?

Documento: El profesor John Skvoretz, U. de Carolina del Sur, Columbia, presentará un seminario

titulado "Compromiso embebido", el jueves, 4 de mayo de 4-5:30 en el PH 223D.

Llenado de formulario (parcial)

lugar: PH 223D

hora de inicio: 4 pm

Título: compromiso embebido

ponente:

El profesor

John

[...]un seminario “Ontologies and Information Extraction”

Figura

4. Ejemplo

deSkvoretz

anuncio de

En un típico sistema de Extracción de información, se pueden identificar tres pasos del

proceso (Hobbs, y otros, 1997) y (Cowie & Wilks, 2000):

Pre-procesamiento de texto, cuyo nivel varía de segmentación del texto sólo en

frases y oraciones mediante tokens, a un análisis lingüístico completo.

Selección de reglas: las reglas de extracción están asociadas con disparadores

(por ejemplo palabras clave), el texto se analiza para identificar los puntos de

disparo y las normas correspondientes se seleccionan.

Aplicación de las reglas, se comprueban las condiciones de la regla

seleccionada y se rellenan los formularios de acuerdo a las conclusiones de las

normas de coincidencia de datos.

Extraer información de los textos requiere conocimientos léxicos, gramáticas que

describen la sintaxis específica de los textos a analizar, así como conocimientos semánticos

y ontológicos. En este punto, no se tomará parte en el debate sobre el límite entre el léxico

y la ontología como un modelo conceptual.

Más bien se centra en el papel que las ontologías juegan para considerarse como bases

de conocimiento semántico en la Extracción de información y el uso de ontologías para la

Extracción de información, las cuales están enriquecidas por el conocimiento conceptual,

esto se refiere a su elaboración lingüísticas (por ejemplo, un concepto debe estar asociado a

los términos que lo expresan con su valor de tiempo en varios idiomas) (Nédellec &

Nazarenko, 2005).

Juan Diego Gómez Fierros

16 | P á g i n a

Capítulo 2.- Fundamento teórico

2.5

Patrones lingüísticos

Al expresarnos utilizamos una serie de estructuras lingüísticas con las que organizamos

nuestro discurso y que ayudan al receptor a asimilar la información conceptual que

emitimos. Por lo tanto, si encontramos estas estructuras, que llamaremos patrones, y las

introducimos en un programa de extracción de información como WordSmith (Scott, 2011),

nos aportarán la información requerida.

El uso de patrones lingüísticos para la extracción de relaciones conceptuales es bastante

reciente en terminología por lo que todavía no posee una denominación establecida. Por

eso, cabe destacar las diferentes maneras con las que los diversos autores han designado lo

que nosotros llamamos en este trabajo patrones lingüísticos, como por ejemplo la

denominación patterns que utiliza el grupo cogniterm dirigido por (Meyer, 2001).

El siguiente listado de términos ha sido tomado de (Marshman, Morgan, & Meyer,

2002): formulae (Lyons, 1977), diagnostic frames o test frames (Cruse, 1986), frames

(Winston et al, 1987), knowledge probes (Ahmad & Fulford, 1992), definitional

metalanguage y defining expositives (Pearson, 1998). En español, se destaca a (Bach, 2005)

que utiliza la denominación de marcadores de reformulación (MR) y (Faber, Rodríguez, &

Sánchez, 2001) que utiliza el término patrones. A pesar de las diferentes denominaciones,

todos los autores se refieren al mismo concepto que (Condamines, 2002) llama marqueurs

en francés o patterns en inglés y la define como:

Una estructura discursiva utiliza como un indicador de la posible transición del discurso

a un modelo, lo que permite la construcción semi-directa de un modelo en forma de una

relación semántica dependiendo de su relación con el contexto.

De una manera más sencilla, (Marshman, Morgan, & Meyer, 2002) los definen como

“Palabras, combinaciones de palabras o elementos paralingüísticos de los textos que a

menudo indican relaciones conceptuales”. A partir de esta definición, estas autoras señalan

en ese mismo artículo que existen tres tipos de patrones lingüísticos para la detección de

contextos ricos en conocimientos:

1) Patrones léxicos. Son los más visibles y consisten en palabras o grupos de palabras

que indican las relaciones conceptuales.

2) Patrones gramaticales. Implican combinaciones de estructuras gramaticales que

ofrecen relaciones semánticas entre conceptos aunque de un modo más limitado que los

patrones léxicos.

3) Patrones paralingüísticos. Se trata de los elementos textuales como por ejemplo

comas, paréntesis, puntos, etc. Así como marcas tipográficas.

Juan Diego Gómez Fierros

17 | P á g i n a

Capítulo 2.- Fundamento teórico

En resumen, gracias a estos patrones de conocimiento, el terminólogo es capaz de

detectar, de una manera rápida y eficaz, las relaciones semánticas y las estructuras

lingüísticas que ayudaron en este trabajo de tesis.

2.6

Espacialidad y eventos

2.6.1 Espacialidad

A lo largo de la historia del pensamiento humano, hubo numerosos intentos de describir

el concepto de espacio. Se enmarcaban en diversas ramas de las ciencias empezando por

filosofía, lógica, física, matemática, astronomía, geometría, etc. Posteriormente este interés

se extendió a otras materias científicas como: psicología, antropología, arte o literatura.

Empezando por la filosofía que, al parecer, fue una de las primeras ramas científicas que

abordó el tema desde el punto de vista científico, ya con Aristóteles (384-322 a.C.)

encontramos las primeras menciones sobre el espacio definido junto con el tiempo como un

conjunto interdefinible. Este gran filósofo sostenía que no se puede medir el tiempo sin el

movimiento, ni el movimiento sin el espacio (Barbosa, 1807) y (Ferrater M, 1974). La

imagen del espacio y movimiento que planteó Aristóteles tuvo su continuación en la física

del siglo XIV. Posteriormente, con la crítica de sus teorías, se propusieron también otras

ideas de filósofos griegos (Pitágoras, Arquímedes, etc.) que dieron lugar a unas nuevas

metodologías científicas que fueron mucho más prácticas y aplicables: Copérnico (1473 –

1642), Galileo (1564 – 1642), Kepler (1575 – 1630), etc.

Dentro de las tendencias actuales podemos observar que se presta cada vez más

atención al fenómeno relacionado con varias categorías espaciales que constituyen las bases

para la descripción de la realidad que nos rodea. Sin embargo, estos conceptos no son nada

nuevos. Ya hace bastante tiempo, Genette reflexionaba sobre la espacialidad de la lengua,

de las ideas o del arte, llegando a la conclusión que la gente “prefiere” conceptualizar más

el espacio que el tiempo. La fascinación por la noción del espacio, llevó a muchos

lingüistas a explicar conceptos gramaticales básicos (tales como p. ej. los casos) como

consecuencia de la visión del mundo a través del aspecto espacial.

La geometría y la lógica son impotentes para describir a fondo los locativos espaciales.

Aunque un día se pueda demostrar la existencia de algún tipo de inteligencia específica del

lenguaje, será irrefutable que la inteligencia general juega un papel importante en la

elaboración de los mecanismos del lenguaje. De ahí el paralelo establecido entre la manera

en que concebimos y percibimos el espacio y la manera en que lo describimos

lingüísticamente. (Vandeloise, 1986: 23-30) hace un intento de describir los locativos en

relación con los conceptos funcionales ligados al conocimiento extralingüístico del espacio

que comparten los hablantes de una misma lengua.

Juan Diego Gómez Fierros

18 | P á g i n a

Capítulo 2.- Fundamento teórico

2.6.1.1

Espacialidad en textos

El rasgo principal de la estructura semántica de la localización espacial constituye el

mecanismo lingüístico usado para indicar el lugar que no puede venir identificado por sí

mismo, sino que tiene que ser siempre identificado en relación a un objeto. Ocurre que para

localizar en el espacio necesitamos un objeto localizante, un objeto localizado y un

elemento relacionante. Ese elemento relacionante (locativo espacial), ha acogido

tradicionalmente a categorías tan diversas como adverbios, preposiciones, locuciones

prepositivas y prefijos, recibiendo últimamente un nuevo tratamiento gracias a la aplicación

de una perspectiva deíctica y/o intrínseca. El mecanismo de la localización supone que el

objeto y el lugar donde está son conocidos. Los locativos también pueden ser usados para

identificar el objeto en relación con el cual viene después identificado un lugar. El

significado de un locativo es la relación específica entre el lugar y el objeto. Esta relación

sólo puede ser descrita tomando en consideración la estructura semántica del objeto.

Este tipo de taxonomía relacional ha sido defendida por varios lingüistas: Hjemslev

(1935), Tesnière (1959), Fillmore (1968), Dowty (1979), Karolak (2001), etc. De acuerdo

con los supuestos presentados por estos lingüistas, el lenguaje está concebido a través de

los papeles relacionantes, es decir, casos semánticos que desempeñan sus funciones dentro

de la estructura sintagmática en la identificación del valor de los actantes del predicado.

Entre los casos enumerados por FILLMORE, figura también uno que corresponde a la

descripción de relaciones espaciales (locativo). La semántica espacial ha sido abordada

posteriormente por muchos semanticistas y causó varias polémicas, puesto que la

determinación de un conjunto homogéneo de los papeles temáticos siempre llevaba a la

elaboración de teorías difícilmente conciliables. Además, el intento de selección de los

criterios uniformes lleva a la conclusión de que existe un número limitado de los papeles

temáticos y que las funciones semánticas son universales puesto que su valor está definido

en función de acciones, eventos psicológicos, acontecimientos sometidos a algún tipo de

modificación o movimiento, así como de situaciones que se localizan en un determinado

espacio o tiempo.

2.6.2 Eventos

Los documentos de noticias contienen información valiosa representada en lenguaje

natural, tal como eventos, sucesos y hechos, así como información contextual del evento

(información temporal, espacial y causal) que describe las características y comportamiento

de la acción en el mundo real.

Juan Diego Gómez Fierros

19 | P á g i n a

Capítulo 2.- Fundamento teórico

En el trabajo de (Reyes, 2011) se realiza una caracterización de los eventos que

describen las noticias escritas con el objetivo de capturar la semántica de las oraciones de

los textos periodísticos.

2.6.2.1

Características de los eventos

Un evento puede estar descrito por un predicado (verbo) de una oración o por una

nominalización, como se puede ver en el siguiente ejemplo.

Los bomberos encontraron a una señora en la provincia de Fukushima.

(Verbo)

La erupción de volcán en Hawái.

(Nominalización)

Los eventos se clasificarán en dos tipos, eventos expresados por verbos y eventos

expresados por nominalización, los cuales se caracterizan de manera independiente.

Eventos expresados por verbos

Estos eventos se expresan por los verbos principales, conjugados en algún tiempo

(pasado, presente y futuro), en una oración. Existen teorías de lingüistas como L. Tesnière y

M.A.K. Halliday que se exponen en (Frías, 2001), y donde se afirma que el verbo es el

núcleo sobre el que giran todos los elementos de la oración, tomando en cuenta este

supuesto, los verbos se convierten en el núcleo de los eventos y con esto surge la necesidad

de utilizar un mecanismo que considere las valencias de los verbos para encontrar sus

argumentos.

La caracterización de este tipo de eventos se centrará en la gramática de valencias de

Tesnière que se expone en (Frías, 2001) y que se define como una teoría en donde el verbo

es el elemento fundamental en una oración y que sirve de columna vertebral al resto de

ésta.

Los principios de la teoría de las valencias, son:

a) Principio actancial. El elemento más importante de una oración es la acción

(verbo) que es considerado el centro de la oración y es el que dirige a los

actores (actantes). Según este principio, los verbos se distinguen según el tipo y

número de valencias que necesitan. Por tanto, los actantes del verbo (sus

valencias necesarias) varían entre verbos según su significado.

Juan Diego Gómez Fierros

20 | P á g i n a

Capítulo 2.- Fundamento teórico

b) Valores actanciales de los verbos. Los verbos en español tiene asignado un

número de valencia. Por lo tanto tenemos: verbos avalentes (sin actantes),

como llover, nevar, tronar (verbos de tiempo atmosférico), ser (en expresiones

como ser tarde, ser necesario, ser lícito, etc.), haber (con valor impersonal);

verbos monovalentes (requieren un actante), como ir, venir, llegar, salir;

verbos bivalentes que requieren necesariamente dos actantes, es decir, si

eliminamos el segundo, el verbo se queda mutilado en cuanto a su significado,

como romper, comer ; verbos trivalentes que requieren tres actantes, como

poner, dar.

c) Elementos de los actantes. Los actantes que participan en una oración pueden

clasificarse según L. Tasnière, en: a) actor: se identifica con el elemento del

que arranca el proceso; responde al rasgo [+animado][+/-humano]. Suele

corresponderse con el sujeto; b) agente: responde al mismo fenómeno que el

actor, pero con el sema [-animado]; c) objeto: se identifica con el elemento que

complementa el significado del proceso y su sema principal es [-animado]; d)

paciente: se identifica en todo con el objeto, con la diferencia de que responde

al sema [+animado]; e) beneficiario: se identifica con aquel que recibe los

beneficios o perjuicios de la acción, tiene el sema [+animado].

Eventos expresados por nominalización

Los eventos por nominalización se encuentran expresados por un verbo nominalizado

también conocido como sustantivación.

La nominalización, consistente en la creación de derivados nominales por sufijación,

puede ser denominal, deadjetival y deverbal. Este trabajo tiene un especial interés en la

nominalización deverbal, la cual se forma con un verbo más un sufijo. Este interés se debe

a la posibilidad de que un evento se encuentre expresado por una nominalización que a su

vez proviene de un verbo.

Según (Hernando, 1998) define la formación de la nominalización deverbal y la

nominalización deverbal regresiva, como:

La nominalización deverbal (N -»V + Afn) la efectúan los sufijos -ada (helada), -ado

(lavado), -aje (viraje), -(a, e)ncia (vagancia, asistencia), -(a, ie)nte (delineante,

escribiente), -anza (cobranza), -(a, i)ción (recaudación, fundición), -(ad, id)era (regadera,

escupidera), -(ed)eras (entendederas), -(ad, ed, id, and)ero (embarcadero, tendedero,

hervidero, curandero), -(ad, ed, id)or (encuadernador, recogedor, surtidor), -(ad)ora

(lavadora), -(ad, ed, id)ura (atadura, torcedura, añadidura), -(at)oria (eliminatoria), -ida

(salida), -ido (ladrido), -(a, i)m(i)ento (juramento, acercamiento, atrevimiento), -imenta

(impedimenta), -ón (tirón), -sión (comprensión), -ura (rotura).

Juan Diego Gómez Fierros

21 | P á g i n a

Capítulo 3. Estado del arte

En este capítulo se presentan diversos trabajos relacionados con el aprendizaje ontológico,

la recuperación y la extracción de información, los patrones lingüísticos y finalmente se

muestran las diferentes herramientas existentes actualmente para la identificación de

entidades espaciales en textos.

Capítulo 3.- Estado del arte

3.1

Introducción

Para los usuarios de la web en todo el mundo la recuperación de información se ha

convertido en una actividad cotidiana. Sin embargo, los usuarios no siempre reciben la

información esperada al momento de realizar una búsqueda en la Web. Una razón de esto

es que los recursos web existentes son pocas veces complementados con la anotación

semántica que describen su contenido, lo que haría más fácil el acceso a los servicios de

búsqueda automatizada (Gaihua, Jones C, & Abdelmoty, 2005).

La Extracción de Información (en inglés Information Extraction) es el campo del

Procesamiento del Lenguaje Natural cuyo objetivo es extraer de forma automática de

conocimiento estructurado, habitualmente dependiente del contexto, a partir de información

existente en texto no estructurado en lenguaje natural, con el fin de mejorar su explotación

y reutilización. Normalmente, como primer paso del proceso de extracción está el

reconocimiento de entidades con nombre (en inglés Named Entity Recognition, NER),

también conocido como identificación de entidades o extracción de entidades, que consiste,

como su propio nombre indica, en la detección y clasificación de los elementos del texto en

categorías predefinidas, como nombres de personas, organizaciones, lugares, expresiones

numéricas, de tiempo, etc., que aparecen mencionadas en un texto escrito en un

determinado idioma. Esta actividad también se suele denominar: etiquetado semántico.

La dificultad de la detección estriba en que dichas entidades pueden aparecer en

diferentes formas: por ejemplo, "Antonio Banderas" => "Banderas", "A. Banderas", "José

Antonio Domínguez Banderas", etc.; "Banco Santander Central Hispano" => "Banco

Santander", "Santander", "Grupo Santander", etc.

Además, una vez detectadas, surge el problema de la ambigüedad para su clasificación,

ya sea entre diferentes categorías o dentro de una misma categoría: por ejemplo, "Sevilla"

puede ser la ciudad, el equipo de fútbol, etc.

La aproximación ampliamente adoptada está basada en conocimiento, es decir, utiliza

diccionarios y conjuntos de reglas, normalmente desarrollados de forma manual, para

realizar la detección y la clasificación. Básicamente, las reglas aplican patrones de

expresiones regulares a las entidades del diccionario para generar las diferentes variantes

posibles en que puede aparecer una entidad, como por ejemplo:

(N)ombre (A)pellido => Nombre / Apellido / N. Apellido / Nombre A. / N. A.

Fernando Alonso => Fernando / Alonso / F. Alonso / Fernando A. / F. A.

(A)aaa (de|del|la|los|las)? (B)bbb (de|del|la|los|las)? (C)cc (de|del|la|los|las)? (D)ddd

=> ABCD

Organización de Países Exportadores de Petróleo => OPEP

Juan Diego Gómez Fierros

23 | P á g i n a

Capítulo 3.- Estado del arte

Existen varias propuestas para automatizar el proceso de construcción de ontologías, las

cuales tienen algunas características en común diferenciándose entre ellas por factores

distintivos muy precisos. Esta sección presenta el estado del arte sobre métodos, técnicas,

sistemas y herramientas que han sido desarrolladas en el área de aprendizaje de ontologías,

de las cuales se analizan sus características.

3.2

Enfoques para aprendizaje ontológico

Los enfoques de aprendizaje ontológico se pueden clasificar de acuerdo a los tipos de

datos utilizados para el aprendizaje (Gomez & Manzano, 2003) y (Shamsfard &

Barforoush, 2003). Estos tipos de datos son: no estructurados, semi-estructurados y

estructurados. Los datos no estructurados son los textos en lenguaje natural, como libros,

revistas, etc.

Datos Semi-estructurados son textos como HTML, archivos XML. Mientras que los

datos estructurados son las bases de datos y diccionarios. Nos vamos a concentrar en el

aprendizaje ontológico en datos de tipos no estructurado y semi-estructurado.

Los datos no estructurados son el tipo de datos más difícil para el aprendizaje

ontológico. Se necesita más capacidad de procesamiento que en los datos semiestructurados.

Los sistemas que se han propuesto para el aprendizaje a partir de texto no estructurado,

a menudo dependen de procesadores de lenguaje natural.

Algunos sistemas utilizan el procesamiento de textos poco profundos, con el análisis

estadístico, como (Sánchez & Moreno, 2004) y otros utilizan un analizador basado en

reglas, para identificar relaciones de dependencia entre las palabras, en lenguaje natural

(Sabou, Wroe, Goble, & Mishne, 2005).

El trabajo de (Cimiano, Hotho, & Staab, 2005) hace uso del etiquetador (part of speech

tagger) del TreeTagger (Schmid, 1994) y del analizador LoPar2 (Schmid, 2000). En

(Cimiano & Vaolker, 2005) se extraen ontologías a partir de texto en lenguaje natural

utilizando un enfoque estadístico, el enfoque de patrones y un enfoque de aprendizaje

automático mediante procesamiento lingüístico básico proporcionado por Text2onto.

El PLN (Procesamiento de Lenguaje Natural) es común en todas las técnicas, por lo

tanto, se clasificarán los diferentes enfoques en base a la técnica utilizada, además del PLN.

Juan Diego Gómez Fierros

24 | P á g i n a

Capítulo 3.- Estado del arte

Primero se describen los sistemas que integran PNL, con el enfoque estadístico, los

cuales, utilizan el recuento de la frecuencia de los sintagmas nominales y el nombre en los

documentos recuperados de la web para descubrir los conceptos y las relaciones

taxonómicas, mientras que por otra parte, utilizando el analizador superficial extraen frases

nominales.

La segunda sección describe los sistemas “puros” de PLN, que utiliza la gramática de

dependencias y programas de análisis para descubrir la relación entre las entidades

sintácticas. La tercera sección describe enfoques que incluye métodos de distintas

disciplinas: recuperación de información, base de datos léxica (WordNet), aprendizaje

máquina, además de la lingüística computacional.

3.2.1 Enfoque estadístico

Sánchez y Moreno (Sánchez & Moreno, 2004) comienzan la construcción de la

ontología usando palabras clave que están cerca a los conceptos de la ontología y

estrechamente relacionados. Envían la palabra clave a los motores de búsqueda para

recuperar las páginas relacionadas, a continuación, se realiza el análisis de estos sitios web

para encontrar los conceptos candidato para un dominio. Esta palabra clave se utiliza para

el aprendizaje de conceptos de las páginas devueltas por la recuperación de los bigramas

que contienen la palabra clave en el segundo término.