[ [ ] n ]

Anuncio

![[ [ ] n ]](http://s2.studylib.es/store/data/008260652_1-3459188c6c9e3d1f9148c20b932b0c45-768x994.png)

1

ESTADÍSTICA II

SOLUCIÓN-PRÁCTICA 8: MUESTREO

EJERCICIO 1

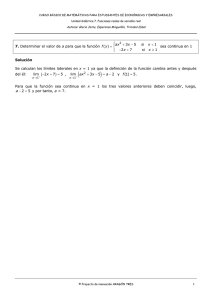

Demostraremos estos resultados por medio de la Función generatriz de momentos y algunos

de los resultados ya obtenidos en la Práctica 4.

1) Sea, entonces, Y = X1 + X2 + … + Xn, tal que X ∼ Bernoulli (p). Entonces:

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) … MX n ( t ) = ( igual distribución ) = [ MY(t) ]n =

[(1 − p) + e p] , que es la f.g.m. de una binomial con parámetros n y p.

t

n

Por lo tanto:

Y ∼ Bin (n, p)

La distribución de Xn es la que, simplemente, toma los mismos valores que Y, pero divididos

entre n, pues Xn =

Y

. En este caso se dice que:

n

n Xn ∼ Bin (n, p)

o también que Xn tiene distribución exacta “cuasi-binomial”. Xn no tiene distribución

“binomial”, a pesar que las probabilidades se calculan mediante la cuantía binomial, porque su

recorrido no es {0, 1, …, n} sino {0, 1/n, 2/n, …, n/n=1}.

2) Demostraremos esta propiedad en un caso más general en el que tengamos m variables

aleatorias independientes, con Xi ∼ Bin (ni, p). Entonces, siendo Y = X1 + X2 + ... + Xm tenemos

que:

[(1 − p) + e p]

t

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) ... M Xm (t ) =

[(1 − p) + e p]

[

]

n1

[(1 − p) + e p]

t

n2

...

( n1 + n2 +...+ nm )

= (1 − p ) + e p

, que es la f.g.m. de una binomial con parámetros

(n1 + n2 + ... + nm) y p.

Por lo tanto, para el caso particular n1 = n2 = ... = nn = n, Y ∼ Bin (n.m, p).

Como en el caso anterior, se dice que:

t

nn

t

m X m ∼ Bin (n.m, p)

3) Sean, n variables aleatorias Xi ∼ Geo (p). Entonces:

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) ... MX n ( t ) =

pn

[ 1 − e t ( 1 − p) ] n

p

p

1 − e ( 1 − p) 1 − e ( 1 − p)

t

t

...

p

1 − e ( 1 − p)

t

=

, que es la f.g.m. de una Binomial Negativa (n, p).

También se dice que:

n Xn ∼ Bin Neg (n, p)

4) Sea Y = X1 + X2 + ... + Xn. Probaremos aquí, también, un caso más general donde cada

Xi ∼ Poisson (λi). La función generatriz de momentos de Y es:

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) ... MXn ( t ) = e λ1( e

e( λ1 + λ 2 +...+ λ n ) ( e

t −1)

t −1)

eλ 2 (e

t −1)

... e λ n ( e

t −1)

=

, que es la f.g.m de una Poisson ( λ1 + λ 2 +...+ λ n )

Si λ1 = λ 2 ... = λ n = λ, entonces Y ∼ Poisson (n λ), n Xn ∼ Poisson (n λ) y se dice que: Xn

∼ Cuasi-Poisson (n λ).

2

5) Supongamos que tenemos n variables aleatorias independientes, con Xi ∼ Exp (λ =

1

)y

θ

sea nuevamente Y = X1 + X2 + ... + Xn. Por lo tanto:

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) ... MX n ( t ) =

⎛ 1 ⎞n

1

1

1

⎟⎟ , la cual

...

= ⎜⎜

1− θ t 1− θ t 1− θ t

⎝1− θt ⎠

es la f.g.m de una Gamma ( n, θ).

Por Ejercicio 3 de la Práctica 4, sabíamos que: MaX(t) = MX(at) y entonces:

⎛

⎞n ⎛

⎞n

1

1

⎟⎟ = ⎜⎜

⎟⎟ , que es la f.g.m. de una Gamma (n, θ/n).

M X ( t ) = MX(t/n) = ⎜⎜

n

⎝1− θt / n ⎠

⎝ 1 − ( θ / n) t ⎠

Con lo que:

Xn ∼ Gamma (n, θ/n)

6) Esta parte es similar a la anterior, dado que Exp (θ) = Gamma (1, θ). Planteemos un caso

también más general donde cada Xi ∼ Gamma (ai, θ) (insistamos nuevamente que la notación

para el segundo parámetro es arbitraria, por lo que queda a elección del lector, siempre que

1

λ = ). Por lo tanto:

θ

⎛ 1 ⎞

⎟⎟

MY(t) = (independencia) = M X1 ( t ) MX 2 ( t ) ... MX n ( t ) = ⎜⎜

⎝1− θt ⎠

⎛ 1 ⎞

⎜⎜

⎟⎟

⎝1− θt ⎠

a1

⎛ 1 ⎞

⎜⎜

⎟⎟

⎝1− θt ⎠

a2

⎛ 1 ⎞

⎟⎟

... ⎜⎜

⎝1− θ t ⎠

an

=

a1 + a 2 + ... + a n

, la cual es la f.g.m de una Gamma (a1 + a2 + ... + an , θ).

Para el caso a1 = a2 = ... = an = a, Y ∼ Gamma ( n a, θ).

Con idéntico razonamiento que en 5) resulta, para este último caso, que:

Xn ∼ Gamma (n a, θ/n)

7) Consideramos, generalizando, el caso en que Xi ∼ N (μi, σi2 ). Entonces:

MY(t) = (independencia) =

1

( μ 1 + μ 2 + ... + μ n ) t + ( σ 12 + σ 22 + ... + σ n2 ) t 2

2

e

M X1 ( t ) MX 2 ( t ) ... MX n ( t )

=

1

μ 1t + σ 12 t 2

2

e

1

μ 2 t + σ 22 t 2

2

e

1

μ n t + σ n2 t 2

2

... e

=

, que es la f.g.m. de una N (μ1 + μ2 + ... + μn, σ12 + σ 22 +...+ σn2 ).

Si μ1 = μ2 = ... = μn = μ y σ12 = σ 22 =...= σn2 = σ2, entonces Y ∼ N (n μ, n σ2).

Finalmente, la distribución de Xn es N (μ,

σ2

), la cual se deduce calculando la f.g.m. de igual

n

forma que arriba.

8) La respuesta a esta parte, es el llamado Teorema del Límite Central que dice que dadas X1,

X2, ... , Xn variables aleatorias independientes e idénticamente distribuidas (su distribución

puede ser cualquiera y denotamos esto como que se distribuyen igual a X), con E (X) =

μ < +∞ y V (X) = σ2 < + ∞, entonces:

Xn − μ

σ

d

⎯⎯→

N (0, 1)

n

Esta tesis indica que, el promedio de n variables aleatorias, estandarizado, tiende en

distribución a una normal estándar y esto sucede, valga la redundancia, cualquiera sea su

3

distribución (este hecho es lo sorprendente !!! ). Dicho de otro modo, a medida que n crece, las

probabilidades del promedio estandarizado de una MAS c/r de cualquier variable aleatoria, se

aproximan a las de una normal estandarizada.

Este resultado también se puede escribir de la siguiente forma:

Xn

d

⎯⎯→

N (μ,

σ2

)

n

Entonces, es fácil observar que:

Y = n Xn

d

⎯⎯→

N (n μ, n σ2)

EJERCICIO 2 (Múltiple opción seleccionado de los exámenes de marzo y

setiembre y de la segunda revisión del 2001)

En las dos primeras partes de este ejercicio se supone, que en ambos casos, tomamos una

M.A.S. con reposición.

σ2

1) La verdadera es la a). Como V ( Xn ) =

, la dispersión de Xn depende de σ2 y de n:

n

cuanto mayor sea la dispersión de X -V (X) = σ2-, mayor es la de Xn y cuanto mayor sea el

tamaño de la muestra, menor es la dispersión de Xn .

2) Sean Yi = Xi – p, para i = 1, 2, ..., n. Entonces, también las Yi, son independientes e

idénticamente distribuidas con:

E (Yi) = E (Xi – p) = E (Xi ) – p = p – p = 0

V (Yi) = V (Xi – p) = V (Xi) = p (1 – p)

Si aplicamos ahora el Teorema del Límite Central a la sucesión

Yn

d

N ( 0,

⎯⎯→

{ Yi }i =1, 2, ..., n :

p (1 − p)

)

n

Esto indica que la distribución de Yn = Xn – p, a medida que n crece, se aproxima a la de una

N ( 0,

p (1 − p)

) y por lo tanto c) es la verdadera.

n

3) Como en la parte anterior, aplicando el Teorema del Límite Central ahora a la sucesión

{ Xi }i =1, 2, ..., n :

Xn =

1

n

n

∑

Xi

d

⎯⎯→

N (μ,

i =1

V ( X)

σ2

) = N ( E (X),

)

n

n

Tomando n = 50, la distribución de X50 es aproximadamente igual a la de una N ( E (X),

Entonces, la respuesta correcta es la c).

4) Por el ejercicio anterior, parte 5, vimos que si cada Xi ∼ Exp (θ), entonces:

Xn ∼ Gamma (n , θ/n)

Por lo tanto, para n = 10, X10 ∼ Gamma (10 , θ/10) y es correcta la opción b).

V ( X)

)

50

4

EJERCICIO 3

1) MT(t) = (indep.) = MaX(t) MbY(t) = MX(at) MY(bt) = e

1

(a μ X + b μ Y ) t + (a 2σ2 + b2σ2 ) t 2

X

Y

2

e

μX a t +

1 2 2 2

σ a t

2 X

e

μY b t +

1 2 2 2

σy b t

2

=

, la cual corresponde a la f.g.m. de una N (a μX + b μY, a2 σ 2X +

b2 σ 2Y ).

2) Entonces: T = 2 X + 3 Y ∼ N ( 16, 1696) y por ello P(T > 18) = 1 – P(

T − 16

1696

≤

18 − 16

)=

1696

1 – φ (0,04856) = 0,4806.

EJERCICIO 4

Peso de cada naranja de la caja: Xi ∼ N(295, 225).

24

∑X

Peso del contenido neto de una caja:

i =1

i

. Peso esperado del contenido neto de una caja:

24

E(

∑X

i =1

i

) = 295 x 24 = 7.080 gramos. Amplitud del intervalo: 10% de 7.080 gramos.

Intervalo normalizado: (7.080 – 708, 7.080 + 708) = (6.372, 7.788).

EJERCICIO 5

Si X ∼ Gamma (α = n/2, λ = 1/2) = Gamma (α = n/2, θ = 2) , entonces por Ejercicio 4 de la

Práctica 1, su f.g.m. es:

⎛ 1 ⎞ n/2

⎟⎟

MX(t) = ⎜⎜

⎝1− 2t ⎠

Por lo tanto:

M’X(t) =

M’’X(t) =

n

2

⎛ 1 ⎞

⎟⎟

⎜⎜

⎝1− 2t ⎠

(n / 2 −1 )

⎛ 1 ⎞

⎜⎜

⎟⎟

⎝1− 2t ⎠

n

2

8

(1 − 2 t )

3

+

(n / 2 −1 )

n n

( – 1)

2 2

2

(1 − 2 t )2

⎛ 1 ⎞

⎟⎟

⎜⎜

⎝1− 2t ⎠

(n / 2 − 2 )

2

(1 − 2 t )

2

2

(1 − 2 t )2

Entonces:

E(X) = M’X(0) = n

Y además:

E(X2) = M’’X(0) = 4 n + n (n – 2) = n2 + 2 n

V(X) = 2 n

Es decir que una X ∼ Gamma (α = n/2, θ = 2), se llama “chi-cuadrado con n grados de

libertad” (notación: X ∼ χ2 (n) ), tiene como esperanza sus grados de libertad y como varianza

el doble de ésta. Algunas probabilidades de esta distribución, para diferentes valores de n,

están tabuladas al final de la GUÍA.

5

EJERCICIO 6

Para hallar la distribución de la variable Y = X2 vamos a deducir su f.g.m.

t Y

MY(t) = E (e

+∞

∫

−

e

1 ⎛⎜

x

2 ⎜ 1 / 1− 2 t

⎝

) = E (e

⎞

⎟

⎟

⎠

t X2

+∞

1

)=

∫

2π

e

t x2

−∞

1− 2t

1

1− 2t

2π

+∞

∫

−

e

dx =

1 ⎛⎜

x

2 ⎜ 1 / 1− 2 t

⎝

⎞

⎟

⎟

⎠

+∞

1

2π

1− 2t

∫

−

e

1 2

x (1− 2 t )

2

−∞

dx =

1

2π

2

1

dx =

1− 2t

−∞

Para este última igualdad se observó que

⎛

1

densidad de una N ( 0, ⎜

⎜ 1− 2t

⎝

e

1 2

x

2

−∞

2

dx =

−

1

2π

+∞

∫

−

e

1 ⎛⎜

x

2 ⎜ 1 / 1− 2 t

⎝

⎞

⎟

⎟

⎠

2

es la función de

−∞

2

⎞

⎟ ) integrada en todo R y por lo tanto vale 1.

⎟

⎠

Concluimos entonces que:

MY(t) =

⎛ 1 ⎞ 1/ 2

⎟⎟

= ⎜⎜

1− 2t ⎝1− 2t ⎠

1

Que corresponde a la f.g.m. de una Gamma (α = 1/2, θ = 2), o lo que es lo mismo una χ2(1).

Por lo mencionado en el ejercicio anterior, E (Y) = 1 y V (Y) = 2. Resultado interesante: el

cuadrado de una variable normal estandarizada tiene una distribución conocida: chi-cuadrado

con un grado de libertad.

EJERCICIO 7 (CONTROL 2001)

2

2

⎛ X − 2⎞

⎟ = ( X − 2 ) = Z2, con

a) Si X ∼ N (2, 9), entonces

∼ N (0, 1) . Como Y = ⎜

⎜

9

9

9 ⎟⎠

⎝

2

Z ∼ N (0, 1), por el ejercicio anterior Y ∼ χ (1).

X−2

Por lo tanto:

P ( Y ≤ 3,84) = ( me fijo en la tabla chi-cuadrado ) = 0,95

b) P ( Y ≤ 3,84) = P ( Z2 ≤ 3,84) = P ( –

3,84 ≤ Z ≤

3,84 ) = P ( – 1,96 ≤ Z ≤ 1,96 ) =

1 – 2 P ( Z ≤ – 1,96) = 1 – 2 Φ (– 1,96) = 1 – 2 x 0,025 = 0,95.

EJERCICIO 8 (EXAMEN OCTUBRE DE 1997)

1) E(X2) = V(X) + E2(X) = 9 + 0 = 9

2) Como γ 2 =

[

E (X − μ )

4

] − 3 = 0 ⇒ dado que μ = 0, E(X ) = 3 σ

4

σ

V(X2) = E [ (X2) ]2 – E2 (X2) = E(X4) – [E(X2)]2 = 243 – 81 = 162.

4

4

= 3 (σ2)2 = 3 x 81 = 243

6

2

Xi

⎛X ⎞

∼ N(0, 1) , ⎜ i ⎟ ∼ χ2(1) y dado que las

3

⎝ 3 ⎠

3) a) Como Xi ∼ N(0, 9), para 1 ≤ i ≤ 6, entonces

⎛ Xi

⎜

⎜ 3

i = 1⎝

6

variables son independientes U =

b) P(J ≤ 113,4) = P(

∑

⎞

⎟

⎟

⎠

2

∼ χ2(6).

J

113,4

≤

) = P(U ≤ 12,6) = 0,95. (Obsérvese que J = 9.U).

9

9

c) P(J > c) = 0,1 ⇔ P(

J

c

c

c

> ) = 0,1 ⇔ P(U > ) = 0,1 ⇔ P(U ≤ ) = 0,9 ⇔

9

9

9

9

c

= 10,65 ⇔ c = 95,85

9

d) Como U ∼ χ2(6) o lo que es lo mismo una Gamma ( α = 3, θ = 2), entonces:

E(U) = α θ = 6, y V(U) = α θ2 = 12.

EJERCICIO 9

a) E(X) = 750 y σX = 20 es lo que afirma la promoción. Se adquiere el lote si X 31 > 745.

En

virtud

del

tamaño

X 31 ⎯TCL

⎯→

⎯ N (750,

P( X 31

de

la

muestra

(n

>

30),

se

puede

afirmar

que

2

20

). En consecuencia:

31

⎛ 745 − 750 ⎞

⎟ = 1 - Φ(-1,39) = Φ(1,39) = 0,9177.

> 745 ) = 1 - Φ⎜

⎜ 20

⎟

31

⎝

⎠

b) X ∼N(750, 20 ). Se trata de calcular

2

2

P(S > 320). Se sabe que:

n.S 2

σ

2

≈ χ n2−1 .

Entonces:

⎛ 31.S 2 31x320 ⎞

⎟⎟ = P χ 302 > 24,8 = 1 − P χ 302 ≤ 24,8 = 1 − 0,25 = 0,75.

P⎜⎜

>

2

2

20 ⎠

⎝ 20

(

)

(

)

EJERCICIO 10 (EXAMEN DICIEMBRE DE 1994)

1) Como X ∼ N(μ, σ2) y Y ∼ N(μ + 5, σ2), entonces

por el Ejercicio 6:

⎛X−μ⎞

⎜

⎟

⎝ σ ⎠

2

y

⎛Y −μ −5⎞

⎜

⎟

σ

⎝

⎠

2

X−μ

Y−μ−5

y

∼ N(0, 1). Por lo tanto,

σ

σ

2

∼

χ2(1),

y

dado que las variables son

2

⎛ X −μ⎞ ⎛Y −μ −5⎞

2

independientes su suma ⎜

⎟ +⎜

⎟ ∼ χ (2).

σ

⎝ σ ⎠ ⎝

⎠

Culminamos el razonamiento observando que

2) P(M ≤ 640) = P(

P(J2 ≤ 2,77) = 0,75.

M

100 σ 2

≤

640

100 σ 2

2

2

⎛ X −μ⎞ ⎛Y −μ −5⎞

= ⎜

⎟ +⎜

⎟ .

2

σ

100 σ

⎝ σ ⎠ ⎝

⎠

M

) = ( llamamos J2 a una χ2(2) ) = P( J2 ≤

640

)=

100 x 2,31

7

EJERCICIO 11 (CANAVOS 7.22)

Sea X = espesor del material plástico medido en cm., con X ∼ N (μ, 0,012). Sabemos, además.

n S2

25 S 2

2

por Teorema 8.10 de la GUÍA que

(n

–

1)

o

sea

que

∼ χ2(24).

∼

χ

0,012

σ2

Entonces:

P(S2 ≥ 0,0152) = P (

25 S 2

0,012

≥

25 x 0,015 2

0,012

)=P(

25 S 2

0,012

≥ 56,25) = 0,000212

El resultado que obtuvimos es que dicho suceso tiene probabilidad prácticamente cero si la

varianza poblacional es 0,012. Por ello, se puede deducir que es muy dudosa la afirmación

hecha por el fabricante. Para que el suceso de que la varianza muestral fuera más verosímil, es

25 x 0,015 2

necesario que el cociente

sea más pequeño y por lo tanto la varianza poblacional

σ2

σ2 más grande.

EJERCICIO 12

Previamente a contestar las preguntas hallemos la distribución del estadístico J. Para ello,

observemos, en primer lugar, que cada Xi2 ∼ χ2(1) según el Ejercicio 6. Por otra parte, como

las Xi son independientes, también los son las Xi2 y entonces recordando que las

distribuciones chi-cuadrado son un caso particular de la gamma, y teniendo en cuenta,

nuevamente, el Ejercicio 1, donde en su desarrollo se demostró que la suma de gammas

independientes con iguales parámetros da una gamma, concluimos que J ∼ χ2(10).

1) P ( J > 18,3 ) = 1 – P ( J ≤ 18,3 ) = 0,05

P ( J ≤ 9,34 ) = 0,50

P ( 3,25 ≤ J ≤ 16 ) = 0,90 – 0,025 = 0,875.

n

2) Recordemos que S 2 =

∑

i =1

complicado que para J, que

( Xi − X )2

. Se puede demostrar, con un razonamiento más

n

n S2

σ2

∼ χ2 (n – 1) = χ2 (9) (esta demostración es el Teorema 8.10

mencionado en el ejercicio anterior y la pérdida en un grado de libertad se debe a que X es

dependiente de las Xi). Entonces:

P(S2 > 1,14) = 1 – P(S2 ≤ 1,14) = 1 – P(

10 S 2

≤ 1,14 x 10) = 0,25

1

EJERCICIO 13 (Examen Mar/2003)

Este ejercicio se resuelve con el mismo argumento del Teorema de la Partición de Cochran. Si

X3 = X1 – X2, entonces es X1 = X2 + X3. Se cumple: M X 1 (t ) = M X 2 + X 3 (t ) . Como X2 y X3 son

variables independientes, la función generatriz de la suma es el producto de las generatrices

marginales. Además, la función generatriz de una distribución chi-cuadrado es de la forma

−n

M X (t ) = (1 − 2.t ) 2 donde n son los grados de libertad de la distribución. Entonces:

8

M X 1 (t ) = (1 − 2.t )

−k

2

= M X 3 (t ) × (1 − 2.t )

−r

2

−k

⇒ M X3

(1 − 2.t ) 2

(t ) =

−r

(1 − 2.t ) 2

= (1 − 2.t )

−

k −r

2

. Resulta

que X3 tiene una función generatriz de la forma chi-cuadrado con parámetro (k-r). Por tanto, la

variable X3 tiene distribución chi-cuadrado con (k-r) grados de libertad.

EJERCICIO 14 (EXAMEN DICIEMBRE 1994)

Como X ∼ N ( μ1,σ12 ) y Y ∼ N ( μ 2 ,σ 22 ), entonces

2

X − μ1

Y − μ2

y

∼ N (0, 1). Por el Ejercicio

σ1

σ2

2

⎛ X − μ1 ⎞

⎛ Y − μ2 ⎞

⎜

⎟

⎜

⎟ se distribuyen ambas χ2(1). Además, como son

⎜ σ ⎟ y ⎜ σ

⎟

1

2

⎝

⎠

⎝

⎠

independientes, y con los mismos argumentos de los Ejercicios 10 y 12, deducimos que

6, se cumple que

2

2

⎛ X − μ1 ⎞

⎛ Y − μ2 ⎞

⎜

⎟

⎜

⎟ ∼ χ2(2). Si W es independiente de X e Y, W también es independiente de

⎜ σ ⎟ + ⎜ σ

⎟

1

2

⎝

⎠

⎝

⎠

2

2

⎛ X − μ1 ⎞

⎛ Y − μ2 ⎞

⎜

⎟

⎜

⎟ , y por tanto, la variable T ' =

⎜ σ ⎟ + ⎜ σ

⎟

1

2

⎝

⎝

⎠

⎠

W

2

⎛ X − μ1 ⎞

⎛ Y − μ2

⎜⎜

⎟⎟ + ⎜⎜

⎝ σ1 ⎠

⎝ σ2

2

tiene

⎞

⎟⎟

⎠

2

distribución t con 2 grados de libertad (por ser el cociente de una normal sobre la raíz cuadrada

de una chi-cuadrado sobre sus grados de libertad, ambas independientes).

Obsérvese que T’ =

2 T , por lo que concluimos que concluimos que:

T'=

W

2

=

⎛ X − μ1 ⎞

⎛ Y − μ2

⎜⎜

⎟⎟ + ⎜⎜

⎝ σ1 ⎠

⎝ σ2

2

⎞

⎟⎟

⎠

2

2 T ∼ t2

Por lo tanto:

P (T < 2,065) = P (

2T<

2 x 2,065) = P (T’ < 2,92) = 0,95

EJERCICIO 15

Recordemos el origen de la distribución T de Student. Supongamos que X1, X2, ...Xn es una

X−μ

MAS c/r con Xi ∼ N (μ, σ2). Entonces: X ∼ N (μ, σ2/n), y por lo tanto:

∼ N (0, 1). Sin

σ/ n

embargo, desde el punto de vista práctico, si desconocemos el valor de σ, esta distribución no

nos permite formular inferencias respecto a μ. Entonces surge la distribución T:

T(ν) =

Z

Y/ν

donde Z ∼ N (0, 1) y Y ∼ χ2(ν) y son independientes

9

(ν son los llamados grados de libertad de T)

Construyamos ahora un estadístico T, con las hipótesis antedichas y suponiendo μ conocida y

σ desconocida:

X−μ

1) Por la observación de arriba sea Z =

∼ N (0, 1).

σ/ n

2) También vimos que

n S2

σ

2

∼ χ2(n – 1) y por lo tanto podemos definir Y =

n S2

σ

2

∼ χ2(n – 1)

Finalmente nos queda:

X−μ

Z

T=

σ/ n

=

n S2 / σ2

n −1

Y

n −1

=

n − 1 ( X − μ)

S2

∼ tn-1

Entonces el cálculo es fácil:

P ( t11 > 2,2) = 1 – P(t11 < 2,2) = 0,025.

EJERCICIO 16

Parte A (CANAVOS 7.25)

Sea Xi = la cantidad de nicotina en mg. en el i-ésimo cigarrillo. Sabemos que Xi ∼ N (μ, σ2) y

que si tomamos una muestra de tamaño n = 16, se encuentra que el promedio es x = 0,75, y

la varianza muestral es s = 0,175.

Para hallar P( X16 ≥ 0,75), aplicaremos una distribución conocida que llamamos T de Student,

cuya tabla se encuentra en la GUÍA:

t n −1 =

n − 1 ( Xn − μ )

S2

Obtenemos:

P( X16 ≥ 0,75) = P (

15 ( X16 − 0,6)

0,175

≥

15 (0,75 − 0,6)

0,175

) = P ( t15 ≥ 3,32) = 0,002333

Es decir, que la probabilidad de que se dé el suceso, dada la afirmación del fabricante, es muy

pequeña, por lo cual la hipótesis de partida (μ = 0,6), es poco creíble. Para que el resultado

muestral fuese más probable sería necesario admitir que la verdadera media poblacional μ es

más grande.

Nota: P ( t15 ≥ 3,32) = 0,002333 se ha obtenido utilizando las funciones estadísticas de una

planilla electrónica (FUNCIONES, FUNCIONES ESTADÍSTICAS, DISTRIBUCIÓN T)

introduciendo el argumento (3,32), los grados de libertad (15) y el número de colas de la

distribución cuya probabilidad se quiere calcular (1, en este caso). En la tabla t de la GUÍA solo

están tabulados algunos valores del argumento. En este caso la mejor aproximación es P( t15 ≥

2,95) = 0,005, y lo que podemos afirmar utilizando la tabla de la GUÍA es que P ( t15 ≥ 3,32) <

0,005.

Parte B

Cuando “n es grande” (n > 30), la distribución T se puede aproximar por la distribución normal

estándar. En consecuencia:

10

P( X16 ≥ 0,75) = P (

35 ( X 36 − 0,6)

0,175

35 (0,75 − 0,6)

≥

0,175

) = P ( t35 ≥ 5,07) ≅ 1 – Φ(5,07) = 0

Se trata de un suceso prácticamente imposible. Otra vez, se concluye que la hipótesis de

partida (μ = 0,6) es poco creíble.

EJERCICIO 17 (EXAMEN)

Como U, V y Z son variables aleatorias N(0, σ2), entonces

2

2

U V

Z

,

y

∼ N(0, 1) y por el

σ σ

σ

2

⎛U⎞

⎛V⎞

⎛Z⎞

Ejercicio 6 se cumple que ⎜ ⎟ , ⎜ ⎟ y ⎜ ⎟ ∼ χ2(1). Además, como las variables son

σ

σ

⎝ ⎠

⎝ ⎠

⎝σ⎠

independientes, su suma sigue una distribución chi-cuadrado con 3 grados de libertad:

2

2

2

⎛U⎞

⎛V⎞

⎛Z⎞

= ⎜ ⎟ + ⎜ ⎟ + ⎜ ⎟ ∼ χ2(3).

2

σ

σ

σ

⎝ ⎠

⎝ ⎠

⎝σ⎠

Si llamamos L1 = cantidad de litros de “Rain Rain” que toma el participante A en una hora y L2

= cantidad de litros de “Rain Rain” que toma el participante B en una hora, la probabilidad que

nos solicita el ejercicio es:

L2

L2

P(L1 > 3 L2) = (como L y L’ son positivas) = P( L21 > 9 L22 ) = P( 12 > 9 22 )

σ

σ

L2

donde tanto

L21

2

σ

como

L22

2

σ

L21

2

∼ χ2(3), y son independientes. Por ello: F = σ2

L2

σ2

/3

∼ F(3, 3),

/3

distribución tabulada en la GUÍA.

Entonces:

P(L1 > 3 L2) = P(F > 9) = 0,05204

Nota: P(F3.3 > 9) = 0,05204 se ha obtenido utilizando las funciones estadísticas de una planilla

electrónica (FUNCIONES, FUNCIONES ESTADÍSTICAS, DISTRIBUCIÓN F) introduciendo el

argumento (3,32) y los grados de libertad del numerador y del denominador (3 y 3. En la tabla F

de la GUÍA solo están tabulados algunos valores del argumento y de los grados de libertad (los

argumentos corresponden a valores que acumulan 0,95 o 0,99 de probabilidad). En este caso

la mejor aproximación es P(F3.3 ≤ 9,28) = 0,95 ⇒ P(F3.3 > 9,28) = 0,05, y lo que podemos

afirmar utilizando la tabla de la GUÍA es que P(F3.3 > 9) > 0,05.

EJERCICIO 18

Recordemos primero la distribución F de Fisher: dadas dos variables aleatorias U y V,

independientes, con distribuciones de probabilidad χ2(m) y χ2(n) respectivamente, entonces la

variable aleatoria cociente:

U/m

F(m, n) =

V /n

tiene distribución F con m y n grados de libertad.

Como X ∼ N ( μ1, 9 ) y Y ∼ N ( μ 2 ,16 ), entonces

por la definición anterior:

8 S 2Y

10 S 2X

∼ χ2(9) y

∼ χ2(7). Por lo tanto,

16

9

11

10 S 2X

/9

140 S 2X 140

9

=

=

W

F(9, 7) =

81 S 2Y

81

8 S 2Y

/7

16

Por lo tanto:

140

140

W > 2,1291

) = P(F(9, 7) > 3,68) = 0,05

81

81

1

Además, como resulta obvio observar que la variable aleatoria ∼ F(n, m). Entonces:

F

140 1

140 81 1

140

1

1

1

=

=

=

, con

∼ F(7, 9)

81 140 W

81 140

81 F

W

F

W

81

Por ello:

140 1

81

1

1

> 5,6864) = P (

> 5,6864) = P (

>

5,6864 ) = P ( F(7, 9) > 3,29) = 0,05

P(

81 F

140

W

F

P(W > 2,1291) = P(

EJERCICIO 19

1) Fn(t) = P(Yn ≤ t) = P(X1 ≤ t, ..., Xn ≤ t) = (indep.) = P(X1 ≤ t) ... P(Xn ≤ t) = (igual distrib.) =

[ P(X ≤ t) ]n = FXn ( t ) . Entonces:

a) si t < 0 ⇒ FX(t) = 0 ⇒ Fn(t) = 0

b) si 0 ≤ t < 1, FX(t) = t ⇒ Fn(t) = tn

c) si t ≥ 1. FX(t) = 1 ⇒ Fn(t) = 1

2)

lim Fn ( t ) = lim 0 = 0, si t < 0

n → +∞

n → +∞

lim Fn ( t ) = lim t n = 0, si 0 ≤ t < 1

n → +∞

n → +∞

lim Fn ( t ) = lim 1 = 1, si t ≥ 1

n → +∞

n → +∞

Observación: Fn(t) es la función de distribución de la variable aleatoria que es constantemente

igual a 1 en t = 1; o dicho de otro modo es la variable aleatoria Z, tal que P(Z = 1) = 1. Se dice

que Yn converge en distribución a la variable Z, cuando n →∞.

EJERCICIO 20

1) Fn(t) = P(Yn ≤ t) = 1 – P(Yn > t) = 1 – P(X1 > t, ..., Xn > t) = (indep.) = 1 – P(X1 > t) ... P(Xn > t)

= (idént. distrib.) = 1 – [ P(X > t) ]n = 1 – [1 – P(X ≤ t) ] n = 1 – [1 – FX( t) ] n. Entonces:

a) si t ≤ 0 ⇒ FX(t) = 0 ⇒ Fn(t) = 0

−

b) si t > 0, FX(t) = 1 – e

2)

t

θ

⇒ Fn(t) = 1 – e

−

tn

θ

lim Fn ( t ) = lim 0 = 0, si t ≤ 0

n → +∞

n → +∞

lim Fn ( t ) = lim 1 − e

n → +∞

−

tn

θ

= 1, si t > 0

n → +∞

Observación: En este caso nótese que Fn(t) no es una distribución, ya que no es continua

por la derecha en t = 0. Para que sea una distribución, es necesario modificar la función Fn(t)

12

−

tn

de menara que Fn(t) = 0 si t < 0 y Fn(t) = 1 – e θ si t ≥ 0. Ahora, la variable aleatoria W cuya

función de distribución resulta de hacer lim Fn ( t ) , es una variable constante, concentrada en

n → +∞

el punto w = 1. Se dice que Yn converge en distribución a la variable W, cuando n →∞.

EJERCICIO 21

Para resolver este ejercicio hay que hacer un supuesto adicional que no está escrito, pero que

se podría deducir en coherencia con las hipótesis y es que Xn es uniforme discreta. Por lo

tanto:

i

1

P(Xn = ) = , para 1 ≤ i ≤ n

n

n

Entonces:

a) Fn(t) = P(Xn ≤ t) = 0, si t <

k

b) Fn(t) = P(Xn ≤ t) =

∑

i =1

1

n

1

1

=

n

n

k

∑1 = n ,

i =1

k

si

k

k +1

y 0<k<n

≤t<

n

n

c) Fn(t) = P(Xn ≤ t) = 1, si t ≥ 1

Por lo tanto:

lim Fn ( t ) = lim 0 = 0, si t <

n → +∞

n → +∞

1

n

k

= t, si 0 ≤ t < 1. Esto se debe a que, dado el Rec (Xn), existe k, tal que

n → +∞ n

lim Fn ( t ) = lim

n → +∞

k

1

k +1

k

k

− t < < ε ≤ t para n suficientemente grande pues ≤ t <

y por

n

n

n

n

n

k 1

tanto: 0 ≤ t − < . Entonces: lim Fn ( t ) = 1, si t ≥ 1

n → +∞

n n

Fn (t ) − t =

Nota: La observación final en este ejercicio es que dicha distribución corresponde a la de una

uniforme continua en el intervalo [0, 1]. Se dice que Xn converge en distribución a una uniforme

C[0, 1], cuando n →∞.

EJERCICIO 22

Recordemos previamente la siguiente definición:

p

Xn ⎯⎯→

X (la v.a. Xn tiende en probabilidad a X) ⇔

(

)

lim P Xn − X ≤ ε = 1

n → +∞

1) Recordemos que por la llamada Ley Débil de los Grandes Números:

Si X1, ..., Xn v.a. iid con E(Xi) = μ y V(Xi) = σ2 (finitas) ⇒ Xn =

1

n

n

∑X

i

p

⎯⎯→

μ

i =1

Si Y ∼ Bin(n, p), entonces Y = X1 + ... + Xn con Xi ∼ Ber(p), E(Xi) = p y V(Xi) = p (1 – p).

Y

= Xn , si aplicamos la Ley Débil de los Grandes Números obtenemos

Observando que p̂ =

n

p

μ = p.

que: Xn ⎯⎯→

13

2) Enunciemos el siguiente Teorema:

p

p

X y Yn ⎯⎯→

Y , entonces dadas dos funciones, g: R → R, continua y h: R2

Si Xn ⎯⎯→

→ R2, continua en ambas variables, se puede demostrar que:

p

g ( Xn ) ⎯⎯→

g( X)

p

h ( Xn , Yn ) ⎯⎯→

h ( X, Y )

Para nuestro caso, si tomamos g(x) = x (1 – x) que cumple las condiciones del Teorema

entonces:

p

g ( Xn ) = Xn ( 1 – Xn ) = p̂ ( 1 – p̂ ) ⎯⎯→

p (1 – p)

3) Si aplicamos el Teorema del Límite Central al conjunto X1, X2, ….., Xn: Xi ∼ Bernoulli(p)

obtenemos que:

Xn − p

p̂ − p

d

=

N(0,1)

⎯⎯→

p (1 − p)

p (1 − p)

n

n

⎯→ 0 y Y n ⎯

⎯→ X , entonces

El Teorema de Slutsky establece que si X n − Y n ⎯

p

d

T) X n ⎯

⎯→ X .

d

x −p

Si aplicamos el Teorema enunciado en 2), tomando g (x) =

1

Xn (1 − Xn )

n

=

1

p̂ (1 − p̂)

n

x (1 − x )

n

1

p

⎯⎯→

deducimos que:

p (1 − p)

n

ya que g es real y además continua en (0, 1).

Sean X n =

Xn − p

X n (1 − X n )

n

y Yn =

Xn − p

p (1 − p )

n

. Hay que probar que Xn – Yn

o lo que es lo mismo:

Xn − p

Xn (1 − Xn )

n

–

Xn − p

p (1 − p)

n

p

⎯⎯→

0

Ahora bien:

Xn − p

Xn (1 − Xn )

n

–

Xn − p

p (1 − p)

n

= ( Xn − p ) (

como ambos factores convergen en probabilidad a 0:

1

p

Xn − p ⎯⎯→

0 y

–

Xn (1 − Xn )

n

1

Xn (1 − Xn )

n

1

p (1 − p)

n

–

1

p (1 − p)

n

p

0

⎯⎯→

)

p

⎯⎯→

0,

14

entonces su producto también tiende en probabilidad a cero, con lo que queda probado que

p

Xn – Yn ⎯⎯→

0, y por el Teorema de Slutsky, X n =

Xn − p

X n (1 − X n )

n

d

⎯

⎯→

N (0,1)

EJERCICIO 23

Planteemos, para ello el Teorema de Khintchine (Novales pág. 311), similar a la Ley Débil de

los Grandes Números, pero que no requiere del segundo momento para las variables:

Si X1, ..., Xn v.a. iid con distribución igual a la de X y E(X) < +∞

1

n

⇒ Xn =

Probaremos, ahora que

X12 ,

X 22 ,

n

∑X

i

p

⎯⎯→

E ( X)

i =1

⎯⎯→ σ . Para ello, apliquemos el teorema anterior a las variables

p

Sn2

2

Xn2

...,

las cuales son también independientes e idénticamente distribuidas pues las

originales lo son, y su esperanza E (X2) < +∞ por hipótesis:

1

n

⇒ Xn2 =

Recordando que Sn2 =

1

n

n

∑X

2

i

–

(

i =1

1

n

n

∑X

2

i

p

⎯⎯→

E ( X2 )

i =1

n

∑X ) ,

2

i

aplicamos, en primer lugar, el teorema

i =1

enunciado en el ejercicio anterior parte 2), tomando g (x) = x2 y la sucesión Xn , con lo que

obtenemos:

( X n )2 = (

1

n

n

∑X )

i

2

p

⎯⎯→

E 2 ( X)

i =1

Finalmente, empleamos el Teorema 8.22 del Novales (pág. 309):

Sn2 =

1

n

n

∑

i =1

Xi2 – (

1

n

n

∑X )

i

2

p

⎯⎯→

E ( X 2 ) – E2 (X) = Var (X) = σ2

i =1

Con otra parte del mismo teorema, eligiendo las sucesiones Sn2 y

y

n

, como Sn2

n −1

p

⎯⎯→

σ2

n

p

⎯⎯→

1, (esta es una sucesión de variables constantes para cada n), tenemos que:

n −1

sn2 =

n

p

Sn2 ⎯⎯→

1. σ2 = σ2

n −1