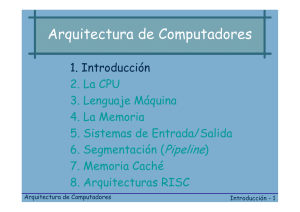

II. Los computadores personales y sus claves

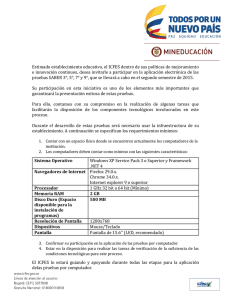

Anuncio