¿Física qué?... Cuántica

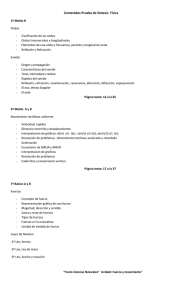

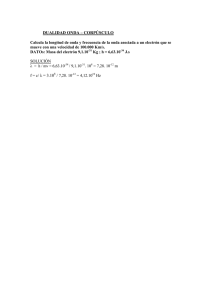

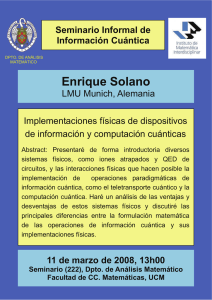

Anuncio