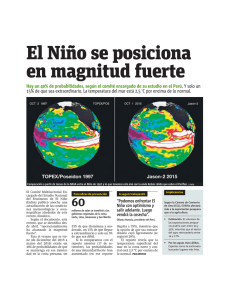

EL AZAR EN FÍSICA Y BIOLOGÍA Y LAS MATEMÁTICAS DEL AZAR

Anuncio