UNIVERSIDAD DE CHILE FACULTAD DE CIENCIAS FÍSICAS Y

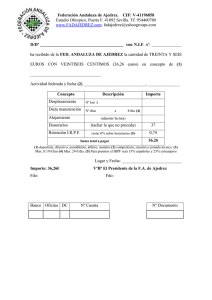

Anuncio