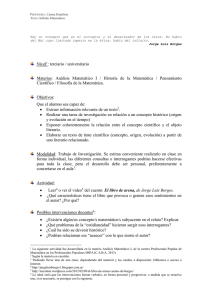

Una mirada a las Matemáticas del siglo XX

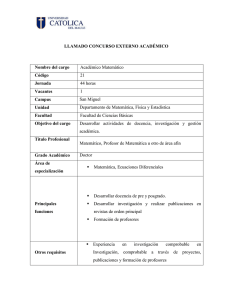

Anuncio